基于seq2seq的文本摘要及相关数据集介绍

基于深度学习的文本摘要方法综述研究

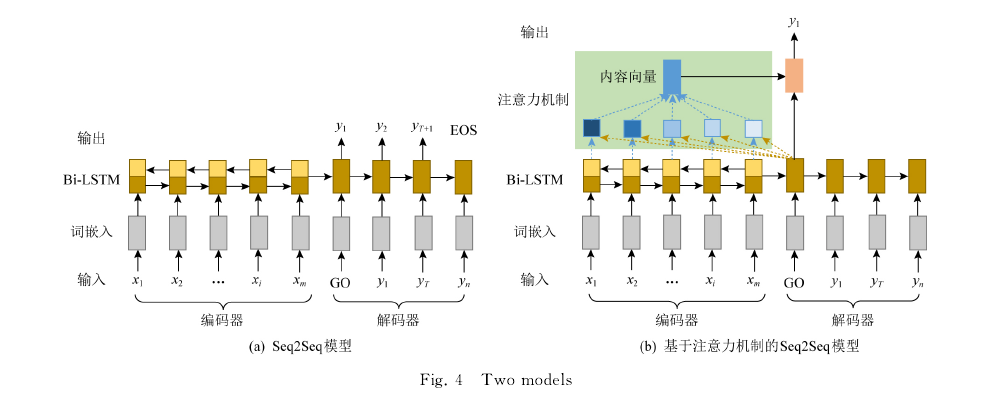

基于序列到序列(Seq2Seq)框架 模 型

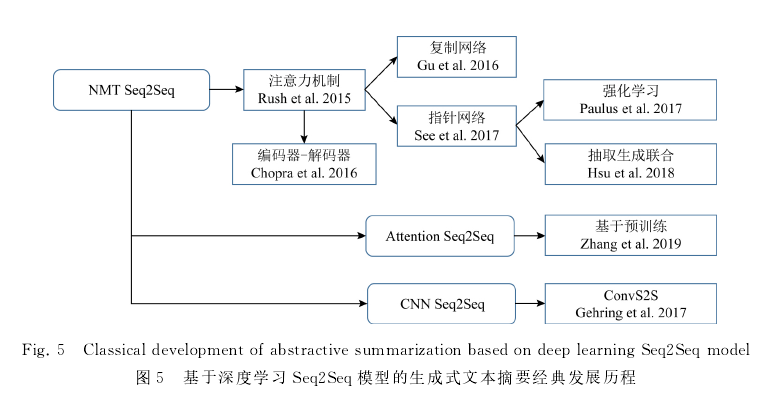

1.2015年,Rush等人受神经机器翻译(NMT)启发,首次提出基于注意力机制(编码器)+神经网络语言模型(NNLM)(解码器)的模型用于生成式摘要;

2016年,Chopra等人,改进RNN(解码器),效果显著,常作为基线模型;

同年,Nallapati等人引入了一些新技术:在编码器加入丰富的文本特征捕获关键词;加入生成器指针来解决词典外词汇(OOV)和低频词的问题;利用层级注意力机制来捕获不同级别文档结构信息;

Gu等人提 出 CopyNet复制网络,一方面可以复制有效保留源文中的重要信息,另一方面输出端可以生成一些和源文措辞不同的摘要,局限:原封不动的复制输入端信息,不能灵活调整;

See等人提出指针生成器网络进行灵活选择,以及覆盖(coverage)机制处理生成重复问题;

2018年,Paulus等人首先提出使用强化学习,应用自批评策略梯度算法训练模型,将强化学习损失与传统的交叉熵损失相结合,因此即可利用不可微的评价指标ROUGH、BLEU,又能提高可读性;

Cao等人为避免模型生成的摘要中存在不符事实的信息,通过使用开放的信息抽取和依存分析技术从源文中提 取 实 际 的 事 实 描 述,还 提 出Dual-Attention

序列到序列的框架使得模型必须以原文本和提取的事实描述为条件生成摘要,实验证明,可减少80%虚假事实;

Hsu等人提出一种抽取式和生成式相结合的方式,先利用抽取模块对句子的重要程度打分,在此基础上使用生成模块更新对原始文章中每个单词的注意力权值,然后逐词生成得到该文的摘要;

Zhou等人在编码器加入Selective门控网络,将词的隐层状态和句子的隐层状态拼接到一起,输入到前馈网络里生成新的语义向量;

在抽取式方法中,深度学习的作用主要体现在分类模型上性能的提升,尽可能使输出结果拟合标准数据的分布.对于生成式方法来说取得了突破性的进展,改变了生成式自动文摘的研究思路,

基于深度学习的生成方式模拟人类写作的习惯,其输出的结果包含了不存在原始文本中的表达方式.深度学习端到端的训练方式正式使自动文摘任务向人工智能迈出了重要一步.但不可避免的是

,深度学习方法同样存在一些缺陷,如需要大量高质量标注数据、调参缺乏理论指导等问题,未来还需要研究者设计出更高效的算法来满足大数据下的自动文摘需求。

2.数据集介绍

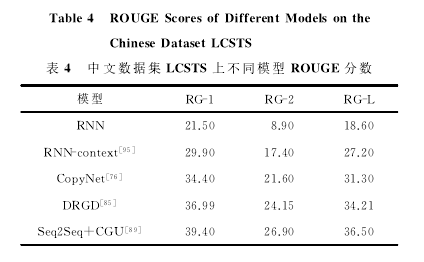

中文数据集:

1)LCSTS:中文短文本摘要数据集,采集于新浪微博认证用户发表的超过200万个中文短文。2.4×10(6)个文本对的训练集、1×10(4)个文本对的验证集和1.1×10(3)

个文本对的测试集.其中验证集和测试集增加了摘要和原文之间的相关程度打分,分数越高代表相关程度越高,方便了研究者根据不同任务特点调整数据集的使用.

2)NLPCC:面向中文微博的新闻摘要。NLPCC-2015包含从新闻门户网站收集的140篇带标题新闻文章,每篇对应2篇人工生成的标准摘要(不超过140个汉字);NLPCC-2017提供了包含标准摘要和不包含标准摘要的2个训练数据集,每个训练集包含5000篇新闻文档。

3)搜狐新闻数据集:根据不同的预处理方法,可用于文本分类、事件检测跟踪、新词发现、命名实体识别、自动文摘等任务,包含140万条新闻正文和新闻标题。

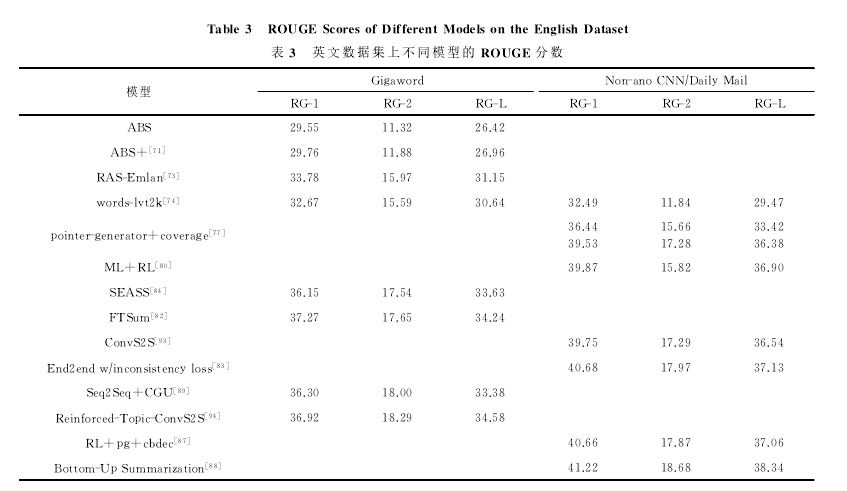

英文数据集:

1)CNN/Darly Mail:新闻数据数据集,包括286817个训练对、13368个验证对和11487个测试对;

2)Gigaword:数据量较大,约有950万篇新闻文章,有3.8*10^6个训练集、1.89*10^5个验证集和1951个测试集。

3)DUC/TAC:仅供测评用的小规模数据集,

目前常用的摘要数据集是DUC-2002,DUC-2003,DUC-2004.DUC-2002包含567篇文档,每篇文档有2个人工生成的100词的摘要;DUC-2003包含

624个文章 摘要对;DUC-2004包含500篇文档,每篇新闻都有对应的4篇不同的人工生成的截取75B的参考摘要

4)New York Times:纽约时报预处理后构成,有超过65万篇工作人员撰写的摘要和150万篇人工标注的文章,并有人、组织、位置和主题等内容的归一化索引表,可用于自动文摘、文本分类、内容提取等任务。更适合作为抽取式自动文摘。

5)Newsroom:可用于训练和评价自动文摘系统的大型数据集,包括130万篇文章和摘要,可作为生成式和抽取式。

6)Bytecup:由130万篇新闻wen'z的文本摘要方法综述研究

基于序列到序列(Seq2Seq)框架 模 型

1.2015年,Rush等人受神经机器翻译(NMT)启发,首次提出基于注意力机制(编码器)+神经网络语言模型(NNLM)(解码器)的模型用于生成式摘要;

2016年,Chopra等人,改进RNN(解码器),效果显著,常作为基线模型;

同年,Nallapati等人引入了一些新技术:在编码器加入丰富的文本特征捕获关键词;加入生成器指针来解决词典外词汇(OOV)和低频词的问题;利用层级注意力机制来捕获不同级别文档结构信息;

Gu等人提 出 CopyNet复制网络,一方面可以复制有效保留源文中的重要信息,另一方面输出端可以生成一些和源文措辞不同的摘要,局限:原封不动的复制输入端信息,不能灵活调整;

See等人提出指针生成器网络进行灵活选择,以及覆盖(coverage)机制处理生成重复问题;

2018年,Paulus等人首先提出使用强化学习,应用自批评策略梯度算法训练模型,将强化学习损失与传统的交叉熵损失相结合,因此即可利用不可微的评价指标ROUGH、BLEU,又能提高可读性;

Cao等人为避免模型生成的摘要中存在不符事实的信息,通过使用开放的信息抽取和依存分析技术从源文中提 取 实 际 的 事 实 描 述,还 提 出Dual-Attention

序列到序列的框架使得模型必须以原文本和提取的事实描述为条件生成摘要,实验证明,可减少80%虚假事实;

Hsu等人提出一种抽取式和生成式相结合的方式,先利用抽取模块对句子的重要程度打分,在此基础上使用生成模块更新对原始文章中每个单词的注意力权值,然后逐词生成得到该文的摘要;

Zhou等人在编码器加入Selective门控网络,将词的隐层状态和句子的隐层状态拼接到一起,输入到前馈网络里生成新的语义向量;

在抽取式方法中,深度学习的作用主要体现在分类模型上性能的提升,尽可能使输出结果拟合标准数据的分布.对于生成式方法来说取得了突破性的进展,改变了生成式自动文摘的研究思路,

基于深度学习的生成方式模拟人类写作的习惯,其输出的结果包含了不存在原始文本中的表达方式.深度学习端到端的训练方式正式使自动文摘任务向人工智能迈出了重要一步.但不可避免的是

,深度学习方法同样存在一些缺陷,如需要大量高质量标注数据、调参缺乏理论指导等问题,未来还需要研究者设计出更高效的算法来满足大数据下的自动文摘需求。

2.数据集介绍

中文数据集:

1)LCSTS:中文短文本摘要数据集,采集于新浪微博认证用户发表的超过200万个中文短文。2.4×10(6)个文本对的训练集、1×10(4)个文本对的验证集和1.1×10(3)

个文本对的测试集.其中验证集和测试集增加了摘要和原文之间的相关程度打分,分数越高代表相关程度越高,方便了研究者根据不同任务特点调整数据集的使用.

2)NLPCC:面向中文微博的新闻摘要。NLPCC-2015包含从新闻门户网站收集的140篇带标题新闻文章,每篇对应2篇人工生成的标准摘要(不超过140个汉字);NLPCC-2017提供了包含标准摘要和不包含标准摘要的2个训练数据集,每个训练集包含5000篇新闻文档。

3)搜狐新闻数据集:根据不同的预处理方法,可用于文本分类、事件检测跟踪、新词发现、命名实体识别、自动文摘等任务,包含140万条新闻正文和新闻标题。

英文数据集:

1)CNN/Darly Mail:新闻数据数据集,包括286817个训练对、13368个验证对和11487个测试对;

2)Gigaword:数据量较大,约有950万篇新闻文章,有3.8*10^6个训练集、1.89*10^5个验证集和1951个测试集。

3)DUC/TAC:仅供测评用的小规模数据集,

目前常用的摘要数据集是DUC-2002,DUC-2003,DUC-2004.DUC-2002包含567篇文档,每篇文档有2个人工生成的100词的摘要;DUC-2003包含

624个文章 摘要对;DUC-2004包含500篇文档,每篇新闻都有对应的4篇不同的人工生成的截取75B的参考摘要

4)New York Times:纽约时报预处理后构成,有超过65万篇工作人员撰写的摘要和150万篇人工标注的文章,并有人、组织、位置和主题等内容的归一化索引表,可用于自动文摘、文本分类、内容提取等任务。更适合作为抽取式自动文摘。

5)Newsroom:可用于训练和评价自动文摘系统的大型数据集,包括130万篇文章和摘要,可作为生成式和抽取式。

6)Bytecup:由130万篇新闻文章组成其中110万篇作为训练集,每篇文章含有文章ID、内容和标题,由于标题较短,更适合生成式。

浙公网安备 33010602011771号

浙公网安备 33010602011771号