C++笔记

-

前言

坚持下去很难,但不坚持永远都无法获得成功~

正文

当前复习进度

31_2_2.中序遍历迭代

经验

答案

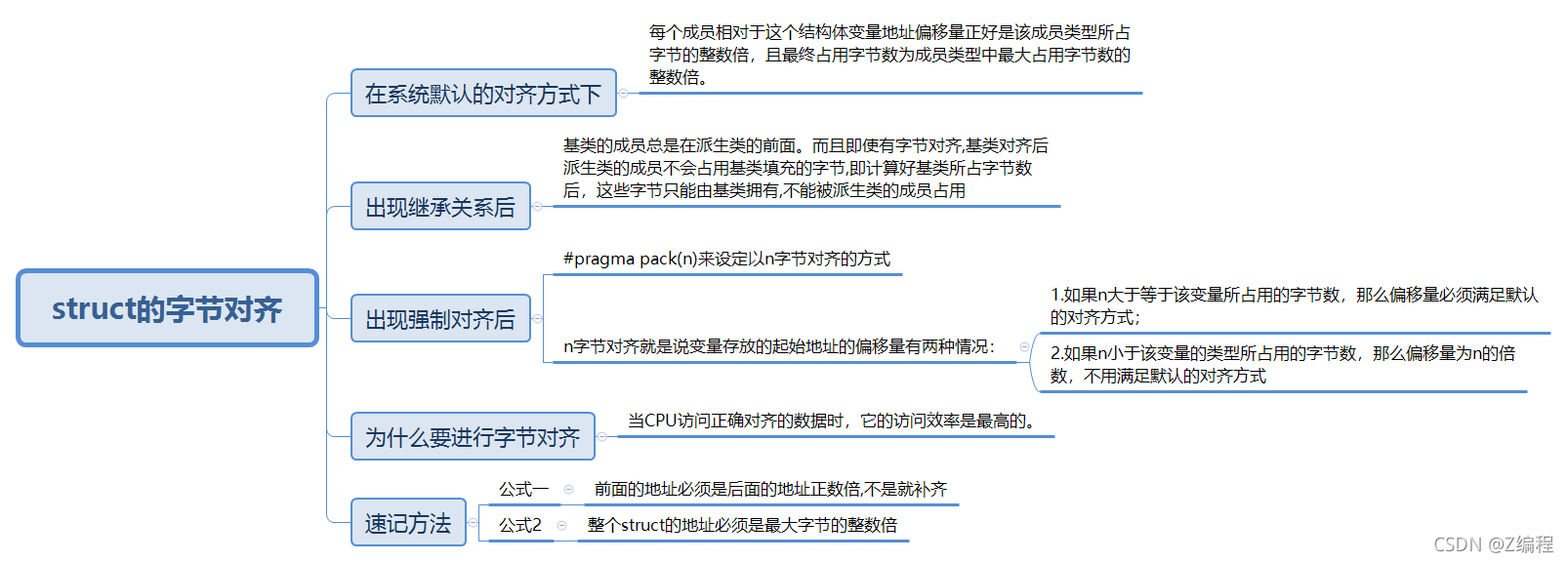

1. 如何获得结构成员相对于结构开头的字节偏移量:offsetof(S,x);

2. 浮点数的值如何比较大小?不能直接用是否相等的方式比较两个数是否相等,只能用两个数相减,然后是否符合某个精度。

3. 引用传递和指针传递是不同的:任何对于形参引用的操作都会通过一个间接寻址的方式操作到主调函数中的相关变量。而指针传递的话,即使在被调函数中改变指针地址,也无法应用到主调函数中的相关变量。

4. 动态建立对象:先执行operator new ,在内存中查找一块合适的地址,然后调用类的构造函数构造对象。

5. 调用者如何调用被调函数:使用Call指令调用被调函数,然后将下一条指令压入栈中,待该函数处理完毕,再将这下一条指令进行出栈。

6. C++中提供了explicit关键字,在构造函数声明的时候加上explicit关键字,能够禁止隐式转换。

7. 一个类对象的地址就是类所包含的这一片内存空间的首地址。

8. 所有的函数都是存放在代码区的,不管是全局函数还是成员函数又或者是静态函数。所以,类的大小由成员变量所决定。

9. 静态成员函数与一般成员函数的区别就在于:静态成员函数没有this指针,因此不能访问非静态数据成员。且this指针只能在成员函数中使用,全局函数,静态函数都不能使用this指针。

10. this指针是在成员函数开始执行前创建的,在成员的执行结束后清除。

11. delete的本质:为被释放的内存调用一个或多个析构函数。然后,释放内存。

12. 空类的大小:为了让对象的实例能够相互区别。并且每个实例都是独一无二的,所以空类的大小为1. 其空类的实例的大小也为1.

13. 静态成员不占用类的大小。其存放在静态存储区。

14. 当在类的非静态成员函数访问类的非静态成员时,编译器会自动将对象的地址传给作为隐含参数传递给函数,这个隐含参数就是this指针。

15. 弱引用指针与普通指针的一个比较大的区别就是:弱引用能检测到所管理的对象是否已经被释放,从而避免非法访问内存。

16. RALL(Resource Acquisition is Initialization):资源获取即初始化。也就是在构造函数中申请分配资源,在析构函数中申请释放资源。

17. 即使是同一个值的Integer对象,那么也是生成不同的对象。所以通过 Map 做了映射,不管你 new 多少个 Integer 出来,这多个 Integer 都会被映射为同一个 Integer,从而保证即使超出 Integer 缓存范围时,也只有一把锁。

18. 定义:减少常见的错误,能够更快的定位错误,提升运行性能。

19. 永远不要在用ranged-for的时候修改容器自身。

20. 说不要判断this 为nullptr,这是UB行为。

21. 不要判断对象的引用是nullptr,这是UB行为。永远认为引用所指向的对象是一个存在的对象。

22. 避免在switch语句中使用default

23. 不要返回裸指针,类似于:int *get_value();

24. 优先用栈而不是堆

例题

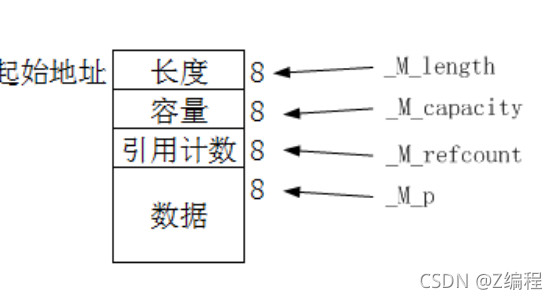

1. 如何手写shared_ptr?

点击查看代码

#include <iostream>

#include <stdio.h>

#include <mutex>

using namespace std;

class Person

{

public:

Person()

{

cout << "Person" << endl;

};

Person(int age)

{

cout << "--->Person age" << endl;

m_Age = age;

}

int m_Age;

~Person()

{

cout << "~Person" << endl;

}

void run()

{

cout << "--->Person run" << endl;

}

};

template<class T>//类模板

class Shared_Ptr {

public:

Shared_Ptr()

{

cout << "Share_Ptr" << endl;

}

Shared_Ptr(T* ptr)//://下面这四句话,叫做初始化列表,相比在括号里进行初始化,效率更高。

//参考这个:https://www.cnblogs.com/graphics/archive/2010/07/04/1770900.html

//m_ptr(ptr)

//,m_pRefCount(new int(1))

//,m_pMutex(new mutex)

{

m_ptr = ptr;

m_pRefCount = new int(1);

m_pMutex = new mutex;

cout << "-->Shared_ptr"<<endl;

}

~Shared_Ptr()

{

Release();

}

//拷贝构造函数,构造出一个新的智能指针对象后,就可以使用这个在其他地方了。

Shared_Ptr(const Shared_Ptr<T>& p)

{

m_ptr = p.m_ptr;

m_pRefCount = p.m_pRefCount;

m_pMutex = p.m_pMutex;

AddRefCount();//赋值完后,AddRef表示又有一个智能指针指向当前资源了

}

//= 操作符的拷贝赋值函数

Shared_Ptr<T>& operator=(const Shared_Ptr<T>& p)

{

if (m_ptr != p.m_ptr)

{

//要先释放原来的旧资源

Release();

//共享管理新对象的资源,并增加引用计数

m_ptr = p.m_ptr;

m_pRefCount = p.m_pRefCount;

m_pMutex = p.m_pMutex;

AddRefCount();

}

}

//拷贝构造函数是一个对象初始化一块内存区域,这块内存就是新对象的内存区,而赋值函数是对于一个已经被初始化的对象来进行赋值操作。

//所以拷贝构造直接赋值就可以了,赋值函数则要先释放原有的空间,再赋值新的空间。

T& operator*()

{

return *m_ptr;

}

T* operator&()

{

return m_ptr;

}

int UseCount()

{

return m_pRefCount;

}

T* Get()

{

return m_ptr;

}

//增加引用计数的方式

void AddRefCount()

{

m_pMutex->lock();

++(*m_pRefCount);

m_pMutex->unlock();

}

private:

void Release()

{

bool deleteflag = false;

m_pMutex->lock();

if (--(*m_pRefCount) == 0)

{

delete m_pRefCount;

delete m_ptr;

deleteflag = true;

}

m_pMutex->unlock();

if (deleteflag == true)

{

delete m_pMutex;

}

}

T* m_ptr;

int* m_pRefCount;

mutex* m_pMutex;

};

void test01()

{

Shared_Ptr<Person> p(new Person(3));

}

int main()

{

{

cout << 1 << endl;

test01();

cout << 2 << endl;

}

getchar();

return 0;

}

2. 请说出二分查找的实现思路及时空复杂度

答:首先使用二分查找算法的前提是数组是有序数组,接下来,讲一下具体的算法思路:

点击查看代码

>1. 对于该有序数组a,我们可以定义两个变量,一个叫Left,其值为0,一个叫Right,为数组的长度-1。接下来,我们可以确定该有序数组的中间者为[(left+right)/2]。

>2. 接下来,判断a[(left+right)/2]是否等于所要查找的值,若大于所要查找的值,则将left指针指向mid+1((left+right)/2)。若小于所要查找的值,则将right指针指向mid-1。所等于则返回当前Mid值。

>3. 接下来,不断的循环执行该过程。若当right指针指向的位置为left+1的话,则该查找过程结束。表示未在该数组找到该值。

>二分查找的时间复杂度为O(logn) -->N*(1/2)^x = 1--->x = O(LOG(N))

2. 构造函数可以是虚函数吗?

答案

答: 不能.

1. 因为我们在构造一个对象的时候,必须要知道这个对象的类型,而虚函数的特性就是在运行期间确定实际的类型的。

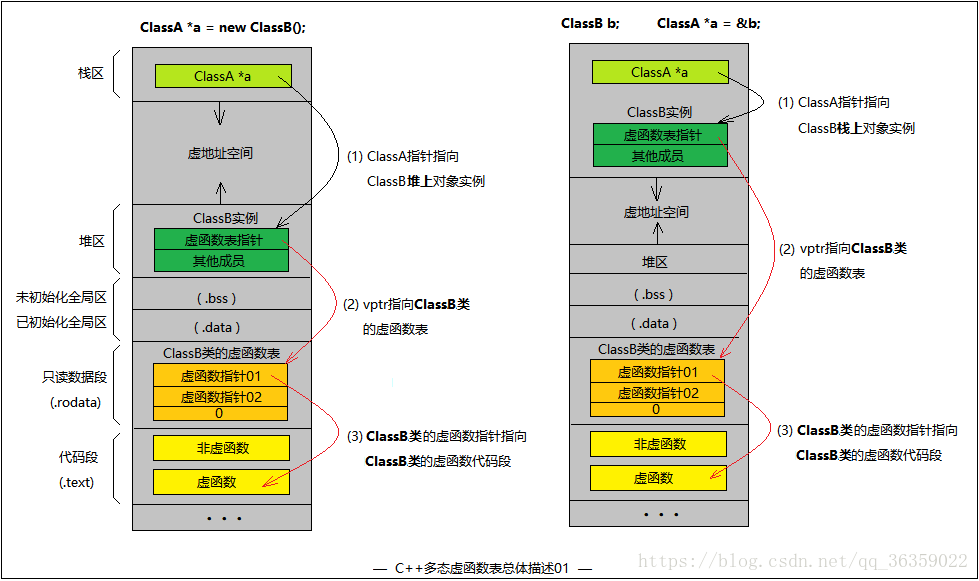

2. 并且,虚函数的执行是依赖于虚函数表的,而在构造对象期间,虚函数表还未初始化。注意:这个虚函数表是存放在**全局/静态数据区**的(全局静态变量,未初始化的放在BSS段,初始化的放在Data段。

3. 虚函数表的创建时机: 虚函数表创建时机是在编译期间。编译期间编译器就为每个类确定好了对应的虚函数表里的内容。所以在程序运行时,编译器会把虚函数表的首地址赋值给虚函数表指针,所以,这个虚函数表指针就有值了.

2.1. C++类有继承时,析构函数必须为虚函数吗?

点击查看代码

若不是虚函数,则派生类调用析构函数释放内存时,有可能调用的是基类的析构函数,导致派生类所申请的内存未正确释放。

2.2 虚函数与纯虚函数的差别是什么?

点击查看代码

1. 纯虚函数只有定义,没有实现;而虚函数不仅有定义,还有实现。

2. 包含纯虚函数的类不能定义其对象,而包含虚函数的可以。

3. 纯虚函数在虚函数表中的表项是空项,值为0,而虚函数在虚函数中的表项是一个具体的值,具体的指针地址。

2.3 纯虚函数实现原理是什么?(通过这个原理,可以达成什么样的目的?)

点击查看代码

虚函数的原理采用虚函数表。

类中含有纯虚函数时,其虚函数表不完全,有个空位。

即“纯虚函数在类的虚函数表中对应的表项被赋值为0。也就是指向一个不存在的函数。由于编译器绝对不允许有调用一个不存在的函数的可能,所以该类不能生成对象。在它的派生类中,除非重写此函数,否则也不能生成对象。”

所以纯虚函数不能实例化。

2.4 虚函数是否可以是内联函数?

点击查看代码

答案:虚函数可以是内联函数,内联是可以修饰虚函数的,但是当虚函数表现多态性的时候不能内联。

**内联函数的原理?**

在编译期间,对调用内联函数的地方替换成函数代码。

**内联函数的作用?**

对程序中需要频繁使用 和调用的小函数有用。可以减少函数调用所做的花销,提高程序的效率。

**为何在表现多态性不能内联?**

内联是在编译器内联,而虚函数的多态性是在运行期,编译器无法知道运行期调用哪个代码,因为虚函数表示为多态性时不可以内联。

什么情况可以使用inline修饰虚函数?(内联函数何时可以内联?)

答案

//inline virtual 唯一可以内联的时候是:编译器知道所调用的对象是哪个类(如 Base::who()),这只有在编译器具有实际对象而不是对象的指针或引用时才会发生。

#include <iostream>

using namespace std;

class Base {

public:

virtual void who() { cout << "I am Base" << std::endl; }

};

class Derived : public Base {

public:

void who() { cout << "I am Derived" << std::endl; }

};

int main() {

// 此处的虚函数who(),是通过类的具体对象来调用的,编译期间就能确定了,所以它可以是内联的。

Base b;

b.who();

// 此处的虚函数是通过指针调用的,需要在运行时期间才能确定,所以不能为内联。

Base* ptr = new Derived();

ptr->who();

return 0;

}

//也就是

class Base

{

inline virtual void who() {..........}

}

class Derived : public Base

{

inline void who() {............}

}

//上面这种情况是可以运行的

2.5 虚函数和虚函数表的存放地址在哪里

点击查看代码

答案:C++中虚函数表位于只读数据段(.rodata),也就是C++内存模型中的常量区;而虚函数则位于代码段(.text),也就是C++内存模型中的代码区。

如何确定虚函数表是位于C++内存模型中的常量区?

1.虚函数表是全局共享的元素,即全局仅有一个.

2.虚函数表类似一个数组,类对象中存储vptr指针,指向虚函数表.即虚函数表不是函数,不是程序代码,不肯能存储在代码段.

3.虚函数表存储虚函数的地址,即虚函数表的元素是指向类成员函数的指针,而类中虚函数的个数在编译时期可以确定,即虚函数表的大小可以确定,即大小是在编译时期确定的,不必动态分配内存空间存储虚函数表,所以不再堆中.

4. 虚函数是针对一个类的,有点像一个类中的static变量,是属于一个类的所有对象的。不属于某一个专门的对象。

根据以上特征,虚函数表类似于类中静态成员变量.静态成员变量也是全局共享,大小确定.

2.6 如何获得虚函数表的地址

答案

在C++的标准规格说明书中说到,编译器必需要保证虚函数表的指针存在于对象实例中最前面的位置(这是为了保证正确取到虚函数的偏移量)。这意味着我们通过对象实例的地址得到这张虚函数表,然后就可以遍历其中函数指针,并调用相应的函数。

取虚表地址和虚函数地址的方式

class Base {

public:

virtual void f() { cout << "Base::f" << endl; }

virtual void g() { cout << "Base::g" << endl; }

void h() { cout << "Base::h" << endl; }

};

typedef void(*Fun)(void); //函数指针

int main()

{

Base b;

// 这里指针操作比较混乱,在此稍微解析下:

// *****printf("虚表地址:%p\n", *(int *)&b); 解析*****:

// 1.&b代表对象b的起始地址

// 2.(int *)&b 强转成int *类型,为了后面取b对象的前四个字节,前四个字节是虚表指针

// 3.*(int *)&b 取前四个字节,即vptr虚表地址

//

// *****printf("第一个虚函数地址:%p\n", *(int *)*(int *)&b);*****:

// 根据上面的解析我们知道*(int *)&b是vptr,即虚表指针.并且虚表是存放虚函数指针的

// 所以虚表中每个元素(虚函数指针)在32位编译器下是4个字节,因此(int *)*(int *)&b

// 这样强转后为了后面的取四个字节.所以*(int *)*(int *)&b就是虚表的第一个元素.

// 即f()的地址.

// 那么接下来的取第二个虚函数地址也就依次类推. 始终记着vptr指向的是一块内存,

// 这块内存存放着虚函数地址,这块内存就是我们所说的虚表.

//

printf("虚表地址:%p\n", *(int *)&b);

printf("第一个虚函数地址:%p\n", *(int *)*(int *)&b);

printf("第二个虚函数地址:%p\n", *((int *)*(int *)(&b) + 1));

Fun pfun = (Fun)*((int *)*(int *)(&b)); //vitural f();

printf("f():%p\n", pfun);

pfun();

pfun = (Fun)(*((int *)*(int *)(&b) + 1)); //vitural g();

printf("g():%p\n", pfun);

pfun();

}

2.7 虚函数表带来的安全性问题有哪些?(两点)

点击查看代码

问题一:通过父类型的指针访问子类自己的虚函数

Base1 *b1 = new Derive();

b1->f1();

//编译出错 这个f1 是子类自己的虚函数

任何妄图使用父类指针想调用子类中的未覆盖父类的成员函数的行为都会被编译器视为非法,所以,这样的程序根本无法编译通过。但在运行时,我们可以通过指针的方式访问虚函数表来达到违反C++语义的行为。

问题二、访问non-public的虚函数

另外,如果父类的虚函数是private或是protected的,但这些非public的虚函数同样会存在于虚函数表中,所以,我们同样可以使用访问虚函数表的方式来访问这些non-public的虚函数,这是很容易做到的。

[参考](https://blog.csdn.net/qq_41375609/article/details/107050911)

2.8 虚函数到底虚在哪?

答案

虚就虚在所谓"推迟联编"或者"动态联编"上,一个类函数的调用并不是在编译时刻被确定的,而是在运行时刻被确定的

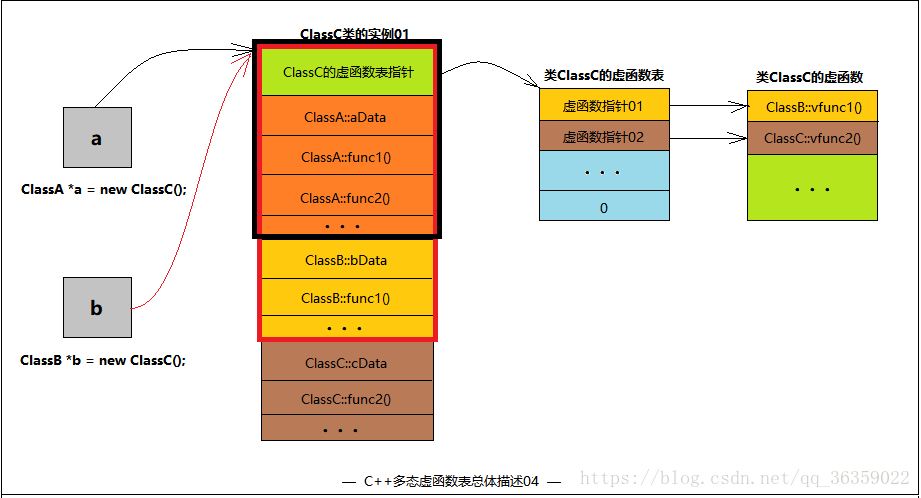

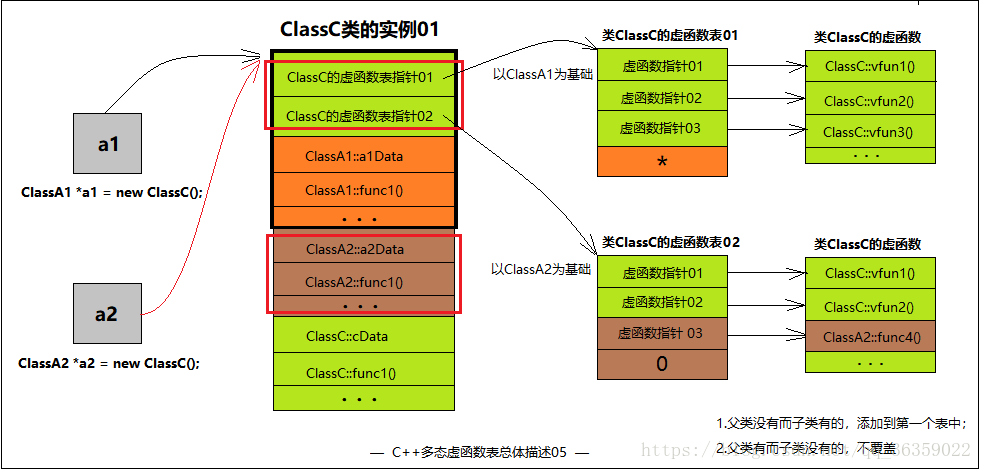

2.9、谈谈你对虚函数表结构的理解,在单继承,多继承,虚继承情况下表的结构是怎么样的?

答案

1. 虚表是属于类的,不属于某个对象。同一个类的所有对象共用一个虚表。

2. 对象的虚表指针指向自己所属类的虚表,虚表中的指针会指向其继承的最近的一个类的虚函数。

3. 对于子类来说,这个虚函数表包含父类中所有的虚函数,当子类重写某个虚函数时就会用子类重写后的函数地址替换原来父类中定义的函数地址,同时在子类的虚函数表中还会包含子类独有的虚函数。

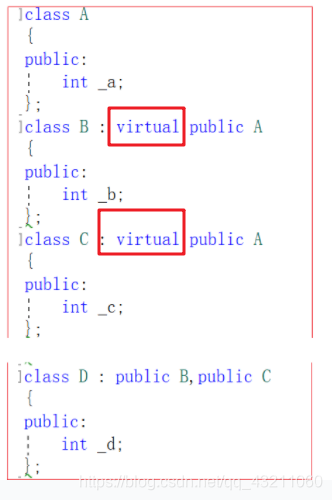

4. 解决菱形继承的方法:虚继承。

单继承:

多继承:当出现多继承时,会出现两个虚函数表指针,一个是指向自己的,一个是指向继承的那个虚函数表的。

菱形继承: 会出现最终继承的子类,会有两份最上级父类的成员变量。

5. 虚继承的作用

> 1. 虚继承是多重继承特有的概念,这里需要明确的是,虚继承与虚函数继承是完全不同的概念。

> 2. 虚继承是为解决多重继承(菱形继承)而出现的,可以节省内存空间。

2.10 C++构造函数和析构函数中可以调用虚函数吗?

答案

1. 从语法上讲,调用完全没有问题。但从效果上讲,往往不能达到需要的目的。

**原因**:

1. 在构造函数中调用虚函数,由于当前对象还没有构造完成,此时调用的虚函数指向的是基类的函数实现方式。

2. 在析构函数中调用虚函数,此时调用的是子类的函数实现方式。

2.11 如何让类不被继承?

答案

a. 将类的构造函数声明为private。

b. 二是,将该类虚继承一个父类,但是该父类的构造函数是带private属性的。(其实子类可以继承有private构造函数的父类,那必定是有权限访问父类的private成员,这是通过将子类声明为父类的friend class了。)

关于第二个方法可行的依据是:

1)派生类不能调用父类private属性的构造函数。

2)建立一个对象时,如果这个对象中含有从虚基类继承来的成员,则虚基类的成员是由最远派生类的构造函数通过调用虚基类的构造函数进行初始化的。

c. 使用final关键字,C++11中允许将类标记为final,方法时直接在类名称后面使用关键字final,如此,意味着继承该类会导致编译错误。

2.12为什么纯虚函数一定要被子类继承?

答案

1. 由于纯虚函数在虚函数表项中是为0的,也就是是指向一个不存在的函数的。那么也就意味着,该类是不能被实例化的,因为编译器是不允许去实例化一个有指向不存在函数的类的。

2. 那么就以为着如果子类继承了这个抽象类,那么虚函数表也就也有一个表项是0,指向不存在的函数。如果子类不去实现,覆盖这个表项的话,那么肯定就没办法进行实例化。

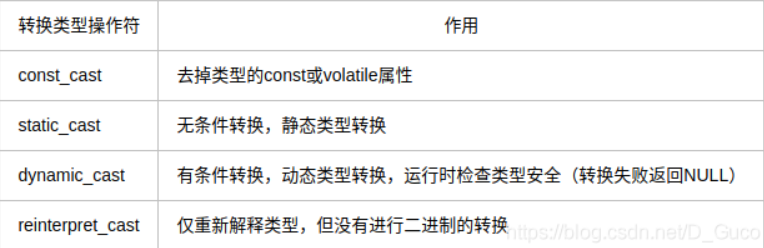

3. C++ 四种强制类型转换

3.0什么叫隐式转换,什么叫显式转换

答案

隐式转换:说白了就是在转换时不给系统提示具体的显示模型,让其自动转换,但是要记住一条编译器一般只支持自下而上的类型转换,例如int 转 float。

显示转换:就是我们在c语言课程中学的,强制转换,是我们可以直接对其赋值的。

3.1 const_cast的作用

答案

>1. 常量指针被转换为非常量的指针,并且仍然指向原来的对象。

>2. 常量应用被转化为非常量的应用,并且仍然指向原来的对象。

>3. 去掉变量的const 或是volatile属性。

3.2 static_cast的作用

答案

>1. 用于类层次结构中父类和子类指针或引用的无条件转换。

>2. 用于基本数据类型之间的转换。

>3. c++ 任何隐式转换都是使用static_cast.

3.3 dynamic_cast的作用

答案

作用:用于子类转父类时的有条件类型转换,会进行类型检查。

关于这个,我目前只了解说在子类转成父类的强制类型转换时可以使用。但其实父类转子类也是可以的。并且dynamic_cast要求操作数必须是多态类型。比如在将整形转为浮点型时。

(1)其他三种都是编译时完成的,dynamic_cast是运行时处理的,运行时要进行类型检查。

(2)不能用于内置的基本数据类型的强制转换。

(3)dynamic_cast转换如果成功的话返回的是指向类的指针或引用,转换失败的话则会返回NULL。

(4)使用dynamic_cast进行转换的,基类中一定要有虚函数,否则编译不通过。

B中需要检测有虚函数的原因:类中存在虚函数,就说明它有想要让基类指针或引用指向派生类对象的情况,此时转换才有意义。

这是由于运行时类型检查需要运行时类型信息,而这个信息存储在类的虚函数表(关于虚函数表的概念,详细可见<Inside c++ object model>)中,

只有定义了虚函数的类才有虚函数表。

(5) dynamic_cast用于类继承层次间的指针或引用转换。主要还是用于执行“安全的向下转型(safe downcasting)”,也即是基类对象的指针或引用转换为同一继承层次的其他指针或引用。至于“先上转型”(即派生类指针或引用类型转换为其基类类型),本身就是安全的,尽管可以使用dynamic_cast进行转换,但这是没必要的, 普通的转换已经可以达到目的,毕竟使用dynamic_cast是需要开销的。也就是说,如果从父类转到子类是安全的,也就是子类没有增加啥其他虚函数,那么转换会成功,倘若增加了其他的虚函数,就会导致转换失败。

dynamic_cast运算符的主要用途

1. 将基类的指针或引用安全地转换成派生类的指针或引用,并用派生类的指针或引用调用非虚函数。

2. 如果是基类指针或引用调用的是虚函数无需转换就能在运行时调用派生类的虚函数。

dynamic_cast怎么保证安全的?

首先,阐述一下使用dynamic_cast的原因:

1. static_cast 强制类型转换时并不具有保证类型安全的功能,而 C++ 提供的 dynamic_cast 却能解决这一问题,它可以在程序运行时检测类型转换是否类型安全。

如何保证的:

1. 本例中是要用基类对象地址去初始化派生类指针,显然是无法保证类型安全的,因此 p 最后得到的返回值是 0。

2. dynamic_cast 的转换规则是:

a. 只允许将指向派生类对象的指针转换为指向基类对象的指针。否则就会返回NULL.

b. 要求所转换的操作数必须包含多态类型。

c. dynamic_cast 的转换规则是:只允许将指向派生类对象的指针转换为指向基类对象的指针。否则的话,则会进行类型检查,确保转换安全。

3.4 reinterpret_cast的作用

答案

1. 用在任意的指针之间的转换。

2. 引用之间的转换。

3. 指针和足够大的int之间的转换。

4. 整数到指针之间的一个转换。

3.5 static_cast与dynamic_cast的区别?

答案

1. 编译时期的不同。static_cast是在编译时期强制转换,dynamic_cast在运行时期转换。

2. 类型检查的不同:static_cast是C的强制类型转换,不做检查。 而dynamic_cast会在运行时检查该转换是否类型安全,只在多态类型是合法。要转的类至少具有一个虚函数。(扩展:dynamic_cast在转换前会检查指针(或引用)所指向对象的实际类型是否与转换的目的类型兼容,如果兼容转换才会发生,才能得到派生类的指针(或引用),否则:如果执行的是指针类型的转换引用,会得到空指针;如果执行的是用引用类型的转换,会抛出异常。)(扩展2:在类层次间进行上行转换时,dynamic_cast和static_cast的效果是一样的;在进行下行转换时,dynamic_cast具有类型检查的功能,比static_cast更安全)

3. 是否可以转换对象:dynamic_cast可以转换指针和和引用(基类到派生类),不能用来转换对象。 而static_cast可以转换对象。

4. vector怎么删除重复的元素

答案

答案:sort->unique->erase

假如是一个数组,存在多个重复的元素。我们可以先用sort进行排序,然后用vector的erase(unique)删除掉重复的元素。unique返回的是重复元素的开始位置。

**注意**

>1. 算法unique能够移除重复的元素。每当在[first, last]内遇到有重复的元素群,它便移除该元素群中第一个以后的所有元素。

>2. unique只移除相邻的重复元素,如果你想要移除所有(包括不相邻的)重复元素,必须先将序列排序,使所有重复元素都相邻。

>3. unique会返回一个迭代器指向新区间的尾端,新区间之内不包含相邻的重复元素。

>4. 事实上unique并不改变元素个数,有一些残余数据会留下来,可以用erase函数去除。

> sort->unique->erase

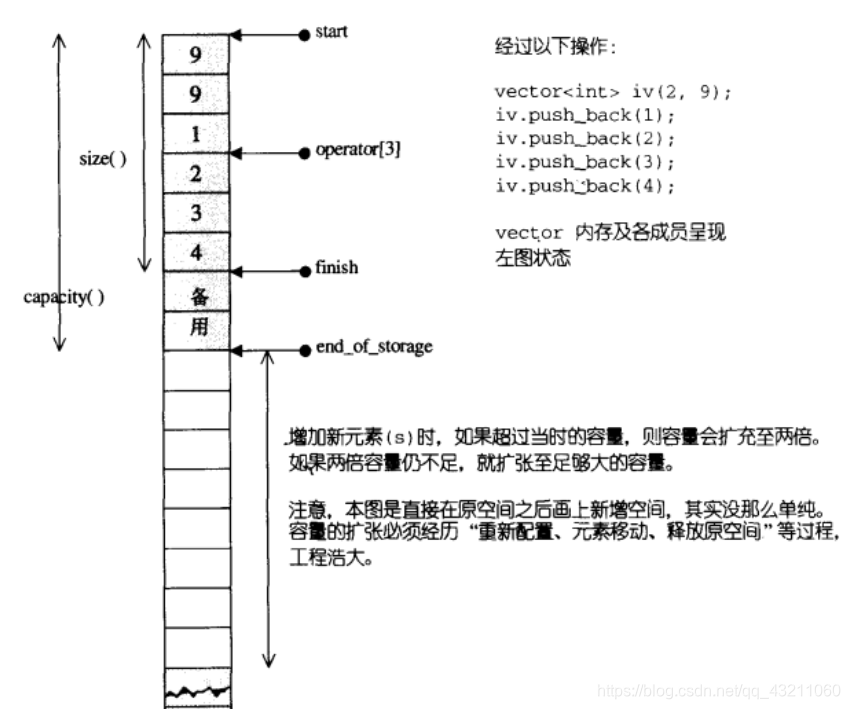

4.1 vector的底层原理?删除一个元素底层会做什么事情?

vector的底层源代码

template<class T, class Alloc = alloc>

class vector {

public:

typedef T value_type;

//vector中的迭代器就是一个指针

typedef value_type* iterator;

typedef value_type& reference;

typedef size_t size_type;

protected:

iterator start;

iterator finish;

iterator end_of_storage;

public:

iterator begin() { return start; }

iterator end() { return finish; }

size_type size() const

{

return size_type(end() - begin());

}

size_type capacity() const

{

return size_type(end_of_storage - begin());

}

bool empty() const { return begin() == end(); }

reference operator[](size_type n)

{

return *(begin() + n);

}

reference front() { return *begin(); }

reference back() { return *(end() - 1); }

}

void push_back(const T& x) {

//尚有备用空间

if (finish != end_of_storage) {

construct(finish, x);

++finish:

}

else //已经没有备用空间了

insert_aux(end(), x);

}

template <class T, class Alloc>

void vector<T, Alloc>::insert_aux(iterator position, const T& x) {

if ();

else {

const size_type old_size = size();

//如果原大小为0,则分配1;

//如果原大小不为0,则分配原大小的两倍

//前半段用来放原始数据,后半段准备用来放置新数据

const size_type len = old_size != 0 ? 2 * old_size : 1;

iterator new_start = data_allocator::allocate(len);

iterator new_finish = new_start;

try {

//将原vector的内容拷贝到新vector

new_finish = uninitialized_copy(start, position, new_start);

//为新元素设定初值

construct(new_finish, x);

++new_finish;

}

catch (...) {

}

}

}

vector所拥有的变量如下

template <class T, class Alloc = alloc>

class vector

{

protected:

iterator start;

// 目前使用的空间头

iterator finish;

// 目前使用的空间尾 i

iterator end_of_storage; // 目前可用的空间尾

}

答案

底层原理:一段连续线性内存空间。以上定义中迭代器start和finish之间是已经被使用的空间范围,end_of_storage是整块连续空间包括备用空间的尾部。end_of_storage存在的原因是为了降低空间配置的成本,vector实际分配空间大小的时候会比客户端需求的大一些,以便于未来的可能的扩展。

运用start,finish,end_of_storage三个迭代器,便可轻易地提供首尾标示、大小、容量、空容器判断、注标([])运算子、最前端元素值、最后端元素值…等机能:

4.2 vector 扩容的本质

答案

**重新申请,移动元素,释放空间**

需经历的步骤如下:

1. 完全弃用现有的内存,重新申请更大的内存空间。

2. 将旧内存空间中的数据,按原有顺序移动到新的内存空间中。

3. 最后将旧的内存空间释放。

4. 不同的编译器实现的扩容方式不一样,VS2015中以1.5倍扩容,GCC以2倍扩容。

4.3 vector的push_back()

源代码

void push_back(const T& x)

{

if(finish!=end_of_storage)

{

construct(finish,x);//把x这个元素放入finish这个位置

++finish;

}

else//如果已经没有备用空间了

{

insert_aux(end(),x);

}

}

template<class T,class Alloc>

void vector<T,Alloc>::insert_aux(iterator position,const T&x)

{

if(finish!=end_of_storage)//尚有备用空间

{

//在备用空间起始处建立一个元素,并以vector最后一个元素值为其初值

construct(finish,*(finish-1));

++finish;//调整水位

T x_copy = x;

copy_backward(position,finish-2,finish-1) ;

*posion = x_copy;

}

else//已无备用空间

{

const size_type old_size = size();

const size_type len = old_size!=0?2*old_size:1;

//以上分配原则,若原大小为0,则分配1.

//若原大小不为0,则分配原大小的两倍。

iterator new_start = data_allocator::allocate(len);

iterator new_finish = new_start;

try{

new_finish = uninitialized_copy(start,position,new_start);

construct(new_finish,x);

new_finish = uninitialized_copy(position,finish,new_finish);

}

catch(){

destroy(new_start,new_finish);

data_allocator::dealocate(new_start,len);

throw;

}

destroy(begin(),end());

deallocate();

start = new_start;

finish = new_finish;

end_of_storage = new_start+len;

}

}

4.4 vector的插入,删除

删除

对于序列式容器(vector、deque、list),删除当前的iterator会使后面所有元素的iterator都失效。这是因为vector,deque使用了连续分配的内存,删除一个元素导致后面所有的元素会向前移动一个位置。使用erase方法后,返回的是下一个有效的iterator。例如:

vector<int> val = { 1,2,3,4,5,6 };

vector<int>::iterator iter;

for (iter = val.begin(); iter != val.end(); ){

if (3 == *iter){

iter = val.erase(iter); //返回下一个有效的迭代器

} else {

++ iter;

}

}

vector的erase方法

iterator erase(iterator position){

if(position + 1 != end())

copy(position + 1, finish, position); //后序的元素向前移动

-- finish;

destory(finish);

return position;

}

vector的插入

//往某个位置插入一个元素,则这个位置之后的元素都要后移,因此后面的迭代器都会失效;如果引起内存的重新配置,所有的迭代器都将失效。

vector<int> val = { 1,2,3,4,5,6 };

vector<int>::iterator iter = val.begin();

val.insert(iter, 0);

for (iter = val.begin(); iter != val.end(); iter ++){

cout<<*iter<<" ";

}

}

4.5 emplace_back VS push_back

4.6 扩容会导致效率低下,那如何避免动态扩容呢?

答案

如果在插入之前,可以预估vector存储元素的个数,提前将底层容量开辟好即可。如果插入之前进行reserve,只要空间给足,则插入时不会扩容,如果没有reserve,则会边插入边扩容,效率极其低下。

4.7 为什么以1.5倍或者2倍的方式扩容,而不是使用等长扩容?

答案

计算结论:等长方式扩容后,push_back的时间复杂度为O(N)

以倍数方式进行扩容,push_back的时间复杂度为O(1)

所以选择倍数的方式进行扩容。

4.8 为什么选择以1.5倍或者2倍方式进行扩容?而不是3倍4倍扩容?

答案

1). 使用2倍(k=2)扩容机制扩容时,每次扩容后的新内存大小必定大于前面的总和。

2). 而使用1.5倍(k=1.5)扩容时,在几次扩展以后,可以重用之前的内存空间了。

4.9 vs为什么选择1.5倍,linux为什么选择2倍?

答案

1) vs为什么选择1.5倍

Windows中堆管理系统会对释放的堆块进行合并,因此:vs下的vector扩容机制选择使用1.5倍的方式扩容,这样多次扩容之后,就可以使用之前已经释放的空间。

2) linux为什么选择2倍

由于linux引入伙伴系统为内核分配连续的页,伙伴系统将整个内存区域构建成基本大小的basicSize的 1倍,2倍,4倍等,要求是2的整数次幂,因此,linux选用2倍的方式进行扩容,能快速的找到对应的内存块。

详细的讲解:

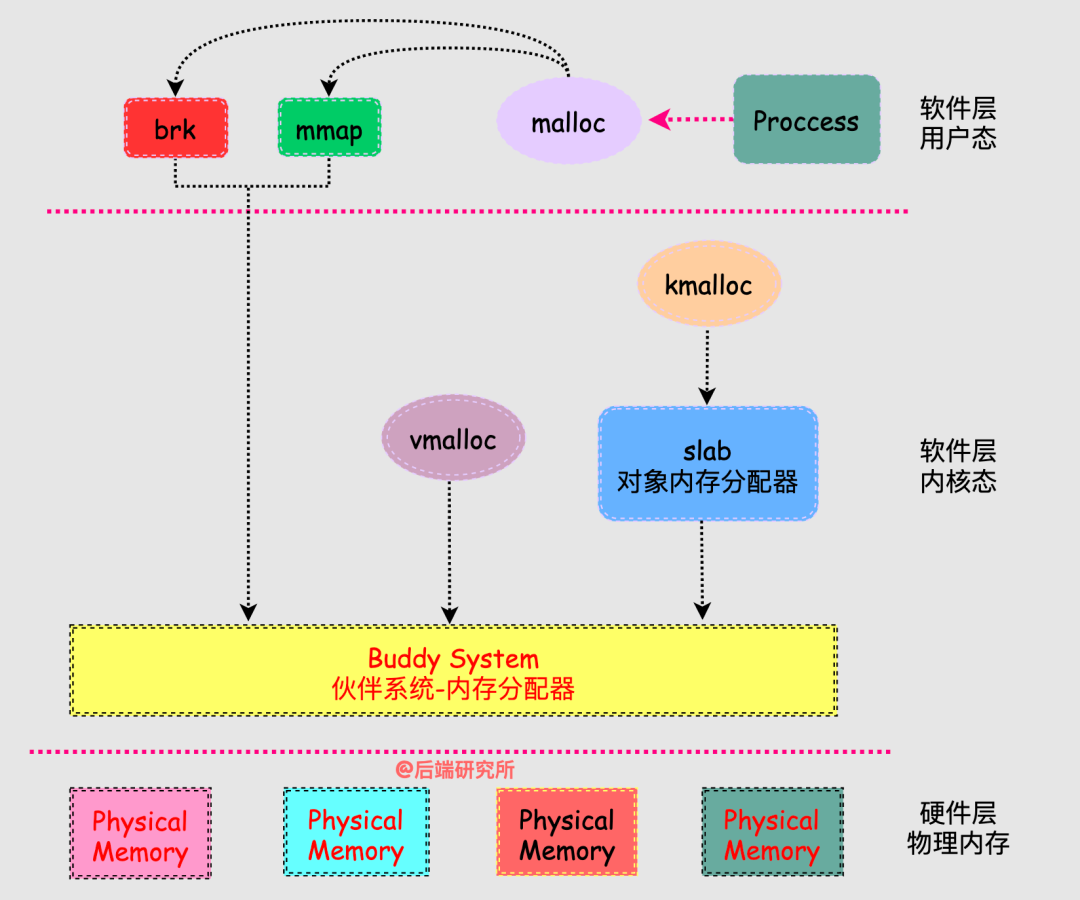

a. linux下主要使用glibc的ptmalloc来进行用户空间申请的.如果malloc的空间小于128KB,其内部通过brk()来扩张,如果大于128KB且arena中没有足够的空间时,通过mmap将内存映射到进程地址空间.

b. linux中引入伙伴系统为内核提供了一种用于分配一下连续的页而建立的一种高效的分配策略,对固定分区和动态分区方式的折中,固定分区存在内部碎片,动态分区存在外部碎片,而且动态分区回收时的合并以及分配时的切片是比较耗时的.

c. 伙伴系统是将整个内存区域构建成基本大小basicSize的1倍、2倍、4倍、8倍、16倍等,即要求内存空间分区链均对应2的整次幂倍大小的空间,整齐划一,有规律的而不是乱糟糟的。

d. 在分配和释放空间时,可以通过log2(request/basicSize)向上取整的哈希算法快速找到对应内存块。

e. 通过伙伴系统管理空闲分区的了解,可以看到在伙伴系统中的每条空闲分区链中挂的都是2i的页面大小,通过哈希思想进行空间分配与合并,非常高效。估计可能是这个原因SGI-STL选择以2倍方式进行扩容。

vector在push_back以成倍增长可以在均摊后达到O(1)的时间复杂度,相对于增长指定大小的O(n)时间复杂度更好。

为了防止申请内存的浪费,现在使用较多的有2倍与1.5倍的增长方式,而1.5倍的增长方式可以更好的实现对内存的重复利用。

5.深拷贝和浅拷贝

浅拷贝

浅拷贝:实体相同,值拷贝

**浅拷贝**:称值拷贝,将源对象的值拷贝到目标对象中(就是说对象的地址还是相同)去,本质上来说源对象和目标对象共用一份实体,只是所引用的变量名不同,地址其实还是相同的。

深拷贝

深拷贝:开辟空间,内容拷贝。

**深拷贝**:拷贝的时候先开辟出和源对象大小一样的空间,然后将源对象里的内容拷贝到目标对象中去,这样两个指针就指向了不同的内存位置。并且里面的内容是一样的,这样不但达到了我们想要的目的,还不会出现问题,两个指针先后去调用析构函数,分别释放自己所指向的位置。即为每次增加一个指针,便申请一块新的内存,并让这个指针指向新的内存,深拷贝情况下,不会出现重复释放同一块内存的错误。

6. LRU

LRU的简介、思路、算法逻辑

**简介**

LRU的全称为:Least Recently Used。最近最久未使用算法,它是页面置换算法的一种。

LRU 算法根据数据的历史访问记录来进行淘汰数据,其核心思想是「如果数据最近被访问过,那么将来被访问的几率也更高」。实现的方式还是很难的,如果不会就只能作罢了。

**思路**

map存储数据,实现查找效率为O(logN),双向链表实现算法逻辑。

**算法逻辑**

>1. 新数据会插入到链表的头部

>2. 当缓存数据被访问时,将该缓存数据移到链表的头部。

>3. 当新数据插入时,达到缓存上限了,将尾部数据删除掉,新数据放在头部。

源代码

#include <iostream>

#include <map>

using namespace std;

struct LinkNode

{

int m_key;

int m_value;

ListNode* pre;

ListNode* next;

ListNode(int key, int value)

{

m_key = key;

m_value = value;

pre = NULL;

next = NULL;

}

}//* LRU缓存实现类 双向链表。

class LRUCache

{

public:

LRUCache(int size)

{

m_capacity = size;

phead = NULL;

pTail = NULL;

}

~LRUCache()

{

map<int, ListNode*>::iterator it = mp.begin();

for (; it != mp.end();)

{

delete it->second;

it->second = NULL;

mp.erase(it++);

}

delete phead;

phead = NULL;

delete pTail;

pTail = NULL;

}//** 这里只是移除,并不删除节点

void Remove(ListNode* pNode) {

// 如果是头节点

if (pNode->pPre == NULL)

{

pHead = pNode->pNext;

pHead->pPre = NULL;

}

// 如果是尾节点

if (pNode->pNext == NULL)

{

pTail = pNode->pPre;

pTail->pNext = NULL;

}

else

{

pNode->pPre->pNext = pNode->pNext;

pNode->pNext->pPre = pNode->pPre;

}

}

// 将节点放到头部,最近用过的数据要放在队头。

void SetHead(ListNode* pNode)

{

pNode->pNext = pHead;

pNode->pPre = NULL;

if (pHead == NULL)

{

pHead = pNode;

}

else

{

pHead->pPre = pNode;

pHead = pNode;

}

if (pTail == NULL)

{

pTail = pHead;

}

}

// * 插入数据,如果存在就只更新数据

int Set(int key, int value)

{

map<int, ListNode*>::iterator it = mp.find(key);

if (it != mp.end())

{

ListNode* Node = it->second;

Node->m_value = value;

Remove(Node);

SetHead(Node);

}

else

{

ListNode* NewNode = new ListNode(key, value);

if (mp.size() >= m_capacity)

{

map<int, ListNode*>::iterator it = mp.find(pTail->m_key);

//从链表移除

Remove(pTail);

//删除指针指向的内存

delete it->second;

//删除map元素

mp.erase(it);

}

//放到头部

SetHead(NewNode);

mp[key] = NewNode;

}

}

//获取缓存里的数据

int Get(int key)

{

map<int, ListNode*>::iterator it = mp.find(key);

if (it != mp.end())

{

ListNode* Node = it->second;

Remove(Node);

SetHead(Node);

return Node->m_value;

}

else

{

return -1; //这里不太好,有可能取得值也为-1

}

}

int GetSize()

{

return mp.size();

}

private:

int m_capacity; //缓存容量

ListNode* pHead; //头节点

ListNode* pTail; //尾节点

map<int, ListNode*> mp; //mp用来存数据,达到find为O(logN)级别。

};

7.1 静态多态和动态多态是如何实现的?

静态多态的实现方式:

静态多态性是通过**重载**实现的,在程序编译时系统就可以确定调用哪个函数,因此也称为编译时的多态性.

1. 函数重载: 包括普通函数的重载和成员函数的重载。**重载函数的关键**是函数参数列表——也称函数特征标。包括:**函数的参数数目和类型,以及参数的排列顺序**。所以,重载函数与返回值,参数名无关。

2. (泛型编程)函数模板的使用.函数模板是通用的函数描述,也就是说,使用泛型来定义函数,其中泛型可用具体的类型(int 、double等)替换。通过将类型作为参数,传递给模板,可使编译器生成该类型的函数。

3. 运算符重载。

动态多态是如何实现的?

答案

动态多态性则是通过虚函数实现的,在程序运行时才能决定操作的对象,因此也被称为运行时的多态性。程序运行到动态绑定时,通过该指针所指向的对象类型,通过vtpr找到虚函数表,然后调用相应的方法,即可实现多态。

示例

#include <iostream>

using namespace std;

class Base

{

public:

virtual void Print() = 0;

virtual ~Base();

}

class child_1 :public Base {

public:

void Print()

{

cout << "--->child1";

}

}class child_2 :public Base

{

public:

void Print()

{

cout << "---> child2";

}

}

int main()

{

Base* p = new Child_1();

p->Print();

delete p;

p = new Child_2();

p->Print();

p = NULL;

return 0;

}

编译器如何判断一个函数是否是虚函数?

答案

方法:该函数的最前面有virtual进行声明。就会为其搞一个虚函数表,也就是VTABLE。

VATBLE的介绍:

VTABLE实际上是一个函数指针的数组,每个虚函数占用这个数组的一个slot。一个类只有一个VTABLE,不管它有多少个实例。派生类有自己的VTABLE,但是派生类的VTABLE与基类的VTABLE有相同的函数排列顺序,同名的虚函数被放在两个数组的相同位置上。在创建类实例的时候,编译器还会在每个实例的内存布局中增加一个vptr字段,该字段指向本类的VTABLE。通过这些手段,编译器在看到一个虚函数调用的时候,就会将这个调用改写。

7.1_1 为什么C语言中没有重载呢?

答案

答案:由于C与C++函数在内部对函数名字的不同修饰方式,决定了C语言是没有重载的。

编译器在编译期间创建的一个字符串,用来指明函数的定义或原型。C和C++程序的函数在内部使用不同的名字修饰方式。

**C编译器的函数名修饰规则:**

1. 对于__stdcall调用约定,编译器和链接器会在输出函数名前加上一个下划线前缀,函数名后面加上一个“@”符号和其参数的字节数,例如_functionname@number。

2. __cdecl调用约定仅在输出函数名前加上一个下划线前缀,例如_functionname。

3. __fastcall调用约定在输出函数名前加上一个“@”符号,后面也是一个**“@”符号和其参数的字节

例如@functionname@number。

**C++编译器的函数名修饰规则:**

C++的函数名修饰规则有些复杂,但是信息更充分,通过分析修饰名不仅能够**知道函数的调用方式,返回值类型,参数个数甚至参数类型。

不管 __cdecl,__fastcall还是__stdcall调用方式,函数修饰都是以一个“?”开始,后面紧跟函数的名字,再后面是参数表的开始标识和 按照参数类型代号拼出的参数表。

对于__stdcall方式,参数表的开始标识是“@@YG”,

对于__cdecl方式则是“@@YA”,

对于__fastcall方式则是“@@YI”。参数表的拼写代号如下所示:

7.2 多态性指的是什么?(什么是多态)

答案

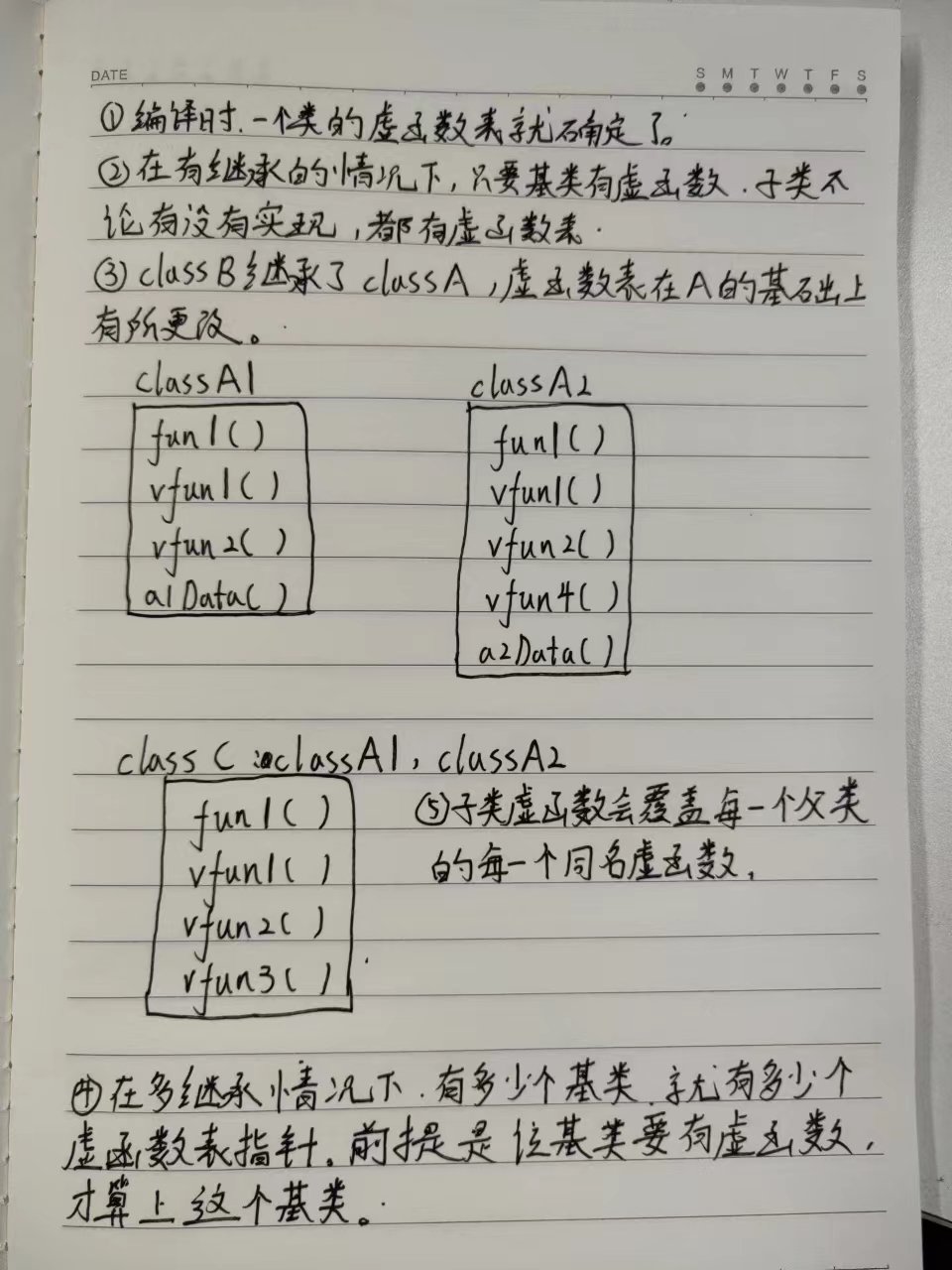

1. 在有继承情况下,只要基类有虚函数,子类不论实现或没实现,都有虚函数表。

2. 在多继承情况下,有多少个基类就有多少个虚函数表指针,前提是基类要有虚函数才算上这个基类。

ClassA* a = new ClassC;

a->func1(); // "ClassA::func1()" 隐藏ClassB::func1()

a->func2(); // "ClassA::func2()" 隐藏ClassC::func2()

a->vfunc1(); // "ClassB::vfunc1()" ClassB把ClassA::vfunc1()覆盖了

a->vfunc2(); // "ClassC::vfunc2()" ClassC把ClassA::vfunc2()覆盖了

ClassB* b = new ClassC;

b->func1(); // "ClassB::func1()" 有权限操作时,子类优先

b->func2(); // "ClassA::func2()" 隐藏ClassC::func2()

b->vfunc1(); // "ClassB::vfunc1()" ClassB把ClassA::vfunc1()覆盖了

b->vfunc2(); // "ClassB::vfunc2()" ClassC把ClassA::vfunc2()覆盖了

答案

答: 其实多态就是在运行时根据对象的实际类型调用相应的函数。

**说法一**:

1. 多态性指的是相同对象在接收不同消息 或 不同对象接收相同消息产生不同的实现动作。

2. 多态支持运行时多态和编译时多态。编译时多态是由子类的重载所实现的,而运行时多态是由虚函数实现的。多态的目的是为了代码模块化和接口重用。

**说法二**:

(运行时多态)在基类的函数前加上virtual关键字,在派生类中重写该函数,运行时将会根据对象的实际类型来调用相应的函数。如果对象类型是派生类,就调用派生类的函数;如果对象类型是基类,就调用基类的函数。

**说法三**:

多态按字面来理解就是多种形态。当类之前存在层次结构,并且类之间是通过继承关联的,就会用到多态。C++多态意味着在调用成员函数时,会根据调用函数的对象的类型来执行不同的函数。

7.3 使用多态的过程中应注意什么点?

答案

1. 构造函数中不能使用虚函数。因为我们在创建一个对象时是需要知道该对象的类型的,而虚函数的特性就是在运行时才能确定对象的类型。

2. 析构函数则必须用多态,否则在调用析构函数时,没办法根据调用对象的类型调用相应的析构函数,有写对象的内存有可能不会被释放。

7.4. 讲一下对多态的理解(多态有哪些实现方式?)

答案

**概念**

首先,多态的实现方式分为两种:重载(静态多态),重写(动态多态)。

**重载**是在相同作用域内,函数名相同,**形参个数或类型或顺序**不同的实现方式。这是一种静态多态,即其作用的函数是在编译时就确定了的。

**重写**是在不同的作用域内,即要求一个在父类,而一个在子类,这两个函数的函数名,以及形参个数,类型都必须相同。这是一种动态多态,只有当程序运行的时候,才能确定是哪个函数。

**重定义**是指在不同的作用域内,即一个在父类,一个在子类中,只要不构成重写,则为重定义。换种说法是,子类中重定义的函数在父类也有一个同名的函数,只不过,父类的该函数并不是虚函数。

7.5 C++虚函数的实现原理(底层结构)

答案

答:实现原理是虚函数表。虚函数表是一个存储类成员函数指针的数据结构,因此在运行时,通过该数据结构,来确定要调用的是基类的函数还是子类的函数。

每一个含有虚函数的类都至少有一个与之对应的虚函数表,其中存放着该类所有的虚函数对应的指针。

**实现原理**

1. 当类中存在虚函数时,编译器会再类中自动生成一个**虚函数表。**

2. 虚函数表是一个存储类成员函数指针的数据结构。

3. 虚函数表由表一起自动生成和维护。

4. virtual修饰的成员函数会被编译器放入虚函数表中。

5. 存在虚函数时,编译器会为对象自动生成一个指向虚函数表的指针(通常称为vptr)

**具体的一个实现过程**

1. 父类的fun()是个虚函数,所以编译器会跟父类对象自动添加了一个vptr指针,来指向父类的虚函数表,这个虚函数表存放了父类的fun()函数的指针。

2. 子类的fun()函数是重写了父类的,所以无论写不写virtual,编译器都会给子类对象添加一个virtual和vptr指针,指向子类的虚函数表,这个虚函数表存放了子类fun()函数的函数指针。

3. 指向p->fun()时,编译器会检测到fun()是一个虚函数,所以会**在运行时,动态的根据指向的对象,找到这个对象的vptr,然后找到这个对象的虚函数表,最后调用虚函数表里对应的函数,从而实现多态**

4. 虚函数表存放在可执行文件的.rodata数据段之中。

7.5_1 函数指针与指针函数

函数指针

定义

定义1:

函数指针是指向函数的指针变量,即本质上是一个指针变量。

定义2:

一个函数在编译时被分配一个入口地址,将这个入口地址称为函数的指针,可以用一个指针变量指向该函数指针,然后通过该变量调用函数。

函数指针的声明格式:

函数返回值类型 (*指针变量名)(参数类型列表)

int (*f) (int x); /* 声明一个函数指针 */

f=func; /* 将func函数的首地址赋给指针f */

其实这里不能称为函数名,应该叫做指针的变量名,这个特殊的指针指向函数的地址

int max(int x, int y)

{

return x > y ? x : y;

}

int (* p)(int, int) = & max; // &可以省略,这里的p就是函数指针。

定义3:typedef uint8_t (*func_ptr) (void);

这里是把定义了一个别名叫(*func_ptr) (void) 的吗,显然不对,其含义是:

上面的例子定义func_ptr是一个函数指针, 函数类型是不带形参, 返回参数是uint8_t。

要定义的类型是uint8_t (*)(void),没有输入参数,返回值为uint8_t 的函数指针,定义的别名是func_ptr。

在分析这种形式的定义的时候可以这样看:先去掉typedef和别名, 剩下的就是原变量的类型。去掉typedef和func_ptr以后就剩:uint8_t (*)(void)。

指针函数

答案

类型标识符 *函数名(参数表) int *f(x,y);

指针函数是指带指针的函数,即本质是一个函数.

首先它是一个函数,只不过这个函数的返回值是一个地址值。指针函数一定有函数返回值,而且在主调函数中,函数返回值必须赋给同类型的指针变量。

注意指针函数与函数指针表示方法的不同,千万不要混淆。

最简单的辨别方式

就是看函数名前面的指针*号有没有被括号()包含,如果被包含就是**函数指针**,反之则是**指针函数**。

7.6 虚函数的使用场景

答案

1. 在有继承关系的类中,析构函数最好使用虚函数。

2. 虚函数的作用是在一个类函数的调用无法在编译时刻确定,必须在运行时刻确定时,应该声明其为虚函数。

7.7. 哪些C++成员函数不能用多态

什么样的函数不能被声明为虚函数?

> 1. **普通函数**:不属于成员函数,是不能被继承的。普通函数只能被重载,不能被重写。因此声明为虚函数没有意义。因为编译器会在编译时绑定函数。而多态体是在运行时绑定,通常通过基类指针子类对象实现绑定。

> 2. **友元函数**:不属于类的成员函数,不能被继承,对于没有继承特性的函数没有虚函数的说法。友元函数

> 3. **构造函数**:a.构造函数时用来初始化对象的,例如,子类可以继承基类的构造函数,那么子类对象得到构造将使用基类的构造函数,而基类构造函数并不知道子类有什么成员,所以不能使用继承。b.另一个角度是,多态是通过基类指针指向子类对象来实现多态的,在对象构造之前并没有对象产生,因此无法使用多态,这是矛盾的。

> 4. **内联成员函数**:该函数的作用是为了在代码中直接展开,减少函数调用的代价。也就是内联函数时在编译时展开的。在编译的时候,将这个内联函数的代码副本放置在每个调用该函数的地方。而多态,是在运行时绑定的,所以显然,相互违背。

> 5. **静态成员函数**:该函数理论上是可继承的。但静态成员函数是在编译时确定的,无法动态绑定。不支持多态。

1)static成员不属于任何类对象或类实例,所以即使给此函数加上virtual也是没有任何意义的。

2)静态与非静态成员函数之间有一个主要的区别。那就是静态成员函数没有隐藏的this指针。对于虚函数,它的调用恰恰需要this指针。在有虚函数的类实例中,this指针调用vptr指针,vptr找到vtable(虚函数列表),通过虚函数列表找到需要调用的虚函数的地址。总体来说虚函数的调用关系是:this指针->vptr->vtable ->virtual虚函数。所以说,static静态函数没有this指针,也就无法找到虚函数了

> 6. **成员函数模板**: 不能是虚函数。因为c++ 编译器在解析一个类的时候就要确定虚函数表的大小,如果允许一个虚函数是模板函数,那么compiler就需要在parse这个类之前扫描所有的代码,找出这个模板成员函数的调用(实例化),然后才能确定vtable的大小,而显然这是不可行的,除非改变当前compiler的工作机制。因为类模板中的成员函数在调用的时候才会创建

7.9 可以在C++的成员函数里调用delete this?

答案

1. 在类的成员函数中能调用delete this 吗?

可以,但要注意,在delete this之后,当调用delete this时,类对象的内存空间被释放。不能再涉及这个对象的数据成员和虚函数。

原因是:类对象在声明之后,系统会分配内存空间,这个内存空间中存有的数据是:数据成员和虚函数表指针。

所以,一旦delete this的话,该内存空间被释放,那么就不能再操作数据成员以及调用虚函数了。但按理说是应该程序崩溃的,可实际上,会出现不可告知的情况。因为该内存空间被释放,并不一定会马上被回收。所以,会出现不可预期的情况。

2. 在类的析构函数中调用delete this会发生什么情况?

会出现堆栈溢出的情况,因为delete本身就会去调用析构函数,所以是不断的循环调用该类的析构函数。

7.10 C++的=delete表示的含义是什么?

答案

当我们定义一个类的成员函数时,如果后面使用"=delete"去修饰,那么就表示这个函数被定义为deleted,也就意味着这个成员函数不能再被调用,否则就会出错。

int func(int data)=delete;

在C++11之前,我们不希望一个类被拷贝,就会把构造函数定义为private,但在。

8、问题:const的作用有哪些,谈谈你对const的理解

1. const的相关概念?

1_1. 什么是const?

答案

const是用来修饰常类型的类型修饰符,常类型的对象和变量的值不能更新的。const修饰的值并不是真的常量,它只是告诉编译器该变量不能出现在赋值符号的左边。

1_2. 为什么引入const(const的作用)?

答案

为了替换预处理指令,摒弃其缺点(无法进行类型检查),继承其优点,并发扬光大.

1_3. const修饰的变量的存储位置?

C语言:

答案

1. const全局变量最初在编译器是保存在符号表的,但在第一次使用的时候,为其分配内存,将其保存在只读数据段。不可通过指针对const全局变量进行修改。

2. const局部变量(在函数中定义的const变量) 存储在栈中,代码块结束时释放。可通过指针对const局部变量进行修改。

C++:

答案

**const全局变量**:

1. 若只是简单的替换值,那么就不分配内存空间。 不过若要对其取地址或是使用extern时,就要对其分C++11里面,我们就可以在构造函数后加上=delete来修饰下就可以了配内存。 存储在只读数据段,也是不能修改的。

**const局部变量**:

1. 对于`const int a= 10;`这种,编译器会将其放入符号表中,不分配内存,只有当对其取地址的时候,会分配内存。

2. 若用一个变量来初始化const变量的话,如`const int a = b;`,则会分配内存。一般就是分配在栈中。

1_4. const的作用?

答案

1. 为了替换预处理指令,摒弃其缺点(无法进行类型检查),继承其优点,并发扬光大.

2. 便于类型检查,消除隐患。

3. 可以避免意义模糊的数字出现,同时可以很方便的进行参数的调整和修改。

4. 可以保护被修饰的东西,防止意外的修改。可以修饰常量,变量,函数形参,函数返回值,类等。若const修饰的是对象(常对象),则该对象只能调用const 成员(包括成员函数或成员变量).若const修饰的是引用(常引用),则引用所引用的对象不能被更新。

5. 可以节省内存空间。

6. 可以提高效率。编译器通常不为普通const常量分配存储空间,而是将其保存在符号表中,这使其成为一个编译时期的常量,没有了存储于读内存的操作。

1_5. C语言的const存在的隐患

答案

如果在C语言中,用const定义了一个常量。那么按理说,应该该值是不可更改的,可实际上,是可以通过指向一个变量地址的指针去指向它,然后通过*p1去健个修改b的值。

1_6. const的实战用途

答案

1. 对变量来说:防止一个变量被更改。

2. 对指针来说:可以防止指针被修改,可以防止指针指向的对象被修改。

3. 对函数形参来说: 修饰函数形参,表明它是一个输入参数,在函数内部不能改变其值。

4. 对类的成员函数来说: 若指定该函数为const,则表明其实一个常函数,不能修改类的成员变量。

5. 对成员函数的返回值来说: 若指定返回值为const,则该返回值就不是一个左值。

2. const如何修改

答案

1. 方法一:在const前面加上volatile.

2. 方法二:通过创建一个指针,通过显式类型转换,获取a变量的地址。

3. const常见例子

例子1

1. const int a;//a是一个常整型数

2. int const a;//a是一个常整型数

3. const int *a;//a是一个指向常整型数的指针(也就是,整型数是不可修改的,但指针可以)

4. int *const a;//a是一个指向整 型数的常指针(也就是说,指针指向的整型数是可以修改的,但指针是不可修改的)

5. int const *a const;//a是一个指向常整型数的常指针(也就是说,指针指向的整型 数是不可修改的,同时指针也是不可修改的)

例子2

// 类

class A

{

private:

const int a; // 常对象成员,可以使用初始化列表或者类内初始化

public:

// 构造函数

A() : a(0) { };

A(int x) : a(x) { }; // 初始化列表

// const可用于对重载函数的区分

int getValue(); // 普通成员函数

int getValue() const; // 常成员函数,不得修改类中的任何数据成员的值

};

void function()

{

// 对象

A b; // 普通对象,可以调用全部成员函数

const A a; // 常对象,只能调用常成员函数

const A *p = &a; // 指针变量,指向常对象

const A &q = a; // 指向常对象的引用

// 指针

char greeting[] = "Hello";

char* p1 = greeting; // 指针变量,指向字符数组变量

const char* p2 = greeting; // 指针变量,指向字符数组常量(const 后面是 char,说明指向的字符(char)不可改变)

char* const p3 = greeting; // 自身是常量的指针,指向字符数组变量(const 后面是 p3,说明 p3 指针自身不可改变)

const char* const p4 = greeting; // 自身是常量的指针,指向字符数组常量

}

// 函数

void function1(const int Var); // 传递过来的参数在函数内不可变

void function2(const char* Var); // 参数指针所指内容为常量

void function3(char* const Var); // 参数指针为常量

void function4(const int& Var); // 引用参数在函数内为常量

// 函数返回值

const int function5(); // 返回一个常数

const int* function6(); // 返回一个指向常量的指针变量,使用:const int *p = function6();

int* const function7(); // 返回一个指向变量的常指针,使用:int* const p = function7();

9. 宏的相关概念

9_1. define的作用?

答案

1. 避免了意义模糊的数字出现。

2. 便于修改

3. 有了提高程序的运行时效率,减少程序运行时的函数调用,就可以提高程序的运行时效率了。

9_2.#define 宏函数,为什么能够提高性能?

答案

首先,有几个概念:

1.函数调用在编译后程序运行时进行,分配内存空间。函数调用占运行时间

2.宏替换在编译前进行,不分配内存,宏展开不占运行时间,只占编译时间。

也就是我的宏替换,就是做到了上面的两点,所以,我提升了运行效率。

首先,函数调用的功能,宏替换可以实现,例如:

#define S(a,b) a*b

这个就可以代替函数调用了。并且,这个还实现了第二点,所以提高了性能。

但有三个缺点

1. 如果目标代码空间较大的话,不建议使用宏替换,否则空间和时间都获取不到。

2. 不方便调试

3. 宏定义只是简单的值替代,缺乏类型的检测机制。

9_3. typedef和define有什么区别

答案

1. 功能不同。

typedef不是简单的替换,而是起一个类型的别名。

define只是简单的替换,可以定义常量,变量,编译开关等。

2. 作用域不同。

typedef 若在函数外定义,则作用域只有当前文件,若在函数内定义,则作用域只有该函数。

#define,无论是在函数内还是在函数外,作用域都是从定义开始到整个文件结尾。

3. 执行阶段不同。

#define是在预处理阶段进行处理的。

typedef是在编译阶段进行处理的。

4. 对指针的操作不同:这里属于严重不同,要注意,虽然都是用pint 代替int * 但是,但是typedef 相当于是一个别名

typedef int * pint;

#define PINT int *

int i1 = 1, i2 = 2;

const pint p1 = &i1; //p不可更改,p指向的内容可以更改,相当于 int * const p;

const PINT p2 = &i2; //p可以更改,p指向的内容不能更改,相当于 const int *p;或 int const *p;

9_4 do {...} while (0) 在宏定义中的作用

答案

担心这样的宏->#define foo(x) bar(x); baz(x)

这样的宏,如果没手动做一个do while循环,很可能最终的结果与我们期望的结果大相径庭。

do能确保大括号里的逻辑能被执行,而while(0)能确保该逻辑只被执行一次,即与没有循环时一样。

10. 谈一下对static的理解?

10_1. 说一下static的作用(static使用的场所).

答案

1. 隐藏。所有未加static前缀的全局变量和函数都具有全局可见性。加了static,则将该全局变量或函数限制在该文件中,对其他文件不可见。

2. 延长局部变量的生命周期,只初始化一次,直到程序运行结束以后才释放。原因是:静态变量在全局数据区中分配内存,直到程序运行结束,才释放内存.

10_2. static的用法?

答案

1、被 static 修饰的变量属于类变量,可以通过类名.变量名直接引用,而不需要 new 出一个类来。

2. 被 static 修饰的方法属于类方法,可以通过类名.方法名直接引用,而不需要 new 出一个类来

10_3. 静态资源的特性(静态资源与非静态资源之间的相互调用问题)

答案

从类的加载机制的角度讲,静态资源时类初始化的时候加载的,而非静态资源时类实例化对象的时候加载的。

1)静态方法能不能引用非静态资源?不能,实例化对象的时候才会产生的东西,对于初始化后就存在的静态资源来说,根本不认识它。

2)静态方法里面能不能引用静态资源?可以,因为都是类初始化的时候加载的,大家相互都认识。

3)非静态方法里面能不能引用静态资源?可以,非静态方法就是实例方法,那是实例化对象之后才产生的,那么属于类的内容它都认识。

4) 静态数据成员可以实现多个对象之间的数据共享,它是类的所有对象的共享成员。只占用一份内存。

5) 静态数据成员既可以通过类引用,也可以通过对象名引用。

6) 非静态成员函数有 this 指针,而静态成员函数没有 this 指针。

11. C语言中的const和static的比较分析?

答案

1. 修饰局部变量

const修饰的局部变量,其存储位置在栈上。但有个特例:const static修饰的局部变量是存储在只读存储区的。

static修饰的局部变量,会将局部变量由栈转到静态区存储。

2. 修饰全局变量

const修饰的全局变量,其存储位置转移到只读存储区了。且,作用域变了。

static修饰的全局变量,依然存储在静态区,只是,作用域变了。

12. extern函数的作用(请你谈谈你对extern的理解)3点?

答案

引用不在同一个文件中的变量或者函数。这样就不必特意包含某个文件。

1. extern表示后面的变量或函数的定义在别的文件中。提升编译器遇到此变量或函数时,在其他模块寻找其定义。

2. extern "C" 用于C++中,用于将C++的一些代码用C语言的方式编译。

3. extern是声明变量,并不是定义,所以并不会分配空间。

4. 如果在一个文件中需要引用另一个文件中的外部变量,则用extern修饰这个外部变量。

13. c++类内常量定义 static const?

答案

1. static const:

·`static const int SIZE = 10;`int/char/bool等。//类内声明,同时初始化,仅适用整型变量,要想对变量进行取地址,必须在实 现文件中再次声明。

· `static const double pi;`//对于非整型变量,只能声明,不能设定初始值。

2. static:对于类内static变量,仅能在头文件中声明,在实现文件进行初始化。

`static int SIZE;`//仅声明,不能初始化。

3. const:对于const 变量,在类内声明必须初始化。

`const int SIZE2 = 9;`//const类型,声明时必须设定初始值

`const doubel pii = 2.6;`//const类型,声明时必须设定初始值

4. enum:类内使用枚举定义常量,不能对常量取地址。

`enum{SIZE3=10;} // 类内使用枚举定义常量,不能对变量取地址

14. 海量数据处理面试题

- 海量日志数据,提取出某日访问百度次数最多的那个IP

答案

a. IP最多2^32次方。直接存入内存hash。

b. 将所有IP存入一个大文件中。使用%1000的方式。分成1000个小文件。然后对每个小文件进行hash映射。接下来,取每个小文件中出现次数最多的ip再进行一次hash就可以了。

- 假设目前有一千万个记录(这些查询串的重复度比较高,虽然总数是1千万,但如果除去重复后,不超过3百万个。一个查询串的重复度越高,说明查询它的用户越多,也就是越热门。),请你统计最热门的10个查询串,要求使用的内存不能超过1G。

答案

a. 在O(N)的时间内对所有数据进行hash处理。去掉大部分重复的记录。

b. 然后维护一个10个元素的大顶堆结构,时间复杂度为O(NLOGK).

所以,总的时间复杂度为:O(N)+O(NLOGK).

- 有一个1G大小的一个文件,里面每一行是一个词,词的大小不超过16字节,内存限制大小是1M。返回频数最高的100个词。

答案

a. 先将1G的大文件分解成5000个小文件。这样每个文件大约是200k。如果超过内存限制的话,继续分。

b.然后可以采用hash 。

- 在2.5亿个整数中找出不重复的整数,注,内存不足以容纳这2.5亿个整数。

答案

a. 使用2 bit-map。(每个数分配两个bit,00表示不存在,01表示出现一次,10表示出现多次,11无意义)然后,扫描这2.5亿整数,查看其对应的位。

b. 进行%1000. 可以分别存入1000个文件中。

14.1Top(K)一般处理方式

答案

1、直接全部排序(只适用于内存够的情况)

当数据量较小的情况下,内存中可以容纳所有数据。

则最简单也是最容易想到的方法是将数据全部排序,然后取排序后的数据中的前K个。

这种方法对数据量比较敏感,当数据量较大的情况下,内存不能完全容纳全部数据,这种方法便不适应了。即使内存能够满足要求,该方法将全部数据都排序了,而题目只要求找出top K个数据,所以该方法并不十分高效,不建议使用。

2、快速排序的变形 (只使用于内存够的情况)

这是一个基于快速排序的变形,因为第一种方法中说到将所有元素都排序并不十分高效,只需要找出前K个最大的就行。

这种方法类似于快速排序,首

先选择一个划分元,将比这个划分元大的元素放到它的前面,比划分元小的元素放到它的后面,此时完成了一趟排序。

如果此时这个划分元的序号index刚好等于K,那么这个划分元以及它左边的数,刚好就是前K个最大的元素;如果index > K,那么前K大的数据在index的左边,那么就继续递归的从index-1个数中进行一趟排序;如果index < K,那么再从划分元的右边继续进行排序,直到找到序号index刚好等于K为止。

再将前K个数进行排序后,返回Top K个元素。这种方法就避免了对除了Top K个元素以外的数据进行排序所带来的不必要的开销。

3、最小堆法

这是一种局部淘汰法。先读取前K个数,建立一个最小堆。然后将剩余的所有数字依次与最小堆的堆顶进行比较,如果小于或等于堆顶数据,则继续比较下一个;否则,删除堆顶元素,并将新数据插入堆中,重新调整最小堆。当遍历完全部数据后,最小堆中的数据即为最大的K个数。

4、分治法

将全部数据分成N份,前提是每份的数据都可以读到内存中进行处理,找到每份数据中最大的K个数。此时剩下N*K个数据,如果内存不能容纳N*K个数据,则再继续分治处理,分成M份,找出每份数据中最大的K个数,如果M*K个数仍然不能读到内存中,则继续分治处理。直到剩余的数可以读入内存中,那么可以对这些数使用快速排序的变形或者归并排序进行处理。

5、Hash法

如果这些数据中有很多重复的数据,可以先通过hash法,把重复的数去掉。这样如果重复率很高的话,会减少很大的内存用量,从而缩小运算空间。处理后的数据如果能够读入内存,则可以直接排序;否则可以使用分治法或者最小堆法来处理数据。

14.2海量日志处理,提取出日访问百度次数最多的IP地址

答案

**算法思想:分而治之+hash**

首先,将IP地址%1024。将这些ip地址分别放入1024个小文件中。这样每个小文件就包含有4MB个 IP地址,

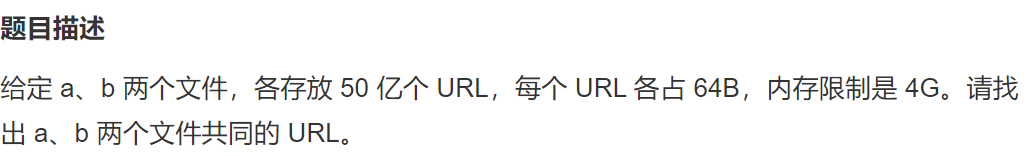

14.3 如何从 100 亿 URL 中找出相同的 URL?

题目

答案

1. 50 0000 0000 *64B = 5*64GB = 320GB

2. 遍历文件a。执行`hash(URL) % 1000`。根据计算结果把遍历到的 URL 存储到 a0, a1, a2, ..., a999。

3. 遍历文件b。执行`hash(URL) % 1000`。根据计算结果把遍历到的 URL 存储到b0, b1, b2, ..., b999。

4. 这样所有相同的URL都一定在对应的小文件里面。比如a0->b0

5. 接下来遍历ai。把 URL 存储到一个 HashSet 集合中。然后遍历 bi 中每个 URL,看在 HashSet 集合中是否存在,若存在,说明这就是共同的 URL,可以把这个 URL 保存到一个单独的文件中。

**方法总结**

1. 分而治之,进行哈希取余;

2. 对每个子文件进行 HashSet 统计。

14.4 位图法

答案

位图法就是bitmap的缩写,所谓bitmap,就是用每一位来存放某种状态,适用于大规模数据,但数据状态又不是很多的情况。 通常是用来判断某个数据存不存在的。

1. 海量数据排序

从最简单的情况说起,如果要对90个小于100的不重复的正整数排序。用位图的思想就是先申请一块100bit的空间,第一遍遍历所有的数,将出现的数字在位图中对应的位置置为1;第二遍遍历位图,依次输出值为1的位对应的数字。先且不说这种情况出现的频率不是很高,就仅这种情况,还是有很多其他的排序算法有它们自己的优势(不用额外占用空间之类)。但更进一步,如果我们把数字范围放大,对1000,000,000中的900,000,000个不重复的正整数排序,由于需要的内存非常大,其他算法在不分治的情况下就很难再处理这个问题。而用位图法只需要1000000000/(8*1024*104)=119.2MB空间,对现在的计算机来说没有任何问题。

2. 海量数据去重

看一个比较常见的面试题:在2.5亿个整数中找出不重复的整数,内存不足以放下所有的数。我们可以采用两位的位图法,为每个数分配两位,00表示没有出现,01表示出现一次,10表示出现多次,11没有意义。这样下来总共需要232∗2=1232∗2=1GB(这里没有限定整数的范围,所有把所有32位整数都考虑进去)的内存。接下去扫描着2.5亿个整数,查看位图中相对应的位,如果是00就变为01,如果是01就变为10,其他情况保持不变。扫描完成后仍为01的整数就是需要查找的数。

**总结**

Bitmap适用于数据规模大,但数据状态少的情况。同时Bitmap在存在以下一些不足:

存储离散数据利用率低

Bitmap申请空间时要根据最大的数来决定申请的空间大小,如果数据是离散的,那空间的利用率就会非常低。

不适合多状态

一个bit只能表示两种状态,如果要表示更多的状态,就需要更多的状态位来实现。如果一个数字需要多个状态位来表示的话,Bitmap的优越性也会大打折扣,而且复杂度却在增加。

可读性差

将数据抽象为bit不利于理解,尤其是用多个bit位来表示一个数时。

性能一般

需要维护额外的逻辑,计算速度会受到一定的影响。

15. 解释一下HashMap这个数据结构

答案

1. 首先,hashMap是一个保存(key,value)键值对的一个数据结构,每个键值对叫一个Entry。这些Entry分散存储在一个数组中,这个数组就是HashMap的主干。

2. 新来的Entry节点若和原来的冲突的话,则使用头插法将其插入Entry主节点后。之所以使用头插法是因为发明者认为后面插入的节点更容易会被使用。

3. HashMap的默认初始长度是16,并且每次扩展或手动初始化时,长度必须是2的整数次幂。注意为啥是16呢,是为了符合均匀分布的原则,若长度为其他数字,你会发现,在与改数字做与运算的时候,有些index很容易得到,有些index则较难得到。这就违背了Hash算法均匀分布的原则。

4. index = HashCode(Key) & (Length - 1),从value->index

5. 扩容后,要重新遍历原来的Hash数组,从而让该hash数组均衡分布到新的hash数组之中。

19. 请说一下C/C++ 中指针和引用的区别?

区别

1. 名字的含义:指针指向的是一个具体的空间,而引用只是一个别名。

2. sizeof的含义:sizeof(p)大小依据系统不同,会有所不同,32位的系统,指针的大小为4.而引用的sizeof的大小一般是被引用对象的大小。

3. 初始化:指针可以被初始化为NULL,而引用只能被初始化为一个已有对象的引用。

4. 使用:作为参数传递时,指针需要解引用才可以对对象进行操作,而直接对引用的修改都会更改引用所指向的对象。

5. 可以有const指针,但是没有const引用。

6. 指针在使用过程中,可以指向其他对象,而引用只能是一个对象的引用,不能被改变。

7. 指针可以有多级指针,引用只能有一个引用。

总结:指针传递的本质是值传递复制实参的地址到函数的栈中,然后在形参中对地址取值操作。而引用的形参是给实参起了一个别名,可以直接操控形参从而实现对实参的控制。

名字,sizeof,使用,初始化,引用,const,多级

19.0 C++传参是传指针还是传引用?

答案

1. 传指针的好处

1) 指针可以设置默认参数,某些场合有奇效。

2. 传指针的缺点

1) 可能用户会传入NULL指针。

总结:

1 如果参数跟基本属性有关系,那就使用引用,如果参数跟扩展属性有关系,那就使用指针。

2 在指针的优势没有明显高过引用的地方就使用引用,毕竟指针存在释放危险。

3. 逻辑上如果要处理可能为空的这种情况之外,一般都可以使用引用。

4. 传入的内容会被修改的,用指针。

19.1 引用的底层原理

答案

引用即别名,它并非对象,相反地,它只是一个已经存在的对象所起的另外一个名字。引用存放的就是指针的地址。

引用的大小就是一个指针的大小。 引用同指针一样占有内存空间的,且内存的大小与指针一样,即32系统上是4个字节,64位系统上是8个字节。但是对引用进行sizeof运算得到的是被引用对象的内存大小,并不是其真实所占内存

引用在C++中是通过一个指针常量(就是const修饰的指针是常量)来实现的,即&b=a实际上等价于`int* const b=&a`,而编译器会把&b编译为:&(*b),那么得到的自然就是a的地址,所以我们会看到&a、&b得到的地址是一样的。但是一定要注意,&b并不是b的地址。

指针常量:就是这个指针就是一个常量。

19_2. 什么时候使用指针?什么时候使用引用?什么时候应该按值传递?

1. 传递引用的好处:

答案

1. 传递引用,避免了一次实参到形参的拷贝。

2. 程序员能够修改调用函数中的数据对象。

3. 通过传递引用而不是整个数据对象,可以提高运行速度。

4. 数据对象是类对象则使用引用。

5. 注意,引用传递也是要在堆栈中开辟内存空间的。但存放的是主调函数放进来的实参的值。

2. 使用指针:

答案

1. 如果数据对象是数组则使用指针。

2. 需要改变实参的时候,只能使用指针。

3. 需要遍历数组或频繁引用其元素时,使用指针的效率比使用下标的高。

4. 动态分配空间时,必须使用指针。

5. 传递大型结构并且“只读”其元素的时候,使用指针。因为不然大型结构通过值传递,需要拷贝每个元素,这样效率太低了。

3. 什么时候按值传递?

答案

1. 对于内建的数据类型,如小于4字节的的类型来讲,实际上传递时只需要传递1-4个字节。

2. 从健壮性来讲,值传递是比指针传递要健壮的,因为指针传递随便什么指针都可以传入。只要是void*就可以符合要求。而值传递就会进行类型检查。

引用的一些规则如下:

3. 引用被创建的同时必须被初始化。

4. 引用不能指向NULL,必须与合法的存储单元关联。

5. 一旦引用被初始化,就不能改变引用的关系

4. 总结来说什么情况用哪种?

答案

1. 对于那些函数,它们只使用传递过来的值,而不对值进行修改。

(1)如果数据对象很小,如内置数据类型或小型结构,使用按值传递。

(2)如果数据对象是数组,则使用指向const的指针。

(3)如果数据对象是较大的结构,则使用const指针或者const引用,以提高程序的效率。

(4)如果数据对象是类对象,则使用const引用。因此,传递类对象参数的标准方式是按引用传递。

2. 对于那些函数,它们需要修改传递过来的值。

(1)如果数据对象是内置数据类型,则使用指针。

(2)如果数据对象是数祖,则只能使用指针。

(3)如果数据对象是结构。则使用指针或者引用。

(4)如果数据对象是类对象,则使用引用。

21. 你知道什么树?

21.1完全二叉树

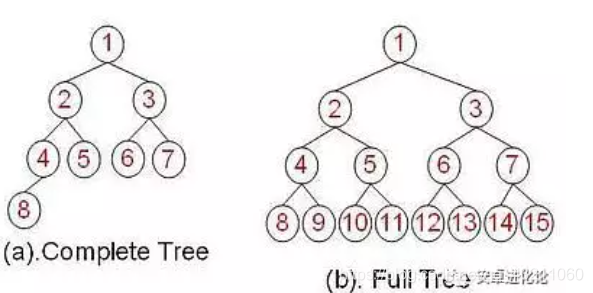

答案

完全二叉树是一种特殊的二叉树,满足以下要求:

所有叶子节点都出现在 k 或者 k-1 层,而且从 1 到 k-1 层必须达到最大节点数;

第 k 层可以不是满的,但是第 k 层的所有节点必须集中在最左边。

需要注意的是不要把完全二叉树和“满二叉树”搞混了,完全二叉树不要求所有树都有左右子树,但它要求:

任何一个节点不能只有右子树没有左子树

叶子节点出现在最后一层或者倒数第二层,不能再往上

用一张图对比下“完全二叉树”和“满二叉树”:

当我们用数组实现一个完全二叉树时,叶子节点可以按从上到下、从左到右的顺序依次添加到数组中,然后知道一个节点的位置,就可以轻松地算出它的父节点、孩子节点的位置。

以上面图中完全二叉树为例,标号为 2 的节点,它在数组中的位置也是 2,它的父节点就是 (k/2 = 1),它的孩子节点分别是 (2k=4) 和 (2k+1=5),别的节点也是类似。

**完全二叉树使用场景:**

根据前面的学习,我们了解到完全二叉树的特点是:“叶子节点的位置比较规律”。因此在对数据进行排序或者查找时可以用到它,比如堆排序就使用了它,后面学到了再详细介绍。

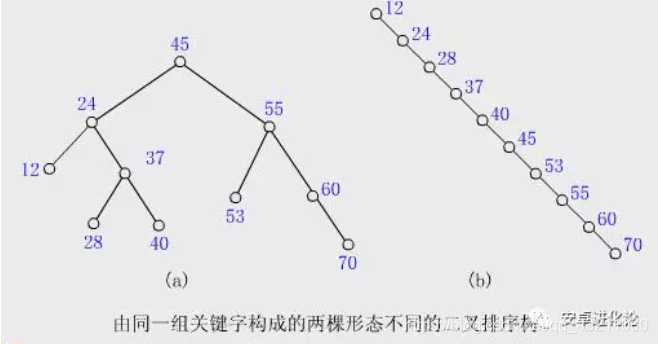

21.2二叉查找树(二叉排序树)

答案

二叉树的提出其实主要就是为了提高查找效率,比如我们常用的 HashMap 在处理哈希冲突严重时,拉链过长导致查找效率降低,就引入了红黑树。

我们知道,二分查找可以缩短查找的时间,但是它要求 查找的数据必须是有序的。每次查找、操作时都要维护一个有序的数据集,于是有了二叉查找树这个概念。

**二叉查找树(又叫二叉排序树),它是具有下列性质的二叉树:**

若左子树不空,则左子树上所有结点的值均小于它的根结点的值;

若右子树不空,则右子树上所有结点的值均大于或等于它的根结点的值;

左、右子树也分别为二叉排序树。

也就是说,二叉查找树中,左子树都比节点小,右子树都比节点大,递归定义。

根据二叉排序树这个特点我们可以知道:二叉排序树的中序遍历一定是从小到大的。

比如上图,中序遍历结果是:

1 3 4 6 7 8 10 13 14

二叉排序树(二叉查找树)的性能

答案

在最好的情况下,二叉排序树的查找效率比较高,是 O(logn),其访问性能近似于折半查找;

但最差时候会是 O(n),所谓O(n)的含义是算法的运行时间与输入规模呈比例,若输出规模为N,花费时间为T,则若输出规模为2N,则花费时间为2T.比如插入的元素是有序的,生成的二叉排序树就是一个链表,这种情况下,需要遍历全部元素才行(见下图 b)。

如果我们可以保证二叉排序树不出现上面提到的极端情况(插入的元素是有序的,导致变成一个链表),就可以保证很高的效率了。

但这在插入有序的元素时不太好控制,按二叉排序树的定义,我们无法判断当前的树是否需要调整。

因此就要用到平衡二叉树(AVL 树)了。

21.3平衡二叉树(二叉搜索树)

答案

1. 平衡二叉树提出的原因:

平衡二叉树的提出就是为了保证树不至于太倾斜,尽量保证两边平衡。

2. 平衡二叉树的定义:

平衡二叉树要么是一棵空树

要么保证左右子树的高度之差不大于 1

子树也必须是一颗平衡二叉树

也就是说,树的两个左子树的高度差别不会太大。

3. 示例:

那我们接着看前面的极端情况的二叉排序树,现在用它来构造一棵平衡二叉树。

以 12 为根节点,当添加 24 为它的右子树后,根节点的左右子树高度差为 1,这时还算平衡,这时再添加一个元素 28:

这时根节点 12 觉得不平衡了,我左孩子一个都没有,右边都有俩了,超过了之前说的最大为 1,不行,给我调整!

于是我们就需要调整当前的树结构,让它进行旋转。

因为最后一个节点加到了右子树的右子树,就要想办法给右子树的左子树加点料,因此需要逆时针旋转,将 24 变成根节点,12 右旋成 24 的左子树,就变成了这样(有点丑哈哈):

依次类推,平衡二叉树在添加和删除时需要进行旋转保持整个树的平衡,内部做了这么复杂的工作后,我们在使用它时,插入、查找的时间复杂度都是 O(logn),性能已经相当好了。

21.4 avl树是什么结构,让我说一下怎么插入,插入后怎么旋转。

答案

avl树是平衡二叉树。

**满足以下性质的二叉搜索树:**

> 1、左右子树都是AVL树

> 2、左右子树的高度之差的绝对值不超过1

bf = 右子树的个数-左子树的个数

若bf<0--->右旋转

若bf>0---->左旋转

21. 5 哪两种遍历方式可以唯一确定一棵二叉树?

答案

1. 前序+中序

2. 中序+后序

这两种方式可以唯一确定一棵二叉树。

22. C语言中的strlen与sizeof的区别

答案

1. sizeof与strlen是有着本质的区别,sizeof是求数据类型所占的空间大小,而strlen是求字符串的长度,字符串以/0结尾。

2. sizeof的底层原理:sizeof是运算符,需要操作系统支持。

#define sizeof(type) ((size_t) ((type*)0 + 1))

#define array_sizeof(T) ( (size_t)(&T+1) - (size_t)(&T) )

上面这两句就是其底层原理。

sizeof与strlen的测试代码:

#include <iostream>

#include <stdlib.h>

#include <stdio.h>

#include <cstring>

using namespace std;

int main()

{

//win10 64位系统

int a = 10;

cout<<"--->int1:"<<sizeof(a)<<endl;//4

cout<<"--->int2:"<<sizeof(a++)<<endl;//4

cout<<"--->int3:"<<sizeof(a+1)<<endl;//4

char* pHead = new char[100];

cout<<"--->char*"<<sizeof(pHead)<<endl;//8

string str = "abs";

cout<<"-->string"<<sizeof(str)<<endl;//8

char char2[] = "abcd";

cout<<"--->char2"<<sizeof(char2)<<endl; //5

int a1, b1, c1, d1;

a1 = sizeof("123456789"); //a1为10,而这个还是char 型的数组,9的字符+\0 公共十个字符

b1 = sizeof("123456789"+2); //b1 为8 +2之后,相当于已经被连接成一个char*的指针数组了,所以,不管+多少,都是指针的大小

c1 = strlen("123456789"); //c1为9 strlen算出的字符的长度

d1 = strlen("123456789"+3); //d1为6

cout<<"--->test sizeof1 "<<a1<<endl;

cout<<"--->test sizeof2 "<<b1<<endl;

cout<<"--->test sizeof3 "<<c1<<endl;

cout<<"--->test sizeof4 "<<d1<<endl;

return 0;

}

3. sizeof计算对象的大小

(1)A的大小为4个字节,因为在大部分的情况下计算类的对象大小时只需要计算它的成员变量的大小就可以了,而不需要计算成员函数的大小。

(2)B的大小为8个字节,因为B除了它本身的成员变量大小占4个字节之外,它还有一个虚函数,虚函数需要4个字节去存放虚函数表,所以B的大小为8个字节

(3)C的大小为12字节,是因为它继承了类B,类B的大小为8个字节,再加上它自己的成员变量4个字节,所以有12个字节,注意C的大小不是16个字节,因为子类虽然拥有自己的虚函数,但是与父类共用一张虚表

25. C++ 友元是什么

答案

类的友元函数是定义在类外部,但有权访问类的所有私有(private)成员和保护(protected)成员。尽管友元函数的原型有在类的定义中出现过,但是友元函数并不是成员函数。

**友元可以是一个函数,该函数被称为友元函数;友元也可以是一个类,该类被称为友元类,在这种情况下,整个类及其所有成员都是友元**。

如果要声明函数为一个类的友元,需要在类定义中该函数原型前使用关键字 friend,如下所示

**优点**

通常对于普通函数来说,要访问类的保护成员是不可能的,如果想这么做那么必须把类的成员都声明成为public(共用的),然而这做带来的问题遍是任何外部函数都可以毫无约束的访问它操作它,c++利用friend修饰符,可以让一些你设定的函数能够对这些保护数据进行操作,避免把类成员全部设置成public,最大限度的保护数据成员的安全。

**缺点**

友元能够使得普通函数直接访问类的保护数据,避免了类成员函数的频繁调用,可以节约处理器开销,提高程序的效率,但所矛盾的是,即使是最大限度大保护,同样也破坏了类的封装特性,这即是友元的缺点,在现在cpu速度越来越快的今天我们并不推荐使用它,但它作为c++一个必要的知识点,一个完整的组成部分,我们还是需要讨论一下的。 在类里声明一个普通数学,在前面加上friend修饰,那么这个函数就成了该类的友元,可以访问该类的一切成员。

29.1 排序算法集合

排序稳定性的概念:排序前相等的两个元素的先后顺序,排序后,是否先后顺序依旧未改变。

1、冒泡排序:

答案

从数组中第一个数开始,依次遍历数组中的每一个数,通过相邻比较交换,每一轮循环下来找出剩余未排序数的中的最大数并“冒泡”至数列的顶端。

稳定性:稳定

平均时间复杂度:O(n ^ 2)

答案

class Solution {

public:

vector<int> sortArray(vector<int>& nums)//冒泡排序

{

int n = nums.size();

for (int i = 0; i < n; i++)

{

bool flag = false;

for (int j = n - 1; j > i; j--)

{

if (nums[j] > nums[j - 1])//不断的比较相邻的两个数,如果比较到i的位置,都还没有出现过一次交换,那么证明已经该数据已经是有序的了,不用再比较了

{

swap(nums[j], nums[j - 1]);

flag = true;

}

}

if (flag == false)

return nums;

}

}

}

2、插入排序:

答案

从待排序的n个记录中的第二个记录开始,依次与前面的记录比较并寻找插入的位置,每次外循环结束后,将当前的数插入到合适的位置。

稳定性:稳定

平均时间复杂度:O(n ^ 2)

代码

class Solution {

public: vector<int> sortArray(vector<int>& nums) {

int n = nums.size();

for (int i = 1; i < n; i++)

{

int cur = nums[i];//这到哪一位,就能将其排到最适合的位置,从而结束这个排序

int index = i - 1;

while (index >= 0 && cur < nums[index])

{

nums[index + 1] = nums[index];

index--;

}

nums[index + 1] = cur;

}

return nums;

}

}; /* 1 4 2 3 5cur = 2;index = 1;num[2] = num[1](4) 1 2 4 3 51 2 3 4 5 */

3、希尔排序(缩小增量排序):

答案

希尔排序法是对相邻指定距离(称为增量)的元素进行比较,并不断把增量缩小至1,完成排序。

希尔排序开始时增量较大,分组较多,每组的记录数目较少,故在各组内采用直接插入排序较快,后来增量di逐渐缩小,分组数减少,各组的记录数增多,但由于已经按di−1分组排序,文件叫接近于有序状态,所以新的一趟排序过程较快。因此希尔 排序在效率上比直接插入排序有较大的改进。

在直接插入排序的基础上,将直接插入排序中的1全部改变成增量d即可,因为希尔排序最后一轮的增量d就为1。

稳定性:不稳定

平均时间复杂度:希尔排序算法的时间复杂度分析比较复杂,实际所需的时间取决于各次排序时增量的个数和增量的取值。时间复杂度在O(n ^ 1.3)到O(n ^ 2)之间。

code

答案

public: vector<int> sortArray(vector<int>& nums) {

int n = nums.size();

int gap = n;

while (gap > 1)

{

gap = gap / 3 + 1;//先划定一个范围

for (int i = gap; i < n; i++)

{

int cur = nums[i];

int index = i - gap;

while (index >= 0 && cur < nums[index])//这个操作可以把nums中把gap作为间隔的地方全部都排好序

{

nums[index + gap] = nums[index];

index = index - gap;

}

nums[index + gap] = cur;

}

}

return nums;

}

4、选择排序:

答案

从所有记录中选出最小的一个数据元素与第一个位置的记录交换;然后在剩下的记录当中再找最小的与第二个位置的记录交换,循环到只剩下最后一个数据元素为止。

稳定性:不稳定

平均时间复杂度:O(n ^ 2)

代码

//selectSort 每次将当前元素替换为后面最小的元素

public static void selectSort(int[] a){

int N = a.length;

for (int i = 0; i < N; i++) {

int min = i;

for (int j = i+1; j < N; j++) {//从i+1到N选一个最小的数,将其idx赋值给min,然后,与原来的a[i]进行数值上的交换

if(a[j]<a[min])

min=j;

}

int t =a[i];

a[i] = a[min];

a[min] = t;

}

}

5、快速排序

答案

1)从待排序的n个记录中任意选取一个记录(通常选取第一个记录)为分区标准;

2)把所有小于该排序列的记录移动到左边,把所有大于该排序码的记录移动到右边,中间放所选记录,称之为第一趟排序;

3)然后对前后两个子序列分别重复上述过程,直到所有记录都排好序。

稳定性:不稳定

平均时间复杂度:O(nlogn)

快速排序

//quickSort 每次选择一个元素并且将整个数组以这个元素分为两部分,小于该元素的放右边,大于该元素的放左边

public void quickSort(int[] arr,int l,int r){

if(l<r){ //跳出递归的条件

//partition就是划分操作,将arr划分成满足条件的两个子表

int pivotpos = partition(arr,l,r);

//依次对左右两个子表进行递归排序

quickSort(arr,l,pivotpos);

quickSort(arr,pivotpos+1,r);

}

}

public int partition(int[] arr,int l,int r){

//以当前数组的最后一个元素作为中枢pivot,进行划分

int pivot = arr[r];

while (l<r){

while (l<r && arr[l]<pivot) l++;

arr[r] = arr[l];//将比中枢值大的移动到右端r处 由于r处为中枢或者该位置值已经被替换到l处,所以直接可以替换

while (l<r && arr[r]>=pivot) r--;

arr[l] = arr[r];//将比中枢值小的移动到左端l处 由于前面l处的值已经换到r处,所以该位置值也可以替换掉

}

//l==r时,重合,这个位置就是中枢的最终位置

arr[l] = pivot;

//返回存放中枢的最终位置

return l;

}

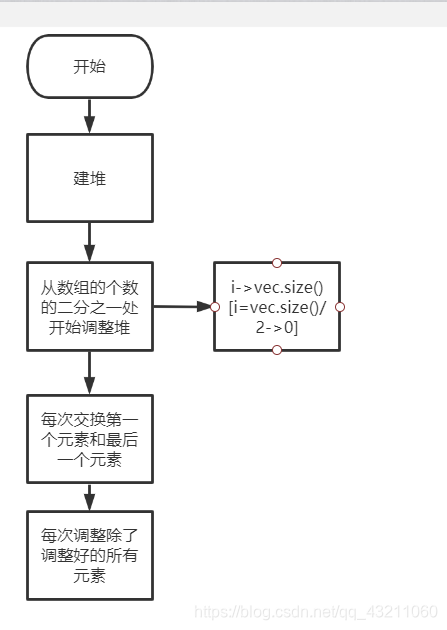

6、堆排序:

答案

堆:

1、完全二叉树或者是近似完全二叉树。

2、大顶堆:父节点不小于子节点键值,小顶堆:父节点不大于子节点键值。左右孩子没有大小的顺序。

堆排序在选择排序的基础上提出的,步骤:

1、建立堆

2、删除堆顶元素,同时交换堆顶元素和最后一个元素,再重新调整堆结构,直至全部删除堆中元素。

稳定性:不稳定

平均时间复杂度:O(nlogn)

核心思想:

将输入分为已排序的和未排序的区域。它通过提取未排序的区域内最大的元素 并将其移到已排序的区域来迭代缩小未排序的区域。其实一种`非稳定排序`.

堆排序的基本思路:

答案

> 1. 将无序序列构建成一个堆,根据升序需求选择大顶堆还是小顶堆。

> 2. 将堆顶元素与末尾元素进行交换,将最大元素沉到数组末端。

> 3. 重新调整结构,使其满足堆定义,然后继续交换堆顶元素与当前末尾元素,反复执行调整,交换的操作。

#include <stdio.h>

#include <iostream>

#include <vector>

#include <time.h>

#include <Windows.h>

using namespace std;

//建堆是核心

void Heap_build(int a[],int root,int len)

{

int lchild = root*2+1;

if(lchild<len)

{

int flag = lchild;//flag保存的是根节点的左右节点最大值的下标

int rchild = lchild+1;//根节点的右子节点下标

if(rchild<len)

{

if(a[rchild]>a[flag])//找出左右子节点的最大值

{

flag = rchild;

}

}

if(a[root]<a[flag])

{

swap(a[root],a[flag]);

Heap_build(a,flag,len); //不断更改根节点的位置。

}

}

}

void Heap_sort(int a[],int len)

{

for(int i = len/2;i>=0;i--)//第一遍建堆

{

Heap_build(a,i,len);

}

for(int j = len-1;j>=0;j--)

{

swap(a[0],a[j]);//交换那两个元素

Heap_build(a,0,j); //继续堆排序,不过,排除已经建好堆的数组

}

}

int main()

{

clock_t Start_time = clock();

int a[10] = {12,45,748,12,56,3,89,4,48,2};

Heap_sort(a,10);

for(int j = 0;j<10;j++)

{

cout<<a[j]<<" ";

}

clock_t end_time = clock();

cout<<endl;

cout<<"Total_Running Time"<<static_cast<double>(end_time-Start_time)/CLOCKS_PER_SEC*1000<<" ms"<<endl;

return 0;

}

7、归并排序:

答案

采用分治思想,现将序列分为一个个子序列,对子序列进行排序合并,直至整个序列有序。

稳定性:稳定

平均时间复杂度:O(nlogn)

code

答案

class Solution {

public:

vector<int> sortArray(vector<int>& nums) {//归并排序

int left=0;

int right=nums.size()-1;

MergeSort(nums,left,right);

return nums;

}

void MergeSort(vector<int>&nums,int left,int right)

{

if(left<right)//只要left<right,最终情况是left=right,即数组长度为1,单独一个数,肯定是有序的

{

int mid=(left+right)/2;//取中点

MergeSort(nums,left,mid);//左边块递归排序

MergeSort(nums,mid+1,right);

Merge(nums,left,mid,mid+1,right);//左右块合并

}

}

void Merge(vector<int>&nums,int L1,int R1,int L2,int R2)//L1,R1是第一块的左右索引,L2R2同理,将两个块合并

{

int temp[R2-L1+1];//存放合并后的有序数组(这里没用vector,用了会提示内存不足)

int i=L1;

int j=L2;

int k=0;

while(i<=R1 && j<=R2){

if(nums[i]<nums[j])

{

temp[k++]=nums[i++];

}

else

{

temp[k++]=nums[j++];

}

}//while结束之后若有某块没遍历完(另一块肯定已经遍历完),剩下的数直接赋值

while(i<=R1) temp[k++]=nums[i++];

while(j<=R2) temp[k++]=nums[j++];

for(int i=0;i<k;i++)//合并后的数赋值回原来的数组

nums[L1+i]=temp[i];

}

};

8、计数排序:

答案

思想:如果比元素x小的元素个数有n个,则元素x排序后位置为n+1。

步骤:

1)找出待排序的数组中最大的元素;

2)统计数组中每个值为i的元素出现的次数,存入数组C的第i项;

3)对所有的计数累加(从C中的第一个元素开始,每一项和前一项相加);

4)反向填充目标数组:将每个元素i放在新数组的第C(i)项,每放一个元素就将C(i)减去1。

稳定性:稳定

时间复杂度:O(n+k),k是待排序数的范围。

9、桶排序:

答案

步骤:

1)设置一个定量的数组当作空桶子; 常见的排序算法及其复杂度:

2)寻访序列,并且把记录一个一个放到对应的桶子去;

3)对每个不是空的桶子进行排序。

4)从不是空的桶子里把项目再放回原来的序列中。

时间复杂度:O(n+C) ,C为桶内排序时间。

桶排序

//radixSort 按位数进行排序,借助桶bucket进行分配与收集

public void radixSort(int[] arr){

int max = 0;

for (int i : arr) {

if(i>max) max = i;

}

int count = (max+"").length();

for (int i = 1; i <= count; i++) {

//分配

int[][] bucket = new int[10][arr.length];

//bucketCount用于统计该桶中元素的数量

int[] bucketCount = new int[10];

for (int value : arr) {

bucket[value % (10 * i)][bucketCount[value % (10 * i)]++] = value;

}

//收集

int k = 0;

for (int j = 0; j < 10; j++) {

//如果桶中有数据,放入数组

if(bucketCount[j]!=0) {

//循环该桶,取出元素到arr中,每取一个元素,桶中元素-1

while (bucketCount[j]!=0) arr[k++] = bucket[j][--bucketCount[j]];

}

}

}

}

29.1 快排(算一下快排复杂度,计算过程)

答案

**快排的思想:**首先,快排是选出一个基准元素,一般选择第一个元素。然后,通过一趟排序,将数组分为两个部分,一部分比该元素小,一部分比该元素大。然后,再按此方法对这两部分分别进行递归。

快速排序算法的时间复杂度为O(nlogn)

答案

int once_quick_sort(vector<int>& data, int left, int right)

{

int key = data[left];

while (left < right)

{

while (left < right && key <= data[right])

{

right--;

}

if (left < right)

{

data[left] = data[right];

left++;

}

while (left < right && key > data[left])

{

left++;

}

if (left < right)

{

data[right] = data[left];

right--;

}

}

data[left] = key;

return left;

}

int quick_sort(vector<int>& data, int left, int right)

{

if (left >= right)

{

return 1;

}

int middle = 0;

middle = once_quick_sort(data, left, right);

quick_sort(data, left, middle - 1);

quick_sort(data, middle + 1, right);

}

快排的优化方式

答案

1. 选择基准的方式

若每次划分都能划分成**等长的两个序列**,那么分治效率将会达到最大。下面介绍三种基准的选取方式

a. 取序列的第一个或最后一个

**这种效率很不好,若数组原本就是有序的,则会导致算法退化成为O(n^2)**

b. 随机选择基准

**可以达到O(Nlogn)**

c. 最佳的是选取序列的中间的值,但这很难得到,所以我们一般选取头,尾,中三数 的中值作为枢纽元。

2. 其他优化方式:

a. 待排序序列的长度分割到一定大小后,使用插入排序.

b. 在一次分割结束后,可以把与Key相等的元素聚在一起,继续下次分割时,不用再对与key相等元素分割.

c. 优化递归操作:快排函数在函数尾部有两次递归操作,我们可以对其使用尾递归优化。

**最好的方式是:三数取中+插排+聚集相等元素,它和STL中的Sort函数效率差不多**

尾递归

答案

1. 什么是尾递归?

如果一个函数中所有递归形式的调用都出现在函数的末端,我们称这个递归函数是尾递归。

2. 尾递归和一般的递归不同在对内存的占用,普通递归创建stack累积而后计算收缩,尾递归只会占用恒量的内存(和迭代一样)。

def recsum(x):

if x == 1:

return x

else:

return x + recsum(x - 1)

尾调用的概念非常简单,一句话就能说清楚,就是指某个函数的最后一步是调用另一个函数。尾调用不一定出现在函数尾部,只要是最后一步操作即可。

3. 尾递归函数的特点是在回归过程中不用做任何操作,这个特性很重要,因为大多数现代的编译器会利用这种特点自动生成优化的代码

29.2 堆排(算一下复杂度)

答案

**堆排的思想**:利用堆进行排序的思想,将待排序的序列构成一个大顶堆,此时,整个序列的最大值就是堆顶的根节点,再将它移走(其实就是将其与堆数组的末尾元素交换,此时末尾元素就是最大值),然后将剩余的n-1个序列重新构建成一个大顶堆,这样就是得到这n个元素序列的次小值,如此反复进行,便能得到一个有序序列。

堆排序的时间复杂度为O(n*log(n)), 非稳定排序,原地排序(空间复杂度O(1))。

code

答案

#include <cstdio>

#include <iostream>

#include <cstring>

#include <algorithm>

using namespace std;

void adjust(int arr[],int len,int index)

{

int left = 2*index+1;

int right = 2*index+2;

int maxIdx = index;

if(left<len&&arr[left]>arr[maxIdx])

maxIdx = left;

if(right<len&&arr[right]>arr[maxIdx])

maxIdx = right;

if(maxIdx!=index)

{

swap(arr[maxIdx],arr[index]);

adjust(arr,len,maxIdx);//这个是递归调整这个节点下面的所有节点进行排序

}

}

void heapSort(int arr[],int size)

{

for(int i = size/2;i>=0;i++)

adjust(arr,size,i);

for()

}

int main()

{

int array[8] = {8,1,14,3,21,5,7,10};

heapSort(array,8);

for(auto it:array)

{

cout<<it<<endl;

}

return 0;

}

29.3 sort采用的是什么排序?

答案

答案: 用到了快速排序还结合 了插入排序和堆排序。

sort算法逻辑: 数据量大时采用快排,分段归并排序。分段后的数据小于某个门槛,为避免快排的递归调用带来过大的额外负荷,就改用Inserttion Sort插入排序。如果递归层次过深,还会改用堆排。

1. 快速排序递归实现时,怎么解决递归层次过深的问题?

预防堆栈溢出的方法:

(1)避免层次过深的递归调用;

(2)不要使用过多的局部变量,控制局部变量的大小;

(3)避免分配占用空间太大的对象,并及时释放;

(4)实在不行,适当的情景下调用系统API修改线程的堆栈大小;

2. 快速排序的优化

1)中枢值的选取。这个很显然,如果每次都选中实际大小中中间的那个值,那么就能达到最优的排序效果,避免最坏的情况的;

(2)划分的最小数列长度。因为快速排序是对子序列不停递归的一个过程(分治法)。所以如果递归的过多,堆栈带来的性能损失也是不容小视的。还有最重要的一点就是在数据量很小的情况下,插入排序在时间上的性能要比快速排序的性能要好,所以当子序列长度小于某阈值时,调整为插入排序;

(3)对是否交换做标记,如果全过程没有发生交换,直接返回就可以了;

(4)栈的深度。要优先对小的数组进行排序,这样可以减少递归调用栈的深度。

(5) 非递归的方式来实现快速排序或者去掉尾递归也是另外一种思路的优化

31. 二叉树的遍历(前序,中序,后序,递归+迭代 )

31.1 前序遍历

31_1_1. 前序遍历(递归)

答案

class Solution {

public:

void traversal(TreeNode* cur, vector<int>& vec) {

if (cur == NULL)

return;

vec.push_back(cur->val); // 中

traversal(cur->left, vec); // 左

traversal(cur->right, vec); // 右

}

vector<int> preorderTraversal(TreeNode* root) {

vector<int> result;

traversal(root, result);

return result;

}

};

31_1_2.前序遍历(迭代)

code

答案

vector<int> preorder(TreeNode* root)

{

vector<int> res;

if(root==NULL)

return res;

stack<TreeNode*> st;

st.push(root);

while(!st.empty())

{

TreeNode* node = st.top();

res.push(node);

st.pop();

if(node->right)

st.push(node->right);

if(node->left)

st.push(node.left);

}

return result;

}

31.2 中序遍历

31_2_1. 中序遍历递归

递归

class Solution {

public:

void traversal(TreeNode* cur, vector<int>& vec) {

if (cur == NULL) return;

traversal(cur->left, vec); // 左

vec.push_back(cur->val); // 中

traversal(cur->right, vec); // 右

}

vector<int> preorderTraversal(TreeNode* root) {

vector<int> result;

traversal(root, result);

return result;

}

};

31_2_2.中序遍历迭代

答案

/* 注意中序遍历的非递归是借助了栈的方式进行遍历的,并且,规则是: 先往左边走,走到最底下,最左下没东西了,开始出栈的元素,然后,往右边走。*/

/**

* Definition for a binary tree node.

* struct TreeNode {

* int val;

* TreeNode *left;

* TreeNode *right;

* TreeNode() : val(0), left(nullptr), right(nullptr) {}

* TreeNode(int x) : val(x), left(nullptr), right(nullptr) {}

* TreeNode(int x, TreeNode *left, TreeNode *right) : val(x), left(left), right(right) {}

* };

*/

class Solution {

public:

vector<int> inorderTraversal(TreeNode* root) {

vector<int> result;

stack<TreeNode*> st;

TreeNode* cur = root;

while(cur!=NULL||!st.empty())

{

if(cur!=NULL)//将入栈和出栈动作分开

{

st.push(cur);//这里才是第一次入栈,外面未入栈

cur = cur->left;//左

}

else//这个是出栈的动作

{

cur = st.top();

st.pop();

result.push_back(cur->val);//中

cur = cur->right;//右

}

}

return result;

}

};

31.3 后序遍历

31.3.1 后序遍历递归

答案

class Solution {

public:

void traversal(TreeNode* cur, vector<int>& vec) {

if (cur == NULL) return;

traversal(cur->left, vec); // 左

traversal(cur->right, vec); // 右

vec.push_back(cur->val); // 中

}

vector<int> preorderTraversal(TreeNode* root) {

vector<int> result;

traversal(root, result);

return result;

}

};

31.3.2 后序遍历迭代

答案

/*如栈就按照头右左,刚好出来的顺序就是左右头。这样就是后序遍历的顺序了。*/

/**

* Definition for a binary tree node.

* struct TreeNode {

* int val;

* TreeNode *left;

* TreeNode *right;

* TreeNode() : val(0), left(nullptr), right(nullptr) {}

* TreeNode(int x) : val(x), left(nullptr), right(nullptr) {}

* TreeNode(int x, TreeNode *left, TreeNode *right) : val(x), left(left), right(right) {}

* };

*/

class Solution {

public:

vector<int> postorderTraversal(TreeNode* root) {

vector<int> res;

if(root==nullptr)

return res;

stack<TreeNode*> st;

st.push(root);

while(!st.empty())

{

TreeNode* node = st.top();

res.push_back(node->val);

st.pop();

if(node->left)

st.push(node->left);

if(node->right)

st.push(node->right);

}

reverse(res.begin(),res.end());

return res;

}

};

32. 红黑树

答案

1)什么是红黑树?

它是一种特殊的二叉查找树,红黑树的每个节点都有存储位表示节点的颜色,可以是红(red)也可以是黑(black).

其实平衡二叉树最大的作用就是查找,**AVL树的查找、插入和删除在平均和最坏情况下都是O(logn)**。AVL树的效率就是高在这个地方。如果在AVL树中插入或删除节点后,使得高度之差大于1。此时,AVL树的平衡状态就被破坏,它就不再是一棵二叉树;为了让它重新维持在一个平衡状态,就需要对其进行旋转处理, 那么创建一颗平衡二叉树的成本其实不小. 这个时候就有人开始思考,并且提出了红黑树的理论,那么红黑树到底比AVL树好在哪里?

32.1 红黑树与AVL树的比较:

答案

1. AVL树的时间复杂度虽然优于红黑树,但是对于现在的计算机,cpu太快,可以忽略性能差异

2. 红黑树的插入删除比AVL树更便于控制操作

3. 红黑树整体性能略优于AVL树(红黑树旋转情况少于AVL树)

4. AVL 树是高度平衡的,频繁的插入和删除,会引起频繁的rebalance,导致效率下降;红黑树不是高度平衡的,算是一种折中,插入最多两次旋转,删除最多三次旋转。

5. 红黑树插入,删除,查找的时间复杂度都为 O(logn)

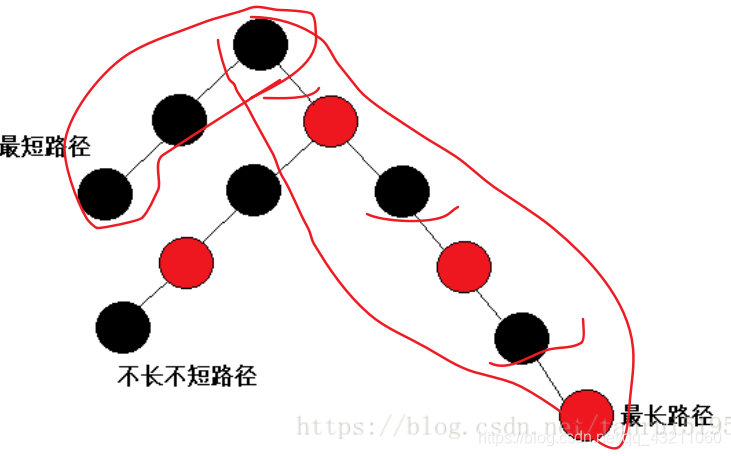

32.2 红黑树特性。

答案

红黑树是一棵二叉搜索树,它在每个节点增加了一个存储位,用来记录节点的颜色,可以是红色,也可以是黑色。通过任意一条从根到叶子简单路径上颜色的约束。红黑树可以保证最长路径不超过最短路径的两倍。近似平衡。

具体性质如下:

1. 每个节点颜色不是黑色就是红色。

2. 根节点是黑色。

3. 叶节点也是黑色。

4. 若某节点是红色,那其子节点一定是黑色。

5. 对于每个节点,从该节点到其后代叶节点的简单路径上。均包含相同数目的黑色节点。这个属性很重要这个,保证了上面的最长路径不超过最短路径的两倍的这个特性。

32.3 红黑树查找速度。

答案

红黑树是一种二叉查找树。可以在O(log n)时间内做查找,插入和删除。这里的n 是树中元素的数目。恢复红黑属性需要少量(O(log n))的颜色变更(这在实践中是非常快速的)并且不超过三次树旋转(对于插入是两次)。这允许插入和删除保持为 O(log n) 次,

32.4 红黑树的插入

答案

**红黑树插入节点过程大致分析:**

RBTree为二叉搜索树,我们按照二叉搜索树的方法对其进行节点插入

RBTree有颜色约束性质,因此我们在插入新节点之后要进行颜色调整

**具体步骤如下:**

1.根节点为NULL,直接插入新节点并将其颜色置为黑色

2. 根节点不为NULL,找到要插入新节点的位置

3.插入新节点

3. 判断新插入节点对全树颜色的影响,更新调整颜色

由于插入黑色节点的成本太高,所以,我们选择节点的颜色为红色。但若上一个节点也是红色的话,我们就需要依据情况进行调整 了。

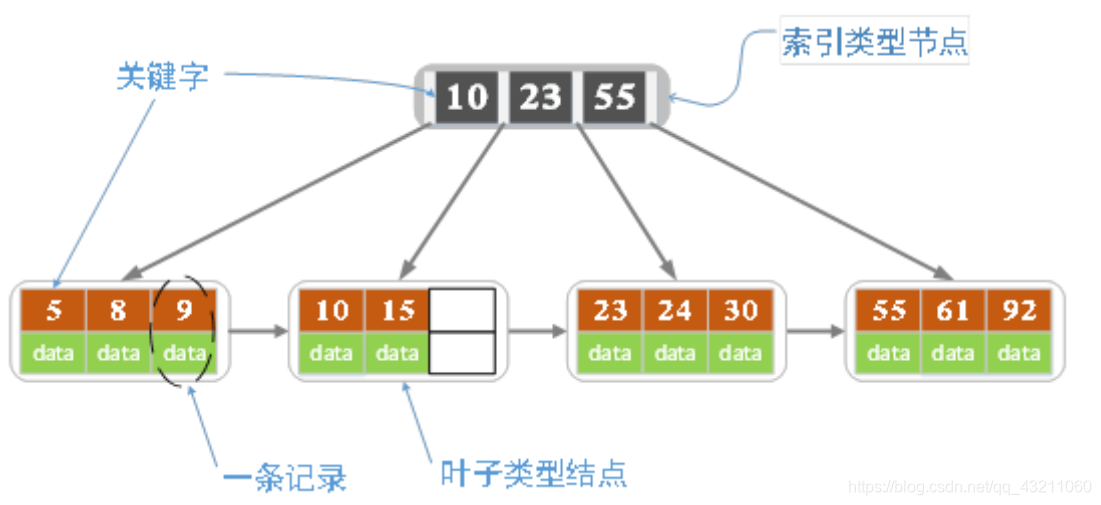

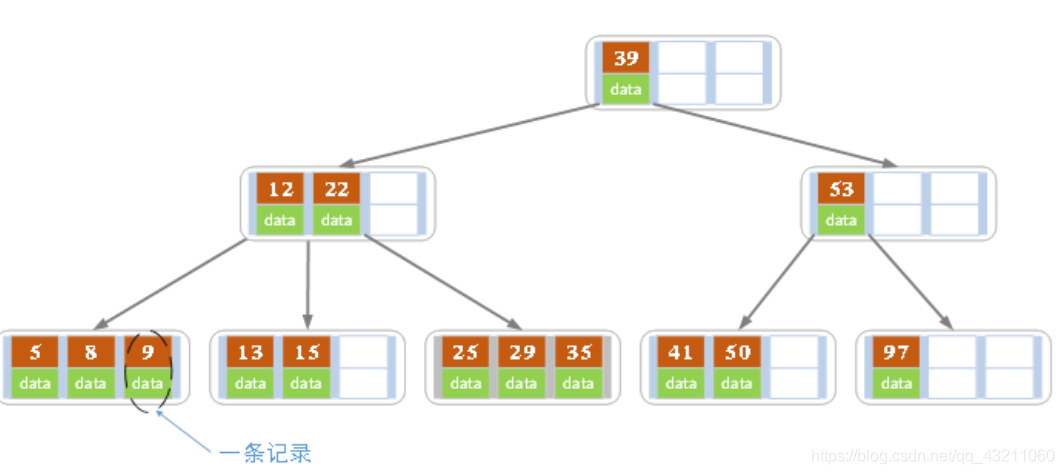

32.5 红黑树与B+树的比较?(B树与B+树的介绍)

1. 简介

答案

我们在MySQL中的数据一般是放在磁盘中的,读取数据的时候肯定会有访问磁盘的操作,磁盘中有两个机械运动的部分,分别是盘片旋转和磁臂移动。盘片旋转就是我们市面上所提到的多少转每分钟,而磁盘移动则是在盘片旋转到指定位置以后,移动磁臂后开始进行数据的读写。那么这就存在一个定位到磁盘中的块的过程,而定位是磁盘的存取中花费时间比较大的一块,毕竟机械运动花费的时候要远远大于电子运动的时间。当大规模数据存储到磁盘中的时候,显然定位是一个非常花费时间的过程,但是我们可以通过B树进行优化,提高磁盘读取时定位的效率。

为什么B类树可以进行优化呢?我们可以根据B类树的特点,构造一个多阶的B类树,然后在尽量多的在结点上存储相关的信息,保证层数尽量的少,以便后面我们可以更快的找到信息,磁盘的I/O操作也少一些,而且B类树是平衡树,每个结点到叶子结点的高度都是相同,这也保证了每个查询是稳定的。

总的来说,B/B+树是为了磁盘或其它存储设备而设计的一种平衡多路查找树(相对于二叉,B树每个内节点有多个分支),与红黑树相比,在相同的的节点的情况下,一颗B/B+树的高度远远小于红黑树的高度(在下面B/B+树的性能分析中会提到)。B/B+树上操作的时间通常由存取磁盘的时间和CPU计算时间这两部分构成,而CPU的速度非常快,所以B树的操作效率取决于访问磁盘的次数,关键字总数相同的情况下B树的高度越小,磁盘I/O所花的时间越少。

B树是为了提高**磁盘或外部存储设备查找效率**而设计的一种多路平衡二叉树。B+树为B树的变形结构,用于大多数数据库或文件系统的存储而设计的。

2. B树的定义:

答案

B树也称B-树,它是一颗多路平衡查找树。我们描述一颗B树时需要指定它的阶数,阶数表示了一个结点最多有多少个孩子结点,一般用字母m表示阶数。当m取2时,就是我们常见的二叉搜索树。

一棵m阶的二叉树的定义如下:

a. 每个节点最多有m-1个关键字。

b. 根节点最少可以只有一个关键字。

c. 非根节点至少有math.ceil(m/2)-1个关键字。

d. 每个节点的关键字都按照从小到大的顺序排列,每个关键字的左子树都小于它。而右子树的所有关键字都大于它。

e. 所有叶子节点都位于同一层,或者说根节点到每个叶子节点的长度都相同。

3. B+树的定义

所谓B+树,就是关键字的个数比孩子节点个数小1.

4. B+树的其他要求:

答案

a. B+树包含两种类型的节点:内部节点(索引节点)和叶子节点。根节点本身即可以是内部节点,也可以是叶子节点。根节点的关键字的个数最少可以只有一个。

b. **B+树与B树的不同点在于内部节点不保存数据,只用于索引,所有数据都保存在叶子节点中。**

c. m阶B+树表示了内部结点最多有m-1个关键字(但孩子节点的个数就可以是m)。阶数m同时限制了叶子节点最多存储m-1个记录。

d. 内部结点中的key都要按照从小到大的顺序排列,对于内部结点中的一个key,左树中所有的key都小于它,右树结点的key都大于它。

e.每个叶子结点都存有相邻叶子结点的指针,叶子结点本身依关键字的大小自小而大顺序链接。

5. B树的缺点(为何要用B+数在数据库的查找上应用)

答案

1.每个节点中既要存索引信息,又要存其对应的数据,如果数据很大,那么当**树的体量很大**时,每次读到内存中的树的信息就会不太够。

2.B树遍历整个树的过程和二叉树本质上是一样的,B树相对二叉树虽然提高了磁盘IO性能,但并没有解决**遍历元素效率**低下的问题。

6.B树和B+树的区别:

答案

1. B+树中只有叶子节点会带有指向记录的指针,而B树则所有节点都带有,在内部节点出现的索引项不会再出现在叶子节点中。

2. B+树中所有叶子节点都是通过指针连接在一起,而B树不会。

7.B+树的优点

答案

1. 非叶子节点不会带上指向记录的指针,这样,一个块中可以容纳更多的索引项,一是可以降低树的高度。二是一个内部节点可以定位更多的叶子节点。**B+树的磁盘读写代价更低。**

2. 叶子节点之间通过指针来连接,范围扫描将十分简单,而对于B树来说,则需要在叶子节点和内部节点不停的往返移动。具体的来讲,如何想扫描一次所有数据,对于b+树来说,可以从因为他们的叶子结点是连在一起的,所以可以横向的遍历过去。而对于b-树来说,就这能中序遍历了。**B+树的数据信息遍历更加方便**。

3. **B+树的查询效率更加稳定。**

8. B树相对于红黑树的区别:

答案

B树相对于红黑树的差别在大规模 数据存储的时候,红黑树往往由于**深度过大而造成磁盘IO读写过于频繁**,进而导致效率低下的情况。

因为我们知道磁盘IO的代价主要花费在查找所需的柱面上,树的深度过大会造成磁盘IO频繁读写。所以,根据磁盘查找存取的次数往往由树的高度所决定,所以,只要我们通过某种较好的树结构减少树的高度,B树可以有多个子女,从几十到上千,降低树的高度

9.红黑树 和 b+树的用途有什么区别?

答案

红黑树多用在内部排序,即全放在内存中的,STL的map和set的内部实现就是红黑树。

B+树多用于外存上时,B+也被变成一个磁盘友好的数据结构。

10. B/B+树性能分析

答案

n个节点的平衡二叉树的高度为H(即logn),而n个节点的B/B+树的高度为logt((n+1)/2)+1;

若要作为内存中的查找表,B树却不一定比平衡二叉树好,尤其当m较大时更是如此。因为查找操作CPU的时间在B-树上是O(mlogtn)=O(lgn(m/lgt)),而m/lgt>1;所以m较大时O(mlogtn)比平衡二叉树的操作时间大得多。因此在内存中使用B树必须取较小的m。(通常取最小值m=3,此时B-树中每个内部结点可以有2或3个孩子,这种3阶的B-树称为2-3树)。

11. 为什么说B+树比B树更适合数据库索引?

答案

1. **B+树的磁盘读写代价更低**:B+树的内部节点并没有指向关键字具体信息的指针,因此其内部节点相对B树更小,如果把所有同一内部节点的关键字存放在同一盘块中,那么盘块所能容纳的关键字数量也越多,一次性读入内存的需要查找的关键字也就越多,相对IO读写次数就降低了。

2. **B+树的查询效率更加稳定**:由于非终结点并不是最终指向文件内容的结点,而只是叶子结点中关键字的索引。所以任何关键字的查找必须走一条从根结点到叶子结点的路。所有关键字查询的路径长度相同,导致每一个数据的查询效率相当。

3. **区间查询更加快速**:由于B+树的数据都存储在叶子结点中,分支结点均为索引,方便扫库,只需要扫一遍叶子结点即可,但是B树因为其分支结点同样存储着数据,我们要找到具体的数据,需要进行一次中序遍历按序来扫,所以B+树更加适合在区间查询的情况,所以通常B+树用于数据库索引。

4. **总结**:他们认为数据库索引采用B+树的主要原因是:B树在提高了IO性能的同时并没有解决元素遍历的我效率低下的问题,正是为了解决这个问题,B+树应用而生。B+树只需要去遍历叶子节点就可以实现整棵树的遍历。而且在数据库中基于范围的查询是非常频繁的,而B树不支持这样的操作或者说效率太低。

参考

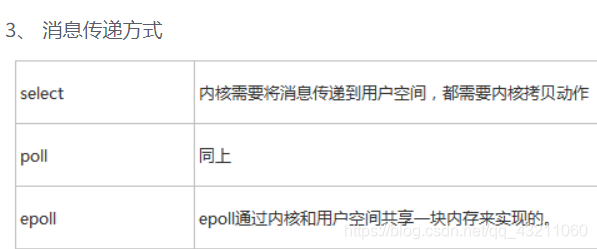

32.6 红黑树的应用

答案

1. C++的STL中,map与set都是用红黑树实现的。

2. 著名的Linux进程调度Completely Fair Scheduler,用红黑树管理进程控制块,进程的虚拟内存区域都存储在一颗红黑树上,每个虚拟地址区域都对应红黑树的一个节点,左指针指向相邻的地址虚拟存储区域,右指针指向相邻的高地址虚拟地址空间;

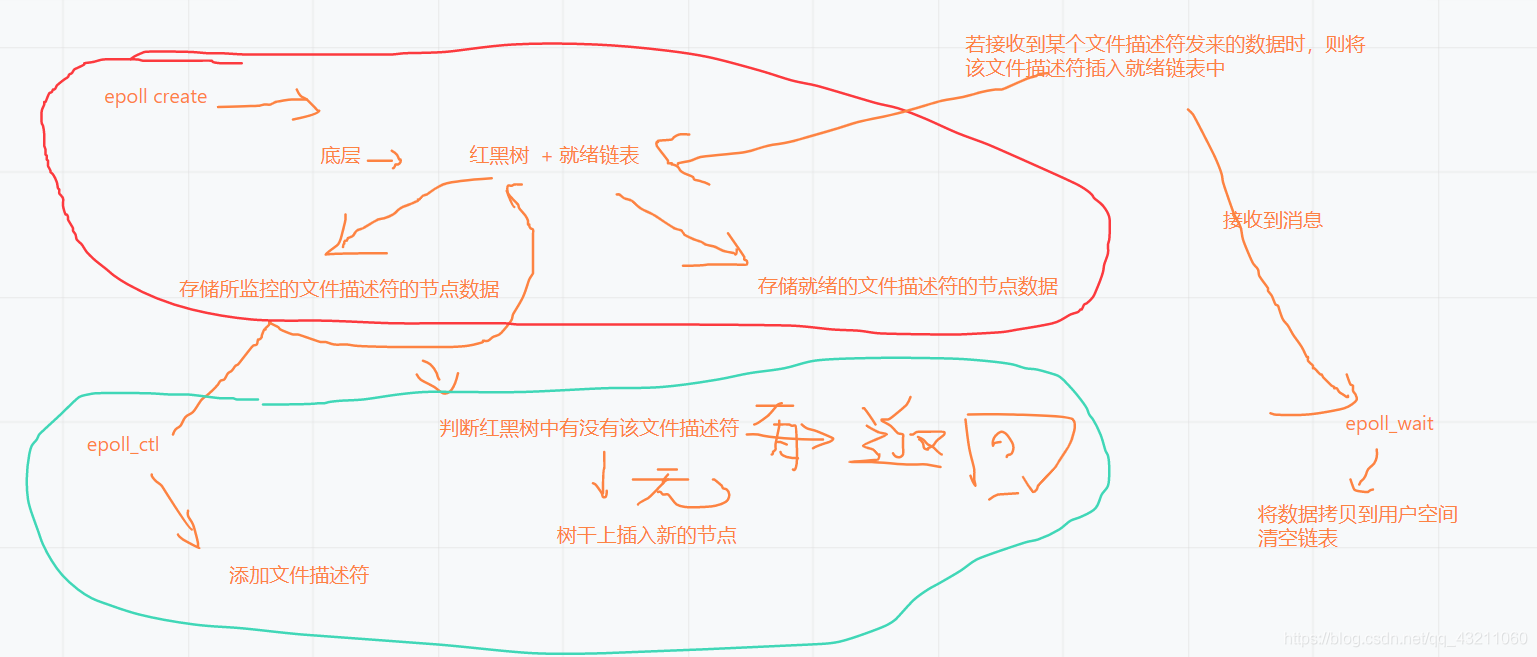

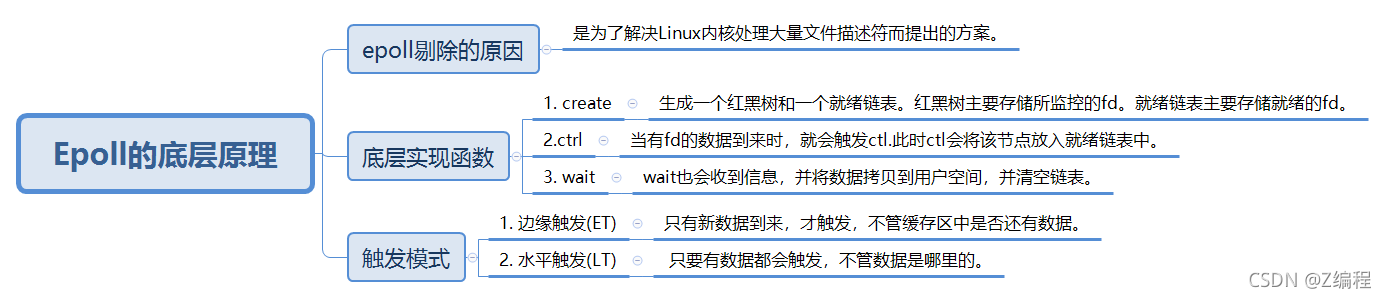

3. IO多路复用epoll的实现采用红黑树组织管理sockfd(文件描述符),以支持快速的增删改查.

4. Nginx中用红黑树管理timer,因为红黑树是有序的,可以很快的得到距离当前最小的定时器;

5. Java中TreeMap的实现;

32.7 mysql中为何要使用B+树?

答案

1. 索引在mysql数据库中分三类:B+树索引,Hash索引,全文索引。

2. 由于内存的易失性,我们将表的数据和索引保存在磁盘这种外围设备中。而磁盘读取数据时,都是按照磁盘块来读取的,并不是一条一条的读。

3. 为解决平衡二叉树的弊端,我们寻找一种单个节点可以存储多个键值和数据的平衡树。

4. 而B+树种中的非叶子节点是不存储数据的,仅存储键值。之所以这样做是因为在数据库中页的大小是固定的,innodb中页的默认大小是16KB.如果不存储数据,那么就会存储更多的键值,相应的树的阶数就会更大,树就会更矮更胖。这样一来,我们查找数据进行磁盘的IO次数就会再次减少,数据查询的效率也会更高。

5. B+树索引的所有数据均存储在叶子节点,而且数据是按照顺序排列的,那么B+树的查找就会变得非常简答。

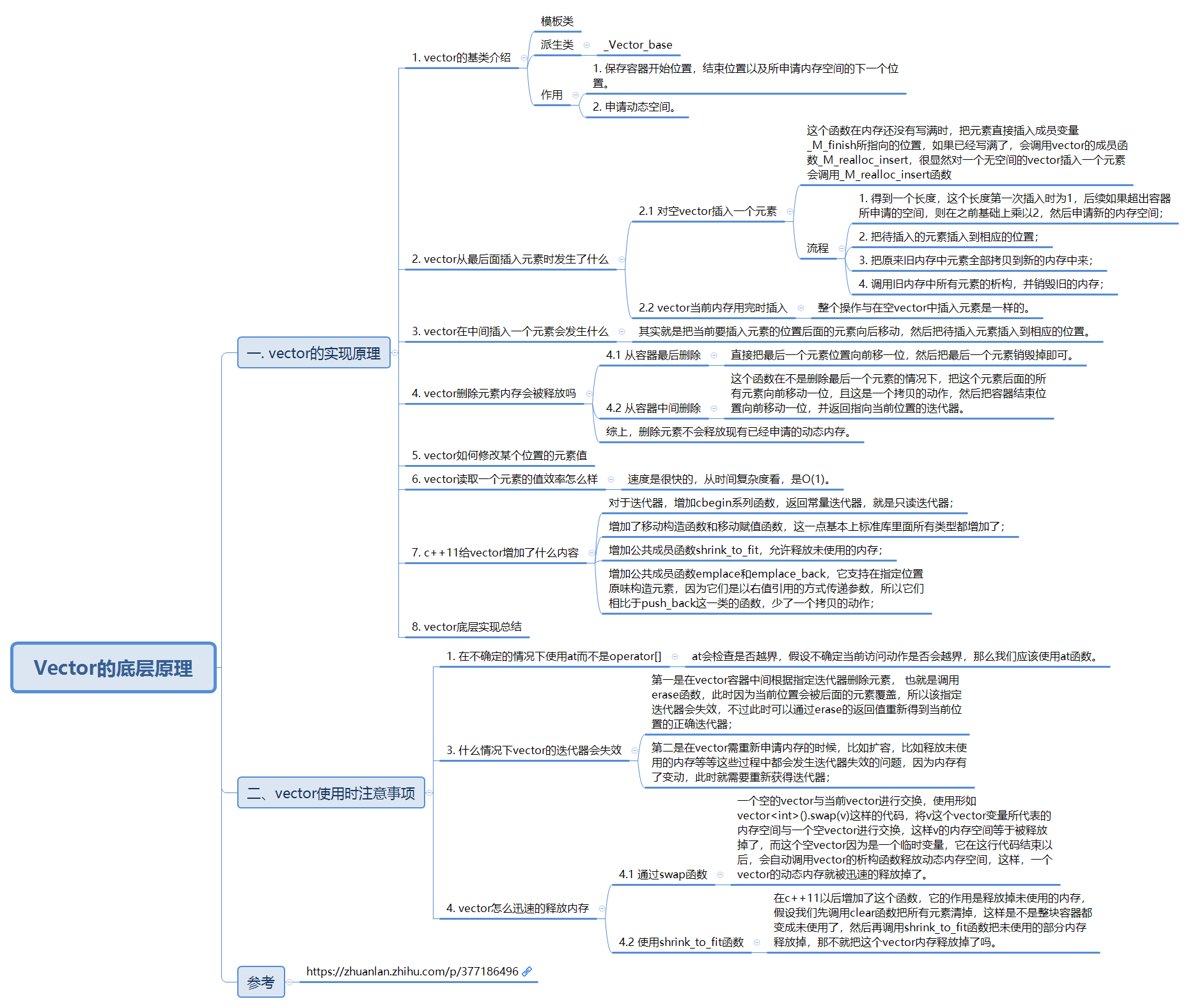

50.vector的底层工作原理

答案

vector采用简单的**线性连续空间**。以两个迭代器start和end分别指向头尾,并以迭代器end_of_storage指向容量尾端。容量可能比(尾-头)还大,多余即备用空间。

50.1. vector存储的元素为结构体时的注意事项

答案

1. 结构体要是全局变量

2. 结构体内部要重载比较运算符

51. map与unordered_map优点和缺点

答案

**对于map,其底层是基于红黑树实现的,优点如下:**

1)有序性,这是map结构最大的优点,其元素的有序性在很多应用中都会简化很多的操作。

2)map的查找、删除、增加等一系列操作时间复杂度稳定,都为O(logN)

**缺点如下:**

1)查找、删除、增加等操作平均时间复杂度较慢,与n相关.

2)空间占用率高,因为map内部实现了红黑树,虽然提高了运行效率,但是因为每一个节点都需要额外保存父节点、孩子节点和红/黑性质,使得每一个节点都占用大量的空间

**对于unordered_map来说,其底层是一个哈希表,优点如下:**

查找、删除、添加的速度快,时间复杂度为常数级O(c)

缺点如下:

因为unordered_map内部基于哈希表,以(key,value)对的形式存储,因此空间占用率高

Unordered_map的查找、删除、添加的时间复杂度不稳定,平均为O(c),取决于哈希函数。极端情况下可能为O(n).时间复杂度为O(n),就代表数据量增大几倍,耗时也增大几倍。

总结:

1. 内存占有率的问题就转化成红黑树 VS hash表 , 还是unorder_map占用的内存要高。

2. 但是unordered_map执行效率要比map高很多

3. 对于unordered_map或unordered_set容器,其遍历顺序与创建该容器时输入的顺序不一定相同,因为遍历是按照哈希表从前往后依次遍历的

51.1 何时使用map,何时使用HashMap?

答案

1. 删除和插入操作较多的情况下,map比hash_map的性能更好,添加和删除的数据量越大越明显。

2. map的遍历性能高于hash_map,而查找性能则相反,hash_map比map要好,数据量越大查找次数越多,表现就越好。

**总结**:hash_map 查找速度会比map快,而且查找速度基本和数据数据量大小,属于常数级别;而map的查找速度是log(n)级别。并不一定常数就比log(n)小, hash还有hash函数的耗时,明白了吧,如果你考虑效率,特别是在元素达到一定数量级时,考虑考虑hash_map。但若你对内存使用特别严格,希望 程序尽可能少消耗内存,那么一定要小心,hash_map可能会让你陷入尴尬,特别是当你的hash_map对象特别多时,你就更无法控制了,而且 hash_map的构造速度较慢。

权衡三个因素: 查找速度, 数据量, 内存使用

51.2 map中的key如果是结构体应该注意什么?

答案

1. 注意,map中的元素要是有序的,如果只是单纯结构体的元素的话,那么程序是会出错的。

2. 在结构体中要对比较符号进行重定义。比如:

struct Info

{

string name;

int score;

bool operator< (const Info &x) const

{

return score < x.score;

}

};

只有这样,才能对map进行存值。归根到底原因就是map的底层原理是红黑树,人家是有序的,不能让你随随便便就往里面放值。

52.2 hash与map的区别

答案

1. **存储结构**:hash:哈希表,map:红黑树。

2. **查找速度**:hash_map 查找速度会比map快,而且查找速度基本和数据数据量大小,属于常数级别;而map的查找速度是log(n)级别。

52. 对哈希函数的理解

答案

散列表(Hash table,也叫哈希表),是根据关键码值(Key value)而直接进行访问的数据结构。也就是说,它通过把关键码值映射到表中一个位置来访问记录,以加快查找的速度。这个映射函数叫做散列函数,存放记录的数组叫做散列表。

**定义**:哈希函数能够将固定长度的输入值,转变成固定程度的值输出,该值成为散列值。

**特点**:

1. Hash的主要原理就是把大范围映射到小范围;所以,你输入的实际值的个数必须和小范围相当或者比它更小。不然冲突就会很多。

2. 由于Hash逼近单向函数;所以,你可以用它来对数据进行加密。

3. 不同的应用对Hash函数有着不同的要求;比如,用于加密的Hash函数主要考虑它和单项函数的差距,而用于查找的Hash函数主要考虑它映射到小范围的冲突率。

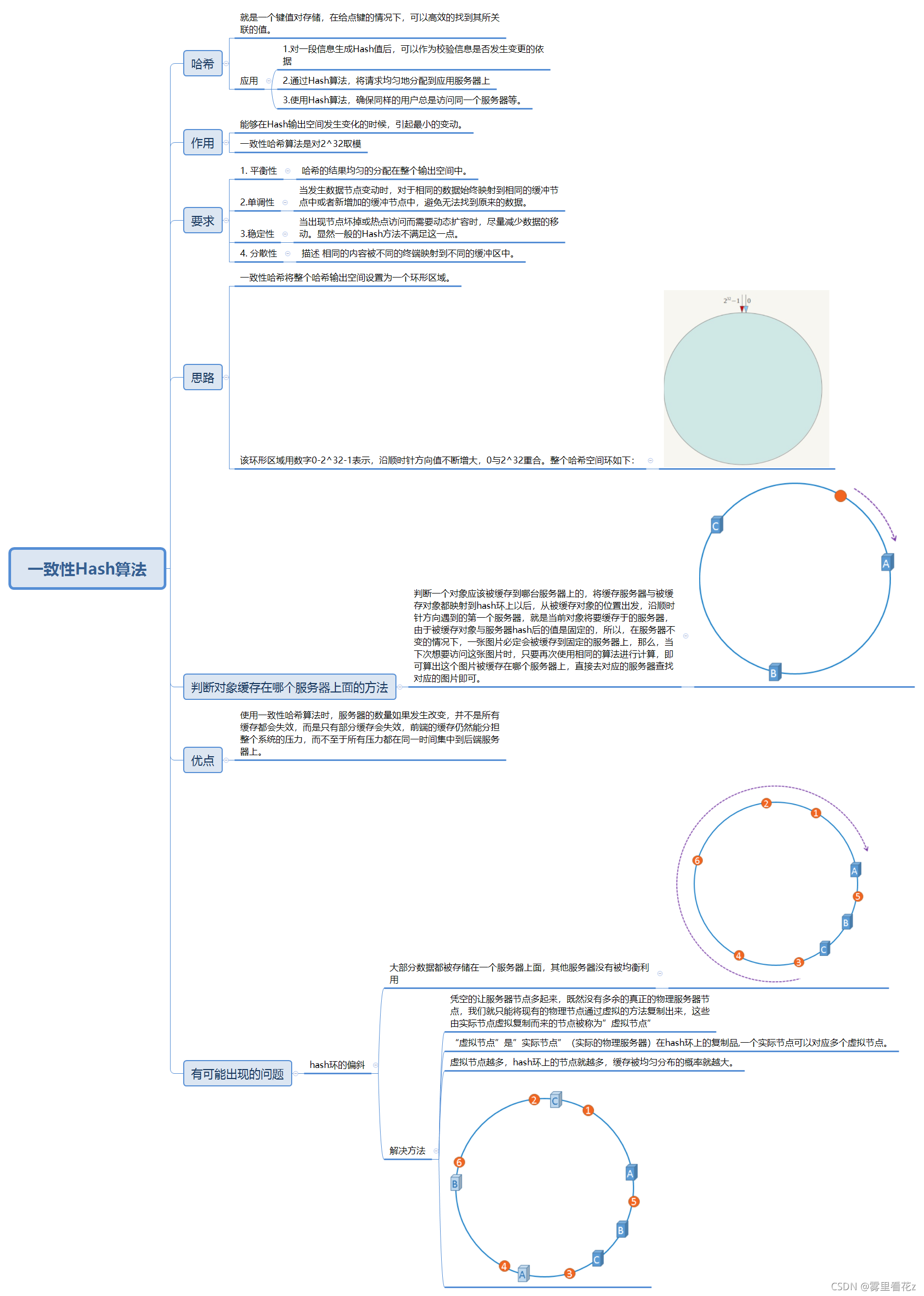

52.1 一致性哈希算法的理解

一致性哈希算法,就是在移除或增加一个节点的时候,能够尽可能小的改变已存在key的映射关系。

答案

1. 平衡性:平衡性是指哈希的结果能够尽可能分布到所有的缓冲中去,这样可以使得所有的缓冲空间都得到利用。

2. 单调性:单调性是指如果已经有一些内容通过哈希分派到了相应的缓冲中,又有新的缓冲加入到系统中。哈希的结果应能够保证原有已分配的内容可以被映射到原有的或者新的缓冲中去,而不会被映射到旧的缓冲集合中的其他缓冲区。

3. 分散性:分布式环境中,终端有可能看不到所有的缓冲,而是只能看到其中的一部分。当终端希望通过哈希过程将内容映射到缓冲上时,由于不同终端所见的缓冲范围有可能不同,从而导致哈希的结果不一致,最终的结果是相同的内容被不同的终端映射到不同的缓冲区中。

4. 负载(Load):负载问题实际上是从另一个角度看待分散性问题。既然不同的终端可能将相同的内容映射到不同的缓冲区中,那么对于一个特定的缓冲区而言,也可能被不同的用户映射为不同 的内容。与分散性一样,这种情况也是应当避免的,因此好的哈希算法应能够尽量降低缓冲的负荷。

一致性hash算法提出了在动态变化的Cache环境中,判定哈希算法好坏的四个定义:

53. 如何实现栈?

53.1 如何用队列实现栈?

其实就是两个队列就可以了。

54. Vector,ArrayList 与LinkedList 的区别

答案

Vector 是 Java 早期提供的线程安全的动态数组,如果不需要线程安全,并不建议选择,同步有额外开销,Vector 内部是使用对象数组保存数据,也可以根据需要自动增加容量,当数组已满时,会创建新的数组,并拷贝原数组数据。

ArrayList 是应用更广泛的动态数组,本身不是线程安全的,与 Vector 相似, ArrayList 也是可以根据需要调整容量,不过两者间的调整有区别,Vector 在扩容时提高一倍, ArrayList 则是增加 50%。

LinkedList 是 Java 提供的双向链表,所有它不需要调整容量,它也不是线程安全的。

Vector、 ArrayList、 LinkedList均为线型的数据结构,但是从实现方式与应用场景中又存在差别,可以从下面几个方面总结。

**底层实现方式**

ArrayList内部用数组来实现; LinkedList内部采用双向链表实现; Vector内部用数组实现。

**读写机制**

ArrayList在执行插入元素是超过当前数组预定义的最大值时,数组需要扩容,扩容过程需要调用底层System.arraycopy()方法进行大量的数组复制操作;在删除元素时并不会减少数组的容量 (如果需要缩小数组容量,可以调用trimToSize()方法);在查找元素时要遍历数组,对于非null的元素采取equals的方式寻找。

LinkedList在插入元素时,须创建一个新的Entry对象,并更新相应元素的前后元素的引用;在查找元素时,需遍历链表;在删除元素时,要遍历链表,找到要删除的元素,然后从链表上将此元 素删除即可。

Vector与ArrayList仅在插入元素时容量**扩充机制不一致**。对于Vector,默认创建一个大小为10的Object数组,并将capacityIncrement设置为0;当插入元素数组大小不够时,如 果capacityIncrement大于0,则将Object数组的大小扩大为现有size+capacityIncrement;如果capacityIncrement<=0,则将Object数组的大小扩大为现有大小的2倍。

**读写效率**

ArrayList对元素的增加和删除都会引起数组的内存分配空间动态发生变化。因此,对其进行插入和删除速度较慢,但检索速度很快。

LinkedList由于基于链表方式存放数据,增加和删除元素的速度较快,但是检索速度较慢。

**线程安全性**

ArrayList、 LinkedList为非线程安全;

Vector是基于synchronized实现的线程安全的ArrayList。

单线程应尽量使用ArrayList, Vector因为同步会有性能损耗;即使在多线程环境下,我们可以利用Collections这个类中为我们提供的synchronizedList(List list)方法返回一个 线程安全的同步列表对象。

vector:线程安全,自动增加容量

ArrayList:非线程安全,扩容增加不一致

LinkedList:双向链表

55.解析c++中函数重载的实现原理

倾轧技术

答案

C++函数重载底层实现原理是C++利用倾轧技术,来改名函数名,区分参数不同的同名函数。

**函数倾轧**: 同名不同参函数(重载函数),C++底层如何区分他们,那就是对函数改名,也就是中文翻译的“倾轧”(苦涩难懂的词),改名也是有规律的,不是随便命名,具体参见下面:

**重载的映射机制:作用域+返回类型+函数名+参数列表**

56. const 和 define的区别

编译器、存储方式、类型和安全检查、定义域、数据拷贝

答案

1. **编译器处理不同**宏定义是一个“编译时”概念,在预处理阶段展开,不能对宏定义进行调试,生命周期结束于编译时期。

const变量是一个运行时概念,在程序运行时使用,类似于一个只读行数据。

2. **存储方式不同**:宏定义是直接替换,不会分配内存。const变量是按内存分配。

3. **类型和安全检查不同**

宏定义是字符替换,没有数据类型的区别,同时这种替换没有类型安全检查,可能产生边际效应等错误;

const常量是常量的声明,有类型区别,需要在编译阶段进行类型检查。

4. **定义域不同**

5. **数据拷贝个数**:const定义常量从汇编的角度来看,只是给出 没有了存储与读内存的操作,使得它的效率也很高。

6. "占用的空间不同**:define预处理后,占用代码段空间,const

60. C++11的新特性

答案

1. **auto 关键字**:编译器可以根据初始值自动推导出类型。但是不能用于函数传参以及数组类型的推导。原理使用的是:模板实参推导机制。

2. **decltype关键字**:选择并返回操作数的数据类型。在这,编译器只是分析表达式的数据类型,并不实际计算其表达式。使用在当你指向获取这个表达式的返回值,而不想计算这个表达式时使用。

int func() {return 0}; decltype(func()) sum = 5;

3. **nullptr:**是一种特殊类型的字面值,它可以被转换成任意其他的指针类型。而NULL一般被宏定义为0,在遇到函数重载的时候可能会遇到问题。在C++11中,用nullptr替换了NULL.

4. **智能指针**:C++11新增了std::shared_ptr,std::weaked_ptr等类型的智能指针,用于解决内存管理的问题。

可变参数模板:对参数进行了高度泛化,可以表示任意数目、任意类型的参数,其语法为:在class或typename后面带上省略号”。

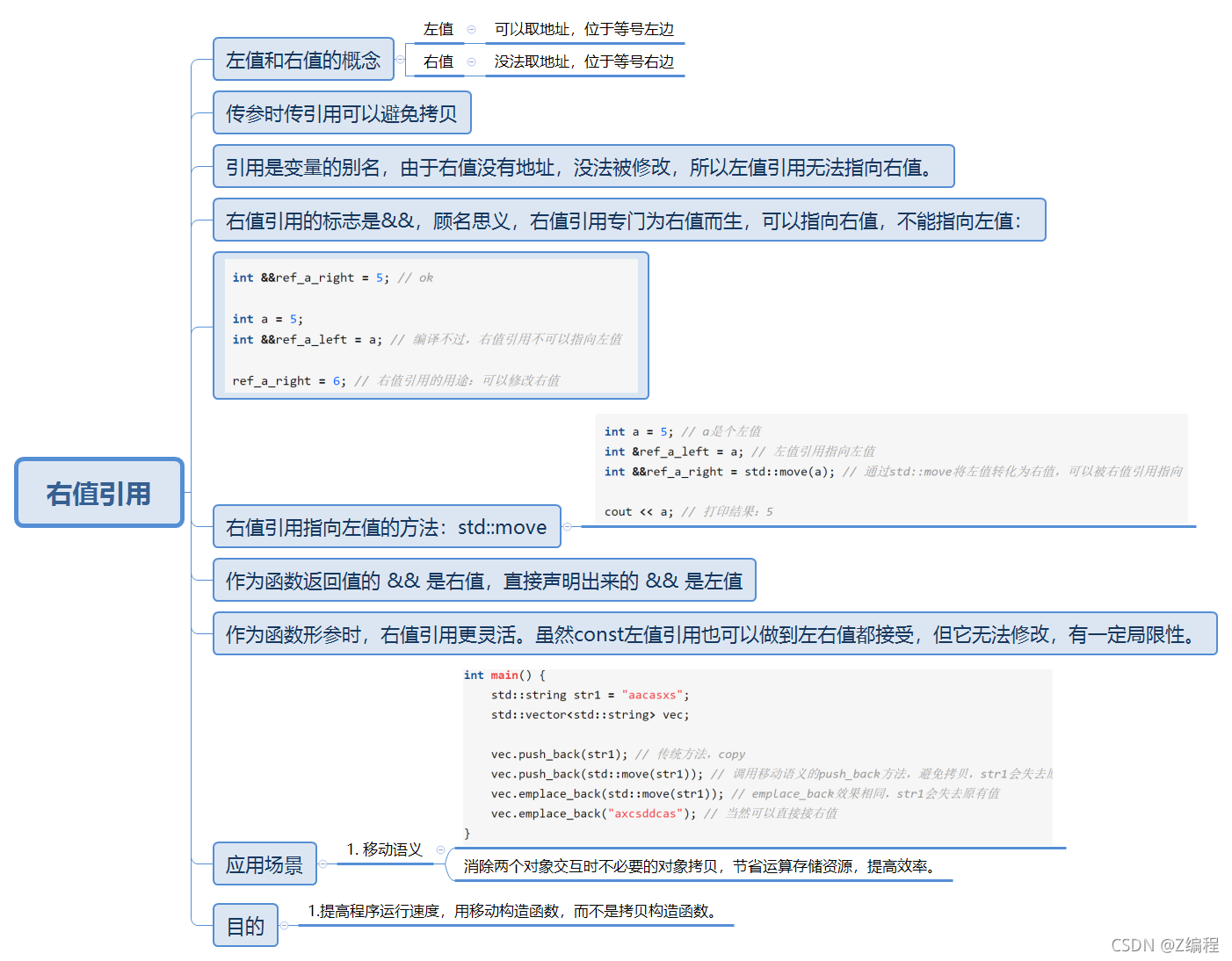

5. **右值引用:**

答案

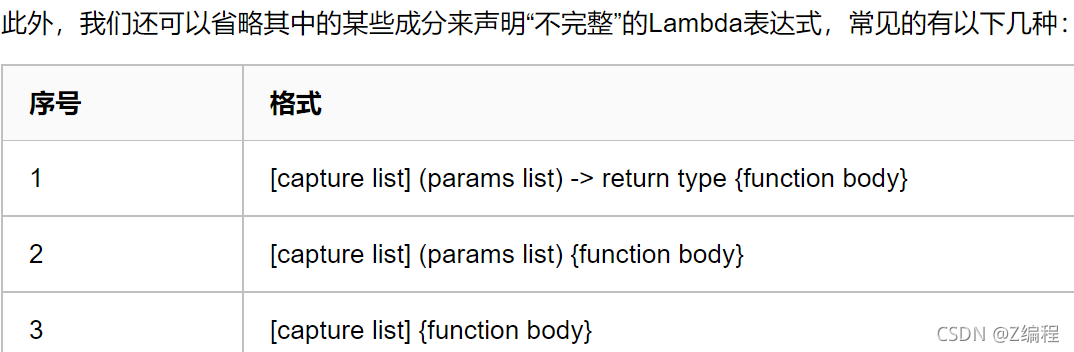

6. **lambda表达式:**利用Lambda表达式,可以方便的定义和创建匿名函数。

Lambda表达式完整的声明格式如下:

[capture list] (params list) mutable exception-> return type { function body }

各项具体含义如下:

>1. capture list:捕获外部变量列表

>2. params list:形参列表

>3. mutable指示符:用来说用是否可以修改捕获的变量

>4. exception:异常设定

>5. return type:返回类型

>6. function body:函数体

**Lambda表达式的使用场景**:

7. 在某个小函数是可以独立出来的时候,并且,在整个工程中只会使用一次的话。那么这个时候我们就考虑使用下Lambda表达式。

8. 省略取函数名字这个麻烦的操作。

9. 可以将Lambda表达式认为是匿名内联函数。

sort(lbvec.begin(), lbvec.end(), [](int a, int b) -> bool { return a < b; });

60.1 智能指针

60.1_1 智能指针的作用

答案

**说法一**:C++程序设计中使用堆内存是非常频繁的操作,堆内存的申请和释放都由程序员自己管理。程序员自己管理堆内存可以提高了程序的效率,但是整体来说堆内存的管理是麻烦的,C++11中引入了智能指针的概念,方便管理堆内存。使用普通指针,容易造成堆内存泄露(忘记释放),二次释放,程序发生异常时内存泄露等问题等,使用智能指针能更好的管理堆内存。**自动释放**

**说法二**:智能指针的作用就是为了保证在使用堆上对象时,对象一定会被释放,但只能释放一次,并且释放后指向该对象的指针应该马上归0.

60.1_2 智能指针的理解

答案

1. 从较浅的层面看,智能指针是利用了一种叫做RAII(资源获取即初始化)的技术对普通的指针进行封装,这使得智能指针实质是一个对象,行为表现的却像一个指针。

2. 智能指针的作用是防止忘记调用delete释放内存和程序异常的进入catch块忘记释放内存。另外指针的释放时机也是非常有考究的,多次释放同一个指针会造成程序崩溃,这些都可以通过智能指针来解决。

3. 智能指针还有一个作用是把值语义转换成引用语义。C++和Java有一处最大的区别在于语义不同,在Java里面下列代码:

Animal a = new Animal();

Animal b = a;

你当然知道,这里其实只生成了一个对象,a和b仅仅是把持对象的引用而已。但在C++中不是这样,

Animal a;

Animal b = a;

这里却是就是生成了两个对象。

聊一聊RAII原理

RAII(Resource Acquisition Is Initialization):使用局部对象来管理资源的技术称为资源获取即初始化。

1. RAII的步骤:

a.设计一个类封装资源。

b. 在构造函数中初始化。

c. 在析构函数中执行销毁操作。

d. 使用时声明一个该对象的类。

60.1_3 智能指针的使用

一、auto_ptr

答案

1. **缺点**:当发生对象拷贝 ,或者赋值时,他会悬空前者(即,释放掉了前者的资源)。

2. **作用**:主要是为了解决“有异常抛出时发生内存泄漏的问题”,抛出异常,将导致指针p所指向的空间得不到释放而导致内存泄漏。

3. 由于auto_ptr对象析构时会删除它所拥有的指针,所以使用时避免多个auto_ptr对象管理同一个指针。

4. Auto_ptr内部实现,析构函数中删除对象用的是delete而不是delete[],所以auto_ptr不能管理数组;

5. auto_ptr支持所拥有的指针类型之间的隐式类型转换。

6. 可以通过*和->运算符对auto_ptr所有用的指针进行提领操作;

7. T* get(),获得auto_ptr所拥有的指针;T* release(),释放auto_ptr的所有权,并将所有用的指针返回。

二、shared_ptr

- 简要介绍

答案

1. shared_ptr多个指针指向相同的对象。shared_ptr使用引用计数,每一个shared_ptr的拷贝都指向相同的内存。每使用他一次,内部的引用计数加1,每析构一次,内部的引用计数减1,减为0时,自动删除所指向的堆内存。shared_ptr内部的引用计数是线程安全的,但是对象的读取需要加锁。

2. std::shared_ptr确定最后一个引用它的对象何时被释放的基本想法是:对被管理的资源进行引用计数,当一个shared_ptr对象要共享这个资源的时候,该资源的引用计数加1,当这个对象生命期结束的时候,再把该引用技术减少1。这样当最后一个引用它的对象被释放的时候,资源的引用计数减少到0,此时释放该资源。

3. 初始化。智能指针是个模板类,可以指定类型,传入指针通过构造函数初始化。也可以使用make_shared函数初始化。不能将指针直接赋值给一个智能指针,一个是类,一个是指针。例如std::shared_ptr<int> p4 = new int(1);的写法是错误的。

4. 拷贝和赋值。拷贝使得对象的引用计数增加1,赋值使得原对象引用计数减1,当计数为0时,自动释放内存。后来指向的对象引用计数加1,指向后来的对象。

5. get函数获取原始指针。注意不要用一个原始指针初始化多个shared_ptr,否则会造成二次释放同一内存,注意避免循环引用,shared_ptr的一个最大的陷阱是循环引用,循环,循环引用会导致堆内存无法正确释放,导致内存泄漏。循环引用在weak_ptr中介绍。

- shared_ptr的初始化

答案

//初始化方式1

std::shared_ptr<int> sp1(new int(123));

//初始化方式2

std::shared_ptr<int> sp2;

sp2.reset(new int(123));

//初始化方式3

std::shared_ptr<int> sp3;

sp3 = std::make_shared<int>(123);

三、weak_ptr

为了解决shared_ptr相互引用的问题,导致资源无法释放的问题。

- weak_ptr的特点:

答案

1) 一个对象被多个shared_ptr类所指向时,就会拥有多个引用计数,但是当weak_ptr指向一个shared_ptr类所指向的对象时,该对象的引用计数不会增加.

2) 因此,当最后一个对象的最后一个shared_ptr类被释放时,该对象会被释放。即使此时仍有weak_ptr指向该对象,该对象的内存仍然会被释放

3) 标准库提供了weak_ptr,允许“共享但不拥有”某对象。

一旦最后一个对象释放掉以后,所有的weak pointer都将为空,因此,除了默认和复制构造函数之外,weak_ptr只提供接受一个shared_ptr的构造函数。

4) weak_ptr虽然是一个模板类,但是不能用来直接定义指向原始指针的对象。

5)weak_ptr接受shared_ptr类型的变量赋值,但是反过来是行不通的,需要使用lock函数。

6) 由于不知道什么之后weak_ptr所指向的对象就会被析构掉,所以使用之前请先使用expired函数检测一下。

- 如何使用weak_ptr

我们需要使用一个shared_ptr类来初始化weak_ptr类

答案

auto p=make_shared<int>(42); //初始化一个shared_ptr对象

weak_ptr<int> wp(p); //用p初始化wp,wp弱共享p

//wp只是指向p所指的对象,p的引用计数没有改变,并且p所指对象的释放也与wp无关

- weak_ptr的源码实现

weak_ptr的源码实现

- 解决循环引用的示例

答案

#include <iostream>

#include <stdio.h>

#include <string>

using namespace std;

class B;

class A

{

public:

A()

{

cout << "---->A" << endl;

}

~A()

{

cout << "--->~A" << endl;

}

shared_ptr<B> m_Aptr;

};

class B

{

public:

B()

{

cout << "--->B" << endl;

}

~B()

{

cout << "--->~B"<< endl;

}

weak_ptr<A> m_Bptr;

};

int main()

{

shared_ptr<B> p1(new B());

shared_ptr<A> p2(new A());

p1->m_Bptr = p2;

p2->m_Aptr = p1;

cout << p1.use_count() << endl;

cout << p2.use_count() << endl;

return 0;

}

四、unique_ptr

答案

强调一个资源只能被一个智能指针所引用。

1. 简单介绍一下unique_ptr指针

unique_ptr指针是一个原生指针独一无二的拥有者和管理者,当一个unique离开其作用域时,其管理的原生指针会被自动销毁。

2. 源码分析

1).

// file: <memory>

template<class _Tp, class _Dp = default_delete<_Tp> >

class unique_ptr {