论文笔记——Deep Model Compression Distilling Knowledge from Noisy Teachers

论文地址:https://arxiv.org/abs/1610.09650

主要思想

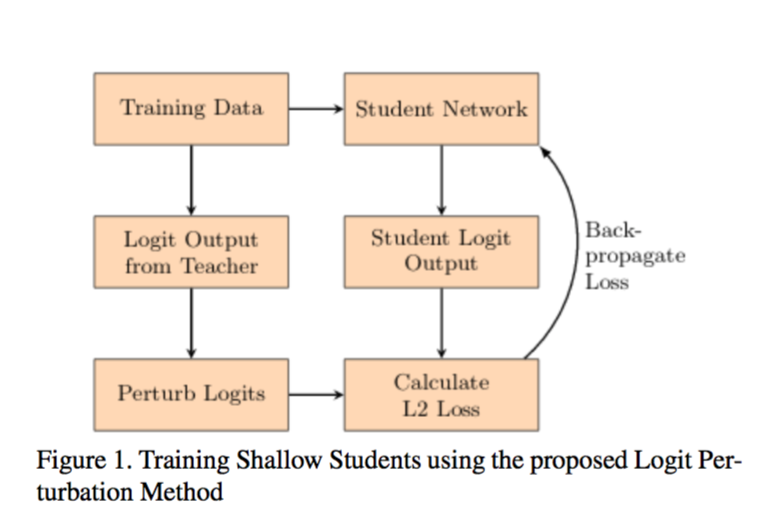

这篇文章就是用teacher-student模型,用一个teacher模型来训练一个student模型,同时对teacher模型的输出结果加以噪声,然后来模拟多个teacher,这也是一种正则化的方法。

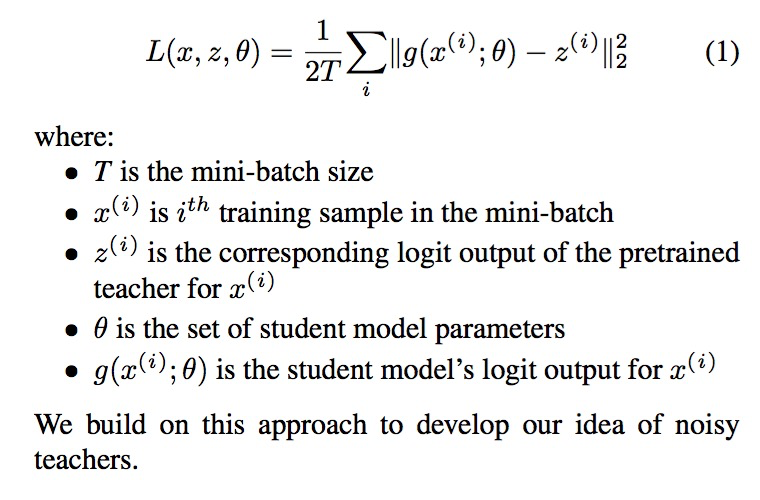

1. teacher输出的结果加噪声以后,然后和student的输出结果计算L2 loss,作为student网络的反馈。

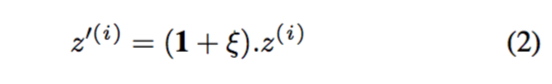

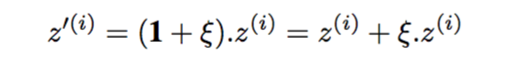

2. 加噪声

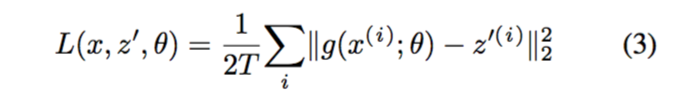

3. 计算L2 loss

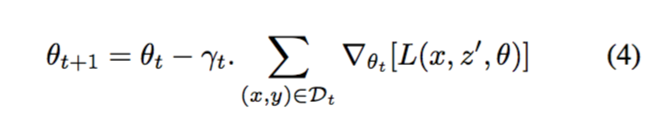

4. 反向传播,更新参数

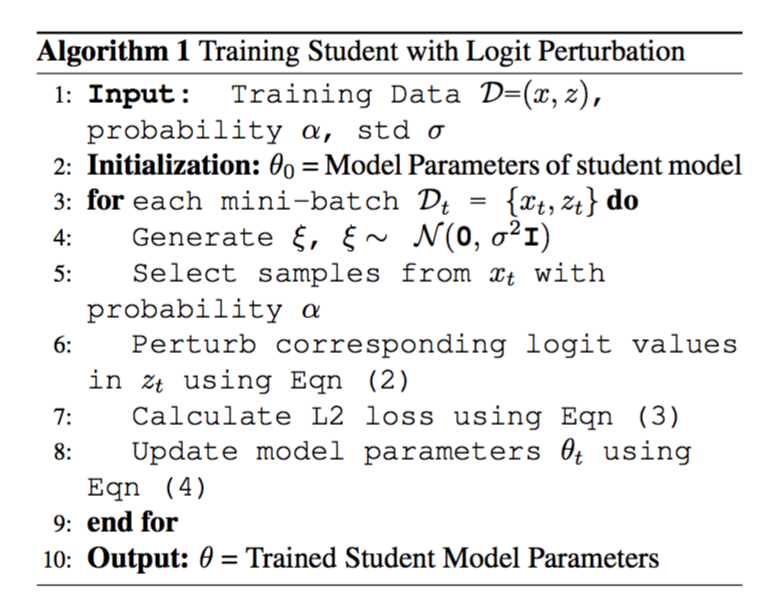

5. 算法过程

- 注意:加噪声的时候对输入进行了采样,不然直接全加也太暴力了吧。

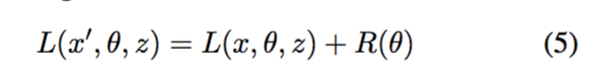

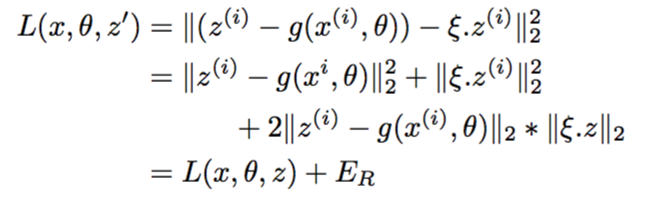

等价于基于噪声的回归

实验结果

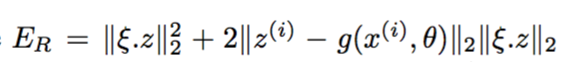

1. 对比了不同噪声比例对结果的影响,其实就是调参的过程。

2. 比较了学生加噪声和教师加噪声,结果是教师加噪声效果更加明显。

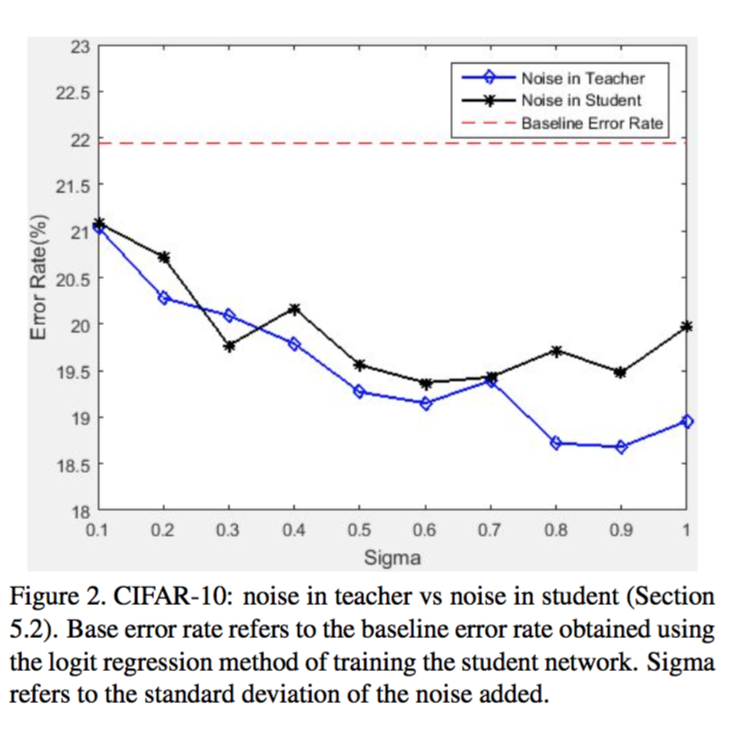

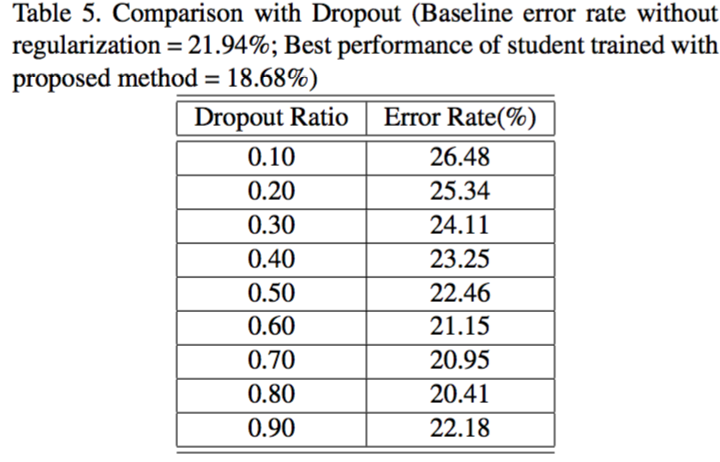

3. 比较了教师加噪声和一般的正则化操作(dropout)

总结

本文想法比较简单,就是给teacher输出结果加噪声,美曰其名,learn from multi teachers.

浙公网安备 33010602011771号

浙公网安备 33010602011771号