小白系列2——nn.ReLU与nn.LeakyReLU的区别

nn.ReLU与nn.LeakyReLU的区别

因为之前从未接触过这方面,直接接手GAN,有点吃力,如有明显漏洞,请指正,我会感激不尽。

昨晚查阅了ReLU的含义,结果今天发现高老师给的代码中又有一个LeakyReLU,所以今天这个小白贴来对比下两者:

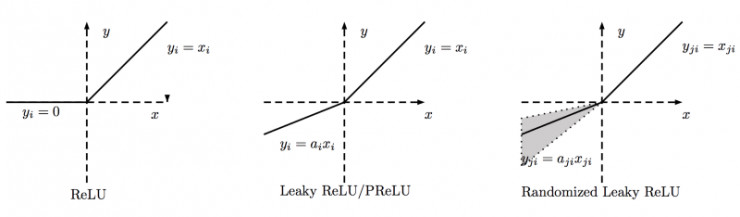

下图是ReLU、Leaky ReLU、PReLU和RReLU的比较:

ReLU是将所有的负值都设为零,相反,Leaky ReLU是给所有负值赋予一个非零斜率。

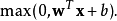

可以看到,ReLU函数即小于0的就等于0,大于0的就等于原函数.=max(0,x)=

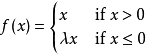

LeakyReLu的函数为

浙公网安备 33010602011771号

浙公网安备 33010602011771号