Redis笔记(下)

1、Redis持久化

面试和工作,持久化都是重点!

Redis 是内存数据库,如果不将内存中的数据库状态保存到磁盘,那么一旦服务器进程退出,服务器中的数据库状态也会消失。所以 Redis 提供了持久化功能!

RDB(Redis DataBase)

在指定的时间间隔内将内存中的数据集快照写入磁盘,也就是行话讲的Snapshot快照,它恢复时是将快照文件直接读到内存里。

Redis会单独创建(fork)一个子进程来进行持久化,会先将数据写入到一个临时文件中,待持久化过程都结束了,再用这个临时文件替换上次持久化好的文件。整个过程中,主进程是不进行任何IO操作的。这就确保了极高的性能。如果需要进行大规模数据的恢复,且对于数据恢复的完整性不是非常敏感,那RDB方式要比AOF方式更加的高效。RDB的缺点是最后一次持久化后的数据可能丢失。我们默认的就是RDB,一般情况下不需要修改这个配置!

有时候在生产环境我们会将这个文件进行备份!

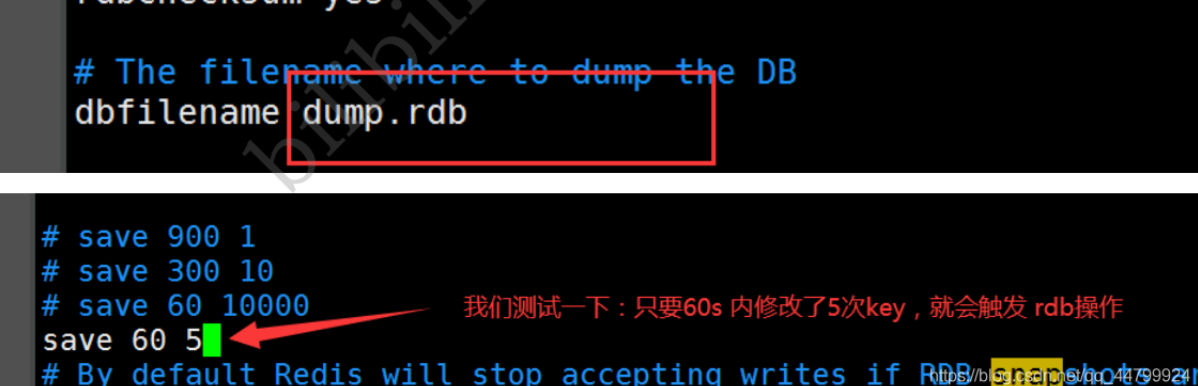

rdb保存的文件是dump.rdb 都是在我们的配置文件中快照中进行配置的!

1.触发机制

- (1)save的规则满足的情况下,会自动触发rdb规则

- (2)执行 flushall 命令,也会触发我们的rdb规则!

- (3)退出redis,也会产生 rdb 文件!

备份就自动生成一个 dump.rdb

2.如何恢复rdb文件?

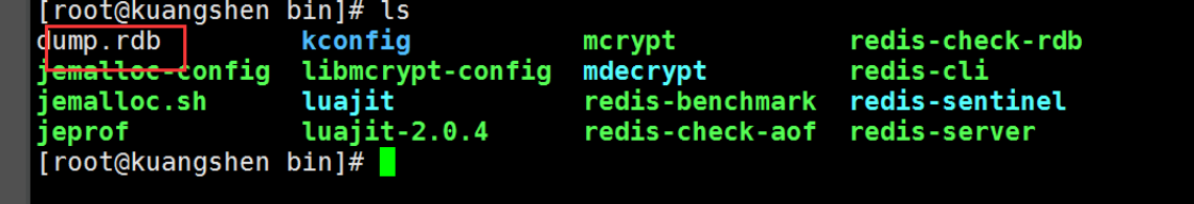

- (1)只需要将rdb文件放在我们redis启动目录就可以,redis启动的时候会自动检查dump.rdb 恢复其中的数据!

- (2)查看需要存在的位置

127.0.0.1:6379> config get dir 1) "dir" 2) "/usr/local/bin" # 如果在这个目录下存在 dump.rdb 文件,启动就会自动恢复其中的数据

几乎Redis的默认配置就够用了,但是我们还是需要去学习!

RDB优点:

1、适合大规模的数据恢复!

2、对数据的完整性要不高!

RDB缺点:

1、需要一定的时间间隔进程操作!如果redis意外宕机了,这个最后一次修改数据就没有的了!

2、fork进程的时候,会占用一定的内容空间

案例:使用RDB方式恢复数据

1、登录服务器 [root@vm172-16-61-151 bin]# ./redis-cli 2、找到Redis备份文件的存放目录 127.0.0.1:6379> CONFIG GET dir 1) "dir" 2) "/usr/local/redis/bin" 3、添加一些测试数据,并执行保存,会默认在上面dir目录下生成dump.rdb文件 127.0.0.1:6379> set k1 v1 OK 127.0.0.1:6379> set k2 v2 OK 127.0.0.1:6379> set k3 v3 OK 127.0.0.1:6379> save OK 127.0.0.1:6379> flushdb #清空数据,等会通过备份文件进行恢复 OK 127.0.0.1:6379> keys * (empty list or set) 4、停止redi [root@vm172-16-61-151 bin]# ps -ef|grep redis root 30197 1 0 11:51 ? 00:00:00 ./redis-server *:6379 root 30390 30240 0 11:53 pts/0 00:00:00 grep --color=auto redis [root@vm172-16-61-151 bin]# kill -9 30197 5、恢复文件:将dump.rbd放到dir目录("/usr/local/redis/bin")下,重新启动reids会自动加载这个文件 [root@vm172-16-61-151 bin]# ls dump.rdb redis-benchmark redis-check-aof redis-check-rdb redis-cli redis-sentinel redis-server [root@vm172-16-61-151 bin]# ./redis-server ../etc/redis.conf # 启动redis [root@vm172-16-61-151 bin]# ./redis-cli 127.0.0.1:6379> keys * 1) "k3" 2) "k2" 3) "k1"

AOF(Append Only File)

将我们的所有命令都记录下来,history,恢复的时候就把这个文件全部在执行一遍!

以日志的形式来记录每个写操作,将Redis执行过的所有指令记录下来(读操作不记录),只许追加文件但不可以改写文件,redis启动之初会读取该文件重新构建数据,换言之,redis重启的话就根据日志文件的内容将写指令从前到后执行一次以完成数据的恢复工作

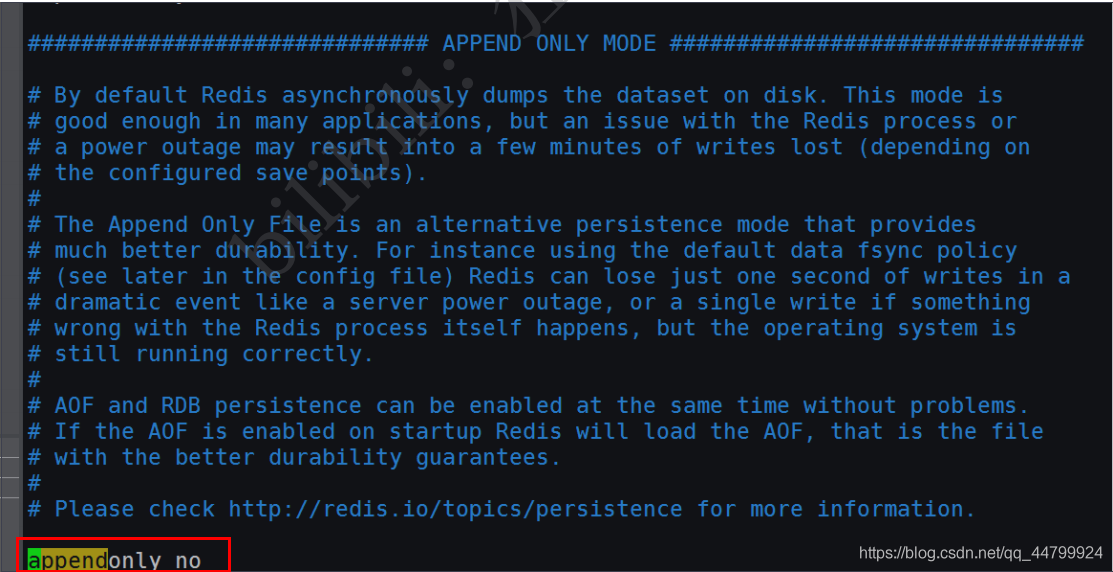

Aof保存的是 appendonly.aof 文件

append

默认是不开启的,我们需要手动进行配置!我们只需要将 appendonly 改为yes就开启了 aof!

重启,redis 就可以生效了!

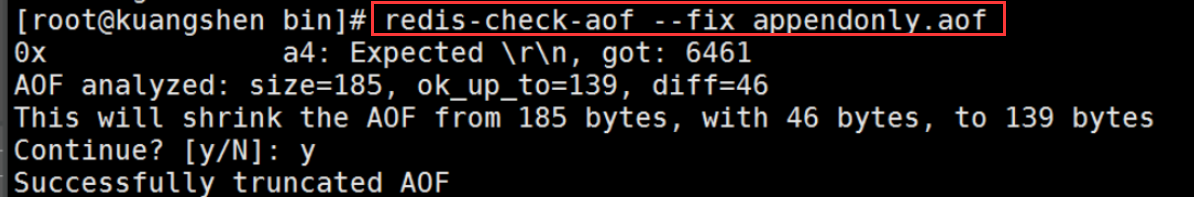

如果这个 aof 文件有错误,这时候 redis 是启动不起来的吗,我们需要修复这个aof文件

redis 给我们提供了一个工具 redis-check-aof --fix

如果文件正常,重启就可以直接恢复了!

重写规则说明

aof 默认就是文件的无限追加,文件会越来越大!

如果 aof 文件大于 64m,太大了! fork一个新的进程来将我们的文件进行重写!

优点和缺点!

appendonly no # 默认是不开启aof模式的,默认是使用rdb方式持久化的,在大部分所有的情况下, rdb完全够用! appendfilename "appendonly.aof" # 持久化的文件的名字 # appendfsync always # 每次修改都会 sync。消耗性能 appendfsync everysec # 每秒执行一次 sync,可能会丢失这1s的数据! # appendfsync no # 不执行 sync,这个时候操作系统自己同步数据,速度最快! # rewrite 重写

优点:

- 1、每一次修改都同步,文件的完整会更加好!

- 2、每秒同步一次,可能会丢失一秒的数据

- 3、从不同步,效率最高的!

缺点:

- 1、相对于数据文件来说,aof远远大于 rdb,修复的速度也比 rdb慢!

- 2、Aof 运行效率也要比 rdb 慢,所以我们redis默认的配置就是rdb持久化!

扩展:

- 1、RDB 持久化方式能够在指定的时间间隔内对你的数据进行快照存储

- 2、AOF 持久化方式记录每次对服务器写的操作,当服务器重启的时候会重新执行这些命令来恢复原始的数据,AOF命令以Redis 协议追加保存每次写的操作到文件末尾,Redis还能对AOF文件进行后台重写,使得AOF文件的体积不至于过大。

- 3、只做缓存,如果你只希望你的数据在服务器运行的时候存在,你也可以不使用任何持久化

- 4、同时开启两种持久化方式在这种情况下,当redis重启的时候会优先载入AOF文件来恢复原始的数据,因为在通常情况下AOF文件保存的数据集要比RDB文件保存的数据集要完整。RDB 的数据不实时,同时使用两者时服务器重启也只会找AOF文件,那要不要只使用AOF呢?作者建议不要,因为RDB更适合用于备份数据库(AOF在不断变化不好备份),快速重启,而且不会有AOF可能潜在的Bug,留着作为一个万一的手段。

- 5、性能建议因为RDB文件只用作后备用途,建议只在Slave上持久化RDB文件,而且只要15分钟备份一次就够了,只保留 save 900 1 这条规则。如果Enable AOF ,好处是在最恶劣情况下也只会丢失不超过两秒数据,启动脚本较简单只load自己的AOF文件就可以了,代价一是带来了持续的IO,二是AOF rewrite 的最后将 rewrite 过程中产生的新数据写到新文件造成的阻塞几乎是不可避免的。只要硬盘许可,应该尽量减少AOF rewrite的频率,AOF重写的基础大小默认值64M太小了,可以设到5G以上,默认超过原大小100%大小重写可以改到适当的数值。如果不Enable AOF ,仅靠 Master-Slave Repllcation 实现高可用性也可以,能省掉一大笔IO,也减少了rewrite时带来的系统波动。代价是如果Master/Slave 同时倒掉,会丢失十几分钟的数据,启动脚本也要比较两个 Master/Slave 中的 RDB文件,载入较新的那个,微博就是这种架构。

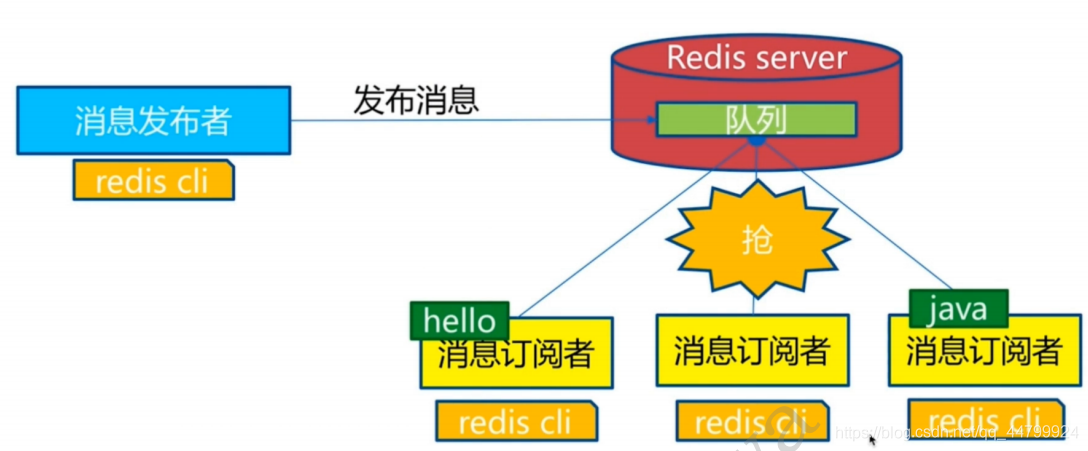

2、Redis发布订阅

Redis 发布订阅(pub/sub)是一种消息通信模式:发送者(pub)发送消息,订阅者(sub)接收消息。微信、微博、关注系统!

Redis 客户端可以订阅任意数量的频道。

订阅/发布消息图:

第一个:消息发送者, 第二个:频道 第三个:消息订阅者!

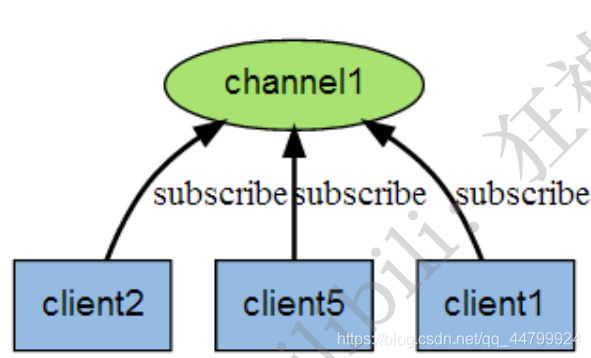

下图展示了频道 channel1 , 以及订阅这个频道的三个客户端 —— client2 、 client5 和 client1 之间的关系:

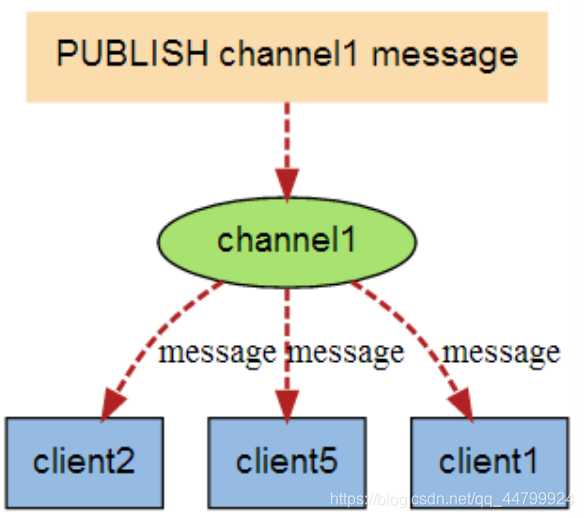

当有新消息通过 PUBLISH 命令发送给频道 channel1 时, 这个消息就会被发送给订阅它的三个客户端:

命令

这些命令被广泛用于构建即时通信应用,比如网络聊天室(chatroom)和实时广播、实时提醒等。

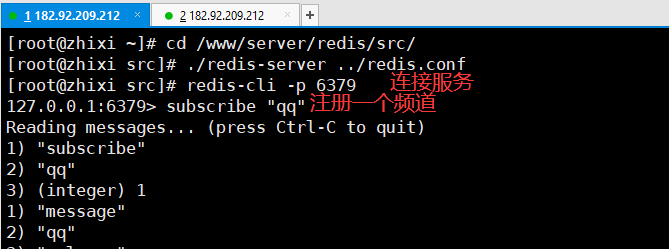

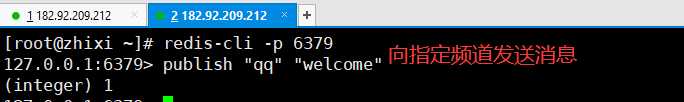

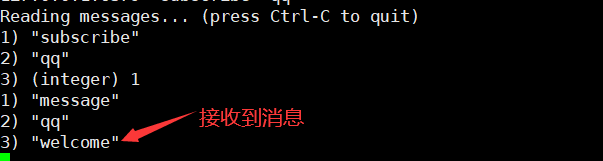

redis测试消息订阅与发送:

1、在一个窗口注册频道

2、在另外一个窗口连接到指定的频道,发送消息

3、频道1接收到消息

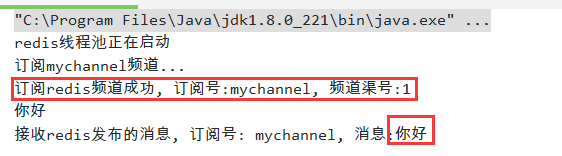

java实现redis的订阅与发布:

特性介绍:

什么是redis的发布订阅(pub/sub)? Pub/Sub功能(means Publish, Subscribe)即发布及订阅功能。基于事件的系统中,Pub/Sub是目前广泛使用的通信模型,它采用事件作为基本的通信机制,提供大规模系统所要求的松散耦合的交互模式:订阅者(如客户端)以事件订阅的方式表达出它有兴趣接收的一个事件或一类事件;发布者(如服务器)可将订阅者感兴趣的事件随时通知相关订阅者。熟悉设计模式的朋友应该了解这与23种设计模式中的观察者模式极为相似。

同样,Redis的pub/sub是一种消息通信模式,主要的目的是解除消息发布者和消息订阅者之间的耦合, Redis作为一个pub/sub的server, 在订阅者和发布者之间起到了消息路由的功能。

如果没听懂上述的专业解释,没关系,其实我也没太听懂。

简单来讲,这里面还有个channel的概念,这里就是频道的意思,比如你订阅了银行的频道,当你的资金发生变动时,银行就会通过它的频道给你发送信息,在这里,你是属于被动接收的,而不是向银行索要信息,这个例子中,你就是sub(订阅者),而银行就是pub(发布者)。

项目运用场景:

一直都认为你会一样技术之前,都必须先明白这样一种技术在哪些地方会被用到,不能盲目的学东西。

看到发布订阅的特性,用来做一个简单的实时聊天系统再适合不过了。这是其中之一,当然这样的东西,我们开发中很少涉及到。再举一个常用的,在我们的分布式架构中,常常会遇到读写分离的场景,在写入的过程中,就可以使用redis发布订阅,使得写入值及时发布到各个读的程序中,就保证数据的完整一致性。再比如,在一个博客网站中,有100个粉丝订阅了你,当你发布新文章,就可以推送消息给粉丝们拉。总之场景很多,需要去挖掘。。

回顾java如何操作redis:

redis是一种缓存数据库,它也是C/S的结构,也就是客户端和服务端,一般来说,在java中,我们通常使用 jedis(客户端)去操作redis(服务端),这其中操作的时候,两者之间肯定要建立连接,就像数据库链接一样,在关系型数据库中,我们一般都维护一个连接池,以达到链接的复用,来省去建立连接和关闭连接的时间。所以在jedis中,同样也存在一个jedispool(jedis连接池)的概念,我们都是从池中去取连接使用。

实现代码:

1、引入依赖

<!-- 操作redis -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>

<!--redis客户端-->

<dependency>

<groupId>redis.clients</groupId>

<artifactId>jedis</artifactId>

<version>2.9.0</version>

</dependency>

2、创建消息发布者:Publisher

package com.zhixi.chatroom;

import redis.clients.jedis.Jedis;

import redis.clients.jedis.JedisPool;

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

/**

* @author zhangzhixi

* @date 2021/3/2 19:06

* 消息的发布者

*/

public class Publisher extends Thread {

private final JedisPool jedisPool;

public Publisher(JedisPool jedisPool) {

this.jedisPool = jedisPool;

}

@Override

public void run() {

BufferedReader reader = new BufferedReader(new InputStreamReader(System.in));

//连接池中取出一个连接

Jedis jedis = jedisPool.getResource();

while (true) {

String line = null;

try {

line = reader.readLine();

if (!"quit".equals(line)) {

//从 mychannel 的频道上推送消息

jedis.publish("mychannel", line);

} else {

break;

}

} catch (IOException e) {

e.printStackTrace();

}

}

}

}

3、创建消息的订阅者:Subscribe

package com.zhixi.chatroom;

import redis.clients.jedis.JedisPubSub;

/**

* @author zhangzhixi

* @date 2021/3/2 19:23

* 消息的订阅者

*/

public class Subscriber extends JedisPubSub {

public Subscriber() {

}

@Override

public void onMessage(String channel, String message) { //收到消息会调用

System.out.println("接收redis发布的消息, 订阅号: " + channel + ", 消息:" + message + "");

}

@Override

public void onSubscribe(String channel, int subscribedChannels) { //订阅了频道会调用

System.out.println("订阅redis频道成功, 订阅号:" + channel + ", 频道渠号:" + subscribedChannels + "");

}

@Override

public void onUnsubscribe(String channel, int subscribedChannels) { //取消订阅 会调用

System.out.println("退订Redis频道, 订阅号:" + channel + ", 频道渠号:" + subscribedChannels + "");

}

}

4、订阅者去订阅频道

package com.zhixi.chatroom;

import redis.clients.jedis.Jedis;

import redis.clients.jedis.JedisPool;

/**

* @author zhangzhixi

* @date 2021/3/2 19:23

* 订阅频道

*/

public class SubThread extends Thread {

private final JedisPool jedisPool;

// 消息的订阅者

private final Subscriber subscriber = new Subscriber();

// 消息的频道

private final String channel = "mychannel";

public SubThread(JedisPool jedisPool) {

super("SubThread");

this.jedisPool = jedisPool;

}

@Override

public void run() {

System.out.println("订阅" + channel + "频道...");

Jedis jedis = null;

try {

//取出一个连接

jedis = jedisPool.getResource();

//通过subscribe 的api去订阅,入参是订阅者和频道名

jedis.subscribe(subscriber, channel);

} catch (Exception e) {

System.out.println(String.format("subsrcibe channel error, %s", e));

} finally {

if (jedis != null) {

jedis.close();

}

}

}

}

5、测试类

package com.zhixi.chatroom;

import redis.clients.jedis.JedisPool;

import redis.clients.jedis.JedisPoolConfig;

/**

* @author zhangzhixi

* @date 2021/3/2 19:23

*/

public class PubSubDemo {

public static void main(String[] args) {

// 连接redis服务端

JedisPool jedisPool = new JedisPool(new JedisPoolConfig(), "182.92.209.212", 6379);

System.out.println("redis线程池正在启动");

//订阅者

SubThread subThread = new SubThread(jedisPool);

subThread.start();

//发布者

Publisher publisher = new Publisher(jedisPool);

publisher.start();

}

}

6、测试结果

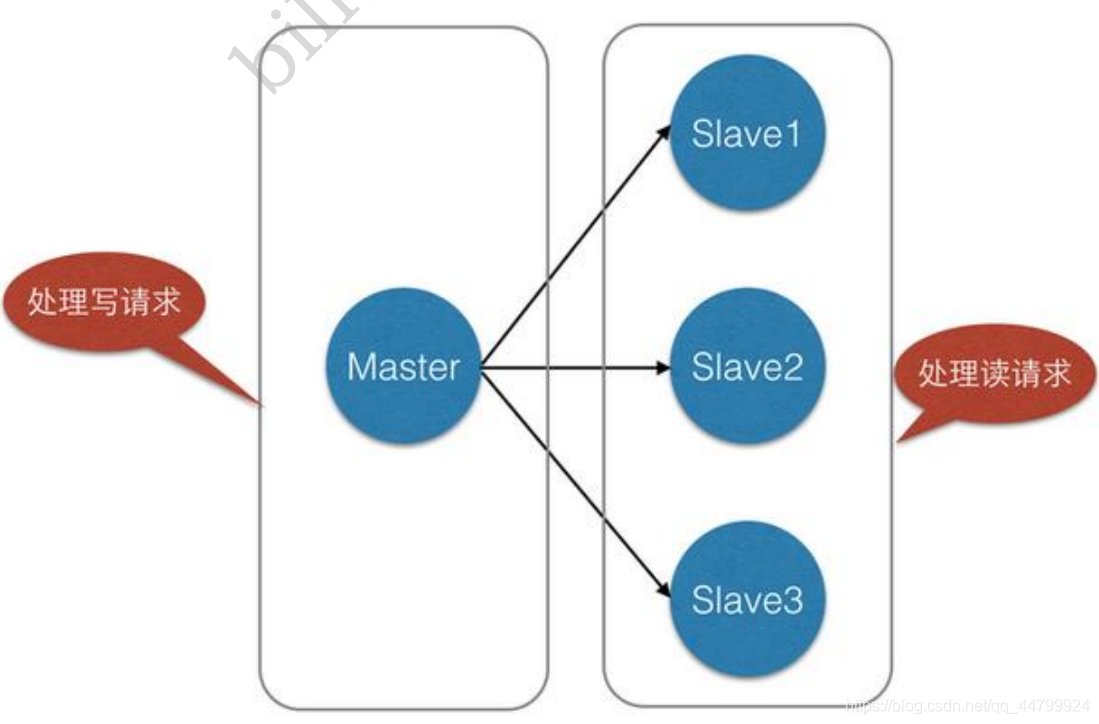

3、Redis主从复制

new-博客链接:https://www.cnblogs.com/zhangzhixi/p/17636887.html

概念

主从复制,是指将一台Redis服务器的数据,复制到其他的Redis服务器。前者称为主节点(master/leader),后者称为从节点(slave/follower);数据的复制是单向的,只能由主节点到从节点。

Master以写为主,Slave 以读为主。

默认情况下,每台Redis服务器都是主节点;

且一个主节点可以有多个从节点(或没有从节点),但一个从节点只能有一个主节点。()

主从复制的作用主要包括:

- 1、数据冗余:主从复制实现了数据的热备份,是持久化之外的一种数据冗余方式。

- 2、故障恢复:当主节点出现问题时,可以由从节点提供服务,实现快速的故障恢复;实际上是一种服务的冗余。

- 3、负载均衡:在主从复制的基础上,配合读写分离,可以由主节点提供写服务,由从节点提供读服务(即写Redis数据时应用连接主节点,读Redis数据时应用连接从节点),分担服务器负载;尤其是在写少读多的场景下,通过多个从节点分担读负载,可以大大提高Redis服务器的并发量。

- 4、高可用(集群)基石:除了上述作用以外,主从复制还是哨兵和集群能够实施的基础,因此说主从复制是Redis高可用的基础。

一般来说,要将Redis运用于工程项目中,只使用一台Redis是万万不能的(宕机),原因如下:

- 1、从结构上,单个Redis服务器会发生单点故障,并且一台服务器需要处理所有的请求负载,压力较大;

- 2、从容量上,单个Redis服务器内存容量有限,就算一台Redis服务器内存容量为256G,也不能将所有内存用作Redis存储内存,一般来说,单台Redis最大使用内存不应该超过20G。

电商网站上的商品,一般都是一次上传,无数次浏览的,说专业点也就是"多读少写"。

对于这种场景,我们可以使如下这种架构:

主从复制,读写分离! 80% 的情况下都是在进行读操作!减缓服务器的压力!架构中经常使用! 一主二从!

只要在公司中,主从复制就是必须要使用的,因为在真实的项目中不可能单机使用Redis!

环境配置

只配置从库,不用配置主库!

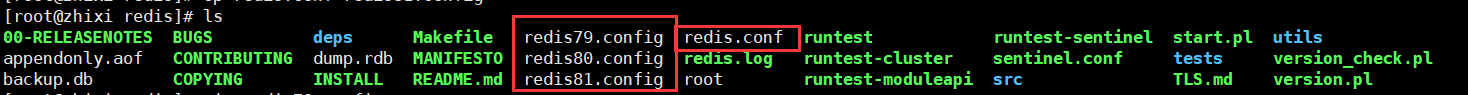

复制3个配置文件:cp redis.config redis79.config...

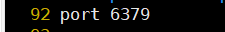

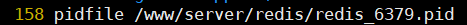

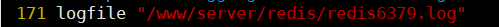

修改信息:

- 1、端口

- 2、pid 名字

- 3、log文件名字

- 4、dump.rdb 名字

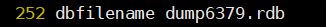

修改完毕之后,启动我们的3个redis服务器,可以通过进程信息查看!

一主二从

默认情况下,每台Redis服务器都是主节点; 我们一般情况下只用配置从机就好了!

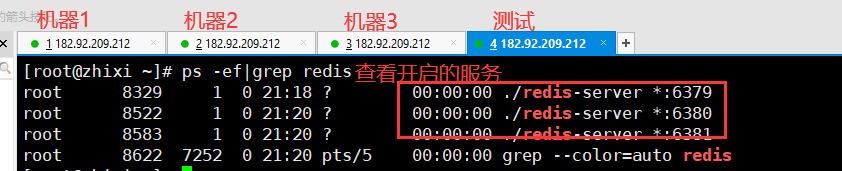

认老大! 一主 (79)二从(80,81)

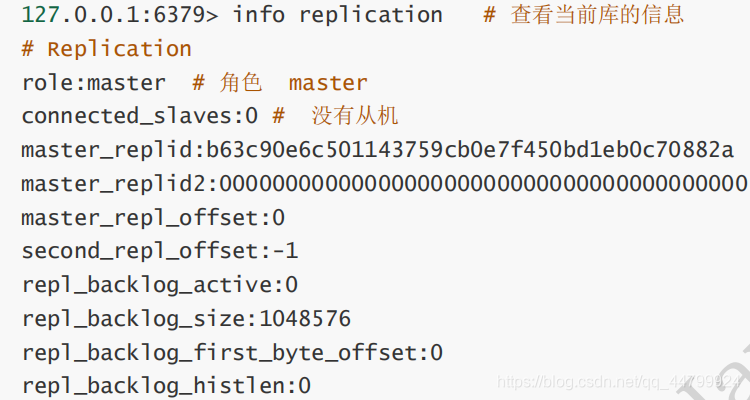

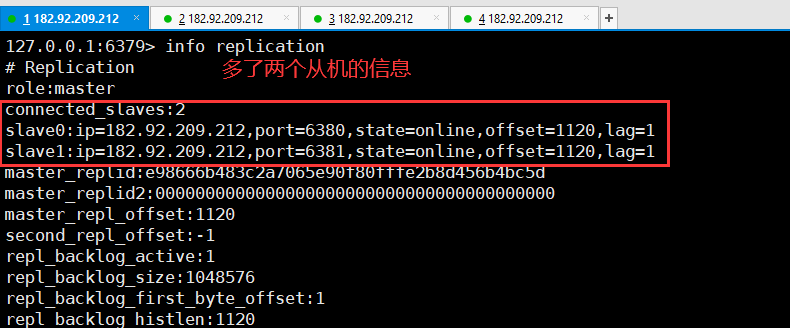

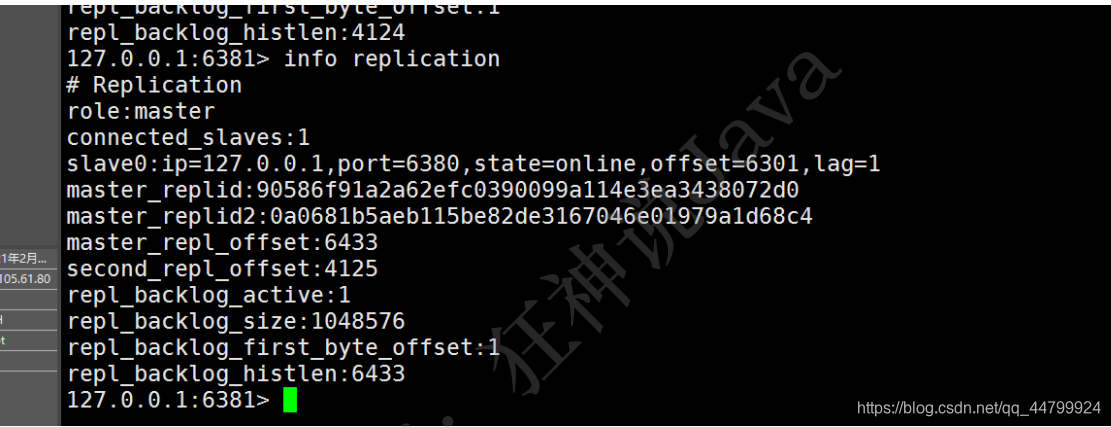

在主机中查看:

真实的从主配置应该在配置文件中配置,这样的话是永久的,我们这里使用的是命令,暂时的!

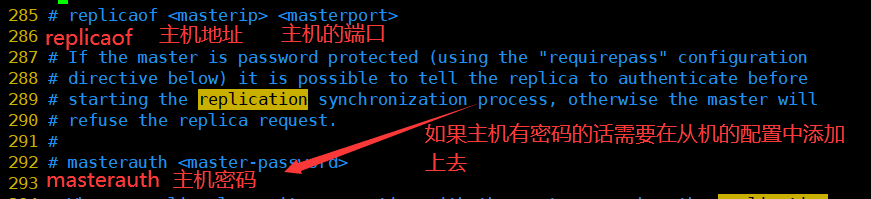

从机配置主机的信息:

注意:

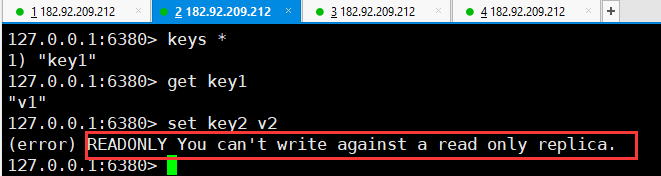

主机可以写,从机不能写只能读!主机中的所有信息和数据,都会自动被从机保存!

主机写:

从机只能读取,不能写入:

测试:主机断开连接,从机依旧连接到主机的,但是没有写操作,这个时候,主机如果回来了,从机依旧可以直接获取到主机写的信息!

如果是使用命令行,来配置的主从,这个时候如果重启了,就会变回主机!只要变为从机,立马就会从主机中获取值!

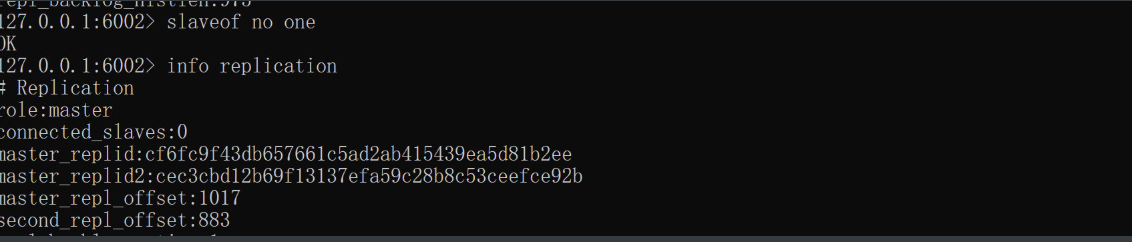

恢复从节点为之前的状态(master):slaveof no one

复制原理

Slave 启动成功连接到 master 后会发送一个sync同步命令

Master 接到命令,启动后台的存盘进程,同时收集所有接收到的用于修改数据集命令,在后台进程执行完毕之后,master将传送整个数据文件到slave,并完成一次完全同步。

- 全量复制:而slave服务在接收到数据库文件数据后,将其存盘并加载到内存中。

- 增量复制:Master继续将新的所有收集到的修改命令依次传给slave,完成同步

但是只要是重新连接master,一次完全同步(全量复制)将被自动执行! 我们的数据一定可以在从机中看到!

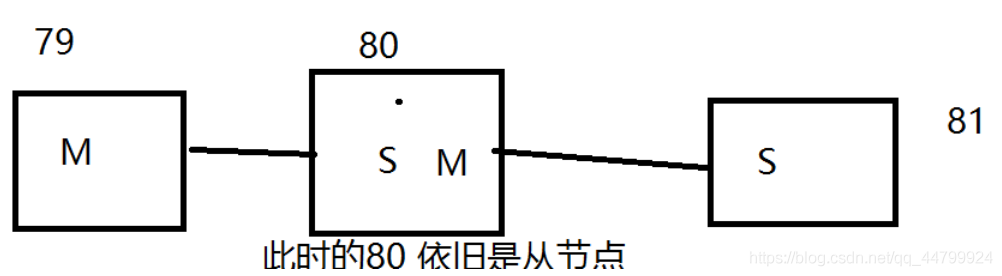

层层链路

上一个M链接下一个 S!

这时候也可以完成我们的主从复制!

如果没有老大了,这个时候能不能选择一个老大出来呢?

谋朝篡位

如果主机断开了连接,我们可以使用 SLAVEOF no one 让自己变成主机!其他的节点就可以手动连接到最新的这个主节点(手动)!如果这个时候老大修复了,那就重新连接!

4、哨兵模式(sentinel)

(自动选举老大的模式)

概述

主从切换技术的方法是:当主服务器宕机后,需要手动把一台从服务器切换为主服务器,这就需要人工干预,费事费力,还会造成一段时间内服务不可用。这不是一种推荐的方式,更多时候,我们优先考虑哨兵模式。

Redis从2.8开始正式提供了Sentinel(哨兵) 架构来解决这个问题。

谋朝篡位的自动版,能够后台监控主机是否故障,如果故障了根据投票数自动将从库转换为主库。

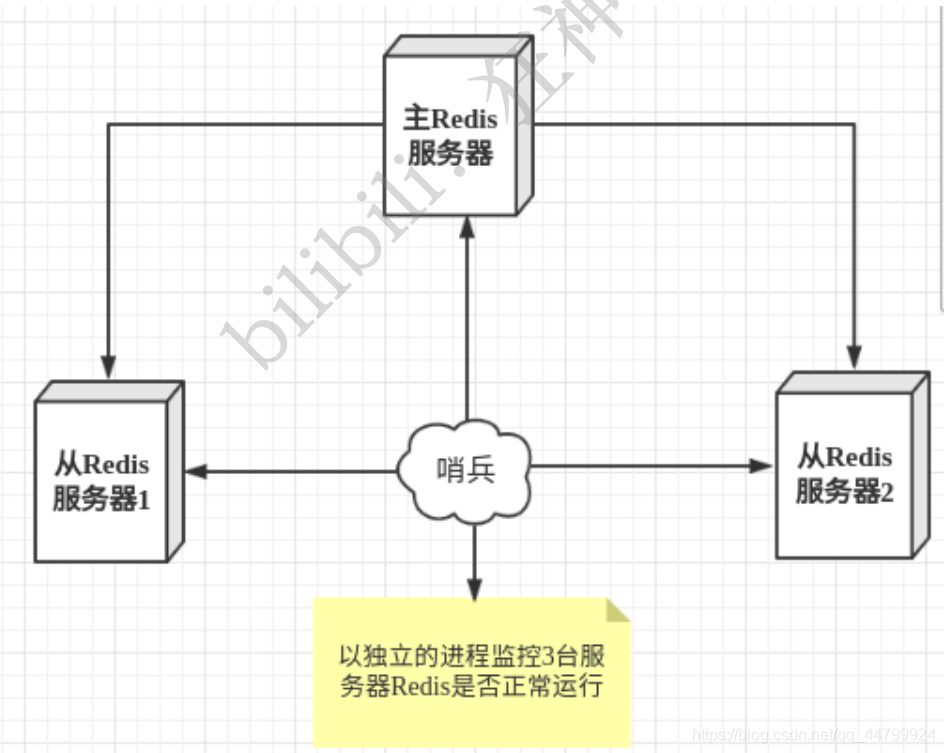

哨兵模式是一种特殊的模式,首先Redis提供了哨兵的命令,哨兵是一个独立的进程,作为进程,它会独立运行。其原理是哨兵通过发送命令,等待Redis服务器响应,从而监控运行的多个Redis实例。

这里的哨兵有两个作用

- 通过发送命令,让Redis服务器返回监控其运行状态,包括主服务器和从服务器。

- 当哨兵监测到master宕机,会自动将slave切换成master,然后通过发布订阅模式通知其他的从服务器,修改配置文件,让它们切换主机。

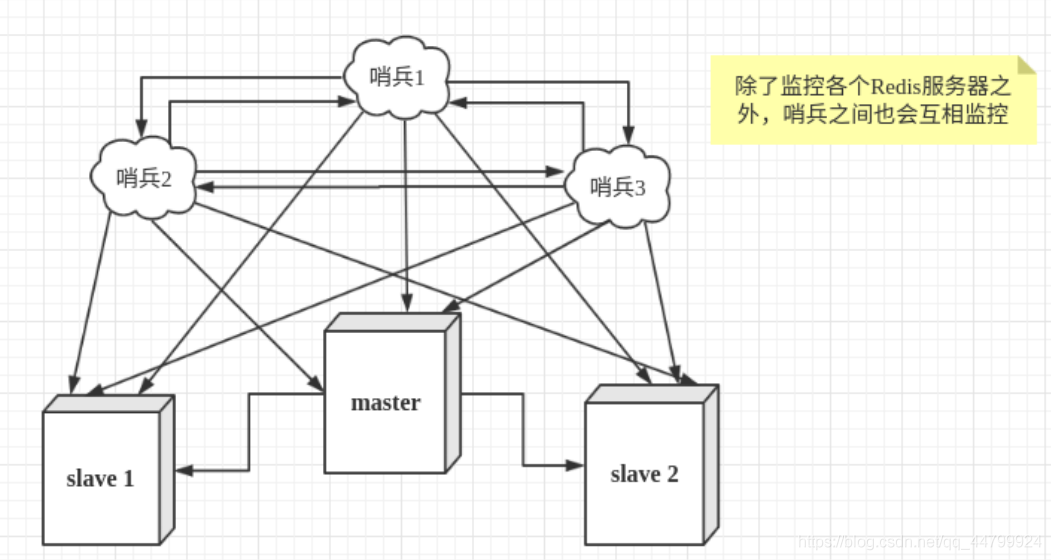

然而一个哨兵进程对Redis服务器进行监控,可能会出现问题,为此,我们可以使用多个哨兵进行监控。各个哨兵之间还会进行监控,这样就形成了多哨兵模式。

假设主服务器宕机,哨兵1先检测到这个结果,系统并不会马上进行failover过程,仅仅是哨兵1主观的认为主服务器不可用,这个现象成为主观下线。当后面的哨兵也检测到主服务器不可用,并且数量达到一定值时,那么哨兵之间就会进行一次投票,投票的结果由一个哨兵发起,进行failover[故障转移]操作。

切换成功后,就会通过发布订阅模式,让各个哨兵把自己监控的从服务器实现切换主机,这个过程称为客观下线。

测试

我们目前的状态是 一主二从!

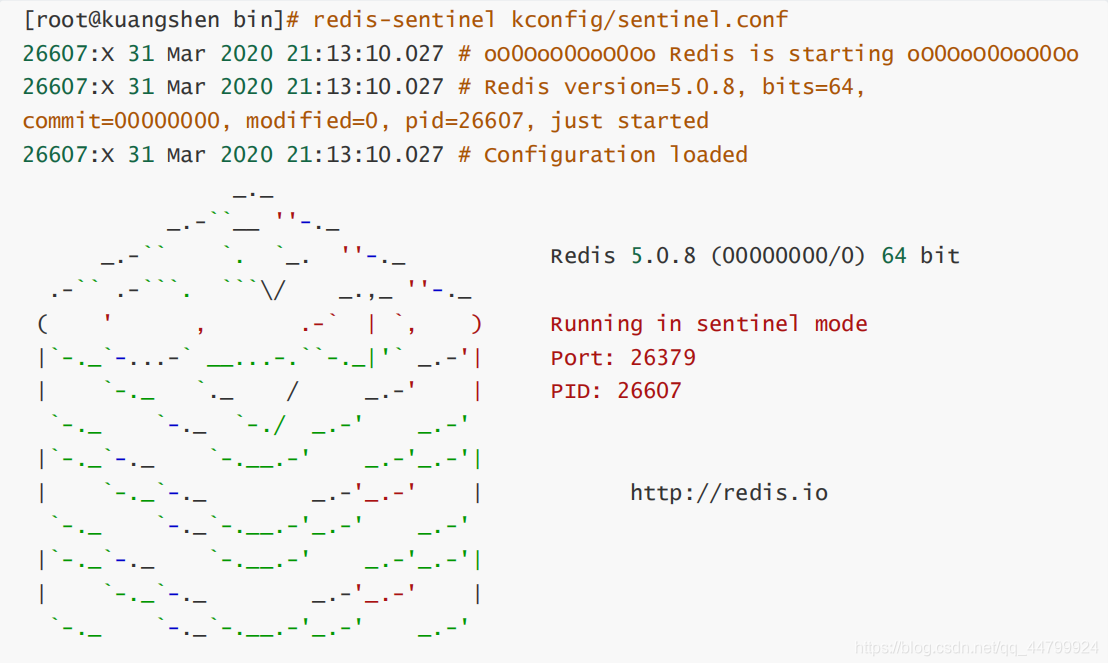

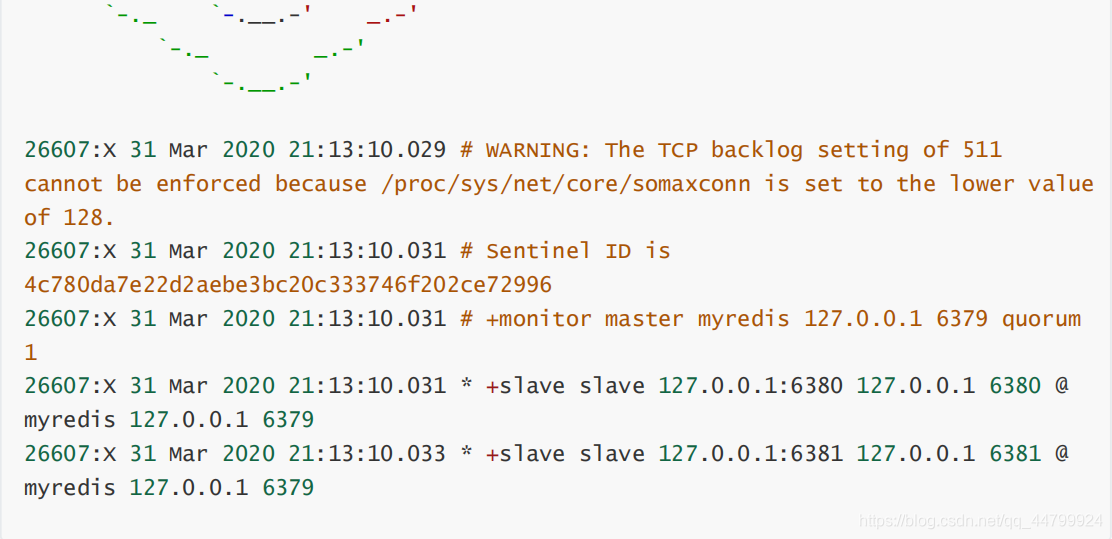

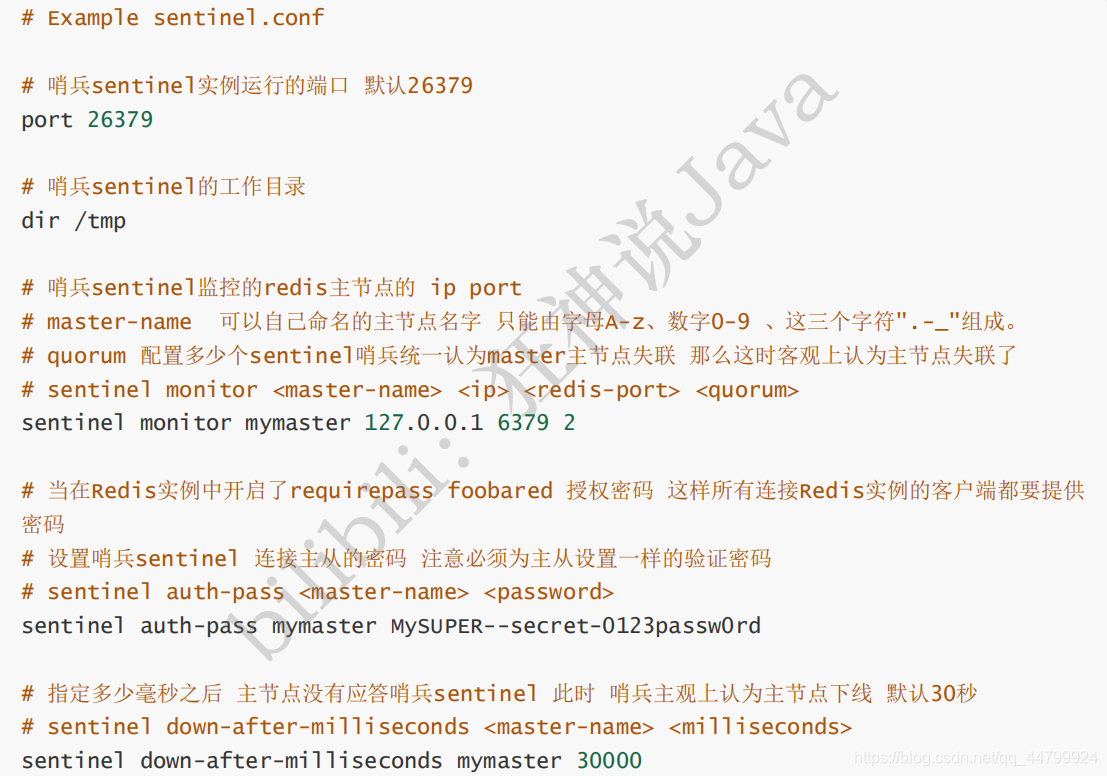

1、配置哨兵配置文件 sentinel.conf

# sentinel monitor 哨兵名称 local post 1(表示有几个哨兵通过就让它称为老大) sentinel monitor myredis 182.92.209.212 6379 1

2、启动哨兵!

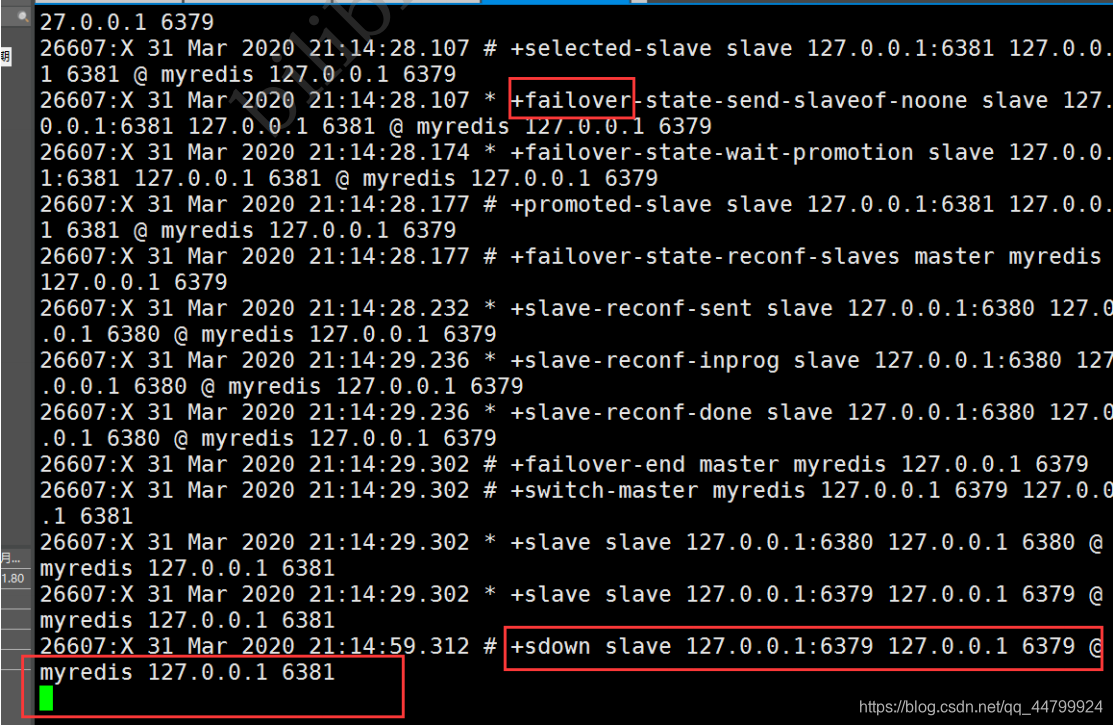

如果Master 节点断开了,这个时候就会从从机中随机选择一个服务器! (这里面有一个投票算法!)

哨兵日志!

如果主机此时回来了,只能归并到新的主机下,当做从机,这就是哨兵模式的规则!

哨兵模式优缺点

优点:

- 1、哨兵集群,基于主从复制模式,所有的主从配置优点,它全有

- 2、 主从可以切换,故障可以转移,系统的可用性就会更好

- 3、哨兵模式就是主从模式的升级,手动到自动,更加健壮!

缺点:

- 1、Redis 不好啊在线扩容的,集群容量一旦到达上限,在线扩容就十分麻烦!

- 2、实现哨兵模式的配置其实是很麻烦的,里面有很多选择!

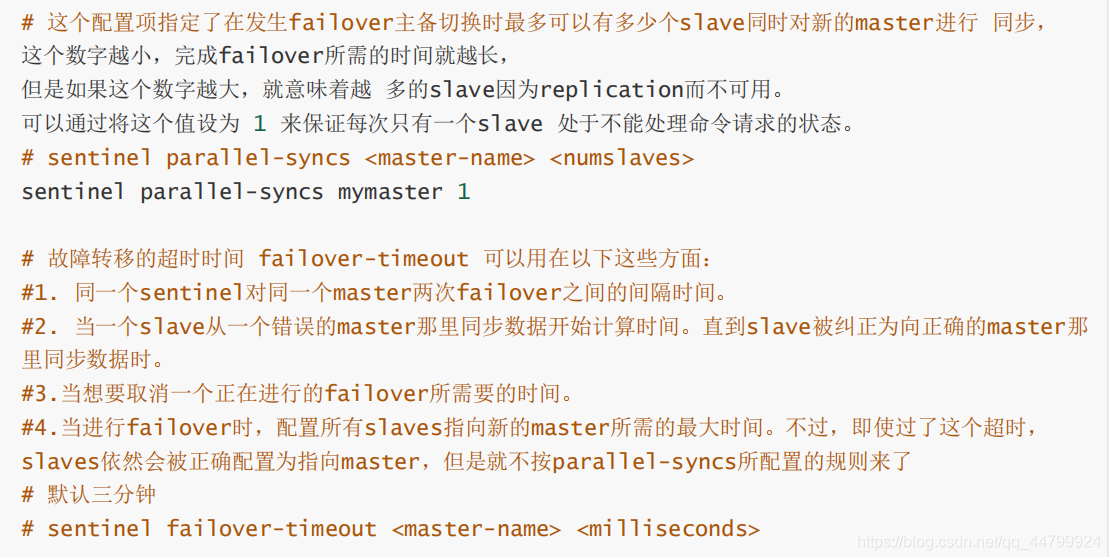

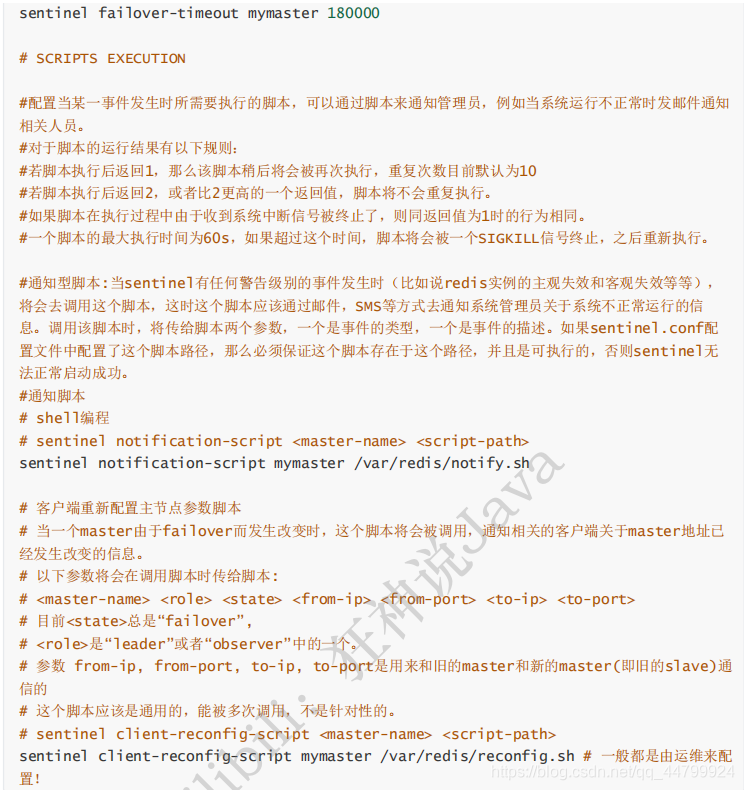

哨兵模式的全部配置!

5、Redis缓存穿透和雪崩

服务的高可用问题!

在这里我们不会详细的区分析解决方案的底层!

Redis缓存的使用,极大的提升了应用程序的性能和效率,特别是数据查询方面。但同时,它也带来了一些问题。其中,最要害的问题,就是数据的一致性问题,从严格意义上讲,这个问题无解。如果对数据的一致性要求很高,那么就不能使用缓存。

另外的一些典型问题就是,缓存穿透、缓存雪崩和缓存击穿。目前,业界也都有比较流行的解决方案。

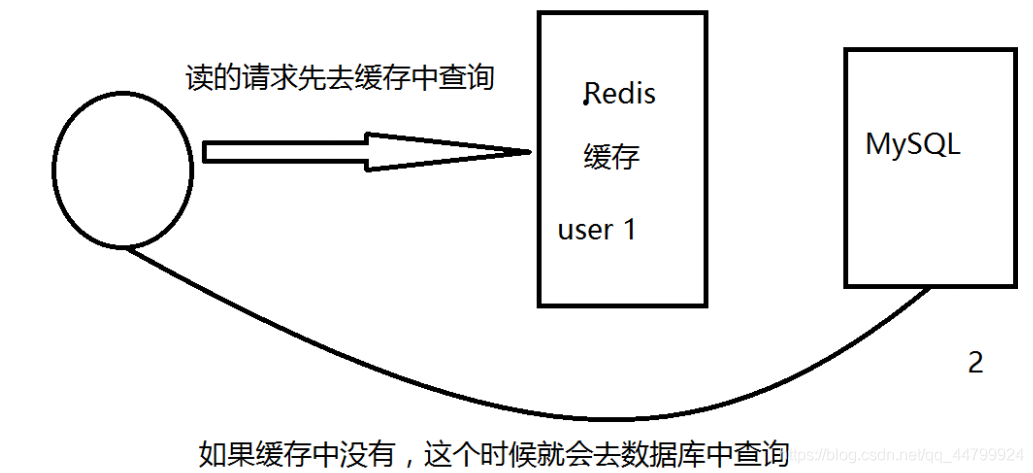

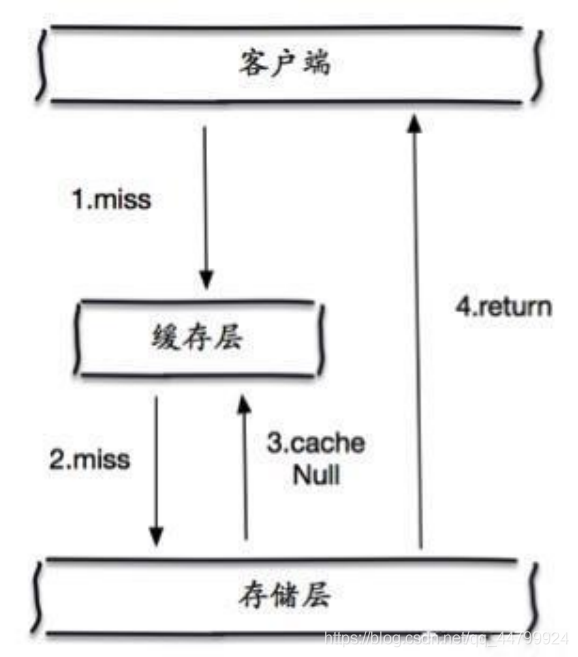

缓存穿透(查询不到数据)

概念

缓存穿透的概念很简单,用户想要查询一个数据,发现redis内存数据库没有,也就是缓存没有命中,于是向持久层数据库查询。发现也没有,于是本次查询失败。当用户很多的时候,缓存都没有命中(秒杀!),于是都去请求了持久层数据库。这会给持久层数据库造成很大的压力,这时候就相当于出现了缓存穿透。

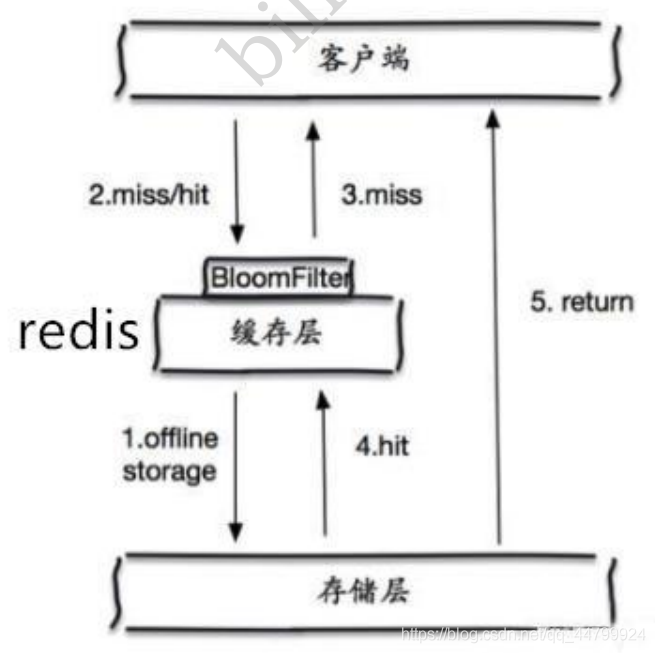

解决方案

布隆过滤器是一种数据结构,对所有可能查询的丢弃,从而避免了对底层存储系统的查询压力;所有可能统的查询

缓存空对象

当存储层不命中后,即使返回的空对象也将其缓存起来,同时会设置一个过期时间,之后再访问这个数据将会从缓存中获取,保护了后端数据源;

但是这种方法会存在两个问题:

- 1、如果空值能够被缓存起来,这就意味着缓存需要更多的空间存储更多的键,因为这当中可能会有很多的空值的键;

- 2、即使对空值设置了过期时间,还是会存在缓存层和存储层的数据会有一段时间窗口的不一致,这对于需要保持一致性的业务会有影响。

缓存击穿(量太大,缓存过期!)

概述

这里需要注意和缓存击穿的区别,缓存击穿,是指一个key非常热点,在不停的扛着大并发,大并发集中对这一个点进行访问,当这个key在失效的瞬间,持续的大并发就穿破缓存,直接请求数据库,就像在一个屏障上凿开了一个洞。

当某个key在过期的瞬间,有大量的请求并发访问,这类数据一般是热点数据,由于缓存过期,会同时访问数据库来查询最新数据,并且回写缓存,会导使数据库瞬间压力过大。

解决方案

设置热点数据永不过期

从缓存层面来看,没有设置过期时间,所以不会出现热点 key 过期后产生的问题。

加互斥锁

分布式锁:使用分布式锁,保证对于每个key同时只有一个线程去查询后端服务,其他线程没有获得分布式锁的权限,因此只需要等待即可。这种方式将高并发的压力转移到了分布式锁,因此对分布式锁的考验很大。

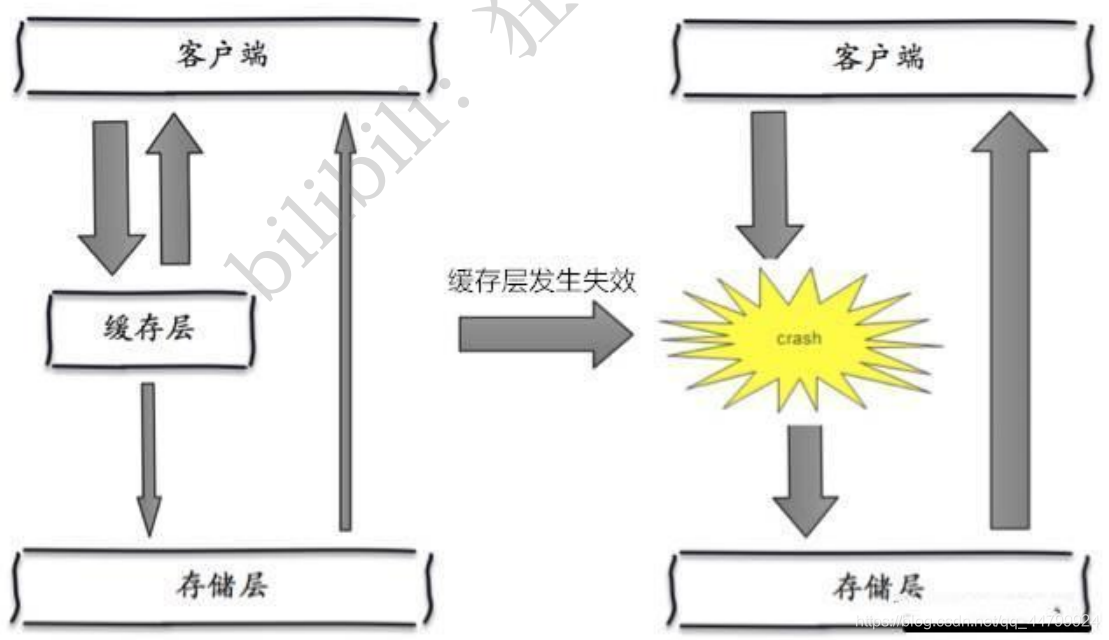

缓存雪崩

概念

缓存雪崩,是指在某一个时间段,缓存集中过期失效。Redis 宕机!

产生雪崩的原因之一,比如在写本文的时候,马上就要到双十二零点,很快就会迎来一波抢购,这波商品时间比较集中的放入了缓存,假设缓存一个小时。那么到了凌晨一点钟的时候,这批商品的缓存就都过期了。而对这批商品的访问查询,都落到了数据库上,对于数据库而言,就会产生周期性的压力波峰。于是所有的请求都会达到存储层,存储层的调用量会暴增,造成存储层也会挂掉的情况。

其实集中过期,倒不是非常致命,比较致命的缓存雪崩,是缓存服务器某个节点宕机或断网。因为自然形成的缓存雪崩,一定是在某个时间段集中创建缓存,这个时候,数据库也是可以顶住压力的。无非就是对数据库产生周期性的压力而已。而缓存服务节点的宕机,对数据库服务器造成的压力是不可预知的,很有可能瞬间就把数据库压垮。

解决方案

redis高可用

这个思想的含义是,既然redis有可能挂掉,那我多增设几台redis,这样一台挂掉之后其他的还可以继续工作,其实就是搭建的集群。(异地多活!)

限流降级(在SpringCloud讲解过!)

这个解决方案的思想是,在缓存失效后,通过加锁或者队列来控制读数据库写缓存的线程数量。比如对某个key只允许一个线程查询数据和写缓存,其他线程等待。

数据预热

数据加热的含义就是在正式部署之前,我先把可能的数据先预先访问一遍,这样部分可能大量访问的数

据就会加载到缓存中。在即将发生大并发访问前手动触发加载缓存不同的key,设置不同的过期时间,让

缓存失效的时间点尽量均匀。

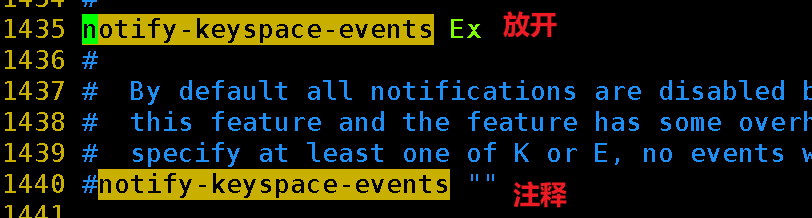

6、Redis过期监听

使用Springboot做个demo

1、Redis开启支持

将notify-keyspace-events设置为Ex

2、Springboot配置

依赖:

<!--整合Redis-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>

<!--springboot2.x以后用得是lettuce:lettuce默认连接池使用 common-pool2 -->

<dependency>

<groupId>org.apache.commons</groupId>

<artifactId>commons-pool2</artifactId>

</dependency>

配置:

##########################Redis配置################################### # 连接的那个数据库(默认为0) spring.redis.database=0 # redis服务的ip地址(默认是本机-127.0.0.1) spring.redis.host=182.xxx212 # redis端口号(默认) spring.redis.port=6379 # redis的密码,没设置过密码,可为空 spring.redis.password=xxx # 连接超时时间 spring.redis.timeout=10s # 连接池中的最小空闲连接 spring.redis.lettuce.pool.min-idle=0 # 连接池中的最大空闲连接 spring.redis.lettuce.pool.max-idle=8 # 连接池中的最大连接数 spring.redis.lettuce.pool.max-active=8 # 连接池中的最大等待时间(-1表示没有限制) spring.redis.lettuce.pool.max-wait=-1ms

Redis配置类:做序列化和注册redis监听

import org.springframework.beans.factory.annotation.Value; import org.springframework.cache.CacheManager; import org.springframework.cache.interceptor.KeyGenerator; import org.springframework.cache.interceptor.SimpleKeyGenerator; import org.springframework.context.annotation.Bean; import org.springframework.context.annotation.Configuration; import org.springframework.data.redis.cache.RedisCacheConfiguration; import org.springframework.data.redis.cache.RedisCacheManager; import org.springframework.data.redis.connection.RedisConnectionFactory; import org.springframework.data.redis.core.RedisTemplate; import org.springframework.data.redis.listener.RedisMessageListenerContainer; import org.springframework.data.redis.serializer.GenericJackson2JsonRedisSerializer; import org.springframework.data.redis.serializer.RedisSerializationContext; import org.springframework.data.redis.serializer.StringRedisSerializer; import java.time.Duration; import java.util.HashMap; import java.util.Map; /** * @ClassName RedisConfiguration * @Author zhangzhixi * @Description * @Date 2022-5-2 17:40 * @Version 1.0 */ @Configuration public class RedisConfiguration { /** * @param redisConnectionFactory redis连接工厂 * @功能描述 redis作为缓存时配置缓存管理器CacheManager,主要配置序列化方式、自定义 * <p> * 注意:配置缓存管理器CacheManager有两种方式: * 方式1:通过RedisCacheConfiguration.defaultCacheConfig()获取到默认的RedisCacheConfiguration对象, * 修改RedisCacheConfiguration对象的序列化方式等参数【这里就采用的这种方式】 * 方式2:通过继承CachingConfigurerSupport类自定义缓存管理器,覆写各方法,参考: * https://blog.csdn.net/echizao1839/article/details/102660649 * <p> * 切记:在缓存配置类中配置以后,yaml配置文件中关于缓存的redis配置就不会生效,如果需要相关配置需要通过@value去读取 */ @Bean public CacheManager cacheManager(RedisConnectionFactory redisConnectionFactory) { RedisCacheConfiguration redisCacheConfiguration = RedisCacheConfiguration.defaultCacheConfig() // 设置key采用String的序列化方式 .serializeKeysWith(RedisSerializationContext.SerializationPair.fromSerializer(StringRedisSerializer.UTF_8)) //设置value序列化方式采用jackson方式序列化 .serializeValuesWith(RedisSerializationContext.SerializationPair.fromSerializer(serializer())) //当value为null时不进行缓存 .disableCachingNullValues() // 配置缓存空间名称的前缀 .prefixCacheNameWith("spring-cache:") //全局配置缓存过期时间【可以不配置】 .entryTtl(Duration.ofMinutes(30L)); //专门指定某些缓存空间的配置,如果过期时间【主要这里的key为缓存空间名称】 Map<String, RedisCacheConfiguration> map = new HashMap<>(); return RedisCacheManager .builder(redisConnectionFactory) // 默认配置 .cacheDefaults(redisCacheConfiguration) //某些缓存空间的特定配置 .withInitialCacheConfigurations(map) .build(); } /** * 自定义缓存的redis的KeyGenerator【key生成策略】 * 注意: 该方法只是声明了key的生成策略,需在@Cacheable注解中通过keyGenerator属性指定具体的key生成策略 * 可以根据业务情况,配置多个生成策略 * 如: @Cacheable(value = "key", keyGenerator = "keyGenerator") */ @Bean public KeyGenerator keyGenerator() { /* target: 类 method: 方法 params: 方法参数 */ return (target, method, params) -> { //获取代理对象的最终目标对象 StringBuilder sb = new StringBuilder(); sb.append(target.getClass().getSimpleName()).append(":"); sb.append(method.getName()).append(":"); //调用SimpleKey的key生成器 Object key = SimpleKeyGenerator.generateKey(params); return sb.append(key); }; } /** * @param redisConnectionFactory:配置不同的客户端,这里注入的redis连接工厂不同: JedisConnectionFactory、LettuceConnectionFactory * @功能描述 :配置Redis序列化,原因如下: * (1) StringRedisTemplate的序列化方式为字符串序列化, * RedisTemplate的序列化方式默为jdk序列化(实现Serializable接口) * (2) RedisTemplate的jdk序列化方式在Redis的客户端中为乱码,不方便查看, * 因此一般修改RedisTemplate的序列化为方式为JSON方式【建议使用GenericJackson2JsonRedisSerializer】 */ @Bean public RedisTemplate<String, Object> redisTemplate(RedisConnectionFactory redisConnectionFactory) { GenericJackson2JsonRedisSerializer genericJackson2JsonRedisSerializer = serializer(); RedisTemplate<String, Object> redisTemplate = new RedisTemplate<>(); // key采用String的序列化方式 redisTemplate.setKeySerializer(StringRedisSerializer.UTF_8); // value序列化方式采用jackson redisTemplate.setValueSerializer(genericJackson2JsonRedisSerializer); // hash的key也采用String的序列化方式 redisTemplate.setHashKeySerializer(StringRedisSerializer.UTF_8); //hash的value序列化方式采用jackson redisTemplate.setHashValueSerializer(genericJackson2JsonRedisSerializer); redisTemplate.setConnectionFactory(redisConnectionFactory); return redisTemplate; } /** * 此方法不能用@Ben注解,避免替换Spring容器中的同类型对象 */ public GenericJackson2JsonRedisSerializer serializer() { return new GenericJackson2JsonRedisSerializer(); } /** * 配置Redis消息监听器 * @param connectionFactory redis连接工厂 * */ @Bean RedisMessageListenerContainer container(RedisConnectionFactory connectionFactory) { RedisMessageListenerContainer container = new RedisMessageListenerContainer(); container.setConnectionFactory(connectionFactory); return container; } }

Redis过期事件监听类

import lombok.extern.slf4j.Slf4j; import org.springframework.data.redis.connection.Message; import org.springframework.data.redis.listener.KeyExpirationEventMessageListener; import org.springframework.data.redis.listener.RedisMessageListenerContainer; import org.springframework.stereotype.Component; /** * @author zhangzhixi * @version 1.0 * @description * @date 2023-07-08 11:13 */ @Slf4j @Component public class RedisKeyExpirationListener extends KeyExpirationEventMessageListener { public RedisKeyExpirationListener(RedisMessageListenerContainer listenerContainer) { super(listenerContainer); } /** * 针对redis数据失效事件,进行数据处理 * * @param message 失效的key * @param pattern 失效的key所属的模式 */ @Override public void onMessage(Message message, byte[] pattern) { String redisData = message.toString(); System.out.println("失效的key是:" + redisData); // TODO -根据失效的key,进行业务处理 } }

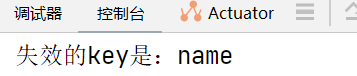

3、测试

向redis添加数据:

setex name 10 zhangsan

看10s后,控制台打印结果,测试成功:

浙公网安备 33010602011771号

浙公网安备 33010602011771号