文件服务器层详解

文件服务器层可用方案介绍

共享存储,集群当中多个web服务器在工作的时候数据要保持一致。

可用方案

nfs主+nfs备:基于rsync+inotify来实现数据的实时同步。

用scp命令也可以自己做重复性的动作比较麻烦,可以用计划任务,但是计划任务最短的时间也只是精确到分钟。

主的挂掉还得人主动的去重新挂在一下备的上面去,不能自动去做,故障切换不能自动操作。

DRBD+HeartBeat+NFS:高可用文件服务器

解决了单点故障,故障可以自动切换,但是当访问量打到一定程度就会性能不足。

兼顾:性能+高可用+数据安全性 ----->分布式存储

ceph

mfs

gluster

大公司都不会用开源的,一般都是自己开发自己的分布式存储,分布式对应的就是集中式,集中式是所有东西都集中在一个地方,所以会有单点故障,为了防单点故障就开始了分布式方案,一份完整的数据分成很多片分在不同的机器上,并且每台机器上都衍生出一些备份机。

**文件服务器层可用方案详细介绍** 在构建企业级文件服务器架构时,确保数据一致性、高可用性及性能优化是关键目标。针对不同规模的场景,有多种方案可供选择,每种方案在成本、复杂性、性能及自动化程度方面各有优劣。以下将详细展开各方案的实现原理、优缺点及适用场景,帮助读者根据实际需求做出合理选择。 --- ### **一、NFS主服务器 + NFS备服务器方案** 该方案通过主备模式实现数据冗余,核心依赖rsync和inotify工具实现实时数据同步。 **1. 工作原理** - **rsync同步**:rsync是一种高效的远程文件同步工具,通过比对文件内容差异,仅传输变化部分,减少网络带宽消耗。 - **inotify监控**:inotify是Linux内核提供的文件事件监控机制,实时监听主服务器上的文件变动(如新增、修改、删除),触发rsync同步操作,确保主备服务器数据实时一致。 - **备选方案**:若不使用rsync+inotify,可通过scp命令手动或通过计划任务(如cron)定期同步。但计划任务存在明显延迟(最小间隔1分钟),无法实现实时性,且需人工维护脚本。 **2. 优缺点分析** **优点**: - 部署简单,适合中小规模场景,无需复杂集群配置。 - 成本较低,基于开源工具,无需额外硬件投入。 - 数据同步机制较为成熟,rsync的高效算法降低同步开销。 **缺点**: - **手动故障切换**:主服务器宕机后,需人工介入将备服务器挂载至集群,无法自动完成故障切换,可能导致服务中断。 - **性能瓶颈**:当并发访问量增大时,单点主服务器可能成为性能瓶颈,且备服务器资源闲置,利用率低。 - **同步延迟风险**:尽管rsync+inotify接近实时,但仍存在毫秒级延迟,对强一致性场景(如金融交易)可能不足。 **适用场景**:适合对实时性要求不高、访问量中等且运维人力充足的中小型企业,或作为临时过渡方案。 --- ### **二、DRBD + HeartBeat + NFS高可用方案** 该方案通过集成DRBD(分布式复制块设备)、HeartBeat(集群监控)和NFS,实现高可用性文件服务。 **1. 核心组件功能** - **DRBD**:在块设备层实现数据的实时镜像复制。主服务器写入数据时,DRBD同步将数据写入备服务器磁盘,确保双节点数据完全相同。 - **HeartBeat**:集群心跳监控服务,定期检测主服务器状态。若主节点故障,HeartBeat自动触发备服务器接管IP地址及NFS服务,实现故障切换。 - **NFS**:作为文件共享协议,客户端通过NFS挂载访问统一文件路径,无需感知后端服务器切换。 **2. 优缺点分析** **优点**: - **自动故障切换**:彻底解决单点故障问题,切换过程对用户透明,减少服务中断时间。 - **数据零丢失**:DRBD的同步复制机制确保主备数据实时一致,无需担心切换后的数据不一致问题。 - **集群管理简化**:HeartBeat提供统一监控接口,便于运维管理。 **缺点**: - **性能限制**:随着访问量增加,单节点NFS服务(无论主备)可能成为瓶颈,尤其在高并发读写场景下,性能扩展性不足。 - **复杂性提升**:部署需配置DRBD、HeartBeat及NFS多层组件,对运维技术要求较高。 - **资源利用率低**:备服务器需保持实时同步但无法提供服务,资源闲置。 **适用场景**:适合对数据一致性要求极高、能容忍短暂服务中断的中型企业,或对自动化运维有一定投入的场景。 --- ### **三、分布式存储方案** 当性能、高可用性及数据安全性成为核心需求时,分布式存储成为必然选择。常见方案包括Ceph、MooseFS(MFS)、GlusterFS等,其核心思想是“分散存储 + 多副本冗余”。 **1. 技术特点** - **数据分片与冗余**:文件被切分成多个数据块,分散存储在多台服务器(节点)上,每个数据块有多个副本(如3副本),确保单节点故障不影响数据可用性。 - **负载均衡**:通过分布式算法(如哈希、一致性哈希)将读写请求均匀分配到各节点,避免单点性能瓶颈。 - **自动故障恢复**:节点故障时,系统自动识别并调度其他节点提供服务,同时重建失效副本,无需人工干预。 - **扩展性强**:通过增加节点即可线性扩展存储容量和性能,适应海量数据及高并发场景。 **2. 主流方案对比** - **Ceph**:兼具对象存储、块存储和文件存储能力,功能强大但部署复杂,适合超大规模云环境。 - **MFS**:轻量级分布式文件系统,易于部署,适合中小规模场景,但社区支持相对较弱。 - **GlusterFS**:模块化设计,支持多种扩展功能(如缓存、纠删码),适合高性能应用场景。 **3. 企业级实践** 大型企业往往选择自研分布式存储系统,原因包括: - **定制化需求**:开源方案难以满足特定业务场景(如极低延迟、特定安全策略)。 - **性能优化**:通过硬件定制(如NVMe、RDMA网络)和算法优化提升吞吐量。 - **安全合规**:内部系统更易满足数据主权、隐私保护等法规要求。 **4. 优缺点总结** **优点**: - **高性能**:多节点并行处理,可应对PB级存储和万级并发。 - **高可用**:多副本 + 自动恢复机制,数据可用性接近100%。 - **弹性扩展**:按需扩容,资源利用率高。 - **自动化运维**:故障自愈、负载均衡等功能降低人力成本。 **缺点**: - **部署复杂**:集群搭建、调优需专业团队支持。 - **成本较高**:需较多服务器及高速网络设备(如万兆/InfiniBand)。 - **学习曲线陡峭**:运维需掌握分布式系统原理及工具。 **适用场景**:适用于互联网巨头、金融、科研等对数据规模、性能及可靠性有极致要求的大型企业。 --- ### **总结与选型建议** - **小型企业/测试环境**:优先NFS主备方案,成本低且满足基本需求,可后续平滑迁移至分布式存储。 - **中型企业/核心业务**:选择DRBD+HeartBeat方案,兼顾高可用与数据安全,但需注意性能瓶颈。 - **大型企业/高性能场景**:部署分布式存储,权衡开源方案与自研系统的投入产出比,优先考虑成熟且社区活跃的项目(如Ceph)。 在实际部署时,还需结合业务特性(如读写比例、数据增长速率)及预算,选择最适配的技术路径,并建立完善的监控与灾备机制,确保文件服务器层的稳定运行。

文件存储、块存储、对象存储

NFS(network file system):网络文件系统,基于网络提供服务,远程挂载多台web服务器。

网络存储可以氛围三大类:

文件存储:对外提供的是文件,典型代表是文件----->NFS

块存储:对外提供一个块设备(本质就是一块裸盘),ceph可以通过块存储。

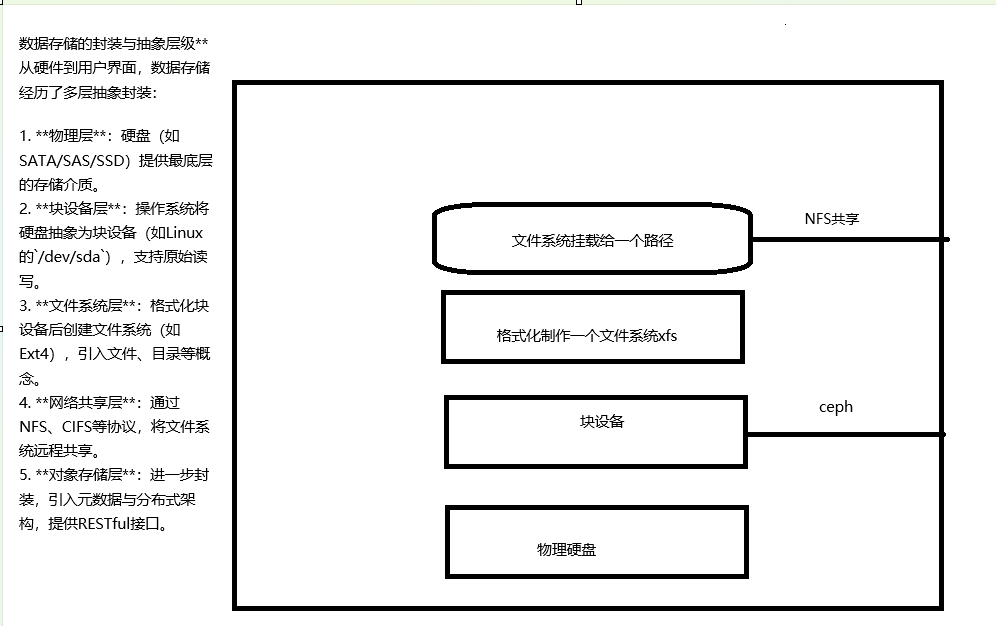

对象存储:存储数据单位是一个个的对象,真正要存数据一定是要存到,在计算机体系中,数据要么存到内存要么存在硬盘,永久存储一定是存到硬盘里面,存储可以有不同的形式无非就是在硬盘设备之上进行一层层封装,随着一层层封装到最后展示的形式是不一样的。用一块硬盘的时候装了操作系统,用文件,文件是操作系统提供的,Linux操作系统一切皆文件,硬盘关联到操作系统的文件名都是dev下的sd开头的,sda块设备,物理硬盘需要关联块设备才能用,这个块设备需要格式化制作一个文件系统,做完文件系统挂载一个文件夹里面就可以写文件或者文件夹了。用NFS的时候用的就是文件夹里面有现成的文件。

**文件存储、块存储、对象存储与NFS:网络化数据存储的三大范式解析** 在数字化时代,数据存储技术是支撑各类应用系统的核心基石。根据数据访问方式与组织形式的不同,网络存储可以划分为三大类别:文件存储、块存储和对象存储。这三种存储范式在应用场景、性能特性、管理方式上各具特色,共同构建了现代数据基础设施的多样性。本文将深入解析这三者的技术原理、典型代表NFS(网络文件系统)的作用,以及它们在计算机系统中的实践应用。 **一、文件存储:网络化文件共享的基石** 文件存储(File Storage)是一种以文件为单位进行数据管理的存储模式,其核心目标是为用户提供透明、便捷的文件访问接口。典型代表如NFS(Network File System),它通过TCP/IP网络协议,允许客户端远程挂载服务器端的文件系统,实现跨主机的文件共享。在多台Web服务器集群中,NFS常被用于存储静态网页、日志文件或共享配置数据,使得不同服务器能够访问同一套文件资源,降低数据冗余,简化维护流程。 NFS的工作原理基于客户端-服务器模型:服务器端将文件系统导出(export),客户端通过挂载(mount)操作将远程目录映射到本地文件树中。例如,在Linux系统中,执行`mount -t nfs server_ip:/path /local_mountpoint`后,用户即可像操作本地文件一样访问远程服务器上的文件。这种设计使文件存储非常适合需要频繁共享和协作的场景,如企业办公、科研数据共享等。 **二、块存储:底层硬件的抽象与高性能访问** 块存储(Block Storage)提供的是最原始的存储抽象——块设备。它向用户呈现一个未经格式化的“裸盘”,用户需自行在其上创建文件系统(如Ext4、XFS)或部署数据库等应用。块存储的典型应用场景包括虚拟机的磁盘镜像、高性能数据库(如MySQL、Oracle)的存储后端,以及分布式存储系统(如Ceph的RBD模块)的底层支撑。 块设备的优势在于极致的性能与灵活性。由于数据以固定大小的块(通常为512字节或4KB)进行读写,块存储能够提供低延迟、高吞吐量的I/O能力。例如,在云计算环境中,云主机通过iSCSI或NVMe over Fabric协议连接块存储卷,实现与本地硬盘相似的访问体验。此外,块存储支持RAID阵列、快照、克隆等高级功能,为数据安全与容灾提供了保障。 **三、对象存储:大规模非结构化数据的理想选择** 对象存储(Object Storage)以“对象”作为数据管理的基本单元,每个对象包含数据本体、元数据(描述数据属性的键值对)以及唯一标识符。对象存储系统通常采用扁平化的命名空间(如Amazon S3的“桶”与“对象”),而非传统文件系统的层级目录结构。这种设计使其具备近乎无限的扩展性,适合存储海量图片、视频、备份数据等非结构化内容。 对象存储的核心优势在于分布式架构与低成本。数据被切分为多个片段,分散存储在集群中的多台服务器上,并通过冗余机制(如Erasure Code或副本机制)确保可靠性。例如,用户上传一个10GB的文件,系统会自动将其拆分成多个对象并分布存储,同时每个对象拥有独立的元数据记录访问权限、创建时间等信息。这种模式不仅降低了硬件成本,还通过RESTful API或SDK支持,简化了应用程序的接入复杂性。 **四、NFS(网络文件系统)的深入解析** 作为文件存储的代表协议,NFS自1985年诞生至今已发展至NFSv4版本,其在网络存储领域的地位不可替代。其关键技术特性包括: 1. **远程透明性**:客户端无需感知文件的实际物理位置,所有读写操作通过网络自动转发至服务器端。 2. **共享语义支持**:支持多用户并发访问,通过锁机制(如NLM)保证文件一致性。 3. **协议灵活性**:可运行于不同操作系统(如Linux、Windows、UNIX),兼容POSIX标准文件操作。 4. **性能优化**:通过缓存机制(如客户端缓存、异步写入)减少网络传输开销,提升访问效率。 然而,NFS也存在局限性:由于其基于文件系统的共享模式,在大规模集群中可能面临元数据瓶颈;此外,传统NFS的同步写机制在分布式环境下可能导致性能下降。为此,现代NFS常与分布式文件系统(如Lustre、GPFS)结合,通过并行I/O和元数据分区技术提升扩展性。 **五、存储范式的应用场景与对比** 理解三种存储范式的差异,有助于根据实际需求选择合适的技术: - **文件存储(NFS/FTP/SMB)**:适用于需要共享文件、目录的场景,如Web静态资源、办公文档协作、传统NAS应用。其优势是易用性高,但性能受限于网络带宽与服务器处理能力。 - **块存储(SAN/iSCSI/本地磁盘)**:适合对I/O性能要求极高的场景,如数据库服务器、虚拟化平台、高性能计算(HPC)。用户需自行管理文件系统或应用部署,灵活性与性能最优,但管理复杂度较高。 - **对象存储(S3、MinIO、Ceph Object Gateway)**:专为云原生应用、大数据分析、备份归档设计。其扩展性、冗余机制与API接口使其成为存储海量非结构化数据的理想选择,但文件操作语义(如随机写入、目录遍历)相对受限。 **六、数据存储的封装与抽象层级** 从硬件到用户界面,数据存储经历了多层抽象封装: 1. **物理层**:硬盘(如SATA/SAS/SSD)提供最底层的存储介质。 2. **块设备层**:操作系统将硬盘抽象为块设备(如Linux的`/dev/sda`),支持原始读写。 3. **文件系统层**:格式化块设备后创建文件系统(如Ext4),引入文件、目录等概念。 4. **网络共享层**:通过NFS、CIFS等协议,将文件系统远程共享。 5. **对象存储层**:进一步封装,引入元数据与分布式架构,提供RESTful接口。 这种分层设计既保证了底层硬件的通用性,又通过上层封装满足不同应用场景的需求。例如,用户使用NFS时,实际是在操作经过多层封装后的文件,而对象存储则直接跳过文件系统的中间层,以更高效的方式管理数据。 **七、未来趋势与融合创新** 随着云计算、边缘计算、AI技术的快速发展,存储技术也在不断演进: - **分布式融合**:Ceph等系统同时支持块、文件、对象三种接口,实现“一池多协议”的存储资源池化。 - **云原生存储**:Kubernetes通过CSI(容器存储接口)标准化不同存储系统的接入方式,推动容器化应用的存储解耦。 - **智能存储**:AI算法辅助数据分层(如热数据存SSD,冷数据存对象存储),优化成本与性能平衡。 - **边缘存储**:在边缘设备上部署轻量级对象存储,支持物联网数据的就近处理。 **结语** 文件存储、块存储、对象存储作为数据存储的三大范式,各自以独特的优势支撑着不同的应用场景。NFS作为文件存储的经典代表,在远程文件共享领域持续发挥着重要作用。理解这些技术的本质差异与演进方向,有助于构建高效、可靠、可扩展的现代数据基础设施。无论是传统企业还是云计算平台,选择合适的存储范式并进行合理组合,将是应对数据爆炸时代的关键。

nfs架构流程

nfs:基于网络通信,cs架构。

对于服务端而言首先准备一个本地硬盘,格式化,做成一个文件系统,文件系统挂载给一个文件夹,然后再用nfs把这个文件夹给共享出来,编辑的配置文件/etc/exports,起nfs server,rpc_nfsd、rpc_mount、portmap。

客户端也得装一个客户端组件,mount -t nfs 服务端IP地址:/data /本地路径

读写数据------>/本地路径------>nfs数据源

**NFS架构流程详解** NFS(Network File System)是一种基于网络通信的分布式文件系统,采用典型的客户机/服务器(CS)架构。它允许客户端通过网络访问服务器共享的存储资源,实现跨设备的数据共享与协同操作。下面将详细阐述NFS的架构流程,涵盖服务端配置、客户端挂载及数据交互的全过程,并补充相关技术细节与注意事项。 **一、服务端配置与共享流程** 1. **硬盘准备与文件系统创建** 服务端首先需要准备一块本地硬盘(可以是物理磁盘或逻辑卷),对其进行分区和格式化。常见的文件系统类型包括Ext4、XFS等,需根据实际需求选择(如性能、容量限制等)。例如,使用`mkfs.ext4 /dev/sdb1`命令将分区格式化为Ext4文件系统。 2. **挂载文件系统至本地目录** 格式化完成后,需将文件系统挂载到指定的本地文件夹(称为“导出目录”)。例如,创建`/data/nfs_share`目录,并通过`mount /dev/sdb1 /data/nfs_share`命令挂载。此时,该目录将成为NFS共享的“数据源”。 3. **配置NFS共享(/etc/exports文件)** 编辑NFS的核心配置文件`/etc/exports`,定义共享目录、客户端访问权限及选项。例如: 3. 含义:允许192.168.1.0网段的所有客户端以读写(rw)权限访问,同步写入(sync)避免数据丢失,并禁用root用户权限转换(no_root_squash,允许客户端root用户保留权限)。 4. **启动NFS服务及相关守护进程** - **rpcbind(旧版portmap)**:负责管理RPC(Remote Procedure Call)端口映射,确保客户端与服务端进程通信的端口正确绑定。 - **nfsd(rpc.nfsd)**:NFS核心服务进程,处理客户端的文件系统请求。 - **rpc.mountd**:管理文件系统的挂载与卸载,验证客户端权限。 启动命令(以Systemd为例):`systemctl start nfs-server`(实际可能包含rpcbind、nfs-kernel-server等单元)。 5. **防火墙与端口配置** NFS依赖多个动态端口(默认2049及随机端口),需确保防火墙允许TCP/UDP的111(rpcbind)、2049(NFSv3/v4)及其他相关端口通信。例如,使用`firewall-cmd --add-service=nfs`添加规则。 **二、客户端配置与挂载流程** 1. **安装NFS客户端组件** 客户端需安装nfs-common等包,提供mount.nfs、rpcinfo等工具。例如,在Debian/Ubuntu中使用`apt install nfs-common`。 2. **挂载远程共享目录** 通过mount命令挂载: 2. 参数解析: - `-t nfs`指定文件系统类型; - 服务端IP地址及共享路径对应服务器配置; - 本地路径为客户端挂载点,可自定义。 3. **验证挂载与权限** 挂载后,通过`df -h`查看挂载状态,使用`ls /本地路径`确认能否访问共享数据。若权限配置错误(如no_root_squash未启用),可能需以root身份操作或调整配置。 **三、数据读写与通信机制** - **客户端读写流程**:当客户端对挂载目录(如`/本地路径`)进行文件操作时(如读写、创建文件),本地内核会将请求封装为NFS协议数据包,通过TCP/UDP发送至服务端。 - **服务端响应**:NFS服务进程解析请求,调用本地文件系统操作,并将结果返回客户端。数据实际存储在服务端的`/data/nfs_share`中,客户端无需感知底层存储细节。 - **RPC机制**:NFS依赖RPC进行动态端口分配与程序绑定。客户端首次连接时,通过rpcbind查询NFS服务端口,后续通信直接使用指定端口,提升效率。 **四、扩展与优化注意事项** 1. **性能优化**: - 使用NFSv4(支持TCP优化、并行传输)替代v3; - 调整`/etc/exports`参数(如async提升写入速度,但可能牺牲数据一致性); - 部署在高带宽低延迟的网络环境(如数据中心内)。 2. **安全性考虑**: - 限制客户端IP范围(如仅允许特定子网访问); - 启用SEC_KRB5(基于Kerberos认证)增强权限验证; - 禁用匿名访问(默认已禁用,但需确认配置)。 3. **故障排查**: - 使用`rpcinfo -p [服务端IP]`检查NFS及RPC服务端口状态; - 查看`/var/log/messages`或`journalctl`日志定位错误; - 确认防火墙未阻断NFS相关端口。 4. **应用场景**: - 企业文件共享(如Web服务器集群共享静态资源); - 存储备份系统(跨设备统一存储管理); - 开发环境共享(多机器访问同一代码库)。 **五、总结** NFS架构通过CS模式实现了跨网络的透明文件共享,其核心在于将本地文件系统封装为网络服务,借助RPC机制实现高效通信。配置时需关注权限管理、端口映射及性能调优,同时结合应用场景选择适当的协议版本与安全策略。理解其底层流程有助于在实际部署中快速定位问题,并优化系统可靠性与性能。

nfs配置详解

nfs使用详解

服务端

环境初始化

关selinux、防火墙

yum install nfs-utils rpcbind -y (centos7 已经默认安装了)

配置 /etc/exports

格式: /data 192.168.1.0/24(rw,all_squash)

/data ----->这是要共享给客户端使用的文件夹;

192.168.1.0/24----->这是服务端要给哪个网段的客户端共享;

(rw,all_squash)----->这是一些配置项,里面涉及到一些权限问题;rw:可读可写,但是这只是nfs的服务端允许,操作系统还得看一看对这个文件夹有没有权限;all_squash 代表客户端连进来之后转变的身份,nfsnobody;

创建目录

mkdir /data

启动服务

systemctl start nfs-server

客户端

环境初始化

关selinux、防火墙

getenforce、systemctl status firewalld、iptables -I -N

yum nstall -y rpcbind nfs-utils

rpm -qa |grep nfs-utils

rpm -qa |grep rpcbind

查看挂载点

showmount -e 服务端IP地址

mount -t nfs 服务端IP地址:服务端共享的文件夹 /客户端挂载点本地的文件夹

文件夹是水龙头是不存任何东西的,他里面的东西来源于水源(数据源),这个水龙头插到谁身上他它就流出来谁身上的水。

**NFS配置与服务使用详解(扩展版)** **NFS(Network File System)** 是一种分布式文件系统协议,允许客户端通过网络访问远程服务器上的文件,实现数据共享。将详细讲解NFS服务端和客户端的配置步骤、关键配置项、权限管理、常见问题及优化策略 **一、服务端配置详解** **1. 环境初始化** - **关闭SELinux**: - 编辑文件 `/etc/selinux/config`,将 `SELINUX` 改为 `disabled`,重启生效。 - 临时关闭命令:`setenforce 0`(立即生效,但重启后失效)。 - 原因:SELinux可能会限制NFS的访问权限,导致挂载失败。 - **关闭防火墙**: - 临时关闭:`systemctl stop firewalld`。 - 永久关闭:`systemctl disable firewalld`。 - 或配置防火墙规则允许NFS端口(默认TCP/UDP 2049及其他动态端口)。 - **安装NFS和RPC服务**: - 命令:`yum install nfs-utils rpcbind -y`(CentOS 7默认已安装,但需确认版本)。 - 检查安装:`rpm -qa | grep nfs-utils` 和 `rpm -qa | grep rpcbind`。 **2. 配置 /etc/exports 文件** - 该文件定义共享目录、访问权限和客户端列表。 - 示例配置:`/data 192.168.1.0/24(rw,all_squash,async)`。 - **参数解析**: - **/data**:服务端要共享的目录(需提前创建)。 - **192.168.1.0/24**:允许访问的客户端网段,也可指定单个IP(如192.168.1.100)。 - **配置选项**: - **rw**:读写权限(客户端需同时具备操作系统权限)。 - **all_squash**:将客户端用户映射为服务端的 `nfsnobody` 用户(降低权限风险)。 - **async**:异步写入,提高性能但可能丢失数据,可选 `sync`(同步写入,更安全)。 - **no_root_squash**:允许root用户访问(慎用,存在安全风险)。 - **anonuid/anongid**:自定义映射的本地用户ID(如 `anonuid=1000,anongid=1000`)。 - **其他高级配置**: - 多客户端权限:`/data 192.168.1.0/24(rw) 10.0.0.0/8(ro)`(不同网段不同权限)。 - 指定协议版本:`vers=4`(使用NFSv4)。 **3. 创建共享目录并授权** - 命令:`mkdir /data && chown -R nfsnobody:nfsnobody /data`。 - 确保目录权限允许NFS读写(如 `chmod 777 /data`,根据实际需求调整)。 **4. 启动NFS服务** - 启动:`systemctl start nfs-server`。 - 设置开机自启:`systemctl enable nfs-server`。 - 检查服务状态:`systemctl status nfs-server` 和 `rpcinfo -p`(查看NFS注册端口)。 **5. 验证共享配置** - 使用 `exportfs -rv` 刷新导出列表并检查配置。 - 通过 `showmount -e` 查看本机导出信息。 **二、客户端配置与使用** **1. 环境初始化** - 关闭SELinux和防火墙(同服务端)。 - 安装依赖:`yum install rpcbind nfs-utils -y`。 - 确认安装:`rpm -qa | grep nfs-utils`。 **2. 查看服务端共享** - 命令:`showmount -e <服务端IP>`。 - 示例输出:`/data 192.168.1.100`。 **3. 挂载NFS共享** - 命令:`mount -t nfs <服务端IP>:/data /mnt/nfs`。 - **参数说明**: - `-t nfs`:指定文件系统类型。 - `/mnt/nfs`:本地挂载点(需提前创建)。 - **永久挂载**:编辑 `/etc/fstab`,添加行: - 使用 `mount -a` 立即生效。 **4. 验证挂载与权限** - 查看挂载:`df -h` 或 `mount | grep nfs`。 - 测试读写:在 `/mnt/nfs` 中创建文件,检查服务端 `/data` 目录是否同步。 **5. 高级使用与优化** - **自动卸载**:使用 `umount /mnt/nfs` 或 `systemctl stop nfs-client`。 - **性能优化**: - 使用TCP协议:`mount -o tcp <...>`(默认UDP易丢包)。 - 调整缓存参数:`mount -o actimeo=60,nolock...`(减少延迟)。 - **访问控制**: - 防火墙限制:仅允许特定客户端IP访问NFS端口。 - 配置认证(如NFSv4的Kerberos认证)。 --- **三、常见问题与故障排除** **1. 挂载失败**: - **错误信息**:`mount: RPC: Unable to receive...`。 - 原因:防火墙未开放端口或RPC服务未启动。 - 解决方法:检查服务端防火墙规则,确认 `rpcbind` 和 `nfs-server` 服务已启动。 - **权限问题**:客户端无法写入。 - 检查服务端 `/etc/exports` 是否配置 `rw`,以及本地目录权限(如 `chmod 777`)。 **2. 延迟高或卡顿**: - 可能原因:网络延迟或NFS默认参数不合适。 - 优化:使用TCP协议、调整 `async` 或 `actimeo` 参数。 **3. 用户身份映射问题**: - 若使用 `all_squash`,所有客户端用户均映射为 `nfsnobody`,可能无法区分上传者身份。 - 解决方案:在客户端使用 `anonuid/anongid` 指定映射ID,或服务端配置 `no_all_squash`。 --- **四、最佳实践与安全性** - **权限管理**: - 避免使用 `no_root_squash`,除非绝对必要。 - 通过 `anonuid/anongid` 控制映射用户,避免直接使用 `nfsnobody`(可能被其他服务占用)。 - **安全加固**: - 防火墙仅开放NFS相关端口(2049及其他动态端口需通过 `rpcinfo` 查看)。 - 使用NFSv4并配置加密传输(如 `sec=krb5`)。 - **监控与日志**: - 查看 `/var/log/messages` 中的NFS日志。 - 使用工具如 `nfsstat` 监控性能。 --- **五、示例场景应用** **1. 跨部门文件共享**: - 服务端配置:`/shared 192.168.2.0/24(rw,all_squash)`。 - 客户端挂载:`mount -t nfs 192.168.2.100:/shared /dept1/data`。 - 权限:所有部门用户上传文件后均映射为 `nfsnobody`,避免权限混乱。 **2. 备份服务器挂载**: - 服务端配置:`/backup 192.168.3.10(rw,no_root_squash)`(仅允许备份服务器root访问)。 - 客户端(备份服务器):通过root身份挂载,执行备份脚本。 --- **总结** NFS通过简单的配置即可实现高效的文件共享,但需注意权限与安全。合理配置 `exports` 选项、控制访问网段、优化性能参数,并结合防火墙和身份映射策略,可构建稳定安全的共享系统。在实际应用中,需根据场景灵活调整配置,并定期监控维护。

并行写数据的冲突问题

这个问题应该应用程序本身来解决,并发编程用到的就是锁机制,本质原理大家同时写一个东西就会出现问题,解决方法就是不让大家同时写,让并行变成抢锁。

**并行写数据的冲突问题** 在计算机系统的并发编程和多线程处理中,并行写数据的冲突问题是一个核心挑战。当多个进程、线程或分布式节点同时尝试修改同一数据资源时,若缺乏有效的协调机制,极易导致数据不一致、覆盖丢失或逻辑错误,进而影响系统的可靠性和正确性。这一问题本质上是资源竞争的体现,而解决冲突的关键在于如何合理分配和管理对共享数据的访问权限。 **冲突产生的根源与典型场景** 并行写冲突的根源在于数据操作的“原子性”被破坏。例如,在数据库事务中,两个用户同时提交对同一账户的转账操作:用户A将账户余额减100元,用户B同时加200元。若系统未对账户余额进行独占锁定,可能导致以下错误结果: 1. **覆盖丢失**:A和B的修改操作可能被交错执行,最终只保留其中一个结果,导致数据不一致。 2. **脏写**:A读取旧值并计算新值的过程中,B已写入新值,导致A基于旧值的修改覆盖了B的正确结果。 3. **逻辑错误**:在复杂数据结构(如链表、树)中,并行修改可能破坏数据结构完整性,引发程序崩溃或数据丢失。 类似的场景广泛存在于多线程编程(如共享内存的修改)、分布式系统(多节点同步数据)、实时协作工具(如在线文档编辑)等环境中。因此,冲突问题的解决必须从系统设计层面进行考虑,确保数据操作的隔离性和顺序性。 **锁机制:并发控制的核心策略** 锁机制是解决并行写冲突的经典方法,其核心思想是“将并行操作转化为串行化访问”。通过引入锁(如互斥锁、读写锁、自旋锁等),系统可确保任一时刻只有一个执行单元能持有锁并修改数据,其他请求必须等待锁释放后才能执行。这种“排他性访问”有效避免了竞争条件,保证了数据一致性。 具体实现中,锁机制通常包含以下关键步骤: 1. **加锁阶段**:进程/线程在修改数据前,先尝试获取锁。若锁已被占用,则进入阻塞或自旋等待状态。 2. **临界区操作**:持有锁后,执行单元可安全地读写共享数据,无需担心其他干扰。 3. **解锁阶段**:操作完成后释放锁,唤醒等待队列中的其他请求。 例如,在Java中的`synchronized`关键字或ReentrantLock,Python中的`Lock`对象,数据库中的行级锁/表级锁,均基于此原理实现。此外,针对不同场景,锁策略可进一步优化: - **读写锁(ReadWriteLock)**:允许多个读操作并行,但写操作必须互斥,提升读密集型场景的并发性能。 - **乐观锁**:通过版本号或时间戳检测冲突,适用于冲突概率低的场景,减少锁开销。 - **分布式锁**:在分布式系统中,使用协调服务(如ZooKeeper、Redis)实现跨节点的资源锁定。 **锁机制的代价与优化方向** 虽然锁能有效解决冲突,但其引入的代价不可忽视: - **性能损耗**:加锁/解锁涉及上下文切换和同步开销,可能导致吞吐量下降。 - **死锁风险**:若多个锁的获取顺序不一致,可能陷入相互等待的僵局。 - **可扩展性限制**:高并发场景下,锁竞争加剧,系统吞吐量随并发度增加而饱和。 为缓解这些问题,现代系统常采用以下优化策略: 1. **细粒度锁**:将大锁拆分为多个小锁(如数据库的分区锁),提升并发度。 2. **无锁算法**:使用CAS(Compare-and-Swap)等硬件原子指令实现非阻塞同步,避免线程阻塞。 3. **事务隔离级别**:在数据库层面通过设置事务隔离等级(如读未提交、可重复读)平衡并发与一致性。 4. **异步与消息队列**:将写请求异步化,通过队列顺序处理,减少实时竞争。 **其他并发控制技术** 除了锁机制,现代系统还结合多种技术应对写冲突: - **版本控制**:如Git或分布式数据库中的多版本并发控制(MVCC),通过保存历史版本避免直接冲突。 - **副本与一致性协议**:在分布式系统中,通过Paxos、Raft等共识算法确保多副本间数据同步。 - **乐观并发**:如事件溯源架构,通过记录事件流而非直接修改状态,利用补偿机制处理冲突。 **实际应用中的权衡与设计原则** 在设计并发系统时,需综合考虑业务需求、性能目标与一致性要求: 1. **场景适配**:高一致性场景优先锁机制,低冲突场景可采用乐观策略。 2. **热点数据拆分**:识别高频访问资源,通过分片、缓存等手段降低锁竞争。 3. **监控与容错**:实时监测锁等待时长、死锁事件,设计超时机制和自动解锁策略。 4. **异步解耦**:通过消息队列或事件驱动架构,将写操作异步化,减少同步阻塞。 **总结** 并行写数据的冲突问题是并发编程中的基本挑战,其本质是资源竞争与原子性需求的矛盾。锁机制作为核心解决方案,通过强制串行化访问保障了数据一致性,但需权衡性能与复杂性。随着分布式系统与高性能计算的普及,结合无锁算法、事务隔离、副本同步等技术的混合策略逐渐成为主流。在实际应用中,开发者需根据场景特性,灵活选择合适的并发控制方案,在一致性、吞吐量与系统复杂度之间找到最佳平衡点。 --- **扩展说明** - **内容扩展方向**: 1. 增加了冲突产生的具体场景案例(数据库转账、数据结构破坏),帮助读者理解问题的实际影响。 2. 详细阐述了锁机制的工作原理、常见类型(互斥锁、读写锁等)及分布式锁的实现。 3. 补充了锁机制的代价分析(性能、死锁)及优化方向(细粒度锁、无锁算法)。 4. 引入了其他并发控制技术(版本控制、一致性协议),扩展了解决方案的多样性。 5. 结合实际系统设计,提供了权衡原则与优化建议,增强内容的实用性。 - **技术深度**:通过介绍CAS、MVCC、Paxos等具体技术,提升了内容的专业性和可参考性。

nfs镜像方案介绍

nfs本身是有单点故障问题的,为了解决单点故障问题,我们可以来台备份机,但是要做到近乎实时备份,主nfs在给web服务器提供共享存储的过程当中有可能产生新的数据,但凡产生新的数据都要能实时的检测到立马传到备份服务器上,让备份服务器始终变成主服务器的镜像。

主nfs备份服务器两种方案:

rsync+inotify

inotify:帮我们检测一个文件夹下的变动,nfs往外共享的就是一个文件夹,那inotify就帮我们监测这个文件夹,一旦该文件夹下有变动都可以检测到,检测到之后搭配rsync。

rsync:帮我们把变动的文件同步到远程的备份机器上,说白了就是远程拷贝。

sersync=(rsync+inotify的封装)

缺点:

故障切换需要人工完成

**NFS镜像方案深度解析与扩展实践** NFS(Network File System)作为一种广泛应用的网络文件系统,因其简单易用、跨平台支持等特点,在分布式存储场景中扮演着重要角色。然而,其单点故障问题却一直是系统高可用性的重大隐患。当主NFS服务器因硬件故障、网络中断或软件异常而宕机时,整个共享存储服务将陷入瘫痪,直接影响业务连续性。为了解决这一问题,构建实时备份机制并实现故障快速切换成为关键。将详细解析两种主流的NFS镜像方案,并深入探讨其技术原理、优缺点及实践要点。 --- ### **一、NFS单点故障问题分析** NFS的核心架构中,所有客户端都依赖单一的主服务器进行文件读写操作。这种集中式架构在以下场景中极易暴露风险: - **硬件故障**:服务器磁盘损坏、内存错误或电源问题可能导致服务中断。 - **网络问题**:主服务器所在网络分区、交换机故障或链路拥堵会影响全局访问。 - **软件错误**:NFS服务进程异常退出、配置错误或系统内核漏洞均可能引发服务不可用。 因此,构建高可用的NFS集群必须从消除单点故障入手,通过实时数据同步和故障切换机制保障服务的连续性。 --- ### **二、基于rsync+inotify的实时镜像方案** #### **1. 技术原理与组件解析** 该方案的核心在于结合**inotify**和**rsync**工具,实现文件夹级变动的实时监测与同步: - **inotify**:Linux内核自2.6.13版本引入的事件通知机制,能够实时监测文件系统的变化(如文件创建、修改、删除、重命名等)。通过监控NFS共享目录,inotify可以精准捕捉到每个数据更新事件。 - **rsync**:一款强大的远程同步工具,支持增量传输和压缩,仅同步发生变更的文件部分,极大提升传输效率。其特性包括: - 支持断点续传,避免因网络波动导致重复传输。 - 可通过SSH加密通道传输,保障数据安全。 - 提供灵活的过滤规则,可排除特定文件或目录。 **工作流程**: 1. 主NFS服务器启动inotify监控进程,实时监听共享目录的变动。 2. 当有新数据写入或文件修改时,inotify触发事件通知。 3. rsync进程根据事件信息,将变更文件通过加密通道同步到备份服务器。 4. 备份服务器保持与主服务器完全一致的数据镜像,随时可接管服务。 #### **2. 优势与适用场景** - **实时性**:inotify的毫秒级监测延迟确保数据同步近乎实时,适用于对数据一致性要求极高的场景(如数据库备份、实时日志共享)。 - **资源高效**:rsync的增量同步机制大幅减少网络带宽和磁盘I/O消耗,适合大规模文件系统的备份。 - **灵活性**:支持自定义同步策略(如定时任务+实时触发混合模式),可根据业务需求调整。 - **部署成本低**:基于开源工具,无需额外硬件或商业许可,适用于中小型企业或测试环境。 #### **3. 实践要点与注意事项** - **监控粒度配置**:inotify默认监测整个目录树,对于海量文件场景可能导致性能瓶颈。需合理设置监测范围或采用分层监控策略。 - **同步频率优化**:rsync可通过参数调整同步间隔(如每5秒检查一次),但过于频繁的同步可能增加系统负载。 - **网络延迟处理**:在跨机房或广域网场景下,需考虑传输延迟对实时性的影响,可部署多区域备份节点或采用异步复制+定期校验机制。 - **数据一致性校验**:定期运行完整同步任务,防止因长期增量同步导致的累积误差。 --- ### **三、sersync:rsync+inotify的封装优化方案** sersync是对rsync和inotify的深度封装,进一步简化了部署和配置流程: - **自动化配置**:提供一键部署脚本,可快速完成监控进程、同步规则和日志系统的搭建。 - **多线程同步**:支持并行处理多个文件变更事件,提升同步效率。 - **错误重试机制**:内置失败任务队列,自动重传同步失败的文件,增强可靠性。 - **Web管理界面**:部分版本提供可视化控制台,实时展示同步状态和错误日志。 **适用场景**: - 对运维效率要求较高的环境,减少手动配置工作量。 - 需要快速搭建高可用NFS镜像的场景,如测试集群或临时项目。 **缺点**: - 封装层可能引入额外性能开销,需根据实际测试评估。 - 故障切换仍需人工干预,无法实现全自动高可用(后续可结合集群管理工具优化)。 --- ### **四、故障切换与高可用扩展** 尽管上述方案解决了数据实时同步问题,但人工切换仍存在以下风险: - **切换延迟**:从故障检测到手动执行切换命令的时间窗口可能导致服务中断。 - **人为误操作**:紧急情况下容易因操作失误导致恢复失败。 - **监控盲区**:若未实时监控主服务器状态,可能错过故障时机。 **优化方向**: 1. **引入监控与自动化脚本**: - 使用Nagios、Zabbix等监控工具实时检测NFS服务状态和磁盘健康。 - 编写故障切换脚本,当检测到主服务器不可用时,自动停止备份机同步进程,切换VIP(虚拟IP)或修改DNS记录指向备份机。 2. **结合集群管理软件**: - 使用Pacemaker、Keepalived构建NFS高可用集群,实现全自动故障检测和资源接管。 - 配置共享存储仲裁机制(如分布式锁或Quorum磁盘),防止脑裂现象。 3. **多活架构设计**: - 部署双主NFS集群,通过双向同步工具(如DRBD)实现双节点同时读写,彻底消除单点故障。 - 但需注意双写冲突处理和数据一致性校验的复杂性。 --- ### **五、对比其他高可用方案** | **方案** | **优点** | **缺点** | | ------ |------ |------ | | rsync+inotify | 轻量、灵活、开源免费;实时同步效果好。 | 故障切换需人工干预;不适合超大规模文件场景。 | | sersync | 部署简单,自动化程度高。 | 封装层可能降低性能;仍需手动切换。 | | DRBD双主集群 | 双节点同时在线,零数据丢失;自动故障切换。 | 配置复杂,需专用存储网络;成本较高。 | | 分布式文件系统 | 天生多副本机制,高扩展性和容错能力(如Ceph、GlusterFS)。 | 部署和维护难度高;性能受元数据服务器影响。 | --- ### **六、总结与最佳实践** 在选择NFS镜像方案时,需综合考虑业务需求、系统规模、运维能力和成本预算。对于中小型应用,rsync+inotify方案凭借其低成本、高实时性和灵活性成为理想选择。但需注意以下最佳实践: 1. **分层备份策略**:对核心数据启用实时同步,非关键数据采用定时备份。 2. **压力测试与演练**:定期模拟故障切换,验证切换流程和同步延迟。 3. **日志与审计**:记录所有同步事件和错误日志,便于故障排查和性能优化。 4. **逐步迁移**:在生产环境部署前,先在测试集群验证方案的稳定性和性能。 通过合理的设计和运维优化,NFS镜像方案能够有效解决单点故障问题,为业务系统提供稳定可靠的共享存储服务。

rsync命令介绍

安装软件

yum install rsync -y

这个软件非常强大既可以当客户端用又可以当服务端用。

当客户端用:

涵盖了scp命令、cp命令一样,既可以远程拷贝也可以本地拷贝。

scp与cp每次都是全量拷贝,而rsync是增量的。

scp远程传输不支持断电续传,而rsync支持

rsync灵活性、可配置性强,但是命令行选项复杂,本身没有检测文本何时变化的能力,所以通常需要结合其他工具一起使用,对CPU消耗较大。

当服务端用:

rsync --deamon #systemctl start rsyncd

之所以用rsync,一定是在某些程度上比scp已经cp命令更加强大一些,scp和cp每次都是覆盖,不会对比是否发生变动,而scp会对比一下,如果源文件和目标文件没有发生变化则不会拷贝,这样会好处也有缺点

对比:

scp--------ssh协议--------sshd

rsync--------ssh协议--------sshd

rsync /a.txt 系统账号@1.1.1.111:/test

rsync--------rsync协议--------reyncd

/a.txt 虚拟账号@1.1.1.111::模块名

**rsync命令详解与安装指南** **一、rsync简介与安装** rsync(Remote Sync)是一款开源的、功能强大的文件同步工具,兼具客户端和服务端双重角色。它不仅可以替代传统的`scp`和`cp`命令,还在性能、灵活性和可靠性上实现了显著提升。通过yum命令可以快速安装: ``` yum install rsync -y ``` 安装完成后,rsync即可在Linux系统中使用,支持本地和远程文件传输、增量同步、断点续传等高级功能。 **二、作为客户端使用:功能与优势** 1. **功能覆盖与对比** - **替代scp和cp**:rsync同时支持远程(`scp`类似)和本地(`cp`类似)文件拷贝,但具备更智能的增量传输机制。 - **增量同步核心**:默认情况下,rsync通过比对文件大小、修改时间、校验和等信息,仅传输变化的文件部分,大幅节省带宽和时间。例如,当同步一个1GB文件但仅修改了10MB内容时,rsync只会传输这10MB。 - **断点续传**:使用`--partial`或`--partial-dir`参数时,rsync能在网络中断后从断点继续传输,避免重复传输已完成部分。 - **灵活性与可配置性**:通过丰富的命令行选项(如`-a` `-v` `-z` `-r` `-P`等)可自定义同步行为,如递归同步、压缩传输、显示进度、保留权限等。 2. **命令行示例** - 本地文件拷贝:`rsync /path/to/source /path/to/destination` - 远程传输(基于SSH协议):`rsync -avz /local/file user@remote:/remote/path` - 增量同步目录:`rsync -av /local/directory user@remote:/remote/directory` 3. **与其他命令的对比** - **scp vs rsync**:

| 命令 | 传输方式 | 增量同步 | 断点续传 | 安全性 | 适用场景 |

| scp | 全量传输 | 不支持 | 不支持 | 高(SSH) | 小文件/单次传输 |

| rsync | 增量传输 | 支持 | 支持 | 高(可配) | 大文件/频繁同步 |

- **cp vs rsync**:

- `cp`仅支持本地全量拷贝,无法跨主机传输,而rsync可本地+远程,且增量节省资源。

4. **局限性**

- **依赖其他工具检测变化**:rsync本身不监测文件实时变化,需结合`inotify`(Linux内核)或定时任务(如cron)触发同步。

- **CPU消耗较高**:增量同步前的文件比对过程需要较多计算资源,尤其在处理大量小文件时更明显。

- **命令复杂度**:参数众多,新手可能需要学习曲线,但熟练后能大幅提升效率。

**三、作为服务端使用:搭建与配置**

1. **启动rsync服务端**

通过守护进程模式(rsyncd)提供文件同步服务,需配置`/etc/rsyncd.conf`并启动服务:

2. **rsyncd.conf配置示例**

3. **客户端访问服务端**

使用rsync协议(非SSH)进行同步,语法特殊:

4. **服务端优势**

- **集中管理**:通过模块定义控制访问权限和路径,适合多客户端同步同一服务器。

- **协议选择**:rsync协议(`rsync://`)比SSH更高效,但需额外配置防火墙(开放873端口)和认证机制。

- **虚拟用户支持**:使用虚拟账号(非系统账号)提升安全性,避免直接操作系统文件。

**四、传输协议对比:SSH vs rsync协议**

1. **SSH协议(rsync + ssh)**

- 使用场景:无需额外配置,直接利用现有SSH服务,适合临时或低安全要求的同步。

- 命令示例:`rsync -avz user@1.1.1.111:/remote/path /local`

- 依赖:`sshd`服务,传输加密但效率略低。

2. **rsync协议(rsyncd守护进程)**

- 使用场景:需长期、频繁同步,且对性能或权限控制有高要求。

- 命令示例:`rsync -av rsync_user@1.1.1.111::module_name /local`

- 依赖:`rsyncd`服务、自定义端口(默认873)、独立的认证配置。

**五、高级使用场景与注意事项**

1. **备份与镜像**

结合`-a`参数(归档模式,保留权限、时间等元数据)实现服务器数据备份,如:

2. **实时同步**

搭配`inotify-tools`监听文件变化,实时触发rsync同步,适用于文件服务器或日志同步:

3. **性能优化**

- 大文件传输:使用`-z`参数压缩传输(网络带宽优先),或关闭压缩(本地磁盘IO优先)。

- 小文件优化:通过`--no-whole-file`避免传输整个文件,适合大量小文件场景。

4. **安全性考虑**

- 服务端禁用`list`选项防止模块列表泄露。

- 密码文件需设置600权限(`chmod 600 /etc/rsync.password`)。

- 结合SSH密钥认证替代明文密码。

**六、总结与建议**

rsync的强大在于其增量同步、断点续传和灵活配置,但需权衡CPU消耗和命令复杂性。适合以下场景:

- 大文件或频繁变动的数据同步(如备份、集群文件共享)

- 需要断点续传或高效带宽利用的传输任务

- 对权限、路径控制有严格要求的服务器环境

**不足之处**:

- 命令行参数学习成本高

- 不适合实时监测文件变化(需第三方工具)

- 高并发同步可能占用较多系统资源

通过合理配置参数和结合其他工具(如cron、inotify),rsync能大幅提升文件传输和同步效率,成为系统运维中不可或缺的工具。

浙公网安备 33010602011771号

浙公网安备 33010602011771号