阅读笔记

文章总结(week 1)

2024.3.4 ~ 2024.3.10

Deep Ritz Method for Elliptical Multiple Eigenvalue Problems

IF=2.5, Journal of Scientific Computing

DOI: 10.1007/s10915-023-02443-8

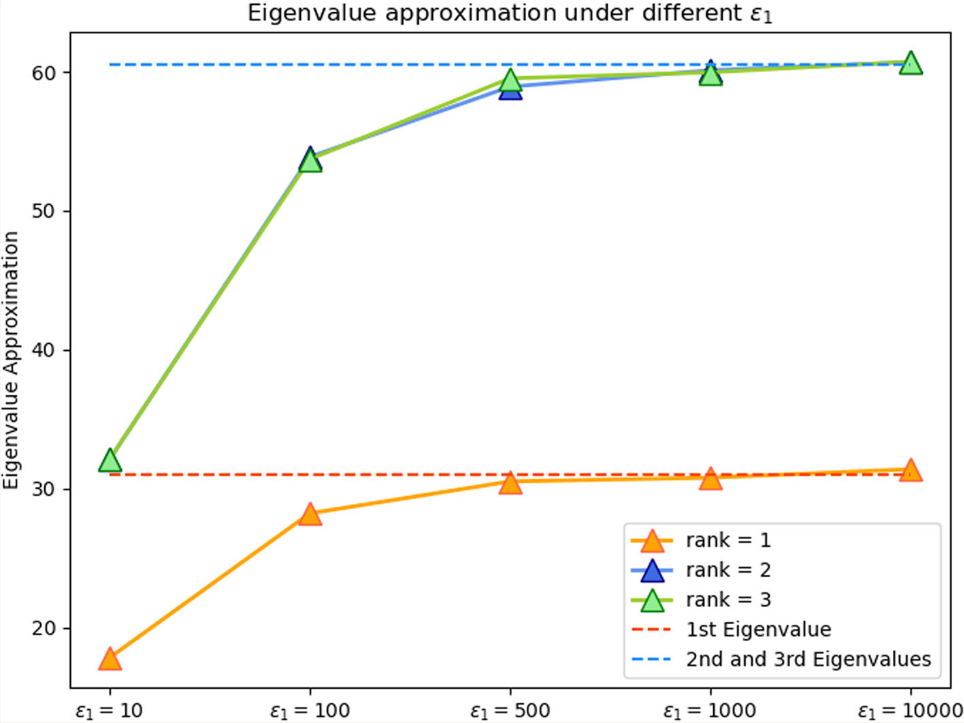

文章研究了用神经网络求解椭圆型多重特征值问题。基于椭圆特征值问题的惩罚变分形式,提出了椭圆多重特征值计算的一般公式。用Deep Ritz method求解了椭圆方程的特征值和特征函数。有网络深度和宽度的定量理论分析结果。主要内容如下:

背景

为求如下椭圆方程特征值和特征向量:

一般用瑞利商来求:

但直接用瑞利商求解会因为瑞利商非凸而不正则,所以需要正则化方法。另需要特征函数是正交的,应引入正交惩罚项。文章证明了 \(T\) 是Robin边界和Dirichlet边界时的收敛性。

方法

文章考虑如下方程的特征值 \(\lambda ^ {\varepsilon_1}\):

并证明了如下定理:

Let \(Q(v)=\|v\|^2-1\) and we define:

and

If \(\varepsilon_2>2 \lambda_k\), we claim that

and \(\xi_k\) is the only minimizer of \(\mathcal{L}_k\), omitting a linear transformation in the eigenspace of \(a^{\varepsilon_1}\).

因此要求方程 (1) 的特征值,可以求方程 \((2)\) 的特征值,只需要选择较大的 \(\varepsilon_1\) 即可有较准的估计。而方程的 (2) 的特征向量正是损失函数 \(\mathcal{L}_k(v)\) 的最小值。所以只需要利用神经网络优化即可,文章中使用的是DeepRitz。

结果

文章另有神经网络尺寸和特征值误差关系的分析。

hp-VPINNs: Variational physics-informed neural networks with domain decomposition

IF=7.2, Computer Methods in Applied Mechanics and Engineering

DOI: 10.1016/j.cma.2020.113547

文章主要改进了PINN算法

改进的方式:

将PINN强形式的误差函数中引入测试函数,即将误差函数变为变分形式。

文章的主要创新点在于用分区域的紧支集正交多项式作为测试函数v,而非一般在整个I上定义的测试函数。

经过这样处理的测试函数可以将上述积分化为如下求和形式:

这样做的好处:

- 原本的积分式子可以分为多个子积分计算,能并行,速度不慢

- 实验数据说明这样的误差要更小

文章选择的测试函数 \(v^e_k\) 是定义在区域e内的k阶高斯勒让德多项式。即在每个子区域内做了一个高斯勒让德函数的测试函数族。最后的积分运算也选择了使用高斯积分公式。

NSNO: Neumann Series Neural Operator for Solving Helmholtz Equations in Inhomogeneous Medium

IF=2.1, Journal of Systems Science and Complexity

DOI: 10.1007/s11424-024-3294-x

文章主要做了两件事情:

- 用纽曼序列解了Helmholtz方程正问题

- 求解思路是迭代法

- 使用了U-Net和Fourier Neural Network框架

- 监督学习+物理信息

- 训练数据来源于有限差分法

- 用上文提到的NSNO模型解了一下Helmholtz反问题:

- 解法是基于求解优化问题的伴随状态法(见文后appendix)

- 将伴随状态法中的正问题求解器换成了神经网络

- 相对误差比直接使用有限差分法大一点22.68% -> 25.25%

- 但是速度快了很多 29.81s -> 2.76s

文章提到的NSNO模型内容比较多,主要想法是用U-Net提取不同尺度(三个尺度)的特征,特征过三个FNO,最后decode的过程。文章过程写的很清楚,但是数值实验的结果不是很漂亮。

PETAL: Physics Emulation Through Averaged Linearizations for Solving Inverse Problems

NerualPS 2023文章

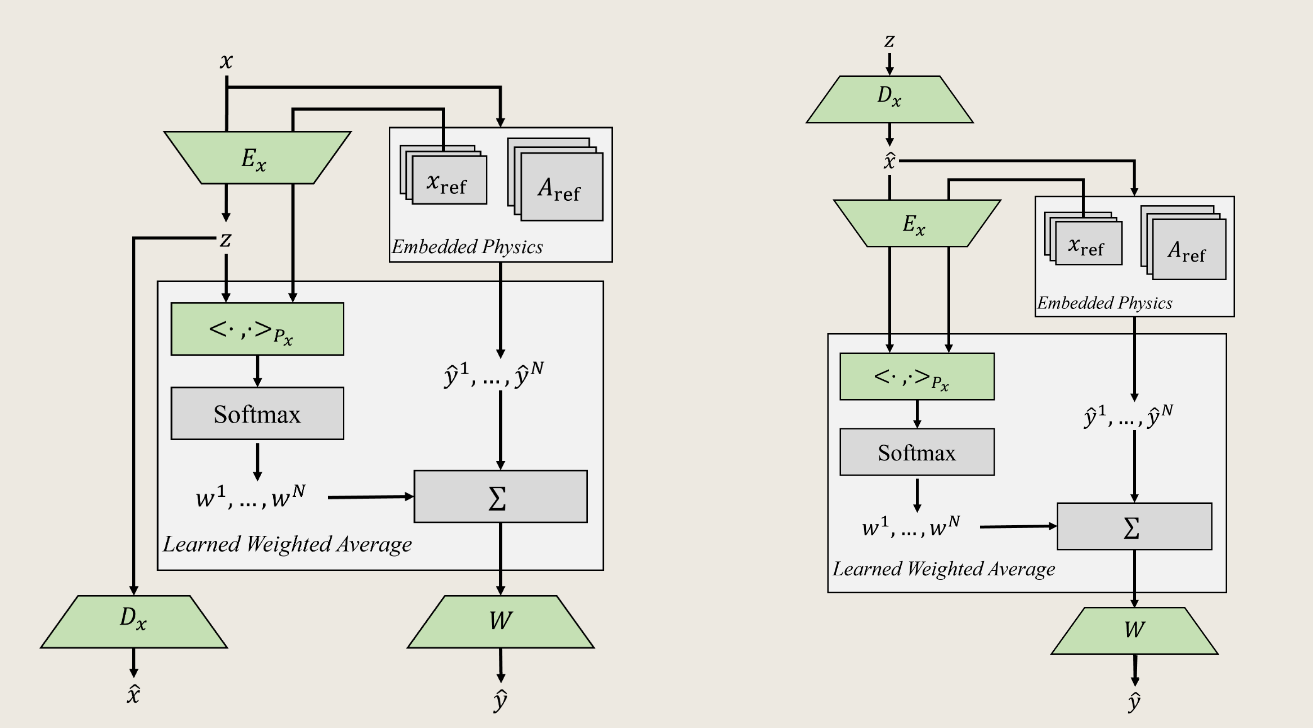

正问题模型:使用多个线性模型加权,代替MLP作为反问题的正演模型。输入参数投影到特征空间,加权的权值是特征空间中的权值,最后加权后结果由W投影回结果矩阵。

反问题模型:在特征空间下的优化问题。求解可以用LBFS、SGD等,作者说使用特征空间投影将提升优化问题的导数的准确度。

【准确的下降方向对于解反问题的优化问题至关重要。然而,正演黑盒模型(如MLP)只被训练来匹配输出,因此执行梯度下降可能导致许多不受欢迎的局部最小值】

文章使用监督学习训练正问题。正问题的可训练参数仅为:encoding矩阵E,投影矩阵P,反投影矩阵W,decoding矩阵D.

因此实际上的网络就是带数据的MLP,最后反问题的梯度也依赖于自动微分。

正问题模型(图左),反问题模型(图右)。

浙公网安备 33010602011771号

浙公网安备 33010602011771号