Hadoop集群扩容

一、添加新的节点(热部署)

1.克隆一台虚拟机作为新的节点,修改IP、主机名

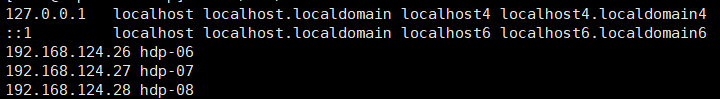

2.修改namenode的/etc/hosts中的IP地址映射(这个步骤只是为了方便记忆,可以不做,在namenode的slaves添加ip地址即可)

3.修改namenode的slaves,添加新的节点

4.配置新节点的免密登陆

ssh-keygen //生成公钥和私钥 ssh-copy-id 主机名 //传递公钥

5.单独启动新节点datanode

hadoop-daemon.sh start datanode

6.验证

二、纵向扩容(挂载新的硬盘)

1.新增硬盘 右键虚拟机 >> 设置 >> 添加 >> 硬盘 重启reboot

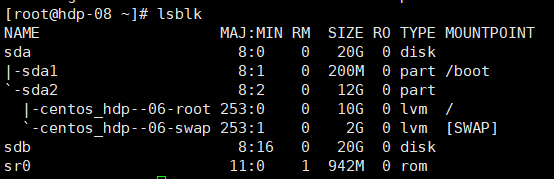

2.使用命令lsblk查看系统的硬盘使用状况

3.硬盘分区 fdisk /dev/sdb

常用命令:m 查看帮助 n 分区 p 查看分区表 w 保存分区信息

4.硬盘分区格式化 mkfs.xfs /dev/sdb1

5.挂载

在根目录新建文件夹 mkdir sdb1

mount /dev/sdb1 /sdb1 (临时挂载,重启就没了)

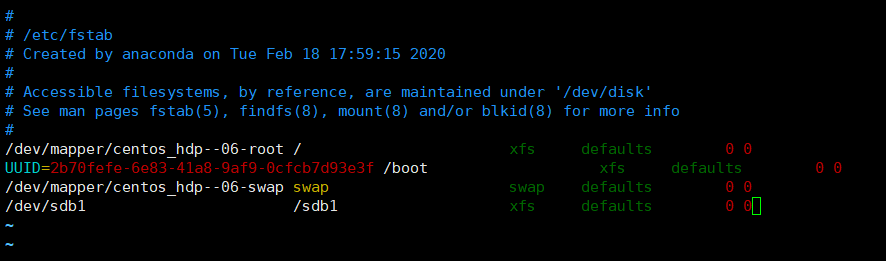

持久化 vim /etc/fstab (配置开机挂载)

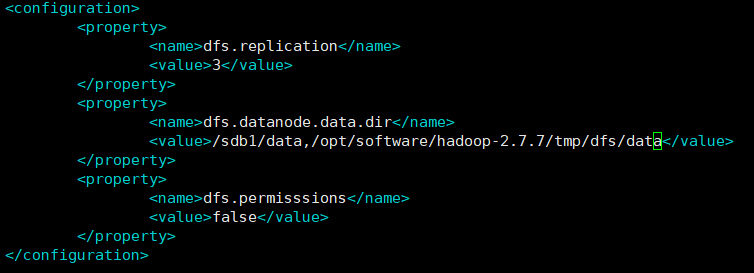

6.配置hdfs-site.xml

cd /opt/software/hadoop-2.7.7/etc/hadoop/

vim hdfs-site.xml

7.启动datanode

hadoop-daemon.sh start datanode

8.查看节点情况

浙公网安备 33010602011771号

浙公网安备 33010602011771号