AI自动化环境搭建(一)

之前在学习AI自动化之前,将学习内容都记录到本地了,今天把内容发布出来和大家一起分享,共同探讨

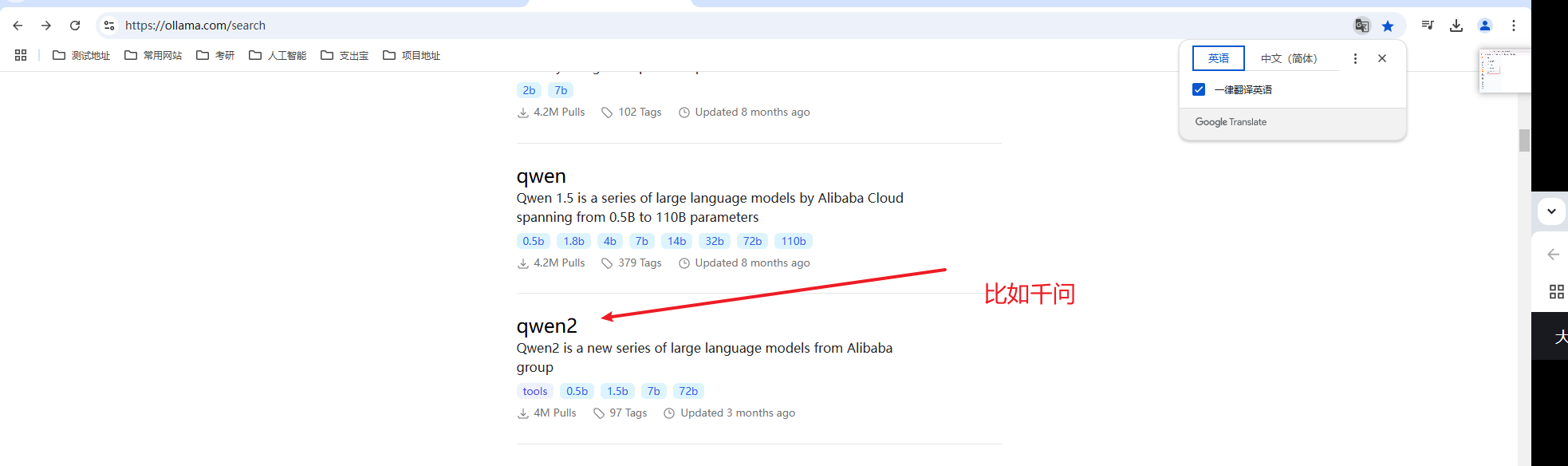

1、下载ollama 网址:https://ollama.com/search

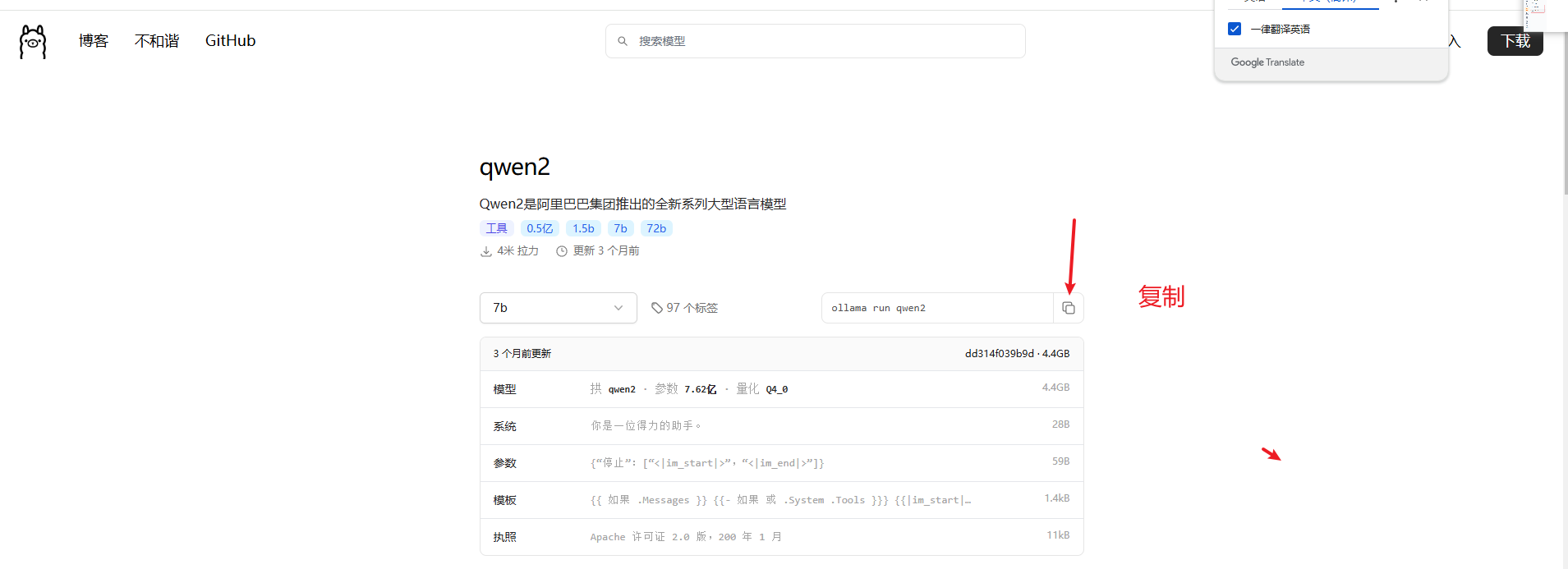

2、下载之后,安装到本地,然后找到ollama 你想用的大模型

3、打开allama客户端,执行之后,就会下载对应的大模型到本地,下载完之后,本地就可以自己运行了

或者打开cmd 直接运行 Ollama run qwen2.5

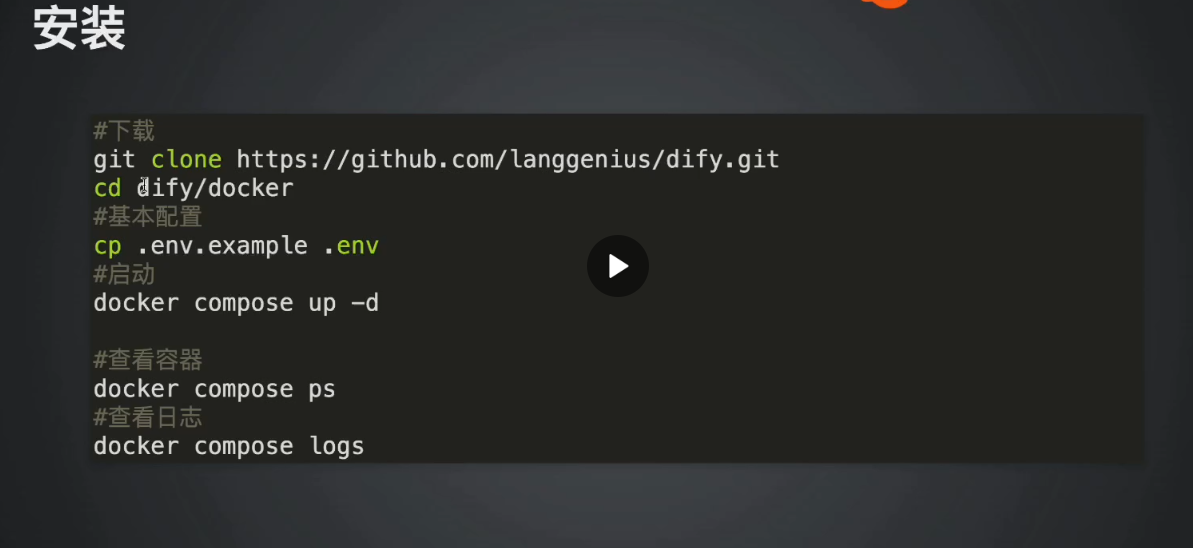

4、将部署的平台,分享给其他人,可被访问,先把dify 克隆到本地,先下载git.exe 安装后下载

下载完之后,使用git clone https://github.com/langgenius/dify.git

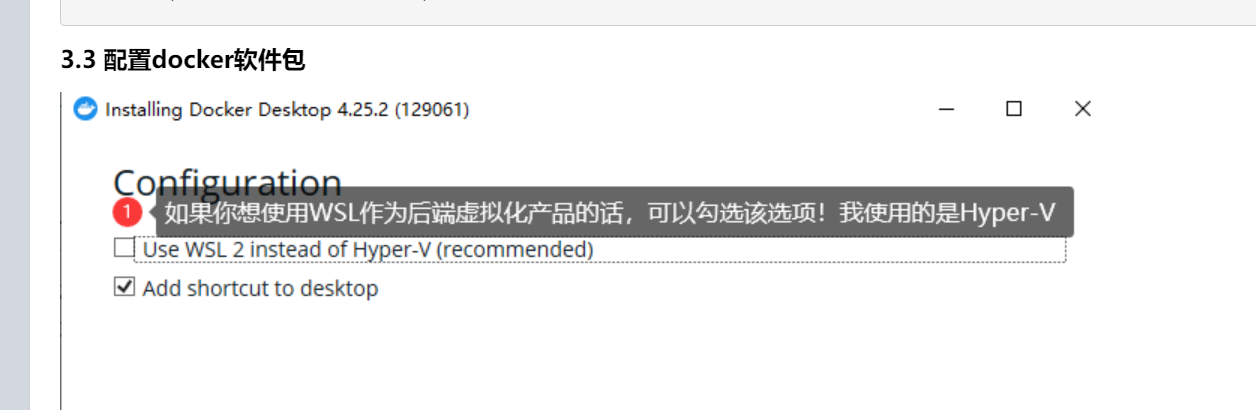

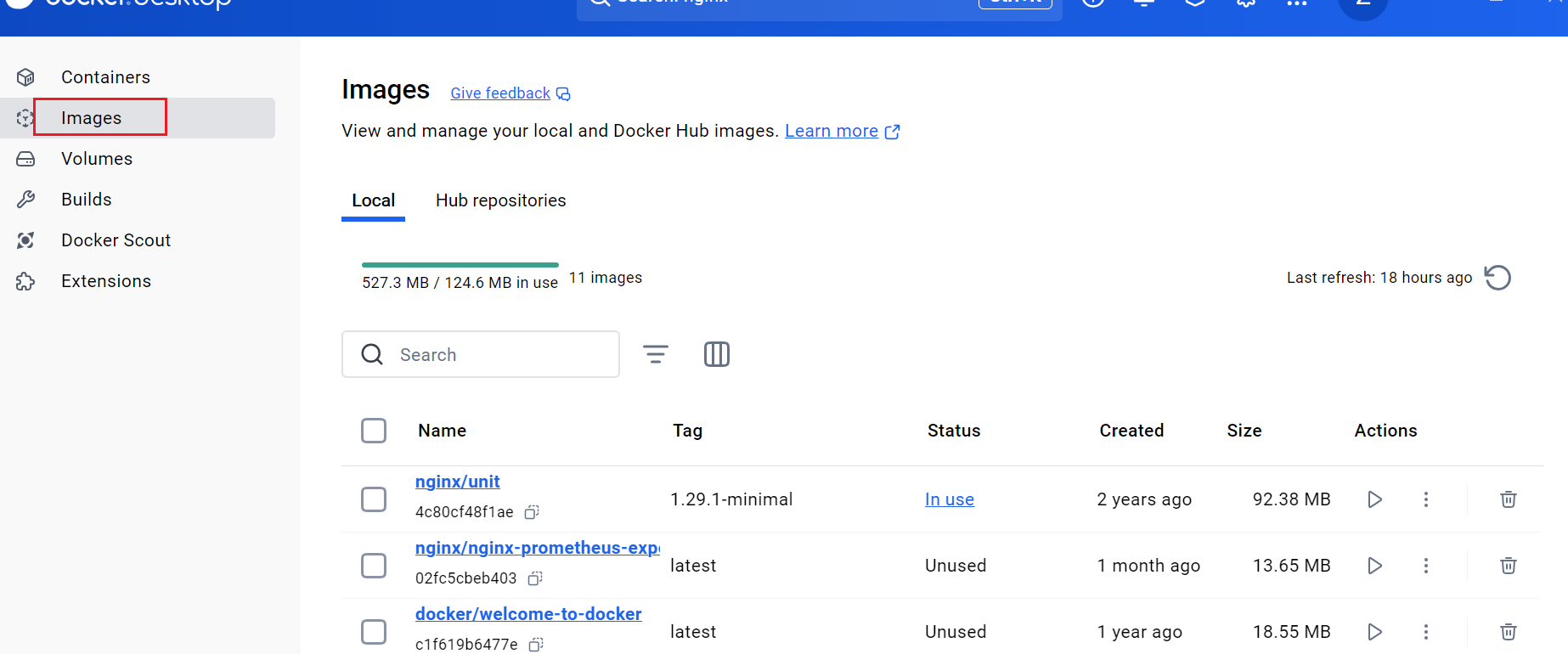

1、安装docker desktop 之后,安装docker 的方式:https://www.cnblogs.com/yinzhengjie/p/17889373.html

这里要注意这一点,选择了WL2就是说明要用wL2环境,我没有勾选,我要用Hpy的环境

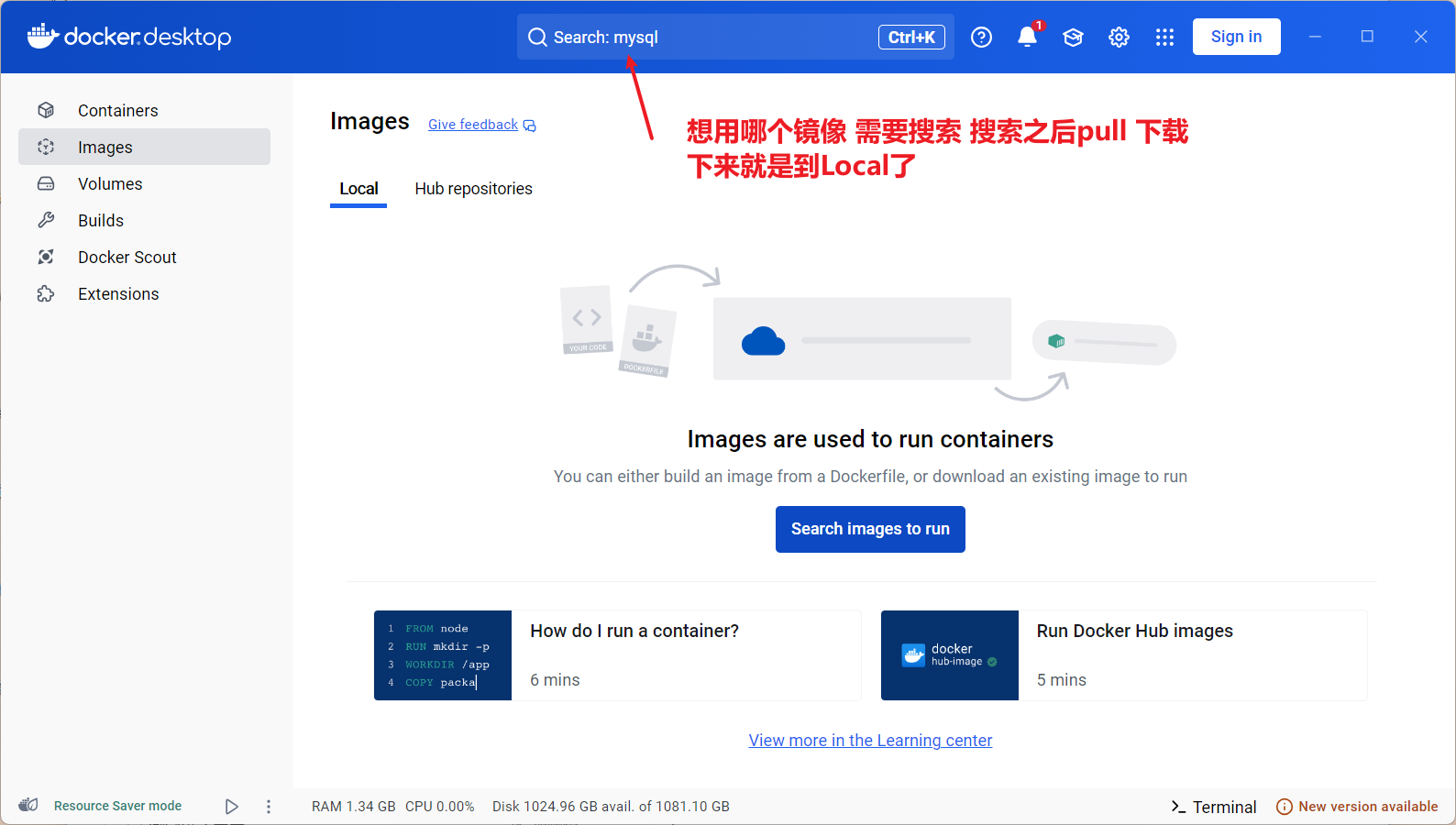

1安装之后 打开dockers,先配置下载地址:

1、

第一步

搜索要先kexue上网

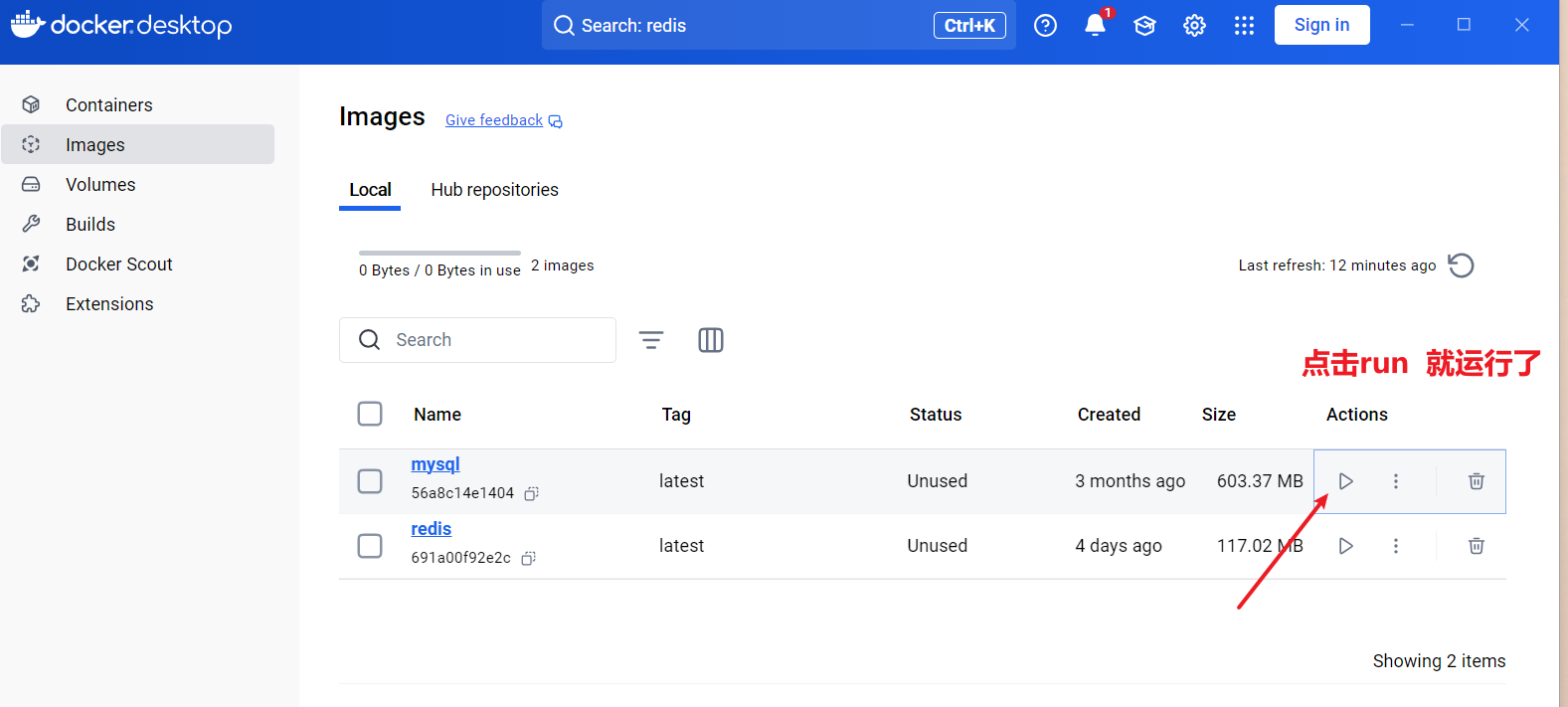

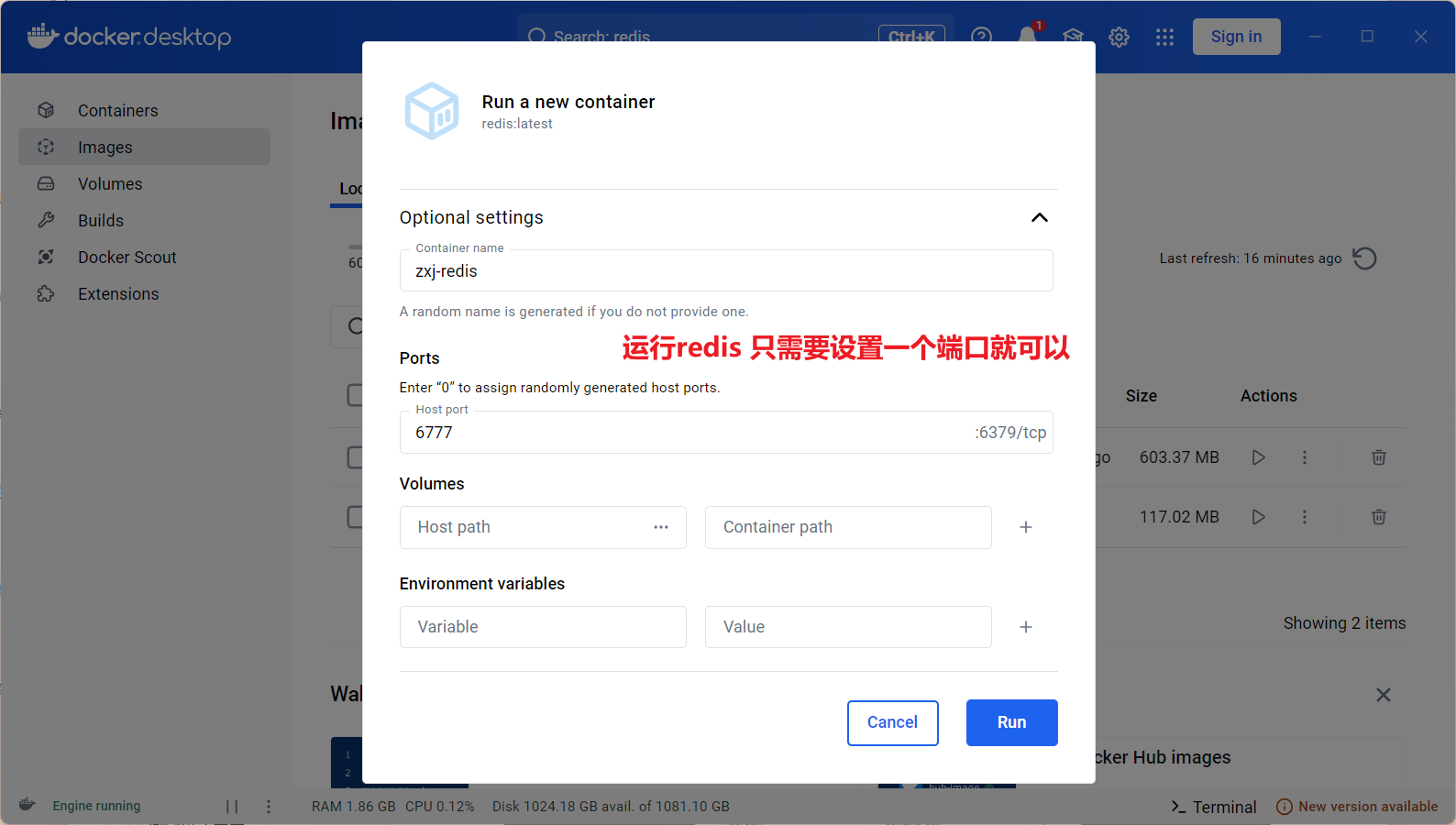

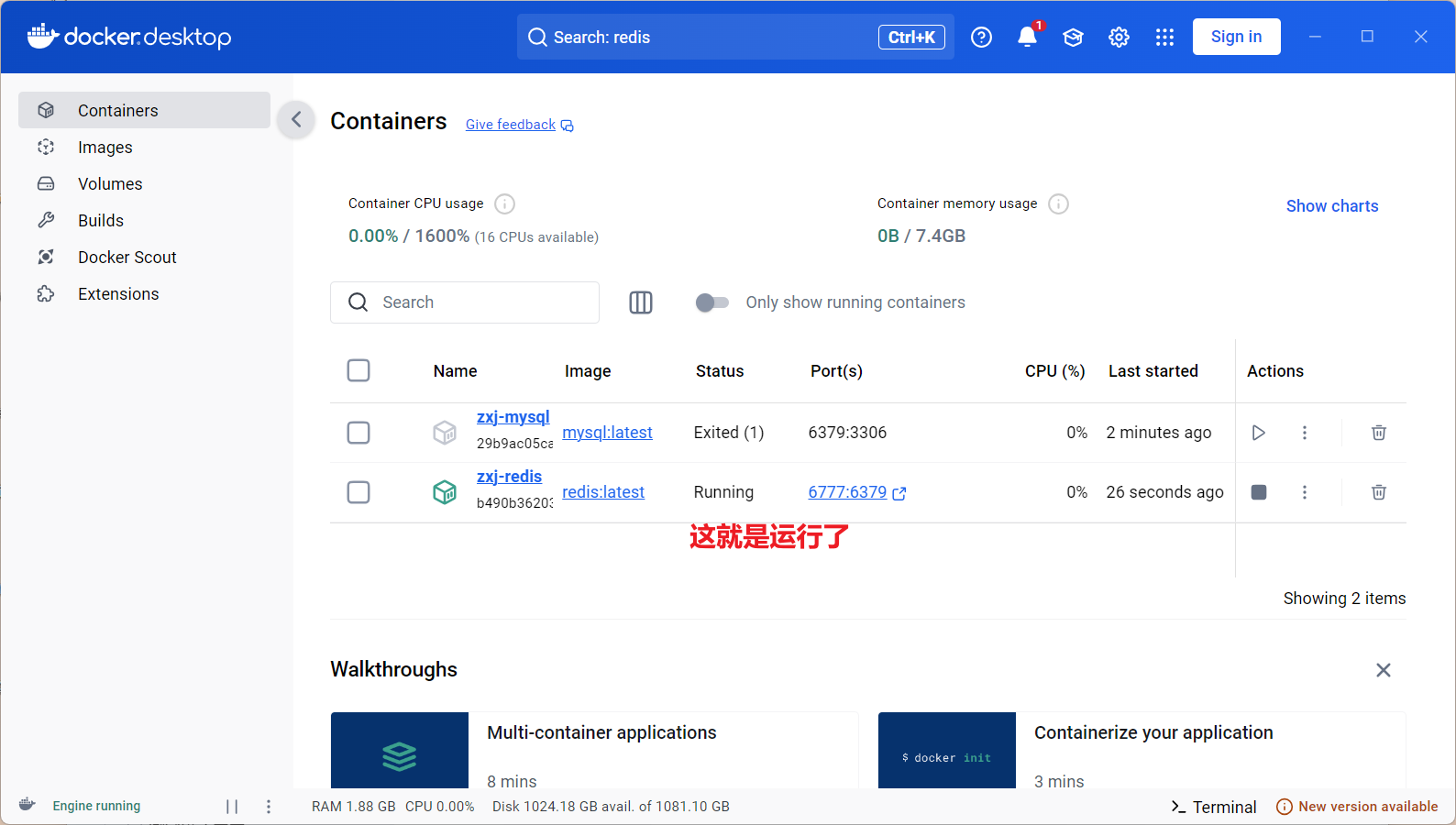

运行redis

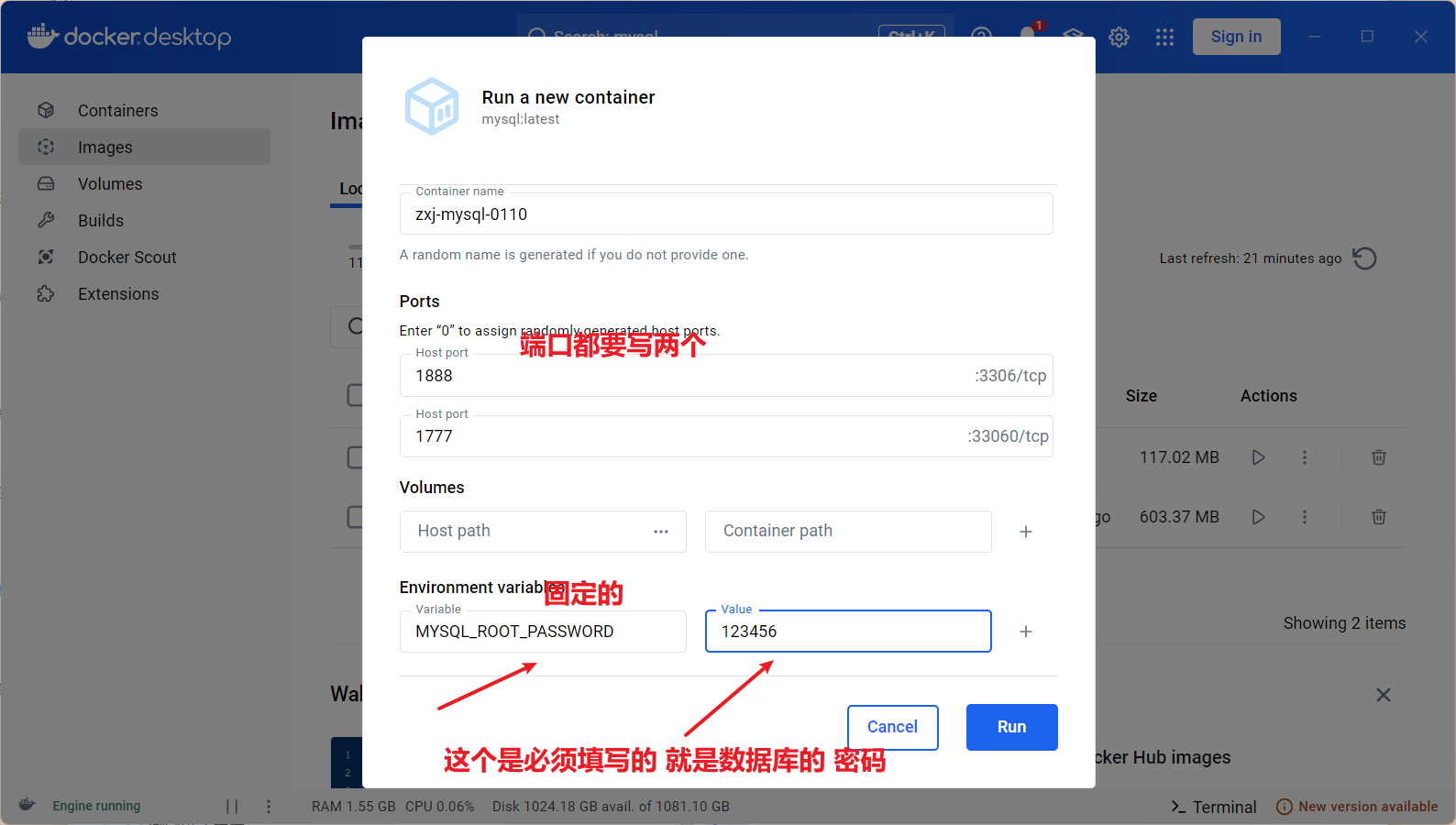

mysql 配置

{

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": true,

"registry-mirrors": [

]

}

然后重启docker

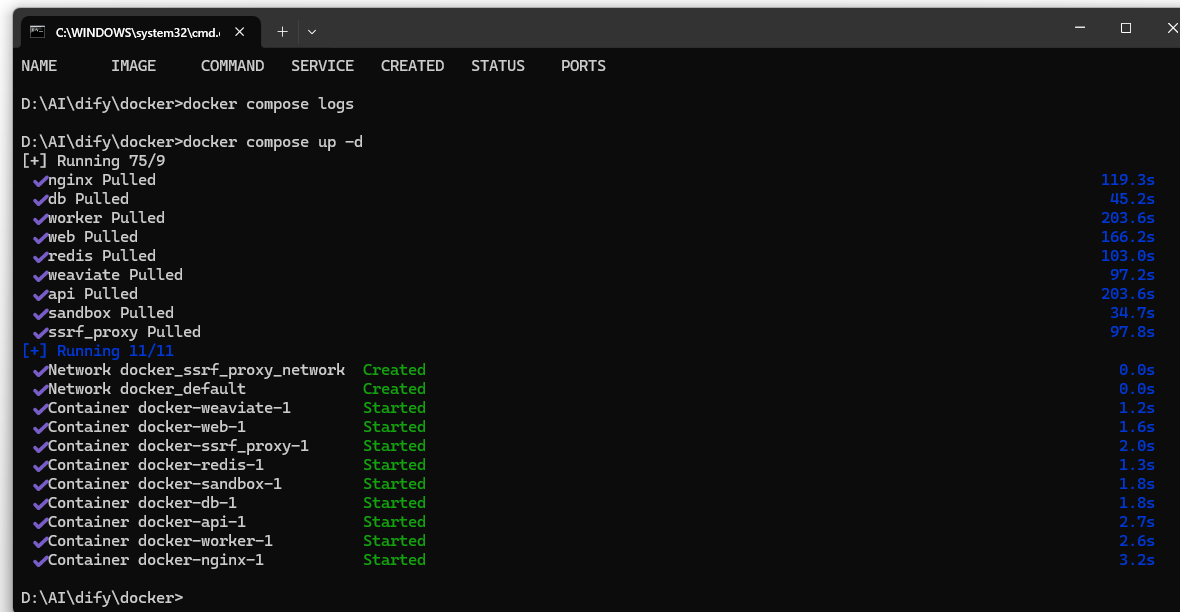

2、然后下载dify 之后,进入dify/docker下 执行命令,这样才能运行成功

打开docker 进入docker 的目录D:\AI\dify\docker>

docker compose up -d

打开 127.0.0.1 在浏览器里

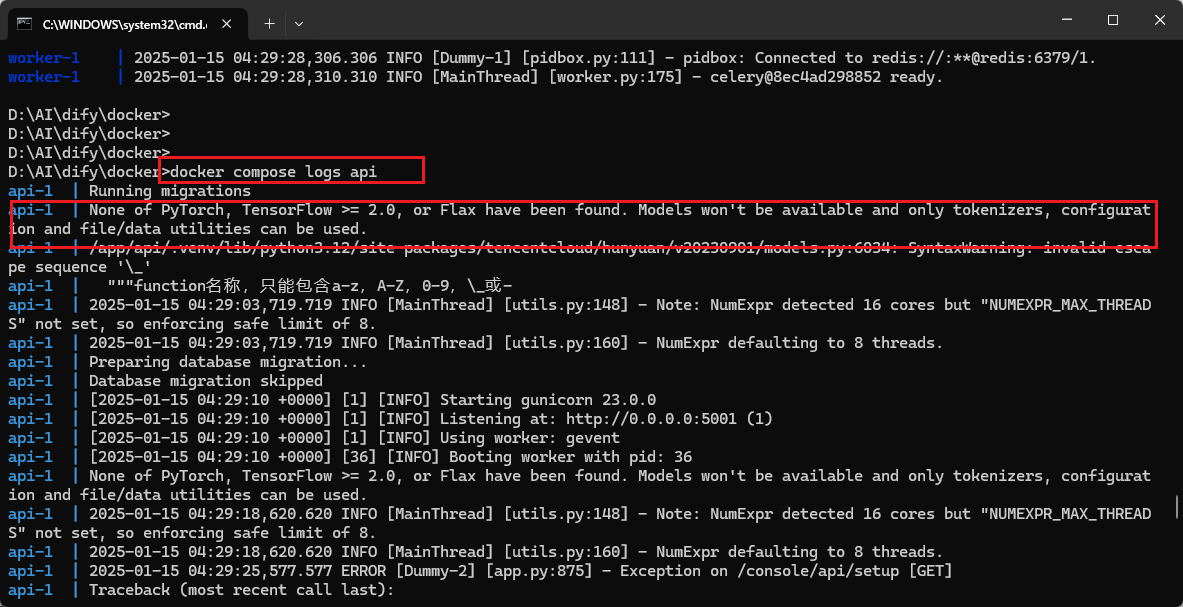

如果打开127.0.0.1报错的话,就查看docker日志,docker compose logs api 根据报错的日志进行纠正

根据提示,安装对应的三个包 torch tensorflow flax

如果报错 这个能解决https://zhuanlan.zhihu.com/p/10005905119

进入到doker 的命令行 执行这三个

在命令行中运行 copy .env.example .env,生成 .env 文件

在命令行中运行 copy middleware.env.example middleware.env ,生成 middleware.env 文件 在命令行中运行docker compose docker-compose.middleware.yaml up -d

在命令行中运行 docker compose up -d

然后再启用127.0.0.1 就可以打开dify 了

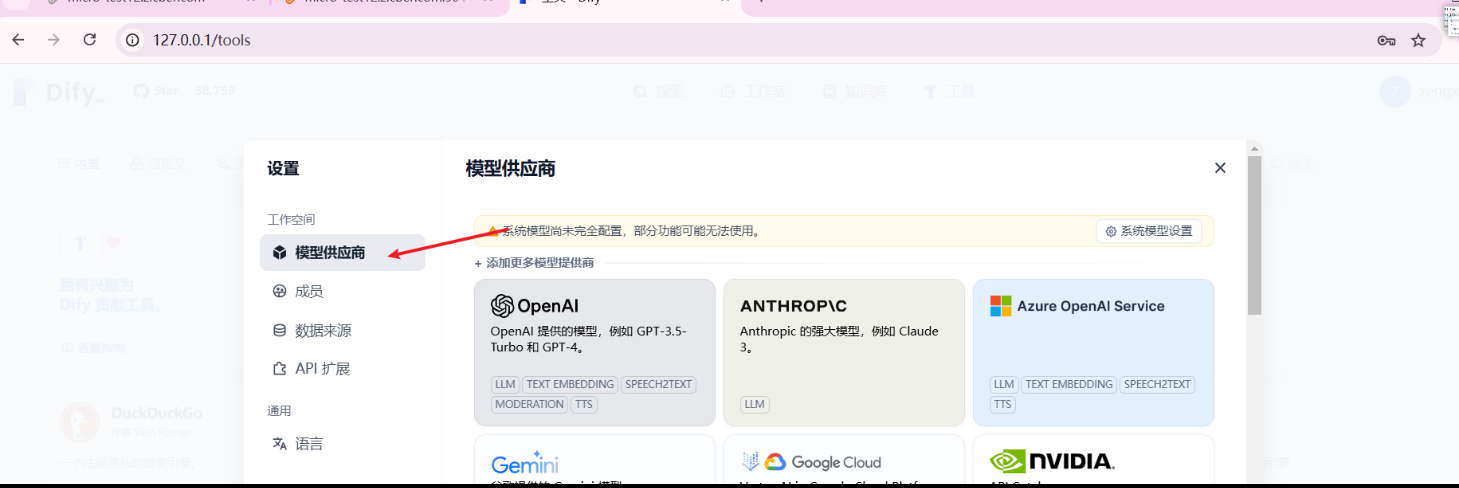

然后增加自己的模

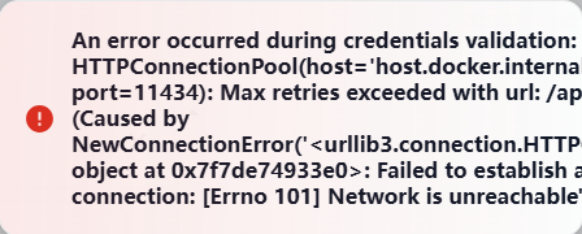

如果添加时报错

,可以打开官网查看

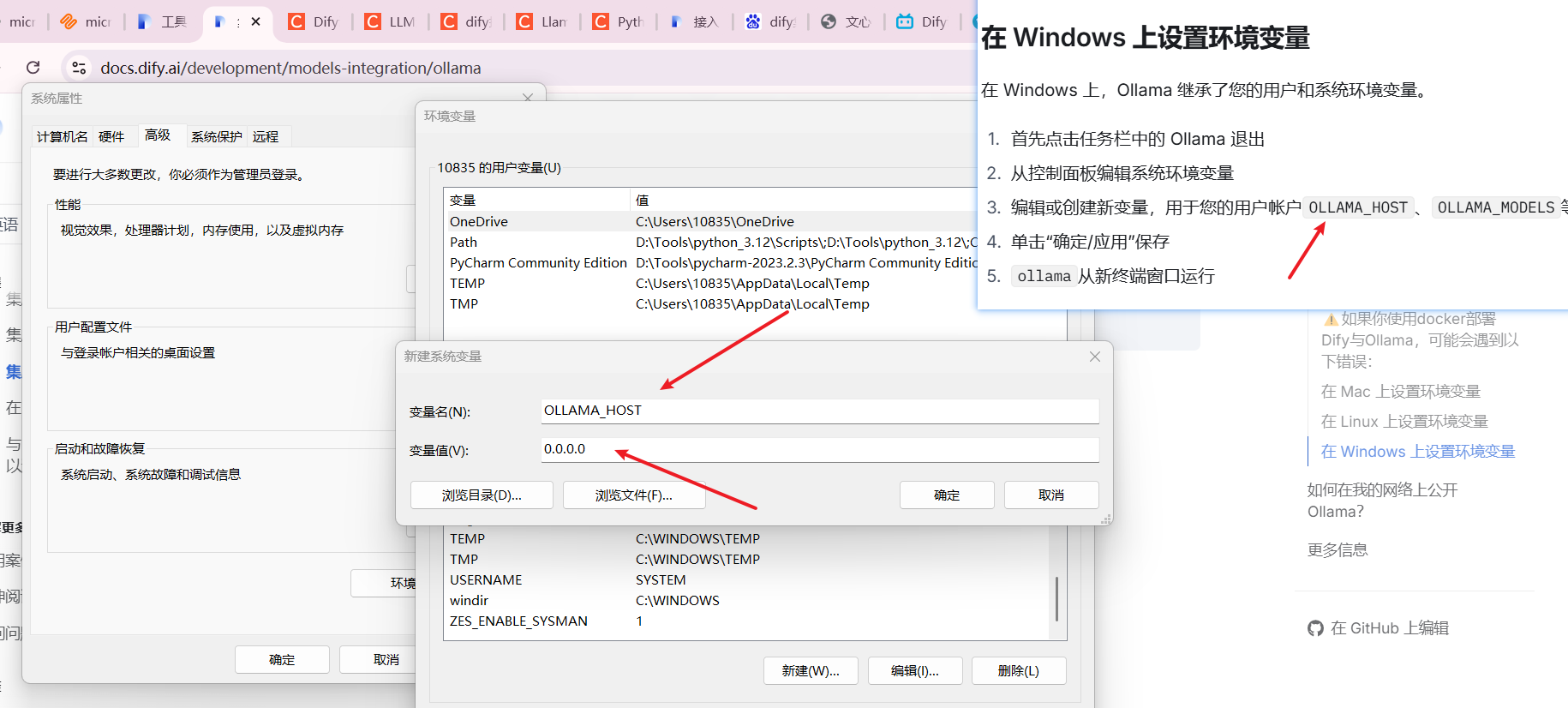

win再系统变量里 添加一个环境变量

重启ollama 添加时,添加:http://host.docker.internal:11434 这个就可以了

这就是添加成功了

如果运行大模型时 报链接不上时,检查一下 Ollama 和docker 是否都开启了 都开了之后,就不报错了

浙公网安备 33010602011771号

浙公网安备 33010602011771号