consul 高可用集群搭建

1.启动参数详解

–net=host docker参数, 使得docker容器越过了net namespace的隔离,免去手动指定端口映射的步骤

-server consul支持以server或client的模式运行, server是服务发现模块的核心, client主要用于转发请求

-advertise 将本机私有IP传递到consul

-retry-join 指定要加入的consul节点地址,失败后会重试, 可多次指定不同的地址

-client 指定consul绑定在哪个client地址上,这个地址可提供HTTP、DNS、RPC等服务,默认是>127.0.0.1

-bind 绑定服务器的ip地址;该地址用来在集群内部的通讯,集群内的所有节点到地址必须是可达的,>默认是0.0.0.0

allow_stale 设置为true则表明可从consul集群的任一server节点获取dns信息, false则表明每次请求都会>经过consul的server leader

-bootstrap-expect 数据中心中预期的服务器数。指定后,Consul将等待指定数量的服务器可用,然后>启动群集。允许自动选举leader,但不能与传统-bootstrap标志一起使用, 需要在server模式下运行。

-data-dir 数据存放的位置,用于持久化保存集群状态

-node 群集中此节点的名称,这在群集中必须是唯一的,默认情况下是节点的主机名。

-config-dir 指定配置文件,当这个目录下有 .json 结尾的文件就会被加载,详细可参考https://www.consul.io/docs/agent/options.html#configuration_files

-enable-script-checks 检查服务是否处于活动状态,类似开启心跳

-datacenter 数据中心名称

-ui 开启ui界面

-join 指定ip, 加入到已有的集群中

2.端口详解

: http 端口,用于 http 接口和 web ui访问;

: server rpc 端口,同一数据中心 consul server 之间通过该端口通信;

: serf lan 端口,同一数据中心 consul client 通过该端口通信; 用于处理当前datacenter中LAN的gossip通信;

: serf wan 端口,不同数据中心 consul server 通过该端口通信; agent Server使用,处理与其他datacenter的gossip通信;

: dns 端口,用于已注册的服务发现;

首先

# 查看防火墙状态

systemctl status firewalld

# 停止防火墙

systemctl stop firewalld

三台机器

192.168.0.191 主

192.168.0.110 从

192.168.0.122 从

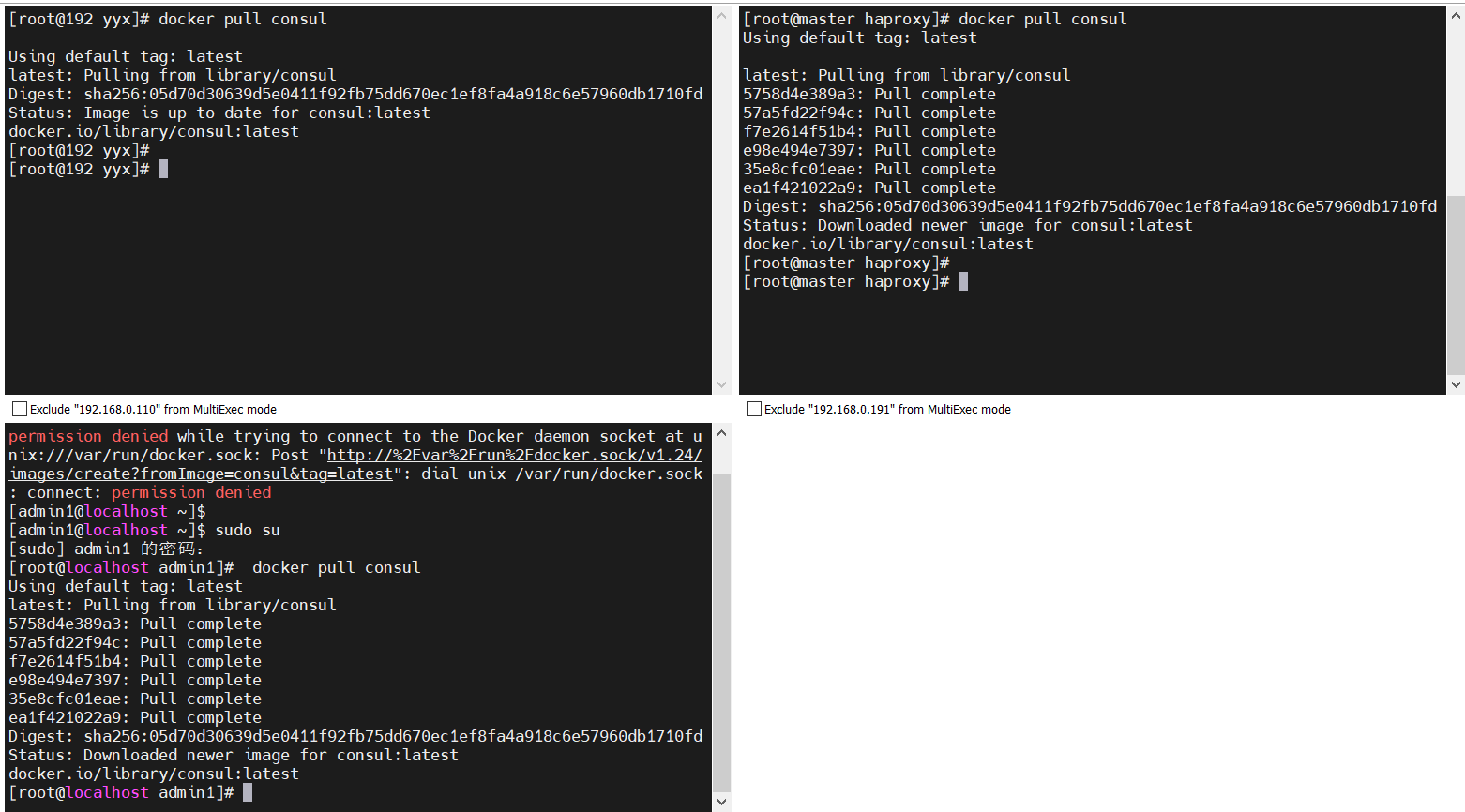

每台机器拉取consul

192.168.0.191

docker run -d --name consul21 -h=consul21 --net=host -e CONSUL_BIND_INTERFACE=ens33 \

consul agent -server=true -client=0.0.0.0 -bind=192.168.0.191 -ui -bootstrap-expect=3

192.168.0.110

docker run -d --name consul22 -h=consul22 --net=host -e CONSUL_BIND_INTERFACE=ens33 \

consul agent -server=true -client=0.0.0.0 -join=192.168.0.191 -ui

192.168.0.122

docker run -d --name consul23 -h=consul23 --net=host -e CONSUL_BIND_INTERFACE=ens33 \

consul agent -server=true -client=0.0.0.0 -join=192.168.0.191 -ui

8300:集群内数据的读写和复制

8301:单个数据中心lan gossip协议通讯

8302:跨数据中心wan gossip协议通讯

8500:提供获取服务列表、注册服务、注销服务等HTTP接口;提供UI服务

8600:采用DNS协议提供服务发现功能

参考 【微服务| Consul】使用docker搭建consul集群_docker consul-CSDN博客

--net=host:容器启动最好是host,因为如果用Bridge,Consul 自带的DNS功能不起作用。

docker run -d --name consul1 --net=host -e CONSUL_BIND_INTERFACE=ens33 consul agent -server=true -client=0.0.0.0 -bind=192.168.0.168 -ui -bootstrap-expect=3 -node=node1

docker run -d --name consul2 --net=host -e CONSUL_BIND_INTERFACE=ens33 consul agent -server=true -client=0.0.0.0 -join=192.168.0.168 -node=node2

docker run -d --name consul3 --net=host -e CONSUL_BIND_INTERFACE=ens33 consul agent -server=true -client=0.0.0.0 -join=192.168.0.168 -node=node3

这里有个问题 如果 是 Bridge 启动 集群 会报错 节点之前 通信 有问题

类似下面的 方式 在一台机器 启动 3个 consul 没问题 3台 机器 每台都 一个consul 会出现 通信 报错 导致 集群选举失败

但是 如果 用 --net=host 方式部署完 之后 可以在某台机器上 用 下面 方式 添加节点就没有问题 需要注意

docker run -d --name=node1 --restart=always \

-e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' \

-p 8300:8300 \

-p 8301:8301 \

-p 8301:8301/udp \

-p 8302:8302/udp \

-p 8302:8302 \

-p 8400:8400 \

-p 8500:8500 \

-p 8600:8600 \

-h node1 \

consul agent -server -bind=0.0.0.0 -bootstrap-expect=3 -node=node1 \

-data-dir=/tmp/data-dir -client 0.0.0.0 -ui

docker run -d --name=node2 --restart=always \

-e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' \

-p 8300:8300 \

-p 8301:8301 \

-p 8301:8301/udp \

-p 8302:8302/udp \

-p 8302:8302 \

-p 8400:8400 \

-p 8500:8500 \

-p 8600:8600 \

-h node2 \

consul agent -server -bind=0.0.0.0 -node=node2 \

-join=192.168.0.168 -node-id=$(uuidgen | awk '{print tolower($0)}') \

-data-dir=/tmp/data-dir -client 0.0.0.0 -ui

docker run -d --name=node3 --restart=always \

-e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' \

-p 8300:8300 \

-p 8301:8301 \

-p 8301:8301/udp \

-p 8302:8302/udp \

-p 8302:8302 \

-p 8400:8400 \

-p 8500:8500 \

-p 8600:8600 \

-h node3 \

consul agent -server -bind=0.0.0.0 -node=node3 \

-join=192.168.0.168 -node-id=$(uuidgen | awk '{print tolower($0)}') \

-data-dir=/tmp/data-dir -client 0.0.0.0 -ui

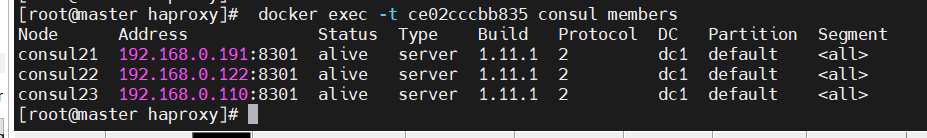

查看集群成员

docker exec -t ce02cccbb835 consul members

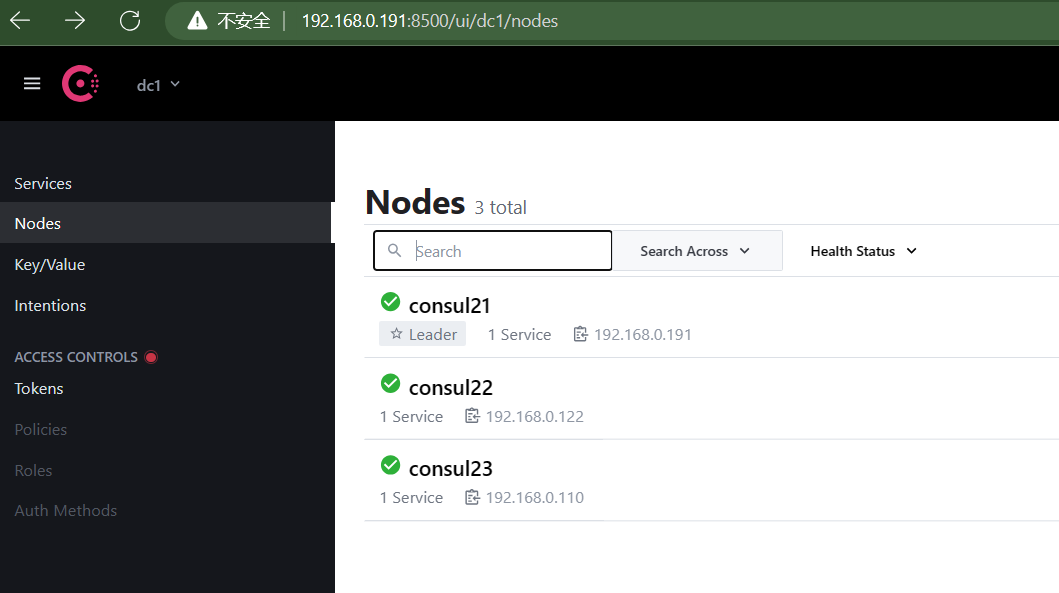

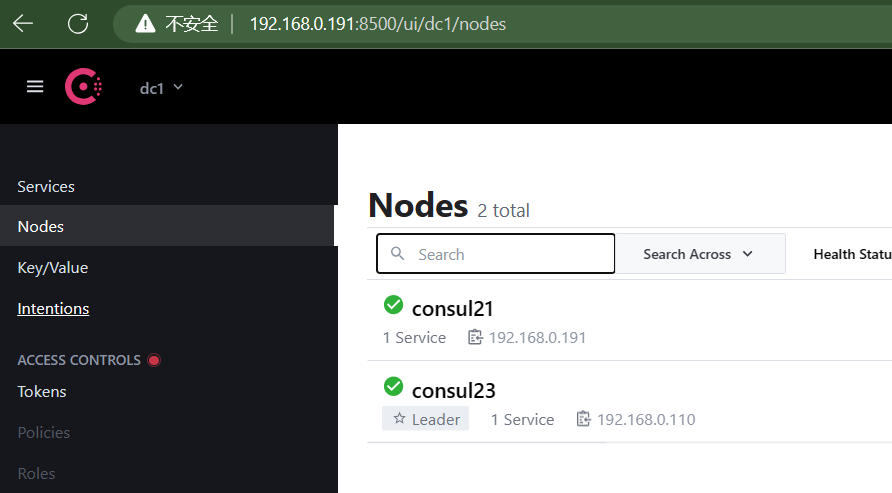

ui 查看集群成员

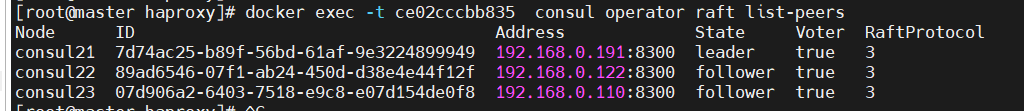

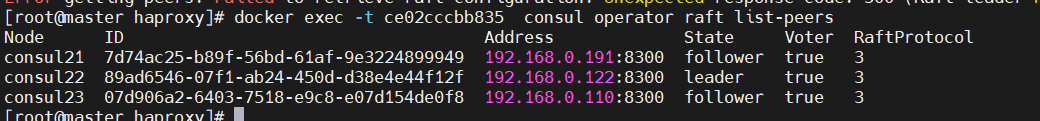

查看主从信息

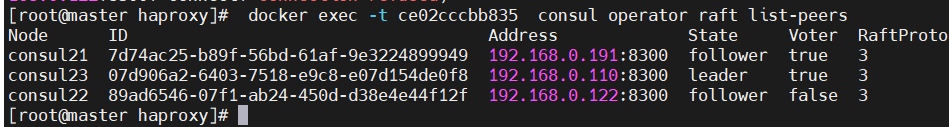

docker exec -t ce02cccbb835 consul operator raft list-peers

现在是122 是主 停止122 看是否能选举成功

到122机器 把 consul 停了

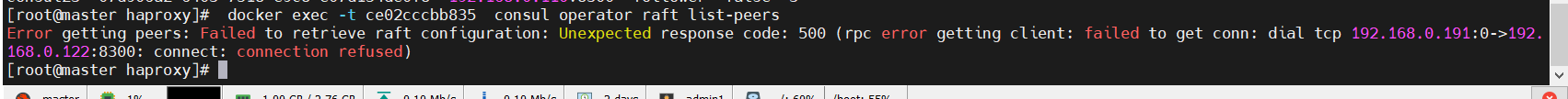

看到122 停掉了 集群访问122 也报错了

集群还可以正常运行

重启122 查看集群 可以看到 集群的 leader 变为 110机器了 重新选举成功 说consul高可用集群搭建成功了

参考

docker搭建consul集群 - YoungQ - 博客园 (cnblogs.com)

浙公网安备 33010602011771号

浙公网安备 33010602011771号