服务发现(6)

服务发现(6)

1. kubedns

1.1 内部服务发现

前面我们给大家讲解了 Service 的用法,我们可以通过 Service 生成的 ClusterIP(VIP)来访问 Pod 提供的服务,但是在使用的时候还有一个问题:我们怎么知道某个应用的 VIP 呢?比如我们有两个应用,一个是 api 应用,一个是 db 应用,两个应用都是通过 Deployment 进行管理的,并且都通过 Service 暴露出了端口提供服务。api 需要连接到 db 这个应用,我们只知道 db 应用的名称和 db 对应的 Service 的名称,但是并不知道它的 VIP 地址,我们前面的 Service 课程中是不是学习到我们通过 ClusterIP 就可以访问到后面的 Pod 服务,如果我们知道了 VIP 的地址是不是就行了?

1.2 apiserver

我们知道可以从 apiserver 中直接查询获取到对应 service 的后端 Endpoints信息,所以最简单的办法是从 apiserver 中直接查询,如果偶尔一个特殊的应用,我们通过 apiserver 去查询到 Service 后面的 Endpoints 直接使用是没问题的,但是如果每个应用都在启动的时候去查询依赖的服务,这不但增加了应用的复杂度,这也导致了我们的应用需要依赖 Kubernetes 了,耦合度太高了,不具有通用性。

1.3 环境变量

为了解决上面的问题,在之前的版本中,Kubernetes 采用了环境变量的方法,每个 Pod 启动的时候,会通过环境变量设置所有服务的 IP 和 port 信息,这样 Pod 中的应用可以通过读取环境变量来获取依赖服务的地址信息,这种方法使用起来相对简单,但是有一个很大的问题就是依赖的服务必须在 Pod 启动之前就存在,不然是不会被注入到环境变量中的。比如我们首先创建一个 Nginx 服务:(test-nginx.yaml)

[root@node01 ~]# vim test-nginx.yaml

[root@node01 ~]# cat test-nginx.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deploy

labels:

k8s-app: nginx-demo

spec:

replicas: 2

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.7.9

ports:

- containerPort: 80

---

apiVersion: v1

kind: Service

metadata:

name: nginx-service

labels:

name: nginx-service

spec:

ports:

- port: 5000

targetPort: 80

selector:

app: nginx

创建上面的服务:

[root@node01 ~]# kubectl create -f test-nginx.yaml

deployment.apps "nginx-deploy" created

service "nginx-service" created

[root@node01 ~]# kubectl get pods

NAME READY STATUS RESTARTS AGE

nginx-deploy-75675f5897-d2kw8 1/1 Running 0 3s

nginx-deploy-75675f5897-rqb6b 1/1 Running 0 3s

[root@node01 ~]# kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

...

nginx-service ClusterIP 10.100.13.170 <none> 5000/TCP 7s

...

我们可以看到两个 Pod 和一个名为 nginx-service 的服务创建成功了,该 Service 监听的端口是 5000,同时它会把流量转发给它代理的所有 Pod(我们这里就是拥有 app: nginx 标签的两个 Pod)。

现在我们再来创建一个普通的 Pod,观察下该 Pod 中的环境变量是否包含上面的 nginx-service 的服务信息:(test-pod.yaml)

[root@node01 ~]# vim test-pod.yaml

[root@node01 ~]# cat test-pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: test-pod

spec:

containers:

- name: test-service-pod

image: busybox

command: ["/bin/sh", "-c", "env"]

然后创建该测试的 Pod:

[root@node01 ~]# kubectl create -f test-pod.yaml

pod "test-pod" created

等 Pod 创建完成后,我们查看日志信息:

[root@node01 ~]# kubectl logs test-pod

KUBERNETES_SERVICE_PORT=443

KUBERNETES_PORT=tcp://10.96.0.1:443

HOSTNAME=test-pod

SHLVL=1

HOME=/root

NGINX_SERVICE_PORT_5000_TCP_ADDR=10.100.13.170

NGINX_SERVICE_PORT_5000_TCP_PORT=5000

NGINX_SERVICE_PORT_5000_TCP_PROTO=tcp

KUBERNETES_PORT_443_TCP_ADDR=10.96.0.1

PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin

NGINX_SERVICE_SERVICE_HOST=10.100.13.170

NGINX_SERVICE_PORT_5000_TCP=tcp://10.100.13.170:5000

KUBERNETES_PORT_443_TCP_PORT=443

KUBERNETES_PORT_443_TCP_PROTO=tcp

NGINX_SERVICE_SERVICE_PORT=5000

NGINX_SERVICE_PORT=tcp://10.100.13.170:5000

KUBERNETES_PORT_443_TCP=tcp://10.96.0.1:443

KUBERNETES_SERVICE_PORT_HTTPS=443

KUBERNETES_SERVICE_HOST=10.96.0.1

PWD=/

我们可以看到打印了很多环境变量处理,其中就包括我们刚刚创建的 nginx-service 这个服务,有 HOST、PORT、PROTO、ADDR 等,也包括其他已经存在的 Service 的环境变量,现在如果我们需要在这个 Pod 里面访问 nginx-service 的服务,我们是不是可以直接通过 NGINX_SERVICE_SERVICE_HOST 和 NGINX_SERVICE_SERVICE_PORT 就可以了,但是我们也知道如果这个 Pod 启动起来的时候如果 nginx-service 服务还没启动起来,在环境变量中我们是无法获取到这些信息的,当然我们可以通过 initContainer 之类的方法来确保 nginx-service 启动后再启动 Pod,但是这种方法毕竟增加了 Pod 启动的复杂性,所以这不是最优的方法。

1.4 KubeDNS

由于上面环境变量这种方式的局限性,我们需要一种更加智能的方案,其实我们可以自己想学一种比较理想的方案:那就是可以直接使用 Service 的名称,因为 Service 的名称不会变化,我们不需要去关心分配的 ClusterIP 的地址,因为这个地址并不是固定不变的,所以如果我们直接使用 Service 的名字,然后对应的 ClusterIP 地址的转换能够自动完成就很好了。我们知道名字和 IP 直接的转换是不是和我们平时访问的网站非常类似啊?他们之间的转换功能通过 DNS 就可以解决了,同样的,Kubernetes 也提供了 DNS 的方案来解决上面的服务发现的问题。

1.5 kubedns 介绍

DNS 服务不是一个独立的系统服务,而是作为一种 addon 插件而存在,也就是说不是 Kubernetes 集群必须安装的,当然我们强烈推荐安装,可以将这个插件看成是一种运行在 Kubernetes 集群上的一直比较特殊的应用,现在比较推荐的两个插件:kube-dns 和 CoreDNS。我们在前面使用 kubeadm 搭建集群的时候直接安装的 kube-dns 插件,如果不记得了可以回头去看一看。当然如果我们想使用 CoreDNS 的话也很方便,只需要执行下面的命令即可:

$ kubeadm init --feature-gates=CoreDNS=true

Kubernetes DNS pod 中包括 3 个容器,可以通过 kubectl 工具查看:

$ kubectl get pods -n kube-system

NAME READY STATUS RESTARTS AGE

...

kube-dns-5868f69869-zp5kz 3/3 Running 0 19d

...

READY 一栏可以看到是 3/3,用如下命令可以很清楚的看到 kube-dns 包含的3个容器:

$ kubectl describe pod kube-dns-5868f69869-zp5kz -n kube-system

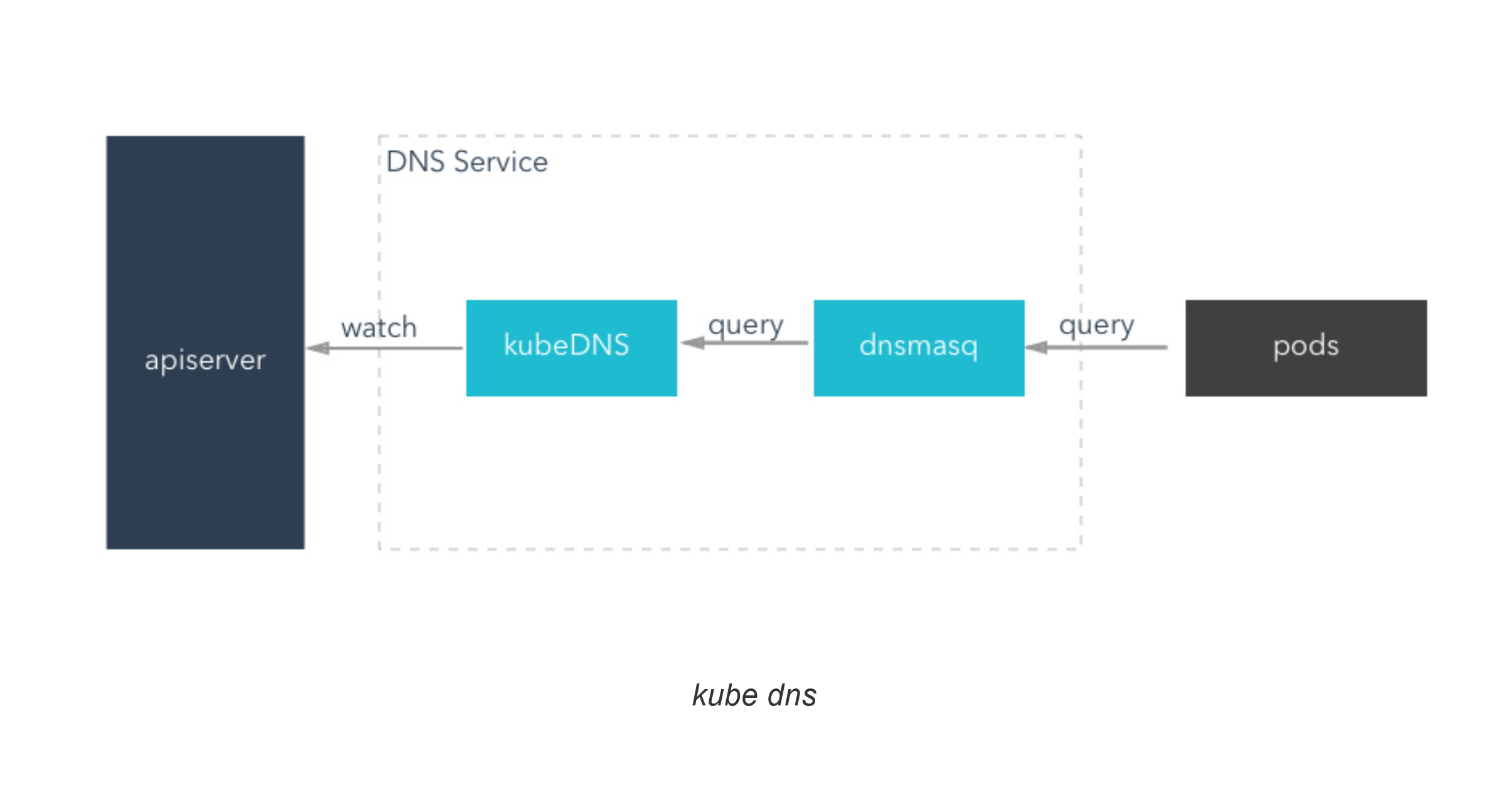

kube-dns、dnsmasq-nanny、sidecar 这3个容器分别实现了什么功能?

- kubedns: kubedns 基于 SkyDNS 库,通过 apiserver 监听 Service 和 Endpoints 的变更事件同时也同步到本地 Cache,实现了一个实时的 Kubernetes 集群内 Service 和 Pod 的 DNS服务发现

- dnsmasq: dsnmasq 容器则实现了 DNS 的缓存功能(在内存中预留一块默认大小为 1G 的地方,保存当前最常用的 DNS 查询记录,如果缓存中没有要查找的记录,它会到 kubedns 中查询,并把结果缓存起来),通过监听 ConfigMap 来动态生成配置

- sider: sidecar 容器实现了可配置的 DNS 探测,并采集对应的监控指标暴露出来供 prometheus 使用

1.6 对 Pod 的影响

DNS Pod 具有静态 IP 并作为 Kubernetes 服务暴露出来。该静态 IP 被分配后,kubelet 会将使用 --cluster-dns = <dns-service-ip>参数配置的 DNS 传递给每个容器。DNS 名称也需要域名,本地域可以使用参数--cluster-domain = <default-local-domain>在 kubelet 中配置。

我们说 dnsmasq 容器通过监听 ConfigMap 来动态生成配置,可以自定义存根域和上下游域名服务器。

例如,下面的 ConfigMap 建立了一个 DNS 配置,它具有一个单独的存根域和两个上游域名服务器:

apiVersion: v1

kind: ConfigMap

metadata:

name: kube-dns

namespace: kube-system

data:

stubDomains: |

{"acme.local": ["1.2.3.4"]}

upstreamNameservers: |

["8.8.8.8", "8.8.4.4"]

按如上说明,具有.acme.local后缀的 DNS 请求被转发到 DNS 1.2.3.4。Google 公共 DNS 服务器 为上游查询提供服务。下表描述了具有特定域名的查询如何映射到它们的目标 DNS 服务器:

| 域名 | 响应查询的服务器 |

|---|---|

| kubernetes.default.svc.cluster.local | kube-dns |

| foo.acme.local | 自定义 DNS (1.2.3.4) |

| widget.com | 上游 DNS (8.8.8.8, 8.8.4.4,其中之一) |

另外我们还可以为每个 Pod 设置 DNS 策略。 当前 Kubernetes 支持两种 Pod 特定的 DNS 策略:“Default” 和 “ClusterFirst”。 可以通过 dnsPolicy 标志来指定这些策略。

注意:Default 不是默认的 DNS 策略。如果没有显式地指定dnsPolicy,将会使用 ClusterFirst

- 如果 dnsPolicy 被设置为 “Default”,则名字解析配置会继承自 Pod 运行所在的节点。自定义上游域名服务器和存根域不能够与这个策略一起使用

- 如果 dnsPolicy 被设置为 “ClusterFirst”,这就要依赖于是否配置了存根域和上游 DNS 服务器

- 未进行自定义配置:没有匹配上配置的集群域名后缀的任何请求,例如 “www.kubernetes.io”,将会被转发到继承自节点的上游域名服务器。

- 进行自定义配置:如果配置了存根域和上游 DNS 服务器(类似于 前面示例 配置的内容),DNS 查询将基于下面的流程对请求进行路由:

- 查询首先被发送到 kube-dns 中的 DNS 缓存层。

- 从缓存层,检查请求的后缀,并根据下面的情况转发到对应的 DNS 上:

- 具有集群后缀的名字(例如 “.cluster.local”):请求被发送到 kubedns。

- 具有存根域后缀的名字(例如 “.acme.local”):请求被发送到配置的自定义 DNS 解析器(例如:监听在 1.2.3.4)。

- 未能匹配上后缀的名字(例如 “widget.com”):请求被转发到上游 DNS(例如:Google 公共 DNS 服务器,8.8.8.8 和 8.8.4.4)。 kube dns

1.7 域名格式

我们前面说了如果我们建立的 Service 如果支持域名形式进行解析,就可以解决我们的服务发现的功能,那么利用 kubedns 可以将 Service 生成怎样的 DNS 记录呢?

- 普通的 Service:会生成 servicename.namespace.svc.cluster.local 的域名,会解析到 Service 对应的 ClusterIP 上,在 Pod 之间的调用可以简写成 servicename.namespace,如果处于同一个命名空间下面,甚至可以只写成 servicename 即可访问

- Headless Service:无头服务,就是把 clusterIP 设置为 None 的,会被解析为指定 Pod 的 IP 列表,同样还可以通过 podname.servicename.namespace.svc.cluster.local 访问到具体的某一个 Pod。

CoreDNS 实现的功能和 KubeDNS 是一致的,不过 CoreDNS 的所有功能都集成在了同一个容器中,在最新版的1.11.0版本中官方已经推荐使用 CoreDNS了,大家也可以安装 CoreDNS 来代替 KubeDNS,其他使用方法都是一致的:https://coredns.io/

1.8 测试

现在我们来使用一个简单 Pod 来测试下 Service 的域名访问:

$ kubectl run --rm -i --tty test-dns --image=busybox /bin/sh

If you don't see a command prompt, try pressing enter.

/ # cat /etc/resolv.conf

nameserver 10.96.0.10

search default.svc.cluster.local svc.cluster.local cluster.local

options ndots:5

/ #

我们进入到 Pod 中,查看/etc/resolv.conf中的内容,可以看到 nameserver 的地址10.96.0.10,该 IP 地址即是在安装 kubedns 插件的时候集群分配的一个固定的静态 IP 地址,我们可以通过下面的命令进行查看:

$ kubectl get svc kube-dns -n kube-system

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kube-dns ClusterIP 10.96.0.10 <none> 53/UDP,53/TCP 62d

也就是说我们这个 Pod 现在默认的 nameserver 就是 kubedns 的地址,现在我们来访问下前面我们创建的 nginx-service 服务:

/ # wget -q -O- nginx-service.default.svc.cluster.local

可以看到上面我们使用 wget 命令去访问 nginx-service 服务的域名的时候被 hang 住了,没有得到期望的结果,这是因为上面我们建立 Service 的时候暴露的端口是 5000:

/ # wget -q -O- nginx-service.default.svc.cluster.local:5000

<!DOCTYPE html>

<html>

<head>

<title>Welcome to nginx!</title>

<style>

body {

width: 35em;

margin: 0 auto;

font-family: Tahoma, Verdana, Arial, sans-serif;

}

</style>

</head>

<body>

<h1>Welcome to nginx!</h1>

<p>If you see this page, the nginx web server is successfully installed and

working. Further configuration is required.</p>

<p>For online documentation and support please refer to

<a href="http://nginx.org/">nginx.org</a>.<br/>

Commercial support is available at

<a href="http://nginx.com/">nginx.com</a>.</p>

<p><em>Thank you for using nginx.</em></p>

</body>

</html>

加上 5000 端口,就正常访问到服务,再试一试访问:nginx-service.default.svc、nginx-service.default、nginx-service,不出意外这些域名都可以正常访问到期望的结果。

到这里我们是不是就实现了在集群内部通过 Service 的域名形式进行互相通信了,大家下去试着看看访问不同 namespace 下面的服务呢?

2. ingress

2.1 外部服务发现之 ingress

上节课我们学习了在 Kubernetes 集群内部使用 kube-dns 实现服务发现的功能,那么我们部署在 Kubernetes 集群中的应用如何暴露给外部的用户使用呢?我们知道前面我们使用 NodePort 和 LoadBlancer 类型的 Service 可以实现把应用暴露给外部用户使用,除此之外,Kubernetes 还为我们提供了一个非常重要的资源对象可以用来暴露服务给外部用户,那就是 ingress。对于小规模的应用我们使用 NodePort 或许能够满足我们的需求,但是当你的应用越来越多的时候,你就会发现对于 NodePort 的管理就非常麻烦了,这个时候使用 ingress 就非常方便了,可以避免管理大量的 Port。

2.2 介绍

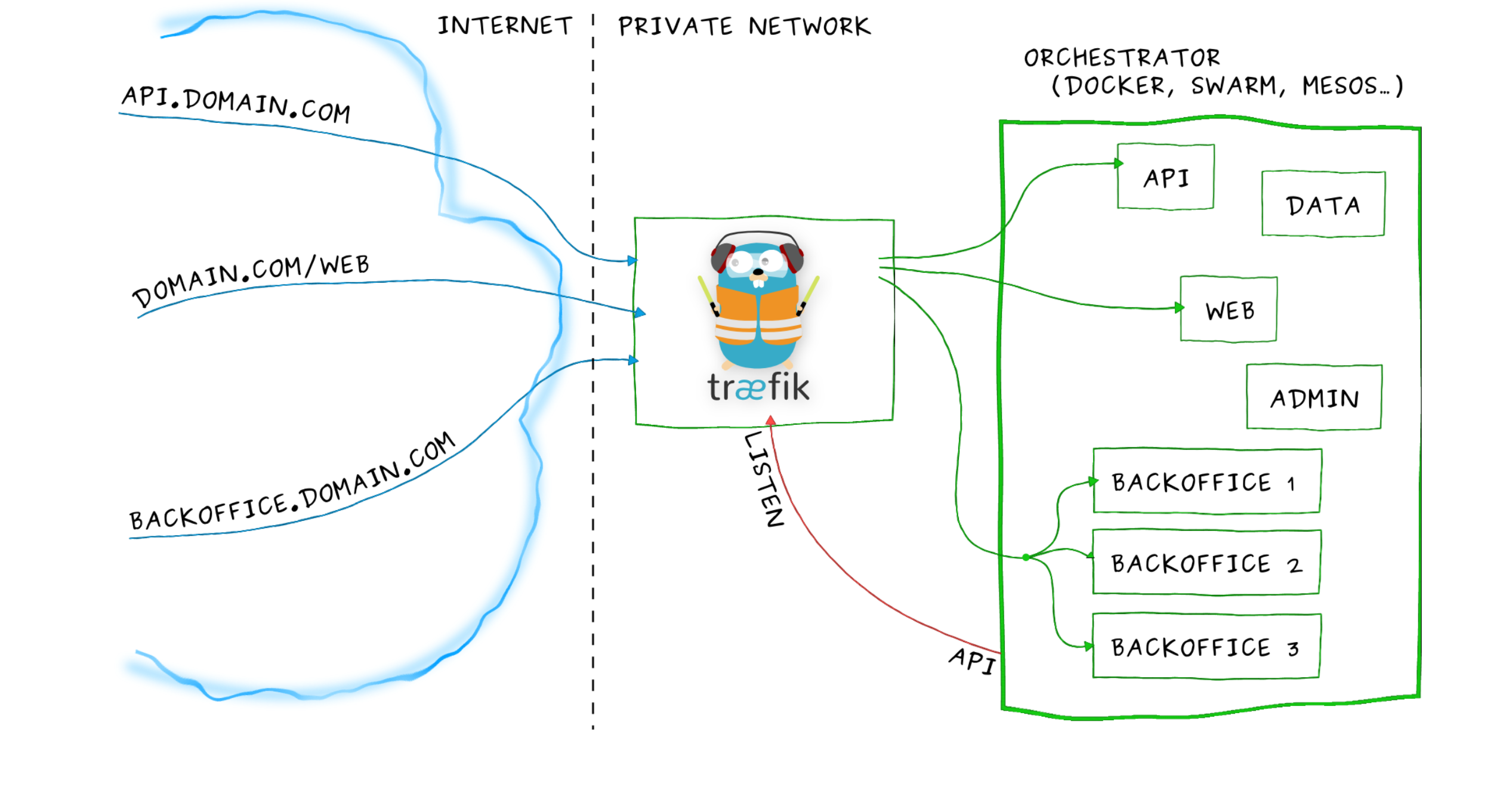

Ingress其实就是从 kuberenets 集群外部访问集群的一个入口,将外部的请求转发到集群内不同的 Service 上,其实就相当于 nginx、haproxy 等负载均衡代理服务器,有的同学可能觉得我们直接使用 nginx 就实现了,但是只使用 nginx 这种方式有很大缺陷,每次有新服务加入的时候怎么改 Nginx 配置?不可能让我们去手动更改或者滚动更新前端的 Nginx Pod 吧?那我们再加上一个服务发现的工具比如 consul 如何?貌似是可以,对吧?而且在之前单独使用 docker 的时候,这种方式已经使用得很普遍了,Ingress 实际上就是这样实现的,只是服务发现的功能自己实现了,不需要使用第三方的服务了,然后再加上一个域名规则定义,路由信息的刷新需要一个靠 Ingress controller 来提供。

Ingress controller 可以理解为一个监听器,通过不断地与 kube-apiserver 打交道,实时的感知后端 service、pod 的变化,当得到这些变化信息后,Ingress controller 再结合 Ingress 的配置,更新反向代理负载均衡器,达到服务发现的作用。其实这点和服务发现工具 consul consul-template 非常类似。

现在可以供大家使用的 Ingress controller 有很多,比如 traefik、nginx-controller、Kubernetes Ingress Controller for Kong、HAProxy Ingress controller,当然你也可以自己实现一个 Ingress Controller,现在普遍用得较多的是 traefik 和 nginx-controller,traefik 的性能较 nginx-controller 差,但是配置使用要简单许多,我们这里会以更简单的 traefik 为例给大家介绍 ingress 的使用。

2.3 Traefik

Traefik 是一款开源的反向代理与负载均衡工具。它最大的优点是能够与常见的微服务系统直接整合,可以实现自动化动态配置。目前支持 Docker、Swarm、Mesos/Marathon、 Mesos、Kubernetes、Consul、Etcd、Zookeeper、BoltDB、Rest API 等等后端模型。

要使用 traefik,我们同样需要部署 traefik 的 Pod,由于我们演示的集群中只有 master 节点有外网网卡,所以我们这里只有 master 这一个边缘节点,我们将 traefik 部署到该节点上即可。

首先,为安全起见我们这里使用 RBAC 安全认证方式:(rbac.yaml):

[root@node01 ~]# vim rbac.yaml

[root@node01 ~]# cat rbac.yaml

---

apiVersion: v1

kind: ServiceAccount

metadata:

name: traefik-ingress-controller

namespace: kube-system

---

kind: ClusterRole

apiVersion: rbac.authorization.k8s.io/v1beta1

metadata:

name: traefik-ingress-controller

rules:

- apiGroups:

- ""

resources:

- services

- endpoints

- secrets

verbs:

- get

- list

- watch

- apiGroups:

- extensions

resources:

- ingresses

verbs:

- get

- list

- watch

---

kind: ClusterRoleBinding

apiVersion: rbac.authorization.k8s.io/v1beta1

metadata:

name: traefik-ingress-controller

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: traefik-ingress-controller

subjects:

- kind: ServiceAccount

name: traefik-ingress-controller

namespace: kube-system

直接在集群中创建即可:

[root@node01 ~]# kubectl create -f rbac.yaml

serviceaccount "traefik-ingress-controller" created

clusterrole.rbac.authorization.k8s.io "traefik-ingress-controller" created

clusterrolebinding.rbac.authorization.k8s.io "traefik-ingress-controller" created

然后使用 Deployment 来管理 Pod,直接使用官方的 traefik 镜像部署即可(traefik.yaml)

[root@node01 ~]# vim traefik.yaml

[root@node01 ~]# cat traefik.yaml

---

kind: Deployment

apiVersion: apps/v1

metadata:

name: traefik-ingress-controller

namespace: kube-system

labels:

k8s-app: traefik-ingress-lb

spec:

replicas: 1

selector:

matchLabels:

k8s-app: traefik-ingress-lb

template:

metadata:

labels:

k8s-app: traefik-ingress-lb

name: traefik-ingress-lb

spec:

serviceAccountName: traefik-ingress-controller

terminationGracePeriodSeconds: 60

tolerations:

- operator: "Exists"

nodeSelector:

kubernetes.io/hostname: master

containers:

- image: traefik:v1.7.17

name: traefik-ingress-lb

ports:

- name: http

containerPort: 80

- name: admin

containerPort: 8080

args:

- --api

- --kubernetes

- --logLevel=INFO

---

kind: Service

apiVersion: v1

metadata:

name: traefik-ingress-service

namespace: kube-system

spec:

selector:

k8s-app: traefik-ingress-lb

ports:

- protocol: TCP

port: 80

name: web

- protocol: TCP

port: 8080

name: admin

type: NodePort

需要注意的是最近 Traefik 发布了 2.0 版本,导致默认的 taefik 镜像升级到了最新版本,而 2.x 版本和 1.x 版本变化非常大,而且配置不兼容,所以这里使用的使用注意使用一个具体的镜像 tag,比如 traefik:v1.7.17

直接创建上面的资源对象即可:

[root@node01 ~]# kubectl create -f traefik.yaml

deployment.apps "traefik-ingress-controller" created

service "traefik-ingress-service" created

要注意上面 yaml 文件:

tolerations:

- operator: "Exists"

nodeSelector:

kubernetes.io/hostname: master

由于我们这里的特殊性,只有 master 节点有外网访问权限,所以我们使用nodeSelector标签将traefik的固定调度到master这个节点上,那么上面的tolerations是干什么的呢?这个是因为我们集群使用的 kubeadm 安装的,master 节点默认是不能被普通应用调度的,要被调度的话就需要添加这里的 tolerations 属性,当然如果你的集群和我们的不太一样,直接去掉这里的调度策略就行。

nodeSelector 和 tolerations 都属于 Pod 的调度策略,在后面的课程中会为大家讲解。

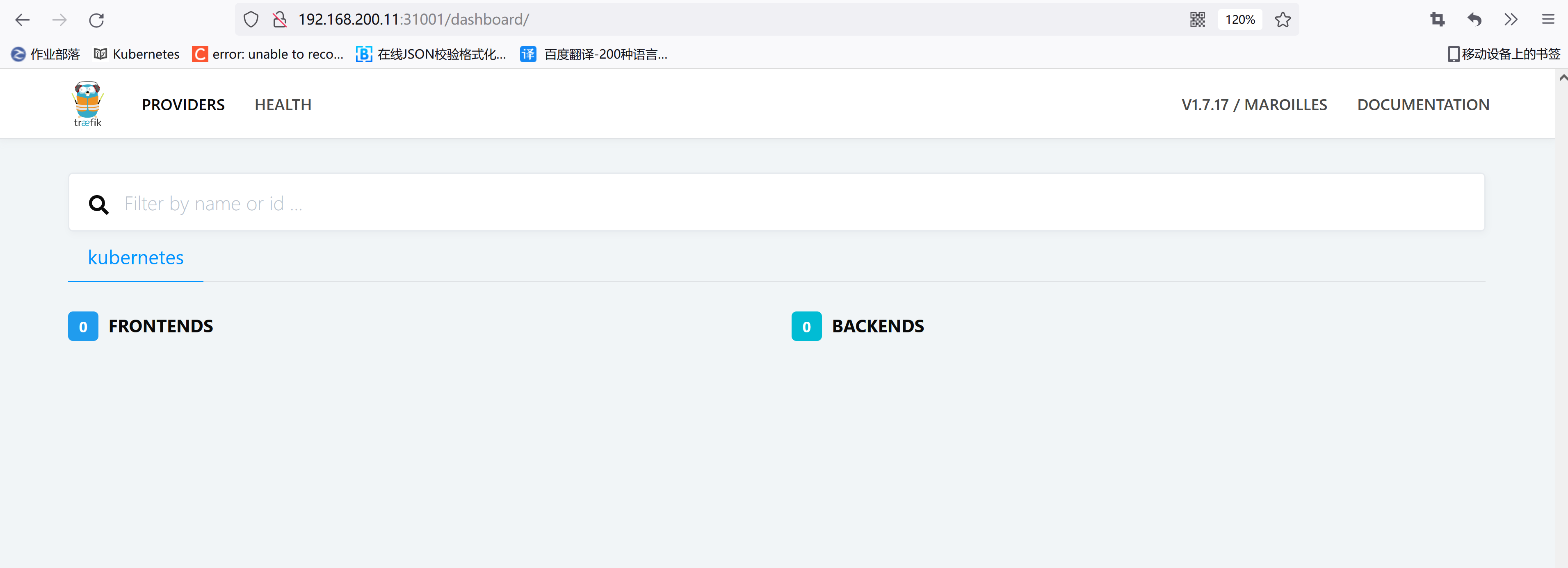

traefik 还提供了一个 web ui 工具,就是上面的 8080 端口对应的服务,为了能够访问到该服务,我们这里将服务设置成的 NodePort:

[root@node01 ~]# kubectl get pods -n kube-system -l k8s-app=traefik-ingress-lb -o wide

NAME READY STATUS RESTARTS AGE IP NODE

traefik-ingress-controller-9b84c4fbf-d2kw8 1/1 Running 0 1m 10.244.0.3 master

[root@node01 ~]# kubectl get svc -n kube-system

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

...

traefik-ingress-service NodePort 10.100.13.170 <none> 80:31941/TCP,8080:31001/TCP 1m

...

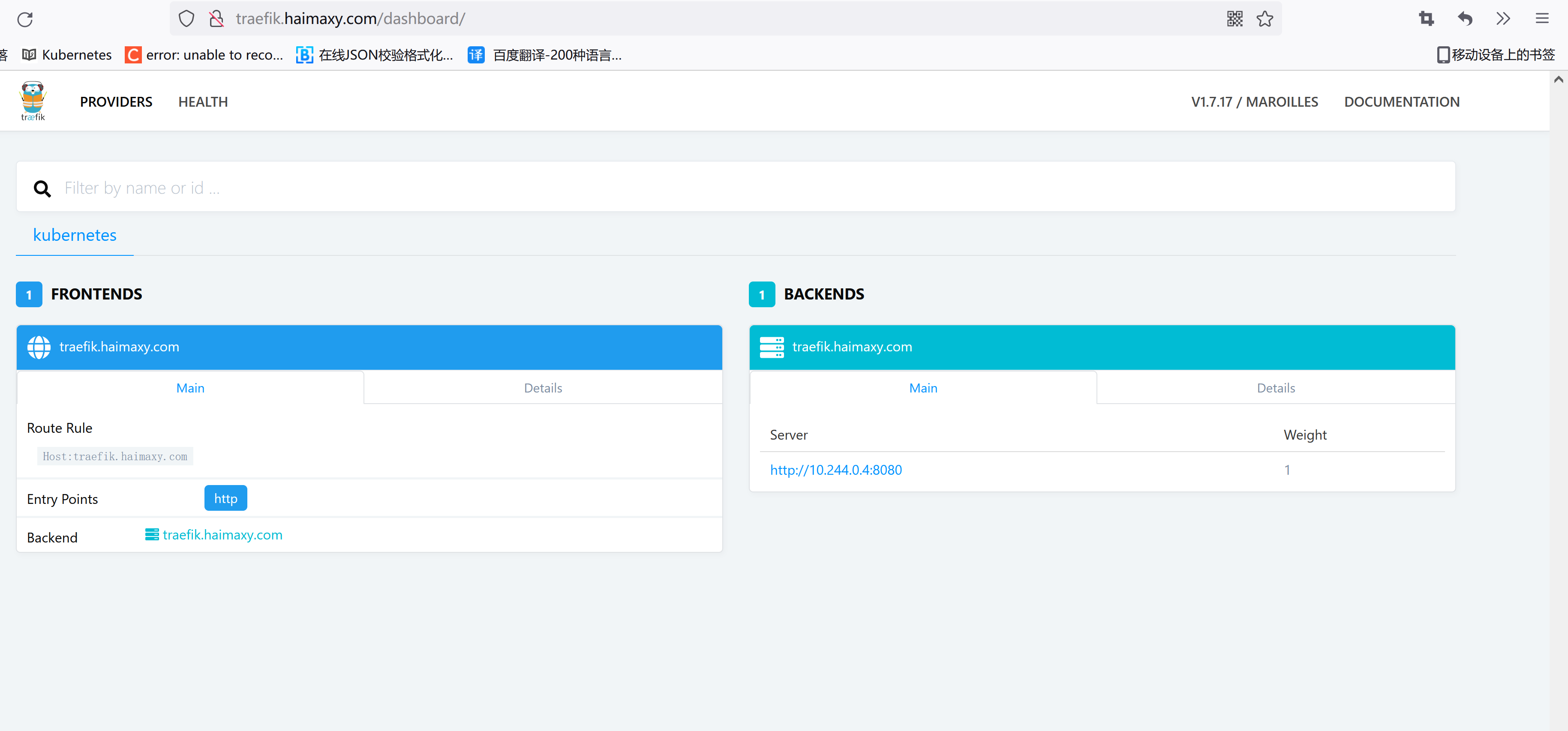

现在在浏览器中输入 http://192.168.200.11:31001 就可以访问到 traefik 的 dashboard 了:

2.4 Ingress 对象

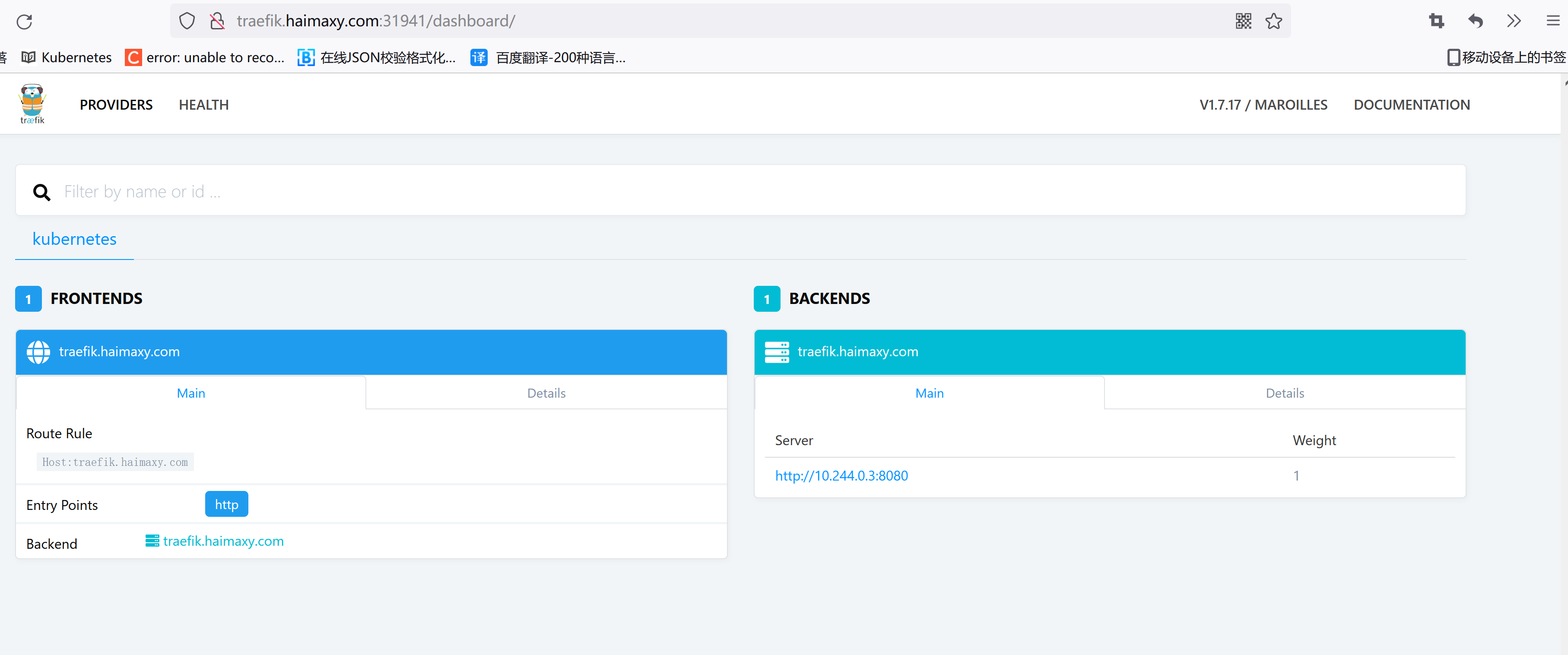

现在我们是通过 NodePort 来访问 traefik 的 Dashboard 的,那怎样通过 ingress 来访问呢? 首先,需要创建一个 ingress 对象:(ingress.yaml)

[root@node01 ~]# vim ingress.yaml

[root@node01 ~]# cat ingress.yaml

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: traefik-web-ui

namespace: kube-system

annotations:

kubernetes.io/ingress.class: traefik

spec:

rules:

- host: traefik.haimaxy.com

http:

paths:

- backend:

serviceName: traefik-ingress-service

servicePort: 8080

然后为 traefik dashboard 创建对应的 ingress 对象:

[root@node01 ~]# kubectl create -f ingress.yaml

ingress.extensions "traefik-web-ui" created

要注意上面的 ingress 对象的规则,特别是 rules 区域,我们这里是要为 traefik 的 dashboard 建立一个 ingress 对象,所以这里的 serviceName 对应的是上面我们创建的 traefik-ingress-service,端口也要注意对应 8080 端口,为了避免端口更改,这里的 servicePort 的值也可以替换成上面定义的 port 的名字:

创建完成后,我们应该怎么来测试呢?

第一步,在本地的/etc/hosts里面添加上 traefik.haimaxy.com 与 master 节点外网 IP 的映射关系

第二步,在浏览器中访问:http://traefik.haimaxy.com 我们会发现并没有得到我们期望的 dashboard 界面,这是因为我们上面部署 traefik 的时候使用的是 NodePort 这种 Service 对象,所以我们只能通过上面的 31941端口访问到我们的目标对象:http://traefik.haimaxy.com:31941

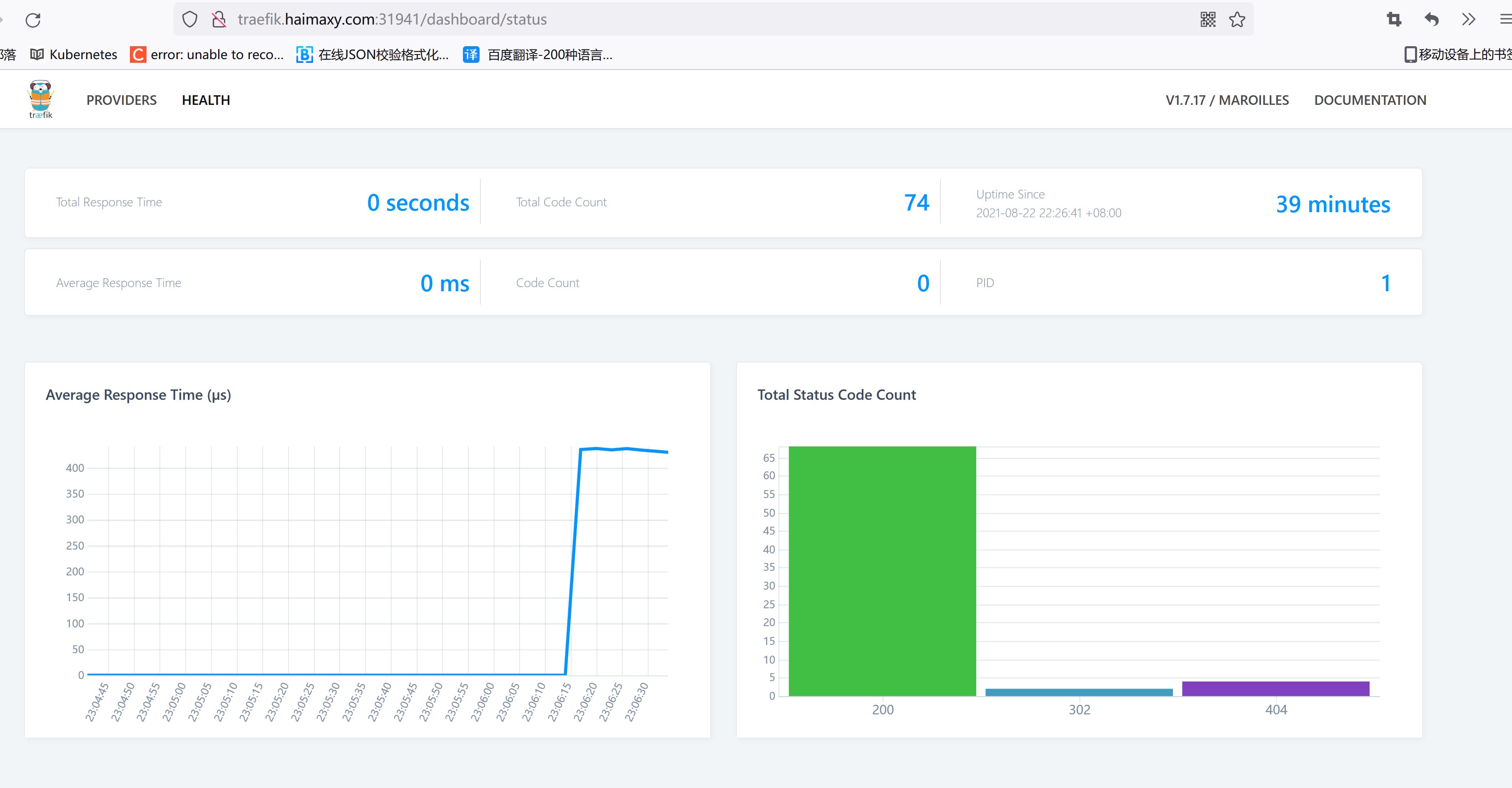

加上端口后我们发现可以访问到 dashboard 了,而且在 dashboard 当中多了一条记录,正是上面我们创建的 ingress 对象的数据,我们还可以切换到 HEALTH 界面中,可以查看当前 traefik 代理的服务的整体的健康状态 traefik health

第三步,上面我们可以通过自定义域名加上端口可以访问我们的服务了,但是我们平时服务别人的服务是不是都是直接用的域名啊,http 或者 https 的,几乎很少有在域名后面加上端口访问的吧?为什么?太麻烦啊,端口也记不住,要解决这个问题,怎么办,我们只需要把我们上面的 traefik 的核心应用的端口隐射到 master 节点上的 80 端口,是不是就可以了,因为 http 默认就是访问 80 端口,但是我们在 Service 里面是添加的一个 NodePort 类型的服务,没办法映射 80 端口,怎么办?这里就可以直接在 Pod 中指定一个 hostPort 即可,更改上面的 traefik.yaml 文件中的容器端口:

containers:

- image: traefik

name: traefik-ingress-lb

ports:

- name: http

containerPort: 80

hostPort: 80 #添加此行

- name: admin

containerPort: 8080

添加以后hostPort: 80,然后更新应用:

[root@node01 ~]# kubectl apply -f traefik.yaml

Warning: kubectl apply should be used on resource created by either kubectl create --save-config or kubectl apply

deployment.apps "traefik-ingress-controller" configured

Warning: kubectl apply should be used on resource created by either kubectl create --save-config or kubectl apply

service "traefik-ingress-service" configured

更新完成后,这个时候我们在浏览器中直接使用域名方法测试下:http://traefik.haimaxy.com

第四步,正常来说,我们如果有自己的域名,我们可以将我们的域名添加一条 DNS 记录,解析到 master 的外网 IP 上面,这样任何人都可以通过域名来访问我的暴露的服务了。

如果你有多个边缘节点的话,可以在每个边缘节点上部署一个 ingress-controller 服务,然后在边缘节点前面挂一个负载均衡器,比如 nginx,将所有的边缘节点均作为这个负载均衡器的后端,这样就可以实现 ingress-controller 的高可用和负载均衡了。

到这里我们就通过 ingress 对象对外成功暴露了一个服务,下节课我们再来详细了解 traefik 的更多用法。

3. ingress tls和path的使用

3.1 ingress tls

上节课给大家展示了 traefik 的安装使用以及简单的 ingress 的配置方法,这节课我们来学习一下 ingress tls 以及 path 路径在 ingress 对象中的使用方法。

3.2 TLS 认证

在现在大部分场景下面我们都会使用 https 来访问我们的服务,这节课我们将使用一个自签名的证书,当然你有在一些正规机构购买的 CA 证书是最好的,这样任何人访问你的服务的时候都是受浏览器信任的证书。使用下面的 openssl 命令生成 CA 证书:

#一键回车

[root@node01 ~]# openssl req -newkey rsa:2048 -nodes -keyout tls.key -x509 -days 365 -out tls.crt

Generating a 2048 bit RSA private key

.....................................+++

.............................................................................+++

writing new private key to 'tls.key'

-----

You are about to be asked to enter information that will be incorporated

into your certificate request.

What you are about to enter is what is called a Distinguished Name or a DN.

There are quite a few fields but you can leave some blank

For some fields there will be a default value,

If you enter '.', the field will be left blank.

-----

Country Name (2 letter code) [XX]:

State or Province Name (full name) []:

Locality Name (eg, city) [Default City]:

Organization Name (eg, company) [Default Company Ltd]:

Organizational Unit Name (eg, section) []:

Common Name (eg, your name or your server's hostname) []:

现在我们有了证书,我们可以使用 kubectl 创建一个 secret 对象来存储上面的证书:

[root@node01 ~]# kubectl create secret generic traefik-cert --from-file=tls.crt --from-file=tls.key -n kube-system

secret "traefik-cert" created

3.3 配置 Traefik

[root@node01 ~]# mkdir /ssl

[root@node01 ~]# cp -a tls.* /ssl/

[root@node01 ~]# ls /ssl/

tls.crt tls.key

前面我们使用的是 Traefik 的默认配置,现在我们来配置 Traefik,让其支持 https:

[root@node01 ~]# vim traefik.toml

[root@node01 ~]# cat traefik.toml

defaultEntryPoints = ["http", "https"]

[entryPoints]

[entryPoints.http]

address = ":80"

[entryPoints.http.redirect]

entryPoint = "https"

[entryPoints.https]

address = ":443"

[entryPoints.https.tls]

[[entryPoints.https.tls.certificates]]

CertFile = "/ssl/tls.crt"

KeyFile = "/ssl/tls.key"

[root@node01 ~]# mkdir /config

[root@node01 ~]# cp -a traefik.toml /config/

上面的配置文件中我们配置了 http 和 https 两个入口,并且配置了将 http 服务强制跳转到 https 服务,这样我们所有通过 traefik 进来的服务都是 https 的,要访问 https 服务,当然就得配置对应的证书了,可以看到我们指定了 CertFile 和 KeyFile 两个文件,由于 traefik pod 中并没有这两个证书,所以我们要想办法将上面生成的证书挂载到 Pod 中去,是不是前面我们讲解过 secret 对象可以通过 volume 形式挂载到 Pod 中?至于上面的 traefik.toml 这个文件我们要怎么让 traefik pod 能够访问到呢?还记得我们前面讲过的 ConfigMap 吗?我们是不是可以将上面的 traefik.toml 配置文件通过一个 ConfigMap 对象挂载到 traefik pod 中去:

[root@node01 ~]# kubectl create configmap traefik-conf --from-file=traefik.toml -n kube-system

configmap "traefik-conf" created

现在就可以更改下上节课的 traefik pod 的 yaml 文件了:

[root@node01 ~]# vim traefik.yaml

[root@node01 ~]# cat traefik.yaml

kind: Deployment

apiVersion: apps/v1

metadata:

name: traefik-ingress-controller

namespace: kube-system

labels:

k8s-app: traefik-ingress-lb

spec:

replicas: 1

selector:

matchLabels:

k8s-app: traefik-ingress-lb

template:

metadata:

labels:

k8s-app: traefik-ingress-lb

name: traefik-ingress-lb

spec:

serviceAccountName: traefik-ingress-controller

terminationGracePeriodSeconds: 60

volumes:

- name: ssl

secret:

secretName: traefik-cert

- name: config

configMap:

name: traefik-conf

tolerations:

- operator: "Exists"

nodeSelector:

kubernetes.io/hostname: master

containers:

- image: traefik

name: traefik-ingress-lb

volumeMounts:

- mountPath: "/ssl"

name: "ssl"

- mountPath: "/config"

name: "config"

ports:

- name: http

containerPort: 80

hostPort: 80

- name: https

containerPort: 443

hostPort: 443

- name: admin

containerPort: 8080

args:

- --configfile=/config/traefik.toml

- --api

- --kubernetes

- --logLevel=INFO

和之前的比较,我们增加了 443 的端口配置,以及启动参数中通过 configfile 指定了 traefik.toml 配置文件,这个配置文件是通过 volume 挂载进来的。然后更新下 traefik pod:

[root@node01 ~]# kubectl apply -f traefik.yaml

deployment.apps "traefik-ingress-controller" configured

[root@node01 ~]# kubectl log -f traefik-ingress-controller-7775c7bf4f-9cdm8 -n kube-system

log is DEPRECATED and will be removed in a future version. Use logs instead.

time="2021-09-05T14:57:50Z" level=info msg="Using TOML configuration file /config/traefik.toml"

time="2021-09-05T14:57:50Z" level=info msg="No tls.defaultCertificate given for https: using the first item in tls.certificates as a fallback."

time="2021-09-05T14:57:50Z" level=info msg="Traefik version v1.7.17 built on 2019-09-23_06:22:08PM"

time="2021-09-05T14:57:50Z" level=info msg="\nStats collection is disabled.\nHelp us improve Traefik by turning this feature on :)\nMore details on: https://docs.traefik.io/v1.7/basics/#collected-data\n"

time="2021-09-05T14:57:50Z" level=info msg="Preparing server traefik &{Address::8080 TLS:<nil> Redirect:<nil> Auth:<nil> WhitelistSourceRange:[] WhiteList:<nil> Compress:false ProxyProtocol:<nil> ForwardedHeaders:0xc000991a80} with readTimeout=0s writeTimeout=0s idleTimeout=3m0s"

time="2021-09-05T14:57:50Z" level=info msg="Preparing server https &{Address::443 TLS:0xc00066c120 Redirect:<nil> Auth:<nil> WhitelistSourceRange:[] WhiteList:<nil> Compress:false ProxyProtocol:<nil> ForwardedHeaders:0xc000991a20} with readTimeout=0s writeTimeout=0s idleTimeout=3m0s"

time="2021-09-05T14:57:50Z" level=info msg="Preparing server http &{Address::80 TLS:<nil> Redirect:0xc0007c89c0 Auth:<nil> WhitelistSourceRange:[] WhiteList:<nil> Compress:false ProxyProtocol:<nil> ForwardedHeaders:0xc000991a40} with readTimeout=0s writeTimeout=0s idleTimeout=3m0s"

time="2021-09-05T14:57:50Z" level=info msg="Starting provider configuration.ProviderAggregator {}"

time="2021-09-05T14:57:50Z" level=info msg="Starting server on :80"

time="2021-09-05T14:57:50Z" level=info msg="Starting server on :443"

time="2021-09-05T14:57:50Z" level=info msg="Starting server on :8080"

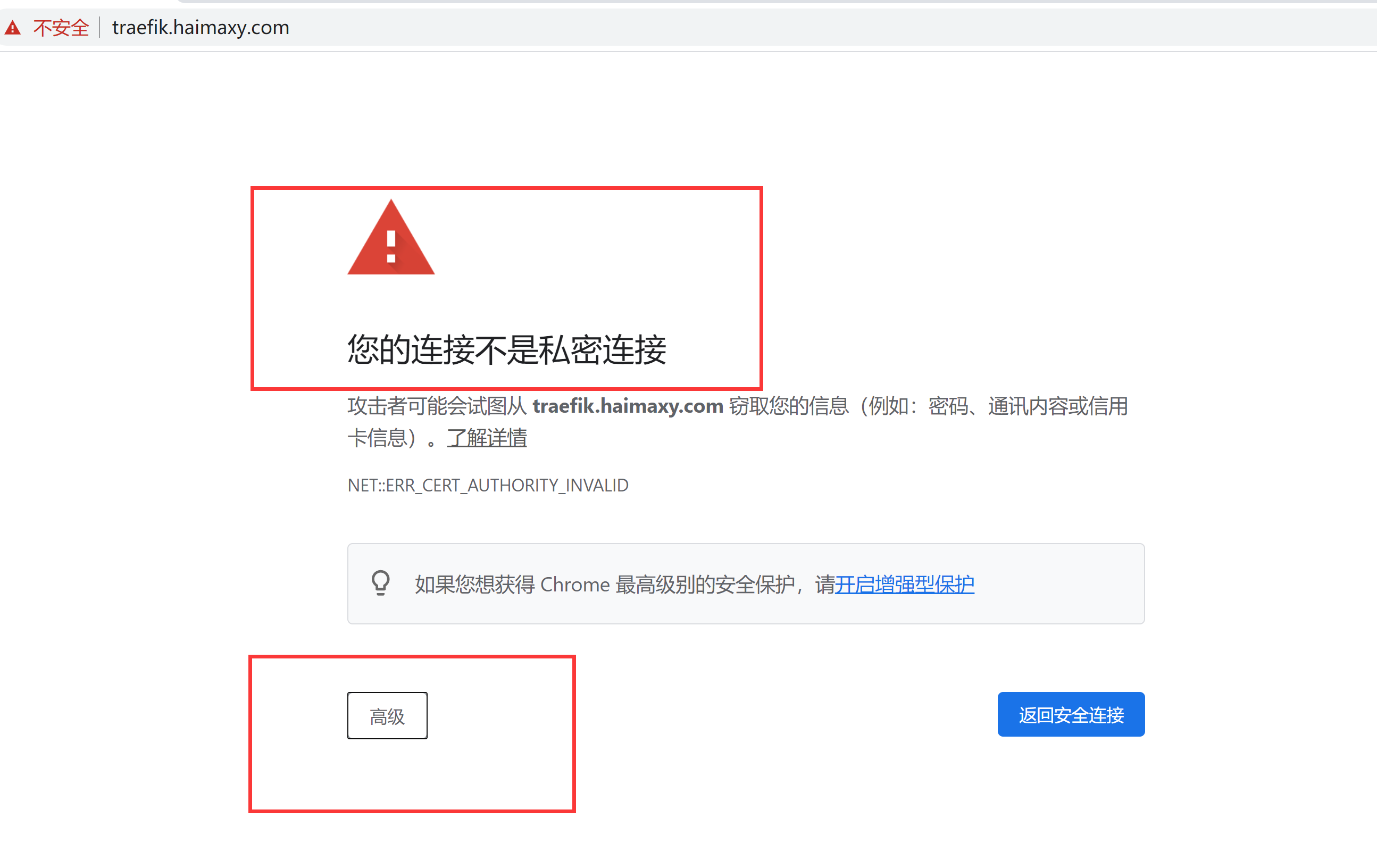

更新完成后我们查看 traefik pod 的日志,如果出现类似于上面的一些日志信息,证明更新成功了。现在我们去访问 traefik 的 dashboard 会跳转到 https 的地址,并会提示证书相关的报警信息,这是因为我们的证书是我们自建的,并不受浏览器信任,如果你是正规机构购买的证书并不会出现改报警信息,你应该可以看到我们常见的绿色标志: https://traefik.haimaxy.com

点击下面的高级,我们可以强制让其跳转,这样我们就可以正常访问 traefik 的 dashboard 了。

备注:https://www.zybuluo.com/yangwenbo/note/1819695

3.4 配置 ingress

其实上面的 TLS 认证方式已经成功了,接下来我们通过一个实例来说明下 ingress 中 path 的用法,这里我们部署了3个简单的 web 服务,通过一个环境变量来标识当前运行的是哪个服务:(backend.yaml)

[root@node01 ~]# vim backend.yaml

[root@node01 ~]# cat backend.yaml

kind: Deployment

apiVersion: apps/v1

metadata:

name: svc1

spec:

replicas: 1

selector:

matchLabels:

app: svc1

template:

metadata:

labels:

app: svc1

spec:

containers:

- name: svc1

image: cnych/example-web-service

env:

- name: APP_SVC

value: svc1

ports:

- containerPort: 8080

protocol: TCP

---

kind: Deployment

apiVersion: apps/v1

metadata:

name: svc2

spec:

replicas: 1

selector:

matchLabels:

app: svc2

template:

metadata:

labels:

app: svc2

spec:

containers:

- name: svc2

image: cnych/example-web-service

env:

- name: APP_SVC

value: svc2

ports:

- containerPort: 8080

protocol: TCP

---

kind: Deployment

apiVersion: apps/v1

metadata:

name: svc3

spec:

replicas: 1

selector:

matchLabels:

app: svc3

template:

metadata:

labels:

app: svc3

spec:

containers:

- name: svc3

image: cnych/example-web-service

env:

- name: APP_SVC

value: svc3

ports:

- containerPort: 8080

protocol: TCP

---

kind: Service

apiVersion: v1

metadata:

labels:

app: svc1

name: svc1

spec:

type: ClusterIP

ports:

- port: 8080

name: http

selector:

app: svc1

---

kind: Service

apiVersion: v1

metadata:

labels:

app: svc2

name: svc2

spec:

type: ClusterIP

ports:

- port: 8080

name: http

selector:

app: svc2

---

kind: Service

apiVersion: v1

metadata:

labels:

app: svc3

name: svc3

spec:

type: ClusterIP

ports:

- port: 8080

name: http

selector:

app: svc3

可以看到上面我们定义了3个 Deployment,分别对应3个 Service:

[root@node01 ~]# kubectl create -f backend.yaml

deployment.apps "svc1" created

deployment.apps "svc2" created

deployment.apps "svc3" created

service "svc1" created

service "svc2" created

service "svc3" created

然后我们创建一个 ingress 对象来访问上面的3个服务:(example-ingress.yaml)

[root@node01 ~]# vim example-ingress.yaml

[root@node01 ~]# cat example-ingress.yaml

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: example-web-app

annotations:

kubernetes.io/ingress.class: "traefik"

spec:

rules:

- host: example.haimaxy.com

http:

paths:

- path: /s1

backend:

serviceName: svc1

servicePort: 8080

- path: /s2

backend:

serviceName: svc2

servicePort: 8080

- path: /

backend:

serviceName: svc3

servicePort: 8080

注意我们这里定义的 ingress 对象和之前有一个不同的地方是我们增加了 path 路径的定义,不指定的话默认是 '/',创建该 ingress 对象:

[root@node01 ~]# kubectl create -f example-ingress.yaml

ingress.extensions "example-web-app" created

[root@node01 ~]# kubectl get ingress

NAME HOSTS ADDRESS PORTS AGE

example-web-app example.haimaxy.com 80 11s

[root@node01 ~]# kubectl describe ingress example-web-app

Name: example-web-app

Namespace: default

Address:

Default backend: default-http-backend:80 (<none>)

Rules:

Host Path Backends

---- ---- --------

example.haimaxy.com

/s1 svc1:8080 (<none>)

/s2 svc2:8080 (<none>)

/ svc3:8080 (<none>)

Annotations:

kubernetes.io/ingress.class: traefik

Events: <none>

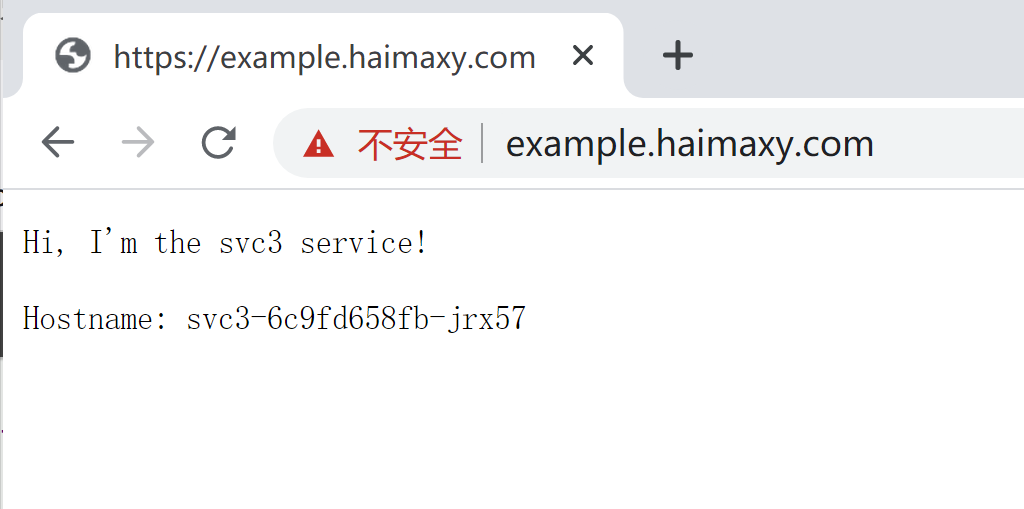

现在我们可以在本地 hosts 里面给域名 example.haimaxy.com 添加对应的 hosts 解析,然后就可以在浏览器中访问,可以看到默认也会跳转到 https 的页面:

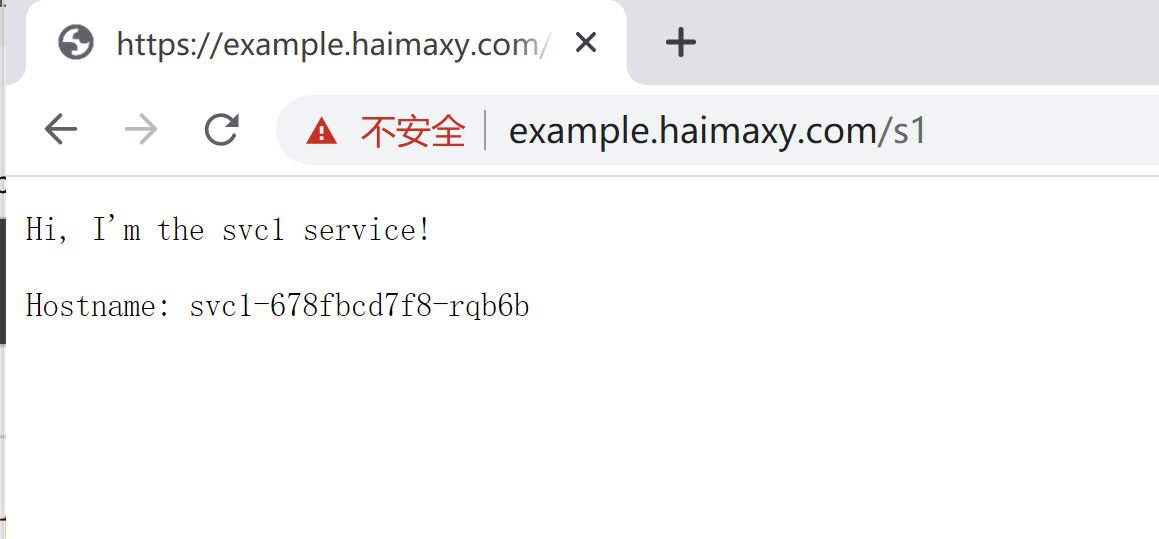

我们可以看到访问上面的域名得到的结果是 svc3 service!这是因为上面在 ingress 中我们为域名的跟路径匹配的是 svc3 这个 service,同样的,我们访问http://example.haimaxy.com/s1 得到的应该就是 svc1 这个 service 了:

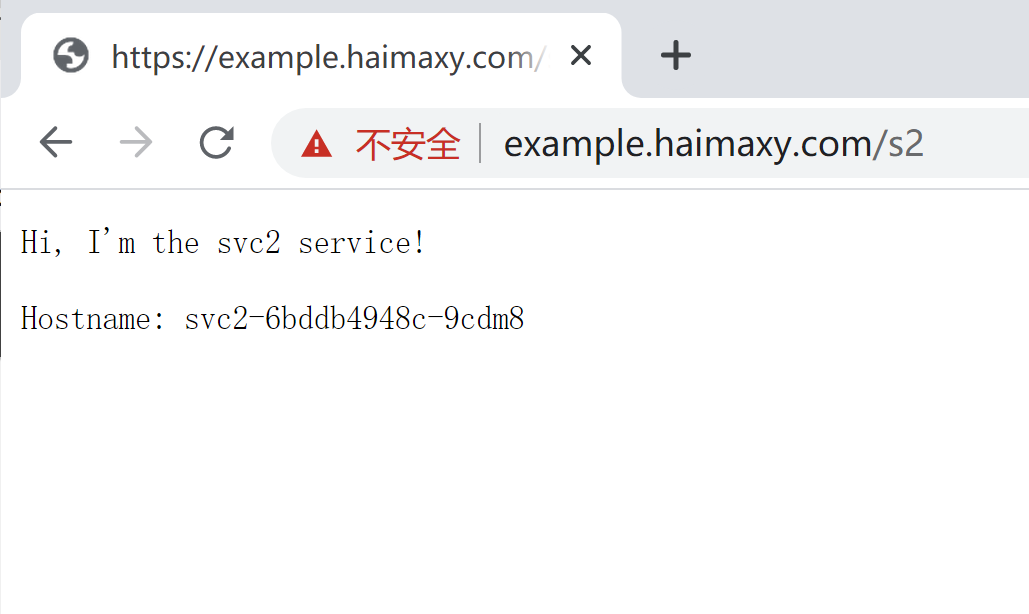

访问http://example.haimaxy.com/s2 得到的应该就是 svc2 这个 service 了:

这里我们需要注意的是根路径/必须在 ingress 对象中声明的时候必须放在最后面,不然就都被/匹配到拦截到了,大家可以尝试下把/这个 path 放在最上面,然后访问下 s1 和 s2 这两个 path,看看得到的结果是怎样的?

有的同学可能有这样的需求,就是不同的 ingress 对象是供不同的域名进行使用的,然后不同的域名的证书还不相同,这样我们想使用上面 traefik 给大家提供的统一的 https 证书就不行了,这个时候我们就可以单独为当前的服务提供单独的证书就可以,同样用证书文件创建一个 secret 对象,然后在 ingress 对象中声明一个 tls 对象即可,比如上面的 example.haimaxy.com 我们可以单独指定一个证书文件:

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: example-web-app

annotations:

kubernetes.io/ingress.class: "traefik"

spec:

tls:

- secretName: traefik-cert

rules:

- host:

...

浙公网安备 33010602011771号

浙公网安备 33010602011771号