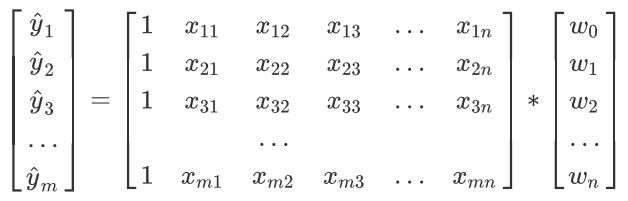

1.多元线性回归方程:![]()

2.模型:![]() (KNN、K-Means没有模型)

(KNN、K-Means没有模型)

3.损失函数:衡量系数w的模型拟合训练集时产生的信息损失的大小,以此衡量w优劣。

![]()

![]() 追求让损失函数最小化的参数组合,即

追求让损失函数最小化的参数组合,即![]()

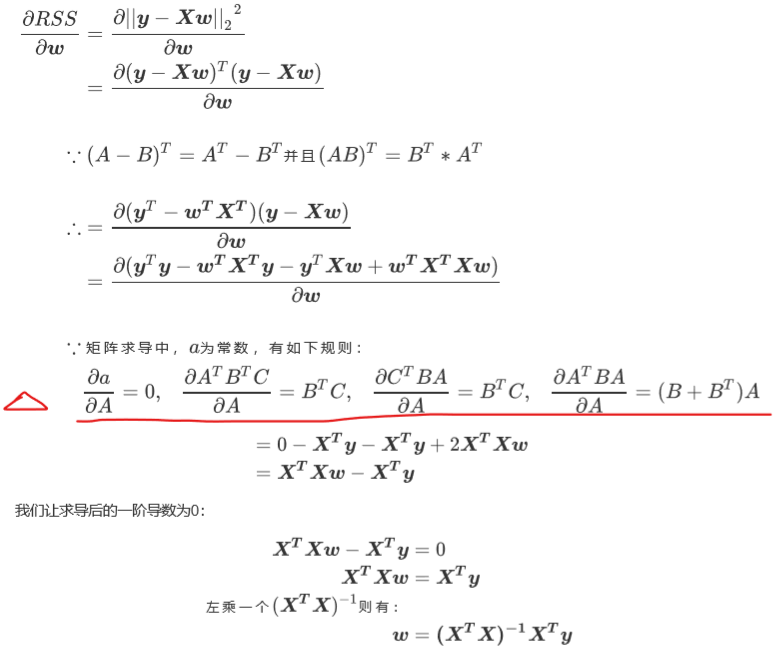

4.L2范式形式的损失函数:SSE误差平方和/RSS残差平方和 ![]()

5.最小二乘法:通过最小化真实值和预测值之间的RSS来求解参数的方法。

其中逆矩阵存在的充要条件是特征矩阵不存在多重共线性

其中逆矩阵存在的充要条件是特征矩阵不存在多重共线性

6.重要参数(非必填):fit_intercept是否计算截距,默认True

normalize特征矩阵X在进入回归之前将会被减去均值(中心化)并除以L2范式(缩放),默认False

copy_X默认True,将在X.copy()上操作

n_jobs用于计算的作业数,默认None。如果输入-1,则全部CPU用来计算

7.重要属性:coef_线性回归方程中估计出的系数

intercept_截距项

8.评估指标:均方误差MSE(是否预测正确数值),衡量预测值和真实值的差异。 RSS=M*MSE

绝对均值误差MAE

R^2(是否拟合足够信息,越接近1越好),衡量1-模型没有捕捉到的信息量占真实标签中所带信息量的比例

9.ESS、TSS、RSS、R^2关系

ESS解释平方和,TSS总离差平方和,TSS=RSS+ESS

![]() R^2可为负,因为TSS=RSS+ESS不一定永远成立,为负时模型拟合糟糕,不适用线性回归

R^2可为负,因为TSS=RSS+ESS不一定永远成立,为负时模型拟合糟糕,不适用线性回归

10.多重共线性:精确相关+高度相关

逆矩阵存在的充要条件特征矩阵不存在多重共线性→矩阵行列式不为0→矩阵满秩

11.相关性衡量指标:多重共线性——方差膨胀因子VIF

线性相关——皮尔逊相关系数

非线性相关——斯皮尔曼相关系数

12.处理多重共线性方法:使用统计学的先验思路、使用向前逐步回归(存在相关性的特征加惩罚项)、改进线性回归(岭回归、Lasso)

13.岭回归:在损失函数上加上正则项L2范式,损失函数为![]() ,α越大越不容易受到共线性影响

,α越大越不容易受到共线性影响

14.岭回归参数:alpha、fit_intercept、normalize、copy_X、max_iter、tol、solver、random_state

15.选最佳正则化参数取值:岭迹图(不建议使用)

交叉验证的岭回归

16.交叉验证岭回归RidgeCV

重要参数:alphas(可传入备选元组)、scoring(评估指标,默认R^2)、store_cv_score(是否保留结果,默认false)、cv(交叉验证模式,默认None留一交叉验证) 只有cv为none时store_cv_score才能为true

重要属性:alpha_(查看选中的α)、cv_values_(调用交叉验证结果,被保留才可以调用)

重要接口:score

17.Lasso:最小绝对收缩和选择算子,L1范式,损失函数为![]()

Lasso无法解决特征之间“精确相关”问题

18.Lasso和岭回归的区别:岭回归为L2范式,Lasso为L1范式

Lasso无法解决精确相关

Lasso可将系数压缩到0(特征选择工具首选)

19.Lasso参数:alpha、positive(为true时要求Lasso回归出的系数必须为正数,保证α一定增加来控制正则化程序)

20.线性与非线性:对于回归问题,数据若能分布为一条直线,则是线性的,否则是非线性;对于分类问题,数据分布若能使用一条直线来划分类别,则是线性可分的,否则是线性不可分的。

21.线性模型拟合非线性数据:分箱,即离散化

from sklearn.preprocessing import KBinsDiscretizer

其中encode="onehot" 用哑变量方式离散化

用交叉验证选择最优箱数

22.另一种线性处理非线性:使用多项式回归 多项式变化使线性模型升维

23.多项式回归参数:degree多项式中的次数,默认为2(最多7-8)

interaction_only是否只产生交互项,默认false

include_bias是否产出与截距项相乘的x0(如果线性回归中fit_intercept=false则可以为true,否则会产生一项无意义的特征项)

浙公网安备 33010602011771号

浙公网安备 33010602011771号