Seq2Seq 到 Attention的演变

https://zhuanlan.zhihu.com/p/28054589

1、Encoder-Decoder is also called Seq2Seq

It's been used to generator sentence based on differenct input length and output length

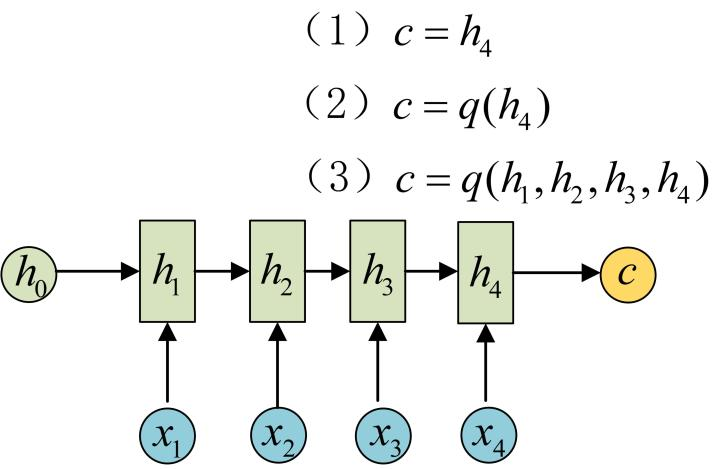

我们知道将S2S就是将序列信息压缩到一个向量c,这个c具体是如何形成?其实有多种方式

如果RNN使用GRU,则可以是:

而我常用的LSTM增加了记忆状态state_c, 所以变成[state_h,state_c]

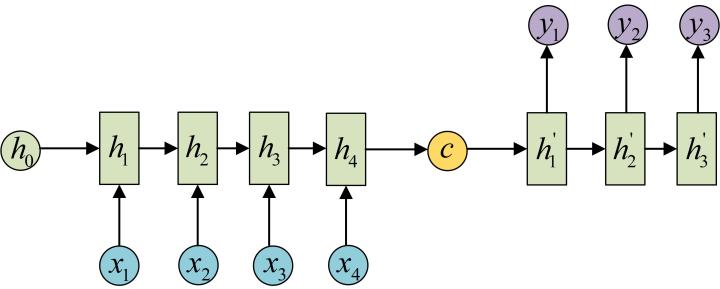

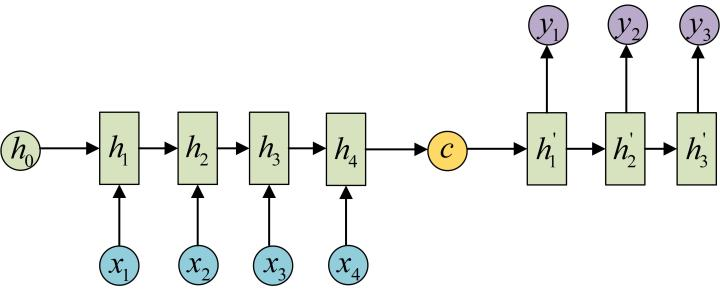

2、得到了c之后如何解码也是一个问题,常见的解码方式有:

我们的对话模型采用的就是这种解码方式,不过这里面少了input层

或者

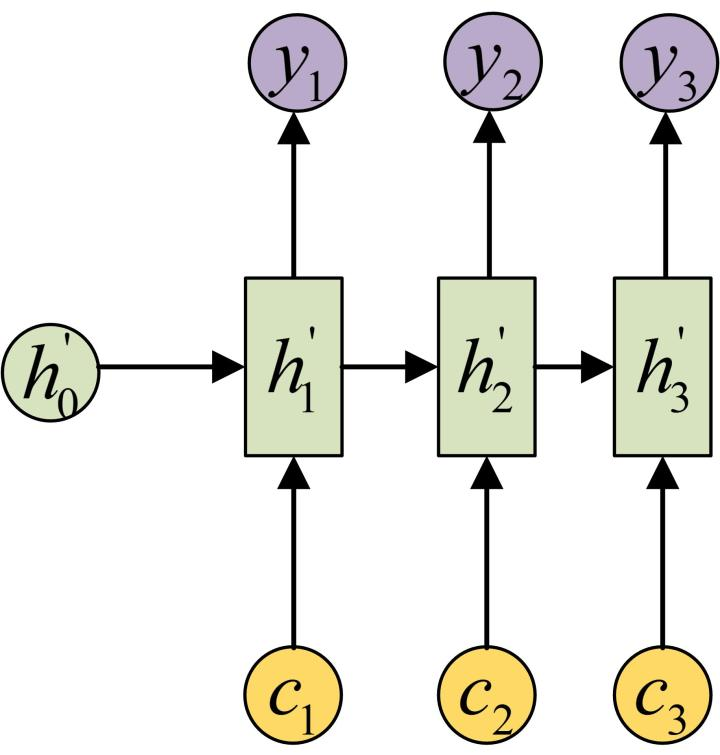

3、那么Attention机制是什么?

Attention的提出,就是为了解决S2S的一个问题,就是将信息压缩成一个向量c之后,必然会损失很多的信息。

一个思路是,我们不应该压缩成一个c,而是应该生成很多c,并根据不同时序的权重不同,去加权求和使用这些c

下列是两个图的对比:

浙公网安备 33010602011771号

浙公网安备 33010602011771号