kubernetes简史及单master架构实战

作者:尹正杰

版权声明:原创作品,谢绝转载!否则将追究法律责任。

目录

一.Kubernetes概述

1.什么是Kubernetes

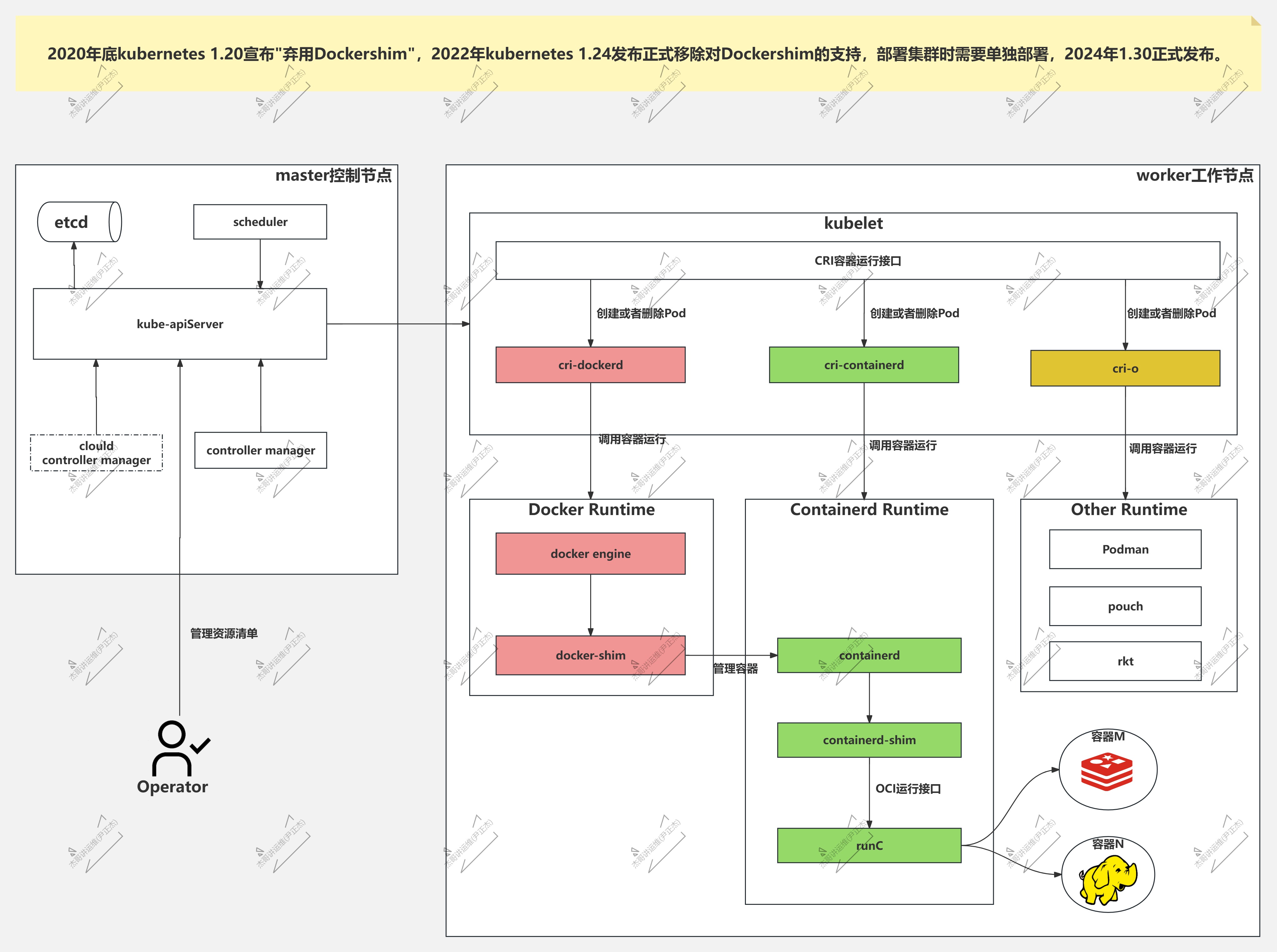

Kubernetes简称K8S,是底层基于容器进行编排,早期支持docker作为底层的容器运行时,从K8S 1.24版本之后,默认采用看containerd作为容器运行时。

官方文档:

https://kubernetes.io/zh-cn/

2.为什么要使用K8S

- 1.它将组成应用程序的容器组合成逻辑单元,以便于管理和服务发现。

Kubernetes 源自Google 15 年生产环境的运维经验,同时凝聚了社区的最佳创意和实践。

- 2.Google 每周运行数十亿个容器,Kubernetes 基于与之相同的原则来设计,能够在不扩张运维团队的情况下进行规模扩展。

- 3.无论是本地测试,还是跨国公司,Kubernetes 的灵活性都能让你在应对复杂系统时得心应手。

- 4.Kubernetes是开源系统,可以自由地部署在企业内部,私有云、混合云或公有云,让您轻松地做出合适的选择。

- 5.走云原生的小伙伴,月薪想要突破15k+,K8S是你必备的技能,25k+必精通技能。

3.Kubernetes(K8S)在运维在找工作的重要程度

简而言之,k8s是15k+必备技能,25k必精通技能。

4. Kubernetes和docker的简史精简版

- 2013年docker开源,IT界的福音,备受关注

- 2014.06 Google有15年的容器编排Borg(博格,商业产品)使用经验,并将K8S(基于borg系统使用go语言研发)底层基于docker作为容器运行时开源

- 2014.12 docker inc公司推出了K8S竞品,docker swarm

- Google kubernets vs docker inc swarm 【3年对抗赛】 2017年年底结束,k8s完胜。(k8s 72% vs swarm %13)

- 2014 coreOS 公司推出了rkt容器管理工具并站队K8S

- 2015 Google公司将K8S开源并贡献给了CNCF组织,成为该组织的第一个毕业项目。

- 2015 docker inc公司推出了OCI提议,主要针对容器运行时和镜像规范,并开源了runc。

- 2016 Google推出了CRI规范,目前市面上没有任何产品可以满足,于是就开源了docker-shim组件(会调用docker接口并满足cri规范)支持CRI接口;

- 2016,RedHat公司基于cri-o(既符合CRI也符合OCI规范)开发框架让rkt容器管理工具支持CRI接口;

- 2017,docker inc公司将containerd从docker engine剥离,并将containerd开源给了CNCF组织,

- containerd底层调用runc,因此该产品是支持OCI提议的;

- containerd组件本身不支持CRI,因此社区大佬们(包含国内外)集体开发cri-containerd组件,最后合并到containerd项目

- 2018 年国内开始流程K8S,各大云厂商已经开始大规模使用K8S集群,

- 阿里云的ACK的SAAS产品

- 腾讯云的TKE的SAAS产品

- 华为云的CCE的SAAS产品

- ucloud的UK8S的SAAS产品

- 亚马逊的Amazon EKS的SAAS产品

- 京东云,百度云等

- 2018年,coreOS公司被Redhat以2.5亿美元收购。

- 2018年10月29日,IBM宣布以340亿美元的价格收购Red Hat。

- 曾经一度,Docker方面的炒作非常猛。

- Docker从Greylock Partners、Insight Partners和红杉资本等大牌投资者处筹资超过2.7亿美元,

- 2018年估值达到最高峰:13.2亿美元。

- 2019年2月,Docker一分为二,将企业业务出售给了云咨询公司Mirantis(对于OpenStack代码贡献量非常大,能排到前3)。

- 2020年,Google宣布K8S将在1.22+版本后弃用docker容器运行时,当时年底发布的最新版是1.20.X;

- 2020年3月11日公布的,当时Docker宣布被云计算软件巨头微软(Microsoft)以 6.7亿美元收购。

- 2021年底 K8S 1.23的RC版本发布;

- 2022年初,K8S 1.24横空出世,直接将docker-shim组件移除,而是使用containerd作为容器运行时;

- 2023年初,K8S 1.27.X发布;

- 2023年3月,K8S 1.23.17 发布了最后一个支持docker-shim的版本。

- docker和Mirantis公司作为合作伙伴,将维护该项目,运维小伙伴如果需要在K8S 1.24及以后的版本使用docker的话,需要单独cri-docker组件。

- 2024年初,K8S 1.30.x版本发布

- 2024年12月,K8S 1.32.x版本发布

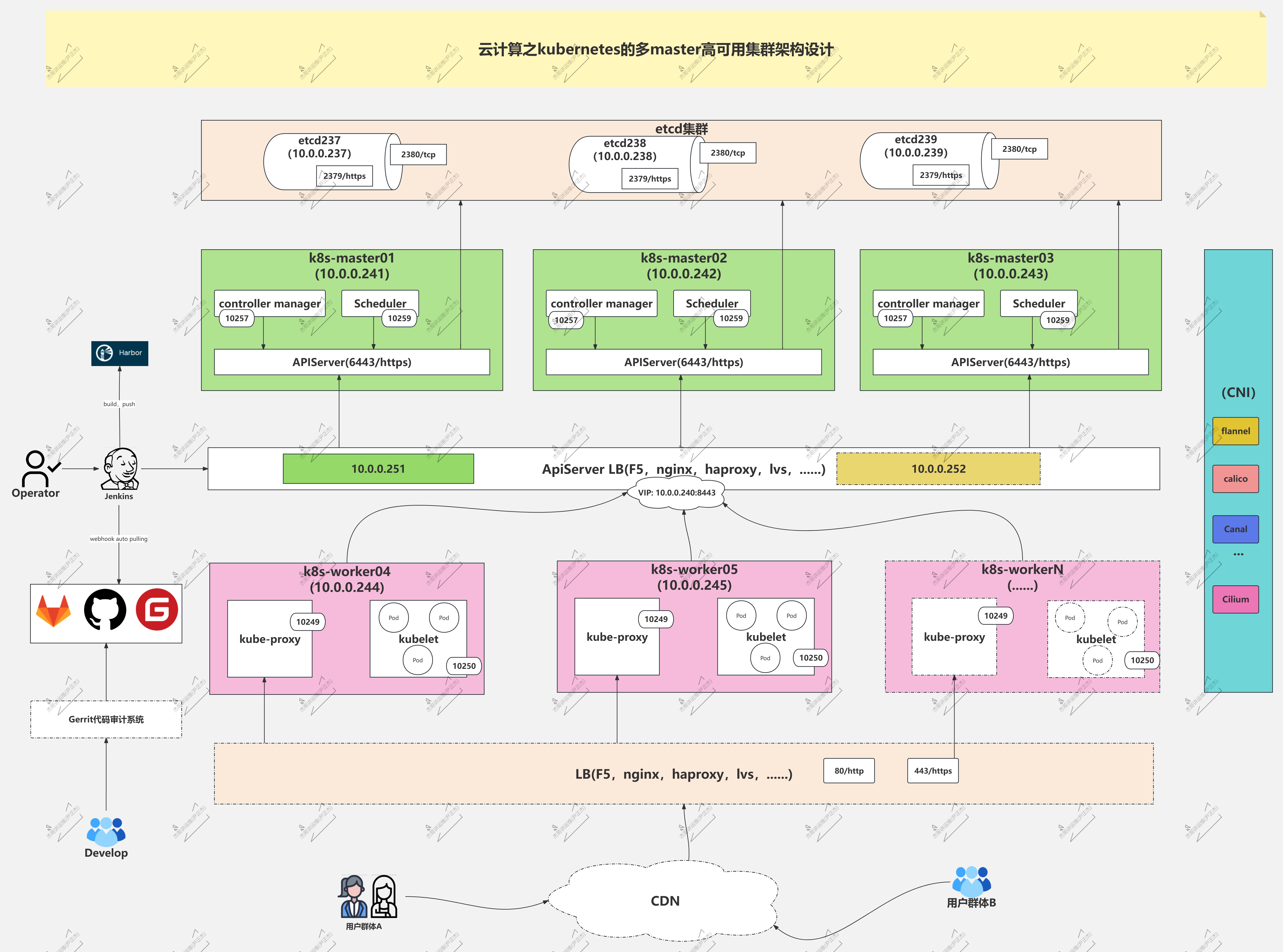

5.Kubernetes集群架构图解

Scheduler:

kube-scheduler根据调度算法为新创建的Pod选择一个Node节点,可以任意部署,可以部署在同一个节点上,也可以部署在不同的节点上。

Controller Manager:

Kube-controller-manager,处理集群中常规后台任务,一个资源对应一个控制器,而ControllerManager就是负责管理这些控制器的。

Cloud Controller Manager:

用在云平台上的Kube-controller-manager组件。如果我们直接在物理机上部署的话,可以不使用该组件。

API Server:

kube-apiserver,集群的统一入口,各组件协调者,以RESTFUL API提供接口服务,所有对象资源的增删改查和监听操作都交给APIServer处理后再提交给etcd存储。

Etcd:

分布式键值存储系统,用于保存集群状态元数据信息,比如Pod,Service等对象信息。这个数据库是可以单独拿出来部署,只需要API server可以连接到该分布式数据库集群即可。

kubelet:

可以理解为Master在工作节点上的Agent,管理本机运行容器的生命周期,比如创建容器,Pod挂载数据卷,下载secret,获取容器的节点状态等工作。kubelet将每一个Pod转换成一组容器。

kube-proxy:

在工作节点上实现Pod网络代理,维护网络规则和四层负载均衡工作。换句话说,就是用于负责Pod网络路由,用于对外提供访问的实现。可以找到你关心的项目所在的pod节点。

POD:

用户划分容器的最小单位,一个POD可以存在多个容器。

docker/rocket(rkt,已停止支持):

容器引擎,用于运行容器。

CNI:

Pod跨节点进行网络通信的网络插件。

参考链接:

https://kubernetes.io/zh/docs/concepts/overview/components/

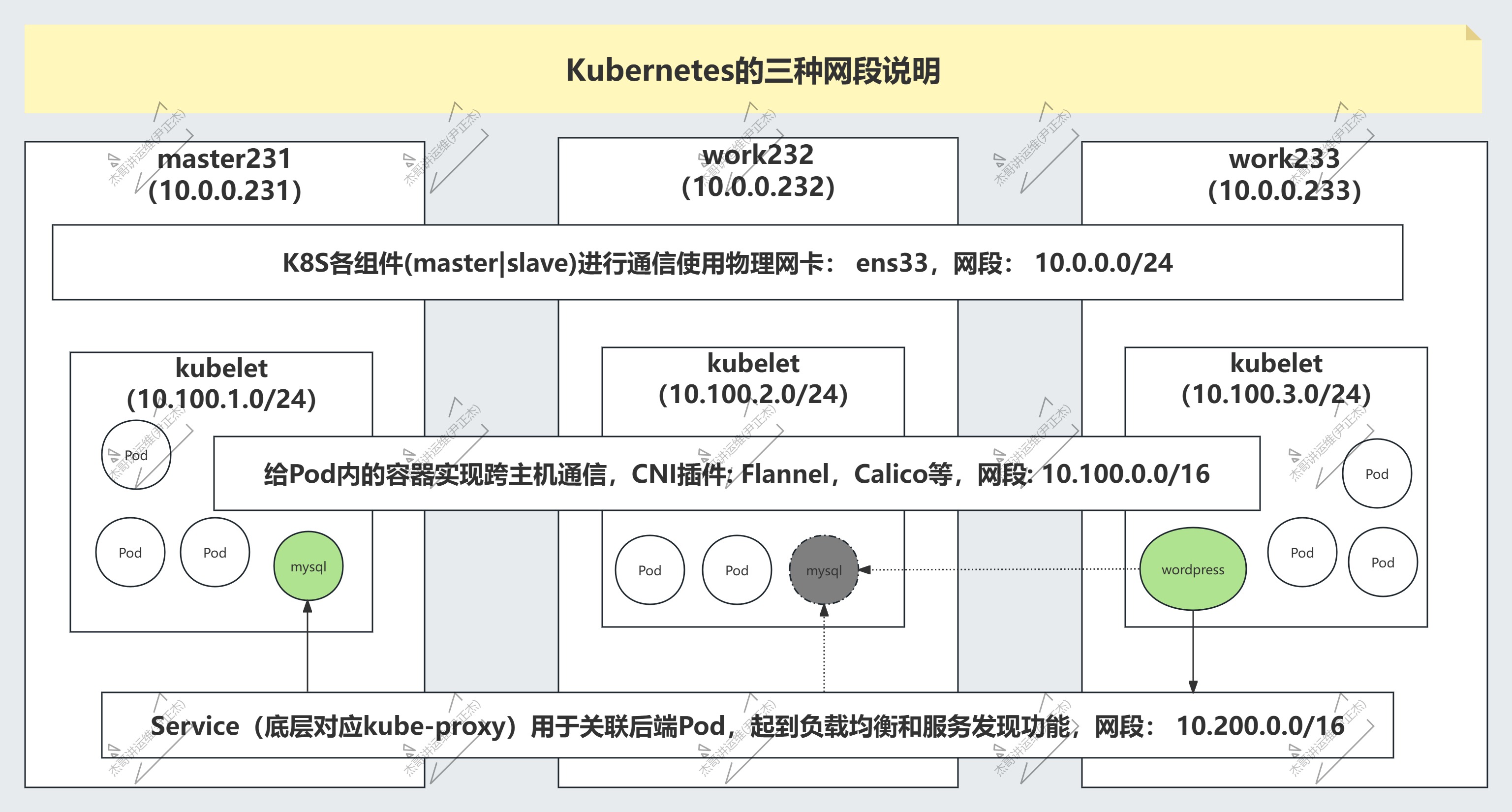

6.Kubernetes的三种网段说明

- K8S各组件通信的网络

使用时物理网卡,默认网段: 10.0.0.0/24。

- 跨节点容器实现通信的网段:

用户可以自定义,学习环境推荐: 10.100.0.0/16。

但是在自定义网段时,要考虑将来能够分片的IP地址数量,"10.100.0.0/16"最多有65536个IP地址。

如果将来容器运行的数量超过该规模时,应该考虑将网段地址调大,比如"10.0.0.0/8"。

- Service网段:

为容器提供负载均衡和服务发现功能。也是需要一个独立的网段,比如"10.200.0.0/16"最多有65536个IP地址。

同理,如果规模较大时,应该考虑网段分配的问题。

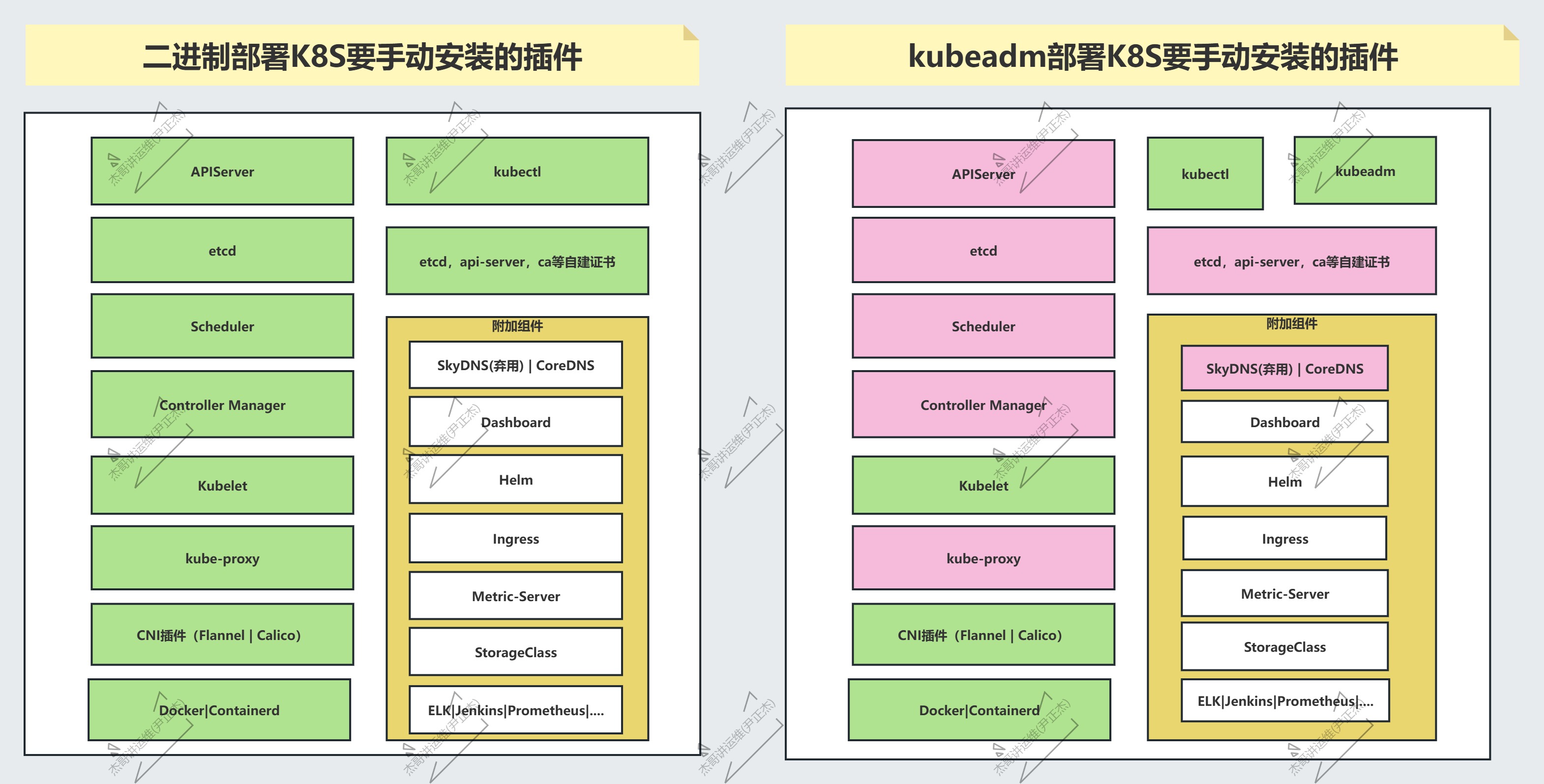

7.kubernetes的部署方式

- 官方默认都有两种部署方式: (在生产环境中都可以使用,且都支持高可用环境。咱们学习过程中,建议选择kubeadm。)

- 二进制部署K8S集群

手动部署K8S各个组件,配置文件,启动脚本及证书生成,kubeconfig文件。

配置繁琐,对新手不友好,尤其是证书管理。但是可以自定义配置信息,老手部署的话2小时起步,新手20小时+

- kubeadm部署K8S集群

是官方提供的一种快速部署K8S各组件的搭建,如果镜像准备就绪的情况下,基于容器的方式部署。

需要提前安装kubelet,docker或者containerd,kubeadm组件。

配置简单,适合新手。新手在镜像准备好的情况下,仅需要2分钟部署完毕。

- 第三方提供的部署方式:

国内公司:

- 青云科技: kubesphere

底层基于kubeadm快速部署K8S,提供了丰富的图形化管理界面。

- kuboard

底层基于kubeadm快速部署K8S,提供了丰富的图形化管理界面。

- kubeasz

底层基于二进制方式部署,结合ansible的playbook实现的快速部署管理K8S集群。

国外的产品:

- rancher:

和国内的kubesphere很相似,也是K8S发行商,提供了丰富的图形化管理界面。

还基于K8S研发出来了K3S,号称轻量级的K8S。

云厂商:

- 阿里云的ACK的SAAS产品

- 腾讯云的TKE的SAAS产品

- 华为云的CCE的SAAS产品

- ucloud的UK8S的SAAS产品

- 亚马逊的Amazon EKS的SAAS产品

- 京东云,百度云的SAAS产品等。

其他部署方式:

- minikube:

适合在windows部署K8S,适合开发环境搭建的使用。不建议生产环境部署。

- kind:

可以部署多套K8S环境,轻量级的命令行管理工具。

- yum:

不推荐,版本支持较低,默认是1.5.2。

CNCF技术蓝图:

https://landscape.cncf.io/

- 二进制部署和kubeadm部署的区别:

相同点:

都可以部署K8S高可用集群。

不同点:

- 1.部署难度: kubeadm简单.

- 2.部署时间: kubeadm短时间。

- 3.证书管理: 二进制需要手动生成,而kubeadm自建一个10年的CA证书,各组件证书有效期为1年。

- 4.软件安装: kubeadm需要单独安装kubeadm,kubectl和kubelet组件,由kubelet组件启动K8S其他相关Pod,而二进制需要安装除了kubeadm的其他K8S组件。

8.Kubernetes的版本选择

我们选择的版本是多版本教学,就是不仅仅是一个版本教学,而是多版本教学,我们线下学员反馈各个公司用的版本不尽相同。

首先,是K8S 1.23.17版本,该版本的第一个rc版本是2021年初,最后一个版本是23年年初结束。

其次,我们会基于kubekey的方式部署K8S 1.28版本,而后部署kubesphere来管理多套K8S集群。

最后,我们以二进制部署K8S集群搭建最新版本讲解。

二.K8S的集群配置环境准备

1.K8S虚拟机硬件环境准备

推荐阅读:

https://kubernetes.io/zh/docs/setup/production-environment/tools/kubeadm/install-kubeadm/

环境准备:

硬件配置: 2core 4GB

磁盘: 50GB+

操作系统: Ubuntu 22.04.04 LTS

IP和主机名:

10.0.0.231 master231

10.0.0.232 worker232

10.0.0.233 worker233

所有节点能够上网,机器必须"干净"。

2.关闭swap分区

swapoff -a && sysctl -w vm.swappiness=0 # 临时关闭

sed -ri '/^[^#]*swap/s@^@#@' /etc/fstab # 基于配置文件关闭

3.确保各个节点MAC地址或product_uuid唯一

ifconfig eth0 | grep ether | awk '{print $2}'

cat /sys/class/dmi/id/product_uuid

温馨提示:

一般来讲,硬件设备会拥有唯一的地址,但是有些虚拟机的地址可能会重复。

Kubernetes使用这些值来唯一确定集群中的节点。 如果这些值在每个节点上不唯一,可能会导致安装失败。

4.检查网络节点是否互通

简而言之,就是检查你的k8s集群各节点是否互通,可以使用ping命令来测试。

ping baidu.com -c 10

5 允许iptable检查桥接流量

cat <<EOF | tee /etc/modules-load.d/k8s.conf

br_netfilter

EOF

cat <<EOF | tee /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.ip_forward = 1

EOF

sysctl --system

6 检查端口是否被占用

参考链接: https://kubernetes.io/zh-cn/docs/reference/networking/ports-and-protocols/

检查master节点和worker节点的各组件端口是否被占用。

7.所有节点修改cgroup的管理进程为systemd

安装docker环境。

svip:

wget http://192.168.11.253/Image/Docker/softwares/yinzhengjie-autoinstall-docker-docker-compose.tar.gz

tar xf yinzhengjie-autoinstall-docker-docker-compose.tar.gz

./install-docker.sh i

[root@master231 ~]# docker info | grep "Cgroup Driver:"

Cgroup Driver: systemd

[root@master231 ~]#

[root@worker232 ~]# docker info | grep "Cgroup Driver:"

Cgroup Driver: systemd

[root@worker232 ~]#

[root@worker233 ~]# docker info | grep "Cgroup Driver:"

Cgroup Driver: systemd

[root@worker233 ~]#

温馨提示:

在CentOS操作系统中,如果不修改cgroup的管理驱动为systemd,则默认值为cgroupfs,在初始化master节点时会失败哟!

下面的案例是CentOS操作的实力,Ubuntu可以跳过此步骤。

[root@master231 ~]# docker info | grep cgroup

Cgroup Driver: cgroupfs

[root@master231 ~]#

[root@master231 ~]# cat /etc/docker/daemon.json

{

"registry-mirrors": ["https://tuv7rqqq.mirror.aliyuncs.com","https://docker.mirrors.ustc.edu.cn/","https://hub-mirror.c.163.com/","https://reg-mirror.qiniu.com"],

"exec-opts": ["native.cgroupdriver=systemd"]

}

[root@master231 ~]#

[root@master231 ~]# systemctl restart docker

[root@master231 ~]#

[root@master231 ~]# docker info | grep "Cgroup Driver"

Cgroup Driver: systemd

[root@master231 ~]#

8.所有节点安装kubeadm,kubelet,kubectl

8.1 软件包说明

你需要在每台机器上安装以下的软件包:

kubeadm:

用来初始化K8S集群的工具。

kubelet:

在集群中的每个节点上用来启动Pod和容器等。

kubectl:

用来与K8S集群通信的命令行工具。

kubeadm不能帮你安装或者管理kubelet或kubectl,所以你需要确保它们与通过kubeadm安装的控制平面(master)的版本相匹配。 如果不这样做,则存在发生版本偏差的风险,可能会导致一些预料之外的错误和问题。

然而,控制平面与kubelet间的相差一个次要版本不一致是支持的,但kubelet的版本不可以超过"API SERVER"的版本。 例如,1.7.0版本的kubelet可以完全兼容1.8.0版本的"API SERVER",反之则不可以。

8.2 K8S所有节点配置软件源

apt-get update && apt-get install -y apt-transport-https

curl https://mirrors.aliyun.com/kubernetes/apt/doc/apt-key.gpg | apt-key add -

cat <<EOF >/etc/apt/sources.list.d/kubernetes.list

deb https://mirrors.aliyun.com/kubernetes/apt/ kubernetes-xenial main

EOF

apt-get update

8.3 查看一下当前环境支持的k8s版本

[root@master231 ~]# apt-cache madison kubeadm

kubeadm | 1.28.2-00 | https://mirrors.aliyun.com/kubernetes/apt kubernetes-xenial/main amd64 Packages

kubeadm | 1.28.1-00 | https://mirrors.aliyun.com/kubernetes/apt kubernetes-xenial/main amd64 Packages

kubeadm | 1.28.0-00 | https://mirrors.aliyun.com/kubernetes/apt kubernetes-xenial/main amd64 Packages

...

kubeadm | 1.23.17-00 | https://mirrors.aliyun.com/kubernetes/apt kubernetes-xenial/main amd64 Packages

kubeadm | 1.23.16-00 | https://mirrors.aliyun.com/kubernetes/apt kubernetes-xenial/main amd64 Packages

kubeadm | 1.23.15-00 | https://mirrors.aliyun.com/kubernetes/apt kubernetes-xenial/main amd64 Packages

kubeadm | 1.23.14-00 | https://mirrors.aliyun.com/kubernetes/apt kubernetes-xenial/main amd64 Packages

...

8.4 安装 kubelet kubeadm kubectl

apt-get -y install kubelet=1.23.17-00 kubeadm=1.23.17-00 kubectl=1.23.17-00

8.5 检查各组件版本

[root@worker232 ~]# kubeadm version

kubeadm version: &version.Info{Major:"1", Minor:"23", GitVersion:"v1.23.17", GitCommit:"953be8927218ec8067e1af2641e540238ffd7576", GitTreeState:"clean", BuildDate:"2023-02-22T13:33:14Z", GoVersion:"go1.19.6", Compiler:"gc", Platform:"linux/amd64"}

[root@worker232 ~]#

[root@worker232 ~]# kubectl version

Client Version: version.Info{Major:"1", Minor:"23", GitVersion:"v1.23.17", GitCommit:"953be8927218ec8067e1af2641e540238ffd7576", GitTreeState:"clean", BuildDate:"2023-02-22T13:34:27Z", GoVersion:"go1.19.6", Compiler:"gc", Platform:"linux/amd64"}

The connection to the server localhost:8080 was refused - did you specify the right host or port?

[root@worker232 ~]#

[root@worker232 ~]# kubelet --version

Kubernetes v1.23.17

[root@worker232 ~]#

温馨提示:

其他两个节点都要检查下,避免你安装的版本和我不一致!

参考链接:

https://kubernetes.io/zh/docs/tasks/tools/install-kubectl-linux/

9.检查时区

[root@master231 ~]# date -R

Mon, 09 Sep 2024 14:58:34 +0800

[root@master231 ~]#

[root@master231 ~]# ll /etc/localtime

lrwxrwxrwx 1 root root 33 Aug 30 15:27 /etc/localtime -> /usr/share/zoneinfo/Asia/Shanghai

[root@master231 ~]#

[root@worker232 ~]# date -R

Mon, 09 Sep 2024 14:59:22 +0800

[root@worker232 ~]#

[root@worker232 ~]# ll /etc/localtime

lrwxrwxrwx 1 root root 33 Aug 30 15:27 /etc/localtime -> /usr/share/zoneinfo/Asia/Shanghai

[root@worker232 ~]#

[root@worker232 ~]#

[root@worker233 ~]# date -R

Mon, 09 Sep 2024 14:59:35 +0800

[root@worker233 ~]#

[root@worker233 ~]# ll /etc/localtime

lrwxrwxrwx 1 root root 33 Aug 30 15:27 /etc/localtime -> /usr/share/zoneinfo/Asia/Shanghai

[root@worker233 ~]#

10.关机,拍快照

避免后续步骤出错时,方便回滚,因为后面的步骤很多同学容易做错。

三.基于kubeadm组件初始化K8S的master组件

1.提前导入镜像

[root@master231 ~]# wget http://192.168.11.253/Image/Kubernetes/images/K8S%20Cluster/yinzhengjie-master-1.23.17.tar.gz

[root@master231 ~]# docker load -i yinzhengjie-master-1.23.17.tar.gz

2.修改时区

[root@master231 ~]# ln -svf /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

'/etc/localtime' -> '/usr/share/zoneinfo/Asia/Shanghai'

[root@master231 ~]#

[root@worker233 ~]# ln -svf /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

'/etc/localtime' -> '/usr/share/zoneinfo/Asia/Shanghai'

[root@worker233 ~]#

[root@worker232 ~]# ln -svf /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

'/etc/localtime' -> '/usr/share/zoneinfo/Asia/Shanghai'

[root@worker232 ~]#

3.使用kubeadm初始化master节点

[root@master231 ~]# kubeadm init --kubernetes-version=v1.23.17 --image-repository registry.aliyuncs.com/google_containers --pod-network-cidr=10.100.0.0/16 --service-cidr=10.200.0.0/16 --service-dns-domain=yinzhengjie.com --apiserver-advertise-address=10.0.0.231 # 如果有多块物理网卡时 --apiserver-advertise-address很有效,单块网卡无需配置此选项。

...

Your Kubernetes control-plane has initialized successfully!

To start using your cluster, you need to run the following as a regular user:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

Alternatively, if you are the root user, you can run:

export KUBECONFIG=/etc/kubernetes/admin.conf

You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

https://kubernetes.io/docs/concepts/cluster-administration/addons/

Then you can join any number of worker nodes by running the following on each as root:

kubeadm join 10.0.0.231:6443 --token iiviy9.z6w6a4b27amj4iui \

--discovery-token-ca-cert-hash sha256:93e8350a3d73276a0bc298ec8ba5343d2611cfe99abfd529c00f58a27ef7c92c

[root@master231 ~]#

温馨提示:

你的token跟我不一致,请保存好,默认保留24小时,因此24小时内你的集群必须启动起来!

相关参数说明:

--kubernetes-version:

指定K8S master组件的版本号。

--image-repository:

指定下载k8s master组件的镜像仓库地址。

--pod-network-cidr:

指定Pod的网段地址。

--service-cidr:

指定SVC的网段

--service-dns-domain:

指定service的域名。若不指定,默认为"cluster.local"。

使用kubeadm初始化集群时,可能会出现如下的输出信息:

[init]

使用初始化的K8S版本。

[preflight]

主要是做安装K8S集群的前置工作,比如下载镜像,这个时间取决于你的网速。

[certs]

生成证书文件,默认存储在"/etc/kubernetes/pki"目录哟。

[kubeconfig]

生成K8S集群的默认配置文件,默认存储在"/etc/kubernetes"目录哟。

[kubelet-start]

启动kubelet,

环境变量默认写入:"/var/lib/kubelet/kubeadm-flags.env"

配置文件默认写入:"/var/lib/kubelet/config.yaml"

[control-plane]

使用静态的目录,默认的资源清单存放在:"/etc/kubernetes/manifests"。

此过程会创建静态Pod,包括"kube-apiserver","kube-controller-manager"和"kube-scheduler"

[etcd]

创建etcd的静态Pod,默认的资源清单存放在:""/etc/kubernetes/manifests"

[wait-control-plane]

等待kubelet从资源清单目录"/etc/kubernetes/manifests"启动静态Pod。

[apiclient]

等待所有的master组件正常运行。

[upload-config]

创建名为"kubeadm-config"的ConfigMap在"kube-system"名称空间中。

[kubelet]

创建名为"kubelet-config-1.22"的ConfigMap在"kube-system"名称空间中,其中包含集群中kubelet的配置

[upload-certs]

跳过此节点,详情请参考”--upload-certs"

[mark-control-plane]

标记控制面板,包括打标签和污点,目的是为了标记master节点。

[bootstrap-token]

创建token口令,例如:"kbkgsa.fc97518diw8bdqid"。

如下图所示,这个口令将来在加入集群节点时很有用,而且对于RBAC控制也很有用处哟。

[kubelet-finalize]

更新kubelet的证书文件信息

[addons]

添加附加组件,例如:"CoreDNS"和"kube-proxy”

2 拷贝授权文件,用于管理K8S集群

[root@master231 ~]# mkdir -p $HOME/.kube

[root@master231 ~]# sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

[root@master231 ~]# sudo chown $(id -u):$(id -g) $HOME/.kube/config

3 查看集群节点

[root@master231 ~]# kubectl get cs

Warning: v1 ComponentStatus is deprecated in v1.19+

NAME STATUS MESSAGE ERROR

scheduler Healthy ok

controller-manager Healthy ok

etcd-0 Healthy {"health":"true","reason":""}

[root@master231 ~]#

[root@master231 ~]#

[root@master231 ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

master231 NotReady control-plane,master 117s v1.23.17

[root@master231 ~]#

4. master初始化不成功解决问题的方法

可能存在的原因:

- 由于没有禁用swap分区导致无法完成初始化;

- 每个2core以上的CPU导致无法完成初始化;

- 没有手动导入镜像;

解决方案:

- 1.检查上面的是否有上面的情况

free -h

lscpu

- 2.重置当前节点环境

[root@master231 ~]# kubeadm reset -f

- 3.再次尝试初始化master节点

四.基于kubeadm部署worker组件

1.提前导入镜像

[root@worker232 ~]# wget http://192.168.11.253/Image/Kubernetes/images/K8S%20Cluster/yinzhengjie-slave-1.23.17.tar.gz

[root@worker232 ~]# docker load -i yinzhengjie-slave-1.23.17.tar.gz

[root@worker233 ~]# wget http://192.168.11.253/Image/Kubernetes/images/K8S%20Cluster/yinzhengjie-slave-1.23.17.tar.gz

[root@worker233 ~]# docker load -i yinzhengjie-slave-1.23.17.tar.gz

2.在worker节点执行加入的命令【注意!!!!!!不要复制我的,照着我的做不出来,复制你自己的token】

[root@worker232 ~]# kubeadm join 10.0.0.231:6443 --token iiviy9.z6w6a4b27amj4iui \

--discovery-token-ca-cert-hash sha256:93e8350a3d73276a0bc298ec8ba5343d2611cfe99abfd529c00f58a27ef7c92c

[root@worker233 ~]# kubeadm join 10.0.0.231:6443 --token iiviy9.z6w6a4b27amj4iui \

--discovery-token-ca-cert-hash sha256:93e8350a3d73276a0bc298ec8ba5343d2611cfe99abfd529c00f58a27ef7c92c

温馨提示:

上面的命令表示将worker节点加入到k8s的master初始化的集群。使用你上一步生成的token即可。

3.master节点检查集群的worker节点列表

[root@master231 ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

master231 NotReady control-plane,master 32m v1.23.17

worker232 NotReady <none> 36s v1.23.17

worker233 NotReady <none> 25s v1.23.17

[root@master231 ~]#

温馨提示:

此时K8S组件就算部署成功了,但是将来容器的网络依旧没有准备就绪,因此各节点处于“NotReady”状态。

五 部署flannel的CNI插件

1.符合的CNI插件列表选择

https://kubernetes.io/zh-cn/docs/concepts/cluster-administration/addons/

falnnel的网站:

https://github.com/flannel-io/flannel#deploying-flannel-manually

1.所有节点手动导入镜像

由于docker官网无法直接访问,因此虚拟机需要FQ。

如果无法FQ的小伙伴可以手动导入镜像,K8S所有节点操作如下 :

[root@master231 ~]# wget http://192.168.11.253/Image/Kubernetes/images/K8S%20Cluster/yinzhengjie-cni-v1.5.1-flannel-v0.25.6.tar.gz

[root@master231 ~]# docker load -i yinzhengjie-cni-v1.5.1-flannel-v0.25.6.tar.gz

[root@worker232 ~]# wget http://192.168.11.253/Image/Kubernetes/images/K8S%20Cluster/yinzhengjie-cni-v1.5.1-flannel-v0.25.6.tar.gz

[root@worker232 ~]# docker load -i yinzhengjie-cni-v1.5.1-flannel-v0.25.6.tar.gz

[root@worker233 ~]# wget http://192.168.11.253/Image/Kubernetes/images/K8S%20Cluster/yinzhengjie-cni-v1.5.1-flannel-v0.25.6.tar.gz

[root@worker233 ~]# docker load -i yinzhengjie-cni-v1.5.1-flannel-v0.25.6.tar.gz

2.下载Flannel组件

wget https://github.com/flannel-io/flannel/releases/latest/download/kube-flannel.yml

自行修改Pod的网段即可。

svip:

[root@master231 ~]# wget http://192.168.11.253/Image/Kubernetes/softwares/kube-flannel.yml

3.安装Flannel组件

[root@master231 ~]# kubectl apply -f kube-flannel.yml

namespace/kube-flannel created

serviceaccount/flannel created

clusterrole.rbac.authorization.k8s.io/flannel created

clusterrolebinding.rbac.authorization.k8s.io/flannel created

configmap/kube-flannel-cfg created

daemonset.apps/kube-flannel-ds created

[root@master231 ~]#

4.检查falnnel各组件是否安装成功

[root@master231 ~]# kubectl get pod -o wide -n kube-flannel

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

kube-flannel-ds-7mchd 1/1 Running 0 20s 10.0.0.232 worker232 <none> <none>

kube-flannel-ds-ccwl7 1/1 Running 0 20s 10.0.0.231 master231 <none> <none>

kube-flannel-ds-wzzq9 1/1 Running 0 20s 10.0.0.233 worker233 <none> <none>

[root@master231 ~]#

5.测试各节点组件

[root@master231 ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

master231 Ready control-plane,master 58m v1.23.17

worker232 Ready <none> 26m v1.23.17

worker233 Ready <none> 25m v1.23.17

[root@master231 ~]#

6.检查flannel.1网卡是否存在

[root@master231 ~]# ifconfig

cni0: flags=4099<UP,BROADCAST,MULTICAST> mtu 1500

inet 10.100.0.1 netmask 255.255.255.0 broadcast 0.0.0.0

inet6 fe80::7498:efff:fe86:d4bc prefixlen 64 scopeid 0x20<link>

ether 3a:28:99:ca:1f:85 txqueuelen 1000 (Ethernet)

RX packets 0 bytes 0 (0.0 B)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 2 bytes 164 (164.0 B)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

...

flannel.1: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1450

inet 10.100.0.0 netmask 255.255.255.255 broadcast 0.0.0.0

inet6 fe80::d88c:e5ff:fe0f:b4ba prefixlen 64 scopeid 0x20<link>

ether da:8c:e5:0f:b4:ba txqueuelen 0 (Ethernet)

RX packets 0 bytes 0 (0.0 B)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 0 bytes 0 (0.0 B)

TX errors 0 dropped 33 overruns 0 carrier 0 collisions 0

...

[root@master231 ~]#

[root@worker232 ~]# ifconfig

cni0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1450

inet 10.100.1.1 netmask 255.255.255.0 broadcast 10.100.1.255

inet6 fe80::3828:99ff:feca:1f85 prefixlen 64 scopeid 0x20<link>

ether 3a:28:99:ca:1f:85 txqueuelen 1000 (Ethernet)

RX packets 0 bytes 0 (0.0 B)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 30 bytes 4343 (4.3 KB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

...

flannel.1: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1450

inet 10.100.1.0 netmask 255.255.255.255 broadcast 0.0.0.0

inet6 fe80::4846:2dff:fe52:2307 prefixlen 64 scopeid 0x20<link>

ether 4a:46:2d:52:23:07 txqueuelen 0 (Ethernet)

RX packets 0 bytes 0 (0.0 B)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 0 bytes 0 (0.0 B)

TX errors 0 dropped 32 overruns 0 carrier 0 collisions 0

...

[root@worker232 ~]#

[root@worker233 ~]# ifconfig

cni0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1450

inet 10.100.2.1 netmask 255.255.255.0 broadcast 10.100.2.255

inet6 fe80::3828:99ff:feca:1f85 prefixlen 64 scopeid 0x20<link>

ether 3a:28:99:ca:1f:85 txqueuelen 1000 (Ethernet)

RX packets 514 bytes 43908 (43.9 KB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 534 bytes 68678 (68.6 KB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

...

flannel.1: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1450

inet 10.100.2.0 netmask 255.255.255.255 broadcast 0.0.0.0

inet6 fe80::17:21ff:fe24:c641 prefixlen 64 scopeid 0x20<link>

ether 02:17:21:24:c6:41 txqueuelen 0 (Ethernet)

RX packets 0 bytes 0 (0.0 B)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 0 bytes 0 (0.0 B)

TX errors 0 dropped 32 overruns 0 carrier 0 collisions 0

...

[root@worker233 ~]#

7.fannel网卡cni0网卡缺失解决方案

1问题描述

部分节点不存在cni0网络设备,仅有flannel.1设备,此时我们需要手动创建cni0网桥设备哟。

2解决方案

如果有节点没有cni0网卡,建议大家手动创建相应的网桥设备,但是注意网段要一致

- 手动创建cni0网卡

---> 假设 master231的flannel.1是10.100.0.0网段。

ip link add cni0 type bridge

ip link set dev cni0 up

ip addr add 10.100.0.1/24 dev cni0

---> 假设 worker232的flannel.1是10.100.1.0网段。

ip link add cni0 type bridge

ip link set dev cni0 up

ip addr add 10.100.1.1/24 dev cni0

六. 验证Pod的CNI网络是否正常

1 编写Pod资源清单

[root@master231 ~]# cat > yinzhengjie-network-cni-test.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:

name: xiuxian-v1

spec:

nodeName: worker232

containers:

- image: registry.cn-hangzhou.aliyuncs.com/yinzhengjie-k8s/apps:v1

name: xiuxian

---

apiVersion: v1

kind: Pod

metadata:

name: xiuxian-v2

spec:

nodeName: worker233

containers:

- image: registry.cn-hangzhou.aliyuncs.com/yinzhengjie-k8s/apps:v2

name: xiuxian

EOF

2.创建Pod资源

[root@master231 ~]# kubectl apply -f yinzhengjie-network-cni-test.yaml

pod/xiuxian-v1 created

pod/xiuxian-v2 created

[root@master231 ~]#

3.查看Pod资源你列表

[root@master231 ~]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

xiuxian-v1 1/1 Running 0 11s 10.100.1.2 worker232 <none> <none>

xiuxian-v2 1/1 Running 0 11s 10.100.2.4 worker233 <none> <none>

[root@master231 ~]#

4.访问worker232节点的服务

[root@master231 ~]# curl 10.100.1.2

<!DOCTYPE html>

<html>

<head>

<meta charset="utf-8"/>

<title>yinzhengjie apps v1</title>

<style>

div img {

width: 900px;

height: 600px;

margin: 0;

}

</style>

</head>

<body>

<h1 style="color: green">凡人修仙传 v1 </h1>

<div>

<img src="1.jpg">

<div>

</body>

</html>

[root@master231 ~]#

[root@master231 ~]# curl 10.100.2.4

<!DOCTYPE html>

<html>

<head>

<meta charset="utf-8"/>

<title>yinzhengjie apps v2</title>

<style>

div img {

width: 900px;

height: 600px;

margin: 0;

}

</style>

</head>

<body>

<h1 style="color: red">凡人修仙传 v2 </h1>

<div>

<img src="2.jpg">

<div>

</body>

</html>

[root@master231 ~]#

[root@master231 ~]# kubectl delete -f yinzhengjie-network-cni.yaml

pod "xiuxian-v1" deleted

pod "xiuxian-v2" deleted

[root@master231 ~]#

[root@master231 ~]# kubectl get pods

No resources found in default namespace.

[root@master231 ~]#

七.kubectl工具实现自动补全功能

1.添加环境变量

[root@master231 ~]# kubectl completion bash > ~/.kube/completion.bash.inc

[root@master231 ~]#

[root@master231 ~]# echo source '$HOME/.kube/completion.bash.inc' >> ~/.bashrc

[root@master231 ~]#

[root@master231 ~]# source ~/.bashrc

[root@master231 ~]#

2.验证自动补全功能

[root@master231 ~]# kubectl # 连续按2次tab键测试能否出现命令

alpha auth cordon diff get patch run version

annotate autoscale cp drain help plugin scale wait

api-resources certificate create edit kustomize port-forward set

api-versions cluster-info debug exec label proxy taint

apply completion delete explain logs replace top

attach config describe expose options rollout uncordon

[root@master231 ~]#

八.K8S主机巡检流程

1.查看master组件是否正常

[root@master231 ~]# kubectl get cs

Warning: v1 ComponentStatus is deprecated in v1.19+

NAME STATUS MESSAGE ERROR

controller-manager Healthy ok

scheduler Healthy ok

etcd-0 Healthy {"health":"true","reason":""}

[root@master231 ~]#

2.查看工作节点是否就绪

[root@master231 ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

master231 Ready control-plane,master 17h v1.23.17

worker232 Ready <none> 17h v1.23.17

worker233 Ready <none> 17h v1.23.17

[root@master231 ~]#

3.检查falnnel组件是否正常运行

[root@master231 ~]# kubectl get pods -n kube-flannel -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

kube-flannel-ds-9qhvd 1/1 Running 6 (15h ago) 16h 10.0.0.232 worker232 <none> <none>

kube-flannel-ds-blxw6 1/1 Running 2 (15h ago) 16h 10.0.0.233 worker233 <none> <none>

kube-flannel-ds-wwrq6 1/1 Running 2 (15h ago) 16h 10.0.0.231 master231 <none> <none>

[root@master231 ~]#

4.检查cni0和flannel网卡是否存在

若不存在则创建。

5.验证网络是否正常

[root@master231 ~]# curl 10.100.1.7

<!DOCTYPE html>

<html>

<head>

<meta charset="utf-8"/>

<title>yinzhengjie apps v1</title>

<style>

div img {

width: 900px;

height: 600px;

margin: 0;

}

</style>

</head>

<body>

<h1 style="color: green">凡人修仙传 v1 </h1>

<div>

<img src="1.jpg">

<div>

</body>

</html>

[root@master231 ~]#

[root@master231 ~]# curl 10.100.2.12

<!DOCTYPE html>

<html>

<head>

<meta charset="utf-8"/>

<title>yinzhengjie apps v2</title>

<style>

div img {

width: 900px;

height: 600px;

margin: 0;

}

</style>

</head>

<body>

<h1 style="color: red">凡人修仙传 v2 </h1>

<div>

<img src="2.jpg">

<div>

</body>

</html>

[root@master231 ~]#

6.检查集群的所有节点是否能够访问互联网

[root@master231 ~]# ping baidu.com

PING baidu.com (110.242.68.66) 56(84) bytes of data.

64 bytes from 110.242.68.66 (110.242.68.66): icmp_seq=1 ttl=128 time=11.5 ms

64 bytes from 110.242.68.66 (110.242.68.66): icmp_seq=2 ttl=128 time=12.6 ms

64 bytes from 110.242.68.66 (110.242.68.66): icmp_seq=3 ttl=128 time=11.2 ms

64 bytes from 110.242.68.66 (110.242.68.66): icmp_seq=4 ttl=128 time=11.1 ms

64 bytes from 110.242.68.66 (110.242.68.66): icmp_seq=5 ttl=128 time=11.4 ms

...

九今日作业

1.基础作业

- 完成课堂的所有练习并整理思维导图;

- 编写开机巡检脚本,要求如下:

- 1.检查各节点主机cni0网卡是否存在,若不存在,则自动创建与当前节点"flannel.1"匹配的网段。

ip a | ifconfig

- 2.检查flannel网络插件是否正常工作;

kubectl get pods -n kube-flannel -o wide

- 3.检查worker组件是否处于就绪状态;

kubectl get nodes

2.扩展作业

- 调研kind方式部署K8S集群。

本文来自博客园,作者:尹正杰,转载请注明原文链接:https://www.cnblogs.com/yinzhengjie/p/18353027,个人微信: "JasonYin2020"(添加时请备注来源及意图备注,有偿付费)

当你的才华还撑不起你的野心的时候,你就应该静下心来学习。当你的能力还驾驭不了你的目标的时候,你就应该沉下心来历练。问问自己,想要怎样的人生。

浙公网安备 33010602011771号

浙公网安备 33010602011771号