常见激活函数求导

废话少说,直接开干!

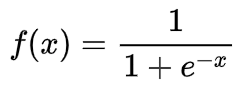

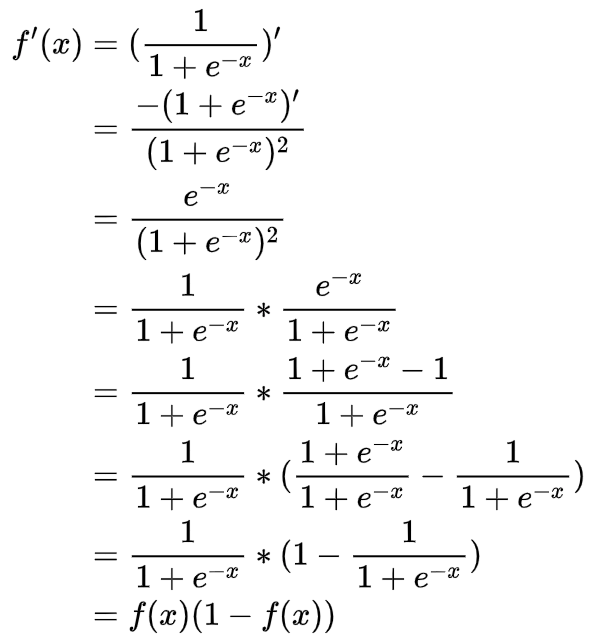

Sigmoid

函数形式

求导过程

如果求导已经还给数学老师了的话,可以参考链式法则版本:Sigmoid 函数的求导过程

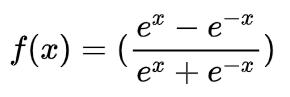

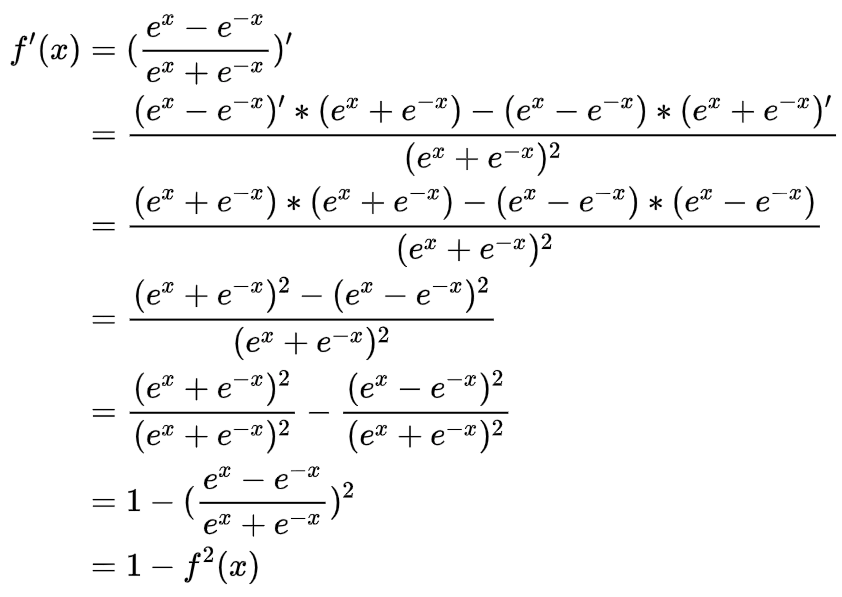

Tanh

函数形式

求导过程

链式法则求导:Tanh 激活函数及求导过程

ReLU

太简单,跳过

SoftMax

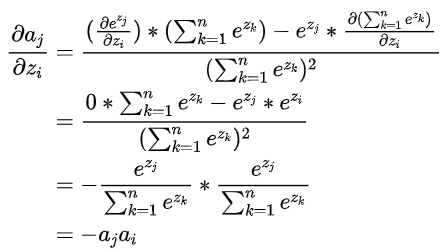

SoftMax常被用作多分类输出层的激活函数,用来将输出结果转化为概率。SoftMax数学特性很好,因为其与交叉熵损失(log损失)函数一起求导,求导结果刚好等于预测值减去label。

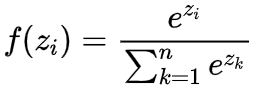

SoftMax函数形式

交叉熵损失函数形式

其中 为可能的类别数,

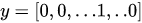

为可能的类别数, 为样本标签,通常是一个大小为N维的one-hot向量,即

为样本标签,通常是一个大小为N维的one-hot向量,即 ,只有

,只有 ,其余位置值为零。

所以损失函数又可以表示为下面的形式

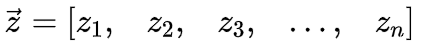

SoftMax函数的输入是一个向量

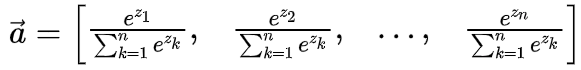

经过SoftMax函数后,输出另一个向量,且向量中所有值的和为1

我们的目标是求 损失函数 对向量

的导数,即

的导数,即 .

.

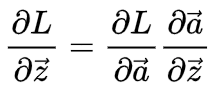

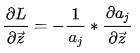

根据链式法则有:

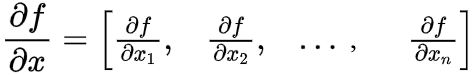

其中 是一个标量,标量对向量求导结果还是一个向量,求导公式如下:

是一个标量,标量对向量求导结果还是一个向量,求导公式如下:

和

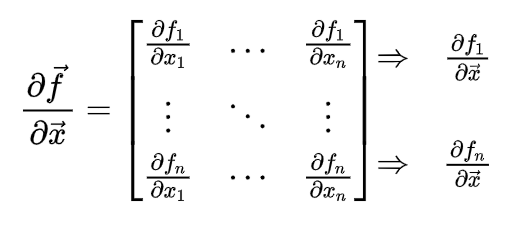

和 都是向量,向量对向量求导,结果为雅可比矩阵,求导公式如下:

都是向量,向量对向量求导,结果为雅可比矩阵,求导公式如下:

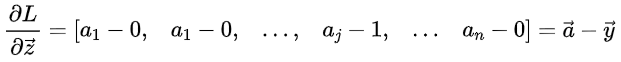

逐步求导:

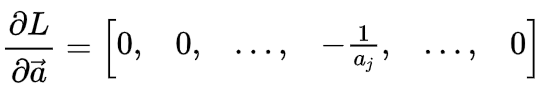

1、求

由 ,可知最终的Loss只跟

有关。

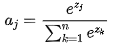

2、求

向量对向量求导的公式刚刚已经做过介绍,是一个雅可比矩阵

由于  只有第j列不为0,由矩阵乘法,其实我们只要求第j行,也即

只有第j列不为0,由矩阵乘法,其实我们只要求第j行,也即 ,

,

,其中

,其中  。

。

(1)当 时

时

(2)当 时

综上所述

推荐一个好用的 LaTeX 公式编辑器:https://www.latexlive.com/##

浙公网安备 33010602011771号

浙公网安备 33010602011771号