ollama+ open webUI 部署本地大模型

一、部署 ollama

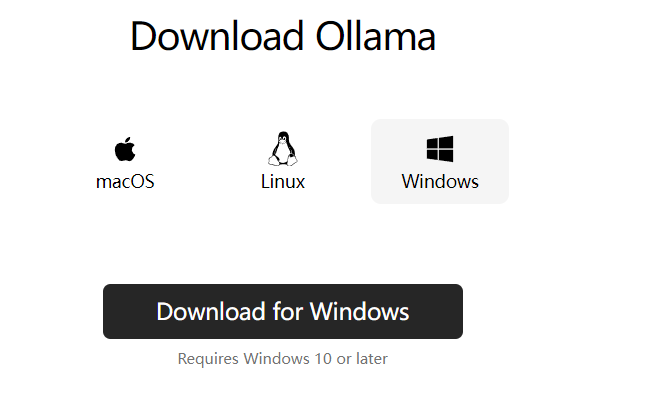

1、windows 系统

注:win10以上

1.1 下载ollama

下载地址:https://ollama.com/download/windows

1.2 安装ollama

点击下载的exe文件执行安装

1.3 验证安装结果

打开cmd,输入 ollama -v

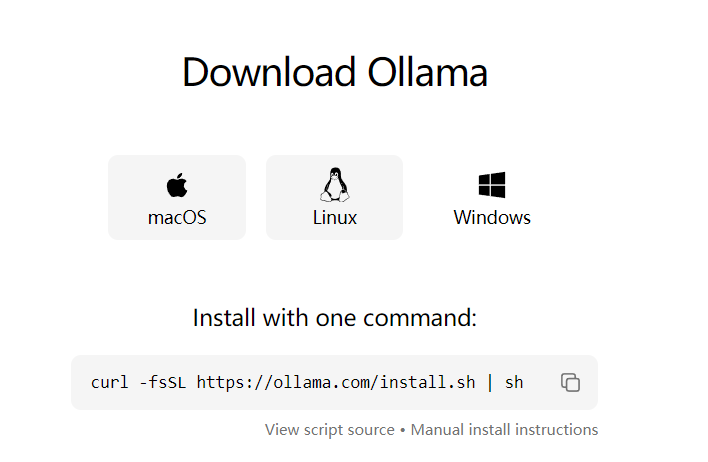

2、linux 系统

2.1 下载安装ollama

下载地址:https://ollama.com/download/linux

打开系统命令,复制上面的命令,执行

2.2 验证安装结果

输入命令 ollama -v

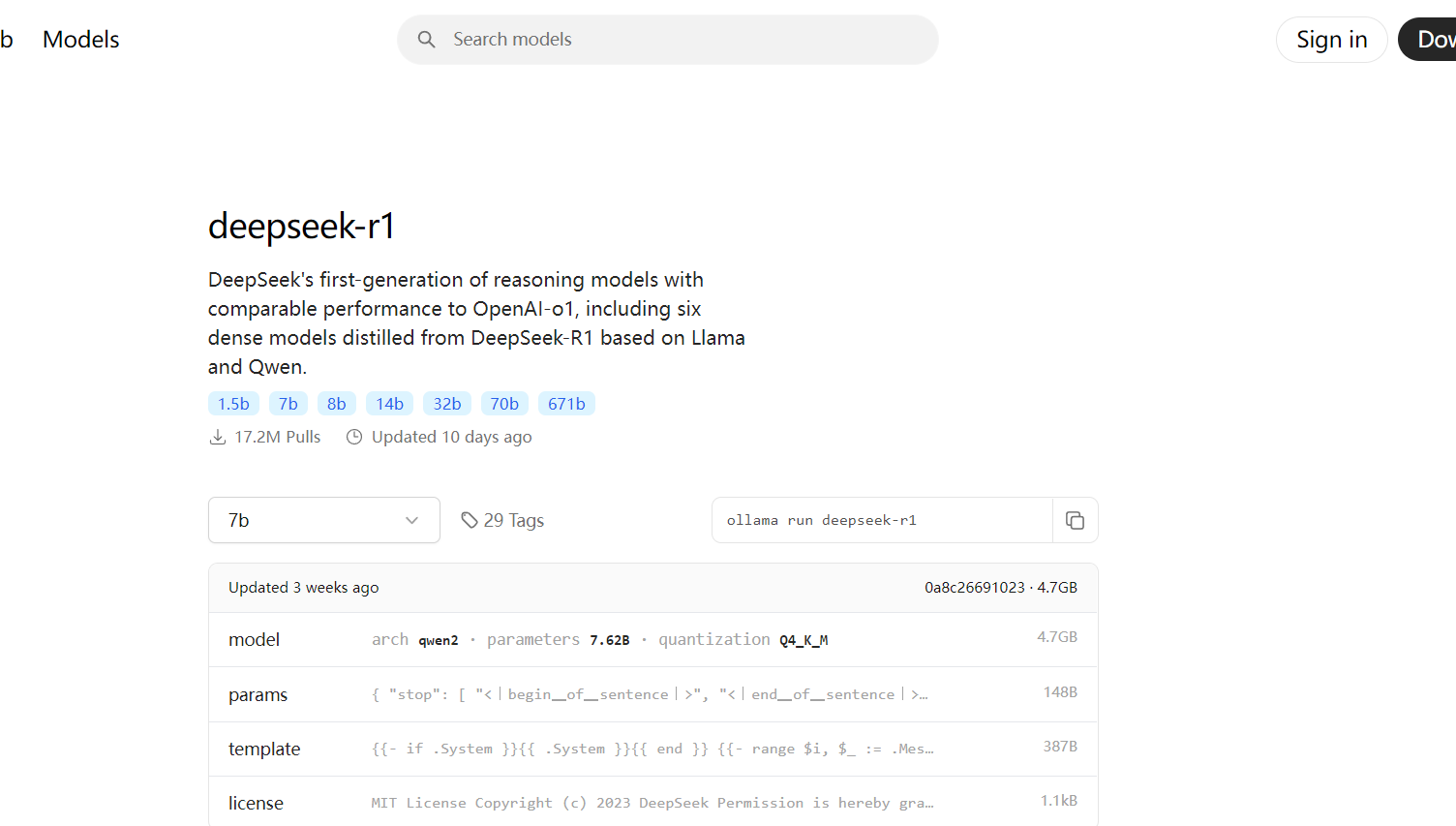

3、拉取模型

复制命令到命令窗口执行,等待下载完成

二、部署open webui

注:默认已安装好Docker

官方文档:https://docs.openwebui.com/

1、拉取 open webui 的镜像

docker pull ghcr.io/open-webui/open-webui:main

2、运行容器

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

# 卷映射(-v open-webui:/app/backend/data):确保您的数据持续存储。这样可以防止容器重新启动之间的数据丢失。

# 端口映射(-p 3000:8080):在您本地计算机的端口3000上公开WebUI。

# 对于NVIDIA GPU支持,请添加--gpus all到docker run命令:

docker run -d -p 3000:8080 --gpus all -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:cuda

# 如果 ollama 服务 不在本机

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

浙公网安备 33010602011771号

浙公网安备 33010602011771号