15 手写数字识别-小数据集

作业十二 朴素贝叶斯垃圾邮件(实习忙忘了)

1. 读邮件数据集文件,提取邮件本身与标签。

列表

numpy数组

代码:

import numpy as np

import csv

p =r"SMSSpamCollection"

sms= open(p,'r',encoding='utf-8')

data=csv.reader(sms,delimiter = "\t")

for i in data:

print(i)

sms.close()

2.邮件预处理

- 邮件分句

- 名子分词

- 去掉过短的单词

- 词性还原

- 连接成字符串

- 传统方法来实现

- nltk库的安装与使用

pip install nltk

import nltk

nltk.download() # sever地址改成 http://www.nltk.org/nltk_data/

或

https://github.com/nltk/nltk_data下载gh-pages分支,里面的Packages就是我们要的资源。

将Packages文件夹改名为nltk_data。

或

网盘链接:https://pan.baidu.com/s/1iJGCrz4fW3uYpuquB5jbew 提取码:o5ea

放在用户目录。

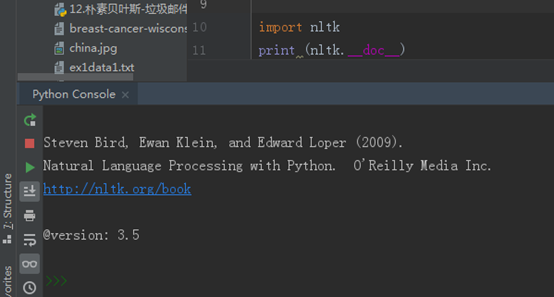

安装完成,通过下述命令可查看nltk版本:

import nltk

print nltk.__doc__

![]()

安装:

2.1 nltk库 分词

nltk.sent_tokenize(text) #对文本按照句子进行分割

nltk.word_tokenize(sent) #对句子进行分词

2.2 punkt 停用词

from nltk.corpus import stopwords

stops=stopwords.words('english')

*如果提示需要下载punkt

nltk.download(‘punkt’)

或 下载punkt.zip

https://pan.baidu.com/s/1OwLB0O8fBWkdLx8VJ-9uNQ 密码:mema

复制到对应的失败的目录C:\Users\Administrator\AppData\Roaming\nltk_data\tokenizers并解压。

2.3 NLTK 词性标注

nltk.pos_tag(tokens)

2.4 Lemmatisation(词性还原)

from nltk.stem import WordNetLemmatizer

lemmatizer = WordNetLemmatizer()

lemmatizer.lemmatize('leaves') #缺省名词

lemmatizer.lemmatize('best',pos='a')

lemmatizer.lemmatize('made',pos='v')

一般先要分词、词性标注,再按词性做词性还原。

2.5 编写预处理函数

def preprocessing(text):

sms_data.append(preprocessing(line[1])) #对每封邮件做预处理

3. 训练集与测试集

4. 词向量

5. 模型

import nltk

from nltk.corpus import stopwords

from nltk.stem import WordNetLemmatizer

import csv

def preprocessing(text):

tokens = [];

# 1.对录入的文本按照句子进行分割;

for sent in nltk.sent_tokenize(text):

# 2.对句子进行分词;

for word in nltk.word_tokenize(sent):

# 存放如token中

tokens.append(word)

#3.去除停用词(如i\me\my)

stops=stopwords.words("english")

tokens = [token for token in tokens if token not in stops]

#4.大小写转换,并去掉短于3的词

tokens=[token.lower() for token in tokens if len(token) >=3]

#NLTK词性标注(

nltk.pos_tag(tokens)

#5.词性还原Lemmatisation

# 定义还原对象

lemmatizer=WordNetLemmatizer()

# 名词

tokens=[lemmatizer.lemmatize(token,pos='n')for token in tokens]

# 动词

tokens=[lemmatizer.lemmatize(token,pos='v')for token in tokens]

# 形容词

tokens=[lemmatizer.lemmatize(token,pos='a')for token in tokens]

# 返回处理完成后的文本

return tokens;

#数据读取

a=open("SMSSpamCollection",'r',encoding='utf-8')

a_data=[]

a_label=[]

csv_reader=csv.reader(a,delimiter='\t')

for line in csv_reader: #预处理

a_label.append(line[0])

a_data.append(preprocessing(line[1]))

a.close()

#标题

print("标题内容:",a_label)

#处理后的邮件内容

print("处理后内容:")

for i in a_data:

print(i)

15 手写数字识别-小数据集

1.手写数字数据集

- from sklearn.datasets import load_digits

- digits = load_digits()

#手写数字数据集

# import tensorflow

# tensorflow.__version__

from sklearn.datasets import load_digits

import numpy as np

import pandas as pd

from sklearn.preprocessing import MinMaxScaler

from sklearn.preprocessing import OneHotEncoder

digits = load_digits()

X_data = digits.data.astype(np.float32)

Y_data = digits.target.astype(np.float32).reshape(-1,1)#将Y_data变为一列

2.图片数据预处理

- x:归一化MinMaxScaler()

- y:独热编码OneHotEncoder()或to_categorical

- 训练集测试集划分

- 张量结构

![]()

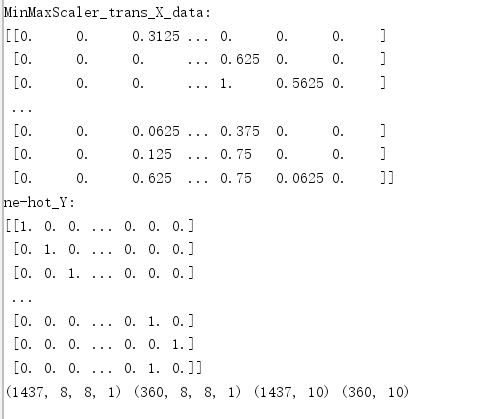

#图片数据预处理

# 将属性缩放到一个指定的最大和最小值(通常食0-1)之间

scaler = MinMaxScaler()

X_data = scaler.fit_transform(X_data)

print('MinMaxScaler_trans_X_data:')

print(X_data)

Y = OneHotEncoder().fit_transform(Y_data).todense() # one-hot编码

print('ne-hot_Y:')

print(Y)

# 转换为图片的格式(batch,height,width,channels)

X = X_data.reshape(-1, 8, 8, 1)

from sklearn.model_selection import train_test_split

X_train, X_test, Y_train, Y_test = train_test_split(X, Y, test_size=0.2, random_state=0, stratify=Y)

print(X_train.shape, X_test.shape, Y_train.shape, Y_test.shape)

3.设计卷积神经网络结构

- 绘制模型结构图,并说明设计依据。

#设计卷积神经网络结构

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Dropout, Flatten, Conv2D, MaxPool2D

# 建立模型

model = Sequential()

ks = (3, 3) # 卷积核的大小

input_shape = X_train.shape[1:]

# 一层卷积,padding='same',tensorflow会对输入自动补0

model.add(Conv2D(filters=16, kernel_size=ks, padding='same', input_shape=input_shape,

activation='relu')) # 第一层输入数据的shape要指定外,其他层的数据的shape框架会自动推导

# 池化层1

model.add(MaxPool2D(pool_size=(2, 2)))

# 防止过拟合,随机丢掉连接

model.add(Dropout(0.25))

# 二层卷积

model.add(Conv2D(filters=32, kernel_size=ks, padding='same', activation='relu'))

# 池化层2

model.add(MaxPool2D(pool_size=(2, 2)))

model.add(Dropout(0.25))

# 三层卷积

model.add(Conv2D(filters=64, kernel_size=ks, padding='same', activation='relu'))

# 四层卷积

model.add(Conv2D(filters=128, kernel_size=ks, padding='same', activation='relu'))

# 池化层3

model.add(MaxPool2D(pool_size=(2, 2)))

model.add(Dropout(0.25))

# 平坦层

model.add(Flatten())

# 全连接层

model.add(Dense(128, activation='relu'))

model.add(Dropout(0.25))

# 激活函数softmax

model.add(Dense(10, activation='softmax'))

model.summary()

model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

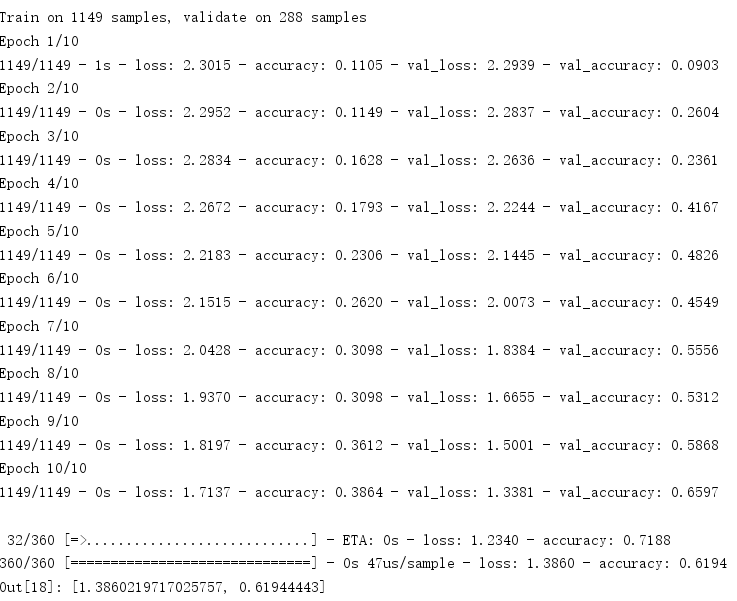

train_history = model.fit(x=X_train, y=Y_train, validation_split=0.2, batch_size=300, epochs=10, verbose=2)

score = model.evaluate(X_test, Y_test)

score

4.模型训练

#模型训练

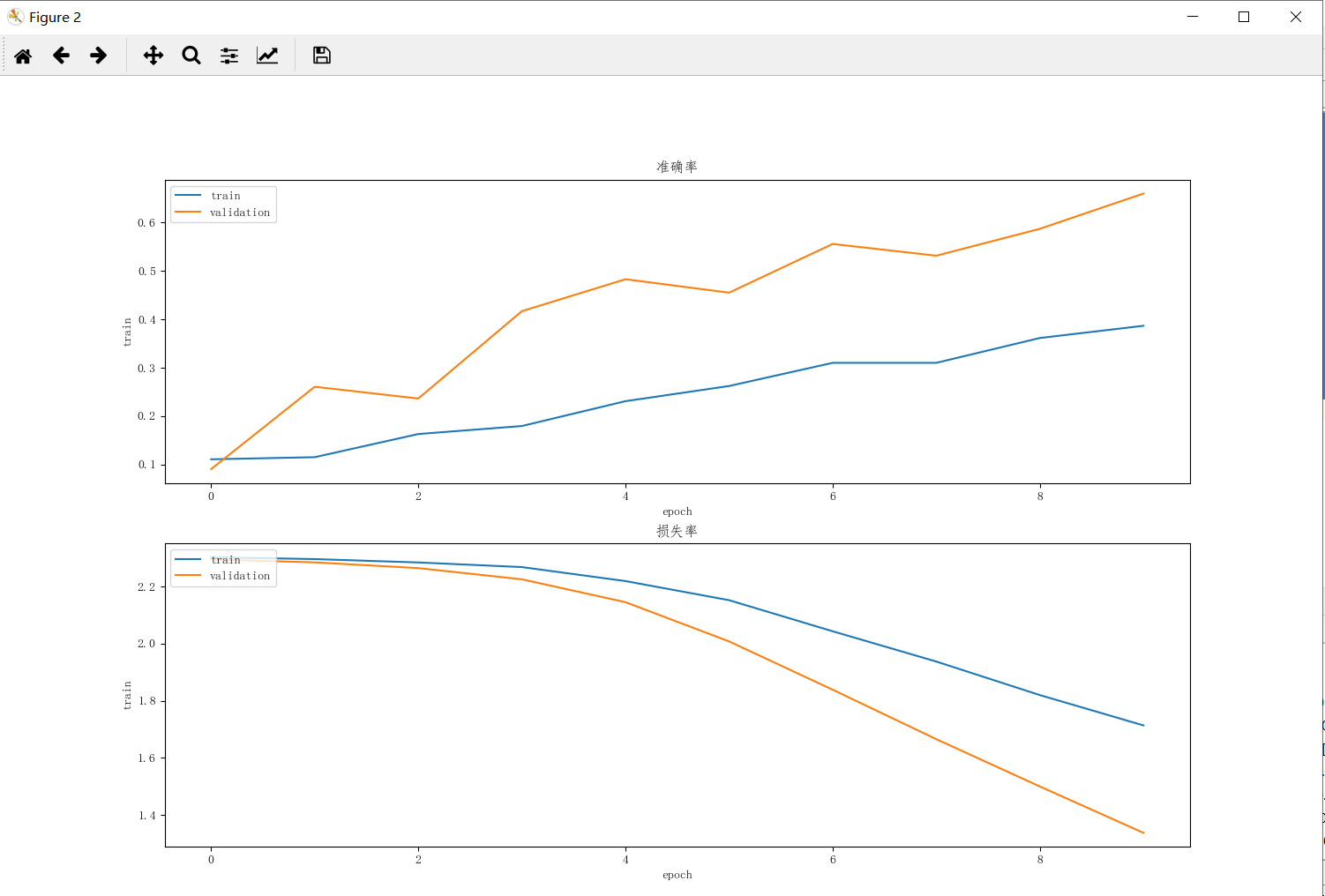

import matplotlib.pyplot as plt

from pylab import mpl

mpl.rcParams['font.sans-serif'] = ['FangSong'] # 指定字体

def show_train_history(train_history, train, validation):

plt.plot(train_history.history[train])

plt.plot(train_history.history[validation])

plt.title('Train History')

plt.ylabel('train')

plt.xlabel('epoch')

plt.legend(['train', 'validation'], loc='upper left')

plt.show()

p = plt.figure(figsize=(15, 15))

a1 = p.add_subplot(2, 1, 1)

show_train_history(train_history, 'accuracy', 'val_accuracy')

plt.title("准确率")

a2 = p.add_subplot(2, 1, 2)

show_train_history(train_history, 'loss', 'val_loss')

plt.title("损失率")

plt.show()

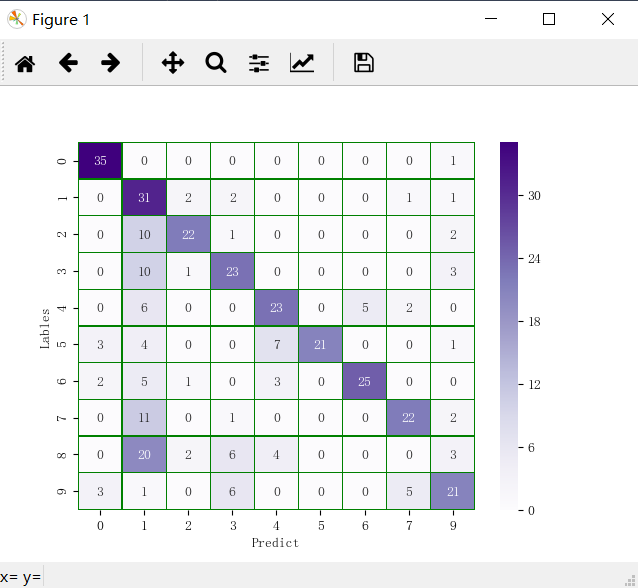

5.模型评价

- model.evaluate()

- 交叉表与交叉矩阵

- pandas.crosstab

- seaborn.heatmap

#模型评价

import seaborn as sns

score = model.evaluate(X_test, Y_test)

print('score:', score)

# 预测值

y_pred = model.predict_classes(X_test)

print('y_pred:', y_pred[:10])

# 交叉表与交叉矩阵

y_test1 = np.argmax(Y_test, axis=1).reshape(-1)

y_true = np.array(y_test1)[0]

# 交叉表查看预测数据与原数据对比

pd.crosstab(y_true, y_pred, rownames=['true'], colnames=['predict'])

# 交叉矩阵

y_test1 = y_test1.tolist()[0]

a = pd.crosstab(np.array(y_test1), y_pred, rownames=['Lables'], colnames=['Predict'])

df = pd.DataFrame(a)

sns.heatmap(df, annot=True, cmap="Reds", linewidths=0.2, linecolor='G')

plt.show()

浙公网安备 33010602011771号

浙公网安备 33010602011771号