23.4.3 文献总结——轻量化图像超分

2020 ECCV LatticeNet: Towards Lightweight Image Super-resolution with Lattice Block

LatticeNet的主要贡献为:

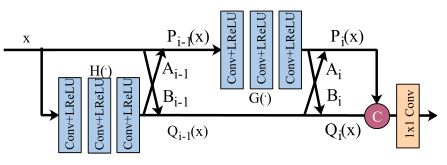

1.提出双碟形结构的Lattice Block,如下图所示。自适应地学习残差连接的权重,Lattice Block 可以替换各种网络中的Residual Block。

2.Lattice Block 通过注意机制自适应地将各Residual Block 的可学习组合系数进行组合,提高了特征映射的重要通道权重,从而获得更好的SR性能。

残差连接的自适应权重通过通道注意力机制学习得来,如下图所示。一条通路使用平均池化,一条通路使用标准差池化,最后二者求平均得到权重参数。

3.Lattice Block 可以替换各种网络中的Residual Block,从而将参数量减少大约一半,同时获得相当的性能。

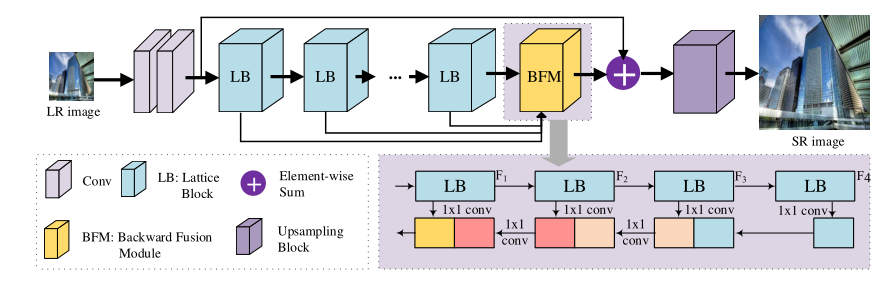

网络总体结构图如下图所示。

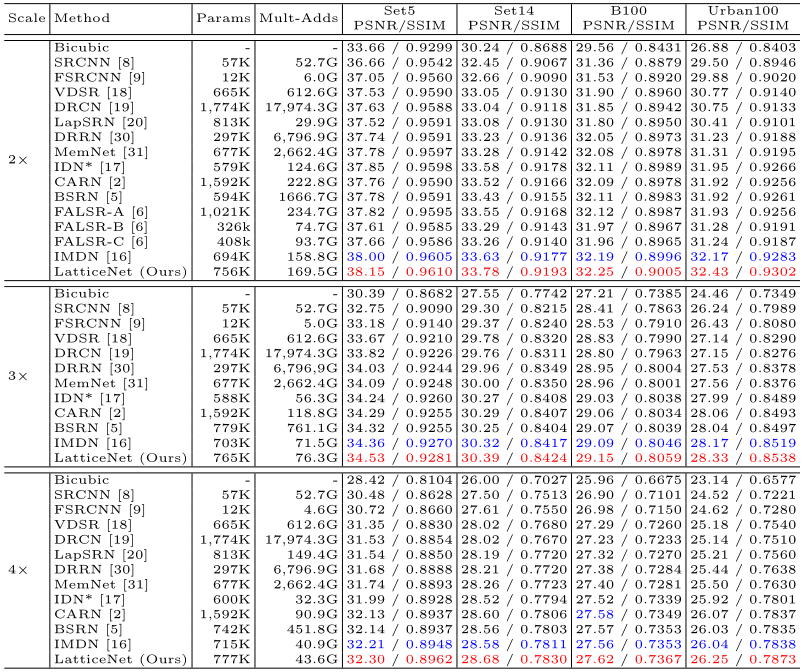

训练数据采用了随机翻转和旋转的数据增强方法。除了Params,还使用了Multi-Adds来比较模型的轻量化。Multi-Adds用于评估模型的计算复杂度,表示处理单张图像的累乘操作的次数。这里的Multi-Adds是采用1280x720大小的图像作为目标图像来计算的。实验结果如下图所示。

2021 MM Edge-oriented Convolution Block for Real-time Super Resolution on Mobile Devices

ECBSR的主要贡献为:

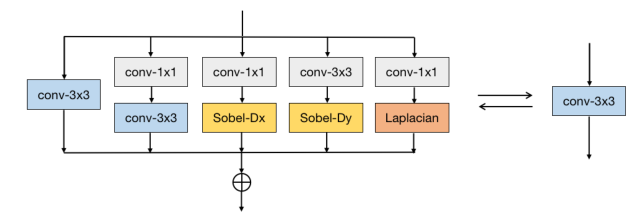

1.首次在SR任务上使用re-parameterizable技术,并提出了 Edge-oriented Convolution Block (ECB)。ECB在提高性能的同时,不会在推理时引入额外的计算负担。

ECB如下图所示。使用re-parameterizable:训练时使用多分支训练,推理时合成单个卷积。

2.在ECB的基础上,进一步提出特别高效和轻量化的SR模型ECBSR,可以用于移动设备上的实时SISR。

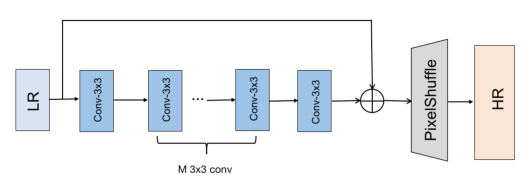

网络结构如下图所示。没有使用BN层,因为它会降低SR的性能。

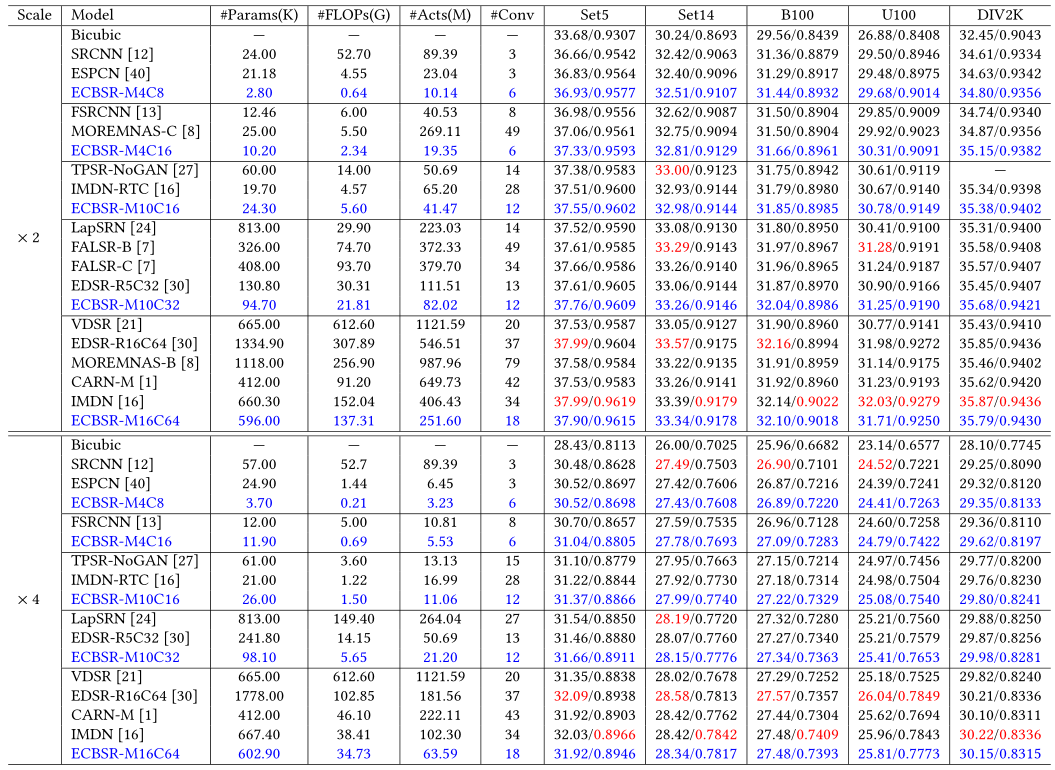

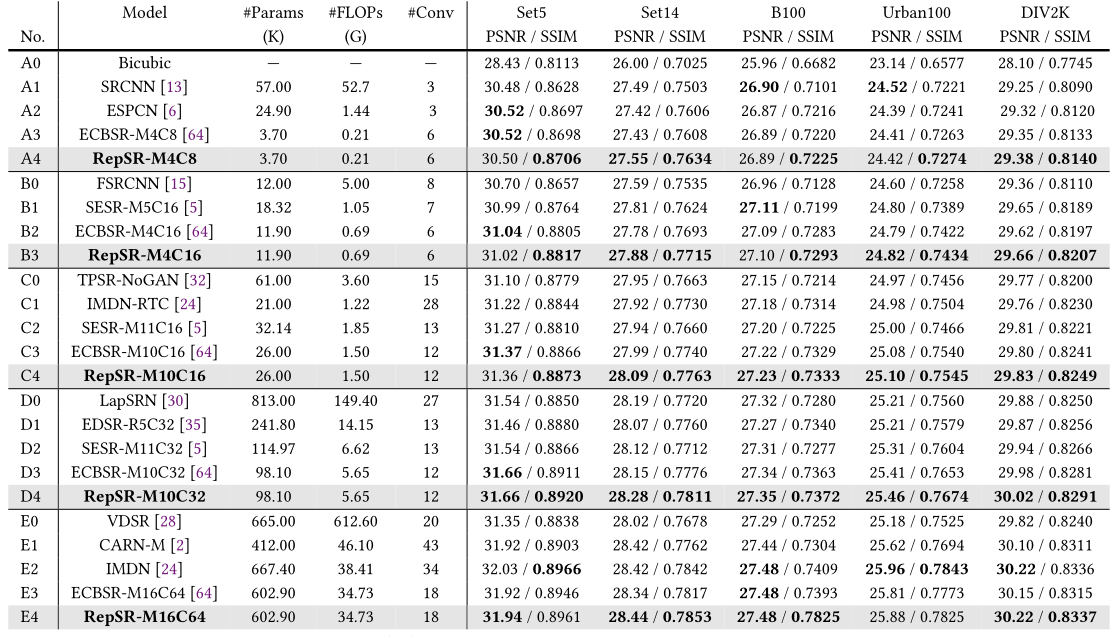

实验结果如下图所示。

除了Params和FLOPs之外,还使用了Act来衡量模型的轻量化。因为最近的研究证明了激活层的数量(Act)在评估模型效率上是比Params和FLOPs更好的指标。

采用了90°,180°,270°的随机旋转和水平翻转的数据增强方法。

2022 MM RepSR: Training Efficient VGG-style Super-Resolution Networks with Structural Re-Parameterization and Batch Normalization

主要贡献如下:

1.分析了BN在SR任务里的作用,以及以前的BN降低SR性能的原因。

以前的工作通常时直接正在网络结构中去除BN,因为BN不仅降低性能,而且带来伪影。这个伪影只在测试时出现,而不会训练过程中的验证集数据中出现。

作者通过一系列实验发现:BN对SR任务带来不利影响是由于训练集和测试集分布上的不一致性。

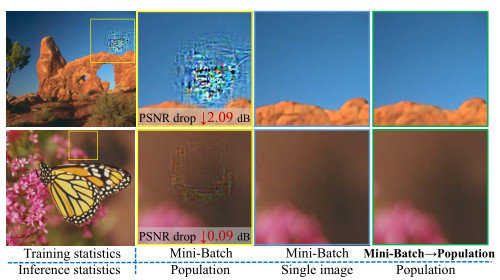

从下图中可以看出,在训练时使用mini-batch的统计特性归一化,在测试时使用训练集的总体统计特性归一化,会造成严重的性能损失和伪影。但如果测试时使用单张图片的统计特性归一化,伪影显著减少。这表明了BN对SR产生不利影响是由于训练集-测试集分布的不一致性。

作者提出frozen BN,即在训练的前期首先用小批量统计数据来训练SR网络,在训练的后期转而使用population数据。

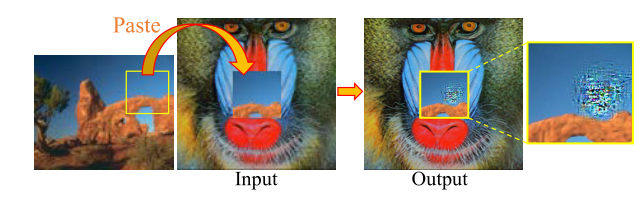

如下图所示。从问题图像中裁剪LRpatch,其输出有严重的BN伪影。然后将这个贴片粘贴到狒狒LR图像的中心,其输出明显很好,没有伪影。接着将合并后的图像通过SR网络。有趣的是,伪影仍然存在于粘贴的平滑patch上,而左侧patch不受影响。似乎这些“有问题的”patch产生了异常的特征统计数据作为它们自身的特征。由于SR网络更多地关注本地处理,并从头到尾保持空间信息(即不像识别等任务提取特征时通常会增加通道数),有问题的patch总是会产生BN伪影,无论它们是单独产生的还是与其他patch一起产生的。

2.将BN重新引入SR任务中。

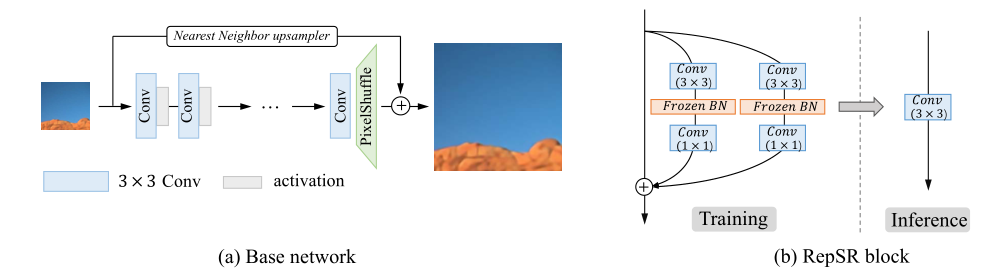

与ECBSR一样采用了re-parameterizable:

re-parameterizable是在训练时使用多分支结构,并在测试时转换成一个普通网络。

作者认为其他的activation function 并不能替代BN,因为其他的activation function不能像BN一样在re-parameterizable中合并入一个卷积中。

网络结构如下图所示。

实验结果:

浙公网安备 33010602011771号

浙公网安备 33010602011771号