什么关系就是Dify: Step2 Dify模型配置 && Dify, Docker,ollama

通过最近的环境安装,形成了下面的概念,有不准确的地方,欢迎大家一起讨论~

目录

概念厘清

Dify:简单来说,Dify是一个工具,可以模拟我们的工作流程,我们把工作任务拆分成不同的工作步骤,经过dyfi模拟这个完整的步骤,得到我们想要的结果。

Docker:可以理解成一个箱子,能够创建一个独立的空间,将运行在其内部的脚本与电脑的其他部分隔离开来,保障安全,便于管理。

Dify与Docker:Dify的运行需要环境,所谓的环境是指Dify 的完整运行依赖多个服务组件(比如API服务,数据库等),这些组件之间要相互配合又各自独立,而Docker能帮我们一键生成该环境,让Dify运行起来(docker compose up -d )。

Dify与ollama一个模型管理工具和平台,它提供了很多国内外常见的模型。我们可以通过Ollama统一部署、管理、运行大模型。就是:Dify在模拟工作流程的过程中,需要使用大数据模型,ollama

- 搜索模型:

通过大家能够在其官网上搜索自己必须的模型:https://ollama.com/search

- 模型下载(直接在终端中执行):ollama pull 模型名

- 模型运行(直接在终端中执行):ollama run 模型名

Docker与Ollama与Dify通过:Ollama可以安装在本地磁盘中,也可以安装在Docker中。Docker中的Dify能够调用Ollama,无论是本地磁盘中的,还是其他Docker中的。

当前启用调整是:Dify 借助Docker部署,而Ollama 是运行在本地电脑的,得让Dify能访问Ollama 的服务。为此,在Dify项目-docker-(Dify/Docker)找到.env文件,在末尾加上下面的配置,构建Dify对Ollama的访问:

# 启用自定义模型

CUSTOM_MODEL_ENABLED=true

# 指定 Ollama 的 API地址(根据部署环境调整IP)

OLLAMA_API_BASE_URL=host.docker.internal:11434Dify中配置模型

在Dify中调整模型时,遵循以下步骤

1. 安装桌面版本Ollama(下载地址:https://ollama.com/download)

2.在本地Ollama部署模型:

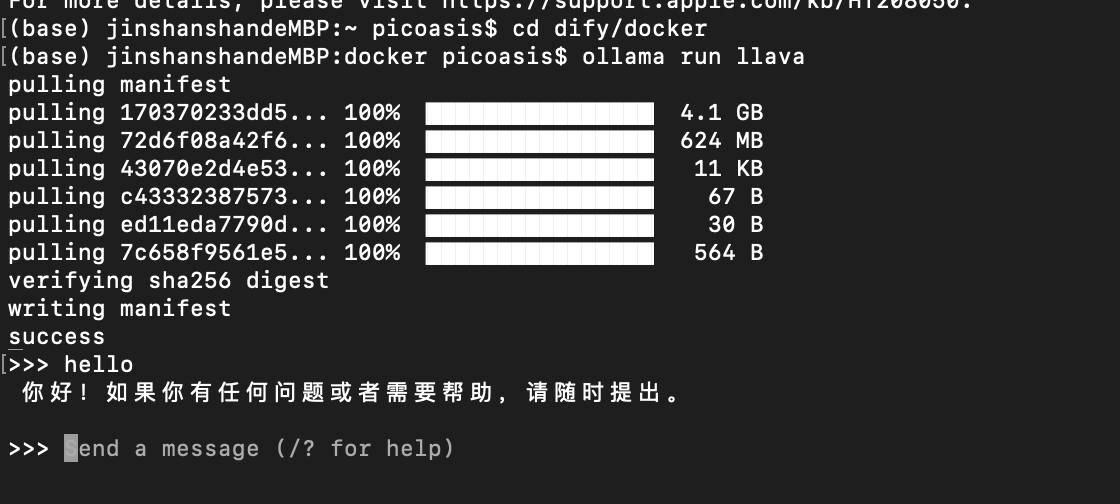

安装llava:ollama run llava

安装deepseek:ollama run deepseek-r1:7b(有多个版本,按需选择)

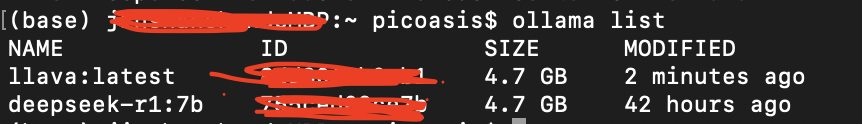

查看已安装的模型:ollama list

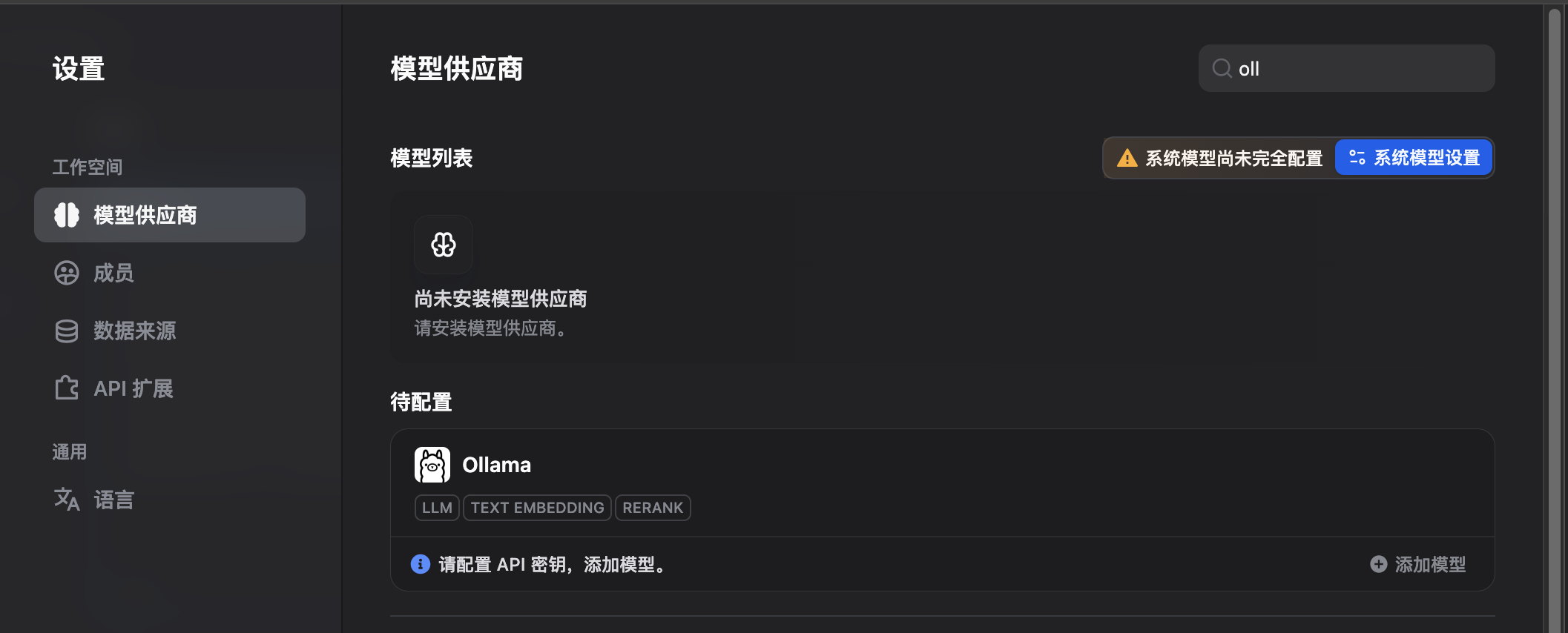

3.在“模型供应商”中搜索Ollama,安装Ollama。

4.在模型列表中,选择Ollama,点击“添加模型”。

5.在配置模型时,需要注意的是,URL与在Dify的.env文档中配备的相同,模型名称需要与终端中查到的Name相同(Ollama依靠名称Name区分其内部不同的模型)。

模型配置完成后如下:

参考链接:

2. 【全网最全最详细】Ollama本地部署DeepSeek-R1

3.本地搭建AI开发平台Dify并使用Ollama添加大语言模型保姆级教程

END

浙公网安备 33010602011771号

浙公网安备 33010602011771号