Linux 搭建MongoDB复制集群

一、介绍

1、节点类型

主节点(Primary):负责处理客户端的请求。可读可写

从节点(Secondary):负责复制主节点上的数据。可读不可写

仲裁节点(Arbiter):不保留任何数据,只具有投票选举作用。不可读不可写

MongoDB实现复制集群至少需要两个节点(一主一从),仲裁节点为可选,但一般会一起作用

2、主从复制方式

从节点定期轮询从主节点操作日志中获取操作记录,然后对自己的数据副本执行这些操作,从而保证从节点的数据与主节点一致

二、环境准备

虚拟机三台,分别安装好MongoDB。服务网格信息如下:

| 主机名 | 操作系统 | IP | Node | 端口 |

| vm-xwj100 | Centos7.6 | 192.168.20.100 | Primary | 27017 |

| vm-xwj101 | Centos7.6 | 192.168.20.101 | Secondary | 27017 |

| vm-xwj102 | Centos7.6 | 192.168.20.102 | Arbiter | 27017 |

三、应用配置

在100/101/102机器上,新建对应的目录,然后添加复制集的配置文件:mongo.conf :

#数据保存路径 dbpath=/usr/local/mongo/data/db/ #日志保存路径 logpath=/usr/local/mongo/logs/mongo.log #进程描述文件 pidfilepath=/usr/local/mongo/pids/mongo.pid #日志追加写入 logappend=true #复制集名称 replSet=rs0 bind_ip_all=true #mongo默认端口 port=27017 #操作日志容量 oplogSize=10000 #开启子进程 fork=true

四、初始化复制集群

1、在所有节点启动 mongod 服务

/usr/local/mongo/bin/mongod -f /usr/local/mongo/conf/mongo.conf

2、登录客户端,访问主节点

/usr/local/mongo/bin/mongo --host 192.168.20.100 --port 27017

3、初始化复制集

rs.initiate({ _id:"rs0", members:[ {_id:0, host:"192.168.20.100:27017", priority:2}, {_id:1, host:"192.168.20.101:27017", priority:1}, {_id:2, host:"192.168.20.102:27017", arbiterOnly:true} ] });

_id: "rs0": 复制集名称,与配置文件对应

priority: 权重(数字越大优先级越高)

arbiterOnly: 是否是仲裁节点

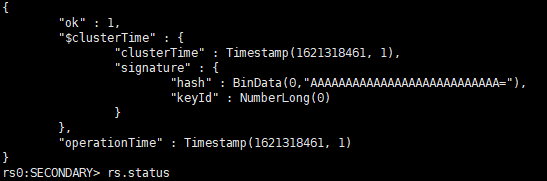

执行成功后,如下所示(命令行符号由 > 变为 rs0:SECONDARY>,然后会进行选举,最终变成rs0:Primary>):

4、查看复制集状态

rs.status()

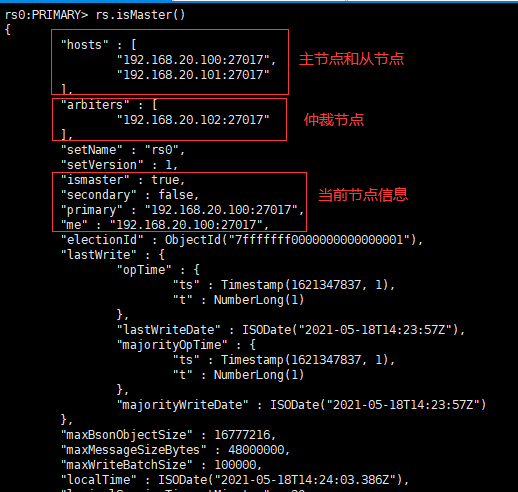

5、查看当前节点是否为主节点

rs.isMaster()

五、测试

1、测试主节点宕机

ps -ef | grep mongod #查询主节点mongod进程 kill -9 pid #杀掉主节点mongod进程 /usr/local/mongo/bin/mongo --host 192.168.20.101 --port 27017 #连接从节点 rs.isMaster(); #查看当前节点是否为Primary节点 /usr/local/mongo/bin/mongod -f /usr/local/mongo/conf/mongo.conf #重新启动原主节点 /usr/local/mongo/bin/mongo --host 192.168.20.100 --port 27017 #重新连接原主节点

rs.isMaster(); #查看当前节点是否为Primary节点

结论:当主节点宕机后,仲裁节点会根据配置信息中的权重值优先选举权重高的节点作为主节点继续提供服务。当宕机的主节点恢复后,复制集会恢复原主节点状态,临时主节点重新成为从节点。

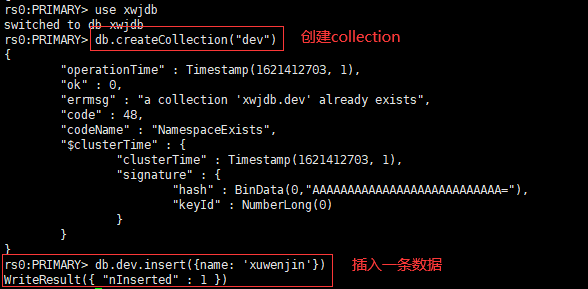

2、测试主从同步

在主节点创建collection,然后插入一条数据:

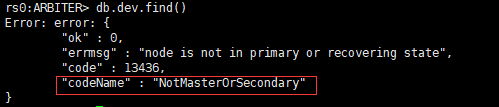

在从节点上读写数据:

在仲裁节点上查询数据:

结论:主节点上的数据会同步给从节点,不会同步给仲裁节点

六、踩坑

1、初始化时,报如下错误:

"errmsg" : "replSetInitiate quorum check failed because not all proposed set members responded affirmatively: 192.168.20.101:27017 failed

with Error connecting to 192.168.20.101:27017 :: caused by :: No route to host, 192.168.20.102:27017 failed with Error connecting to

192.168.20.102:27017 :: caused by :: No route to host", "code" : 74, "codeName" : "NodeNotFound",

问题原因:初始化复制集群时,用的三台机器,主节点想连通其它节点,需要关闭防火墙

解决办法:在从节点和仲裁节点上,关闭防火墙:systemctl stop firewalld

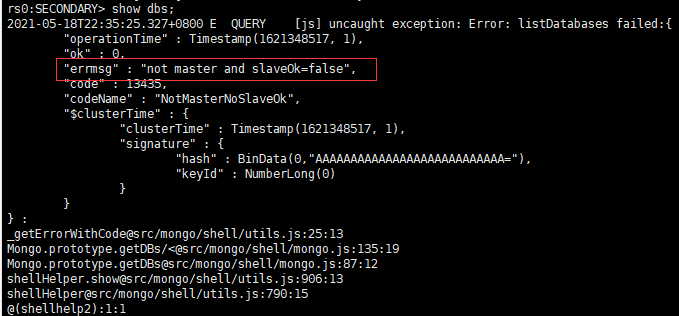

2、在从节点上读取数据失败,报如下错误:

问题原因:默认情况下直接连从节点是无法查询数据的。因为从节点是不可读的

解决办法:开启从节点读权限。在从节点客户端输入命令 rs.slaveOk(true)

浙公网安备 33010602011771号

浙公网安备 33010602011771号