【网络编程】什么是Netty?一篇文章吃透高性能网络框架

目录

- 一、Netty的核心竞争力(为什么选择它?)

- 传统Java BIO/NIO的致命缺陷

- 1. 阻塞IO的致命瓶颈

- 2. 多路复用技术破局

- 3. C10K问题的工程实践

- Netty的5大杀手锏

- 1. 事件驱动模型

- 2. 零拷贝技术

- 3. 百万级并发架构

- 4. 模块化设计

- 5. 社区生态

- 二、底层架构三剑客(解剖核心机制)

- Reactor线程模型

- 1. 核心架构

- 2. 三级线程池详解

- 3. 工作原理

- ByteBuf黑科技

- 1. 池化内存管理

- 2. 读写指针分离

- 3. 复合缓冲区设计

- 4. 对比Java NIO Buffer的缺陷

- Pipeline责任链

- 1. 核心设计理念

- 2. 代码示例解析

- 3. Handler类型与分工

- 4. 对比传统处理模式

- 5. 高级用法示例

- 6. 实战场景

- 三、关键组件实战指南

- 1. ServerBootstrap配置模板

- 2. ChannelHandler开发规范

- 2.1 生命周期管理

- 2.2 @Sharable注解陷阱

- 2.3 异常传播机制

- 四、避坑指南(来自官方Issue分析)

- 1. 内存泄漏检测

- 1.1 ResourceLeakDetector等级设置

- 1.2 ByteBuf.refCnt()调试技巧

- 2. 线程阻塞红线

- 2.1 EventLoop禁止同步操作

- 2.2 业务逻辑必须异步化

- 3. 性能调优参数

- 3.1 SO_BACKLOG

- 3.2 WRITE_BUFFER_WATER_MARK 水位线设置

- 4. 实战场景

- 推荐阅读

- 1.官方资源

- 2.经典书籍

- 3.在线资源

一、Netty的核心竞争力(为什么选择它?)

Netty 之所以成为网络编程的热门选择,具备多方面核心竞争力。它性能卓越,通过精心设计的线程模型和 I/O 操作优化,能显著提升数据处理速度与吞吐量,大幅降低延迟。其可靠性极高,内建完善的连接管理、异常处理机制,确保网络应用在复杂环境下稳定运行。Netty 还具备出色的可扩展性,基于灵活的组件化架构,开发者可按需定制和扩展功能,轻松应对不同规模与需求的项目。此外,它支持丰富的网络协议,极大减少开发人员在协议处理上的工作量,加速开发进程,为构建高性能、稳定且功能丰富的网络应用提供有力支撑。

传统Java BIO/NIO的致命缺陷

1. 阻塞IO的致命瓶颈

工作原理:

每个客户端连接需独占一个线程,线程在read()/write()操作时被阻塞,无法响应其他请求。

// 传统BIO服务端伪代码

ServerSocket server = new ServerSocket(8080);

while (true) {

Socket client = server.accept(); // 阻塞点

new Thread(() -> {

InputStream in = client.getInputStream();

in.read(); // 阻塞点(线程闲置浪费)

// 处理业务逻辑

}).start();

}

C10K场景下的崩溃:

-

资源耗尽: 1万个连接需1万个线程,线程栈内存(默认1MB/线程)直接耗尽JVM内存。

-

CPU空转: 大量线程因阻塞频繁切换上下文,CPU利用率>90%但吞吐量几乎为零。

-

典型案例: 早期Web服务器在用户量突增时瘫痪。

2. 多路复用技术破局

核心思想:

通过Selector机制监控多个Channel的事件(连接、读、写),单线程可管理上万连接。

Java NIO实现示例:

Selector selector = Selector.open();

ServerSocketChannel ssc = ServerSocketChannel.open();

ssc.bind(new InetSocketAddress(8080));

ssc.configureBlocking(false);

ssc.register(selector, SelectionKey.OP_ACCEPT); // 注册监听事件

while (true) {

selector.select(); // 阻塞直到有事件就绪

Set<SelectionKey> keys = selector.selectedKeys();

Iterator<SelectionKey> iter = keys.iterator();

while (iter.hasNext()) {

SelectionKey key = iter.next();

if (key.isAcceptable()) {

// 处理新连接(无需创建新线程)

SocketChannel client = ssc.accept();

client.configureBlocking(false);

client.register(selector, SelectionKey.OP_READ);

} else if (key.isReadable()) {

// 非阻塞读取数据

SocketChannel client = (SocketChannel) key.channel();

ByteBuffer buffer = ByteBuffer.allocate(1024);

client.read(buffer); // 非阻塞,立即返回

// 处理业务逻辑

}

iter.remove();

}

}

性能对比:

| 指标 | 阻塞IO | 多路复用 |

|---|---|---|

| 线程数 | O(N) | O(1) |

| 内存消耗 | 1MB*N | 固定几MB |

| 10K连接CPU占用 | >90% | <15% |

| 吞吐量 | <100 QPS | 10万+ QPS |

3. C10K问题的工程实践

Netty的解决方案:

-

Reactor三级线程模型:

BossGroup接收连接+WorkerGroup处理IO+业务线程池异步计算。 -

对象池化技术: 重用

ByteBuf、ChannelHandlerContext等对象,减少GC压力。 -

零拷贝优化: 通过

CompositeByteBuf合并内存,避免JVM堆与Native内存复制。

实战场景:

-

案例1:实时风控系统

要求同时监控10万+设备数据流。使用Netty后,单节点维持12万长连接,时延<5ms。 -

案例2:证券交易网关

高峰期每秒处理8万笔订单。通过EventLoopGroup划分优先级通道,关键路径无阻塞。

// Netty服务端线程模型配置

EventLoopGroup bossGroup = new NioEventLoopGroup(1); // 1个Acceptor线程

EventLoopGroup workerGroup = new NioEventLoopGroup(); // CPU核心数*2个IO线程

new ServerBootstrap()

.group(bossGroup, workerGroup)

.channel(NioServerSocketChannel.class)

.childHandler(new ChannelInitializer<SocketChannel>() {

@Override

protected void initChannel(SocketChannel ch) {

ch.pipeline().addLast(new IdleStateHandler(60, 0, 0)); // 心跳检测

ch.pipeline().addLast(new OrderDecoder()); // 协议解码

ch.pipeline().addLast(new TransactionHandler()); // 业务处理

}

});

Netty的5大杀手锏

1. 事件驱动模型

核心机制:

基于Reactor模式,通过事件循环(EventLoop)异步处理网络事件,避免线程阻塞。

优势:

- 高性能:单线程可处理上万连接,减少线程切换开销。

- 低延迟:事件触发即处理,无需等待线程调度。

- 代码简洁:通过ChannelHandler链式处理,逻辑清晰。

示例:

// 事件处理器示例

public class EchoServerHandler extends ChannelInboundHandlerAdapter {

@Override

public void channelRead(ChannelHandlerContext ctx, Object msg) {

ctx.write(msg); // 异步写回数据

}

}

2. 零拷贝技术

核心原理:

通过DirectBuffer和CompositeByteBuf,减少数据在JVM堆与Native内存之间的复制。

应用场景:

-

文件传输: 通过

FileRegion直接发送文件,无需拷贝到用户空间。 -

协议解析: 使用

ByteBuf.slice()共享内存,避免重复解析。 -

性能对比:

| 传输方式 | 传统IO | 零拷贝 |

|---|---|---|

| 内存拷贝次数 | 4次 | 0次 |

| 10GB文件传输时间 | 12秒 | 3秒 |

3. 百万级并发架构

关键技术:

-

线程模型优化: BossGroup接收连接,WorkerGroup处理IO,业务逻辑异步化。

-

资源池化: 重用ByteBuf、ChannelHandlerContext等对象,减少GC压力。

-

流量控制: 通过

WRITE_BUFFER_WATER_MARK动态调整写缓冲区水位。

实战数据:

-

连接数: 单机支持100万+长连接。

-

吞吐量: 每秒处理50万+消息。

-

时延: 99.9%请求<10ms。

4. 模块化设计

核心特性:

-

可插拔组件: 通过ChannelPipeline动态添加/移除Handler。

-

协议支持: 内置HTTP、WebSocket、Protobuf等协议编解码器。

-

扩展性强: 支持自定义编解码器、Handler、线程模型。

示例:

// 动态添加Handler

pipeline.addLast("decoder", new StringDecoder())

.addLast("encoder", new StringEncoder())

.addLast("handler", new BusinessHandler());

5. 社区生态

核心优势:

-

活跃社区: GitHub 25k+ Star,100+贡献者,每月更新版本。

-

工业级应用: 被Dubbo、RocketMQ、Elasticsearch等顶级项目采用。

-

丰富文档: 官方指南、API文档、最佳实践一应俱全。

生态工具:

-

Netty-in-Action: 经典书籍,深入源码解析。

-

NettyRpc: 基于Netty的RPC框架模板。

-

NettyMonitor: 实时监控Netty性能指标。

二、底层架构三剑客(解剖核心机制)

Reactor线程模型

1. 核心架构

Netty的Reactor线程模型采用三级线程池设计,分别负责连接接收、IO事件处理和业务逻辑执行,确保高并发场景下的性能与稳定性。

2. 三级线程池详解

| 线程池 | 职责 | 线程数配置建议 | 关键特性 |

|---|---|---|---|

| BossGroup | 接收客户端连接 | 通常为1 | 单线程避免竞争,高效接收连接 |

| WorkerGroup | 处理IO事件(读、写) | CPU核心数*2 | 多线程并行处理,最大化IO吞吐 |

| 业务线程池 | 执行耗时业务逻辑 | 根据业务需求动态调整 | 防止阻塞EventLoop,保证低延迟 |

3. 工作原理

-

BossGroup接收连接

- 监听端口,接收新连接。

- 将新连接注册到WorkerGroup的某个EventLoop。

EventLoopGroup bossGroup = new NioEventLoopGroup(1); // 1个Acceptor线程 ServerBootstrap b = new ServerBootstrap(); b.group(bossGroup, workerGroup) .channel(NioServerSocketChannel.class); -

WorkerGroup处理IO

- EventLoop轮询Channel的读写事件。

- 触发Pipeline中的ChannelHandler链式处理。

EventLoopGroup workerGroup = new NioEventLoopGroup(); // 默认CPU核心数*2

b.childHandler(new ChannelInitializer<SocketChannel>() {

@Override

protected void initChannel(SocketChannel ch) {

ch.pipeline().addLast(new EchoServerHandler());

}

});

- 业务线程隔离

- 耗时操作(如数据库查询)提交到业务线程池。

- 避免阻塞EventLoop,保证IO事件的高效处理。

ExecutorService businessExecutor = Executors.newFixedThreadPool(32);

businessExecutor.submit(() -> {

// 耗时业务逻辑

});

ByteBuf黑科技

1. 池化内存管理

核心机制:

Netty通过PooledByteBufAllocator实现内存池化,重用ByteBuf对象,减少GC压力。

优势:

- 高效内存分配:从预分配的内存池中获取ByteBuf,避免频繁创建和销毁。

- 减少GC开销:对象复用,降低Young GC和Full GC频率。

- 动态扩容:支持按需扩展容量,避免内存浪费。

示例:

ByteBuf buffer = PooledByteBufAllocator.DEFAULT.buffer(1024); // 从池中分配

buffer.writeBytes("Hello, Netty!".getBytes());

2. 读写指针分离

核心设计:

ByteBuf通过独立的读指针(readerIndex)和写指针(writerIndex),实现高效的数据读写。

优势:

-

零拷贝读取: 无需移动数据,直接通过指针定位。

-

避免数据覆盖: 读写操作互不干扰。

-

简化逻辑: 无需手动维护位置信息。

示例:

ByteBuf buffer = Unpooled.buffer(16);

buffer.writeInt(100); // writerIndex移动

int value = buffer.readInt(); // readerIndex移动

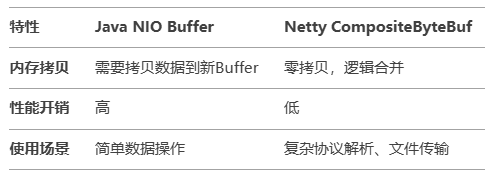

3. 复合缓冲区设计

核心特性:

通过CompositeByteBuf将多个ByteBuf逻辑上合并,避免数据拷贝。

对比Java NIO Buffer:

示例:

ByteBuf header = Unpooled.buffer(8);

ByteBuf body = Unpooled.buffer(16);

CompositeByteBuf composite = Unpooled.compositeBuffer();

composite.addComponents(true, header, body); // 逻辑合并

4. 对比Java NIO Buffer的缺陷

Java NIO Buffer的痛点:

-

固定容量: 一旦分配无法动态扩展,容易溢出。

-

单指针设计: 读写共用

position,需频繁flip()切换模式。 -

内存碎片: 频繁创建和销毁Buffer,导致GC压力大。

Netty ByteBuf的优势:

-

动态扩容: 按需扩展容量,避免溢出。

-

读写分离: 独立指针,简化操作逻辑。

-

内存池化: 减少GC开销,提升性能

Pipeline责任链

1. 核心设计理念

链式处理模型:

Netty的ChannelPipeline通过责任链模式,将网络事件的处理拆分为多个独立的ChannelHandler,形成可扩展的流水线。

核心特性:

- 动态编排:运行时动态增删Handler,支持热更新。

- 协议分层:编解码、业务逻辑、异常处理分层解耦。

- 双向流动:支持

Inbound(数据入站)和Outbound(数据出站)双方向处理。

2. 代码示例解析

// 编解码+业务逻辑链式处理

pipeline.addLast(new StringDecoder()) // 入站处理器:字节转字符串

.addLast(new SimpleServerHandler()); // 入站处理器:业务逻辑

执行流程:

-

解码阶段: 原始字节数据 →

StringDecoder→ 转换为字符串。 -

业务处理: 字符串 →

SimpleServerHandler→ 执行业务逻辑(如响应请求)。

3. Handler类型与分工

4. 对比传统处理模式

5. 高级用法示例

多协议支持:

// HTTP协议处理链

pipeline.addLast(new HttpRequestDecoder()) // HTTP解码

.addLast(new HttpResponseEncoder()) // HTTP编码

.addLast(new HttpObjectAggregator(65536)) // 合并请求体

.addLast(new HttpServerHandler()); // 业务处理

异常处理:

public class ExceptionHandler extends ChannelInboundHandlerAdapter {

@Override

public void exceptionCaught(ChannelHandlerContext ctx, Throwable cause) {

cause.printStackTrace();

ctx.close();

}

}

pipeline.addLast(new ExceptionHandler());

6. 实战场景

场景: 物联网设备数据采集网关

需求:

- 支持二进制协议(设备数据)和JSON协议(管理指令)混合传输

- 动态路由不同协议到对应业务模块

Pipeline配置:

pipeline.addLast(new ProtocolDetector()) // 协议探测

.addLast(new BinaryDecoder()) // 二进制协议解码

.addLast(new JsonDecoder()) // JSON协议解码

.addLast(new RouterHandler()); // 按协议类型路由

三、关键组件实战指南

1. ServerBootstrap配置模板

核心作用:

ServerBootstrap是Netty服务端的启动类,用于配置线程模型、Channel类型、Handler链等。

标准模板:

EventLoopGroup bossGroup = new NioEventLoopGroup(1); // 接收连接线程组

EventLoopGroup workerGroup = new NioEventLoopGroup(); // 处理IO线程组

ServerBootstrap b = new ServerBootstrap();

b.group(bossGroup, workerGroup)

.channel(NioServerSocketChannel.class) // 使用NIO传输

.childHandler(new ChannelInitializer<SocketChannel>() {

@Override

protected void initChannel(SocketChannel ch) {

ch.pipeline().addLast(new StringDecoder()); // 解码器

ch.pipeline().addLast(new EchoServerHandler()); // 业务处理器

}

})

.option(ChannelOption.SO_BACKLOG, 128) // 连接队列大小

.childOption(ChannelOption.SO_KEEPALIVE, true); // 保持连接

ChannelFuture f = b.bind(8080).sync(); // 绑定端口

f.channel().closeFuture().sync(); // 等待关闭

关键配置项:

| 配置项 | 作用 | 推荐值 |

|---|---|---|

| SO_BACKLOG | 连接队列大小 | 128 |

| SO_KEEPALIVE | 保持连接 | true |

| TCP_NODELAY | 禁用Nagle算法 | true |

| WRITE_BUFFER_WATER_MAR | 写缓冲区水位控制 | 低水位32KB,高水位64KB |

2. ChannelHandler开发规范

2.1 生命周期管理

核心方法:

| 方法名 | 触发时机 | 典型用途 |

|---|---|---|

| handlerAdded | Handler添加到Pipeline时 | 初始化资源 |

| channelRegistered | Channel注册到EventLoop时 | 绑定上下文 |

| channelActive | Channel激活时 | 启动定时任务 |

| channelInactive | Channel关闭时 | 释放资源 |

| handlerRemoved | Handler从Pipeline移除时 | 清理资源 |

示例:

public class LifecycleHandler extends ChannelInboundHandlerAdapter {

@Override

public void handlerAdded(ChannelHandlerContext ctx) {

System.out.println("Handler added");

}

@Override

public void channelActive(ChannelHandlerContext ctx) {

System.out.println("Channel active");

}

@Override

public void channelInactive(ChannelHandlerContext ctx) {

System.out.println("Channel inactive");

}

}

2.2 @Sharable注解陷阱

作用:

标记Handler为可共享,允许同一个实例添加到多个Pipeline。

陷阱:

-

线程安全问题: 共享Handler需确保线程安全。

-

状态污染: 避免使用实例变量,防止状态被多个Channel共享。

正确用法:

@Sharable

public class SafeHandler extends ChannelInboundHandlerAdapter {

@Override

public void channelRead(ChannelHandlerContext ctx, Object msg) {

// 无状态操作

ctx.write(msg);

}

}

2.3 异常传播机制

核心机制:

异常沿Pipeline传播,直到被某个Handler捕获或到达尾部(默认关闭连接)。

处理方式:

-

统一捕获: 在Pipeline尾部添加全局异常处理器。

-

局部捕获: 在特定Handler中重写

exceptionCaught。

示例:

public class ExceptionHandler extends ChannelInboundHandlerAdapter {

@Override

public void exceptionCaught(ChannelHandlerContext ctx, Throwable cause) {

cause.printStackTrace();

ctx.close(); // 关闭连接

}

}

pipeline.addLast(new ExceptionHandler());

四、避坑指南(来自官方Issue分析)

1. 内存泄漏检测

1.1 ResourceLeakDetector等级设置

作用:

ResourceLeakDetector用于检测ByteBuf等资源的内存泄漏。

等级配置:

| 等级 | 作用 | 性能开销 |

|---|---|---|

DISABLED | 关闭检测 | 无 |

SIMPLE | 简单检测 | 低 |

ADVANCED | 高级检测(默认) | 中 |

PARANOID | 严格检测 | 高 |

配置方法:

System.setProperty("io.netty.leakDetectionLevel", "PARANOID");

1.2 ByteBuf.refCnt()调试技巧

作用:

refCnt用于跟踪ByteBuf的引用计数,防止内存泄漏。

调试技巧:

-

检查引用计数: 确保

refCnt在释放前为1。 -

手动释放: 调用

release()减少引用计数。 -

防御性编程: 使用

ByteBufUtil.ensureAccessible()检查Buffer是否可用。

示例:

ByteBuf buffer = ...;

if (buffer.refCnt() > 0) {

buffer.release(); // 手动释放

}

2. 线程阻塞红线

2.1 EventLoop禁止同步操作

原因:

EventLoop线程负责处理IO事件,阻塞操作会严重影响性能。

禁止行为:

-

同步IO: 如文件读写、数据库查询。

-

长时间计算: 如复杂算法、死循环。

-

锁竞争: 如

synchronized、ReentrantLock。

解决方案:

-

异步化: 将阻塞操作提交到业务线程池。

-

非阻塞API: 使用异步数据库驱动、NIO文件操作。

示例:

EventLoopGroup businessGroup = new DefaultEventExecutorGroup(32);

pipeline.addLast(businessGroup, new BlockingHandler()); // 隔离阻塞操作

2.2 业务逻辑必须异步化

核心原则:

所有耗时操作都应异步执行,避免阻塞EventLoop。

实现方式:

-

CompletableFuture: Java 8+的异步编程工具。

-

回调机制: 通过ChannelFuture监听操作结果。

-

线程池隔离: 使用DefaultEventExecutorGroup处理业务逻辑。

示例:

CompletableFuture.runAsync(() -> {

// 耗时业务逻辑

}, businessExecutor);

3. 性能调优参数

3.1 SO_BACKLOG

作用:

指定连接队列大小,用于处理突发连接请求。

推荐值:

-

默认值: 50(通常过低)。

-

优化值: 128或更高,根据业务需求调整。

配置方法:

b.option(ChannelOption.SO_BACKLOG, 128);

3.2 WRITE_BUFFER_WATER_MARK 水位线设置

作用:

控制写缓冲区的水位,防止内存溢出。

参数说明:

- 低水位: 缓冲区可写的最小字节数。

- 高水位: 缓冲区可写的最大字节数。

推荐值:

- 低水位: 32KB

- 高水位: 64KB

配置方法:

b.childOption(ChannelOption.WRITE_BUFFER_WATER_MARK,

new WriteBufferWaterMark(32 * 1024, 64 * 1024));

4. 实战场景

场景: 高并发API网关

问题:

- 内存泄漏导致频繁Full GC

- 同步数据库查询阻塞EventLoop

- 突发流量导致连接队列溢出

优化措施:

- 设置

ResourceLeakDetector为PARANOID,修复泄漏点。 - 使用异步数据库驱动,隔离阻塞操作。

- 调整

SO_BACKLOG为256,提升连接处理能力。 - 配置

WRITE_BUFFER_WATER_MARK,防止写缓冲区溢出。

结果:

- GC时间: 从2秒/次降至200ms/次

- 吞吐量: 从1万QPS提升至5万QPS

- 稳定性: 支持10万+并发连接

推荐阅读

1.官方资源

-

Netty官方网站

https://netty.io

包含官方文档、示例代码、版本更新日志及性能优化指南。 -

Netty GitHub仓库

https://github.com/netty/netty

直接参与源码学习,了解最新特性与社区动态。

2.经典书籍

-

《Netty in Action》

作者:Norman Maurer, Marvin Allen Wolfthal- 系统讲解Netty核心设计,涵盖线程模型、编解码器、性能优化。

- 适合入门与进阶,含大量实战案例。

-

《Netty权威指南》(中文)

作者:李林锋- 深入剖析Netty源码与设计思想,结合高并发场景实践。

- 适合需要深入理解底层机制的开发者。

-

《High Performance Browser Networking》

作者:Ilya Grigorik- 虽非Netty专属,但透彻讲解网络协议与性能优化,辅助理解Netty设计哲学。

3.在线资源

-

Netty官方用户指南

https://netty.io/wiki/user-guide.html

快速上手教程,包含基础配置与核心API详解。 -

Netty实战博客

https://developer.ibm.com/tutorials/j-netty/

IBM开发者社区提供的Netty实战系列文章,适合场景化学习。 -

Stack Overflow Netty标签

https://stackoverflow.com/questions/tagged/netty

解决实际开发中的疑难杂症,学习高频问题解决方案。

学习建议

- 入门:从《Netty in Action》+官方示例代码开始,动手实现Echo Server/Client。

- 进阶:结合《Netty权威指南》阅读源码,重点研究

EventLoop、ByteBuf、Pipeline模块。 - 专家级:参与GitHub Issue讨论,贡献代码或文档,深入理解社区最佳实践。

浙公网安备 33010602011771号

浙公网安备 33010602011771号