机器学习100道经典题库

机器学习100道经典题库

目录

练习一

练习二

练习三

练习四

练习一

1 监督学习是根据已有的数据集中(输入特征)和输出标签(Label)之间的关系

2 分类问题的目标是预测 ( 类别标签)

3 回归问题的目标是预测 ( 一组连续值)

4 不收敛一般出现在(基于梯度下降)算法的模型中

5 数据清洗(Data Cleaning)的主要思想是通过填补缺失值,光滑噪声数据,平滑或删除离群点,并解决(数据的一致性)问题

6 属于机器学习分类:监督学习、半监督学习、无监督学习、强化学习。

7 属于机器学习的算法:回归算法、正则化算法、基于树的算法、贝叶斯方法。

8 属于机器学习的范围是:统计学习、数据挖掘、计算机视觉、语音识别。

9 欠拟合的原因有:模型复杂度过低、数据特征少。

10 降维的两种主要方法:投影、流型学习。

练习二

1 数据变换包括对数据进行规范化、(离散化)、稀疏化处理,达到适用于挖掘的目的。

2 信息增益可以衡量某个(特征)对分类结果的影响大小。

3 在构建决策树选择特征时,应选择(基尼指数增益值最大)的特征,作为该结点分裂条件。

4 如果在特征较多的情况下,一般使用(Lasso)回归。

5 决策树学习常见的算法包括:CART、ID3、C4.5、 随机森林。

6 停止构造决策树的条件:决策树的深度达到指定的条件;规定最小节点数。

7 K-Means聚类它对聚类中心的平均值的使用很简单。正确

8 降维将使得机器学习的算法运行更快。正确

9 决策树学习的目标就是把数据集按对应的类别标签进行分类。正确

10 决策树是使用最广泛的机器学习模型之一,因为决策树可以很好地处理噪声或丢失的数据,并且可以很容易地进行整合,以形成更强大的预测器(集成方法常采用决策树作。正确

练习三

1 线性模型的主要参数是(正则化参数)

2 逻辑回归假设因变量y服从(伯努利分布)

3 线性回归假设因变量y服从(高斯分布)

4 支持向量机(Support Vector Machine,SVM)是一个非常强大的机器学习模型,能够执行:线性和非线性的分类、回归、异常值检测, 它是机器学习中最流行的模型之一。

5 常用的核函数有哪些:线性核函数、多项式核函数、高斯径向核函数。

6 神经网络是一种多层前馈神经网络,该网络的主要特点是信号前向传递,误差反向传播。主要包括(隐藏层、输入层、输出层)每一层的神经元状态影响下一层神经元状态。

7 Alpha值较大或C值较小,说明模型比较简单。正确

8 逻辑回归(Logistic Regression)模型是一个红黑树模型。错误

9 逻辑回归与线性回归都是一种广义线性模型(Generalized Linear Model)。正确

10 SVM支持分类和回归。正确

练习四

1 predict_proba的输出是每个类别的(概率),通常比 decision_function的输出更容易理

解。

2 RBM是一种简单的深度学习架构,是一组(无监督)的特征学习算法,它根据数据的概率模型学习一定数量的新特征,往往在使用RBM之后用线性模型(线性回归、逻辑回归、感知机等)的效果极佳。概念上,RBM 是一个浅层(2层)的神经网络,属于深度信念网络。

3 利用传统语法创建管道较为麻烦,Pipeline类提供了一个很方便的函数 (make_pipeline),可以创建管道并根据每个步骤所属的类为其自动命名。如果多个步骤属于同一类,则会自动附加一个数字。

4 由于现实世界获取信息和数据的过程中,会存在各类的原因导致数据丢失和空缺。针对这些缺失值的处理方法,主要是基于变量的分布特性和变量的重要性(信息量和预测能力)采用不同的方法。属于该方法的有(插值法填充、删除变量、模型填充)。

5 数据变换包括对数据进行(离散化、规范化、稀疏化处理)达到适用于挖掘的目的。

6 best_estimator_本质上是个管道,它包含两个步骤(StandardScaler、LogisticRegression)。

7 多层感知机MLP的精度相当好,但没有其他模型好,与较早的SVC例子相同,原因可能在于数据的收敛。错误

8 神经网络要求所有输入特征的变化范围相似,最理想的情况是均值为0、方差为1,为此,将数据进行缩放以满足这些要求。正确

9 噪声是变量的随机误差和方差,是观测点和真实点之间的误差,即 obs=.xE。正确

10 文本处理一般在NLP(自然语言处理)领域应用最为广泛,一般都是需要把文本进行向量化,最为常见的方法有词袋法(Bag of Words)、CountVectorizer 、TF-IDF。正确

文章知识点与官方知识档案匹配

————————————————

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

原文链接:https://blog.csdn.net/m0_57656758/article/details/130319101

1. 深度学习中的激活函数需要具有哪些属性?

计算简单

非线性

具有饱和区

几乎处处可微

ABD。解析:(1)非线性:导数不能是常数。(2)几乎处处可微:sigmoid处处可微,ReLU仅在有限点处不可微)。(3)计算简单。(4)非饱和性:Sigmoid存在饱和区,存在梯度消失问题,后来提出了relu。(5)单调性。(6)输出范围有限;(7)接近恒等变换;(8)参数少;(9)归一化,助力稳定训练。

2. BatchNorm 层对于 input batch 会统计出 mean 和 variance 用于计算 EMA。如果input batch 的 shape 为(B, C, H, W),统计出的 mean 和 variance 的 shape 为:

B * 1 * 1 * 1

1 * C * 1 * 1

B * C * 1 * 1

1 * 1 * 1 * 1

B。解析:BN对多张图像的每个通道做归一化,有多少个通道就有多少均值和方差。

3.CNN常见的Loss函数不包括以下哪个()

softmax_loss

sigmoid_loss

Contrastive_Loss

siamese_loss

D。解析:siamese network(孪生神经网络)中应用Contrastive_Loss(对比损失),能有效的处理paired data的关系。对比损失主要用在降维中,保证本来相似的样本,降维后(新特征空间中)仍旧相似。表达式如下:

d是样本间距离,当样本相似时y=1,损失函数只剩前半部分,距离越大说明模型越差,损失越大。样本不相似时y=0,损失函数只剩后半部分,如果距离越小说明模型越差,损失越大。

4. 关于Attention-based Model,下列说法正确的是()

相似度度量模型

是一种新的深度学习网络

是一种输入对输出的比例模型

都不对

A。解析:Attention-based Model其实就是一个相似性的度量,当前的输入与目标状态越相似,那么在当前的输入的权重就会越大,说明当前的输出越依赖于当前的输入。

5. 考虑某个具体问题时,你可能只有少量数据来解决这个问题。不过幸运的是你有一个类似问题已经预先训练好的神经网络。可以用下面哪种方法来利用这个预先训练好的网络?

把除了最后一层外所有的层都冻结,重新训练最后一层

对新数据重新训练整个模型

只对最后几层进行调参(fine tune)

对每一层模型进行评估,选择其中的少数来用

C。解析:模型微调方法:

数据量少,数据相似度高:改最后几层或者只改输出层。

数据量少,数据相似度低:冻结一些,训练一些。

数据量大,数据相似度低:从头训练。

数据量大,数据相似度高:最理想。用预训练权重重新训练。

6. 基于二次准则函数的H-K算法较之于感知器算法的优点是?

计算量小

可以判别问题是否线性可分

其解完全适用于非线性可分的情况

其解的适应性更好

BD。解析:H-K算法是在最小均方误差准则下求得权矢量。适用于线性可分和非线性。对于线性可分的情况: 给出最优权矢量;对于非线性可分得情况: 能够判别出来,以退出迭代过程。

7. caffe中基本的计算单元为

blob

layer

net

solver

B。解析:blob: caffe的数据存储单元;layer: caffe的计算单元。

8. GoogLeNet提出的Inception结构优势有?

保证每一层的感受野不变,网络深度加深,使得网络的精度更高

使得每一层的感受野增大,学习小特征的能力变大

有效提取高层语义信息,且对高层语义进行加工,有效提高网络准确度

利用该结构有效减轻网络的权重

D。解析:多分支结构,大卷积核拆成小卷积核串联,3*3卷积拆成3*1和1*3卷积,使用1*1卷积等,能够减轻网络权重。

9. 下图是一个利用sigmoid函数作为激活函数的含四个隐藏层的神经网络训练的梯度下降图。这个神经网络遇到了梯度消失的问题。下面哪个叙述是正确的?

第一隐藏层对应D,第二隐藏层对应C,第三隐藏层对应B,第四隐藏层对应A

解析:在神经网络反向传播中,梯度从后往前传,梯度不断减小,最后变为零,此时,浅层的神经网络权重得不到更新,那么前面隐藏层的学习速率低于后面隐藏层的学习速率,即随着隐藏层数目的增加,分类准确率反而下降了。这种现象叫做梯度消失。梯度消失导致后层的权重更新的快,靠近输出层的权值更新相对正常,前层网络由于梯度传递不过去得不到更新。因此,靠近输入层的更新会变得很慢,导致靠近输入层的隐藏层权值几乎不变,接近于初始化的权值。这样在网络很深的时候,学习的速度很慢或者无法学习。D的学习速率最慢,因此是第一隐藏层。

10. 以下关于深度神经网络的说法中错误的是

A 使用梯度裁剪(gradient clipping)有助于减缓梯度爆炸问题

B 若batch size过小,batch normalization的效果会出现退化

C 在使用SGD训练时,若训练loss的变化逐渐平缓不再明显下降时,通常可以通过减小learning rate的方式使其再进一步下降

D 增大L2正则项的系数有助于减缓梯度消失问题

D。解析:L2正则化用于降低模型复杂度,防止过拟合,不能缓解梯度消失。残差结构、合适的激活函数、梯度裁剪、BN、初始化等可以缓解梯度消失。

11. 下列关于神经网络的叙述中,正确的是

A 损失函数关于输入一定是非凸或非凹的

B 存在某种深度神经网络(至少一个隐藏层),使其每个局部最优解都是全局最优解

C 深度神经网络容易陷入局部最优解

D 以上选项都不对

解析:B。神经网络容易陷入的是鞍部而不是局部最优解,在多维度的损失函数中局部最小点非常少。

12. 图像挖掘中常用卷积神经网络作为基础结构,以下关于卷积操作 (conv)和池化 ( pooling)的说法正确的是?

A conv基于平移不变性,pooling基于局部相关性

解析:平移不变性:对于同一张图及其平移后的版本,都能输出同样的结果。局部相关性:池化层利用局部相关性,对图像进行下采样,可以减少数据处理量同时保留有用信息,相当于图像压缩。

13.RNN中哪个做法能够更好处理梯度爆炸问题?

A 用LSTM或GRU

B 梯度裁剪

C dropout

解析:B。LSTM中有梯度累加,能够减轻梯度消失问题,但是会加剧梯度爆炸问题。最好的做法是限制梯度范围,进行梯度裁剪。

14. 关于神经网络中经典使用的优化器,以下说法正确的是

A Adam的收敛速度比RMSprop慢

B 相比于SGD或RMSprop等优化器,Adam的收敛效果是最好的

C 对于轻量级神经网络,使用Adam比使用RMSprop更合适

D 相比于Adam或RMSprop等优化器,SGD的收敛效果是最好的

解析:D。SGD 能收敛到极小值,但用时比较长。如果在意更快的收敛,并且需要训练较深较复杂的网络时,推荐使用学习率自适应的优化方法。

15. (多选)影响聚类算法效果的主要原因有?

A、特征选取

B、模式相似性测度

C、分类准则

D、已知类别的样本质量

解析:ABC。聚类是无监督,不使用标记好的数据。

16.(多选)数据清理中,处理缺失值的方法是?

A、估算

B、整例删除

C、变量删除

D、成对删除

解析:ABCD。

17.在HMM中,如果已知观察序列和产生观察序列的状态序列,那么可用以下哪种方法直接进行参数估计?

A、EM算法

B、维特比算法

C、前向后向算法

D、极大似然估计

解析:D。EM算法:只有观测序列,无状态序列时来学习模型参数,即Baum-Welch算法。维特比算法:用动态规划解决HMM的预测问题,不是参数估计。前向后向算法:用来算概率。极大似然估计:即观测序列和相应的状态序列都存在时的监督学习算法,用来估计参数。注意的是在给定观测序列和对应的状态序列估计模型参数,可以利用极大似然发估计。如果给定观测序列,没有对应的状态序列,才用EM,将状态序列看不不可测的隐数据。

18.L1与L2范数在Logistic Regression 中,如果同时加入L1和L2范数会怎样?。

A. 可以做特征选择,并在一定程度上防止过拟合

B. 能解决维度灾难问题

C. 能加快计算速度

D. 可以获得更准确的结果

解析:A。L1范数具有系数解的特性,但是要注意的是,L1没有选到的特征不代表不重要,原因是两个高相关性的特征可能只保留一个。如果需要确定哪个特征重要,再通过交叉验证。

19.(多选)假定某同学使用Naive Bayesian(NB)分类模型时,不小心将训练数据的两个维度搞重复了,那么关于NB的说法中正确的是?

A. 这个被重复的特征在模型中的决定作用会被加强

B. 模型效果相比无重复特征的情况下精确度会降低

C. 如果所有特征都被重复一遍,得到的模型预测结果相对于不重复的情况下的模型预测结果一样。

D. 当两列特征高度相关时,无法用两列特征相同时所得到的结论来分析问题

E. NB可以用来做最小二乘回归

F. 以上说法都不正确

解析:BD。

20.(多选)以下几种模型方法属于判别式模型(Discriminative Model)的有?

A 混合高斯模型

B 条件随机场模型

C 区分度训练

D 隐马尔科夫模型

解析:BC。常见的判别式模型有:Logistic Regression(Logistical 回归)、Linear discriminant analysis(线性判别分析) 、Supportvector machines(支持向量机)、Boosting(集成学习) 、 Conditional random fields(条件随机场) 、Linear regression(线性回归) 、Neural networks(神经网络)。

常见的生成式模型有:Gaussian mixture model and othertypes of mixture model(高斯混合及其他类型混合模型) 、Hidden Markov model(隐马尔可夫) 、NaiveBayes(朴素贝叶斯) 、 AODE(平均单依赖估计) 、Latent Dirichlet allocation(LDA主题模型) 、Restricted Boltzmann Machine(限制波兹曼机)。

生成式模型是根据概率乘出结果,而判别式模型是给出输入,计算出结果。

21.有两个样本点,第一个点为正样本,它的特征向量是(0,-1);第二个点为负样本,它的特征向量是(2,3),从这两个样本点组成的训练集构建一个线性SVM分类器的分类面方程?

A. 2x+y=4

B. x+2y=5

C. x+2y=3

D. 2x-y=0

解析:C。对于两个点来说,最大间隔就是垂直平分线,因此求出垂直平分线即可。

22.关于 Logit 回归和 SVM 不正确的是?

A. Logit回归目标函数是最小化后验概率

B. Logit回归可以用于预测事件发生概率的大小

C. SVM目标是结构风险最小化

D. SVM可以有效避免模型过拟合

解析:A。Logit回归本质上是一种根据样本对权值进行极大似然估计的方法,而后验概率正比于先验概率和似然函数的乘积。logit仅仅是最大化似然函数,并没有最大化后验概率,更谈不上最小化后验概率。而最小化后验概率是朴素贝叶斯算法要做的。

23.(多选)以下说法中正确的是?

A. SVM对噪声(如来自其他分布的噪声样本)鲁棒

B. 在AdaBoost算法中,所有被分错的样本的权重更新比例相同

C. Boosting和Bagging都是组合多个分类器投票的方法,二者都是根据单个分类器的正确率决定其权重

D. 给定n个数据点,如果其中一半用于训练,一般用于测试,则训练误差和测试误差之间的差别会随着n的增加而减少

解析:BD。SVM本身对噪声具有一定的鲁棒性,但实验证明,是当噪声率低于一定水平的噪声对SVM没有太大影响,但随着噪声率的不断增加,分类器的识别率会降低。Bagging的各个预测函数没有权重,而Boosting是有权重的。

24.(多选)以下哪个属于线性分类器最佳准则?

A. 感知准则函数

B.贝叶斯分类

C.支持向量机

D.Fisher准则

解析:ACD。线性分类器有三大类:感知器准则函数、SVM、Fisher准则,而贝叶斯分类器不是线性分类器。

感知准则函数 :准则函数以使错分类样本到分界面距离之和最小为原则。其优点是通过错分类样本提供的信息对分类器函数进行修正,这种准则是人工神经元网络多层感知器的基础。

支持向量机 :基本思想是在两类线性可分条件下,所设计的分类器界面使两类之间的间隔为最大,它的基本出发点是使期望泛化风险尽可能小。(使用核函数可解决非线性问题)

Fisher 准则 :更广泛的称呼是线性判别分析(LDA),将所有样本投影到一条远点出发的直线,使得同类样本距离尽可能小,不同类样本距离尽可能大,具体为最大化“广义瑞利商”。

25.下列时间序列模型中,哪一个模型可以较好地拟合波动性的分析和预测?

A. AR模型

B. MA模型

C. ARMA模型

D. GARCH模型

解析:D。

AR模型是一种线性预测,即已知N个数据,可由模型推出第N点前面或后面的数据(设推出P点),所以其本质类似于插值。

MA模型(moving average model)滑动平均模型,使用趋势移动平均法建立直线趋势的预测模型。

ARMA模型(auto regressive moving average model)自回归滑动平均模型,模型参量法高分辨率谱分析方法之一。这种方法是研究平稳随机过程有理谱的典型方法。它比AR模型法与MA模型法有较精确的谱估计及较优良的谱分辨率性能,但其参数估算比较繁琐。

GARCH模型称为广义ARCH模型,是ARCH模型的拓展。GARCH(p,0)模型,相当于ARCH(p)模型。GARCH模型是一个专门针对金融数据所量体订做的回归模型,除去和普通回归模型相同的之处,GARCH对误差的方差进行了进一步的建模。特别适用于波动性的分析和预测,这样的分析对投资者的决策能起到非常重要的指导性作用,其意义很多时候超过了对数值本身的分析和预测。

26.假设在训练中我们突然遇到了一个问题,在几次循环之后,误差瞬间降低。你认为数据有问题,于是你画出了数据并且发现也许是数据的偏度过大造成了这个问题。你打算怎么做来处理这个问题?

A. 对数据作归一化

B. 对数据取对数变化

C. 都不对

D. 对数据作主成分分析(PCA)和归一化

解析:D。

27.下面那个决策边界是神经网络生成的?

解析:ABCD。

28.下图显示,当开始训练时,误差一直很高,这是因为神经网络在往全局最小值前进之前一直被卡在局部最小值里。为了避免这种情况,我们可以采取下面哪种策略?

A. 改变学习速率,比如一开始的几个训练周期不断更改学习速率

B. 一开始将学习速率减小10倍,然后用动量项(momentum)

C. 增加参数数目,这样神经网络就不会卡在局部最优处

D. 其他都不对

解析:A。

29.对于一个分类任务,如果开始时神经网络的权重不是随机赋值的,二是都设成0,下面哪个叙述是正确的?

A. 其他选项都不对

B. 没啥问题,神经网络会正常开始训练

C. 神经网络可以训练,但是所有的神经元最后都会变成识别同样的东西

D. 神经网络不会开始训练,因为没有梯度改变

解析:C。

30.假设我们已经在ImageNet数据集(物体识别)上训练好了一个卷积神经网络。然后给这张卷积神经网络输入一张全白的图片。对于这个输入的输出结果为任何种类的物体的可能性都是一样的,对吗?

解析:不对。

31.下列哪项关于模型能力(model capacity)的描述是正确的?(指神经网络模型能拟合复杂函数的能力)

A. 隐藏层层数增加,模型能力增加

B. Dropout的比例增加,模型能力增加

C. 学习率增加,模型能力增加

D. 都不正确

解析:A。其实说的也不太对。

32.神经网络模型因受人类大脑的启发而得名。神经网络由许多神经元(Neuron)组成,每个神经元接受一个输入,对输入进行处理后给出一个输出。请问下列关于神经元的描述中,哪一项是正确的?

A.每个神经元只有一个输入和一个输出

B.每个神经元有多个输入和一个输出

C.每个神经元有一个输入和多个输出

D.每个神经元有多个输入和多个输出

E.上述都正确

解析:E。

文章知识点与官方知识档案匹

————————————————

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

原文链接:https://blog.csdn.net/qq_39066502/article/details/126723605

2021-04-01 18:34

1. 对应GradientBoosting tree算法, 以下说法正确的是: 1. 当增加最小样本分裂个数,我们可以抵制过拟合 2. 当增加最小样本分裂个数,会导致过拟合 3. 当我们减少训练单个学习器的样本个数,我们可以降低variance 4. 当我们减少训练单个学习器的样本个数,我们可以降低bias

A、2 和 4

B、2 和 3

C、1 和 3

D、1 和 4

答案:C

解析:最小样本分裂个数是用来控制“过拟合”参数。太高的值会导致“欠拟合”,这个参数应该用交叉验证来调节。 第二点是靠bias和variance概念的。

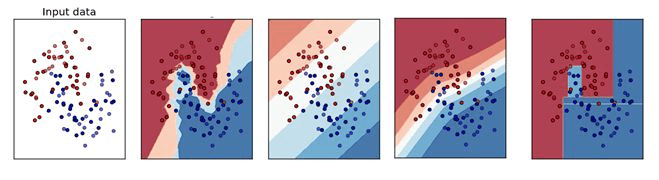

2. 以下哪个图是KNN算法的训练边界

A、B

B、A

C、D

D、C

E、都不是

答案:B

解析:KNN即K近邻算法,其基本思想是先选择和测试数据距离最近的K个已知类别的训练数据,然后将多数样本的类别作为测试数据的类别。KNN不需要训练模型参数,它实际上是利训练数据集对特征向量空间进行划分,并将其作为分类的“模型”,K值的选择、距离度量、分类决策规则(一般为多数表决)是KNN的三个基本要素。KNN算法的训练边界一定不是直线,另外这个算法是看周围最近的k个样本的类别从而确定分类,所以边界一定是坑坑洼洼的。

3. 如果一个训练好的模型在测试集上有100%的准确率, 这是不是意味着在一个新的数据集上,也会有同样好的表现?

A、是的,这说明这个模型的范化能力已经足以支持新的数据集合了

B、不对,依然后其他因素模型没有考虑到,比如噪音数据

答案:B

解析:没有一个模型是可以总是适应新数据的。我们不可能可到100%准确率。

4. 下面的交叉验证方法 i. 有放回的Bootstrap方法 ii. 留一个测试样本的交叉验证 iii. 5折交叉验证 iv. 重复两次的5折教程验证 当样本是1000时,下面执行时间的顺序,正确的是

A、i > ii > iii > iv

B、ii > iv > iii > i

C、iv > i > ii > iii

D、ii > iii > iv > i

答案:B

解析:Boostrap方法是传统地随机抽样,验证一次的验证方法,只需要训练1次模型,所以时间最少。 留一个测试样本的交叉验证,需要n次训练过程(n是样本个数),这里,要训练1000个模型。 5折交叉验证需要训练5个模型。 重复2次的5折交叉验证,需要训练10个模型。 所有B是正确的

5. 变量选择是用来选择最好的判别器子集, 如果要考虑模型效率,我们应该做哪些变量选择的考虑? 1. 多个变量其实有相同的用处 2. 变量对于模型的解释有多大作用 3. 特征携带的信息 4. 交叉验证

A、1 和 4

B、1, 2 和 3

C、1,3 和 4

D、以上所有

答案:C

解析:注意, 这题的题眼是考虑模型效率,所以不要考虑选项2.

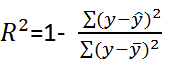

6. 对于线性回归模型,增加一个特征变量,以下可能正确的是 : 1. R-Squared 和 Adjusted R-squared都是递增的 2. R-Squared 是常量的,Adjusted R-squared是递增的 3. R-Squared 是递减的, Adjusted R-squared 也是递减的 4. R-Squared 是递减的, Adjusted R-squared是递增的

A、1 和 2

B、1 和 3

C、2 和 4

D、以上都不是

答案:A

解析:答案: A 线性回归问题中,R-Squared 用来衡量回归方程与真实样本输出之间的相似程度,其表达式为:

上式中,分子部分表示真实值与预测值的平方差之和,类似于均方差 MSE;分母部分表示真实值与均值的平方差之和,类似于方差 Var。一般来说,R-Squared 越大,表示模型拟合效果越好。单独看 R-Squared,并不能推断出增加的特征是否有意义。通常来说,增加一个特征特征,R-Squared 可能变大也可能保持不变,两者不一定呈正相关。 Adjusted R-Squared的表达式为:

其中,n 是样本数量,p 是特征数量。Adjusted R-Squared 抵消样本数量对 R-Squared 的影响,做到了真正的 0~1,越大越好。增加一个特征变量,如果这个特征有意义,Adjusted R-Square 就会增大,若这个特征是冗余特征,Adjusted R-Squared 就会减小。 分析选项,增加一个特征,R-Squared 不变或者递增,故3和4都错;如果增加的特征是有意义的,Adjusted R-Square 就会增大,故1和2可能正确。本题问的是可能正确的选项,故答案选A。

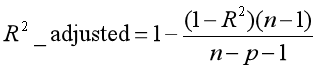

7. 对于下面三个模型的训练情况, 下面说法正确的是:

1. 第一张图的训练错误与其余两张图相比,是最大的 2. 最后一张图的训练效果最好,因为训练错误最小 3. 第二张图比第一和第三张图鲁棒性更强,是三个里面表现最好的模型 4. 第三张图相对前两张图过拟合了 5. 三个图表现一样,因为我们还没有测试数据集

A、1 和 3

B、2 和 3

C、1, 3 和 4

D、5

答案:C

解析:第一张图训练的模型对数据的拟合效果太差,训练误差最大,属于欠拟合,1对;第二张图训练的模型对数据的拟合效果较好,鲁棒性最强,模型表现最好,3对;第三张图训练的模型对数据的拟合效果最好,训练误差最小,但是属于过拟合,在测试集上的误差会很大,这样的模型不好,4对,2错。综上,答案选C。

8. 对于线性回归,下面哪些说法是正确的? 1. 找到离群点很重要, 因为线性回归对离群点很敏感 2. 线性回归要求所有变量必须符合正态分布 3. 线性回归假设数据没有多重线性相关性

A、1 和 2

B、2 和 3

C、1,2 和 3

D、以上都不是

答案:D

解析:第1个假设, 离群点要着重考虑, 第一点是对的 第2个假设, 正态分布不是必须的. 当然, 如果是正态分布, 训练效果会更好 第3个假设, 有少量的多重线性相关性也是可以的, 但是我们要尽量避免

9. 当我们构造线性模型时, 我们注意变量间的相关性. 在相关矩阵中搜索相关系数时, 如果我们发现3对变量的相关系数是(Var1 和Var2, Var2和Var3, Var3和Var1)是-0.98, 0.45, 1.23 . 我们可以得出什么结论: 1. Var1和Var2是非常相关的 2. 因为Var1和Var2是非常相关的, 我们可以去除其中一个 3. Var3和Var1的1.23相关系数是不可能的

A、1 and 3

B、1 and 2

C、1,2 and 3

D、1

答案:C

解析:相关性系数范围应该是 [-1,1] 一般地, 如果相关系数大于0.7或者小于-0.7, 是高相关的. Var1和Var2相关系数是接近负1, 所以这是多重线性相关, 我们可以考虑去除其中一个. 所以1, 2, 3个结论都是对的, 选C.

10. 如果在一个高度非线性并且复杂的一些变量中, 一个树模型可能比一般的回归模型效果更好. 这是()

A、对的

B、错的

答案:A

11. 下面对集成学习模型中的弱学习者描述错误的是?

A、他们经常不会过拟合

B、他们通常带有高偏差,所以其并不能解决复杂学习问题

C、他们通常会过拟合

答案:C

解析:弱学习者是问题的特定部分。所以他们通常不会过拟合,这也就意味着弱学习者通常拥有低方差和高偏差。

12. 下面哪个/些选项对 K 折交叉验证的描述是正确的? 1.增大 K 将导致交叉验证结果时需要更多的时间 2.更大的 K 值相比于小 K 值将对交叉验证结构有更高的信心 3.如果 K=N,那么其称为留一交叉验证,其中 N 为验证集中的样本数量

A、1 和 2

B、2 和 3

C、1 和 3

D、1、2 和 3

答案:D

解析:大 K 值意味着对过高估计真实预期误差(训练的折数将更接近于整个验证集样本数)拥有更小的偏差和更多的运行时间(并随着越来越接近极限情况:留一交叉验证)。我们同样在选择 K 值时需要考虑 K 折准确度和方差间的均衡。

13. 最出名的降维算法是 PCA 和 t-SNE。将这两个算法分别应用到数据「X」上,并得到数据集「X_projected_PCA」,「X_projected_tSNE」。下面哪一项对「X_projected_PCA」和「X_projected_tSNE」的描述是正确的?

A、X_projected_PCA 在最近邻空间能得到解释

B、X_projected_tSNE 在最近邻空间能得到解释

C、两个都在最近邻空间能得到解释

D、两个都不能在最近邻空间得到解释

答案:B

解析:t-SNE 算法考虑最近邻点而减少数据维度。所以在使用 t-SNE 之后,所降的维可以在最近邻空间得到解释。但 PCA 不能。

14. 给定三个变量 X,Y,Z。(X, Y)、(Y, Z) 和 (X, Z) 的 Pearson 相关性系数分别为 C1、C2 和 C3。现在 X 的所有值加 2(即 X+2),Y 的全部值减 2(即 Y-2),Z 保持不变。那么运算之后的 (X, Y)、(Y, Z) 和 (X, Z) 相关性系数分别为 D1、D2 和 D3。现在试问 D1、D2、D3 和 C1、C2、C3 之间的关系是什么?

A、D1= C1, D2 < C2, D3 > C3

B、D1 = C1, D2 > C2, D3 > C3

C、D1 = C1, D2 > C2, D3 < C3

D、D1 = C1, D2 < C2, D3 < C3

E、D1 = C1, D2 = C2, D3 = C3

答案:E

解析:特征之间的相关性系数不会因为特征加或减去一个数而改变。

15. 为了得到和 SVD 一样的投射(projection),你需要在 PCA 中怎样做?

A、将数据转换成零均值

B、将数据转换成零中位数

C、无法做到

答案:A

解析:当数据有一个 0 均值向量时,PCA 有与 SVD 一样的投射,否则在使用 SVD 之前,你必须将数据均值归 0。

16. 假设我们有一个数据集,在一个深度为 6 的决策树的帮助下,它可以使用 100% 的精确度被训练。现在考虑一下两点,并基于这两点选择正确的选项。 注意:所有其他超参数是相同的,所有其他因子不受影响。 1.深度为 4 时将有高偏差和低方差 2.深度为 4 时将有低偏差和低方差

A、只有 1

B、只有 2

C、1 和 2

D、没有一个

答案:A

解析:偏差(bias):描述模型预测值与实际值之间的差距。 方差(variance):描述不同训练阶段模型预测值的波动情况。 随着模型复杂度的提升,对数据的拟合效果也会越来越好,最终会导致过拟合。 过拟合的情况下预测值波动较大,因为他基本要拟合所有的训练数据。所以过拟合时,模型的偏差较小,方差较大。 决策树深度由6变为4,降低了模型复杂度,模型对训练数据的拟合效果也会下降,故偏差增大,方差减小。 方差和偏差的关系是此消彼长。

17. 在以下不同的场景中,使用的分析方法不正确的有

A、根据商家最近一年的经营及服务数据,用聚类算法判断出天猫商家在各自主营类目下所属的商家层级

B、根据商家近几年的成交数据,用聚类算法拟合出用户未来一个月可能的消费金额公式

C、用关联规则算法分析出购买了汽车坐垫的买家,是否适合推荐汽车脚垫

D、根据用户最近购买的商品信息,用决策树算法识别出淘宝买家可能是男还是女

答案:B

解析:预测消费更合适的算法是用回归模型来做。而不是聚类算法。

18. 以下对经典K-means聚类算法解释正确的是

A、能自动识别类的个数,随机挑选初始点为中心点计算

B、能自动识别类的个数,不是随机挑选初始点为中心点计算

C、不能自动识别类的个数,随机挑选初始点为中心点计算

D、不能自动识别类的个数,不是随机挑选初始点为中心点计算

答案:C

解析:(1)适当选择c个类的初始中心; (2)在第k次迭代中,对任意一个样本,求其到c个中心的距离,将该样本归到距离最短的中心所在的类; (3)利用均值等方法更新该类的中心值; (4)对于所有的c个聚类中心,如果利用(2)(3)的迭代法更新后,值保持不变,则迭代结束,否则继续迭代。 以上是KMeans(C均值)算法的具体步骤,可以看出需要选择类别数量,但初次选择是随机的,最终的聚类中心是不断迭代稳定以后的聚类中心。所以答案选C。

19. (假设precision=TP/(TP+FP),recall=TP/(TP+FN)。)在二分类问题中,当测试集的正例和负例数量不均衡时,以下评价方案哪个是相对不合理的()

A、Accuracy:(TP+TN)/all

B、F-value:2*recall*precision/(recall+precision)

C、G-mean:sqrt(precision*recall)

D、AUC:曲线下面积

答案:A

解析:题目提到测试集正例和负例数量不均衡,那么假设正例数量很少占10%,负例数量占大部分90%。 而且算法能正确识别所有负例,但正例只有一半能正确判别。 那么TP=0.05×all,TN=0.9×all,Accuracy=95%。 虽然Accuracy很高,precision是100%,但正例recall只有50%

20. 下列选项中,识别模式与其他不一样的是

A、用户年龄分布判断:少年、青年、中年、老年

B、医生给病人诊断发病类型

C、投递员分拣信件

D、消费者类型判断:高消费、一般消费、低消费

E、出行方式判断:步行、骑车、坐车

F、商家对商品分级

答案:E

解析:ABCDF五个选项都是根据训练集样本特征学习到一个分类模型,然后对新样本进行分类;而E选项是一个预测问题,根据以往的经验(训练集样本),在面对新的情况时先进行预测,然后做出最好的决策,他没有具体的分类实体,仅仅是对未来的一种预测和最优决策,类似于量化交易,根据历史数据进行学习,预测股市未来走势,选择最优的投资策略,故不属于分类问题,答案选 E。返回搜狐,查看更多

浙公网安备 33010602011771号

浙公网安备 33010602011771号