非docker安装:

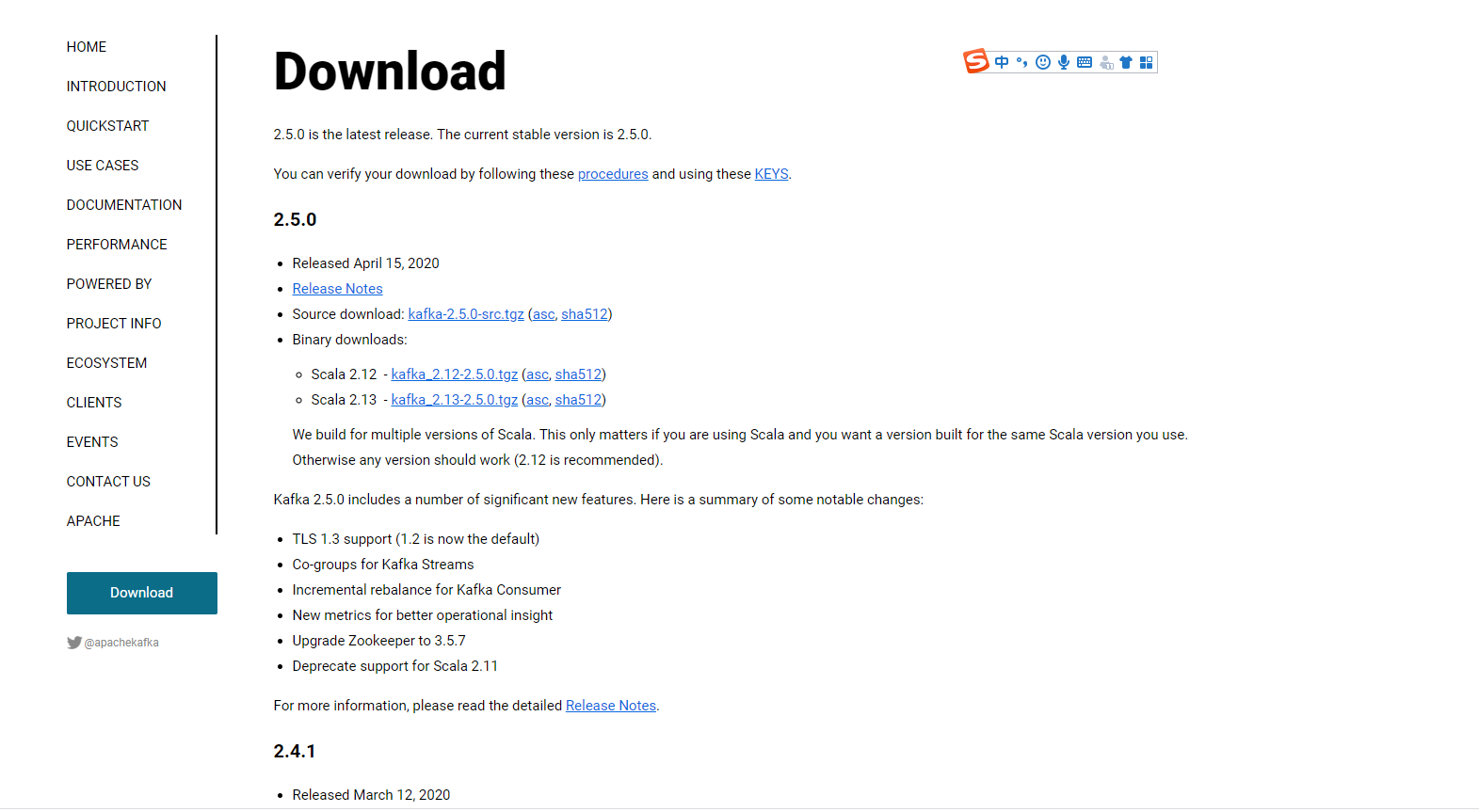

kafka官方下载地址:http://kafka.apache.org/downloads

选择版本:

学习使用的话推荐最新版本,如果生产使用推荐2.2以上版本。低版本有兼容性问题,防止踩坑

1.解压压缩包

tar -zxvf kafka_2.11-2.2.0.tgz

2.service.propertise 配置文件

############################# Server Basics #############################

# 节点的ID,必须与其它节点不同

broker.id=0

# 选择启用删除主题功能,默认false

#delete.topic.enable=true

############################# Socket Server Settings #############################

# 套接字服务器坚挺的地址。如果没有配置,就使用java.net.InetAddress.getCanonicalHostName()的返回值

# FORMAT:

# listeners = listener_name://host_name:port

# EXAMPLE:

# listeners = PLAINTEXT://your.host.name:9092

#listeners=PLAINTEXT://:9092

# 节点的主机名会通知给生产者和消费者。如果没有设置,如果配置了"listeners"就使用"listeners"的值。

# 否则就使用java.net.InetAddress.getCanonicalHostName()的返回值

#advertised.listeners=PLAINTEXT://your.host.name:9092

# 将侦听器的名称映射到安全协议,默认情况下它们是相同的。有关详细信息,请参阅配置文档

#listener.security.protocol.map=PLAINTEXT:PLAINTEXT,SSL:SSL,SASL_PLAINTEXT:SASL_PLAINTEXT,SASL_SSL:SASL_SSL

# 服务器用来接受请求或者发送响应的线程数

num.network.threads=3

# 服务器用来处理请求的线程数,可能包括磁盘IO

num.io.threads=8

# 套接字服务器使用的发送缓冲区大小

socket.send.buffer.bytes=102400

# 套接字服务器使用的接收缓冲区大小

socket.receive.buffer.bytes=102400

# 单个请求最大能接收的数据量

socket.request.max.bytes=104857600

############################# Log Basics #############################

# 一个逗号分隔的目录列表,用来存储日志文件

log.dirs=/tmp/kafka-logs

# 每个主题的日志分区的默认数量。更多的分区允许更大的并行操作,但是它会导致节点产生更多的文件

num.partitions=1

# 每个数据目录中的线程数,用于在启动时日志恢复,并在关闭时刷新。

num.recovery.threads.per.data.dir=1

############################# Internal Topic Settings #############################

# 内部主题设置

# 对于除了开发测试之外的其他任何东西,group元数据内部主题的复制因子“__consumer_offsets”和“__transaction_state”,建议值大于1,以确保可用性(如3)。

offsets.topic.replication.factor=1

transaction.state.log.replication.factor=1

transaction.state.log.min.isr=1

############################# Log Flush Policy #############################

# 在强制刷新数据到磁盘之前允许接收消息的数量

#log.flush.interval.messages=10000

# 在强制刷新之前,消息可以在日志中停留的最长时间

#log.flush.interval.ms=1000

############################# Log Retention Policy #############################

# 以下的配置控制了日志段的处理。策略可以配置为每隔一段时间删除片段或者到达一定大小之后。

# 当满足这些条件时,将会删除一个片段。删除总是发生在日志的末尾。

# 一个日志的最小存活时间,可以被删除

log.retention.hours=168

# 一个基于大小的日志保留策略。段将被从日志中删除只要剩下的部分段不低于log.retention.bytes。

#log.retention.bytes=1073741824

# 每一个日志段大小的最大值。当到达这个大小时,会生成一个新的片段。

log.segment.bytes=1073741824

# 检查日志段的时间间隔,看是否可以根据保留策略删除它们

log.retention.check.interval.ms=300000

############################# Zookeeper #############################

zookeeper.connect=localhost:2181

# 连接到Zookeeper的超时时间

zookeeper.connection.timeout.ms=6000

############################# Group Coordinator Settings #############################

group.initial.rebalance.delay.ms=0

3.启动kafka服务

./bin/kafka-server-start.sh config/server.properties & 【后台启动】

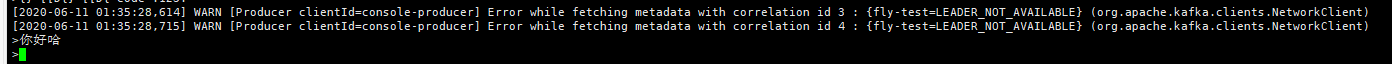

4.启动生产者服务

./kafka-console-producer.sh --broker-list localhost:9003 --topic fly-test

5.启动消费者服务

./kafka-console-consumer.sh --bootstrap-server localhost:9003 --topic fly-test --from-beginning

这时候,生产者发送消息,消费者可以实时监听到数据消息了哈

6.查看topic信息

./bin/kafka-topics.sh --zookeeper localhost:13181 --list

可以查看当前zk节点下所有的topic数据信息

7.查看某个topic详细信息

./bin/kafka-topics.sh --zookeeper localhost:13181 --describe --topic fly-test

---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

Docker 安装kafka

1:kafka需要zookeeper管理,所以需要先安装zookeeper。 下载docker pull wurstmeister/zookeeper:latest版本

docker pull wurstmeister/zookeeper

2:启动镜像生成容器

docker run -d --name zookeeper -p 2181:2181 -v /etc/localtime:/etc/localtime wurstmeister/zookeeper

3:下载kafka镜像

docker pull wurstmeister/kafka

4:启动kafka镜像生成容器

docker run -d --name kafka -p 9092:9092 -e KAFKA_BROKER_ID=0 -e KAFKA_ZOOKEEPER_CONNECT=192.168.155.56:2181/kafka -e KAFKA_ADVERTISED_LISTENERS=PLAINTEXT://192.168.155.56:9092 -e KAFKA_LISTENERS=PLAINTEXT://0.0.0.0:9092 -v /etc/localtime:/etc/localtime wurstmeister/kafka

-e KAFKA_BROKER_ID=0 在kafka集群中,每个kafka都有一个BROKER_ID来区分自己

-e KAFKA_ZOOKEEPER_CONNECT=192.168.155.56:2181/kafka 配置zookeeper管理kafka的路径192.168.155.56:2181/kafka

-e KAFKA_ADVERTISED_LISTENERS=PLAINTEXT://192.168.155.56:9092 把kafka的地址端口注册给zookeeper

-e KAFKA_LISTENERS=PLAINTEXT://0.0.0.0:9092 配置kafka的监听端口

-v /etc/localtime:/etc/localtime 容器时间同步虚拟机的时间

5:验证kafka是否可以使用

进入容器

docker exec -it kafka /bin/sh

进入路径:/opt/kafka_2.11-2.0.0/bin下

运行kafka生产者发送消息

./kafka-console-producer.sh --broker-list localhost:9092 --topic sun

发送消息

{"datas":[{"channel":"","metric":"temperature","producer":"ijinus","sn":"IJA0101-00002245","time":"1543207156000","value":"80"}],"ver":"1.0"}

运行kafka消费者接收消息

kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic sun --from-beginning