hadoop安装与配置(伪分布式)

伪分布式模式:

这篇为大家带来hadoop的伪分布模式:

从最简单的方面来说,伪分布模式就是在本地模式上修改配置文件:

core-site.xml;hdfs-site.xml;mapred-site.xml;yarn-site.xml4

思路简介

|——————————|

| ①:ssh免密登陆 |

| ②:修改配置文件 |

| ③:格式化hadoop |

| ④:启动hadoop |

|——————————|

一:ssh的免密登陆

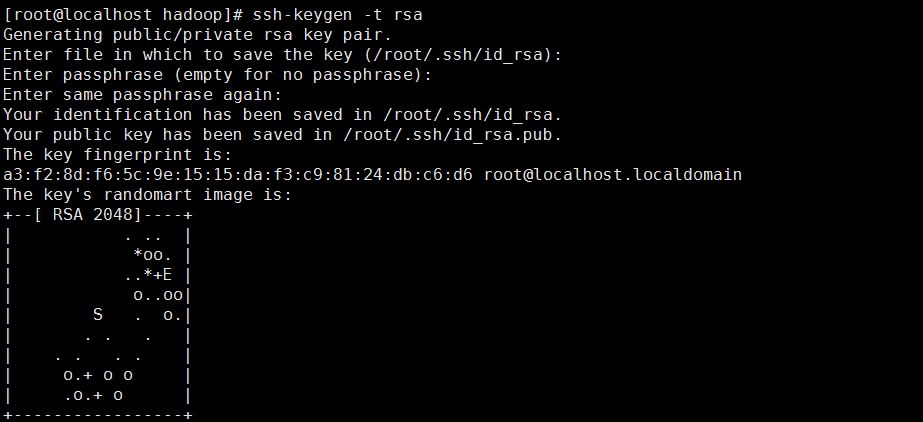

生成id_rsa和id_rsa.pub

[root@localhost hadoop]# ssh-keygen -t rsa

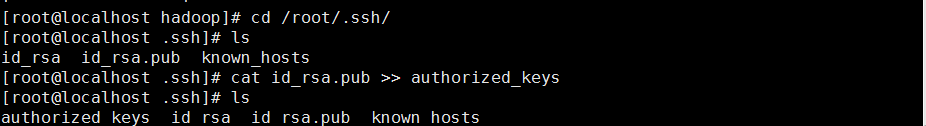

进入/root/.ssh下:将id_rsa.pub的信息发在authorized_keys下:

[root@localhost hadoop]# cd /root/.ssh/ [root@localhost .ssh]# cat id_rsa.pub >> authorized_keys [root@localhost .ssh]# ls authorized_keys id_rsa id_rsa.pub known_hosts

注意这里可能会因为权限原因而使秘钥不起作用

chmod 600 /root/.ssh/authorized_keys

二:关于配置文件的主要内容

core-site.xml:指定hadoop的主节点master

hdfs-site.xml:指定hadoop中的文件副本数

mapred-site.xml:指定mapreduce的资源管理

yarn-site.xml:——————————————

配置文件可以从hadoop的官方文档中下载,有详细解释,这里为了减少对大家的干扰,就直接选取了部分:

[root@localhost hadoop]# cd /data/hadoop/etc/hadoop/ [root@localhost hadoop]# ls capacity-scheduler.xml httpfs-env.sh mapred-env.sh configuration.xsl httpfs-log4j.properties mapred-queues.xml.template container-executor.cfg httpfs-signature.secret mapred-site.xml core-site.xml httpfs-site.xml mapred-site.xml.template hadoop-env.cmd kms-acls.xml slaves hadoop-env.sh kms-env.sh ssl-client.xml.example hadoop-metrics2.properties kms-log4j.properties ssl-server.xml.example hadoop-metrics.properties kms-site.xml yarn-env.cmd hadoop-policy.xml log4j.properties yarn-env.sh hdfs-site.xml mapred-env.cmd yarn-site.xml

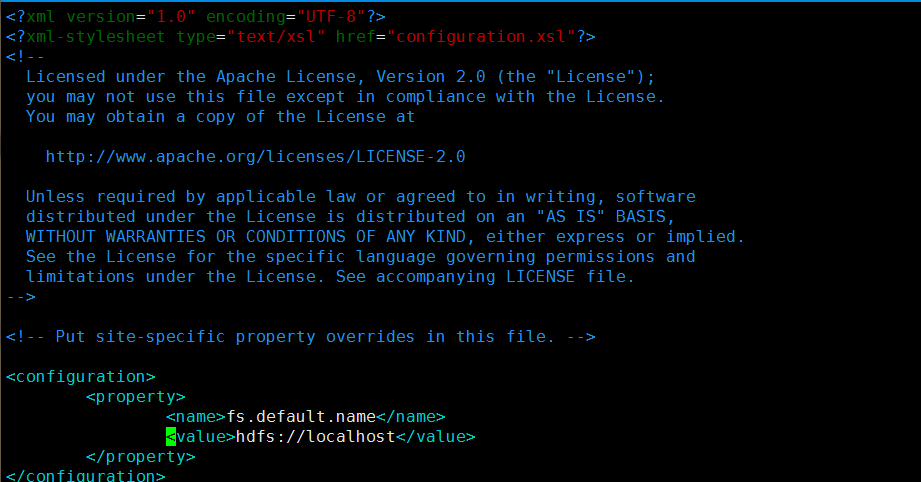

core-site.xml配置修改:<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost</value>(主节点为本机localhost)

</property>

<property>

<name>io.file.buffer.size</name>

<value>131072</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/data/hduser/tmp</value>

</property>

</configuration>

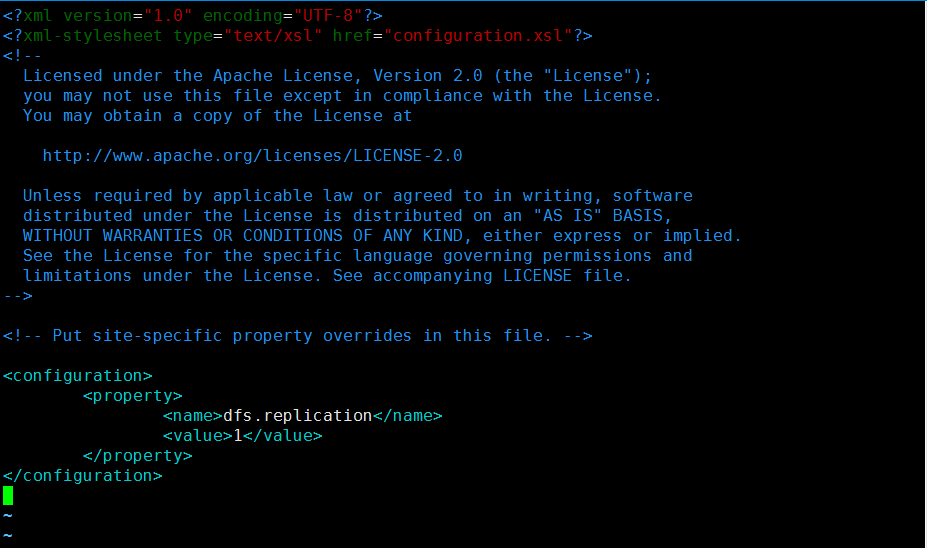

hdfs-site.xml配置修改:

1 <configuration> 2 <property> 3 <name>dfs.replication</name> 4 <value>1</value>(伪分布模式) 5 </property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/data/hduser/tmp/dfs/name</value>

</property>

<property>

<name>dfs.namenode.data.dir</name>

<value>file:/data/hduser/tmp/dfs/data</value>

</property>

6 </configuration>

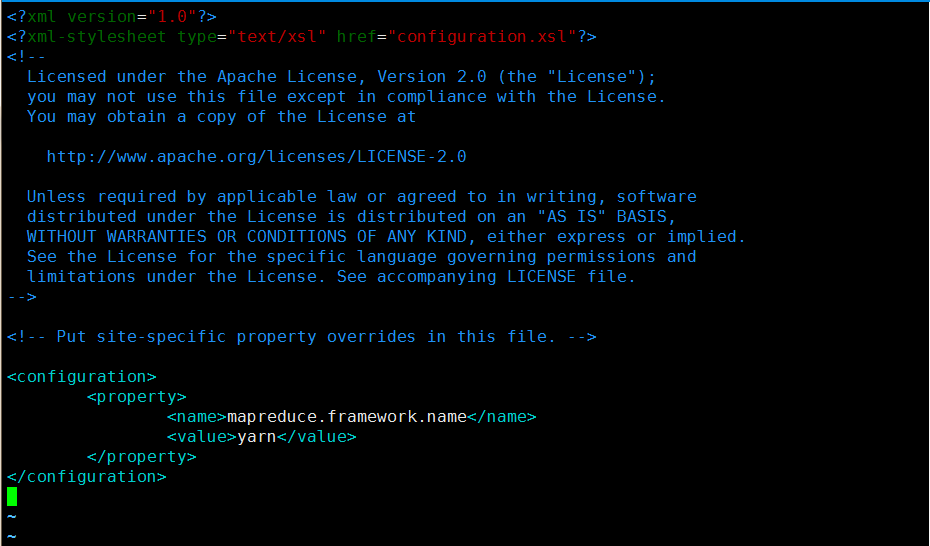

mapred-site.xml配置修改:

备注:

若没有mapred-site.xml,选择以下方法复制

[root@localhost hadoop]# cp mapred-site.xml.template mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>(选择yarn来mapreduce)

</property>

</configuration>

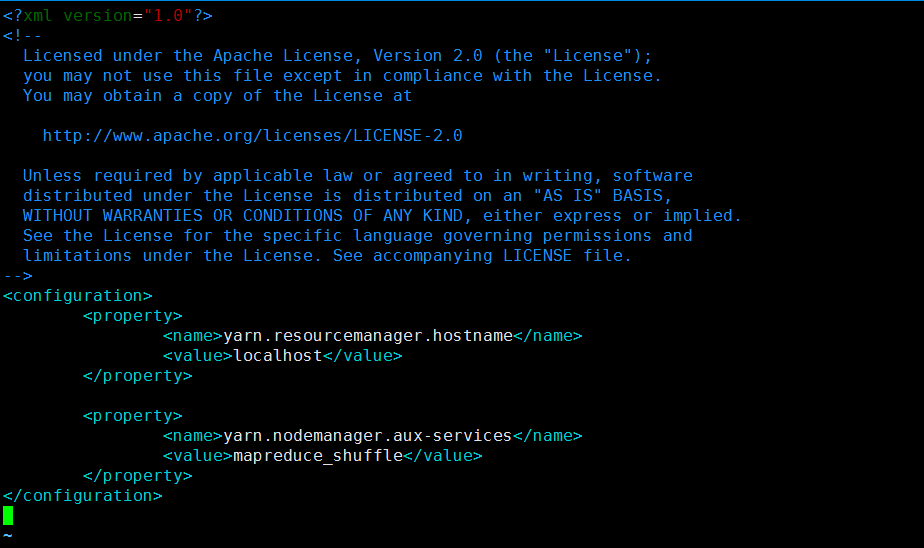

yarn-site.xml配置修改:

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>localhost</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

三:格式化hadoop

hadoop namenode -format

格式化一次就好了

四:启动hadoop

start-all.sh

备注:关闭hadoop:stop-all.sh

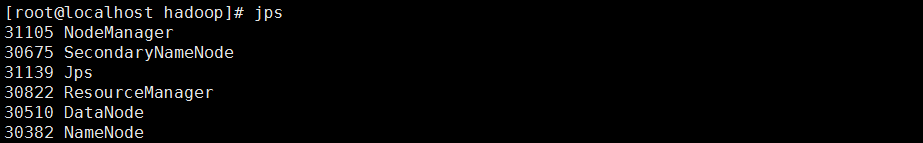

想要知道hadoop是否配置成功,那么就使用jps来查询一下进程吧!

我们知道hadoop主要分为存储和计算,所以我们主要查询一下存储和计算的进程是否启动:

[root@localhost hadoop]# jps 31105 NodeManager(从)(计算) 30675 SecondaryNameNode(主-副本)(计算) 31139 Jps 30822 ResourceManager(主)(计算) 30510 DataNode(从)(存储) 30382 NameNode(主)(存储)

浙公网安备 33010602011771号

浙公网安备 33010602011771号