Hadoop综合大作业

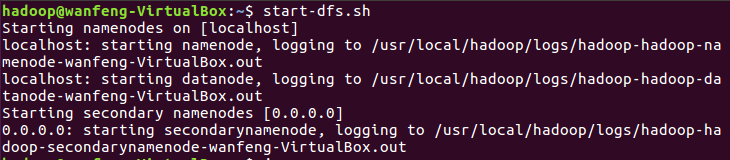

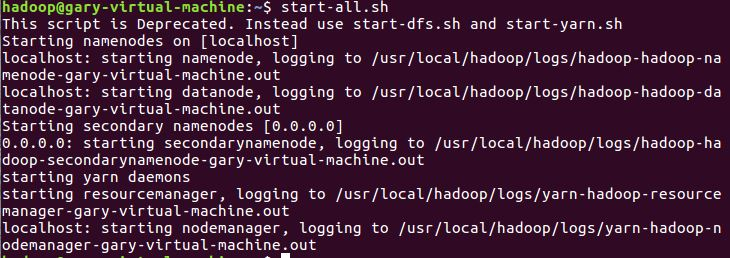

首先启动hadoop

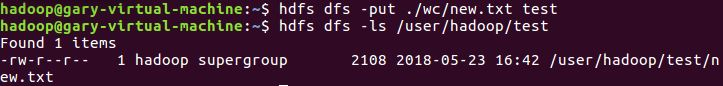

上传到hdfs/data文件中

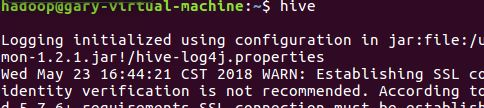

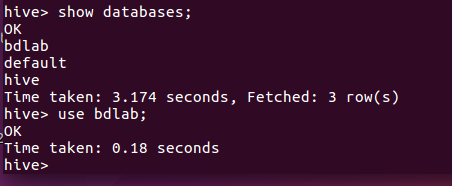

启动Hive

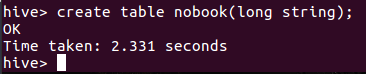

在hive数据库创建表 nobook

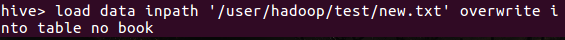

将文本导入到nobook表

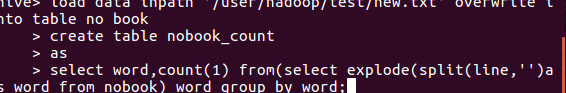

进行HQL词频统计,将结果放入nobook_count表中

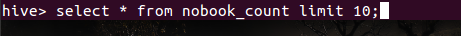

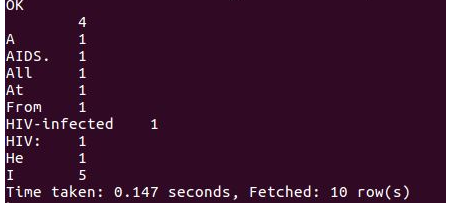

显示词频统计结果(前10的数据)

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

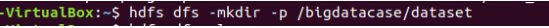

创建用于存放csv数据目录

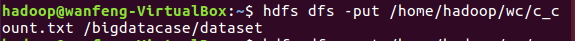

把文件放入文件夹中

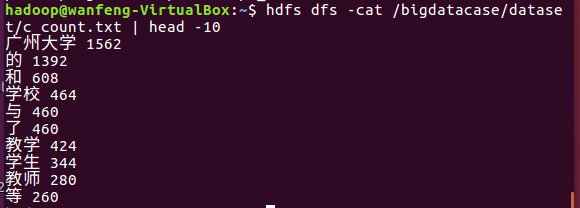

查看文件中的数据:

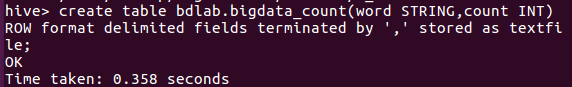

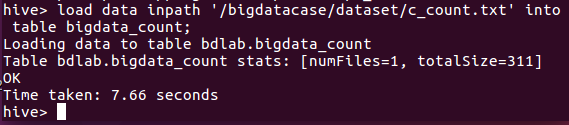

导入数据库表中

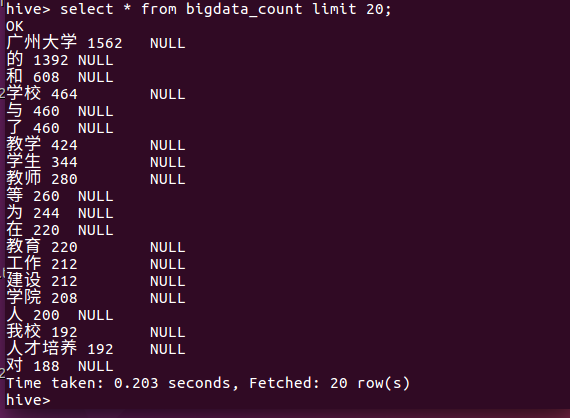

查看数据:

一共爬取了广州大学新闻网的全部新闻,共8300多条。

浙公网安备 33010602011771号

浙公网安备 33010602011771号