[论文笔记]ECCV2016_A Siamese Long Short-Term Memory Architecture for Human Re-Identication

Title: A Siamese Long Short-Term Memory Architecture for Human Re-Identification

Authors: Rahul Rama Variora1, Bing Shuaia1, Jiwen Lub2, Dong Xuc3, Gang Wanga1

Affiliations:

- School of Electrical and Electronic Engineering, Nanyang Technological University, Singapore, Singapore.

- Department of Automation, Tsinghua University, Beijing, China.

- School of Electrical and Information Engineering, University of Sydney, Sydney, Australia.

Contribution:

- 将Long Short-Term Memory (LSTM)融入到了孪生网络(siamese network)中。能够以序列的方式处理局部图像,从而提高局部特征表达能力。

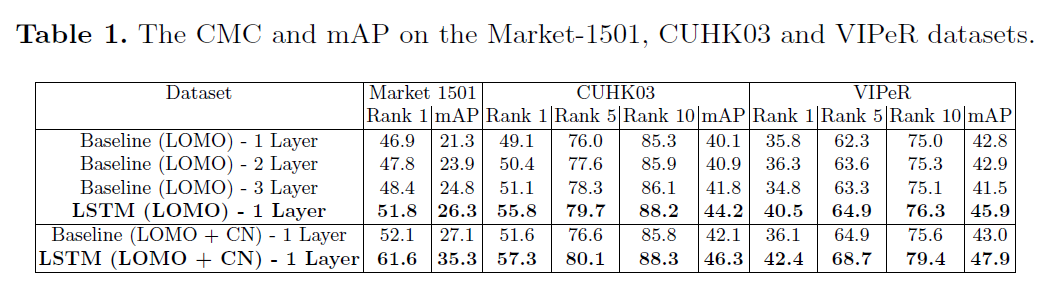

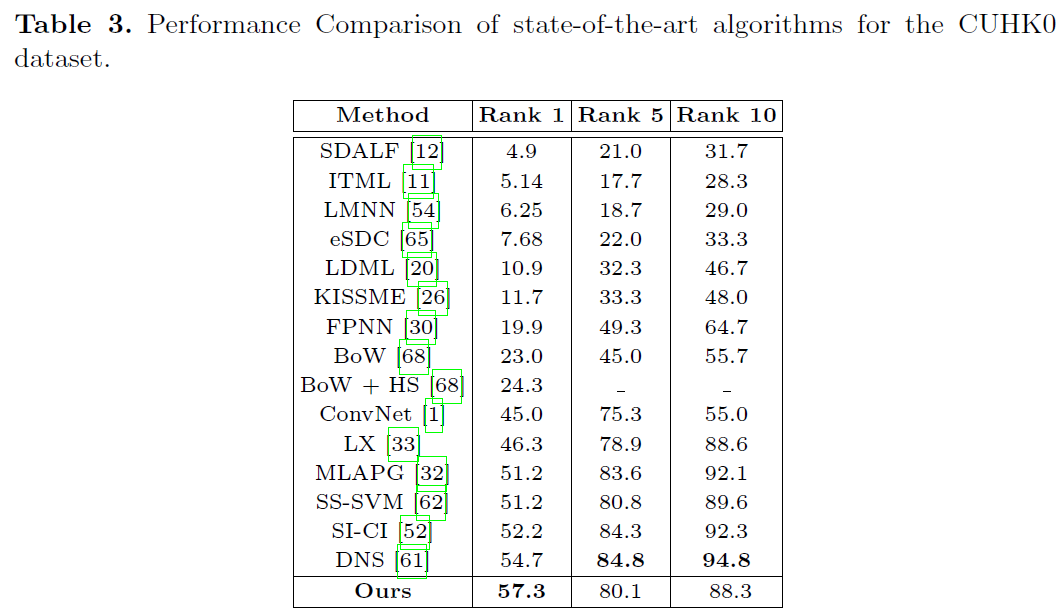

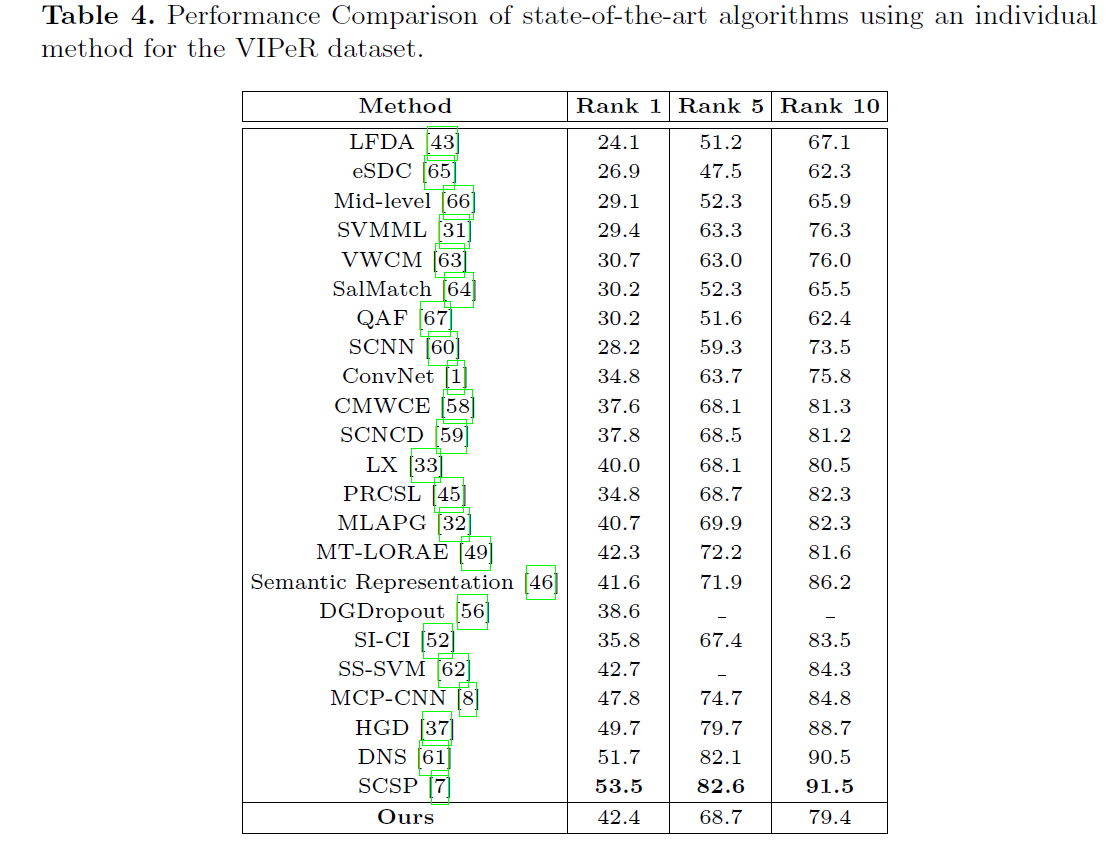

- Market-1501, CUHK03 and VIPeR数据集上达到当时的最优。

1. Introduction

当计算直方图或者卷积+池化操作时,得到的特征是局部的,并且特征之间互相独立。而引入RNN可以学习局部特征之间的关系。

2. Related Works

略。见深度学习行人重识别进展

3. 系统框架

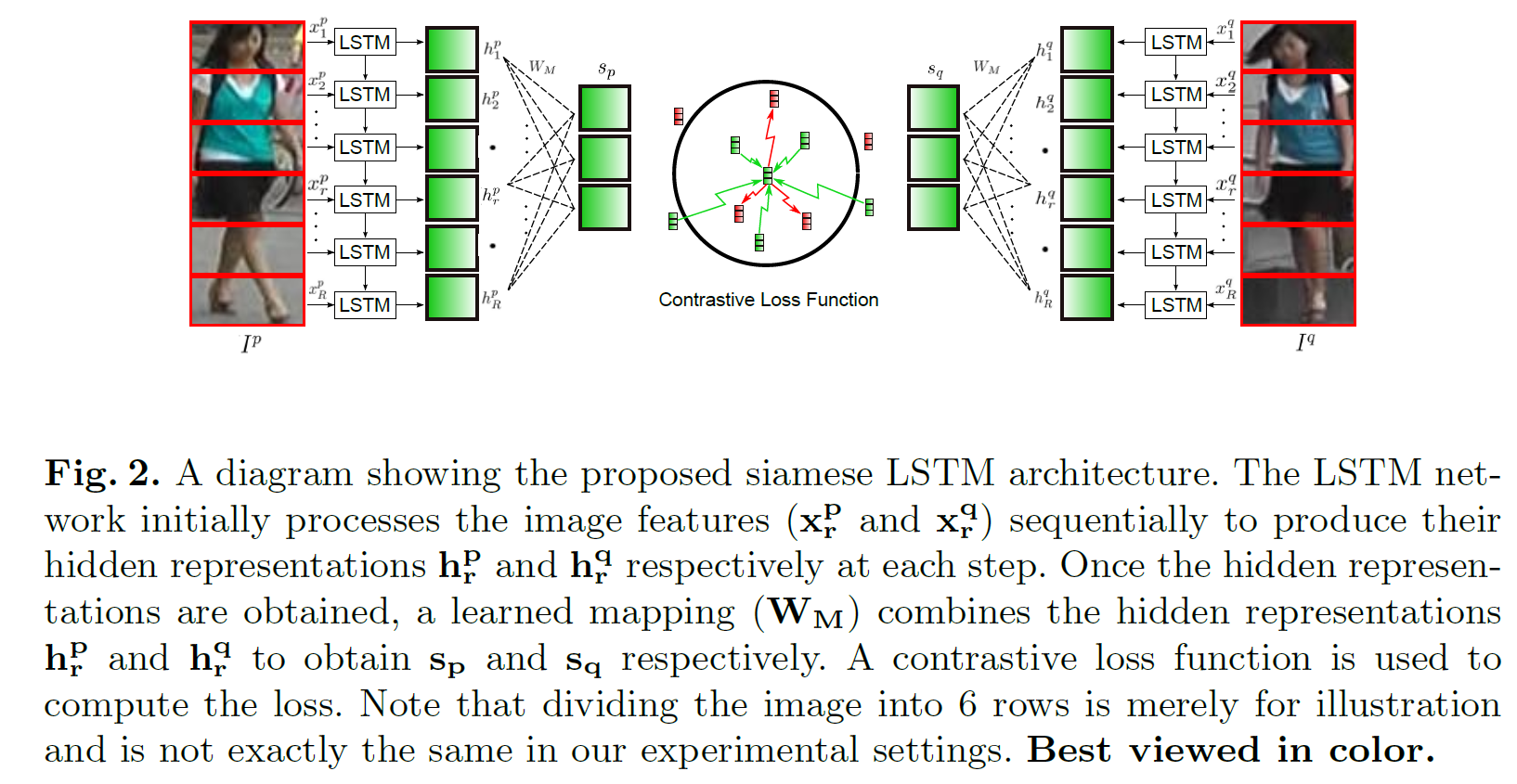

框架图如下图

流程:

A. 输入:将图像划分成若干个条带,对每个条带子图像块,不是输入原始图像,而是输入两个计算的特征。

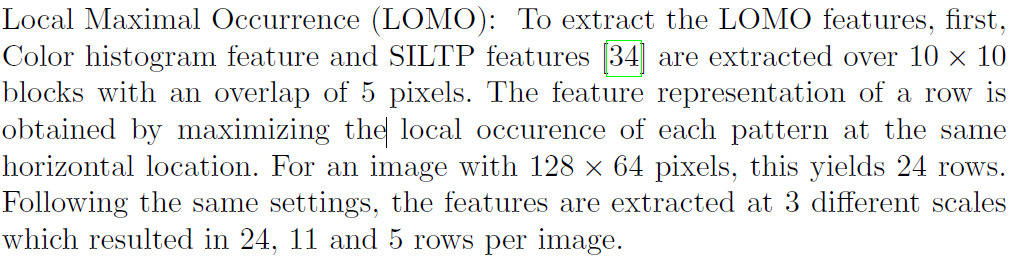

- 一个是Local Maximal Occurrence (LOMO)

![]()

- 一个是Color Names (CN)

![]()

B. 对于影像对$p,q$对应的第$r$个水平条带(行)的特征,分别形成两个向量$x_{r}^{p}, x_{r}^{q}$送入平行的LSTM网络(即孪生网络)。这里作者用单层LSTM网络。分别得到两个隐藏层输出$h_{r}^{p}, h_{r}^{q}$

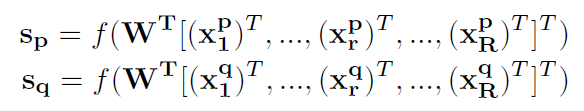

C. 然后按下述公式再乘以权重(这里是全连接层?)得到$s^{p}, s^{q}$

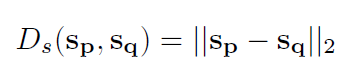

D. 最后,两个特征向量$s^{p}, s^{q}$的距离用欧式距离计算得到

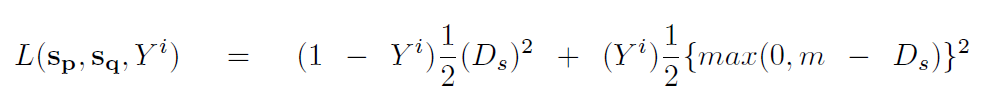

E. 损失计算是按照contrastive loss,在$s^{p}, s^{q}$基础上得到

训练

- 正负样本对是1:2

- 优化器是RMSProp

测试

query和gallery数据集中各有$N_{query}$和$N_{gallery}$张图像,各自两两配对送入孪生网络,那么就有$N_{query} \times N_{gallery}$个样本对。最后的决策取决于$s^{p}, s^{q}$之间的欧氏距离$D_s(s_p,s_q)$。如果使用了多个特征,就分别计算,最后算平均距离。

4. 实验

评价指标有三:

- CMC

- rank 1 accuracy(R1 Acc)

- mean average precision (mAP)

Baseline:同样的网络删除掉LSTM。将所有水平条带(行)的特征concatenate到一起作为输入(而不是用LSTM的隐藏层特征)。单层baseline可用下式表示

$f(\bullet)$表示非线性函数;$W$可学习。contrastive loss function是一样的。文章也用了多层的baseline。

4.1 数据集

5. 分析

浙公网安备 33010602011771号

浙公网安备 33010602011771号