概率论与数理统计复习

第0章 难点理解

详解最大似然估计(MLE)、最大后验概率估计(MAP),以及贝叶斯公式的理解 https://blog.csdn.net/u011508640/article/details/72815981

极大似然估计:https://zhuanlan.zhihu.com/p/26614750

极大似然估计和贝叶斯估计的区别(挺好):https://zhuanlan.zhihu.com/p/61593112

概率和统计是一个东西吗?

概率(probabilty)和统计(statistics)看似两个相近的概念,其实研究的问题刚好相反。

概率研究的问题是,已知一个模型和参数,怎么去预测这个模型产生的结果的特性(例如均值,方差,协方差等等)。 举个例子,我想研究怎么养猪(模型是猪),我选好了想养的品种、喂养方式、猪棚的设计等等(选择参数),我想知道我养出来的猪大概能有多肥,肉质怎么样(预测结果)。

统计研究的问题则相反。统计是,有一堆数据,要利用这堆数据去预测模型和参数。仍以猪为例。现在我买到了一堆肉,通过观察和判断,我确定这是猪肉(这就确定了模型。在实际研究中,也是通过观察数据推测模型是/像高斯分布的、指数分布的、拉普拉斯分布的等等),然后,可以进一步研究,判定这猪的品种、这是圈养猪还是跑山猪还是网易猪,等等(推测模型参数)。

一句话总结:概率是已知模型和参数,推数据。统计是已知数据,推模型和参数。

显然,本文解释的MLE和MAP都是统计领域的问题,是很常用的两种参数估计方法。它们都是用来推测参数的方法。为什么会存在着两种不同方法呢? 这需要理解贝叶斯思想。我们来看看贝叶斯公式。

贝叶斯公式到底在说什么?

$ P(A|B)=\frac{P(B|A)P(A)}{P(B)} $ 式1

把B展开,可以写成:

$ P(A|B)=\frac{P(B|A)P(A)}{P(B|A)P(A)+P(B|\sim A)P(\sim A)} $ 式2,~A表示非A

补充:AB表示同时发生.AB拔表示A发生,B不发生.所以,只要A发生,只有两种情况,就是B发生,B不发生,也就是A发生的概率等于A发生,B不发生的概率+AB同时发生的概率.所以P(AB)+P(AB拔)=P(A)

想想这个情况。一辆汽车(或者电瓶车)的警报响了,你通常是什么反应?有小偷?撞车了? 不。。 你通常什么反应都没有。因为汽车警报响一响实在是太正常了!每天都要发生好多次。本来,汽车警报设置的功能是,出现了异常情况,需要人关注。然而,由于虚警实在是太多,人们渐渐不相信警报的功能了。

贝叶斯公式就是在描述,你有多大把握能相信一件证据?(how much you can trust the evidence)

我们假设响警报的目的就是想说汽车被砸了。把A计作“汽车被砸了”,B计作“警报响了”,带进贝叶斯公式里看。

- 左侧:我们想求等式左边发生A ∣ B 的概率,这是在说警报响了(B),汽车也确实被砸了(A)。

- 右侧:汽车被砸**引起(trigger)**警报响,即B ∣ A 。但是,也有可能是汽车被小孩子皮球踢了一下、被行人碰了一下等其他原因(统统计作 ~A ),其他原因引起汽车警报响了,即 B ∣ ~ A 。

那么,现在突然听见警报响了,这时汽车已经被砸了的概率是多少呢(这即是说,警报响这个证据有了,多大把握能相信它确实是在报警说汽车被砸了?)?

想一想,应当这样来计算。用警报响起、汽车也被砸了这事件的数量 P(AB),除以响警报事件的数量 P(B) (这即【式1】)。

进一步展开,即警报响起、汽车也被砸了的事件的数量,除以警报响起、汽车被砸了的事件数量 加上 警报响起、汽车没被砸的事件数量(这即【式2】)。

可能有点绕,请稍稍想一想。

再思考【式2】。想让P ( A ∣ B ) = 1 ,即警报响了,汽车一定被砸了,该怎么做呢?让 P(B|~ A)P(~ A) = 0 即 可 。 很容易想清楚,假若让P(~ A) = 0,即杜绝了汽车被球踢、被行人碰到等等其他所有情况,那自然,警报响了,只剩下一种可能——汽车被砸了。这即是提高了响警报这个证据的说服力。

从这个角度总结贝叶斯公式:做判断的时候,要考虑所有的因素。 老板骂你,不一定是你把什么工作搞砸了,可能只是他今天出门前和太太吵了一架。

再思考【式2】。观察【式2】右边的分子,P ( B ∣ A )为汽车被砸后响警报的概率。姑且仍为这是1吧。但是,若P ( A ) 很小,即汽车被砸的概率本身就很小,则P ( B ∣ A ) P ( A ) 仍然很小,即【式2】右边分子仍然很小,P(A | B) 还是大不起来。 这里,P ( A ) 即是常说的先验概率(如果A的先验概率P(A)很小),就算P ( B ∣ A )较大,可能A的后验概率P ( A ∣ B )还是不会大(假设P ( B ∣ ∼ A ) P ( ∼ A ) 不变的情况下)。

从这个角度思考贝叶斯公式:一个本来就难以发生的事情,就算出现某个证据和他强烈相关,也要谨慎。证据很可能来自别的虽然不是很相关,但发生概率较高的事情。 发现刚才写的代码编译报错,可是我今天状态特别好,这语言我也很熟悉,犯错的概率很低。因此觉得是编译器出错了。 ————别,还是先再检查下自己的代码吧。

似然函数

似然(likelihood)这个词其实和概率(probability)是差不多的意思,Colins字典这么解释:The likelihood of something happening is how likely it is to happen. 你把likelihood换成probability,这解释也读得通。但是在统计里面,似然函数和概率函数却是两个不同的概念(其实也很相近就是了)。

对于这个函数:P ( x ∣ θ )

输入有两个:x表示某一个具体的数据;θ 表示模型的参数。

- 如果θ 是已知确定的,x 是变量,这个函数叫做概率函数(probability function),它描述对于不同的样本点x,其出现概率是多少。

- 如果x 是已知确定的,θ 是变量,这个函数叫做似然函数(likelihood function), 它描述对于不同的模型参数,出现x这个样本点的概率是多少。

这有点像“一菜两吃”的意思。其实这样的形式我们以前也不是没遇到过。例如,f(x, y) = x^y , 即x的y次 方 。如果x是 已 知 确 定 的 (例如是已知确定的(例如x = 2) ,这就是f(y) = 2^y, 这 是 指 数 函 数 。 如果y是 已 知 确 定 的(例如y = 2) ,这就是f(x) = x^2,这是二次函数。同一个数学形式,从不同的变量角度观察,可以有不同的名字。

这么说应该清楚了吧? 如果还没讲清楚,别急,下文会有具体例子。

现在真要先讲讲MLE了。。

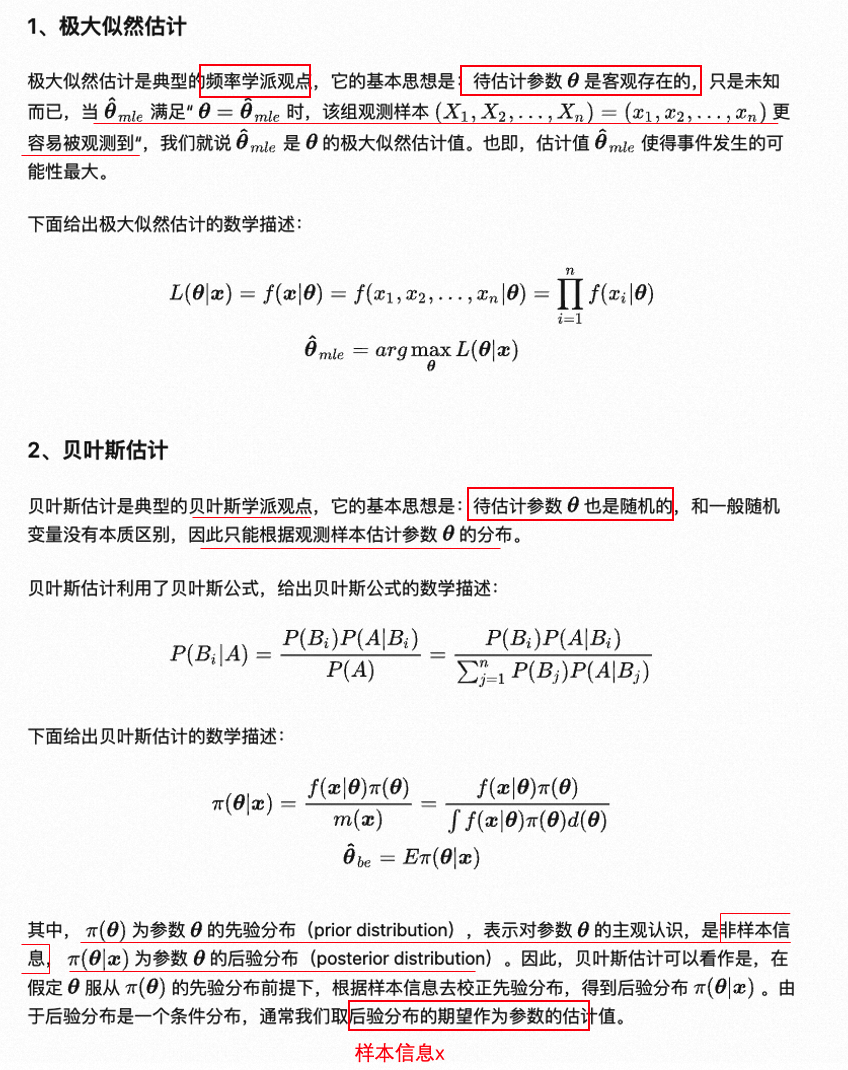

极大似然估计(Maximum likelihood estimation, 简称MLE)

假设有一个造币厂生产某种硬币,现在我们拿到了一枚这种硬币,想试试这硬币是不是均匀的。即想知道抛这枚硬币,正反面出现的概率(记为θ )各是多少?

这是一个统计问题,回想一下,解决统计问题需要什么? 数据!

于是我们拿这枚硬币抛了10次,得到的数据(x0 )是:反正正正正反正正正反。我们想求的正面概率θ 是模型参数,而抛硬币模型我们可以假设是 二项分布。

那么,出现实验结果x0(即反正正正正反正正正反)的似然函数是多少呢?

f ( x 0 , θ ) = ( 1 − θ ) × θ × θ × θ × θ × ( 1 − θ ) × θ × θ × θ × ( 1 − θ ) = θ^7 ( 1 − θ )^3 = f ( θ )

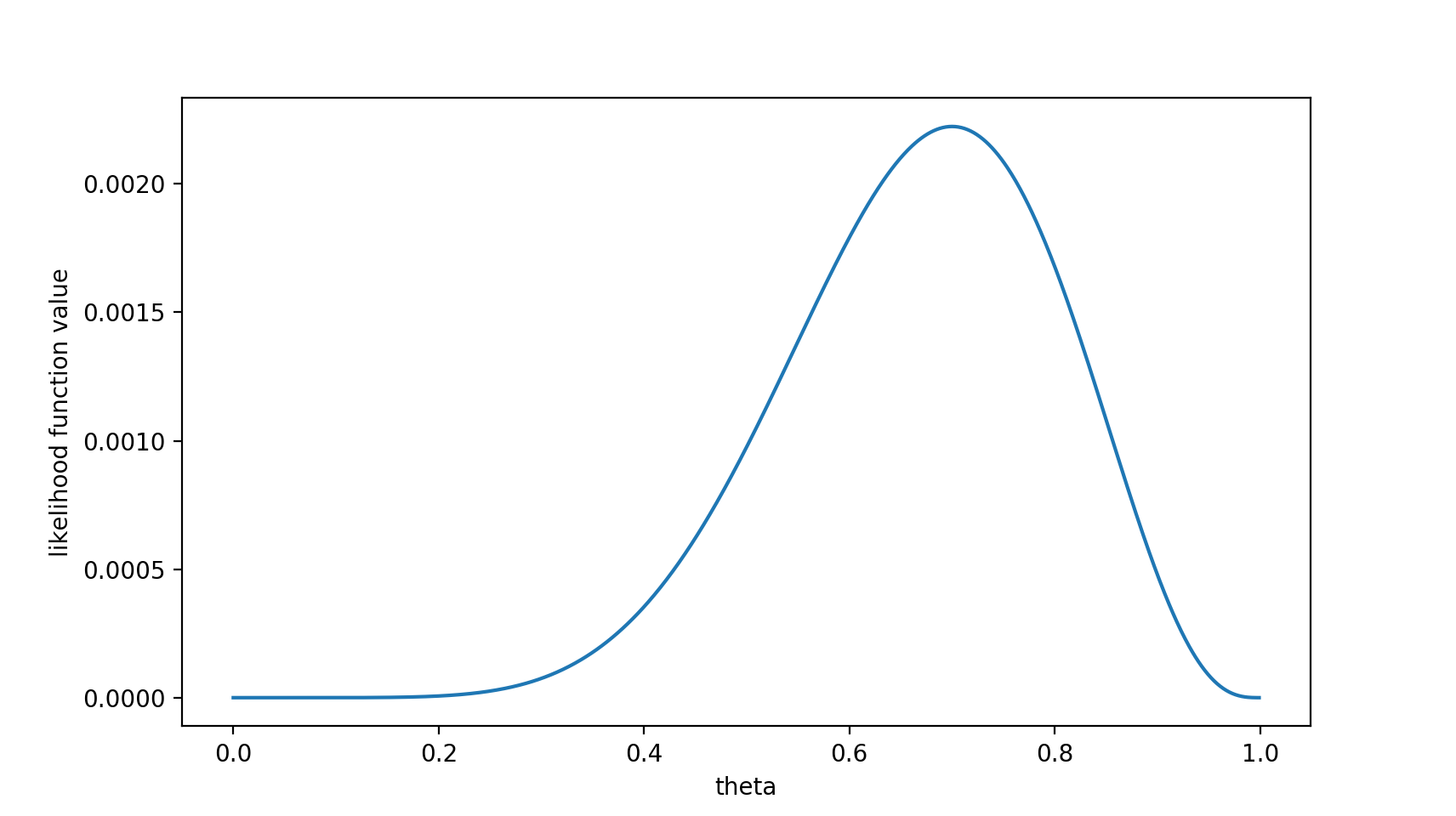

注意,这是个只关于θ 的函数。而最大似然估计,顾名思义,就是要最大化这个函数。我们可以画出f ( θ ) 的图像:

可以看出,在θ = 0.7时,似然函数取得最大值。

这样,我们已经完成了对θ 的最大似然估计。即,抛10次硬币,发现7次硬币正面向上,最大似然估计认为正面向上的概率是0.7。(ummm…这非常直观合理,对吧?)

且慢,一些人可能会说,硬币一般都是均匀的啊! 就算你做实验发现结果是“反正正正正反正正正反”,我也不信θ = 0.7。

这里就包含了贝叶斯学派的思想了——要考虑先验概率。 为此,引入了最大后验概率估计。

例题

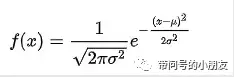

假设一批电池的寿命符合高斯分布,概率密度就上面这个式子吧:

σ,μ >0均为未知参数,从这批电池中随机抽取3件进行寿命实验,失效时间分别是4,5,7

求σ,μ的最大似然估计。

首先我们每个数据点都是独立于其他数据点生成的。如果事件(即电池寿命测试)是独立的,那么观察所有数据的总概率就是单独观察到每个数据点的概率的乘积(即边缘概率的乘积)

1.写出样本联合概率密度方程:

只要求使得L(μ,σ)取最大值的μ,σ就好了。。

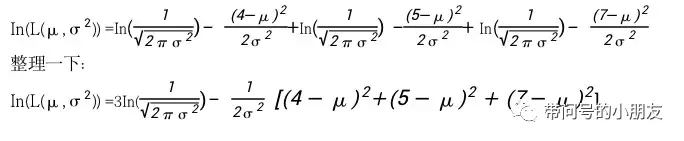

但是上面的函数求起来非常的困难,所以我们转换为对数似然函数

2.对数似然函数如下:

接下来就是我们熟悉的二元方程求极值的问题了,考研必考~

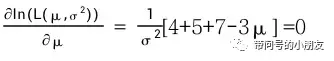

3.先找平均值 μ,我们对函数求 μ 的偏导:

解得μ = 5.333 = (4+5+7)/3

同理:找σ^2 对函数求σ的偏导:

然后把μ代入求σ即可~

解得σ = 1.85 , σ^2 = (1/m)∑(x^(i) - μ )^2 =

想一想高斯分布的图形就明白了,似然方程一定是唯一解,而且一定是最大值~

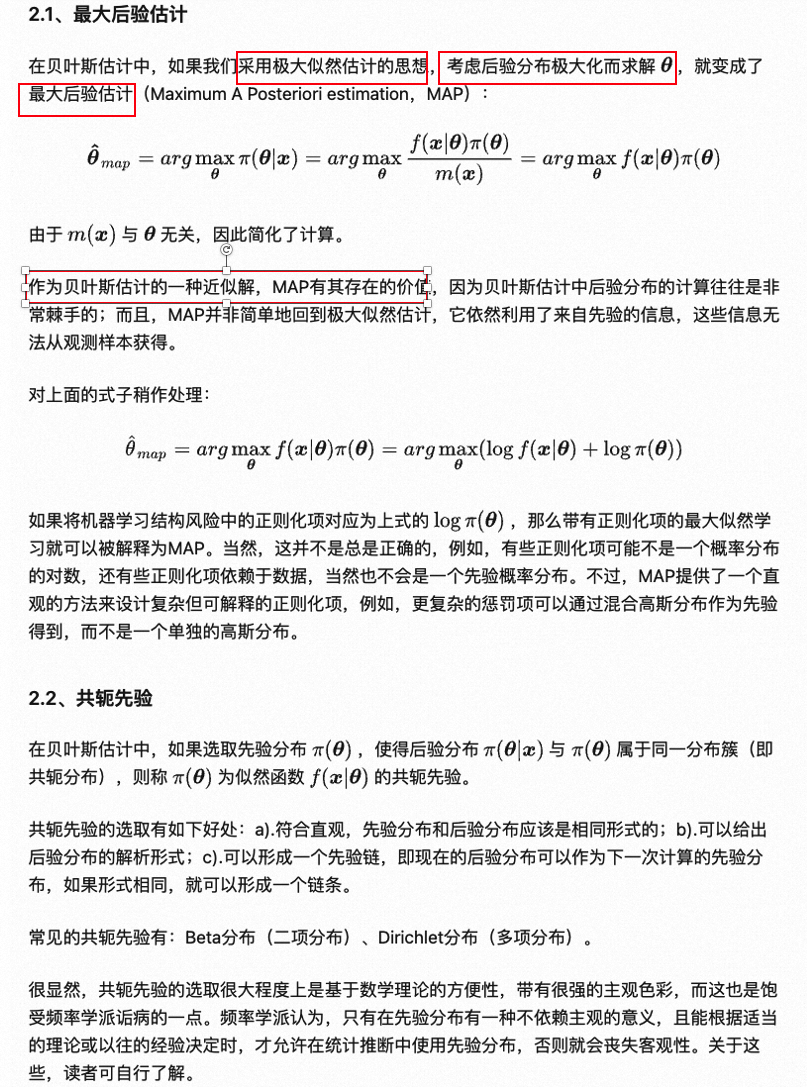

最大后验概率估计(Maximum a posteriori estimation, 简称MAP)

- 最大似然估计是求参数θ , 使似然函数P(x0 | θ) 最 大 (x0是确定的)。

- 最大后验概率估计则是想求θ ,使P(x0 | θ ) P(θ)最 大 。求得的θ 不单单让似然函数P(x0 | θ)大,θ 自己出现的 先验概率P (θ)也得大。 (这有点像正则化里加惩罚项的思想,不过正则化里是利用加法,而MAP里是利用乘法)

MAP其实是在最大化 P(θ | x0) = P(x0 | θ) P(θ) / P(x0);不过因为x0是确定的(即投出的“反正正正正反正正正反”),所以去掉了分母P(x0)(假设“投10次硬币”是一次实验,实验做了1000次,“反正正正正反正正正反”出现了n次,则P ( x 0 ) = n / 1000 。总之,这是一个可以由数据集得到的值)。

最大化P ( θ ∣ x0 ) 的意义也很明确,x0 已经出现了,要求θ取什么值使P ( θ ∣ x 0 ) 最大。顺带一提,P ( θ ∣ x 0 ) 即后验概率,这就是“最大后验概率估计”名字的由来。

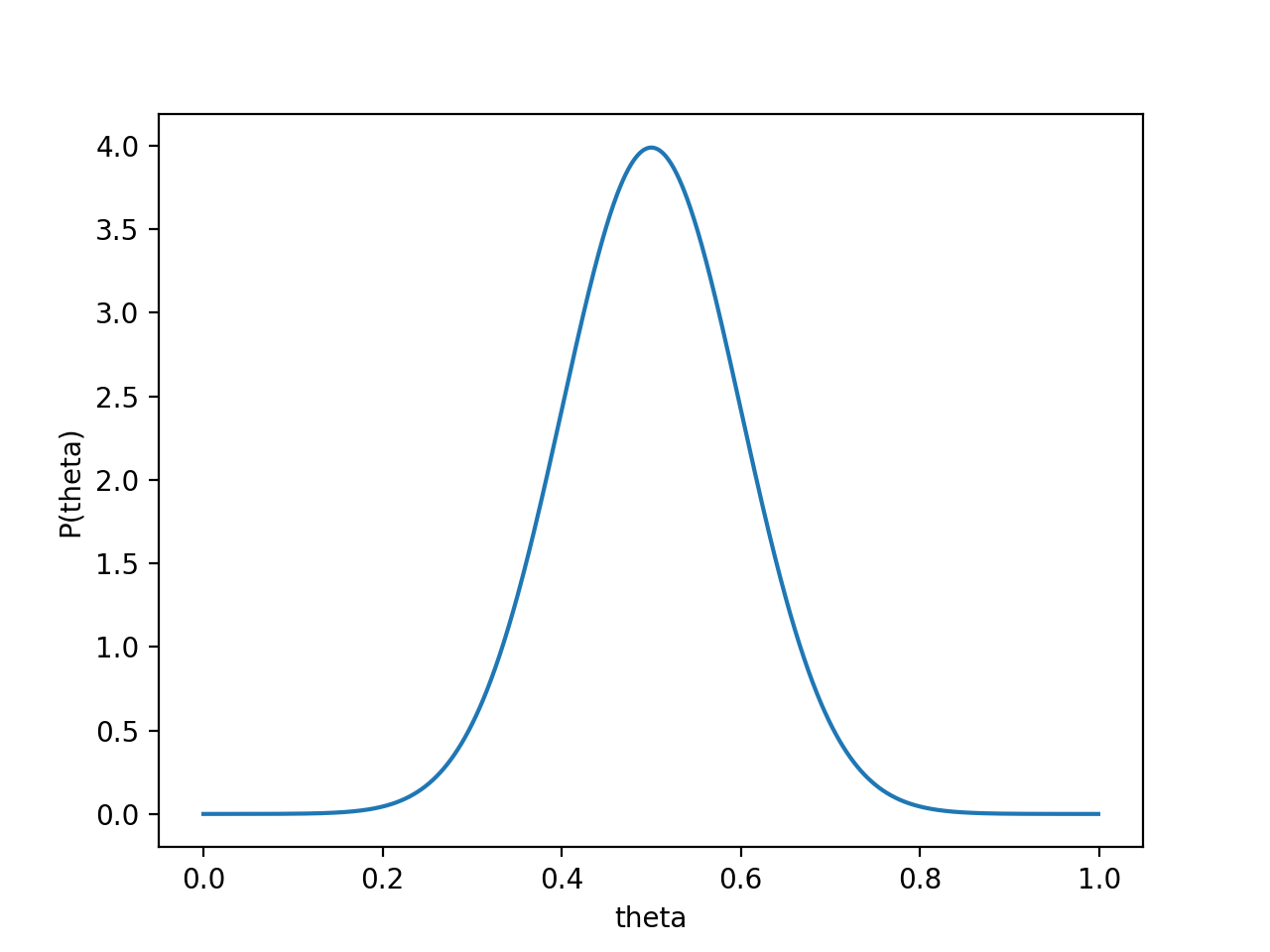

对于投硬币的例子来看,我们认为(”先验地知道“)θ 取0.5的概率很大,取其他值的概率小一些。我们用一个高斯分布来具体描述我们掌握的这个先验知识,例如假设P ( θ ) 为均值0.5,方差0.1的高斯函数,如下图:

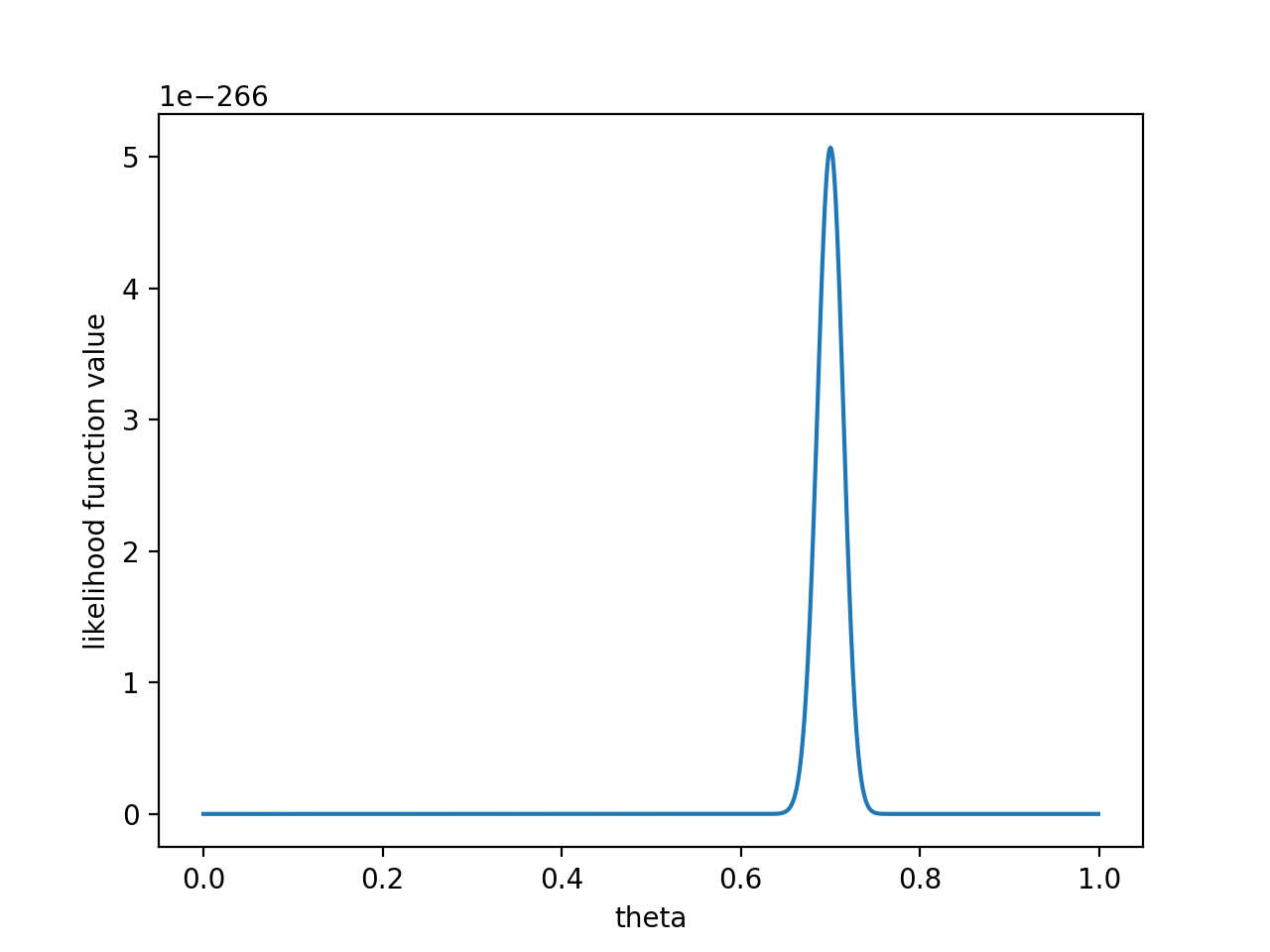

则P ( x0 ∣ θ ) P ( θ )的函数图像为:

注意,此时函数取最大值时,θ 取值已向左偏移,不再是0.7。实际上,在θ = 0.558 时函数取得了最大值。即,用最大后验概率估计,得到θ = 0.558

最后,那要怎样才能说服一个贝叶斯派相信θ = 0.7 呢?你得多做点实验。。如果做了1000次实验,其中700次都是正面向上,这时似然函数为:

如果仍然假设P ( θ ) 为均值0.5,方差0.1的高斯函数,P ( x0 ∣ θ ) P ( θ ) 的函数图像为:

在θ = 0.696 处,P ( x0 ∣ θ ) P ( θ ) 取得最大值。

这样,就算一个考虑了先验概率的贝叶斯派,也不得不承认得把 θ 估计在0.7附近了。

PS. 要是遇上了顽固的贝叶斯派,认为P ( θ = 0.5 ) = 1 ,那就没得玩了。。 无论怎么做实验,使用MAP估计出来都是θ = 0.5 。这也说明,一个合理的先验概率假设是很重要的。(通常,先验概率能从数据中直接分析得到)

最大似然估计和最大后验概率估计的区别??

相信读完上文,MLE(极大似然估计)和MAP(最大后验估计)的区别应该是很清楚的了。MAP就是多个作为因子的先验概率P ( θ )。或者,也可以反过来,认为MLE是把先验概率P ( θ ) 认为等于1,即认为θ 是均匀分布。

极大似然估计和贝叶斯估计的区别

期望和均值的区别

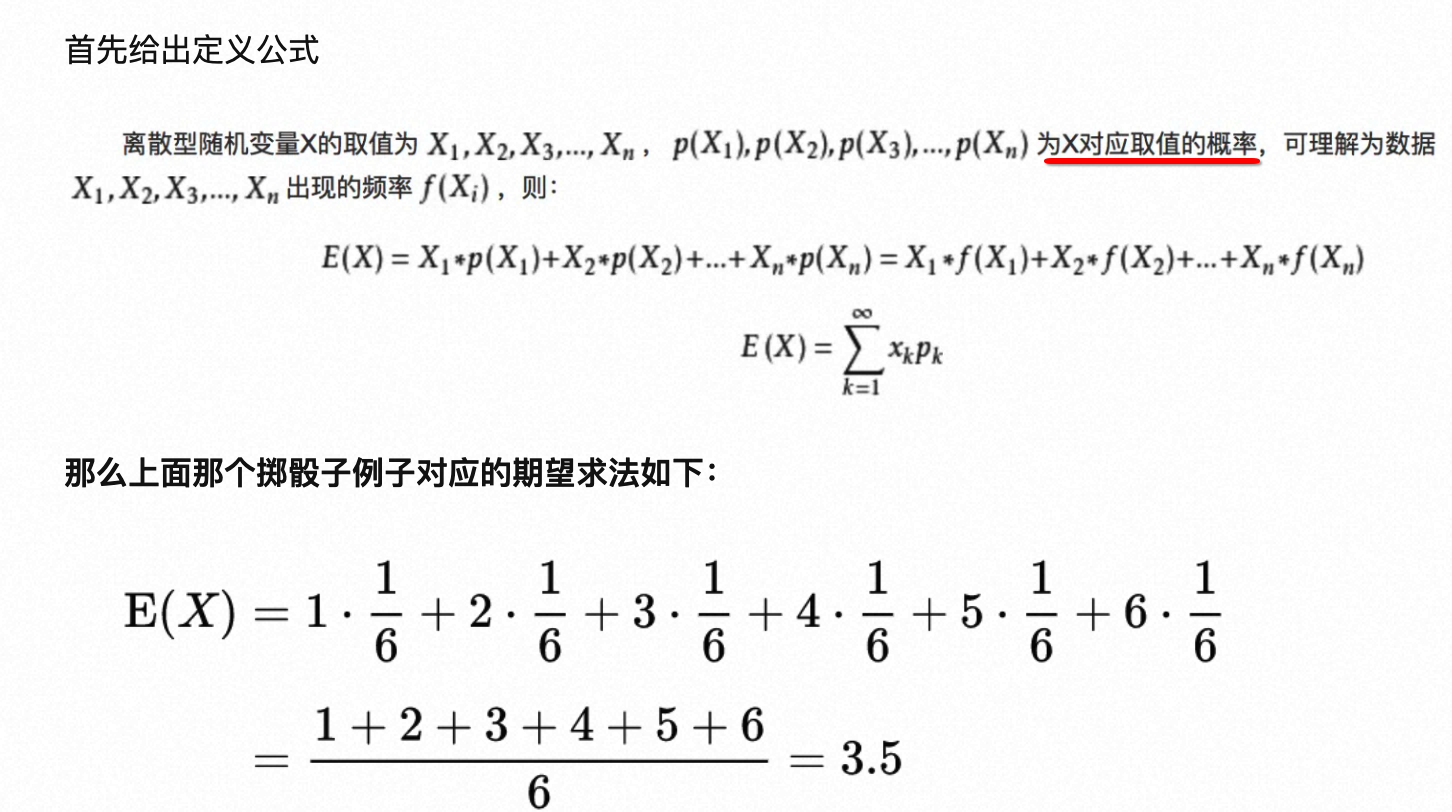

- 平均值属于《数理统计》的范畴(对观察样本的统计),期望属于《概率论》的范畴(期望是针对于随机变量而言的一个量,可以理解是一种站在“上帝视角”的值。针对于他的样本空间而言的,是一个数学特征);期望就是加权平均(以概率为权),平均就是等权均值。

- 均值,其实是针对实验观察到的特征样本而言的。

- 比如我们进行掷骰子,掷了六次,点数分别为2,2,2,4,4,4,这六次的观察就是我们的样本,于是我们可以说均值为(2+2+2+4+4+4)/6=3

- 期望:例子如下图

- 期望的描述引述陈希孺院士《概率论与数理统计》如下:数学期望常称为“均值”,即“随机变量取值的平均值”之意,当然这个平均,是指以概率为权的加权平均。……数学期望是由随机变量的分布完全决定。

- 均值,其实是针对实验观察到的特征样本而言的。

- 联系:大数定理说明当样本量N趋近无穷大的时候,样本的平均值无限接近数学期望。

https://zhuanlan.zhihu.com/p/34150914

大数定律和中心极限定理

https://zhuanlan.zhihu.com/p/259280292

第一章 概率论的基本概念

一.基本概念

随机试验E:(1)可以在相同的条件下重复地进行;(2)每次试验的可能结果不止一个,并且能事先明确试验的所有可能结果;(3)进行一次试验之前不能确定哪一个结果会出现.

样本空间S: E的所有可能结果组成的集合. 样本点(基本事件):E的每个结果.

随机事件(事件):样本空间S的子集.

必然事件(S):每次试验中一定发生的事件. 不可能事件(F):每次试验中一定不会发生的事件.

二. 事件间的关系和运算

1.AB(事件B包含事件A )事件A发生必然导致事件B发生.

2.A∪B(和事件)事件A与B至少有一个发生.

3. A∩B=AB(积事件)事件A与B同时发生.

4. A-B(差事件)事件A发生而B不发生.

5. AB=F (A与B互不相容或互斥)事件A与B不能同时发生.

6. AB=F且A∪B=S (A与B互为逆事件或对立事件)表示一次试验中A与B必有一个且仅有一个发生. B=A, A=B .

运算规则 交换律 结合律 分配律 德•摩根律

三. 概率的定义与性质

1.定义 对于E的每一事件A赋予一个实数,记为P(A),称为事件A的概率.

(1)非负性 P(A)≥0 ; (2)归一性或规范性 P(S)=1 ;

(3)可列可加性 对于两两互不相容的事件A1,A2,…(A iAj=φ, i≠j, i,j=1,2,…),

P(A1∪A2∪…)=P( A1)+P(A2)+…

2.性质

(1) P(F) = 0 , 注意: A为不可能事件 P(A)=0 .

(2)有限可加性 对于n个两两互不相容

的事件A1,A2,…,A n ,

P(A1∪A2∪…∪A n)=P(A1)+P(A2)+…+P(A n) (有限可加性与可列可加性合称加法定理)

(3)若AB, 则P(A)≤P(B), P(B-A)=P(B)-P(A) .

(4)对于任一事件A, P(A)≤1, P(A)=1-P(A) .

(5)广义加法定理 对于任意二事件A,B ,P(A∪B)=P(A)+P(B)-P(AB) .

对于任意n个事件A1,A2,…,A n

…+(-1)n-1P(A1A2…A n)

四.等可能(古典)概型

1.定义 如果试验E满足:(1)样本空间的元素只有有限个,即S={e1,e2,…,e n};(2)每一个基本事件的概率相等,即P(e1)=P(e2)=…= P(e n ).则称试验E所对应的概率模型为等可能(古典)概型.

2.计算公式 P(A)=k / n 其中k是A中包含的基本事件数, n是S中包含的基本事件总数.

五.条件概率

1.定义 事件A发生的条件下事件B发生的条件概率P(B|A)=P(AB) / P(A) ( P(A)>0).

2.乘法定理 P(AB)=P(A) P (B|A) (P(A)>0); P(AB)=P(B) P (A|B) (P(B)>0).

P(A1A2…A n)=P(A1)P(A2|A1)P(A3|A1A2)…P(A n|A1A2…A n-1) (n≥2, P(A1A2…A n-1) > 0)

3. B1,B2,…,B n是样本空间S的一个划分(BiBj=φ,i≠j,i,j=1,2,…,n, B1∪B2∪…∪B n=S) ,则

当P(B i)>0时,有全概率公式 P(A)=

当P(A)>0, P(B i)>0时,有贝叶斯公式P (Bi|A)= .

六.事件的独立性

1.两个事件A,B,满足P(AB) = P(A) P(B)时,称A,B为相互独立的事件.

(1)两个事件A,B相互独立Û P(B)= P (B|A) .

(2)若A与B,A与,与B, ,与中有一对相互独立,则另外三对也相互独立.

2.三个事件A,B,C满足P(AB) =P(A) P(B), P(AC)= P(A) P(C), P(BC)= P(B) P(C),称A,B,C三事件两两相互独立. 若再满足P(ABC) =P(A) P(B) P(C),则称A,B,C三事件相互独立.

3.n个事件A1,A2,…,A n,如果对任意k (1<k≤n),任意1≤i1<i2<…<i k≤n.有

,则称这n个事件A1,A2,…,A n相互独立.

第二章 随机变量及其概率分布

一.随机变量及其分布函数

1.在随机试验E的样本空间S={e}上定义的单值实值函数X=X (e)称为随机变量.

2.随机变量X的分布函数F(x)=P{X≤x} , x是任意实数. 其性质为:

(1)0≤F(x)≤1 ,F(-∞)=0,F(∞)=1. (2)F(x)单调不减,即若x1<x2 ,则 F(x1)≤F(x 2).

(3)F(x)右连续,即F(x+0)=F(x). (4)P{x1<X≤x2}=F(x2)-F(x1).

二.离散型随机变量 (只能取有限个或可列无限多个值的随机变量)

1.离散型随机变量的分布律 P{X= x k}= p k (k=1,2,…) 也可以列表表示. 其性质为:

(1)非负性 0≤Pk≤1 ; (2)归一性 .

2.离散型随机变量的分布函数 F(x)=为阶梯函数,它在x=x k (k=1,2,…)处具有跳跃点,其跳跃值为p k=P{X=x k} .

3.三种重要的离散型随机变量的分布

(1)X~(0-1)分布 P{X=1}= p ,P{X=0}=1–p (0<p<1) .

(2)X~b(n,p)参数为n,p的二项分布P{X=k}=(k=0,1,2,…,n) (0<p<1)

(3))X~p(l)参数为l的泊松分布 P{X=k}= (k=0,1,2,…) (l>0)

三.连续型随机变量

1.定义 如果随机变量X的分布函数F(x)可以表示成某一非负函数f(x)的积分F(x)=,-∞< x <∞,则称X为连续型随机变量,其中f (x)称为X的概率密度(函数).

2.概率密度的性质

(1)非负性 f(x)≥0 ; (2)归一性 =1 ;

(3) P{x 1<X≤x 2}= ; (4)若f (x)在点x处连续,则f (x)=F/ (x) .

注意:连续型随机变量X取任一指定实数值a的概率为零,即P{X= a}=0 .

3.三种重要的连续型随机变量的分布

(1)X~U (a,b) 区间(a,b)上的均匀分布 .

(2)X服从参数为q的指数分布.

(q>0).

(3)X~N (m,s2 )参数为m,s的正态分布 -¥<x<¥, s>0.

特别, m=0, s2 =1时,称X服从标准正态分布,记为X~N (0,1),其概率密度

, 标准正态分布函数 , F(-x)=1-Φ(x) .

若X~N ((m,s2), 则Z=~N (0,1), P{x1<X≤x2}=Φ()-Φ().

若P{Z>z a}= P{Z<-z a}= P{|Z|>z a/2}= a,则点z a,-z a, ±z a/ 2分别称为标准正态分布的上,下,双侧a分位点. 注意:F(z a)=1-a , z 1- a= -z a.

四.随机变量X的函数Y= g (X)的分布

1.离散型随机变量的函数

|

X |

x 1 x2 … x k … |

|

p k |

p 1 p2 … p k … |

|

Y=g(X) |

g(x1) g(x2) … g(x k) … |

若g(x k) (k=1,2,…)的值全不相等,则由上表立得Y=g(X)的分布律.

若g(x k) (k=1,2,…)的值有相等的,则应将相等的值的概率相加,才能得到Y=g(X)的分布律.

2.连续型随机变量的函数

若X的概率密度为fX(x),则求其函数Y=g(X)的概率密度fY(y)常用两种方法:

(1)分布函数法 先求Y的分布函数FY(y)=P{Y≤y}=P{g(X)≤y}=

其中Δk(y)是与g(X)≤y对应的X的可能值x所在的区间(可能不只一个),然后对y求导即得fY(y)=FY /(y) .

(2)公式法 若g(x)处处可导,且恒有g /(x)>0 (或g / (x)<0 ),则Y=g (X)是连续型随机变量,其概率密度为

其中h(y)是g(x)的反函数 , a= min (g (-¥),g (¥)) b= max (g (-¥),g (¥)) .

如果f (x)在有限区间[a,b]以外等于零,则 a= min (g (a),g (b)) b= max (g (a),g (b)) .

第三章 二维随机变量及其概率分布

一.二维随机变量与联合分布函数

1.定义 若X和Y是定义在样本空间S上的两个随机变量,则由它们所组成的向量(X,Y)称为二维随机向量或二维随机变量.

对任意实数x,y,二元函数F(x,y)=P{X≤x,Y≤y}称为(X,Y)的(X和Y的联合)分布函数.

2.分布函数的性质

(1)F(x,y)分别关于x和y单调不减.

(2)0≤F(x,y)≤1 , F(x,- ¥)=0, F(-¥,y)=0, F(-¥,-¥)=0, F(¥,¥)=1 .

(3) F(x,y)关于每个变量都是右连续的,即 F(x+0,y)= F(x,y), F(x,y+0)= F(x,y) .

(4)对于任意实数x 1<x 2 , y 1<y 2

P{x 1<X≤x 2 , y 1<Y≤y 2}= F(x2,y2)- F(x2,y1)- F(x1,y2)+ F(x1,y1)

二.二维离散型随机变量及其联合分布律

1.定义 若随机变量(X,Y)只能取有限对或可列无限多对值(x i,y j) (i ,j =1,2,… )称(X,Y)为二维离散型随机变量.并称P{X= x i,Y= y j }= p i j为(X,Y)的联合分布律.也可列表表示.

2.性质 (1)非负性 0≤p i j≤1 . (2)归一性 .

3. (X,Y)的(X和Y的联合)分布函数F(x,y)=

三.二维连续型随机变量及其联合概率密度

1.定义 如果存在非负的函数f (x,y),使对任意的x和y,有F(x,y)=

则称(X,Y)为二维连续型随机变量,称f(x,y)为(X,Y)的(X和Y的联合)概率密度.

2.性质 (1)非负性 f (x,y)≥0 . (2)归一性 .

(3)若f (x,y)在点(x,y)连续,则

(4)若G为xoy平面上一个区域,则.

四.边缘分布

1. (X,Y)关于X的边缘分布函数 FX (x) = P{X≤x , Y<¥}= F (x , ¥) .

(X,Y)关于Y的边缘分布函数 FY (y) = P{X<¥, Y≤y}= F (¥,y)

2.二维离散型随机变量(X,Y)

关于X的边缘分布律 P{X= x i }= = p i· ( i =1,2,…) 归一性 .

关于Y的边缘分布律 P{Y= y j }= = p·j ( j =1,2,…) 归一性 .

3.二维连续型随机变量(X,Y)

关于X的边缘概率密度f X (x)= 归一性

关于Y的边缘概率密度f Y (y)= 归一性

五.相互独立的随机变量

1.定义 若对一切实数x,y,均有F(x,y)= FX (x) FY (y) ,则称X和Y相互独立.

2.离散型随机变量X和Y相互独立p i j= p i··p·j ( i ,j =1,2,…)对一切xi,yj成立.

3.连续型随机变量X和Y相互独立f (x,y)=f X (x)f Y (y)对(X,Y)所有可能取值(x,y)都成立.

六.条件分布

1.二维离散型随机变量的条件分布

定义 设(X,Y)是二维离散型随机变量,对于固定的j,若P{Y=yj}>0,则称

P{X=x i |Y=yj}

为在Y= yj条件下随机变量X的条件分布律.

同样,对于固定的i,若P{X=xi}>0,则称

P{Y=yj|X=x i}

为在X=xi条件下随机变量Y 的条件分布律.

第四章 随机变量的数字特征

一.数学期望和方差的定义

随机变量X 离散型随机变量 连续型随机变量

分布律P{X=x i}= pi ( i =1,2,…) 概率密度f (x)

数学期望(均值)E(X) (级数绝对收敛) (积分绝对收敛)

方差D(X)=E{[X-E(X)]2}

=E(X2)-[E(X)]2 (级数绝对收敛) (积分绝对收敛)

函数数学期望E(Y)=E[g(X)] (级数绝对收敛) (积分绝对收敛)

标准差s(X)=√D(X) .

二.数学期望与方差的性质

1. c为为任意常数时, E(c) = c , E(cX) = cE(X) , D(c) = 0 , D (cX) = c 2 D(X) .

2.X,Y为任意随机变量时, E (X±Y)=E(X)±E(Y) .

3. X与Y相互独立时, E(XY)=E(X)E(Y) , D(X±Y)=D(X)+D(Y) .

4. D(X) = 0 P{X = C}=1 ,C为常数.

三.六种重要分布的数学期望和方差 E(X) D(X)

1.X~ (0-1)分布P{X=1}= p (0<p<1) p p (1- p)

2.X~ b (n,p) (0<p<1) n p n p (1- p)

3.X~ p(l) l l

4.X~ U(a,b) (a+b)/2 (b-a) 2/12

5.X服从参数为q的指数分布 q q2

6.X~ N (m,s2) m s2

四.矩的概念

随机变量X的k阶(原点)矩E(X k ) k=1,2,…

随机变量X的k阶中心矩E{[X-E(X)] k}

随机变量X和Y的k+l阶混合矩E(X kY l) l=1,2,…

随机变量X和Y的k+l阶混合中心矩E{[X-E(X)] k [Y-E(Y)] l }

第六章 样本和抽样分布

一.基本概念

总体X即随机变量X ; 样本X1 ,X2 ,…,X n是与总体同分布且相互独立的随机变量;样本值x1 ,x2 ,…,x n为实数;n是样本容量.

统计量是指样本的不含任何未知参数的连续函数.如:

样本均值 样本方差 样本标准差S

样本k阶矩( k=1,2,…) 样本k阶中心矩( k=1,2,…)

二.抽样分布 即统计量的分布

1.的分布 不论总体X服从什么分布, E () = E(X) , D () = D(X) / n .

特别,若X~ N (m,s2 ) ,则 ~ N (m, s2 /n) .

2.c2分布 (1)定义 若X~N (0,1) ,则Y =~ c2(n)自由度为n的c2分布.

(2)性质 ①若Y~ c2(n),则E(Y) = n , D(Y) = 2n .

②若Y1~ c2(n1) Y2~ c2(n2) ,则Y1+Y2~ c2(n1 + n2).

③若X~ N (m,s2 ), 则~ c2(n-1),且与S2相互独立.

(3)分位点 若Y~ c2(n),0< a <1 ,则满足

的点分别称为c2分布的上、下、双侧a分位点.

3. t分布

(1)定义 若X~N (0,1),Y~ c2 (n),且X,Y相互独立,则t=~t(n)自由度为n的t分布.

(2)性质①n→∞时,t分布的极限为标准正态分布.

②X~N (m,s2 )时, ~ t (n-1) .

③两个正态总体 相互独立的样本 样本均值 样本方差

X~ N (m1,s12 ) 且s12=s22=s2 X1 ,X2 ,…,X n1 S12

Y~ N (m2,s22 ) Y1 ,Y2 ,…,Y n2 S22

则 ~ t (n1+n2-2) , 其中

(3)分位点 若t ~ t (n) ,0 < a<1 , 则满足

的点分别称t分布的上、下、双侧a分位点.

注意: t 1- a (n) = - ta (n).

4.F分布 (1)定义 若U~c2(n1), V~ c2(n2), 且U,V 相互独立,则F =~F(n1,n 2)自由度为(n1,n2)的F分布.

(2)性质(条件同3.(2)③) ~F(n1-1,n2-1)

(3)分位点 若F~ F(n1,n2) ,0< a <1,则满足

的点分别称为F分布的上、下、双侧a分位点. 注意:

第七章 参数估计

一.点估计 总体X的分布中有k个待估参数q1, q2,…, qk.

X1 ,X2 ,…,X n是X的一个样本, x1 ,x2 ,…,x n是样本值.

1.矩估计法

先求总体矩解此方程组,得到,

以样本矩Al取代总体矩m l ( l=1,2,…,k)得到矩估计量,

若代入样本值则得到矩估计值.

2.最大似然估计法

若总体分布形式(可以是分布律或概率密度)为p(x, q1, q2,…, qk),称样本X1 ,X2 ,…,X n的联合分布为似然函数.取使似然函数达到最大值的,称为参数q1, q2,…,qk的最大似然估计值,代入样本得到最大似然估计量.

若L(q1, q2,…, qk)关于q1, q2,…, qk可微,则一般可由

似然方程组 或 对数似然方程组 (i =1,2,…,k) 求出最大似然估计.

3.估计量的标准

(1) 无偏性 若E()=q,则估计量称为参数q的无偏估计量.

不论总体X服从什么分布, E ()= E(X) , E(S2)=D(X), E(Ak)=mk=E(Xk),即样本均值, 样本方差S2,样本k阶矩Ak分别

是总体均值E(X),方差D(X),总体k阶矩mk

的无偏估计,

(2)有效性 若E(1 )=E(2)= q, 而D(1)< D(2), 则称估计量1比2有效.

(3)一致性(相合性) 若n→∞时,,则称估计量是参数q的相合估计量.

二.区间估计

1.求参数q的置信水平为1-a的双侧置信区间的步骤

(1)寻找样本函数W=W(X1 ,X2 ,…,X n,q),其中只有一个待估参数q未知,且其分布完全确定.

(2)利用双侧a分位点找出W的区间(a,b),使P{a<W <b}=1-a.

(3)由不等式a<W<b解出则区间()为所求.

2.单个正态总体

待估参数 其它参数 W及其分布 置信区间

m s2已知 ~N (0,1) ()

m s2未知 ~ t (n-1)

s2 m未知 ~ c2(n-1)

3.两个正态总体

(1)均值差m 1-m 2

其它参数 W及其分布 置信区间

~ N(0,1)

~t(n1+n2-2)

其中Sw等符号的意义见第六章二. 3 (2)③.

(2) m 1,m 2未知, W=~ F(n1-1,n2-1),方差比s12/s22的置信区间为

注意:对于单侧置信区间,只需将以上所列的双侧置信区间中的上(下)限中的下标a/2改为a,另外的下(上)限取为-¥ (¥)即可.

http://blog.renren.com/share/239457523/10397960763

http://blog.csdn.net/viewcode/article/details/8819361

http://wenku.baidu.com/view/c9ad821c10a6f524ccbf8549.html

浙公网安备 33010602011771号

浙公网安备 33010602011771号