Linux离线部署ollama+deepseek

一、首先安装ollama

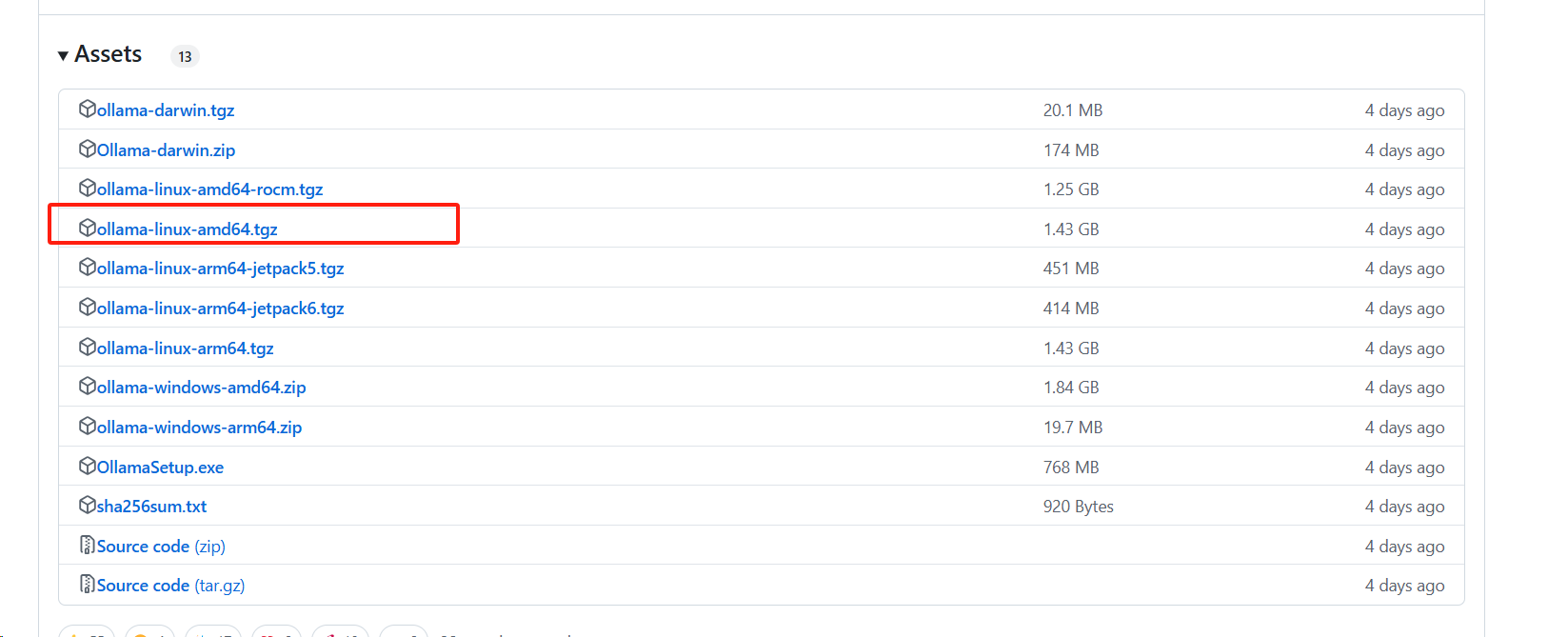

1.下载ollama的tgz包https://github.com/ollama/ollama/releases

下载慢的可以通过我的云盘获取

链接: https://pan.baidu.com/s/1eEDanHghm7HH8L8_YOA7Bw?pwd=x967 提取码: x967

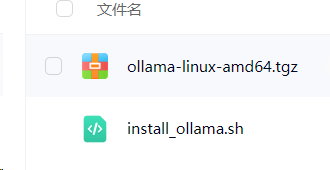

获取有两个文件,一个是ollama-linux-amd64.tgz,另一个是安装脚本install_ollama.sh

2.将两个文件上传到linux服务器,放于同一文件夹下

3.执行install_ollama.sh文件

chmod +x install_ollama.sh #给脚本赋予执行权限 ./install_ollama.sh # 如果报错误: bash: ./build_android.sh:/bin/sh^M:解释器错误: 没有那个文件或目录,执行下面命令后,再执行./install_ollama.sh命令 sed -i 's/\r$//' install_ollama.sh

3.配置ollama

vim /etc/systemd/system/ollama.service

[Unit] Description=Ollama Service After=network-online.target [Service] ExecStart=/usr/local/bin/ollama serve User=ollama Group=ollama Restart=always RestartSec=3 Environment="PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/root/bin:/usr/local/bin" Environment="OLLAMA_HOST=0.0.0.0:11434" Environment="OLLAMA_ORIGINS=*" [Install] WantedBy=default.target

修改后重载服务文件,重启ollama

sudo systemctl daemon-reload

sudo systemctl restart ollama

查看ollama运行状态

sudo systemctl status ollama.service

4.防火墙配置

开放11434端口

sudo firewall-cmd --permanent --zone=public --add-port=11434/tcp

重新加载

sudo firewall-cmd --reload

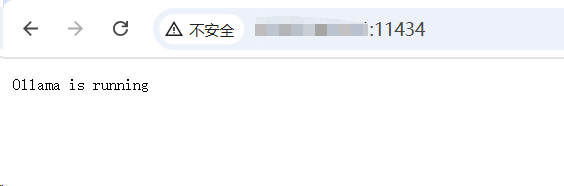

5.访问测试:使用其他计算机访问:http:/<服务器域名>:11434

若返回Ollama is running,说明可成功访问

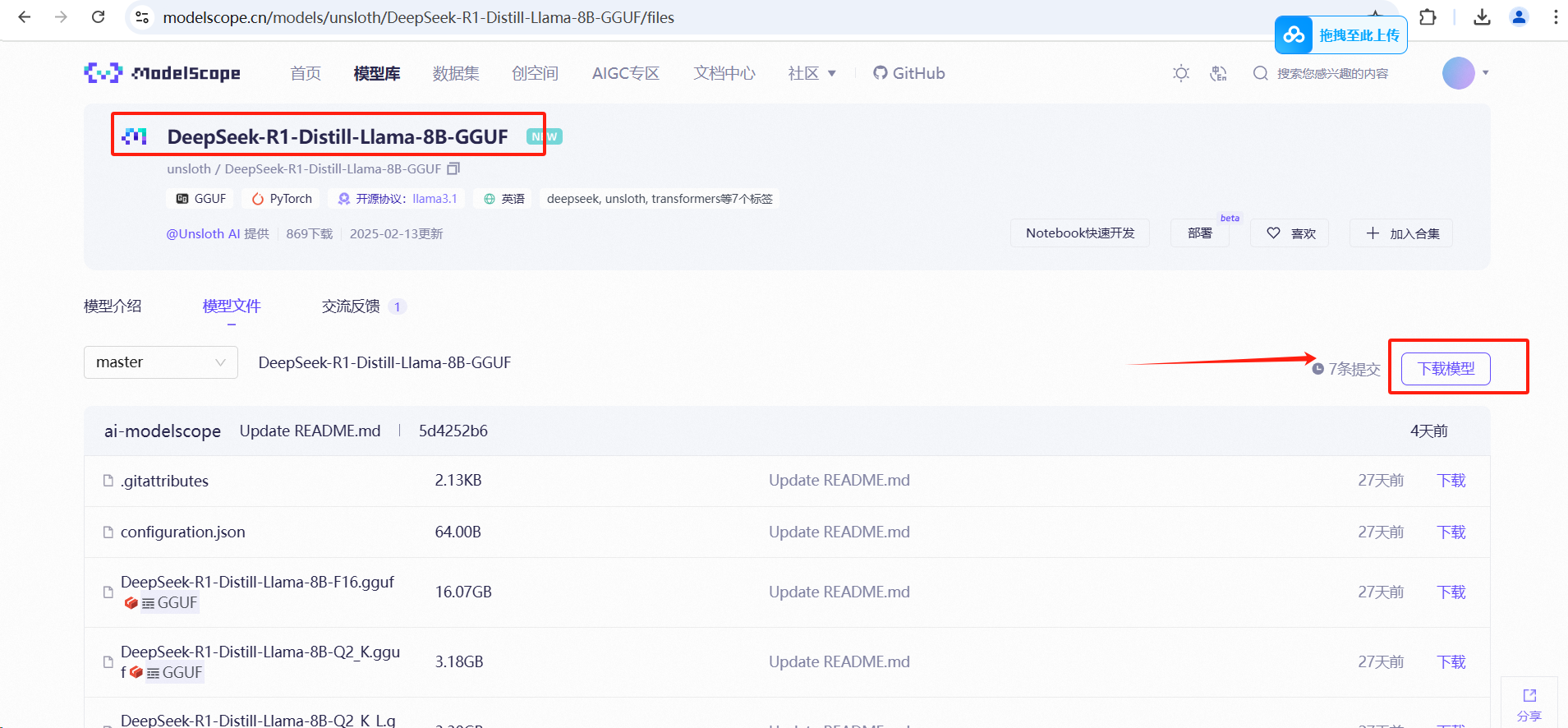

二、安装deepseek,这里例举DeepSeek-R1-Distill-Llama-8B

1.进入modelscope官网下载.gguf文件:https://www.modelscope.cn/models/unsloth/DeepSeek-R1-Distill-Qwen-7B-GGUF

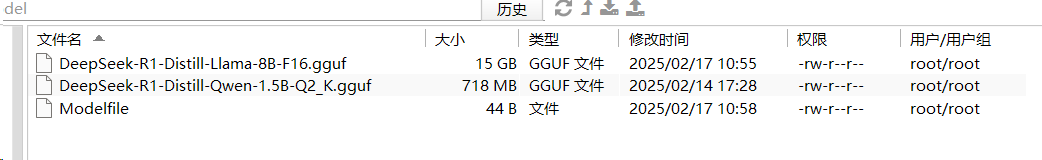

2.将下载好的.gguf文件上传至服务器,并手工新建一个Modelfile文件

Modelfile文件内容填写:FROM ./DeepSeek-R1-Distill-Llama-8B-F16.gguf

3.进入.gguf和Modelfile文件所在目录,执行以下命令

ollama create deepseek-r1:8b -f Modelfile

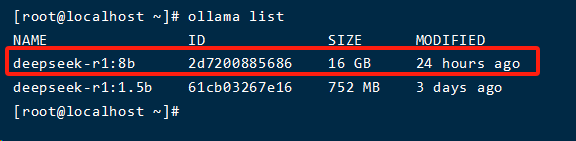

运行成功后,输入ollama list,看到下列信息则说明创建成功

运行

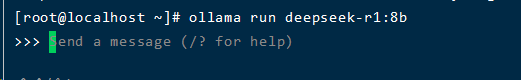

ollama run deepseek-r1:8b

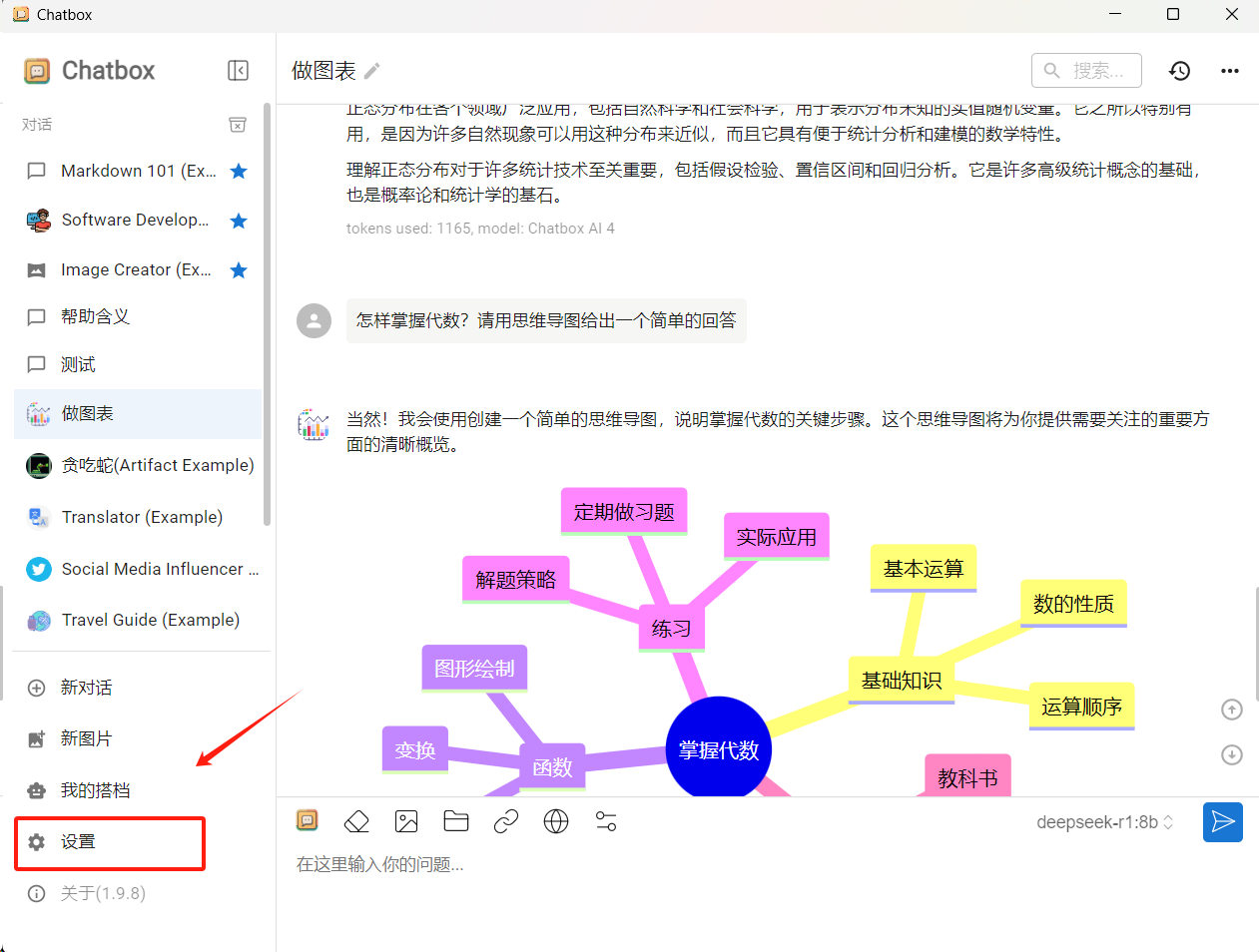

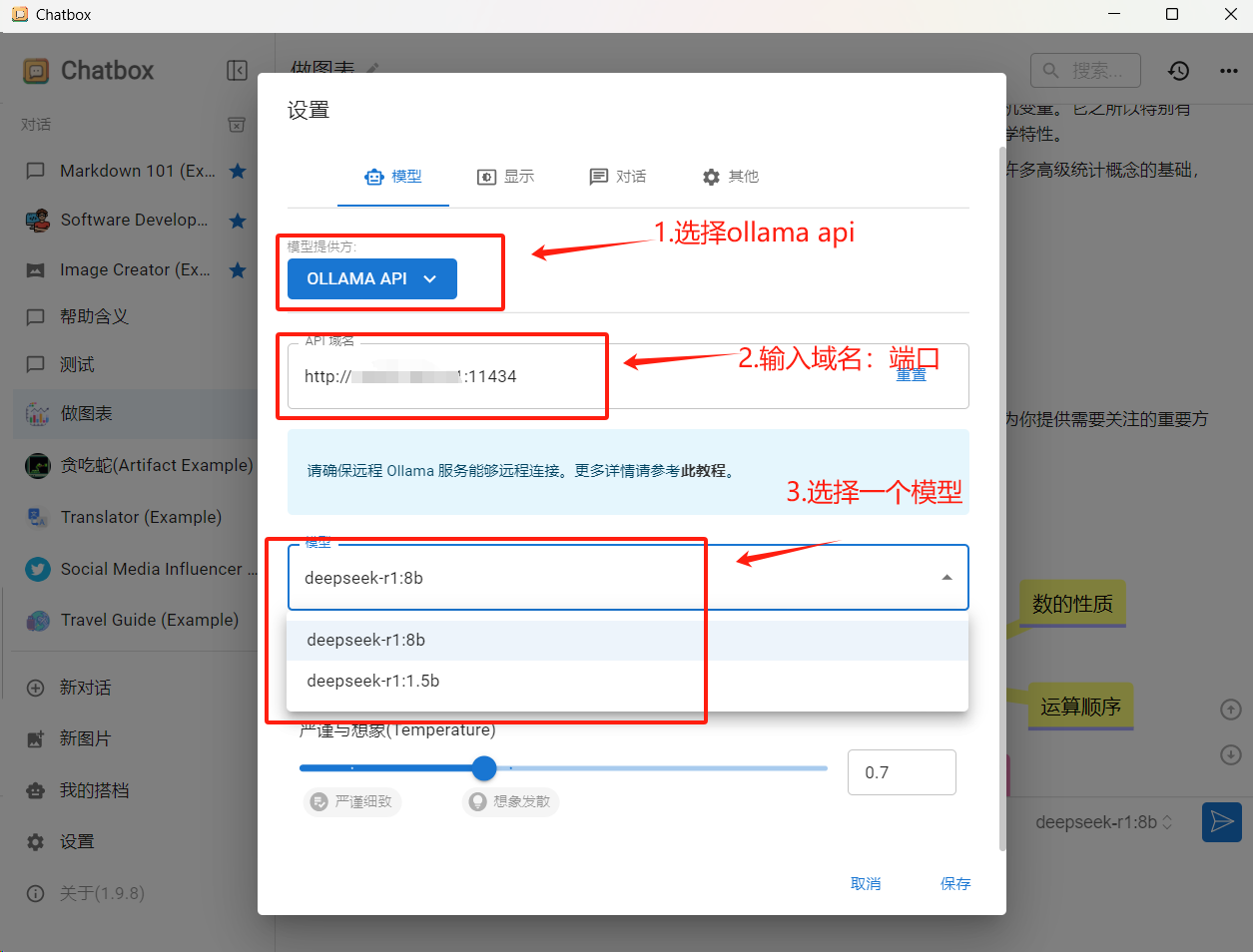

三、使用chatbox可视化窗口连接

1.chatbox下载地址:https://chatboxai.app/zh

下载安装完成后打开对话窗口如下,点击【设置】进行配置

配置完即可使用

浙公网安备 33010602011771号

浙公网安备 33010602011771号