从HBM4到HBM8:下一代HBM存储革命

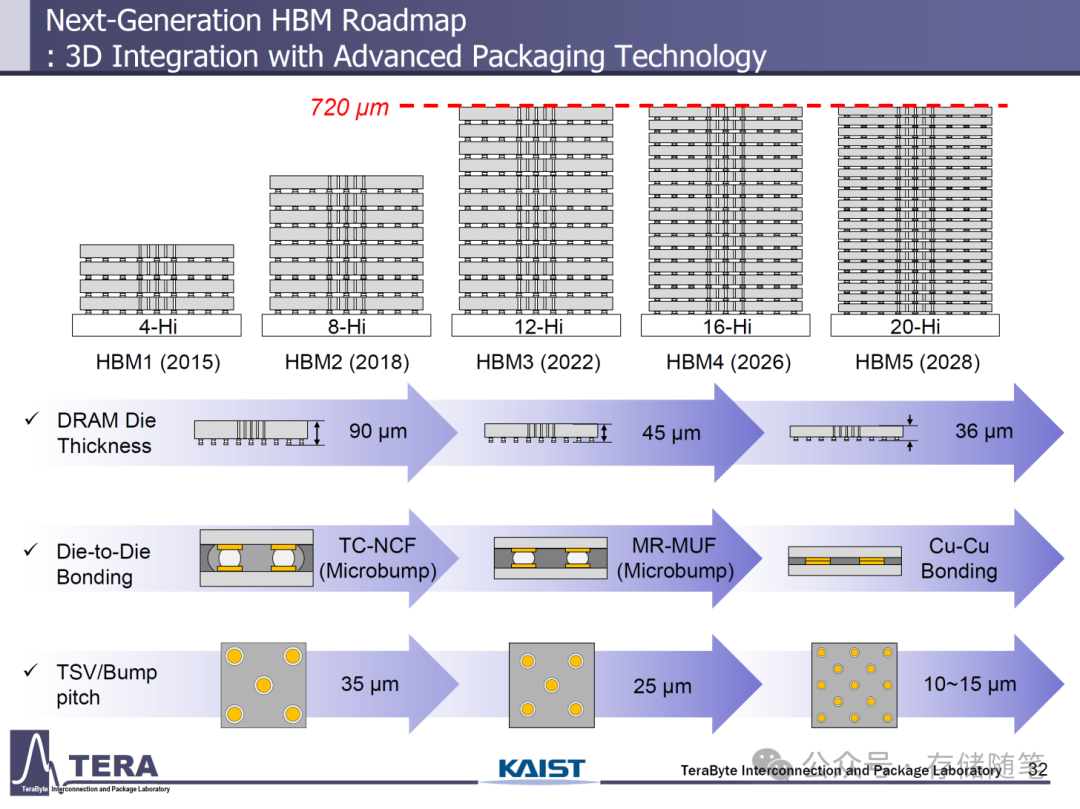

随着人工智能(AI)和数据中心需求的急剧增长,对高性能内存的需求也达到了前所未有的高度。在这种背景下,下一代高带宽内存(HBM)标准的发展成为了行业关注的焦点。近期,韩国科学技术院(KAIST)和Terabyte Interconnection and Package Laboratory的联合研究,详细阐述了HBM的未来路线图,揭示了HBM4到HBM8的诸多技术细节,这些标准的演进将为未来的数据中心和AI应用提供强大的支持。

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

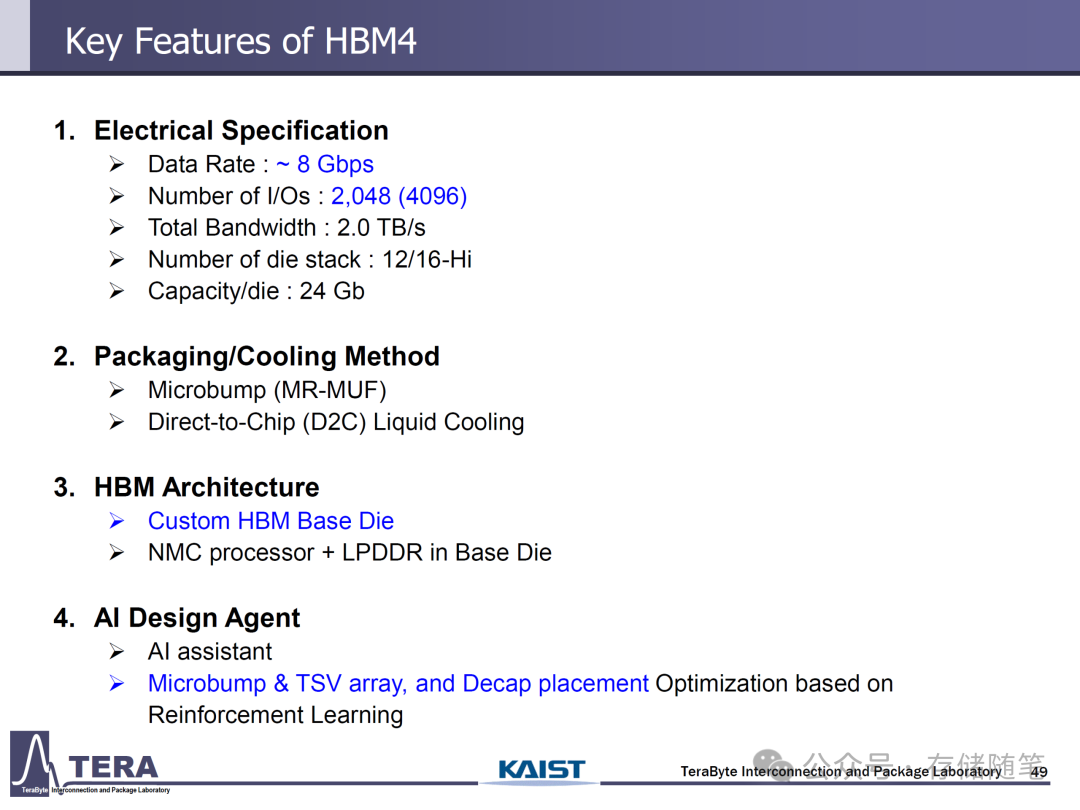

HBM4:迈向2026年的AI与数据中心新标配

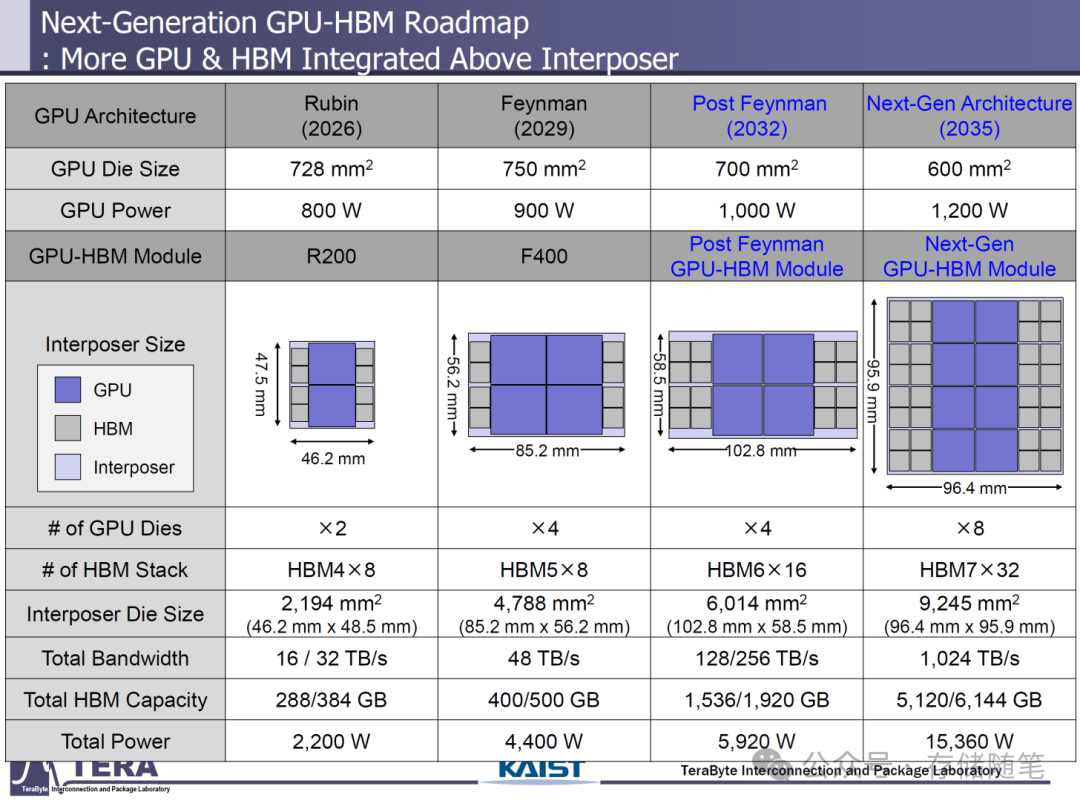

HBM4将成为2026年推出的下一代数据中心和AI GPU的核心内存标准。AMD和NVIDIA均已确认在其下一代产品(如NVIDIA的Rubin和AMD的Instinct MI400)中采用HBM4技术。根据KAIST和Terabyte的研究,NVIDIA的Rubin GPU将采用8个HBM4,而高端的Rubin Ultra则会配备16个HBM4。Rubin的GPU裸片面积预计为728平方毫米,单颗裸片功耗800W,其搭载的HBM4内存总容量可达288-384GB,总带宽16-32TB/s,整个芯片功耗2200W。

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

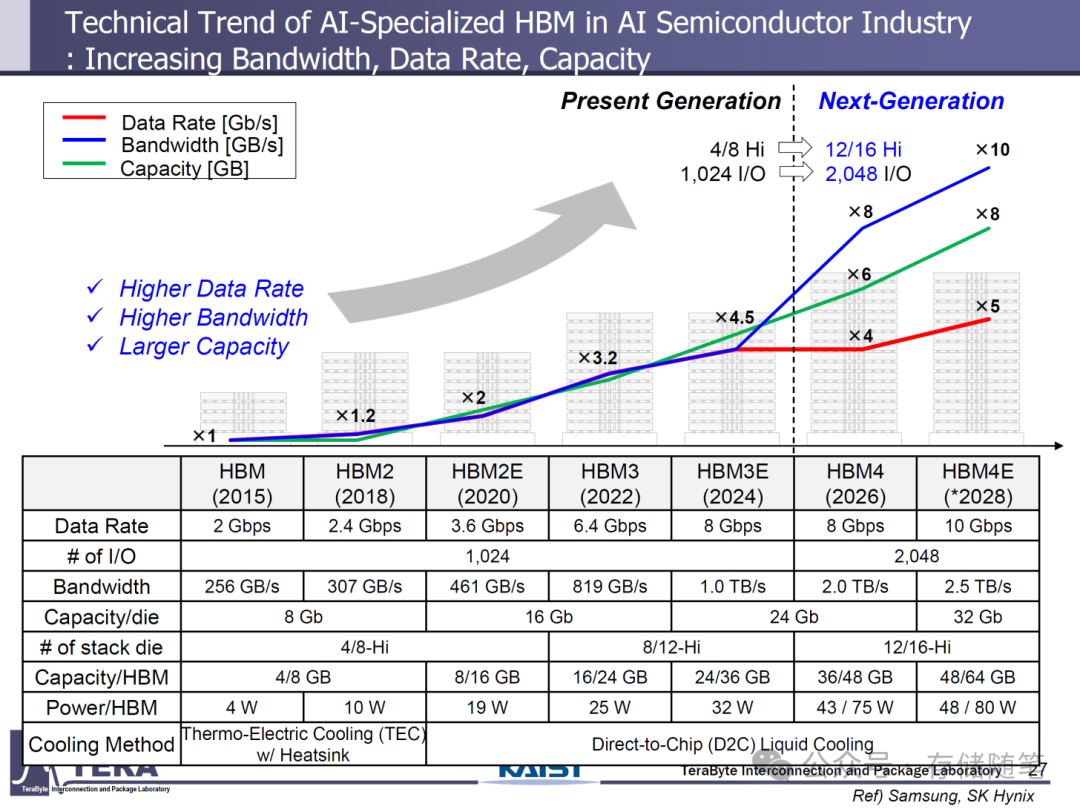

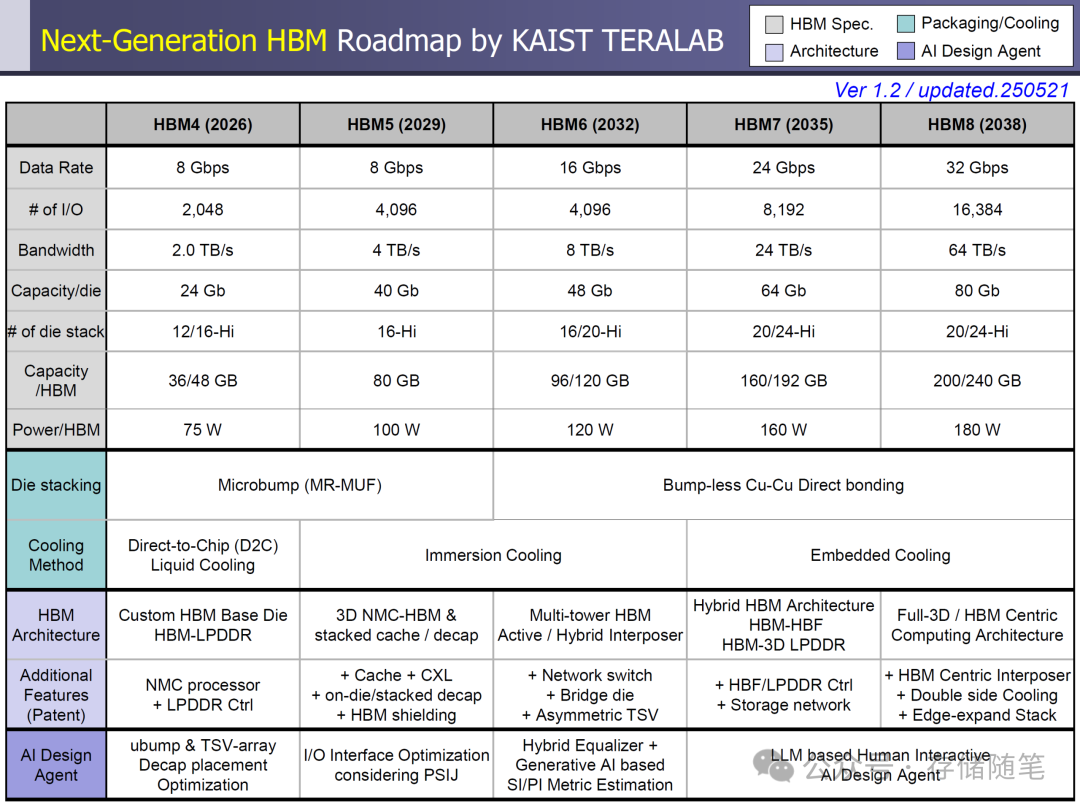

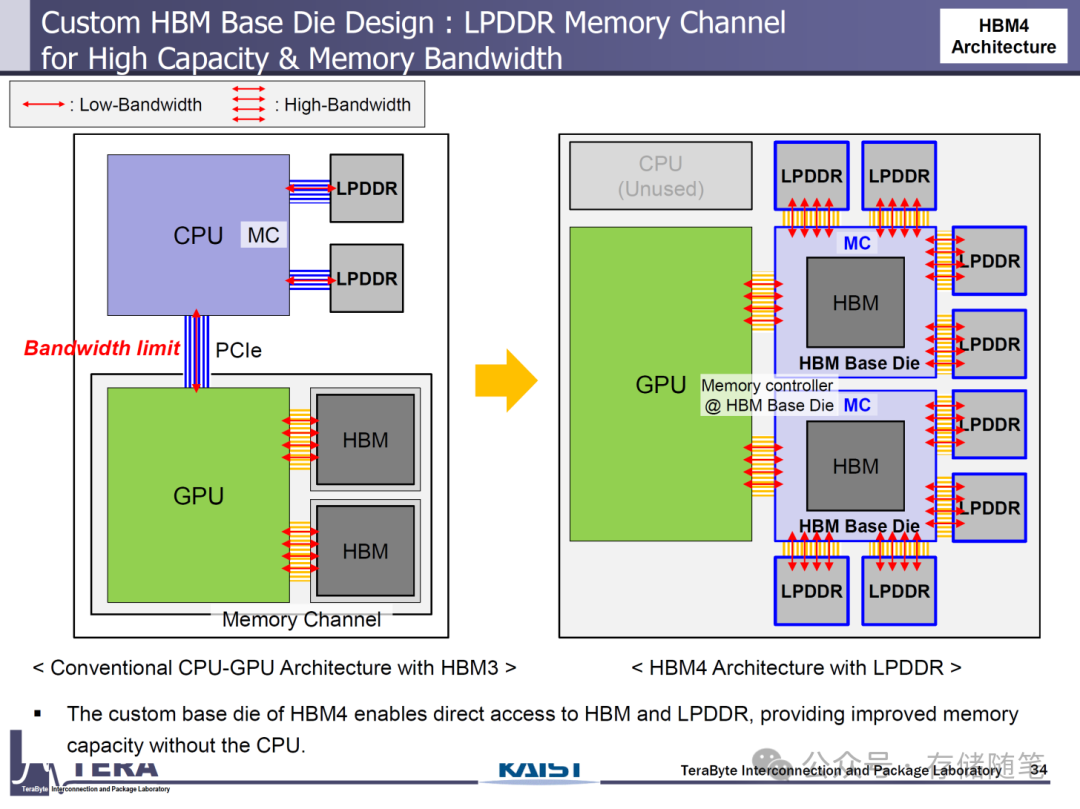

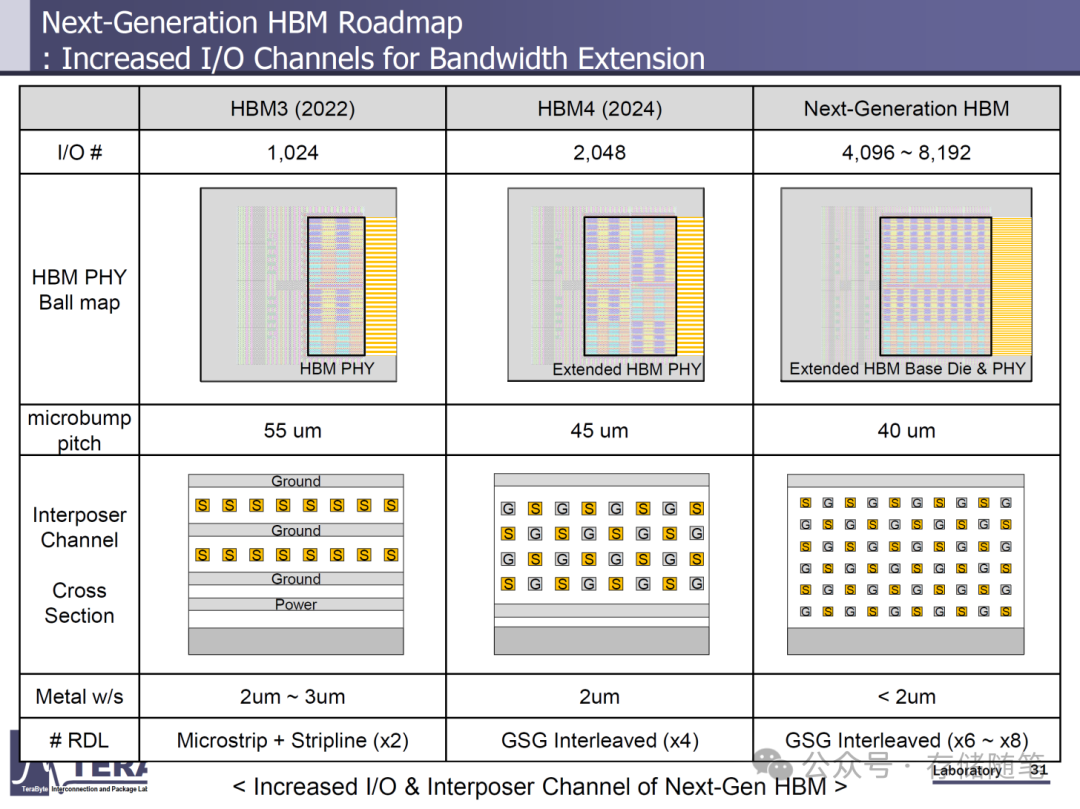

HBM4标准的主要技术指标令人瞩目:数据传输速率约8Gbps,拥有2048个I/O接口(部分配置可达4096个),单堆栈带宽2.0TB/s,支持12层或16层堆栈,每层裸片容量24Gb,使得每个HBM4模块的容量可达36GB(12层堆栈)或48GB(16层堆栈),每个HBM4模块的功耗为75W。在封装方面,采用Microbump(MR - MUF)技术,并配备直接芯片冷却(D2C)液冷系统。同时,HBM4还采用了定制的基础裸片架构,集成了NMC处理器和LPDDR内存。

添加图片注释,不超过 140 字(可选)

AMD的Instinct MI400则更进了一步,计划提供高达432GB的HBM4内存容量,内存带宽可达19.6TB/s。相较于NVIDIA的Rubin,MI400在内存容量和带宽上的提升,显示了AMD在高性能计算领域的强劲竞争力。

HBM4e作为HBM4的增强版本,数据速率提升至10Gbps,单堆栈带宽提高到2.5TB/s,每层裸片容量最大可达32Gb,对应12层或16层堆栈时,内存容量为48GB或64GB,每个HBM4e模块的功耗提升至80W。HBM4e的出现,将为那些对内存性能有极致需求的应用提供更强大的支持。

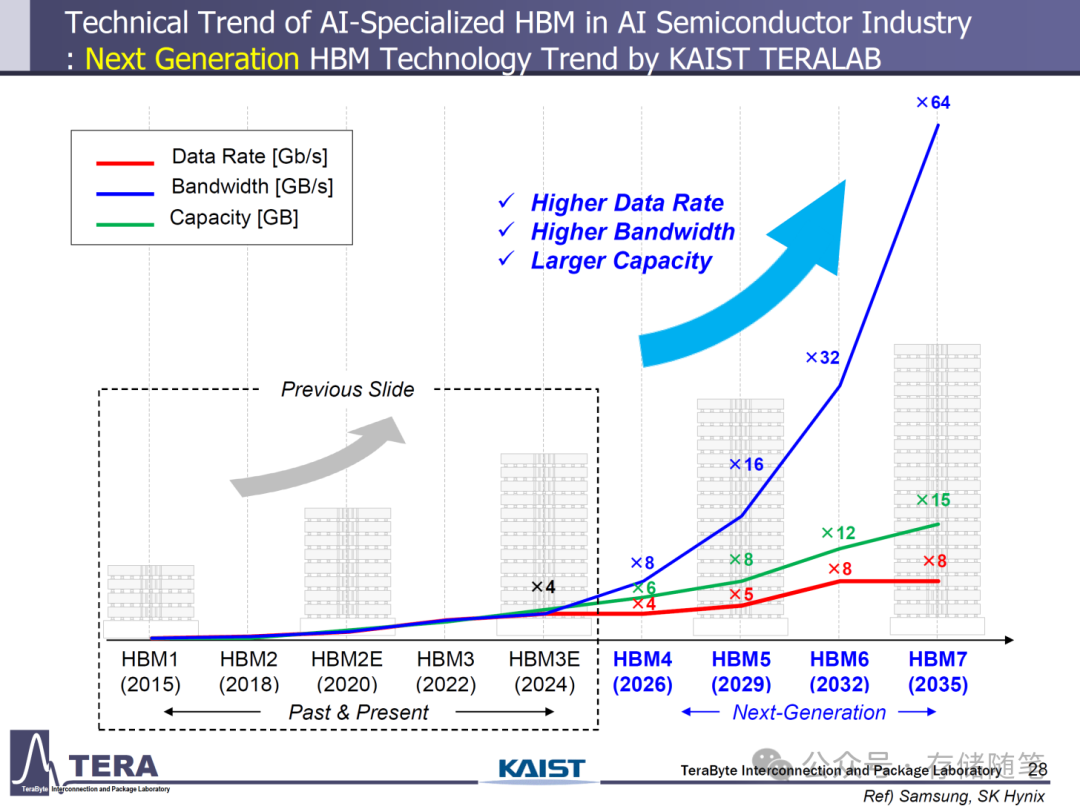

HBM5:2029年NVIDIA Feynman的强大助力

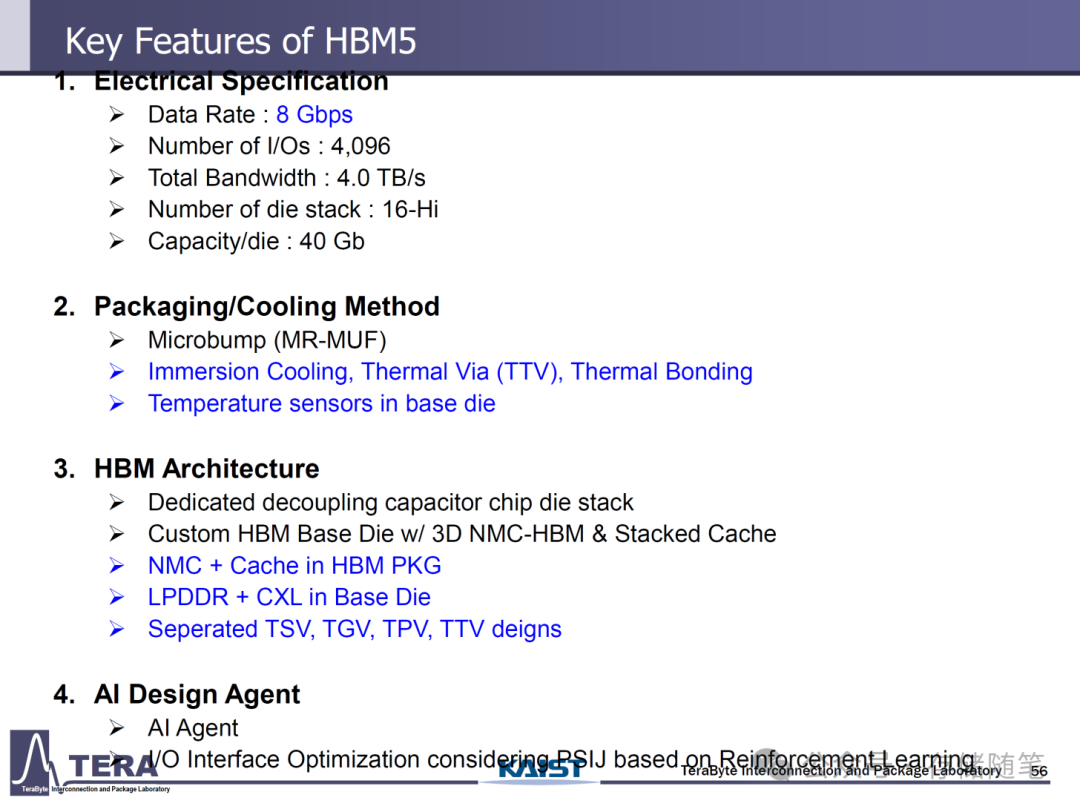

HBM5预计将在2029年成为市场焦点,NVIDIA的Feynman GPU将率先采用这一标准。HBM5在保持8Gbps数据速率(非增强版本)的同时,将I/O通道扩展至4096位,使得单堆栈带宽跃升至4TB/s。它以16层堆栈为基础,搭配40Gb的DRAM裸片,每个堆栈的容量可达80GB,每个堆栈的功耗预计为100W。

添加图片注释,不超过 140 字(可选)

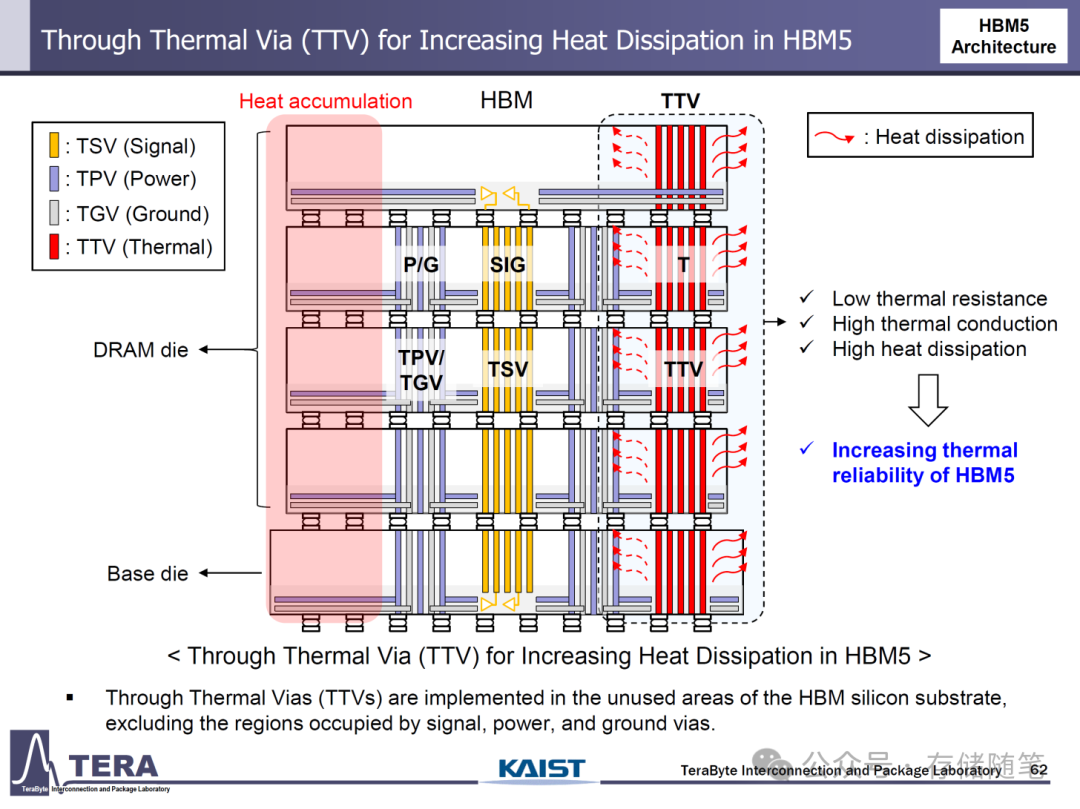

HBM5的封装技术仍采用Microbump(MR - MUF),但在散热方面,将引入沉浸式冷却、热通孔(TTV)和热键合等技术,以应对更高的功耗。

添加图片注释,不超过 140 字(可选)

此外,HBM5还将采用专用的去耦电容芯片裸片堆栈,以及定制的带有3D NMC - HBM和堆叠缓存的基础裸片,并在基础裸片中集成LPDDR和CXL技术。

添加图片注释,不超过 140 字(可选)

据预测,Feynman GPU的裸片面积为750平方毫米,单颗裸片功耗900W,旗舰型号F400将采用四GPU裸片封装,配备8个HBM5存储体,封装面积达4788平方毫米。整个GPU将拥有400 - 500GB的HBM5内存容量,热设计功耗(TDP)为4400W。HBM5的出现,将为2029年的GPU性能带来质的飞跃,满足日益增长的AI和高性能计算需求。

添加图片注释,不超过 140 字(可选)

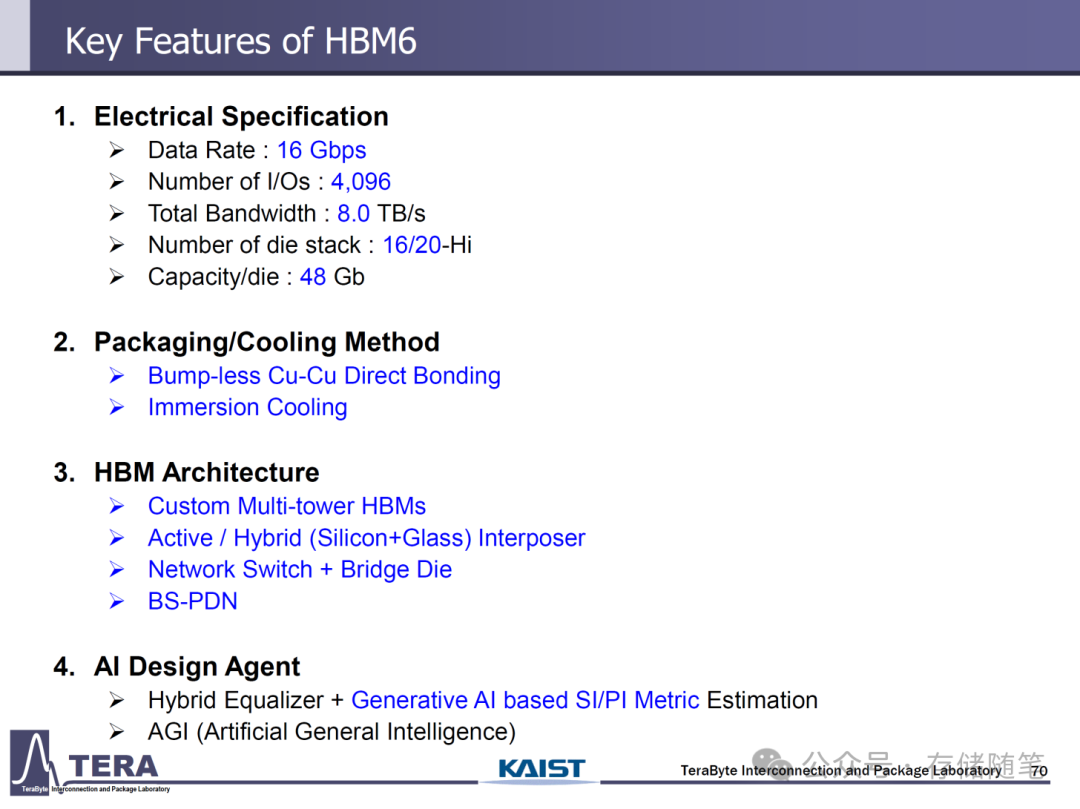

HBM6:后Feynman时代的超高性能之选

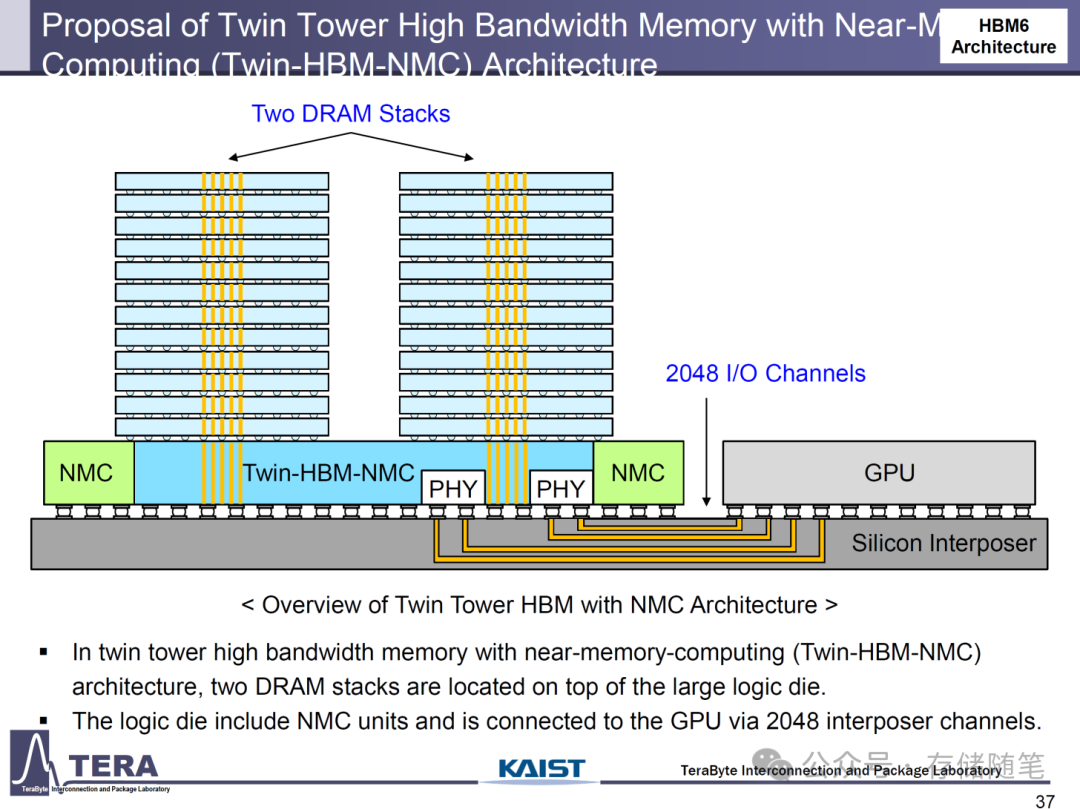

在Feynman之后,NVIDIA可能会推出更强大的产品,而HBM6将为这些后续设计提供支持。HBM6的最大亮点是数据速率提升至16Gbps,采用4096位I/O通道,单堆栈带宽翻倍至8TB/s。它将采用16层或20层堆栈,每层DRAM裸片容量为48Gb,使得每个堆栈的容量达到96GB(16层堆栈)或120GB(20层堆栈),每个堆栈的功耗为120W。

添加图片注释,不超过 140 字(可选)

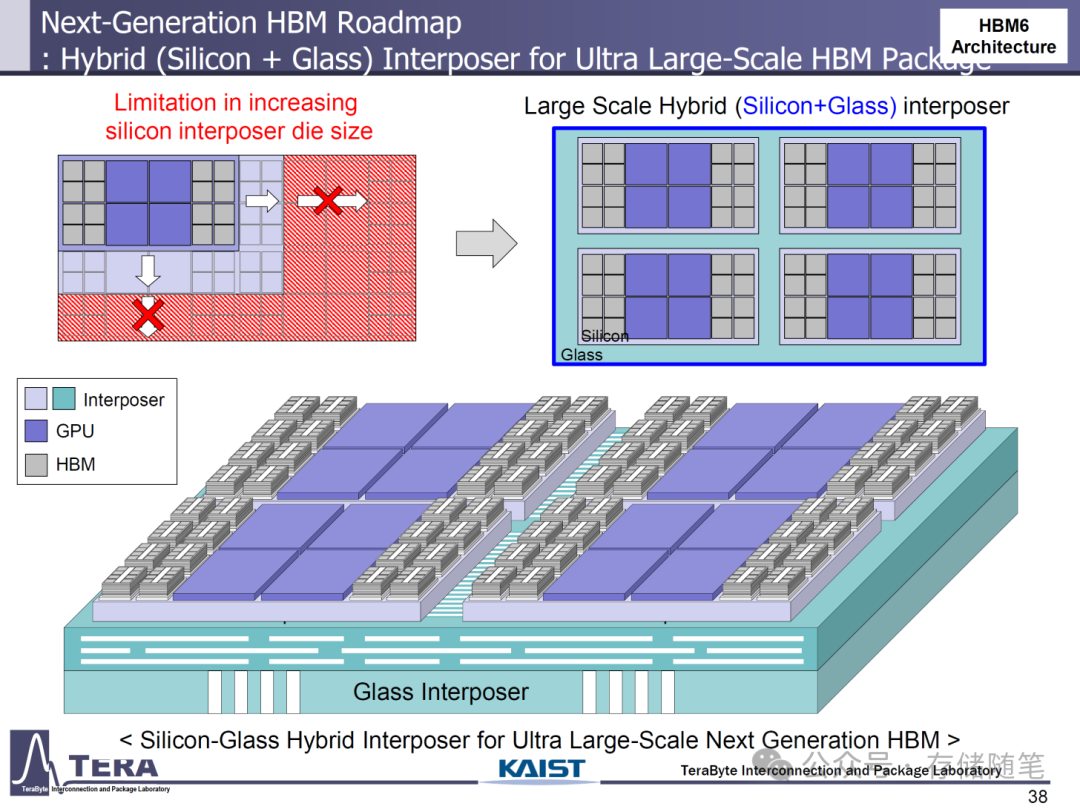

HBM6在封装和散热方面也有重大创新。它将采用无凸点铜 - 铜直接键合技术,以提高封装的可靠性和性能。散热方面,将采用沉浸式冷却方案,并引入定制的多塔式HBM结构和有源/混合(硅 + 玻璃)中介层。此外,HBM6还将集成网络交换机和桥接裸片,进一步提升系统的整体性能。

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

根据研究,下一代GPU采用HBM6时,单颗GPU裸片面积为700平方毫米,功耗1000W。封装将容纳16个HBM6存储体,封装面积6014平方毫米,提供128 - 256TB/s的带宽,内存容量达1536 - 1920GB,总功耗5920W。HBM6的出现,将为未来的超大规模数据中心和最先进的AI应用提供前所未有的内存性能。

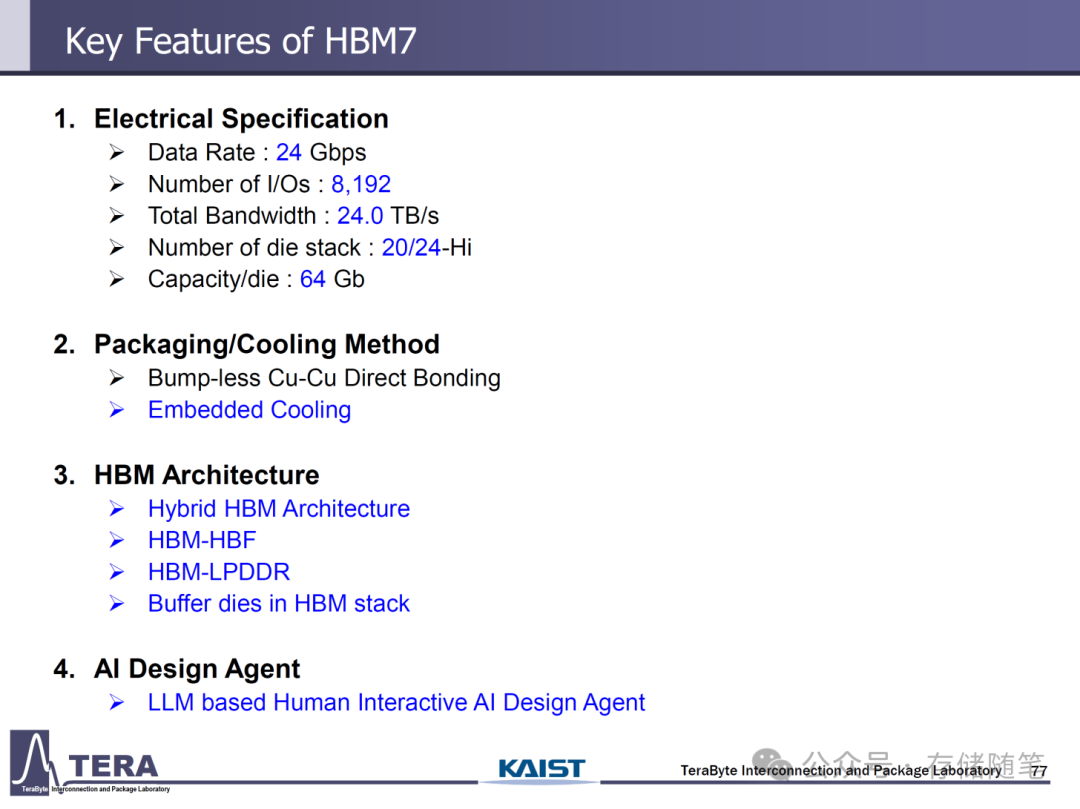

HBM7与HBM8:未来十年的内存巅峰

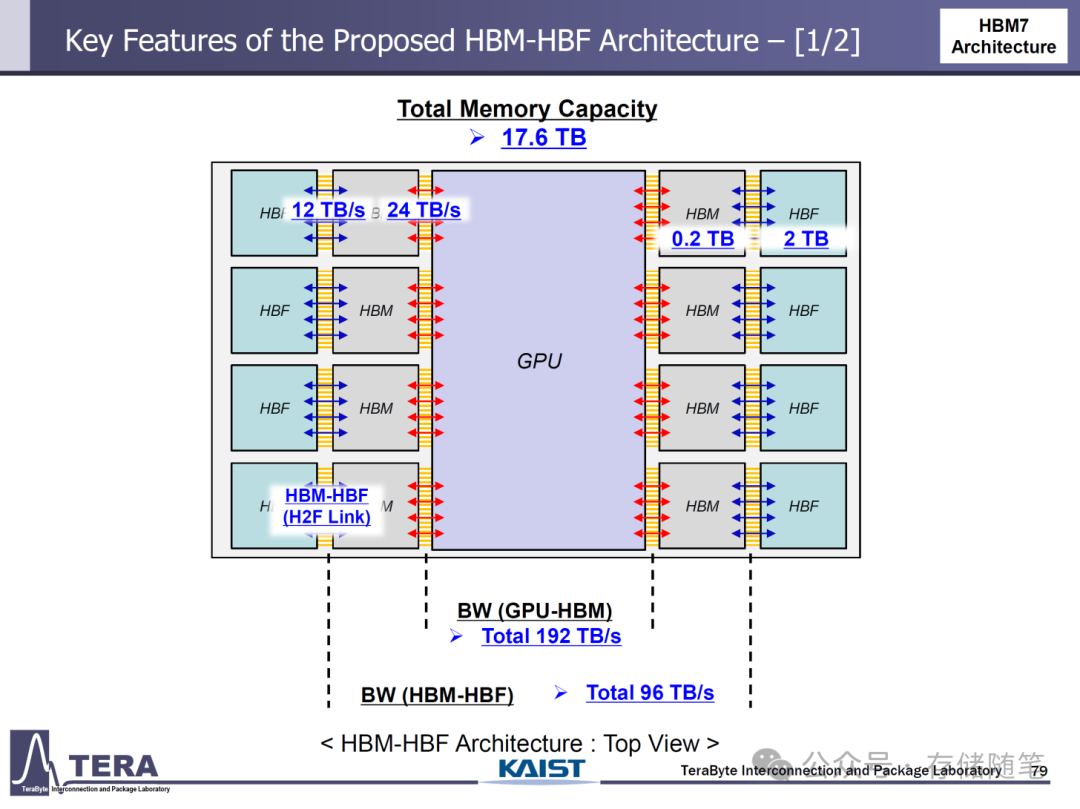

HBM7和HBM8将把HBM技术推向新的高度。HBM7预计将提供24Gbps的引脚速度,拥有8192个I/O通道,单堆栈带宽高达24TB/s,是HBM6的三倍。它将采用20层或24层堆栈,每层DRAM裸片容量为64Gb,每个堆栈的容量可达160GB(20层堆栈)或192GB(24层堆栈),每个堆栈的功耗为160W。

添加图片注释,不超过 140 字(可选)

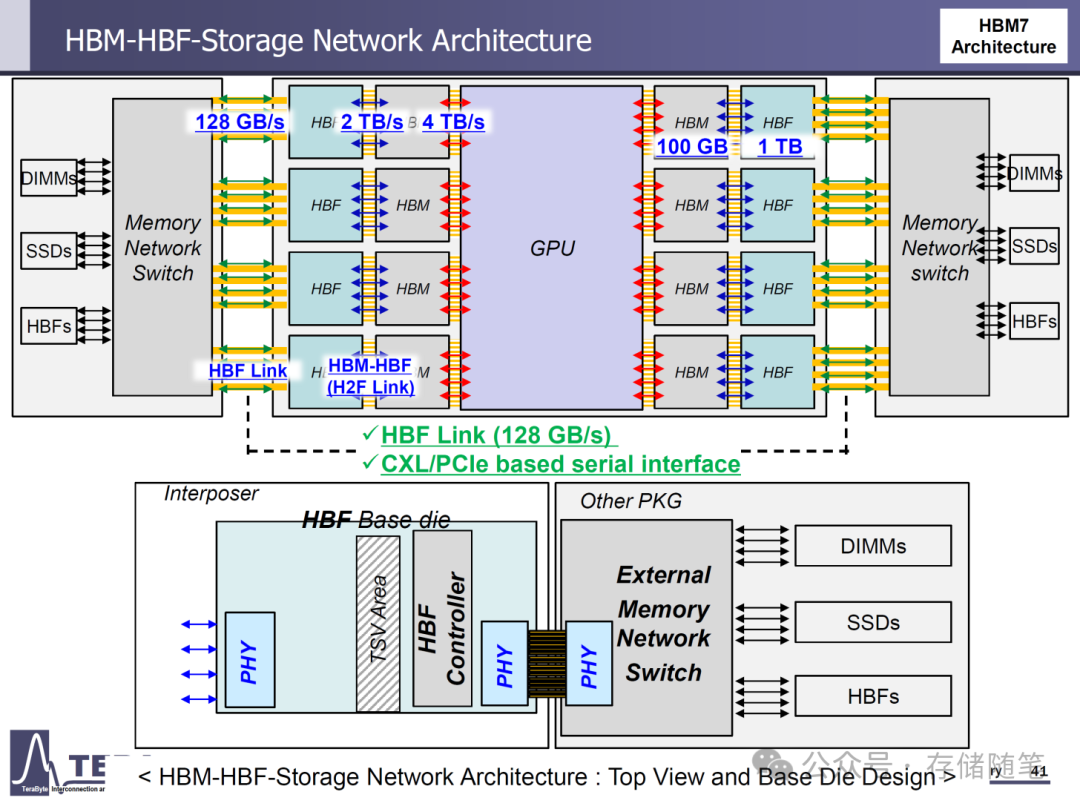

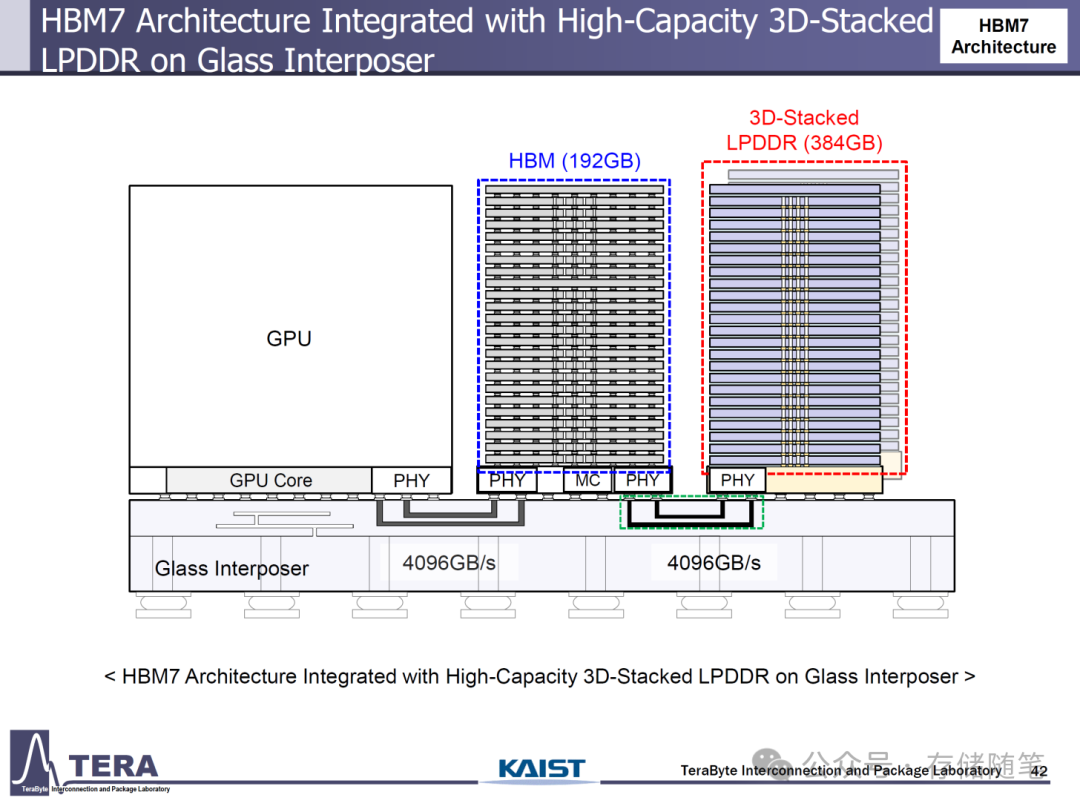

HBM7的封装将采用无凸点铜 - 铜直接键合技术,并引入嵌入式冷却解决方案。此外,HBM7还将推出全新的HBM - HBF(High - Bandwidth Flash)和HBM - 3D LPDDR架构,以进一步提升内存性能。基于HBM7的下一代解决方案将采用超级大尺寸和多芯片设计,单个封装将包含8个GPU位点,每个GPU尺寸为600平方毫米,功耗1200W,32个HBM7存储体将提供1024TB/s的带宽,成为首个达到Exabyte级带宽的解决方案。芯片的内存容量将高达5120 - 6144GB,总功耗15360W。

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

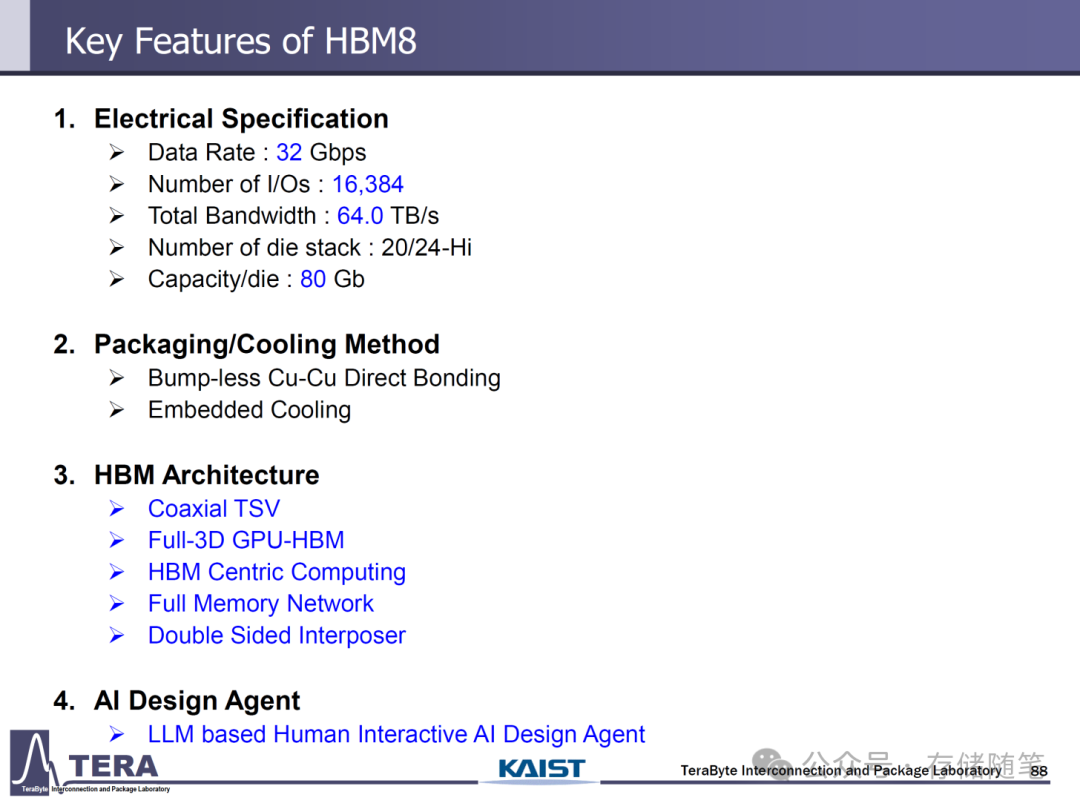

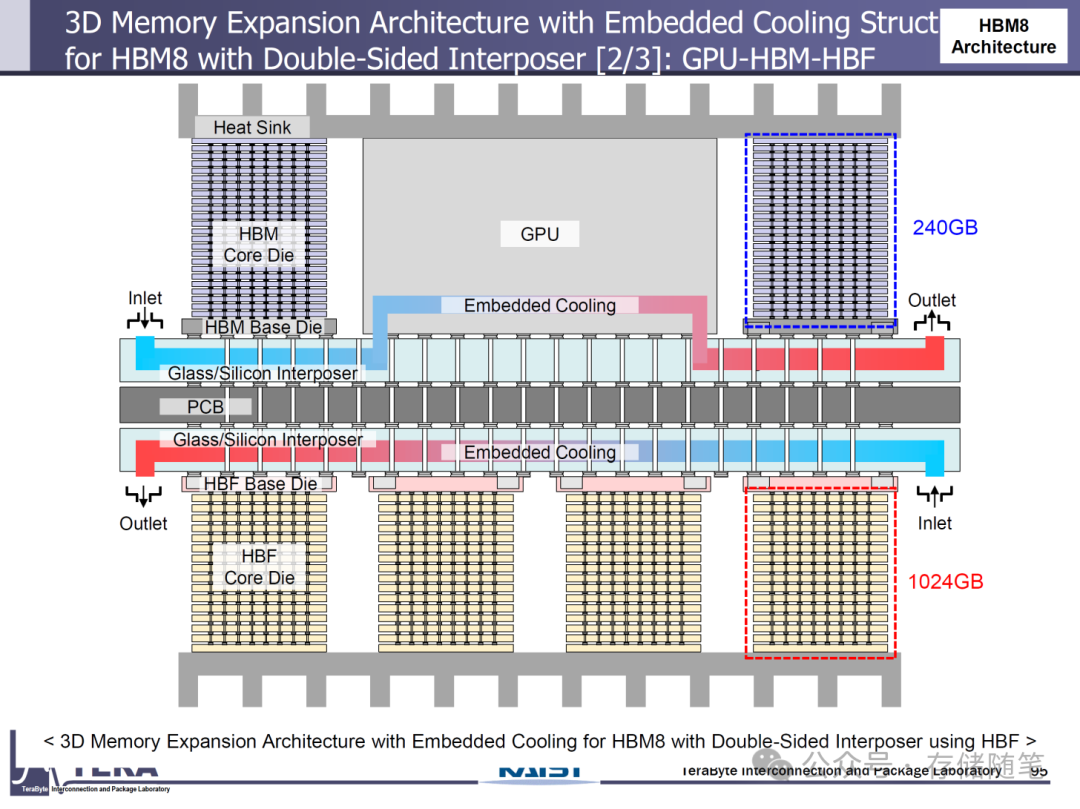

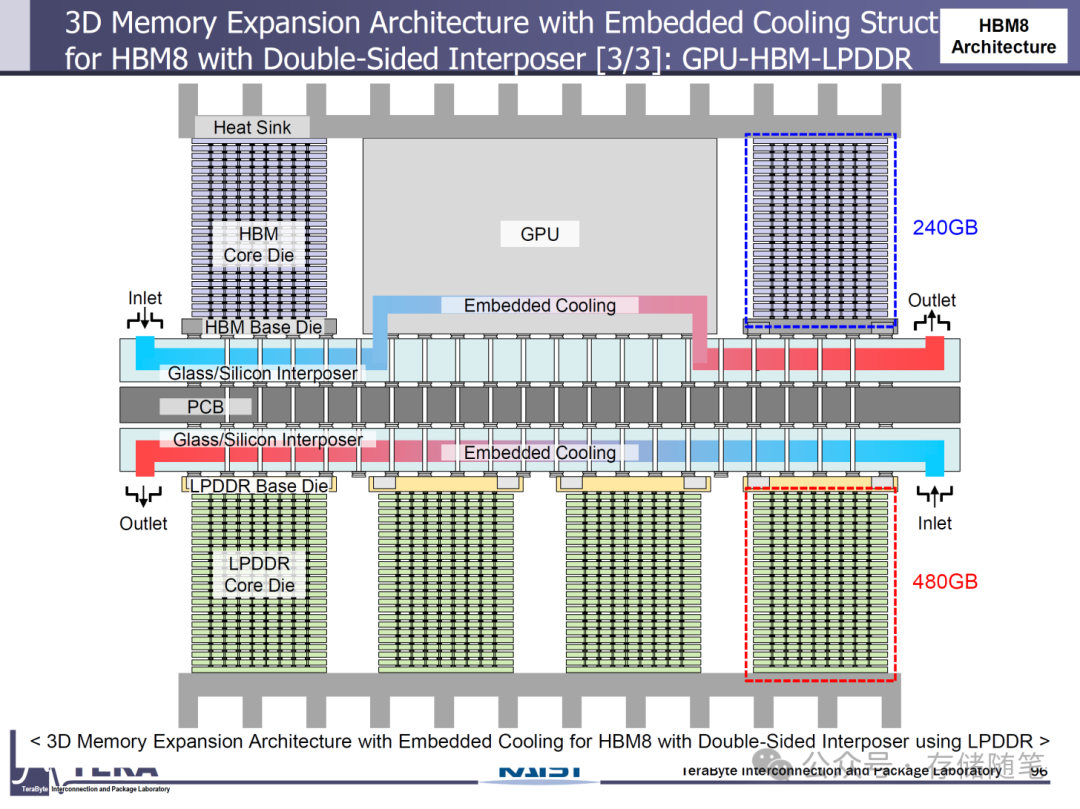

HBM8则要到2038年才会亮相,其数据速率将达到32Gbps,I/O通道数量翻倍至16384个,单堆栈带宽高达64TB/s。采用20层或24层堆栈,每层DRAM裸片容量为80Gb,每个堆栈的容量可达200GB(20层堆栈)或240GB(24层堆栈),每个HBM8存储体的功耗为180W。

添加图片注释,不超过 140 字(可选)

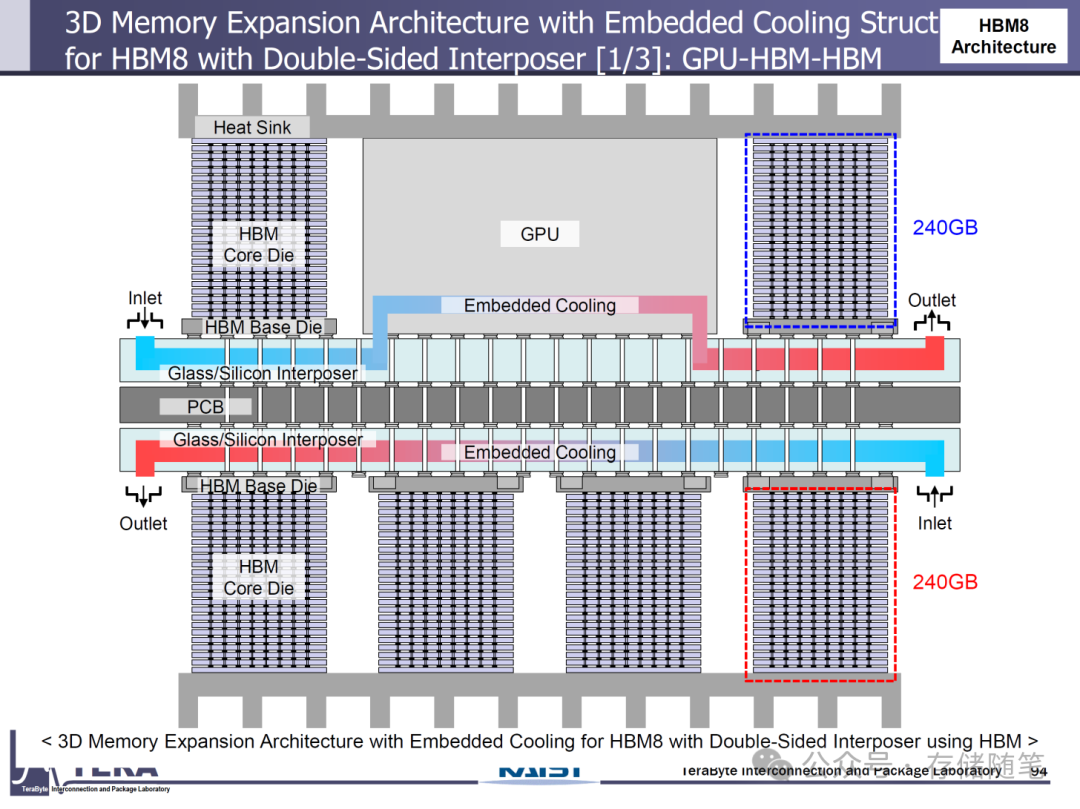

HBM8将采用无凸点铜 - 铜直接键合技术、嵌入式冷却,以及同轴硅通孔(Coaxial TSV)/全3D GPU - HBM架构,实现以内存为中心的计算和全内存网络,并采用双面中介层技术。

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

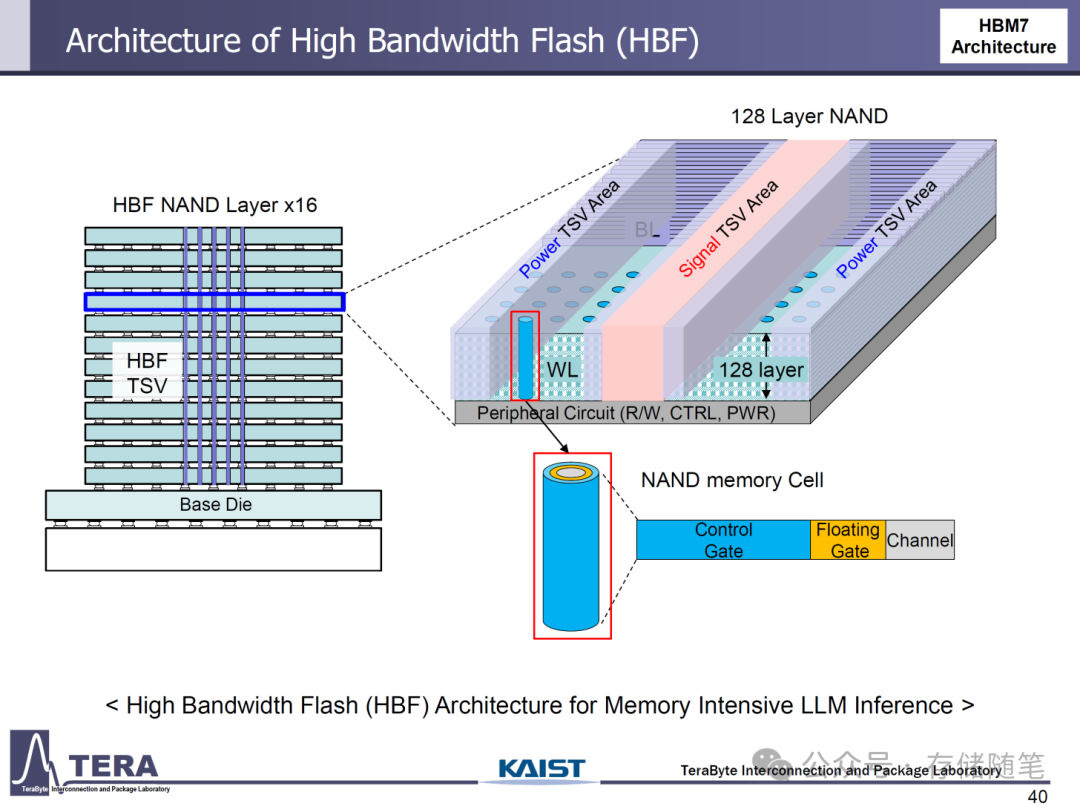

HBF架构与创新冷却方法:应对内存密集型需求

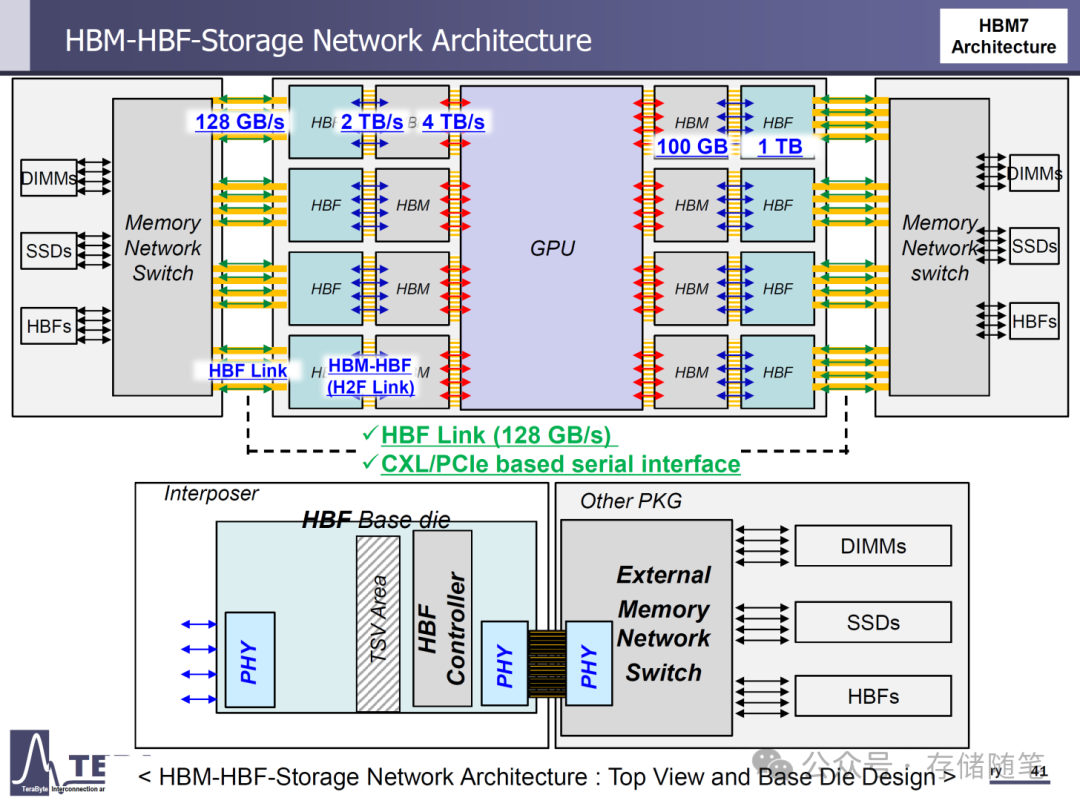

为了满足内存密集型大语言模型(LLM)推理的需求,HBF(High - Bandwidth Flash)架构应运而生。HBF架构使用多达128层的NAND闪存,通过HBF TSV解决方案实现16层堆栈的高容量存储。每个HBF堆栈与HBM堆栈并行连接,可额外提供高达1TB的容量,并通过2TB/s的高速HBM - HBF互连与主板上的其他组件通信,该互连通过128GB/s的双向互连和内存网络交换机实现。

添加图片注释,不超过 140 字(可选)

随着HBM7的发展,基于NAND的HBF堆栈将进一步升级,通过4096GB/s的传输速度连接到玻璃中介层。同时,高达384GB容量的LPDDR解决方案将与192GB容量的HBM堆栈协同工作。HBM7和HBM8还将采用24层堆栈设计,形成双塔高带宽封装。

添加图片注释,不超过 140 字(可选)

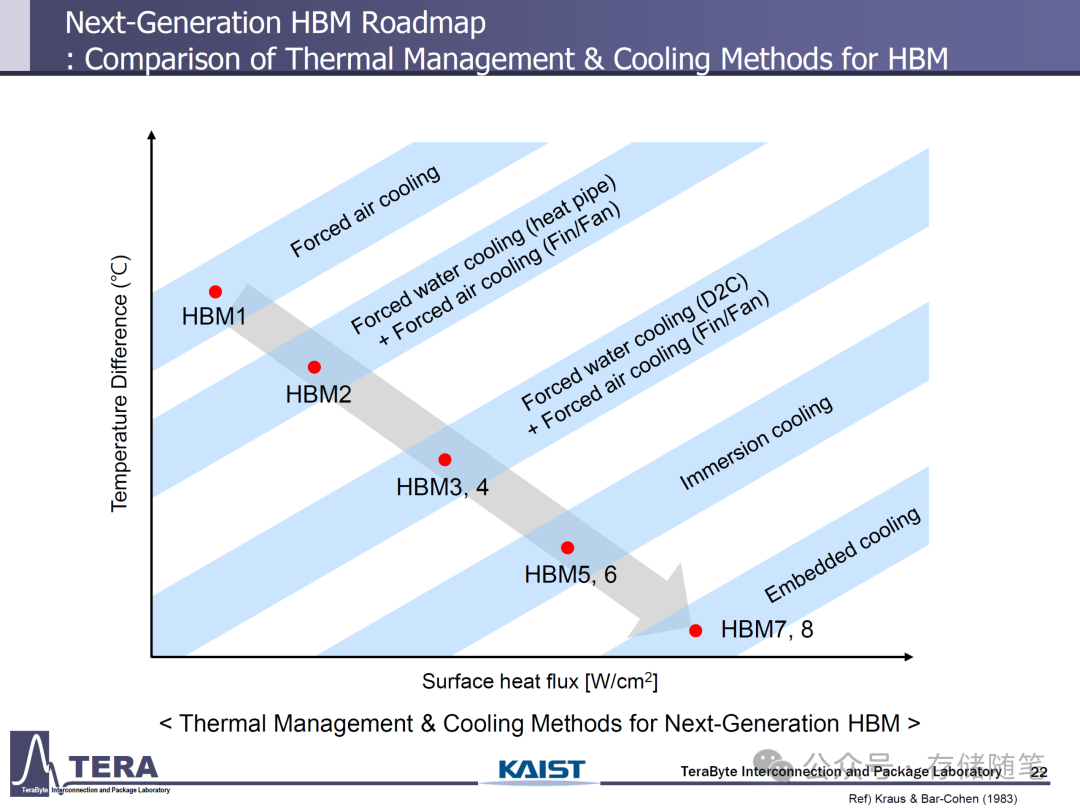

在冷却技术方面,随着玻璃基硅中介层的应用,嵌入式冷却将成为标准方法。这种冷却方式将通过中介层,为HBM、HBF和GPU IP提供直接冷却,有效解决高功耗带来的散热问题。

添加图片注释,不超过 140 字(可选)

下一代HBM标准(HBM4到HBM8)的发展将为未来的数据中心和AI应用带来巨大的性能提升。从不断提高的带宽和容量,到创新的封装和冷却技术,再到全新的内存架构,HBM技术的每一次演进都将为AI和高性能计算领域注入新的活力,推动这些领域迈向更高的台阶。随着这些技术的逐步落地,我们有理由期待未来的计算性能将实现质的飞跃。

参考文献链接

人工智能芯片与自动驾驶

浙公网安备 33010602011771号

浙公网安备 33010602011771号