视频kMaX:一种简单的在线和近在线统一方法

视频kMaX:一种简单的在线和近在线统一方法

Video-kMaX: A Simple Unified Approach for Online and Near-Online Video Panoptic Segmentation

摘要

视频全景分割(VPS)旨在通过分割视频中的所有像素并关联对象来实现全面的像素级场景理解。目前的解决方案可分为在线和近在线两种方法。随着时间的推移,每个类别都有自己的专业设计,这使得在不同类别之间调整模型变得非常重要。为了缓解这种差异,在这项工作中,我们提出了一种统一的在线和近在线VPS方法。所提出的视频kMaX的元架构由两个组件组成:片段内分割器(用于片段级分割)和跨片段关联器(用于超出片段的关联)。我们提出了clip-kMaX(clip-k-means mask transformer)和LA-MB(location-aware memory buffer)来分别实例化分割器和关联器。

我们的一般公式将在线场景作为特例,采用1的剪辑长度。在没有铃声和口哨声的情况下,Video kMaX在KITTI-STEP和VIPSeg上为视频全景分割设置了一个新的最先进的代码和模型可在此链接上获得。

1.简介

视频全景分割(VPS)旨在通过统一两个关键且具有挑战性的任务来实现对场景的整体视频理解:语义分割图像和关联视频中所有帧的分割区域。它可以造福于各种现实世界的应用,如自动驾驶、机器人视觉控制和视频编辑。

随着人们对VPS兴趣的迅速增长,已经有几种方法被提出。它们可以分为在线和近在线方法,逐帧或逐片段处理视频(一个片段只包含几个连续的视频帧)。

在线方法,如VPSNet和Video KNet,通过现代图像级分割器顺序分割每一帧,并建立一个额外的关联分支,该分支经过训练,可以在帧之间执行一致的预测。另一方面,近在线方法,如ViP DeepLab和TubeFormer,通过设计额外的模块(例如,下一帧实例分割或潜在存储器),扩展了现代图像级分割器来处理剪辑。然后对剪辑级别的预测进行拼接以形成最终视频分割结果。为在线或近在线方法设计的模块不仅随着时间的推移而发展,而且对于每种场景也变得非常独特。

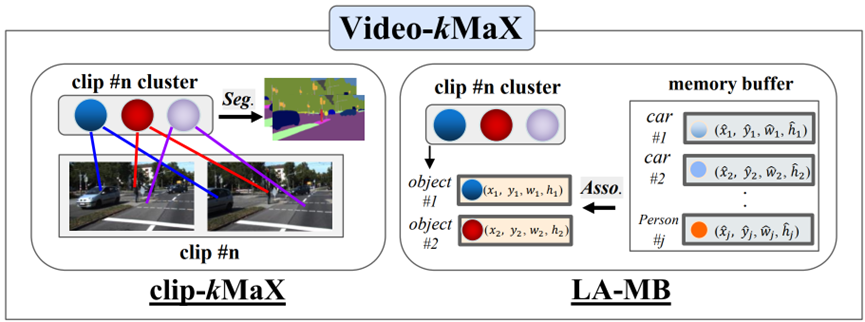

图1. 视频kMaX的元架构由用于剪辑级分割的剪辑kMaX和用于对象关联的LA-MB组成。前者将片段内同一对象的像素分组,后者利用外观和位置特征(由框坐标编码)在片段之间进行长期关联。

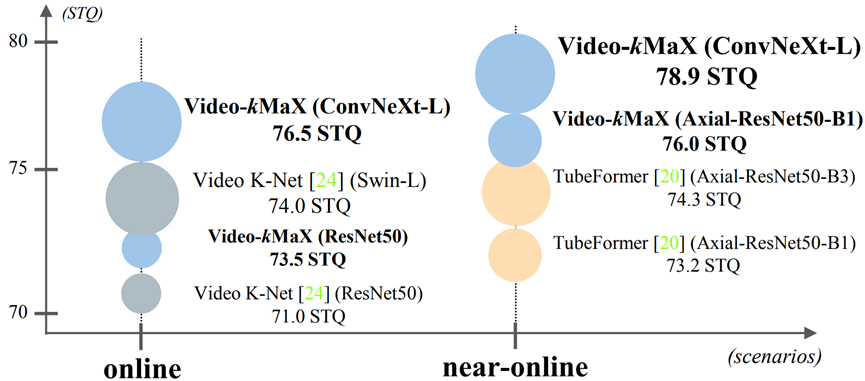

图2:视频kMaX是一种用于在线和近在线视频全景分割的统一方法,在这两种场景中都显示出最先进的性能(在KITTI-STEP值集上)。圆的大小反映了模型参数。

因此,将在线模型轻松地调整为接近在线是不可行的(反之亦然)。特别地,当前的在线方法缺乏适当的剪辑级分割器,而现代的近在线方法由于缺乏重叠帧而无法以在线方式关联对象。对这种场景特定设计的需求导致了效率低下,因为它需要为每个设置使用不同的框架。因此,一个自然的问题出现了:在没有任何特定场景设计的情况下,是否有可能为在线和近在线VPS开发一个统一的框架?

为了回答这个问题,我们精心设计了VideokMaX,这是一种简单而有效的在线和近在线VPS方法。如图6所示,1,视频kMaX的元架构包含两个组件:片段内分割器和跨片段关联器,其中前一个组件执行片段级分割,后一个组件跨片段关联检测到的对象。

所提出的VideokMaX是通过采用clipkMaX(clipK-means mask transformer)作为片段内分割器和LA-MB(Location Aware Memory Buffer,位置感知存储器缓冲器)作为交叉片段关联器的流水线的实例化。

所提出的剪辑kMaX将图像级别的kmeans掩码变换器扩展到剪辑级别,而不添加任何额外的模块或损失函数。受k-means聚类观点的启发,我们将对象查询视为聚类中心,其中每个查询负责将剪辑内同一对象的像素分组在一起。

具体而言,当每个对象查询与片段特征相乘时,都会被学习以产生管状预测(即片段中相同对象的遮罩)。这种学习可以通过在k均值交叉注意力模块中进行令人惊讶的简单修改来实现,该修改通过沿着空间维度连接剪辑级像素特征来实现。

因此,剪辑kMaX可以应用于近在线和在线设置,而不需要额外的复杂性。我们还实证地表明,k-means交叉注意力是处理空间和时间上增肥的片段特征的超长序列的有效机制。

通过仔细的系统研究,提出的LA-MB是基于现有方法的缺点。我们观察到,现代VPS方法无法处理更具挑战性的长期对象跟踪设置,因为它们要么将相邻帧中的对象关联起来,要么缝合重叠帧预测,从而很难跟踪短片段长度之外的对象。一个有前途的解决方案是利用内存缓冲区在所有视频片段中传播跟踪信息,这在最近的工作中已经被证明是成功的。然而,令人惊讶的是,我们观察到,在VPS中简单地采用内存缓冲区会导致较小的改进,甚至更差的性能。

这一挫折迫使我们进一步调查其根源。我们发现,当目标物体被长时间遮挡时,单独的外观特征不足以实现VPS中的长期关联;此外,内存缓冲方法积累了许多检测到的对象,导致了巨大的匹配空间(存储的对象和新检测的对象之间),并阻碍了匹配的准确性。为了解决这些问题,我们开发了LA-MB(位置感知内存缓冲区),它通过两种方式有效地将位置信息合并到内存模块中。首先,当比较存储器中存储的对象和当前帧中检测到的对象之间的相似性时,我们不仅考虑它们的外观特征(由对象查询编码),还考虑它们的位置特征(由归一化边界框坐标编码)。

具体来说,如果感兴趣的对象在当前帧中没有被检测到,但它被存储在存储器中(例如,由于遮挡),我们将通过假设对象以恒定速度移动来“预测”其当前位置。其次,我们提出了一种分层匹配方案,以有效地减少匹配空间。

我们最初利用视频缝合策略的匹配结果,该策略基于剪辑之间重叠帧中的对象掩码IoU来关联对象,对短期关联有效。然后,我们将存储在内存中的对象与当前检测到但不匹配的对象相关联,以实现长期关联。由于我们的精心设计,LA-MB在近在线和在线场景中都提高了长期关联质量,对超参数值的敏感性较低。

总之,我们介绍了Video kMaX,这是一种简单而统一的在线和近在线VPS方法。我们的方法由两个无缝模块组成:clip-kMaX和LA-MB,在两个长序列VPS数据集KITTISTEP和VIPSeg上实现了显著的性能改进。特别是,如图6所示,2,在KITTI-STEP值集上,我们最好的视频kMaX分别比以前最先进的在线模型(视频K-Net)和近在线模型(TubeFormer)高出+2.5%STQ和+4.6%STQ。

2.相关工作

视频全景分割(VPS)视频全景分割旨在统一视频语义和视频实例分割。许多努力都是将图像全景分割模型转换到视频域。

其中,在线方法VPSNet采用了来自实例分割、语义分割和跟踪的任务特定预测头,并对其进行联合训练,以获得全景视频结果。类似地,近在线方法ViP DeepLab在PanopticDeepLab之上添加了下一帧实例分割头,该头通过双ASPP语义分割模块和基于双解码器的实例分割提供通用图像全景分割。最近的工作确定了以前方法的局限性,这些方法需要多个独立的网络和复杂的后处理(例如,NMS、用于跟踪的融合)。

为了解决这些问题,他们设计了一种用于端到端视频全景分割的转换器架构。

然而,所有这些方法都有两个根本问题。首先,它们需要针对在线或近在线场景的特定设计,例如,另一个关联模块、时间一致性损失或剪辑分割模块。其次,模型只能处理短期关联(即,相邻帧或剪辑)。

在这方面,我们提出了一个简单的统一在线和近在线视频全景分割模型,用于长期关联,而不添加额外的场景特定设计。

来自Transformer解码器的长期跟踪对象查询存储模块已用于跟踪多对象跟踪、视频实例分割和视频全景分割中的对象。其中一些利用查询进行短期关联,而另一些则通过额外利用内存缓冲区进行长期关联。

特别地,MOTR提出了一组跟踪查询来对整个视频中的被跟踪对象进行建模。MeMOT开发了一种时空存储器,用于存储所有被跟踪对象的长距离状态。MaskTrack R-CNN采用内存模块来跟踪检测到的对象。为了使关联对具有挑战性的场景(如重度遮挡)具有鲁棒性,IDOL提出了一种用于对象匹配的时间加权softmax分数。沿着同一方向,我们专门针对在线和近在线视频全景分割模型使用内存缓冲方法,并进一步开发了一种有效的分层匹配方案。

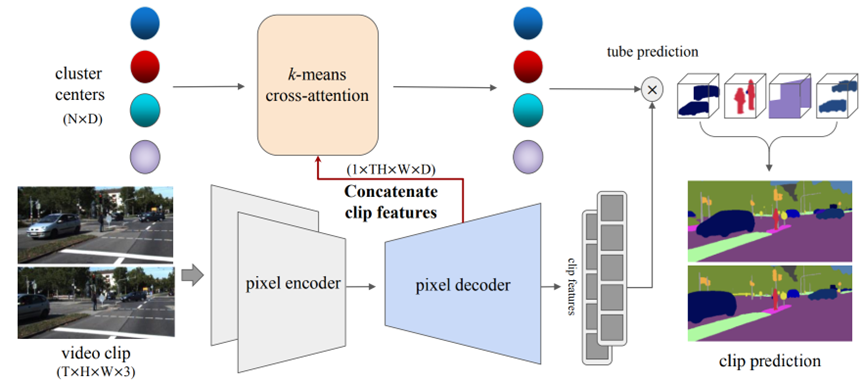

图3. 夹子kMaX的图示。所提出的剪辑kMaX在不添加额外模块的情况下将图像级分割模型kMaX-DeepLab无缝转换为剪辑级。受k-means视角的启发,clip-kMaX将一个对象查询视为一个聚类中心,该聚类中心学习将剪辑内同一对象的像素分组在一起。具体而言,当每个对象查询与片段特征相乘时,都会学习生成管状预测(即片段中相同对象的遮罩)。这种学习可以通过在k均值交叉注意力模块中惊人地简单的改变来实现,方法是沿着空间维度连接剪辑级像素特征(即,将形状为T×H×W×D的剪辑级像素特性视为形状为1×T H×W x D的大图像级像素特征),其中输入视频剪辑包含高度为H和宽度为W的T帧。D是像素特征的通道维度,N是聚类中心的数量。

3.方法

视频kMaX的元架构包含两个组件:用于片段内分割的片段kMaX(片段k均值掩码转换器)和用于跨片段关联的LA-MB(位置感知存储器缓冲器)。我们在下面从近在线框架开始详细介绍它们。我们的一般公式包括使用剪辑长度一的在线场景。

3.1.在片段内:片段kMaX

在介绍我们的片段内分割器clip-kMaX之前,我们首先介绍了图像和视频全景分割的一般公式,它执行具有短长度T(例如,T=2)的片段级分割。

图像和视频的一般公式最近,图像全景分割被重新公式化为一种由Transformer提供支持的简单集合预测。

从开创性的工作(例如,DETR和MaXDeepLab)到最近最先进的方法(例如,kMaX DeepLab),全景预测被设计为通过将图像

分割成N类标记掩码的fxed大小集来匹配地面实况掩码:

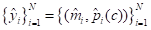

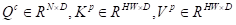

其中,

与

分别表示对应掩码的预测掩码和语义类概率。受此启发,TubeFormer将此公式扩展到类别标记管的集合预测中:

其中

。在此设置中,N个对象查询关注T×H×W片段特征,并预测N个管。对于T的不同值,该预测很好地概括,因为位置嵌入仅在帧级别执行,提供了一个有用的结构先验,即相邻帧中的相同对象(假设慢动作)仍将由相同的对象查询分配。给定可推广性,我们能够在将剪辑特征提供给变换器解码器之前将T轴吸收到H轴中。具体而言,我们建议将等式(1)放宽为更一般的形式:

其中

(即S可以根据帧T的不同数量而改变)。通过这样做,我们可以轻松地将图像全景分割模型扩展到视频域(剪辑级别),如下所述。

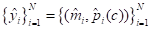

clip kMax最先进的图像分割模型kMax DeepLab通过采用如下聚类方式的argmax,将典型变换器解码器中的交叉注意力替换为k均值交叉注意力:

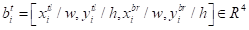

其中

是指具有D个通道的N个对象查询。我们使用上标p和c来分别指示从像素特征和对象查询投影的特征。

分别代表查询、键和值的线性投影特征。在这种k-means视角下,一个对象查询被视为聚类中心,它学习将同一对象的像素分组在一起。根据我们之前的通用公式,我们可以将kMaX DeepLab无缝扩展到视频剪辑,只需将密钥和值重塑为

。

重塑将T形框架特征合并为具有较大高度的单个框架特征T H(即,将T×H×W重塑为1×T H×W),然后与图像模型kMaX DeepLab兼容。

这相当于对长度为T的视频剪辑执行k均值聚类,其中一个查询现在正在学习将剪辑中相同对象的像素分组在一起。我们在图3中展示了剪辑kMaX。请注意,kMaX DeepLab然后成为T=1的剪辑kMaX的特例。

讨论剪辑kMaX的设计表面上看起来可能很简单。然而,在开发过程中,我们在增强用于剪辑级掩模预测的传统交叉注意力模块方面付出了巨大努力。当处理视频片段中空间和时间上增肥的片段特征的超大序列长度时,标准的交叉注意力模块易于学习。

这种现象在最初的交叉注意力的糟糕表现中表现得很明显,这促使现有技术的TubeFormer进一步使用了一个额外的潜在记忆模块。为了应对这一挑战,我们建议使用k-means交叉注意力方法,该方法能够通过对N个聚类中心执行逐聚类argmax来处理任何大小的增肥片段特征。

视频拼接(VS)在实践中,在内存有限的情况下,我们只能执行剪辑级推理(即,分割长度为T的短片)。为了获得视频级分割,需要一些启发式设计。一种流行的方法是视频拼接(VS),它通过匹配重叠帧中的掩码IoU分数来在片段之间传播对象身份。在我们的框架中,我们对近在线视频kMaX采用了相同的视频拼接策略,但还探索了用于长期关联的内存缓冲区。

3.2.交叉夹助理:LA-MB

我们的LA-MB基本上由两个阶段组成:编码阶段用于存储以前的对象特征,解码阶段用于将当前对象与存储在内存缓冲区中的对象相关联。我们在下面详细介绍过程。

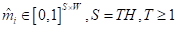

编码阶段当新的测试视频到来时,内存缓冲区最初是空的。它对所有检测到的对象的特征进行编码,同时按顺序处理帧。关于要存储的对象特征,我们利用每个对象的外观和位置属性。

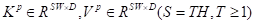

对于在帧t处观察到的对象i的外观特征,我们利用查询嵌入

(即来自掩码变换器解码器的对象查询)。内存缓冲区对外观特征

进行编码如下所示:

其中λ是存储器中存储的外观特征之间的移动平均权重

和当前外观特征

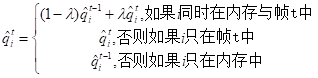

。我们将λ设置为0.8作为默认值。与其他工作不同,我们还利用了在第t帧观察到的对象i的位置特征,使用其归一化边界框(从预测的掩码推断)

:。其中

与

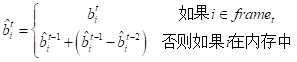

是左上角和右下角的x-y坐标,w和h分别表示边界框的宽度和高度。然后,存储器缓冲器对位置特征进行如下编码:

如等式所示,如果检测到对象,则内存缓冲区将使用其最新的归一化边界框信息。如果对象i没有被检测到,但它被存储在存储器中(例如,由于遮挡),我们将通过假设对象的移动速度是恒定的来“预测”其当前位置,即其位置偏移(

)从其先前存储的位置

。

最后,存储器缓冲器存储直到当前帧为止检测到的所有M个对象的外观和位置特征(

)。在实践中,我们采用了记忆刷新策略,其中旧对象,其最后一个出现的帧是当前帧后面的τ帧,从内存缓冲区中删除。我们在实验中根据经验选择τ的最优值。

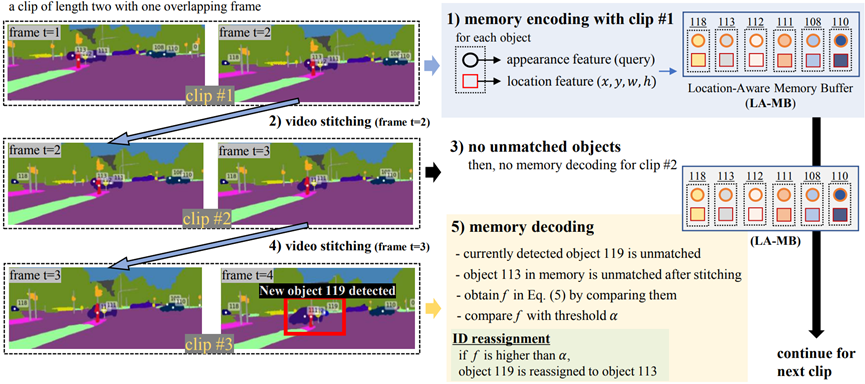

图4. 位置感知内存缓冲区(LA-MB)的逐步概述。LA-MB方法由两个阶段组成:编码和解码。在编码阶段,检测到的对象的外观和位置特征存储在内存缓冲区中。在解码阶段,LA-MB执行分层匹配,从视频拼接开始,用于片段之间的重叠帧中的短期关联,然后是当前片段中的不匹配对象(即,fgure中的对象119)和存储在存储器中的对象(即:fgure中对象113)之间的长期关联。

解码阶段

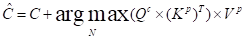

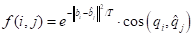

为了在我们的框架中专门化内存缓冲方法,我们最初对剪辑之间的短期关联进行视频拼接(VS)。然后,我们将存储在内存中的对象与当前检测到但不匹配的对象相关联,以实现长期关联。这种分层匹配机制形成了我们提出的位置感知内存缓冲区(LA-MB)。具体地,我们如下计算当前不匹配的对象i(在VS之后)和存储器中的编码对象j之间的相似性函数f(i,j):

计算两个归一化边界框之间的负L2距离,通过温度T进行加权,以缩放位置和外观相似性之间的值。

外观相似性是通过余弦距离来衡量的。然后,我们得到了内存中的M个对象与当前帧中的N个检测对象之间的相似矩阵S∈RM×N。为了找出关联,我们对S执行匈牙利匹配[23]。此外,为了找出错误的关联,我们只考虑相似度值大于置信阈值α的匹配。当前帧中不匹配的对象被视为新对象。建议的LA-MB如图4所示。

讨论我们提出的LA-MB在一定程度上受到了IDOL在视频实例分割中的成功启发,并且在最近的几项工作中已经证明了内存缓冲的有效性。然而,有两个关键问题,如果一个简单地将他们的内存缓冲方法应用到我们的框架中(我们将这种方法命名为我们的基线的内存缓冲(naıve MB))。首先,没有利用位置特征,只利用外观特征。在动态场景中,对象定位起着重要作用。如果目标对象已被遮挡很长时间,则外观特征变得不那么可靠。第二,随着时间的推移,内存大小M不断增加。即使通过内存刷新策略略微缓解了这一问题,但它仍然导致内存中存储的M个对象与当前检测到的N个对象之间存在较大的匹配空间,从而使一对一匹配变得更加困难。

为了克服这些问题,我们的LA-MB提出了一种新的公式来结合位置特征(Eq.(4)和Eq.(5)),并通过在解码阶段开始时执行视频拼接(VS)来增加匹配精度,这有效地进一步减少了匹配空间,提高了匹配精度。

3.3在线视频全景分割

Video kMaX的元架构为在线和近在线VPS提供了通用框架。当处理长度为1的剪辑时,我们的模型会执行在线VPS。具体来说,模型是逐帧训练的,并在clip-kMaX的通用公式的帮助下依次进行评估。与接近在线的设置不同,我们跳过了视频缝合,这在在线框架中变得不可行。之后,我们应用我们的LA-MB,无需任何进一步修改。

表1. [VPS]KITTI-STEP值和测试集结果。

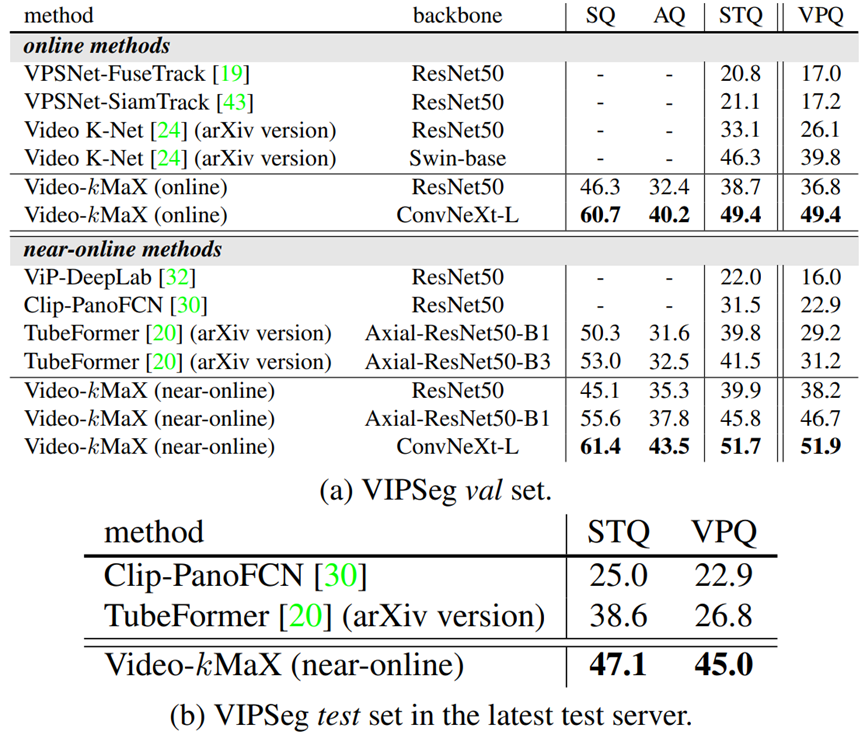

表2. [VPS]VIPSeg val和测试集结果。

4.实验结果

我们在两个长序列视频全景分割数据集上进行了实验:KITTI-STEP和VIPSeg。

4.1.数据集

KITTI-STEP是一个视频全景分割(VPS)数据集,包含平均轨道长度为51帧、最大643帧的长视频序列,为长期关联提供了一个具有挑战性的场景。

它包含19个语义类,类似于Cityscapes,而只有两个类(“pedstrians”和“car”)带有跟踪ID。我们采用分割和跟踪质量(STQ)作为评估指标。

VIPSeg是一个新的大规模视频全景分割(VPS)基准,提供了232个场景和124个类的野生现实世界场景,其中58个类带有跟踪ID。平均序列长度为每个视频24帧。我们采用STQ和VPQ度量进行评估。

4.2.实施细节

所提出的视频kMaX是用于在线和近在线VPS的统一方法。对于接近在线的设置,我们使用两个剪辑长度,剪辑之间有一个重叠帧。对于在线设置,我们将剪辑长度设置为1,并删除管道中的视频拼接策略。

我们为在线和近在线设置使用了两个常见的主干:ResNet50[14]和ConvNeXt-L。

我们还用Axial-ResNet50-B1主干进行了实验,以与TubeFormer进行比较。我们的VideokMaX是用官方代码库构建的。与之前的工作密切相关,近在线和在线模型都采用了KITTI-STEP和VIPSeg的特定预训练协议。它们通常都需要ImageNet预训练的检查点。VIPSeg进一步要求在COCO上对模型进行预训练。对于KITTI-STEP,Cityscapes[10]被额外用作预训练数据集,因为它们共享相似的驾驶场景和类别。

4.3.主要结果

KITTI-STEP

表1总结了我们在KITTI-STEP val和测试集上的性能。在验证集(表1(a))上,我们比较了两类方法:在线方法和近在线方法。在在线设置中,当使用标准ResNet50时,我们的VideokMaX(在线)比Video K-Net高出+2.5%STQ。为了进一步突破极限,我们的型号配备了现代骨干ConvNeXt-L,STQ达到76.5%,达到了最先进的水平。在接近在线的环境中,当使用ResNet50时,我们的Video kMaX(接近在线)显著超过Motion DeepLab+16.2%STQ。当使用Axial-ResNet50-B1主干时,Video kMaX(接近在线)的STQ也比TubeFormer高+2.8%。最后,带有ConvNeXt-L的Video kMaX(近在线)以78.9%的STQ进一步创造了最先进的性能,显著优于当前的最佳结果(带有Axial-ResNet50-B3的TubeFormer)+4.6%的STQ。

在测试集上观察到了相同的趋势(表1(b)),其中我们的模型达到了68.5%的STQ,显著优于现有技术的TubeFormer、Video K-Net和Motion DeepLab,STQ分别为+3.2%、+5.5%和+16.3%。值得注意的是,我们极其简单的模型甚至比ICCV 2021挑战赛冠军UW IPL/ETRI AIRL高出+0.9%STQ,后者利用伪标签,采用极其复杂的系统,不仅由单独的跟踪、检测和分割模块组成,还需要3D对象和深度信息。

VIPSeg表2(a)总结了VIPSeg值集的结果。在在线设置中,我们的视频kMaX(在线)与ResNet50达到38.7%的STQ/36.8%的VPQ,显著优于现有技术的视频K-Net+5.6%的STQ/+10.7%的VPQ。

使用ConvNeXt-L主干,我们的模型将最新的技术水平提高到49.4%STQ/49.4%VPQ。在近在线设置中,当使用ResNet50时,我们的视频kMaX(近在线)超过ClipPanoFCN+8.4%STQ/+15.3%VPQ。当使用Axial-ResNet50-B1时,Video kMaX(接近在线)比TubeFormer高出+6.0%STQ/+17.5%VPQ。

我们采用ConvNeXt-L主干的最佳设置进一步将最先进的STQ/51.9%VPQ提高到51.7%,比Axial-ResNet50-B3的TubeFormer高出+10.2%STQ/+20.7%VPQ。我们还在表2(b)中的VIPSeg测试集上展示了Video kMaX(接近在线)的有效性,其中Video kMaX也创下了新的技术水平,比TubeFormer高出+8.5%STQ/+18.2%VPQ。

4.4.消融研究

关联模块

4.4.消融研究

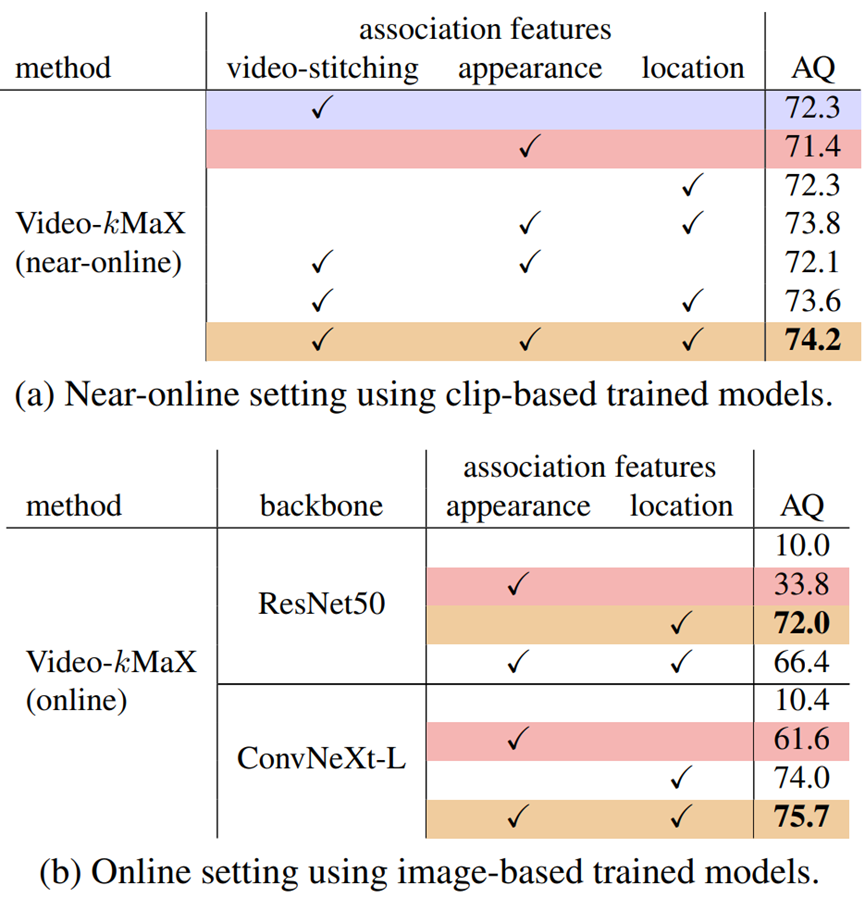

提出的LA-MB贡献

(1) 视频拼接(VS)、(2)外观特征和(3)位置特征,以执行对象关联。在表3中,我们仔细研究了在近在线和在线设置下LA-MB中每个特征的效果。在接近在线的环境中(表3(a)),当单独使用这三个特征时,我们发现VS和位置特征都比外观特征更有效。我们注意到,当只使用外观时,该方法就变成了其他作品所使用的朴素MB方法。将所有这些功能结合起来可以获得最佳的模糊设置,而去掉定位功能将使AQ性能下降最多。这项研究表明,我们提出的位置特征是其中最有效的特征。在在线环境中,由于VS策略变得不可行,我们只对外观和位置特征进行实验。

如表3(b)所示,不利用任何关联特征的纯图像模型的性能最差。有趣的是,我们注意到ResNet50学习的外观特征不如ConvNeXt-L有效。当外观特征不太有效时(例如,当使用ResNet50时),最好仅使用位置特征进行关联。另一方面,当外观特征具有足够的信息量时(例如,当使用ConvNeXt-L时),通过使用外观特征和位置特征来获得最佳性能。

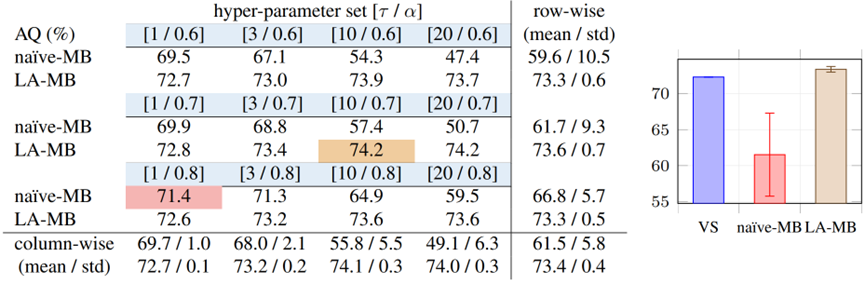

内存相关超参数我们提出的内存模块LA-MB包含两个超参数:

τ(用于刷新内存缓冲区中的旧对象)和α(用于匹配的置信阈值)。

在表4中,我们消除了它们对我们的LA-MB和基线naıve MB的影响。如表所示,我们的LA-MB不仅表现得更好,而且对超参数值的鲁棒性也比naıve MB更强。更具体地说,当计算所获得的AQ w.r.t.不同τ和α的平均值和标准差(std)时,我们的LA-MB获得了73.4的平均值,std为0.4,而基线naıve MB获得了61.5的较低平均值和5.8的较高std。我们认为LA-MB的鲁棒性可以归因于其有效的分层匹配方案,避免了由于匹配空间大而引起的歧义。

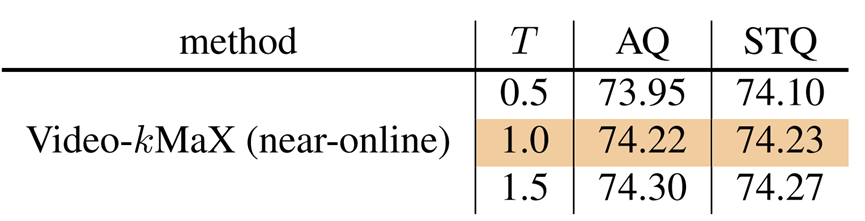

与特征相关的超参数我们采用温度T来缩放位置和外观特征之间的值(见等式(5))。如表5所示,我们的模型对T的不同值是稳健的。因此,为了简单起见,我们将其值默认为1。

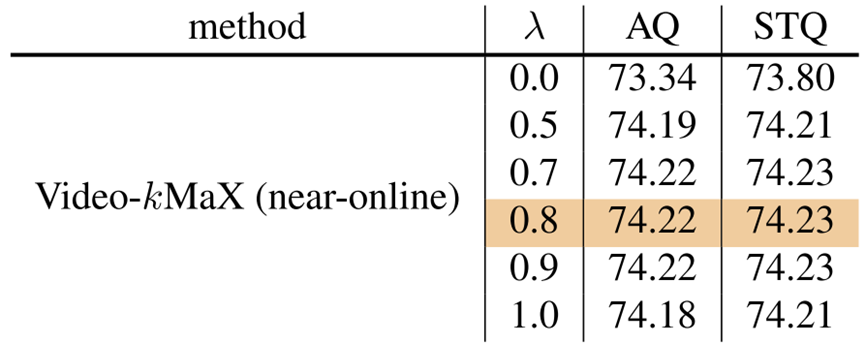

此外,如表6所示,我们的模型对λ的不同值也是稳健的,这平衡了内存中存储的外观特征和当前外观特征之间的权重(见等式(3))。

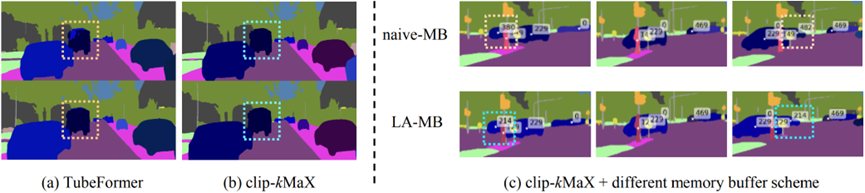

可视化分析我们在图5中可视化KITTI-STEP的结果。剪辑kMaX在剪辑中的帧之间的一致分割方面比最先进的TubeFormer表现得更好。所提出的LA-MB能够实现长期关联,成功地重新识别被遮挡的汽车对象(ID 214),而基线naıve MB失败,因为它只利用了外观特征。

表3. KITTI-STEP值集上不同关联特征的消融研究,包括视频缝合策略、外观特征和位置特征。我们注意到,使用不同的关联特征只会影响关联质量(AQ)。

表4. 在KITTI-STEP val集上使用不同的记忆相关超参数集(τ表示记忆刷新,α表示置信阈值)对Video kMaX稳定性的消融研究。我们改变τ∈{1,3,10,20}(表中的不同列)和α∈{0.6,0.7,0.8}(表的不同行)。我们逐列(fxedτ和变化的α)、逐行(变化的τ和fxedα)和逐表(变化的σ和α)计算平均值和标准偏差。我们绘制了右边整张表的平均值和标准偏差。所提出的LA-MB对超参数值的鲁棒性比朴素的MB方法更强。我们的最终LA-MB设置和初始MB基线分别用棕色和红色标记。

图5. KITTI-STEP值集的可视化结果。所提出的片段内分割器clip-kMaX比现有技术的TubeFormer更好地分割片段中的对象((a)对(b))。在(c)中,所提出的交叉剪辑关联器LA-MB(位置感知内存缓冲区)比仅利用外观特征的基线naıve MB更好地关联被遮挡对象。

表5. 对温度T的消融研究,该研究按位置和外观特征之间的值进行缩放。我们的fnal设置标记为灰色。在该表中,我们显示了最多两个小数点的结果,以更清楚地看到对T的鲁棒性。

表6. 对移动平均权重λ的附加分析,它平衡了存储在存储器中的外观特征和当前外观特征。我们的fnal设置标记为灰色。

在该表中,我们显示了小数点后两位的结果,以更清楚地看到对λ的稳健性。

我们的最终LA-MB设置用棕色标记,而视频拼接和原始MB基线分别用蓝色和红色表示

5.结论

在这项工作中,我们提出了Video kMaX,这是一个用于在线和近在线视频全景分割(VPS)模型的统一框架,具有两个模块:剪辑kMaX和LAMB。片段kMaX利用对象查询作为聚类中心来对片段内同一对象的像素进行分组,而LA-MB是一种新颖且稳健的存储器模块,用于与分层匹配方案的短期和长期关联。我们的方法的有效性在KITTI-STEP和VIPSeg数据集上得到了验证。

视频全景分割

参考文献链接

Video-kMaX: A Simple Unified Approach for Online and Near-Online Video Panoptic Segmentation

https://openaccess.thecvf.com/content/WACV2024/papers/Shin_Video-kMaX_A_Simple_Unified_Approach_for_Online_and_Near-Online_Video_WACV_2024_paper.pdf

浙公网安备 33010602011771号

浙公网安备 33010602011771号