Preapare DeepLearning Interview《一》

1. SVM推导,SMO算法,核函数?

核函数:SIGAI 核函数

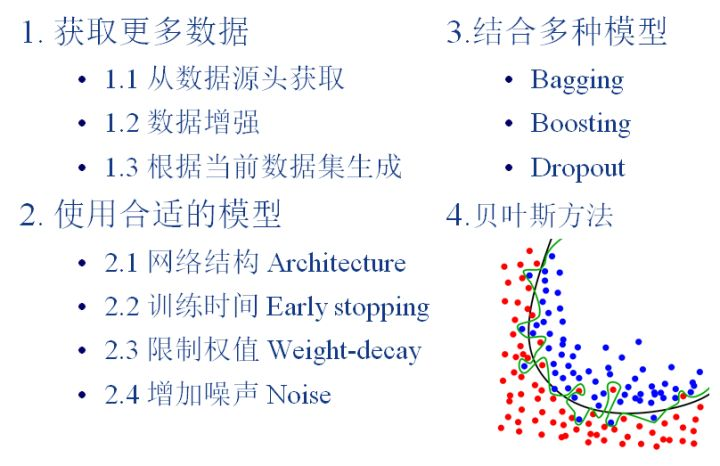

2. 解决过拟合的办法?

答:知乎回答

关于贝叶斯方法:

3. 常用CNN模型介绍及创新点?

4. 理解梯度下降法,牛顿法和拟牛顿法?

答:

5. BP,SGD推导?

6. BatchNormalization原理,训练和测试的区别?

7. Dropout的原理?

8. 类别不平衡怎么办,数据和算法方面?

9. 转置卷积和反卷积的操作?

10. 损失函数的理解?像分类任务中交叉熵和softmax的比较?回归问题的L1和L2。

11. 卷积过程是如何优化的?

12. 常用小型化网络方法?

答:

(1)卷积核分解,使用1×N和N×1的卷积核代替N×N的卷积核,类似MoblieNet

(2)使用bottleneck结构,以SqueezeNet为代表

(3)以低精度浮点数保存,例如Deep Compression

(4)冗余卷积核剪枝及哈弗曼编码

13. 逻辑回归的损失函数推导过程?(数学公式推导)

14. 为什么说反向传播沿负梯度方向更新最快?(数学公式推导)

15. LDA,SVD算法。

16. 小目标检测怎么处理?

浙公网安备 33010602011771号

浙公网安备 33010602011771号