【随手记录】deepseek 容器部署(Ollama + WebGUI)

1、安装Ollama:

Ollama是一个开源的大型语言模型服务工具,它帮助用户快速在本地运行大模型,通过简单的安装指令,可以让用户执行一条命令就在本地运行开源大型语言模型,例如 Llama2。 Ollama 将模型权重、配置和数据捆绑到一个包中,定义成 Modelfile。它优化了设置和配置细节,包括 GPU 使用情况。 直接安装:国内网速比较慢,走华为镜像仓库:

sudo docker pull swr.cn-north-4.myhuaweicloud.com/ddn-k8s/docker.io/ollama/ollama

sudo docker run -d -v ollama:/ollama -p 11434:11434 --name ollama swr.cn-north-4.myhuaweicloud.com/ddn-k8s/docker.io/ollama/ollama

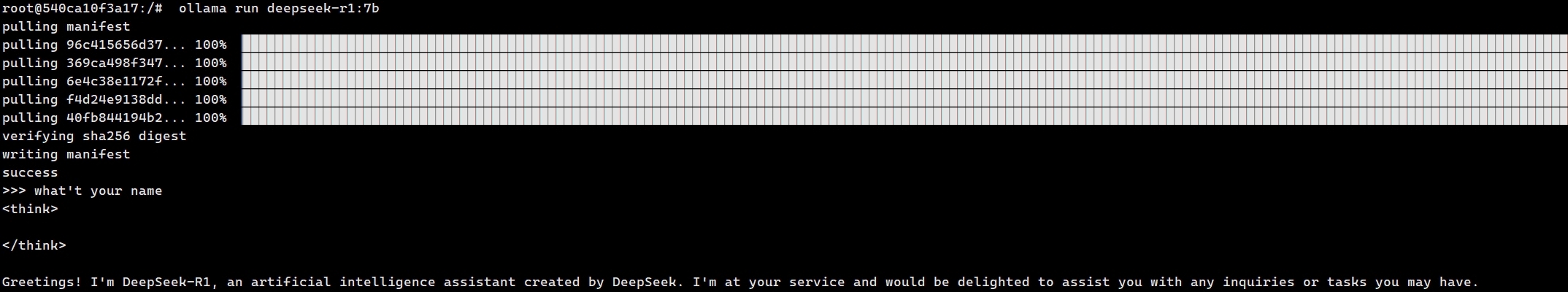

Ollama安装完成后可以安装目标大模型:

// 进入容器

docker exec -it ${containerId} /bin/bash

// ollama run deepseek-r1:${tag} 安装deepseek模型,这里选择7b模型阉割版本,降低服务器性能要求

ollama run deepseek-r1:7b

2、安装WebGUI:

这里直接docker pull ghcr.io/open-webui/open-webui:main,可能会报错:

docker: mediaType in manifest should be 'application/vnd.docker.distribution.manifest.v2+json' not 'application/vnd.oci.image.manifest.v1+json'.

-

Docker V2 Schema 2 是 Docker 原生支持的镜像清单格式(媒体类型为

application/vnd.docker.distribution.manifest.v2+json),而 OCI 格式的清单是对 Docker V2 的扩展,需更高版本 Docker 才能解析。 -

旧版本 Docker(如 18.09 及更早版本)可能因协议不兼容而报错,提示

mediaType不匹配 - 若需确认当前 Docker 版本是否支持 OCI 格式,可通过以下命令查看版本:docker --version 若版本低于 20.10,建议升级至最新稳定版

// 跟Ollama 部署在一起

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mai

// 跟Ollama 分开部署

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=http://ip:11434 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:main

3、还可以通过ctr拉取镜像,导入到docker,安装WebGUI:

// 拉取镜像 ctr i pull ghcr.nju.edu.cn/open-webui/open-webui:main // 导出镜像 -n指定命名恐惧 ctr -n default image export myimage.tar ghcr.nju.edu.cn/open-webui/open-webui:main // 导入docker docker load -i myimage.tar // 启动 docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=http://ip:11434 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:main

浙公网安备 33010602011771号

浙公网安备 33010602011771号