llamafactory配置

1、训练注意参数

2、导出量化参数:

3、验证注意参数

4、微调deepseekR1-Qwen-1.5B使用vllm在llamafactory推理结果跟单独使用vllm推理模型的效果不一致:

原因是因为是提示词模板不一致

构建jinjia后缀的提示词模板

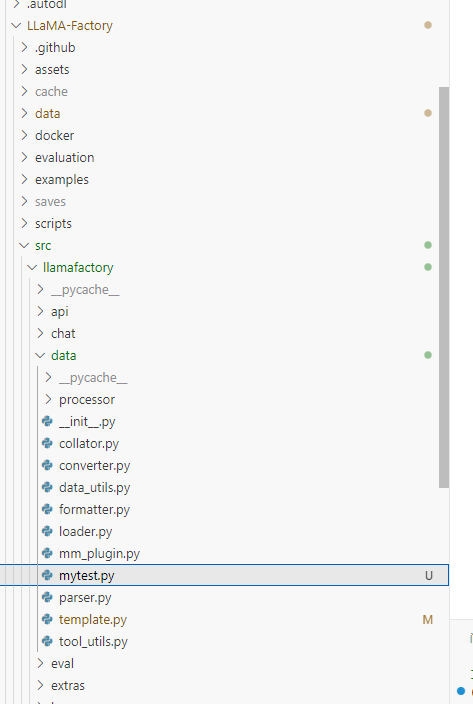

# mytest.py

import sys

import os

# 将项目根目录添加到 Python 路径

root_dir = os.path.dirname(os.path.dirname(os.path.dirname(os.path.dirname(os.path.abspath(__file__)))))

sys.path.append(root_dir)

from llamafactory.data.template import TEMPLATES

from transformers import AutoTokenizer

# 1. 初始化分词器(任意支持的分词器均可)

tokenizer = AutoTokenizer.from_pretrained("/root/autodl-tmp/llm/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B")

# 2. 获取模板对象

template_name = "qwen" # 替换为你需要查看的模板名称

template = TEMPLATES[template_name]

# 3. 修复分词器的 Jinja 模板

template.fix_jinja_template(tokenizer)

# 4. 直接输出模板的 Jinja 格式

print("=" * 40)

print(f"Template [{template_name}] 的 Jinja 格式:")

print("=" * 40)

print(tokenizer.chat_template)

文件位置:

命令:

vllm serve <model> --chat-template ./path-to-chat-template.jinjavllm serve <model> --chat-template ./path-to-chat-template.jinja

中文文档地址:

https://vllm.hyper.ai/docs/inference-and-serving/openai_compatible_server

浙公网安备 33010602011771号

浙公网安备 33010602011771号