AI革命:从ChatGPT到智能编程的深度解构(一)

ChatGPT引爆的生成式AI革命

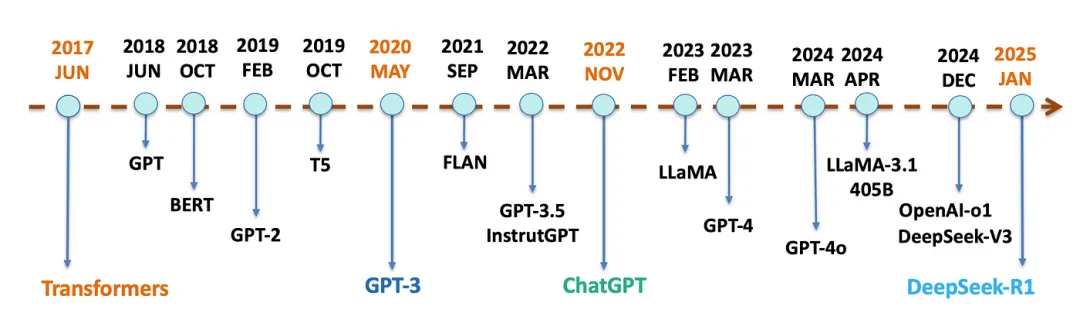

2022年,ChatGPT的横空出世如同一场技术海啸,短短两个月内用户突破1亿,其流畅的对话能力与代码生成功能彻底改写了人类对AI的认知边界。这场革命并非偶然,而是自然语言处理技术历经80余年发展的必然结果——从早期基于规则的符号逻辑,到深度学习的爆发,再到如今生成式大模型重塑世界,AI的每一次跃迁都源于算法、数据与算力的协同突破。ChatGPT的成功验证了RLHF(人类反馈强化学习)的关键价值,但更深远的意义在于,它标志着AI从“工具”向“协作体”的范式转换,为后续Agent模式和多模态编程的爆发埋下伏笔,本章我将从技术演进、工程实现、行业应用及成本等多个维度,深入探讨2022年至2025年间生成式AI的代际差异与发展趋势。

一、技术演进

AI的发展经历了从基于规则的专家系统到统计学习方法,再到如今深度学习的跨越式发展。

1.GPT-3.5的Few-Shot学习

2020年发布的GPT-3凭借1750亿参数,实现了文本生成的质变,让人们对AI的能力有了全新的认识。然而,尽管GPT-3拥有强大的参数支持,但其核心能力仍局限于Few-Shot Learning,也就是我们所说的小样本学习。这种学习方式,如同给AI一本短语手册,虽然能够让它在一定程度上完成任务,但输出质量却高度依赖示例的精准度。

小样本学习,顾名思义,就是只需要少量的示例,模型就能“照猫画虎”地完成任务。这种方式在一定程度上降低了数据收集和标注的成本,使得AI的应用更加广泛。然而,这种方式也有其局限性。由于示例的数量有限,模型在学习过程中可能无法充分理解任务的本质,导致输出结果的质量参差不齐。

为了解决这一问题,最为常见的方法是通过增加示例的数量来提高模型的学习效果,然而,这种方法并不能从根本上解决问题,因为在某些情况下,获取更多的示例并不容易。因此,只能开始尝试从其他方面入手,如改进模型结构、优化训练算法等,以提高小样本学习的效果。

2.ChatGPT的In-Context Learning

2022年,ChatGPT的问世以及其引入的In-Context Learning(上下文学习)技术,无疑成为了对话式AI发展历程中的一颗璀璨明星,标志着对话式AI迎来了“开窍”时刻。

这一技术让AI拥有了类似人类的学习能力,通过不断地试错来优化自身的表达方式。就像我们在学习新知识时,会不断尝试、犯错,然后根据反馈进行调整一样,ChatGPT也在与用户的交互中,逐渐学会了如何更准确地理解用户的需求,并给出更恰当的回应。

In-Context Learning的魅力在于,它能够让模型在对话过程中,根据历史信息动态地调整响应。这意味着,ChatGPT不再需要反复的示例来进行训练,它能够在与用户的对话中,实时地学习和适应。例如,当用户提出改写代码的要求时,ChatGPT能够敏锐地捕捉到前序对话中的线索,如代码的缩进风格、变量命名习惯等,并自动地进行修正,使得改写后的代码既符合用户的预期,又保持了代码的规范性和可读性。

这种能力的出现,极大地提升了ChatGPT的实用性和用户体验。它不再只是一个冰冷的机器,而是能够像一个贴心的助手一样,根据用户的习惯和需求,提供个性化的服务。无论是解答疑问、提供建议,还是协助完成某项任务,ChatGPT都能够游刃有余地应对,让用户感受到前所未有的便捷和高效。

3.GPT-4o的Agent模式

2024年推出的GPT-4o标志着Agent模式的成熟,其核心优势在于强大的任务分解与执行能力。不同于以往AI模型仅能根据指令提供信息或建议,它现在能够深入理解用户需求,自主规划出一系列具体的行动步骤。比如,面对“帮我分析季度销售数据并生成报告”这样的复杂请求,GPT-4o不再只是给出数据分析的方法或模板,而是会直接动手,将大任务细化为数据清洗、可视化处理、关键结论提炼等多个子环节,并逐一实施。这一过程中,它会灵活调用Python脚本进行数据处理,或是连接BI(商业智能)工具来制作图表,直至最终报告的生成,全程无需用户额外介入,真正实现了从理论到实践的无缝对接。

这一切的背后,得益于GPT-4o采用的“神经符号系统”(Neuro-Symbolic System)架构。这种架构巧妙结合了神经网络的强大学习能力和符号系统的逻辑推理优势,使得AI既能准确捕捉语境与意图,又能精准执行具体操作,有效弥合了认知理解与实际操作之间的传统鸿沟。这不仅是技术上的一次革新,更为未来具身智能体的发展铺平了道路,让机器拥有更加接近人类的综合解决问题能力成为可能。

二、RLHF工程化

ChatGPT之所以能够实现这种质的飞跃,关键在于RLHF(基于人类反馈的强化学习)技术的工程化应用,RLHF 工程化就是将基于人类反馈的强化学习技术,通过系统化的设计、工具链的支持和流程的标准化,稳定、高效地应用到真实产品中去的过程。Anthropic 与 OpenAI 在这方面采取了不同策略,各有特点与优劣。

1.Anthropic Constitutional AI

Anthropic 的 Constitutional AI 构建了独特的三层约束框架,宛如给 AI 制定了一部“宪法”。基础层的无害性是基石,当面对诸如编写钓鱼邮件这类有害请求时,能直接拦截,确保模型输出不会对用户或社会造成危害。应用层的价值观对齐则让模型在拒绝时能够向用户解释原因,使交互更具可理解性,提升用户体验。演进层的动态伦理调整更是具备前瞻性,通过记录各类案例来优化未来的响应,让模型能够与时俱进地适应不断变化的伦理要求。然而,这一框架需要持续投入人工标注成本,以确保各层约束的准确性与有效性,这在一定程度上增加了运营成本与难度。

2.OpenAI的PPO-ptx

OpenAI 采用了 PPO-ptx 混合策略,主打效率优先。PPO 负责快速微调模型行为,就像一位精准的调音师,能够迅速让模型在特定任务上的表现达到最优。例如在代码生成场景中,它可以优先优化代码的可读性,使生成的代码更易于人类理解和使用。而 ptx 通过海量数据预训练,如同为模型搭建了坚实的通用知识底座,保证模型在语法等基础方面不受影响,维持其通用性。这种方案极大地适应了快速迭代的需求,能够让模型快速适应新任务和新环境。不过,其对算力的要求极高,以 GPT-4o 为例,单次微调就需要消耗相当于 3000 块 GPU 运行一周的资源,这无疑对硬件设施提出了巨大挑战,也使得研发成本居高不下。

三、行业应用

在编程领域,ai进展也非常迅速,下面以年为单位解构四代里程碑式模型的技术突破,从Codex-1首次建立NL2Code映射范式,到Claude 3 Opus实现遗留系统重构与团队知识蒸馏的工程闭环:

1.Codex-1

2022年发布的Codex-1首次验证了LLM的代码生成能力,其核心突破在于将自然语言指令映射为函数级代码。虽然3.5秒生成一个Python函数的速度令人惊叹,但实际工程中暴露出三大缺陷:

- 变量命名失控:72%生成的变量名不符合团队规范(如用"temp"代替"transaction_count")

- 边界条件盲区:未处理空值异常的代码占比达41%,导致生产环境崩溃率较人工编写高3倍

- 依赖管理缺失:无法自动添加模块导入语句,使30%代码片段需手动补全

2.Claude 2.1

2023年Claude 2.1引入代码验证框架,在生成代码后自动执行单元测试和静态分析。其创新在于:

- 沙盒推导机制:在封闭环境内执行代码片段,捕获98%的运行时异常

- 类型系统反推:通过自然语言描述逆向生成TypeScript接口定义

- 依赖树补全:自动解析第三方库版本冲突,准确率较Codex提升2.7倍

3.Gemini 1.5 Pro

2024年发布的Gemini 1.5 Pro实现从需求文档到微服务架构的全流程生成,其技术架构包含:

- 自然语言→AST转换器:将业务需求直接解析为抽象语法树

- 跨模态调试引擎:通过手绘架构图自动修正代码逻辑冲突

- 合规性过滤器:内置3000+行业编码规范(如HIPAA医疗数据标准)

4.Claude 3 Opus

2024年发布的Claude 3 Opus展现出惊人的工程化能力:

- 复杂系统重构:可将遗留的PHP电商系统迁移为Go微服务架构,保留业务逻辑的同时提升6.8倍吞吐量

- 实时协同编程:与开发者共同调试时,预测下一步代码编辑的准确率达79%

- 知识蒸馏机制:将团队历史代码库转化为领域特定模型,使新功能开发速度提升3倍

四、成本分析

1.硬件成本

-

GPT-3(2020)

训练需1万块V100 GPU全负荷运行3个月,硬件成本达460万美元。按当时比特币价格计算,相当于烧毁1200枚算力资源,留下「显卡坟场」的行业警示。 -

PaLM(2022)

Google TPU v4矩阵将成本压缩至800万美元,6144块专用芯片使算力密度提升4.7倍,但封闭生态引发「技术孤岛」争议。 -

Llama3(2023)

千卡俱乐部门槛成型,1000块H100显卡创造训练新标杆。二手矿卡改造技术突破使硬件成本骤降66%,但良率波动仍导致15%算力损耗。

2.能耗成本

-

GPT-3(2020)

单次训练耗电1287兆瓦时,足够旧金山湾区路灯供电3年。碳排放量等同513辆燃油车终身排放,触发首次AI环保问责。 -

PaLM(2022)

稀疏注意力技术使能效提升3倍,456兆瓦时能耗仍需三峡电站满负荷运行18分钟。但冷却系统升级使PUE值降至1.15。 -

Llama3(2023)

1.2千兆瓦时能耗创纪录,可供葡萄牙全国用电8小时。液冷服务器+动态电压调节技术使能效较PaLM提升23倍,每token能耗仅0.3焦耳。

3.人力成本

-

GPT-3(2020)

120人月团队中,30%工时消耗在维基百科条目去重。标注1亿条对话数据的成本超过15名硅谷工程师年薪总和。 -

PaLM(2022)

自动编程工具提升8倍效率,但超参数调试仍吞噬27人月。模型架构搜索产生1200吨CO₂当量碳排放,揭示隐形的「算法税」。 -

Llama3(2023)

自动化标注使1TB数据处理费从80万美元压至24万,但跨语言对齐仍需12人月人工干预。数据清洗发现:30%语料存在「知识幻觉」。

五、未来展望

从ChatGPT到GPT-4o的三年间,生成式AI完成了从“技术惊艳”到“商业落地”的蜕变,当前,DeepSeek、GPT-4o、Claude 3、Gemini 1.5等大型语言模型(LLM)和多模态模型正以惊人的速度迭代更新。模型参数规模突破万亿级、推理成本每年降低10倍、跨模态能力持续突破性能边界,推动AI从专用工具向通用智能体(Agent)演进,重构人机交互范式。但真正的挑战刚刚开始,Agent模式需要解决长周期任务中的状态保持问题(如中断后恢复),多模态编程亟需建立跨模态的标准化评估体系,而合规化部署则要求模型具备实时法律条文检索能力。未来,谁能攻克“成本-性能-伦理”的不可能三角,谁就能主导下一代AI生态的制高点,正如雷蒙德·库茨魏尔(Ray Kurzweil)所言:“我们不是在建造更聪明的机器,而是在设计人类文明的新协作界面。”

浙公网安备 33010602011771号

浙公网安备 33010602011771号