本地部署deepseek

前言

如果你电脑配置不错,且期望不受网络限制也可以流畅使用deepseek,那就本地部署deepseek试试吧。

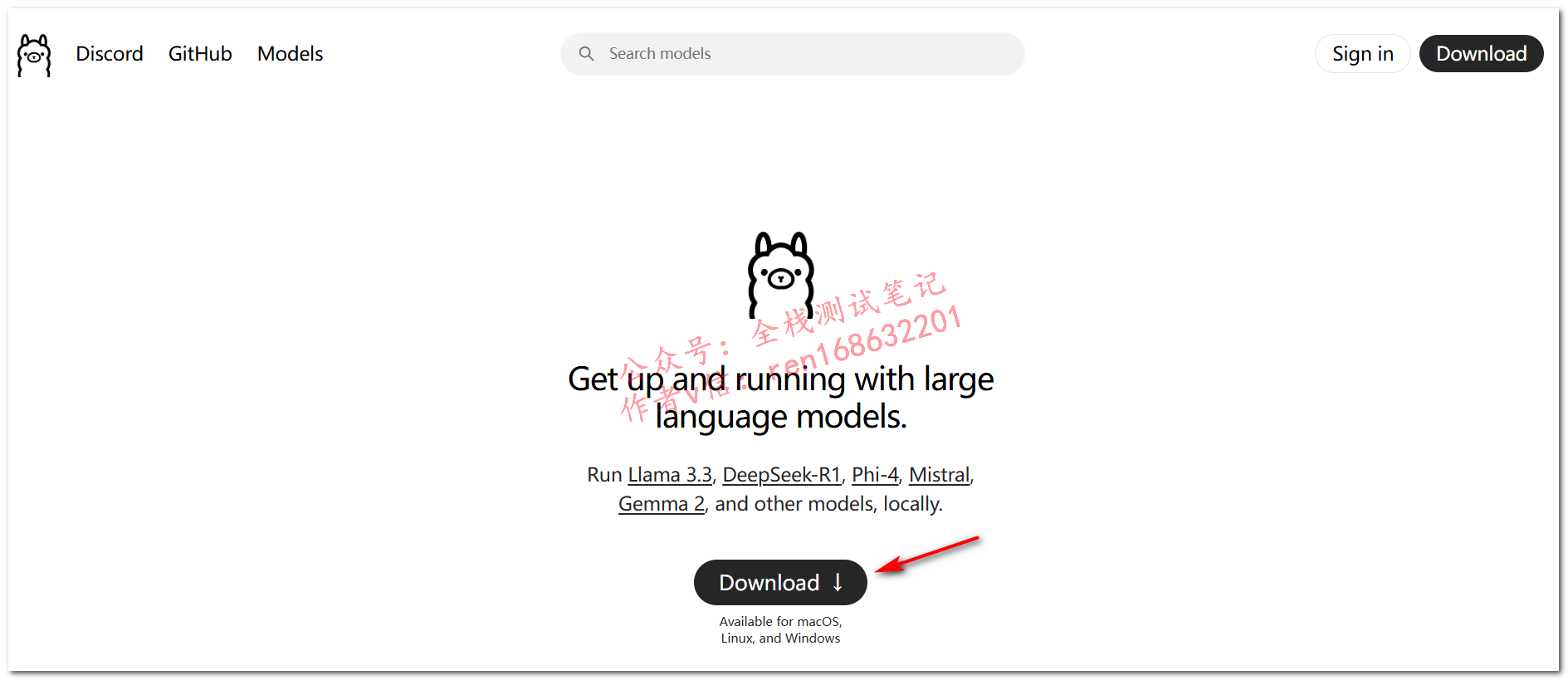

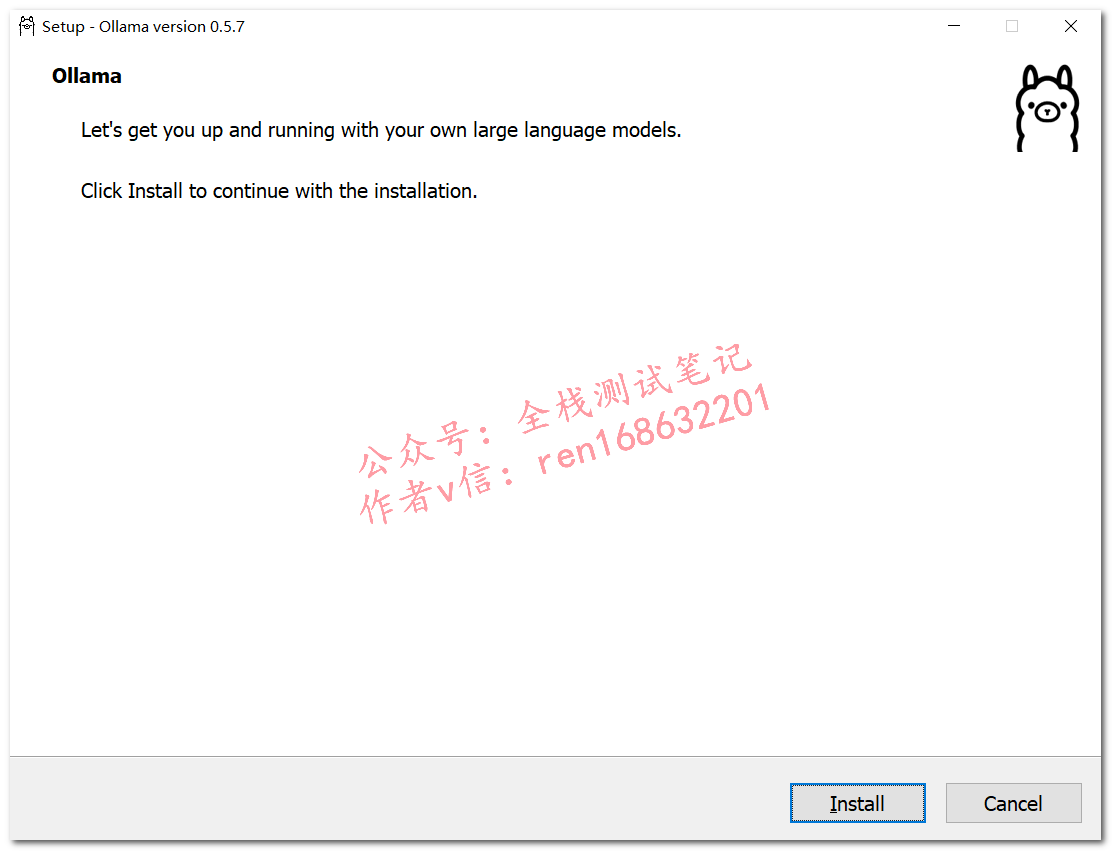

下载并安装Ollama

Ollama是一个开源的 LLM(大型语言模型)服务工具(就是大模型运行工具),用于简化在本地运行大语言模型,降低使用大语言模型的门槛,使得大模型的开发者、研究人员和爱好者能够在本地环境快速实验、管理和部署最新大语言模型。

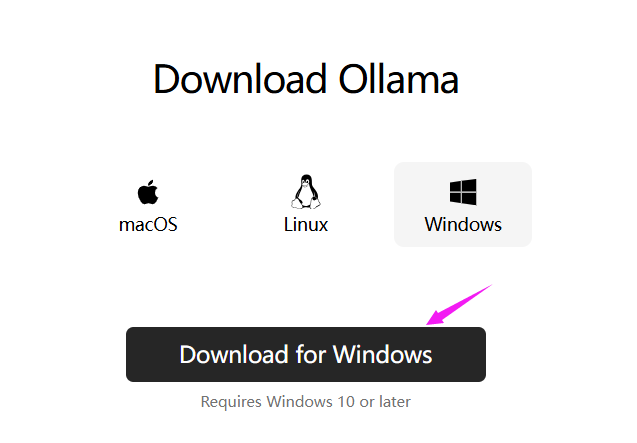

根据自己电脑系统类型下载

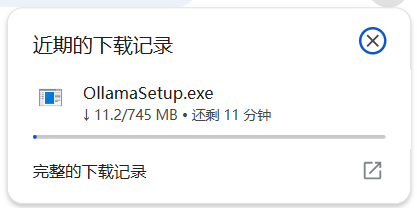

这里要科雪上网下载(可以私信推荐稳定的科雪上网方式)

https://github.com/ollama/ollama/releases/latest/download/OllamaSetup.exe

双击安装

安装完成后,右下角隐藏的图标中可以看到如下图标

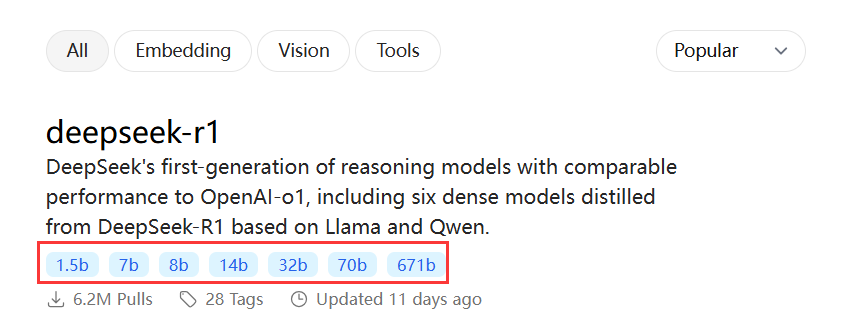

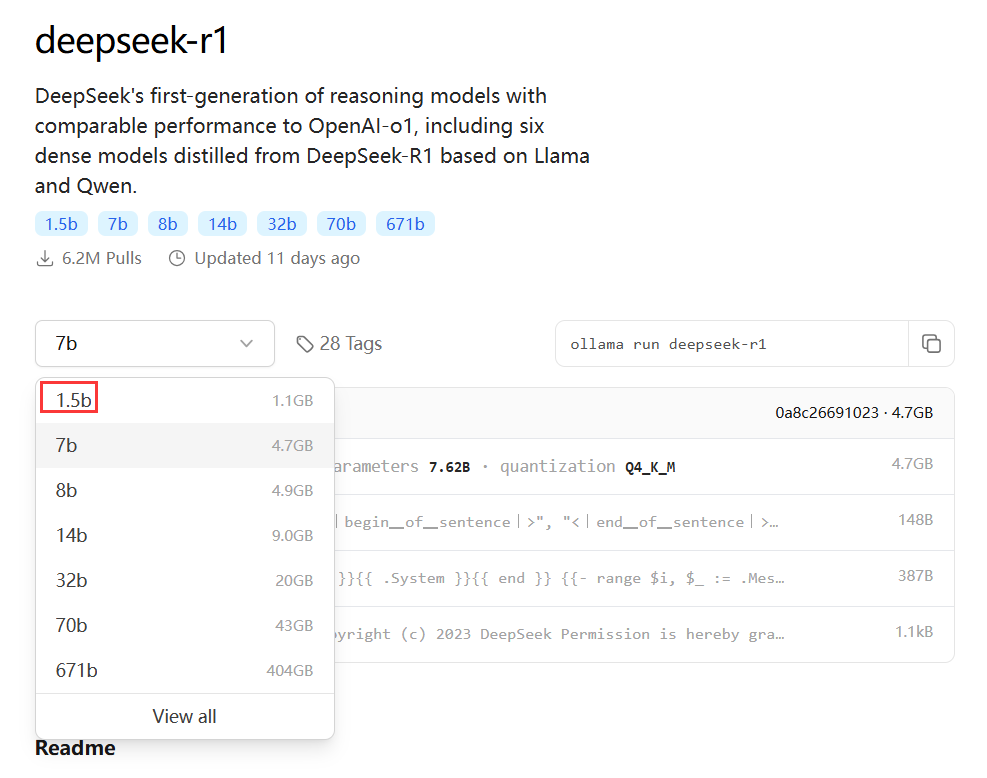

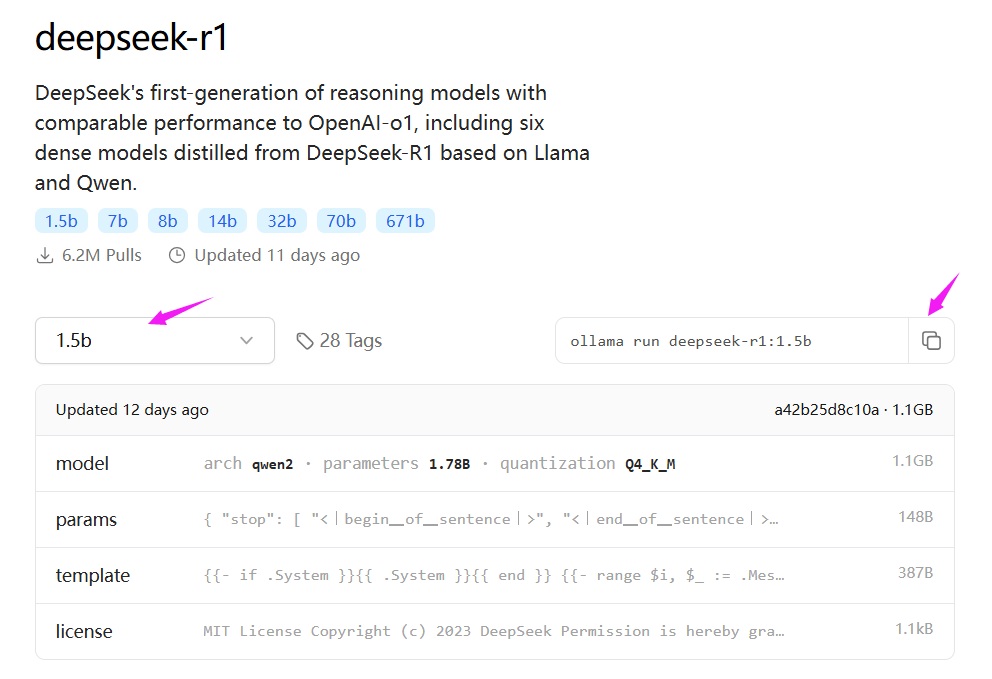

部署deepseekR1模型

从左到右,越来越精准,对电脑配置也依次变高

这里只是演示,选择1.5b

复制右侧命令

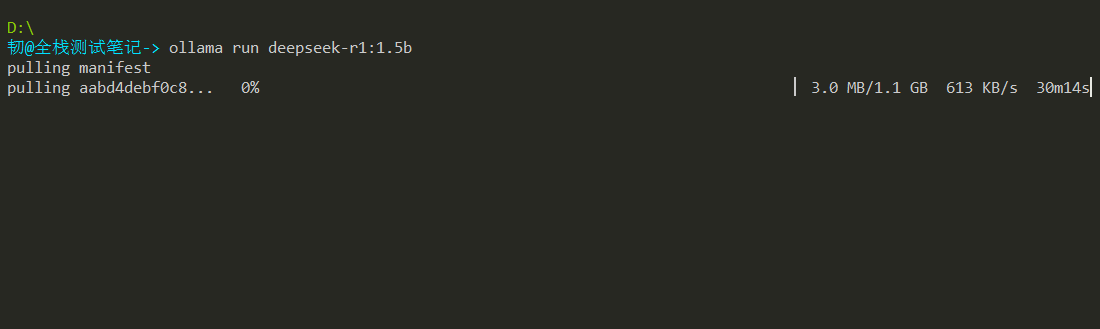

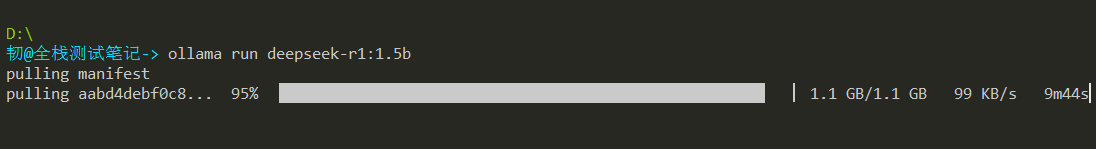

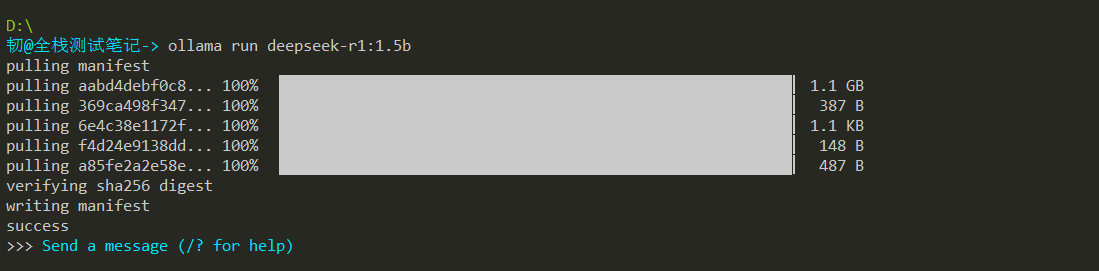

cmd中执行刚刚复制的命令:ollama run deepseek-r1:1.5b

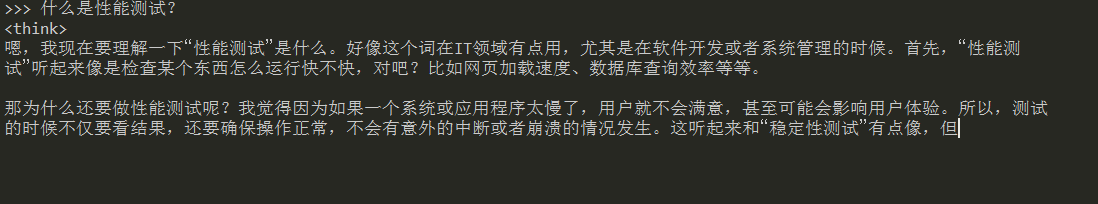

然后可以输入问题获取回复结果

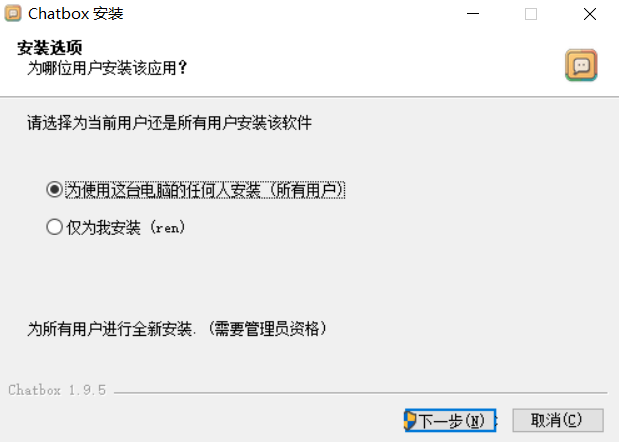

下载、安装、配置chatbox可视化对话框

上面每次都要在cmd中输入运行命令,比较麻烦,我们可以用chatbox可视化对话框。

安装

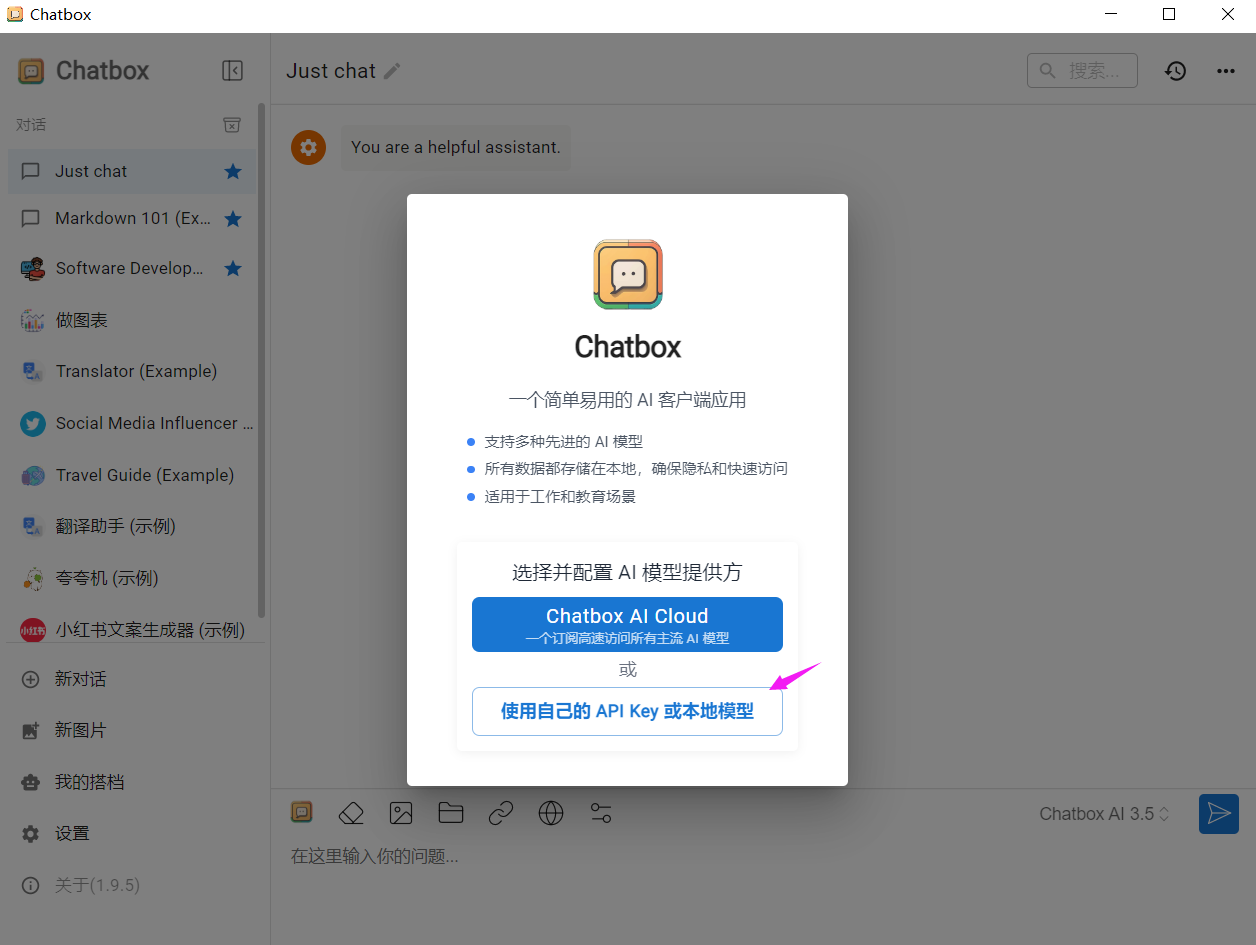

配置

选择模型提供方:OLLAMA API

选择模型:deepseek-r1:1.5b

然后点击“保存”

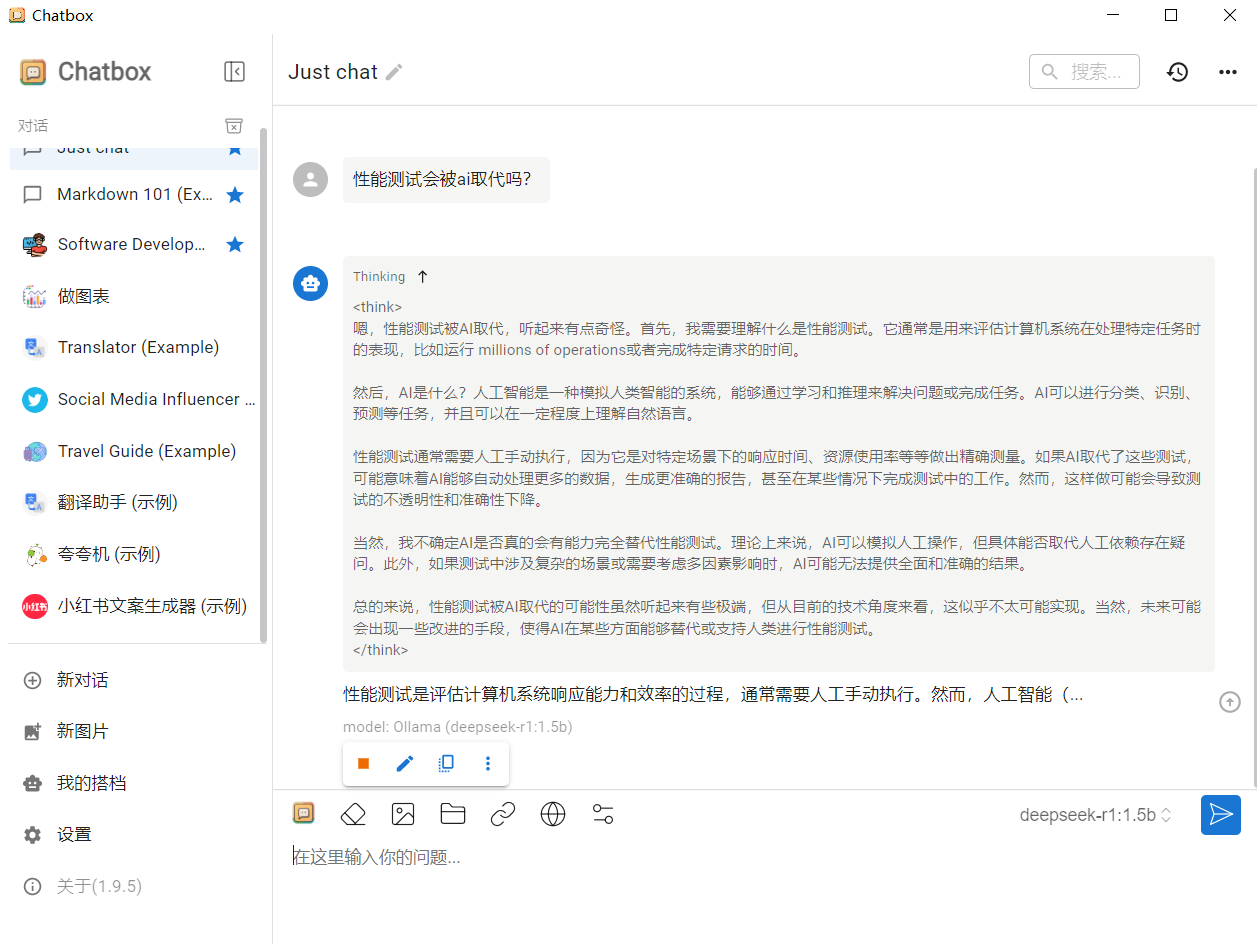

然后就可以在chatbox中输入问题了

是不是很简单?赶紧试试吧。

__EOF__

本文作者:持之以恒(韧)

关于博主:擅长性能、全链路、自动化、企业级自动化持续集成(DevTestOps)、测开等

面试必备:项目实战(性能、自动化)、简历笔试,https://www.cnblogs.com/uncleyong/p/15777706.html

测试提升:从测试小白到高级测试修炼之路,https://www.cnblogs.com/uncleyong/p/10530261.html

欢迎分享:如果您觉得文章对您有帮助,欢迎转载、分享,也可以点击文章右下角【推荐】一下!

关于博主:擅长性能、全链路、自动化、企业级自动化持续集成(DevTestOps)、测开等

面试必备:项目实战(性能、自动化)、简历笔试,https://www.cnblogs.com/uncleyong/p/15777706.html

测试提升:从测试小白到高级测试修炼之路,https://www.cnblogs.com/uncleyong/p/10530261.html

欢迎分享:如果您觉得文章对您有帮助,欢迎转载、分享,也可以点击文章右下角【推荐】一下!

浙公网安备 33010602011771号

浙公网安备 33010602011771号