golang netpoll 底层原理

Golang Netpoll 底层原理深度解析 - 学习记录

📚 前言

最近深度学习了一篇关于 Golang netpoll 底层原理的万字技术文章,这是一篇真正从理论基础到源码实现的深度技术分析。作者不仅从 IO 多路复用的基本概念开始推演,更是通过与 C++ 等其他语言的横向对比,揭示了 Go 语言在网络编程模型设计上的精妙之处。

这篇学习记录将完整梳理从 IO 多路复用理论推演到 Go netpoll 源码实现的全过程,希望能够帮助自己和其他开发者更深入地理解 Go 语言网络编程的底层机制。

🎯 学习目标

通过这次深度学习,我希望能够:

- 从第一性原理理解 IO 多路复用技术的演进过程

- 深入掌握 epoll 机制的核心实现原理和数据结构设计

- 全面分析 Go netpoll 框架的架构设计和策略选型

- 通过源码走读理解 netpoll 与 GMP 调度器的协作机制

- 理解 Go 语言在网络编程领域的设计哲学和工程权衡

📖 理论基础与技术推演

1. IO 多路复用的演进思路

1.1 从餐厅服务模式理解多路复用

原文作者用了一个非常生动的餐厅服务员的例子来解释 IO 多路复用的概念。让我们跟随这个思路来理解技术演进的过程:

多路复用的本质:

- 多路:存在多个待服务目标(多个文件描述符)

- 复用:重复利用一个单元来为多个目标提供服务(单个线程处理多个连接)

1.2 技术演进的三个阶段

1)单点阻塞 IO 模型

在 Linux 系统中,一切皆为文件,所有事物都可以抽象化为文件描述符(fd)。

// 单点阻塞模式

int sockfd = socket(AF_INET, SOCK_STREAM, 0);

bind(sockfd, ...);

listen(sockfd, ...);

// 阻塞等待连接

int connfd = accept(sockfd, ...); // 线程在此阻塞

这就像餐厅为每名顾客提供一位专属服务员进行一对一服务:

- ✅ 优点:服务专一,响应及时

- ❌ 缺点:资源浪费,无法复用

2)多点轮询 + 非阻塞 IO 模型

为了实现复用,需要让一个线程同时监听多个 fd,此时必须摒弃阻塞调用:

// 设置非阻塞模式

fcntl(fd, F_SETFL, O_NONBLOCK);

// 轮询检查

for (int i = 0; i < fd_count; i++) {

int result = accept(fds[i], ...);

if (result == -1 && errno == EAGAIN) {

// 无连接,继续下一个

continue;

}

// 处理连接

}

这就像一个服务员需要不停地在各桌之间询问:"您需要什么服务吗?"

- ✅ 优点:实现了复用

- ❌ 缺点:大量无效轮询,CPU 资源浪费

3)IO 多路复用技术

理想的解决方案是:服务员可以基于顾客的主动招呼再响应,而不是无休止的主动询问。

但是用户态线程就像"视听能力不好的服务生",无法同时精确接收多个文件描述符的状态变化,只能通过系统调用逐一询问。

IO 多路复用技术应运而生:在单个指令层面支持同时监听多个 fd,并可根据需要选择非阻塞、阻塞或超时模式。

2. epoll 核心机制深度解析

2.1 epoll 指令组详解

epoll 全称 EventPoll,是一种基于事件回调机制的 IO 多路复用技术,包含三个核心指令:

1)epoll_create - 创建事件表

extern int epoll_create (int __size) __THROW;

- 在内核空间创建 epoll 事件表

- 事件表基于红黑树实现的 key-value 有序表

- key: 文件描述符 fd

- value: 监听事件类型 + 用户自定义数据

为什么选择红黑树而非哈希表?

这是一个很好的技术权衡问题:

| 对比维度 | 哈希表 | 红黑树 |

|---|---|---|

| 时间复杂度 | O(1) 但常数系数高 | O(logN) 但常数系数低 |

| 内存连续性 | 需要连续的桶数组空间 | 节点通过指针链接,空间分配灵活 |

| 实际性能 | 在 fd 数量较少时,高常数系数成为瓶颈 | 在 N 不大时,O(logN) 与 O(1) 差距不大 |

2)epoll_ctl - 事件表操作

extern int epoll_ctl (int __epfd, int __op, int __fd,

struct epoll_event *__event) __THROW;

支持三种操作,时间复杂度均为 O(logN):

EPOLL_CTL_ADD:增加 fd 并注册监听事件EPOLL_CTL_MOD:修改 fd 监听事件类型EPOLL_CTL_DEL:删除 fd

3)epoll_wait - 等待事件就绪

extern int epoll_wait (int __epfd, struct epoll_event *__events,

int __maxevents, int __timeout);

- 传入固定容量的就绪事件列表

- 基于事件回调机制将就绪事件添加到列表中

- 支持非阻塞、阻塞、超时三种模式

2.2 epoll 相比 select 的核心优势

| 优势维度 | select | epoll |

|---|---|---|

| fd 数量限制 | 固定上限(通常1024) | 灵活指定,无硬限制 |

| 内核拷贝开销 | 每次调用都需要重新拷贝 fd 集合 | 一次注册,多次复用 |

| 结果返回方式 | 只返回就绪数量,需要遍历查找 | 直接返回就绪事件列表 |

| 适用场景 | fd 数量少且活跃度高 | fd 数量大且活跃度不高 |

2.3 epoll 的触发模式

水平触发(Level Triggered, LT):

- 只要 fd 处于就绪状态,就持续通知

- 编程简单,不易丢失事件

- 适合传统的阻塞式编程模型

边缘触发(Edge Triggered, ET):

- 仅在 fd 状态变化时通知一次

- 性能更高,但编程复杂

- 必须一次性处理完所有数据

- 适合高性能服务器场景

🏗️ Go netpoll 框架深度剖析

3. Go netpoll 整体架构设计

Go 在 Linux 系统下依赖 epoll 作为核心基建实现其 IO 模型,但在此基础上设计了一套因地制宜的适配方案——golang netpoll 框架。

3.1 核心流程概览

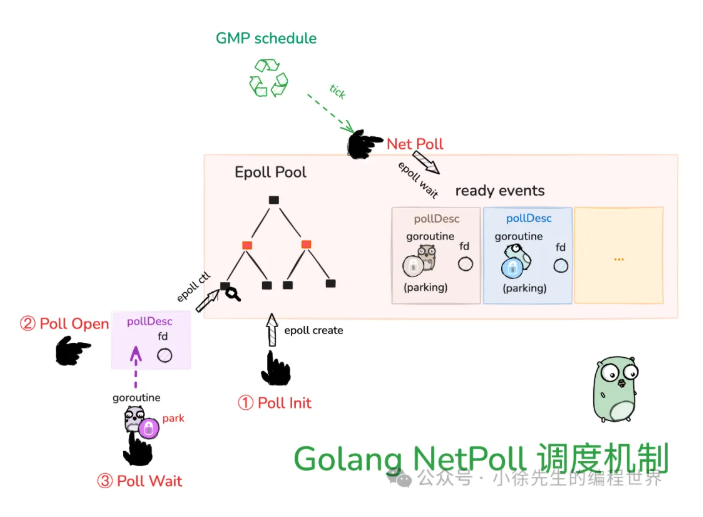

Go netpoll 框架的整体调度机制如下图所示:

💡 图片说明:上图展示了 Go netpoll 的完整架构,包括 GMP 调度器、Epoll 事件池、网络轮询器和就绪事件队列之间的协作关系。从图中可以清晰看到数据流向和各组件的职责分工。

从图中可以看出 Go netpoll 的核心组件:

- GMP Schedule(GMP调度器):负责 goroutine 的调度和管理

- Epoll Pool(Epoll事件池):基于红黑树实现的事件表,存储所有注册的文件描述符

- Net Poll(网络轮询器):连接 GMP 调度器和 Epoll 事件池的桥梁

- Ready Events(就绪事件):存储已就绪的 pollDesc 和对应的 goroutine

核心流程包括:

-

① Poll Init:通过

epoll_create创建 epoll 事件表(全局仅执行一次) -

② Poll Open:构造

pollDesc实例,通过epoll_ctl(ADD)将 fd 注册到 epoll 事件表 -

③ Poll Wait:当 goroutine 依赖的 IO 事件未就绪时,通过

gopark将 goroutine 置为阻塞态 -

Net Poll:GMP 调度流程轮询驱动,通过非阻塞

epoll_wait获取就绪事件,唤醒对应的 goroutine

3.2 net server 流程设计

以启动 net server 为例,完整的流程设计如下图所示:

💡 图片说明:此图详细展示了从 net.Listen 到 conn.Close 的完整流程,每个阶段都标注了对应的 netpoll 操作,帮助理解 Go 网络编程的底层机制。

从图中可以清晰看到四个关键阶段:

🟢 1. net.Listen 阶段

- 创建 socket:通过 syscall socket 创建 socket fd,并执行 bind、listen 操作

- Poll Init 流程:通过 epoll_create 操作创建 epoll 事件表(全局仅执行一次)

- Poll Open 流程:将端口对应的 socket fd 通过 epoll_ctl(ADD) 操作注册到 epoll 事件表

🟡 2. listener.Accept 阶段

- 轮询 + 非阻塞 accept:轮询对 socket fd 调用非阻塞模式下的 accept 操作

- Poll Wait 流程:如若连接未就绪,通过 gopark 操作将当前 goroutine 阻塞,并挂载在 socket fd 对应 pollDesc 的读事件状态标识器 rg 中

- Poll Open 流程:如若连接已到达,将 conn fd 通过 epoll_ctl(ADD) 操作注册到 epoll 事件表

🔵 3. conn.Read/Write 阶段

- 轮询 + 非阻塞 read/write:轮询以非阻塞模式对 conn fd 执行 read/write 操作

- Poll Wait 流程:如果 conn fd 的读写条件未就绪,通过 gopark 操作将当前 goroutine 阻塞,并挂载在 conn fd 对应 pollDesc 的读/写事件状态标识器 rg/wg 中

🟣 4. conn.Close 阶段

- Poll Close 流程:通过 epoll_ctl(DEL) 操作,将 conn fd 从 epoll 事件表中移除

- close fd:通过 close 操作,关闭回收 conn 对应 fd 句柄

// 对应的代码示例

func main() {

l, _ := net.Listen("tcp", ":8080") // 🟢 Poll Init + Poll Open

for {

conn, _ := l.Accept() // 🟡 Poll Wait + Poll Open

go serve(conn)

}

}

func serve(conn net.Conn) {

defer conn.Close() // 🟣 Poll Close

var buf []byte

_, _ = conn.Read(buf) // 🔵 Poll Wait

_, _ = conn.Write(buf) // 🔵 Poll Wait

}

3.3 因地制宜的策略选型

核心设计决策:为什么不直接使用阻塞式 epoll_wait?

这个问题的答案体现在下面的架构对比图中:

💡 图片说明:此图对比了传统阻塞方案与 Go 创新方案的区别,清晰展示了 Go 如何通过 gopark/goready 机制实现 goroutine 粒度的精确控制。

传统方案的问题(上图):

- 用户态直接使用阻塞模式的

epoll_wait - 阻塞粒度是整个线程,影响该线程上的所有 goroutine

- 违背了 Go 语言 GMP 架构的设计理念

Go 的创新方案(下图):

- 采用

gopark实现 goroutine 粒度的精确阻塞 - 使用非阻塞模式的

epoll_wait进行轮询 - 通过

go ready机制精确唤醒对应的 goroutine

原文作者指出的关键点:

epoll_wait的调用单元是 thread(即 GMP 中的 M),而非 goroutine。

Go 语言通过 GMP 架构为使用者屏蔽了线程的所有细节,并发粒度控制在更精细的 goroutine 层面。因此:

- ❌ 不能使用阻塞式 epoll_wait:会导致整个线程阻塞,违背 GMP 设计理念

- ✅ 采用 gopark + 非阻塞 epoll_wait:实现 goroutine 粒度的精确控制

设计对比:

| 方案 | 阻塞单元 | 影响范围 | 调度灵活性 |

|---|---|---|---|

| 传统 epoll_wait 阻塞 | 整个线程 | 该线程上的所有 goroutine | 低 |

| Go netpoll 方案 | 单个 goroutine | 仅当前 goroutine | 高 |

轮询开销的解决:

有人可能会质疑:非阻塞轮询不是会导致 CPU 空转吗?

Go 的巧妙解决方案:

-

与 GMP 调度天然契合:P 本就基于轮询寻找可运行的 goroutine,netpoll 只是其中一种方式

-

智能缩容机制:当 P 找不到可执行的 goroutine 时:

- 保证全局至少有一个 P 进行 netpoll 留守(阻塞或超时模式)

- 其他空闲 P 将 M 和自身置为 idle 态,让出 CPU 执行权

🔍 Go netpoll 源码深度解析

4. 核心数据结构设计

4.1 pollDesc 存储架构

Go netpoll 中有两层 pollDesc 结构:

表层 pollDesc (internal/poll/fd_poll_runtime.go):

type pollDesc struct {

runtimeCtx uintptr // 指向底层 pollDesc 实例

}

底层 pollDesc (runtime/netpoll.go):

type pollDesc struct {

link *pollDesc // 链表指针,用于 pollCache

fd uintptr // 关联的文件描述符

// 核心:读写事件状态标识器

rg atomic.Uintptr // 读事件状态标识器

wg atomic.Uintptr // 写事件状态标识器

// 其他字段...

}

状态标识器的设计精髓:

rg 和 wg 可以存储以下几种状态:

0:无内容pdReady(1):IO 操作已就绪pdWait(2):goroutine 阻塞等待 IO 就绪g 指针:具体阻塞等待的 goroutine 实例

这种设计实现了状态与数据的统一存储,非常巧妙。

4.2 pollCache 缓冲池设计

为了避免频繁的内存分配,Go 设计了 pollCache 缓冲池,其结构如下图所示:

💡 图片说明:此图展示了 pollCache 的内部结构,包括互斥锁、链表头指针以及通过 link 字段连接的 pollDesc 链表,体现了 Go 在内存管理上的精心设计。

从图中可以看到 pollCache 的核心组件:

- pollCache:缓冲池主体,包含互斥锁和链表头指针

- pollDesc 链表:通过

link字段连接的单向链表 - pollDesc 结构:每个节点包含 fd、rg/wg 状态标识器等关键字段

type pollCache struct {

lock mutex // 并发安全锁

first *pollDesc // 单向链表头节点

}

type pollDesc struct {

link *pollDesc // 指向 cache 中相邻的 pollDesc

fd uintptr // 关联的 fd 句柄

rg atomic.Uintptr // 读事件状态标识器

wg atomic.Uintptr // 写事件状态标识器

}

// 分配 pollDesc

func (c *pollCache) alloc() *pollDesc {

lock(&c.lock)

if c.first == nil {

// 批量分配,一次分配多个 pollDesc

const pdSize = unsafe.Sizeof(pollDesc{})

n := pollBlockSize / pdSize

mem := persistentalloc(n*pdSize, 0, &memstats.other_sys)

// 构建链表

for i := uintptr(0); i < n; i++ {

pd := (*pollDesc)(add(mem, i*pdSize))

pd.link = c.first

c.first = pd

}

}

pd := c.first

c.first = pd.link

unlock(&c.lock)

return pd

}

// 回收 pollDesc

func (c *pollCache) free(pd *pollDesc) {

lock(&c.lock)

pd.link = c.first

c.first = pd

unlock(&c.lock)

}

设计亮点:

- 批量分配:减少系统调用开销,提升分配效率

- 单向链表:实现简单高效的对象池,O(1) 时间复杂度

- 非 GC 内存:使用

persistentalloc分配非 GC 内存,避免 GC 压力 - 线程安全:通过互斥锁保证并发安全

5. 关键流程源码走读

5.1 poll_init 流程

调用链:

net.Listen -> ... -> poll.FD.Init -> poll.pollDesc.init

-> poll.runtime_pollServerInit -> runtime.poll_runtime_pollServerInit

-> runtime.netpollinit -> runtime.epollcreate1

核心实现:

var serverInit sync.Once

func (pd *pollDesc) init(fd *FD) error {

// 全局只执行一次 epoll 事件表初始化

serverInit.Do(runtime_pollServerInit)

// ...

}

func netpollinit() {

// 创建 epoll 实例

epfd = epollcreate1(_EPOLL_CLOEXEC)

// 创建 pipe 管道用于信号处理

r, w, errno := nonblockingPipe()

// 将 pipe 读端注册到 epoll 事件表

ev := epollevent{

events: _EPOLLIN,

}

*(**uintptr)(unsafe.Pointer(&ev.data)) = &netpollBreakRd

errno = epollctl(epfd, _EPOLL_CTL_ADD, r, &ev)

// 缓存 pipe 读写端

netpollBreakRd = uintptr(r)

netpollBreakWr = uintptr(w)

}

设计细节:

- 使用

sync.Once确保全局只初始化一次 - 创建 pipe 管道用于程序终止等信号处理

- 将 pipe 读端也注册到 epoll 中

5.2 poll_open 流程

调用链:

net.Listen/Accept -> ... -> poll.pollDesc.init -> poll.runtime_pollOpen

-> runtime.poll_runtime_pollOpen -> runtime.netpollopen

核心实现:

func poll_runtime_pollOpen(fd uintptr) (*pollDesc, int) {

// 从 pollCache 分配 pollDesc

pd := pollcache.alloc()

lock(&pd.lock)

// 关联文件描述符

pd.fd = fd

// 初始化状态标识器

pd.rg.Store(0)

pd.wg.Store(0)

unlock(&pd.lock)

// 注册到 epoll 事件表

errno := netpollopen(fd, pd)

return pd, 0

}

func netpollopen(fd uintptr, pd *pollDesc) int32 {

var ev epollevent

// 同时监听读写事件,使用边缘触发模式

ev.events = _EPOLLIN | _EPOLLOUT | _EPOLLRDHUP | _EPOLLET

*(**pollDesc)(unsafe.Pointer(&ev.data)) = pd

return -epollctl(epfd, _EPOLL_CTL_ADD, int32(fd), &ev)

}

关键设计:

- 同时注册读写事件,后续通过

rg/wg区分具体关心的事件类型 - 使用边缘触发(ET)模式提升性能

- 将

pollDesc指针存储在epoll_event.data中

5.3 poll_wait 流程

调用链:

conn.Read/Write -> ... -> poll.pollDesc.wait -> poll.runtime_pollWait

-> runtime.poll_runtime_pollWait -> runtime.netpollblock -> runtime.gopark

核心实现:

func netpollblock(pd *pollDesc, mode int32, waitio bool) bool {

// 根据模式选择状态标识器

gpp := &pd.rg

if mode == 'w' {

gpp = &pd.wg

}

// 自旋检查状态

for {

// IO 已就绪,直接返回

if gpp.CompareAndSwap(pdReady, 0) {

return true

}

// IO 未就绪,设置等待状态并跳出循环

if gpp.CompareAndSwap(0, pdWait) {

break

}

}

// gopark 阻塞当前 goroutine

gopark(netpollblockcommit, unsafe.Pointer(gpp),

waitReasonIOWait, traceEvGoBlockNet, 5)

// 被唤醒后检查唤醒原因

old := gpp.Swap(0)

return old == pdReady

}

// gopark 的提交函数

func netpollblockcommit(gp *g, gpp unsafe.Pointer) bool {

// 将状态标识器从 pdWait 改为当前 goroutine 指针

r := atomic.Casuintptr((*uintptr)(gpp), pdWait,

uintptr(unsafe.Pointer(gp)))

if r {

atomic.Xadd(&netpollWaiters, 1)

}

return r

}

精妙的设计:

- 使用 CAS 操作保证并发安全

gopark+netpollblockcommit的两阶段提交确保原子性- 同一个 fd 的同种事件类型,同时只能有一个 goroutine 等待

5.4 netpoll 流程

调用链:

runtime.schedule -> runtime.findrunnable -> runtime.netpoll

-> runtime.netpollready -> runtime.netpollunblock

核心实现:

func netpoll(delay int64) gList {

// 根据 delay 决定 epoll_wait 模式

var waitms int32

if delay < 0 {

waitms = -1 // 阻塞模式

} else if delay == 0 {

waitms = 0 // 非阻塞模式

} else {

waitms = int32(delay / 1e6) // 超时模式

}

// 一次最多处理 128 个事件

var events [128]epollevent

n := epollwait(epfd, &events[0], int32(len(events)), waitms)

var toRun gList

for i := int32(0); i < n; i++ {

ev := &events[i]

// 根据事件类型确定模式

var mode int32

if ev.events&(_EPOLLIN|_EPOLLRDHUP|_EPOLLHUP|_EPOLLERR) != 0 {

mode += 'r'

}

if ev.events&(_EPOLLOUT|_EPOLLHUP|_EPOLLERR) != 0 {

mode += 'w'

}

if mode != 0 {

// 获取对应的 pollDesc

pd := *(**pollDesc)(unsafe.Pointer(&ev.data))

// 唤醒等待的 goroutine

netpollready(&toRun, pd, mode)

}

}

return toRun

}

func netpollunblock(pd *pollDesc, mode int32, ioready bool) *g {

// 选择对应的状态标识器

gpp := &pd.rg

if mode == 'w' {

gpp = &pd.wg

}

for {

old := gpp.Load()

if old == 0 {

return nil

}

var new uintptr

if ioready {

new = pdReady

}

// CAS 更新状态并返回需要唤醒的 goroutine

if gpp.CompareAndSwap(old, new) {

if old == pdReady || old == pdWait {

return nil

}

return (*g)(unsafe.Pointer(old))

}

}

}

关键点:

- 支持三种

epoll_wait模式:非阻塞、阻塞、超时 - 批量处理就绪事件,最多一次处理 128 个

- 精确识别读写事件类型并唤醒对应的 goroutine

6. netpoll 与 GMP 调度器的深度集成

6.1 netpoll 的触发时机

原文详细分析了 netpoll 在 GMP 调度系统中的四个触发时机:

1)GMP 常规调度流程

在 runtime.findrunnable 中,P 寻找可运行 goroutine 的优先级顺序:

func findRunnable() (gp *g, inheritTime, tryWakeP bool) {

// 1. 每调度 61 次,处理一次全局队列(防止饥饿)

// 2. 尝试从本地队列获取 g

// 3. 尝试从全局队列获取 g

// 4. 【非阻塞模式】netpoll 流程

if netpollinited() && atomic.Load(&netpollWaiters) > 0 &&

atomic.Load64(&sched.lastpoll) != 0 {

if list := netpoll(0); !list.empty() {

gp := list.pop()

injectglist(&list) // 其余 g 加入全局队列

casgstatus(gp, _Gwaiting, _Grunnable)

return gp, false, false

}

}

// 5. 从其他 P 窃取 g

// 6. 协助 GC

// 7. 【阻塞/超时模式】netpoll 流程(全局仅一个 P)

if netpollinited() && (atomic.Load(&netpollWaiters) > 0 || pollUntil != 0) &&

atomic.Xchg64(&sched.lastpoll, 0) != 0 {

delay := int64(-1) // 默认阻塞

if pollUntil != 0 {

delay = pollUntil - now // 有定时器时使用超时

}

list := netpoll(delay)

// 处理返回的 goroutine 列表...

}

}

2)GC 并发标记流程

为避免 GC 期间 IO 事件处理延迟:

func gcDrain(gcw *gcWork, flags gcDrainFlags) {

idle := flags&gcDrainIdle != 0

var check func() bool

if idle {

check = pollWork // 空闲模式下检查网络事件

}

for /* GC 标记循环 */ {

// GC 标记工作...

if check != nil && check() {

break // 发现有网络事件需要处理

}

}

}

func pollWork() bool {

if netpollinited() && atomic.Load(&netpollWaiters) > 0 &&

sched.lastpoll != 0 {

if list := netpoll(0); !list.empty() {

injectglist(&list)

return true

}

}

return false

}

3)STW 后的 Start The World

func startTheWorldWithSema(emitTraceEvent bool) int64 {

assertWorldStopped()

// STW 结束后立即检查网络事件

if netpollinited() {

list := netpoll(0) // 非阻塞

injectglist(&list)

}

// 启动所有 P...

}

4)sysmon 监控线程

func sysmon() {

for {

// 每 10ms 检查一次网络事件

lastpoll := int64(atomic.Load64(&sched.lastpoll))

if netpollinited() && lastpoll != 0 &&

lastpoll+10*1000*1000 < now {

list := netpoll(0) // 非阻塞

if !list.empty() {

injectglist(&list)

}

}

}

}

6.2 智能的负载均衡机制

全局 netpoll 留守策略:

当多个 P 都空闲时,Go 采用了精妙的负载均衡策略:

- 保证响应性:至少有一个 P 以阻塞/超时模式执行 netpoll,确保 IO 事件及时响应

- 节约资源:其他空闲 P 进入 idle 状态,避免无效轮询

- 动态调整:根据系统负载和定时器状态动态选择 netpoll 模式

设计精髓:

- 用最少的资源保证最大的响应性

- 避免"惊群效应"(多个线程同时被唤醒)

- 与 Go 的整体调度哲学保持一致

💡 深度思考与学习心得

7. 设计哲学的体现

7.1 抽象层次的艺术

Go netpoll 的设计体现了优秀的抽象层次:

| 层次 | 职责 | 用户感知 |

|---|---|---|

| 用户层 | 业务逻辑 | 同步阻塞式编程 |

| Go runtime 层 | netpoll 框架 | 完全透明 |

| 系统调用层 | epoll 机制 | 完全透明 |

| 内核层 | 事件驱动 | 完全透明 |

关键洞察:

最好的抽象是让复杂性消失,而不是转移。

Go netpoll 让开发者可以用最简单的同步方式编写高性能的异步网络程序,这种抽象的价值是巨大的。

7.2 工程权衡的智慧

1)性能 vs 易用性

- ✅ 选择:易用性优先,性能通过底层优化保证

- 💡 体现:同步式 API + 异步式实现

2)通用性 vs 特化

- ✅ 选择:在通用框架基础上允许特化优化

- 💡 体现:标准 net 包 + 第三方高性能库(如字节的 Netpoll)

3)复杂性 vs 可维护性

- ✅ 选择:将复杂性封装在 runtime 层

- 💡 体现:用户代码简单,runtime 代码复杂但集中

7.3 与其他语言的对比思考

Go vs C++:

- C++: 开发者需要手动管理 epoll、线程池、状态机

- Go: runtime 自动处理,开发者专注业务逻辑

Go vs Node.js:

- Node.js: 回调地狱,异步编程心智负担重

- Go: 同步式编程,心智负担轻

Go vs Java NIO:

- Java NIO: 复杂的 Selector、Channel 概念

- Go: 对用户完全透明

8. 技术演进的启示

8.1 从第一性原理出发

原文作者从餐厅服务员的例子开始,一步步推演出 IO 多路复用的必要性,这种从第一性原理出发的思考方式值得学习:

- 识别核心问题:资源利用率低

- 分析根本原因:一对一服务模式的局限

- 探索解决方案:一对多服务模式

- 发现新问题:无效轮询的开销

- 找到最优解:事件驱动的通知机制

8.2 技术选型的思辨

为什么 epoll 选择红黑树而非哈希表?

这个看似简单的问题背后体现了深层的工程思维:

- 不能只看时间复杂度,还要看常数系数

- 不能只看单一指标,还要看综合性能

- 不能只看理论分析,还要考虑实际场景

8.3 系统设计的全局观

Go netpoll 不是孤立的组件,而是与整个 Go runtime 深度集成:

- 与 GMP 调度器无缝协作

- 与 GC 系统协调工作

- 与内存管理系统配合

- 与监控系统集成

这种全局观的系统设计思维值得深入学习。

📋 总结与展望

9. 核心收获

通过这次深度学习,我获得了以下核心认知:

9.1 技术层面

- 理论基础:深入理解了 IO 多路复用从理论到实践的完整演进过程

- 实现细节:掌握了 epoll 机制的核心原理和 Go netpoll 的精妙实现

- 系统集成:理解了 netpoll 与 GMP 调度器的深度集成机制

- 性能优化:学会了从系统层面思考网络编程的性能优化

9.2 设计思维

- 抽象艺术:学会了如何设计优雅的抽象层次

- 权衡智慧:理解了工程实践中的各种权衡考量

- 系统观念:培养了全局性的系统设计思维

- 演进思考:掌握了从第一性原理推演技术方案的方法

9.3 实践指导

- 开发实践:更好地理解 Go 网络编程的最佳实践

- 性能调优:具备了系统级网络性能问题的诊断能力

- 架构设计:能够做出更合理的技术选型和架构决策

10. 后续学习方向

基于这次学习,我计划在以下方向继续深入:

- GMP 调度器深入研究:全面理解 Go 的并发调度机制

- 内存管理系统:学习 Go 的 GC 和内存分配策略

- 高性能网络库实践:研究字节跳动 Netpoll 等高性能实现

- 跨语言对比学习:对比 C++、Rust 等语言的网络编程模型

11. 致谢与思考

感谢原文作者的精彩分析,这种从理论基础到源码实现的深度技术文章为我们提供了宝贵的学习资源。

正如作者所说,通过不同语言生态间的横向对比,我们能够对技术方案的策略取舍产生更加立体的认知。这种学习方法值得我们持续实践。

最后的思考:

技术的本质是解决问题,而优秀的技术是让复杂的问题变得简单。Go netpoll 正是这样一个优秀技术的典型代表。

本文基于《万字解析 golang netpoll 底层原理》的深度学习记录,结合个人理解和技术思考整理而成。通过这次学习,不仅掌握了 Go netpoll 的技术细节,更重要的是学会了系统性的技术分析方法和工程思维。

浙公网安备 33010602011771号

浙公网安备 33010602011771号