数据处理与任务调度的双引擎:ETL工具PDI与DPDI调度管理工具的全面剖析

ETL工具PDI及调度DPDI

ETL流程解析

数据抽取(Extract)

抽取是ETL的起点,需连接多种数据源获取原始数据。如从关系型数据库提取销售记录,或从文本文件读取客户信息,为后续处理奠定基础。

抽取过程面临数据源多样性、数据量大等挑战。例如,需从多个异构数据库抽取数据时,要解决数据格式不统一、连接性能等问题,确保数据准确、高效地被抽取出来。

数据转换(Transform)

转换是ETL的核心,涉及数据清洗、整合、计算等操作。如数据清洗时去除重复记录、修正错误数据;数据整合时将不同数据源的数据合并;数据计算时根据销售额和折扣率计算最终销售金额等。

转换过程需依据业务规则设计。在金融领域,要对交易数据进行风险评估转换,计算风险等级;在电商领域,要将商品信息和订单信息关联,生成完整的销售数据。

数据加载(Load)

加载是将转换后的数据导入目标系统的过程,如数据仓库、数据库或文件系统等。需考虑数据的一致性、完整性和性能问题。

如在数据仓库中加载时,要确保数据按照既定的维度模型和事实表结构存储,以便后续分析和查询;同时,要处理数据冲突、覆盖等问题,保证数据的准确性和完整性。

主流ETL工具概览

Kettle(PDI)

Kettle,也称为PDI,是一个开源的ETL工具。它通过Spoon设计器来设计转换(Transformation)和作业(Job),转换主要针对数据处理,作业定义整个ETL流程。

Kettle具有丰富的组件和功能,适用于各种数据处理场景。例如,使用Table Input组件从数据库读取数据,通过Filter Rows组件筛选特定条件的数据,最后用Table Output组件将结果写入目标表。

Informatica PowerCenter

Informatica PowerCenter是另一款主流的ETL工具,以其强大的数据处理能力和丰富的功能模块著称。适用于大型企业复杂的ETL场景。

它提供了高度可扩展的架构和先进的数据集成技术,能够处理大规模数据,支持多种数据源和目标系统的连接,实现高效的数据抽取、转换和加载。

IBM Datastage

IBM Datastage是IBM公司推出的ETL工具,以其高性能和稳定性受到许多大型企业的青睐。适用于处理大规模数据的ETL任务。

Datastage提供了强大的数据处理功能和丰富的组件库,支持多种数据源和目标系统的连接,能够实现复杂的数据转换和加载操作,满足企业对数据集成的严格要求。

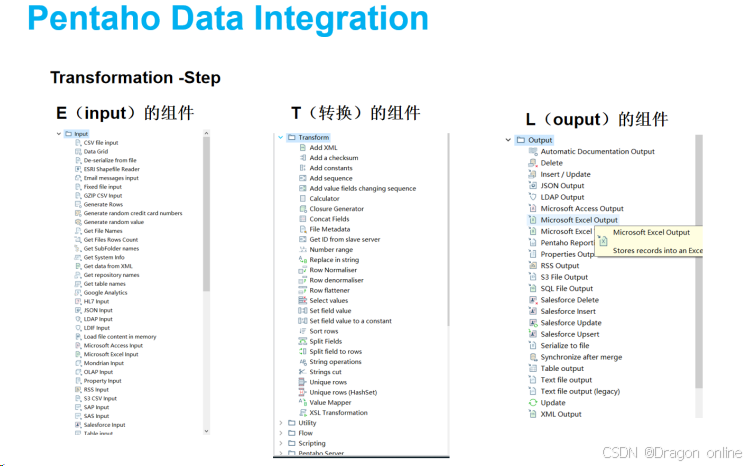

PDI功能模块

转换(Transformation)模块

转换模块是PDI中实现数据处理的核心单元,一个转换可以包含多个步骤(Step),每个步骤代表一个独立的数据处理操作。

例如,在一个销售数据分析的转换中,可能包含以下步骤:使用Table Input从销售数据库读取数据,通过Filter Rows筛选出销售额大于一定值的记录,接着用Group By对数据进行分组汇总,最后用Table Output将结果写入分析数据库。

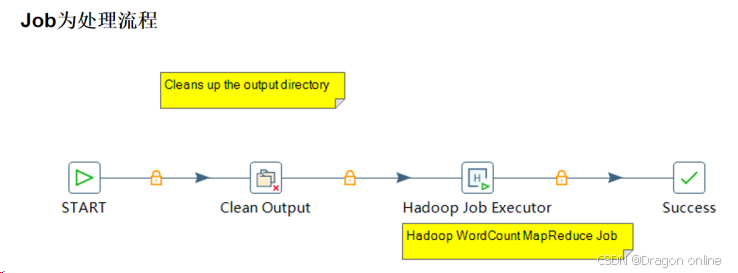

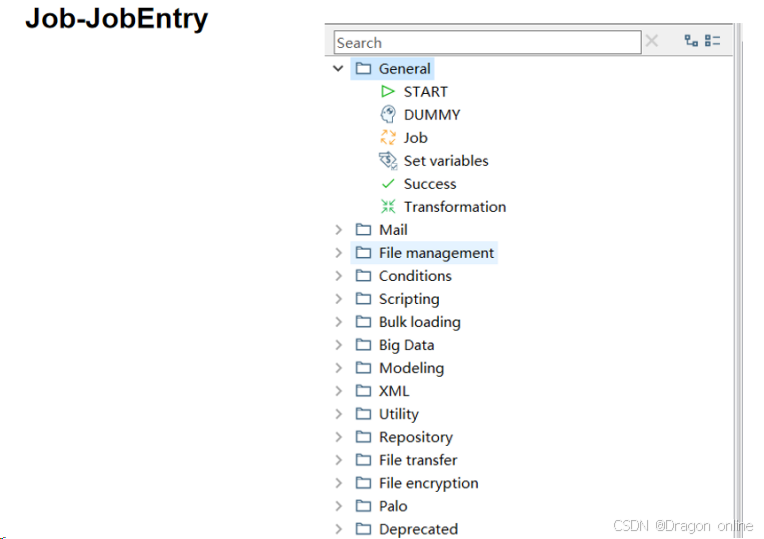

作业(Job)模块

作业模块用于定义整个ETL处理流程,Job为处理流程,Job 中的组件称之为 Job Entry,一个Job流程包含多个作业项(Job Entry),每个作业项代表一个独立的任务,如执行一个转换、发送邮件通知等。

例如,在一个数据备份作业中

浙公网安备 33010602011771号

浙公网安备 33010602011771号