摘要:

### 对于牛顿法的理解,从泰勒展开入手 为什么牛顿法在学习率选取适当的时候,优化效率会优于梯度下降:

评论(0)

推荐(0)

摘要:

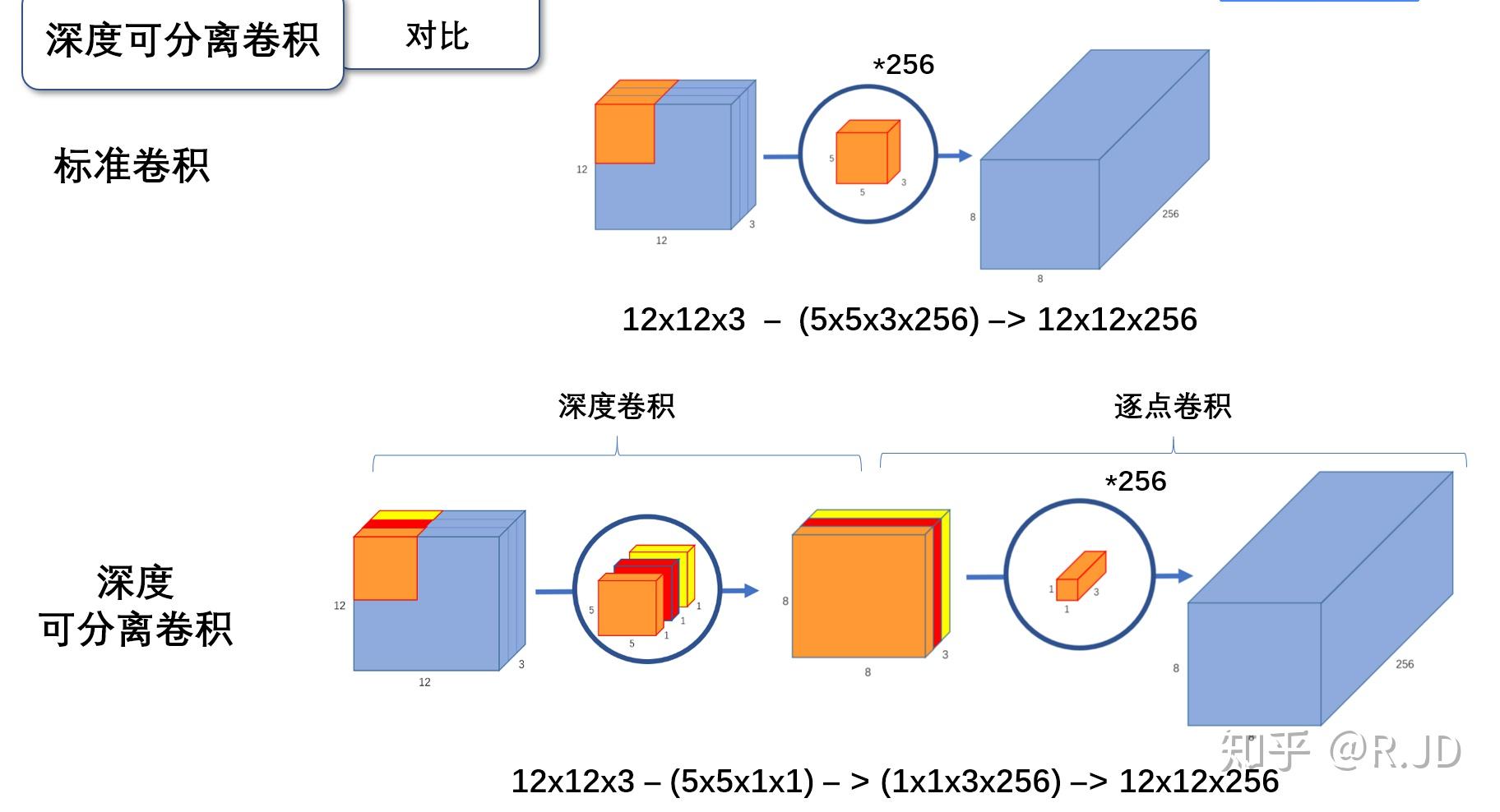

### V1 可分离卷积(深度卷积depthwise+逐点卷积pointwise)  最主要就是为了减少参数量,而且准确率差得不多

评论(0)

推荐(0)

摘要:

作者:刘佳恒 转载: [(99+ 封私信 / 80 条消息) 2022 年,计算机视觉领域有哪些推荐的研究方向? - 知乎 (zhihu.com)](https://www.zhihu.com/question/496500060) 目前想到的有如下方向,排名不分先后,欢迎大家讨论。 1. 自监督: 阅读全文

posted @ 2023-06-08 21:30

tourbillon007

阅读(59)

评论(0)

推荐(0)

摘要:

#### 对于adagrad的理解 [“随机梯度下降、牛顿法、动量法、Nesterov、AdaGrad、RMSprop、Adam”,打包理解对梯度下降法的优化_哔哩哔哩_bilibili](https://www.bilibili.com/video/BV1r64y1s7fU/?spm_id_fro 阅读全文

posted @ 2023-06-08 21:28

tourbillon007

阅读(197)

评论(0)

推荐(0)

浙公网安备 33010602011771号

浙公网安备 33010602011771号