1 搭建K8s环境平台规划

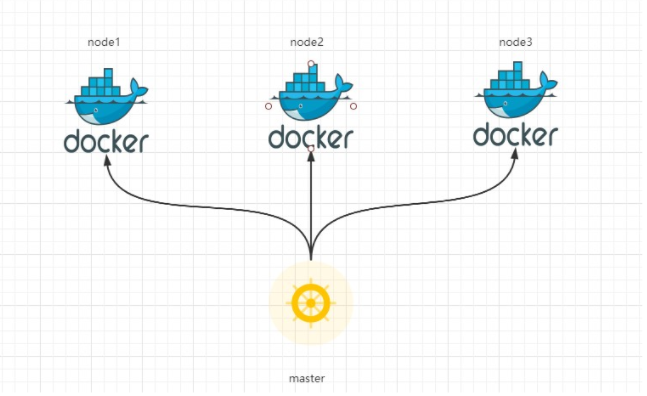

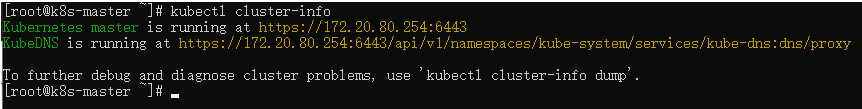

1.1 单master集群

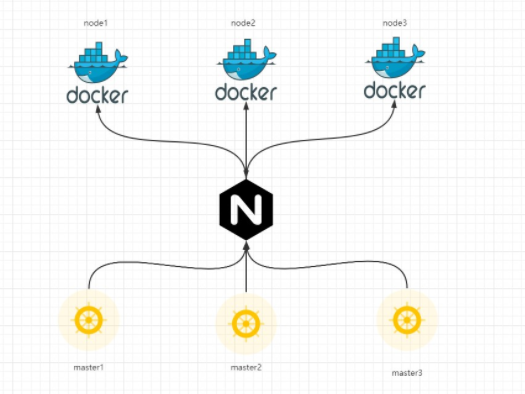

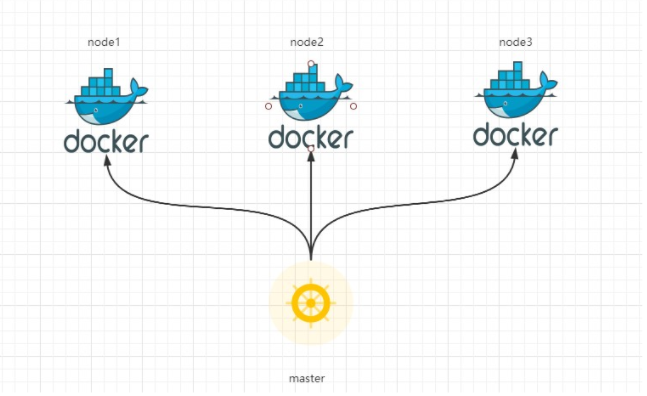

1.2 多master集群

2 服务器硬件配置要求

在开始部署k8s集群之前,服务器需要满足以下条件:

- 一台或多台服务器,操作系统CentOS 7.x-86_x64;

- 硬盘配置:内存2GB或更多,CPU2核或更多,硬盘30GB或更多;

- 集群中的所有机器之间网络互通;

- 可以访问外网,需要拉取镜像;

- 禁止swap分区。

3 搭建k8s集群部署方式

目前生产部署k8s集群主要有两种方式:

- kubeadm(新手推荐,本文采用kubeadm)

- 二级制包

- 从GitHub下载发行版的二进制包,手动部署每个组件,组成k8s集群。

kubeadm降低部署门槛,但是屏蔽了很多细节,遇到问题很难排查,如果想要更容易可控,推荐使用二级制包部署k8s集群,虽然手动部署麻烦点,期间可以学习很多工作原理,也有利于后期维护。

4 采用“kubeadm”搭建k8s集群

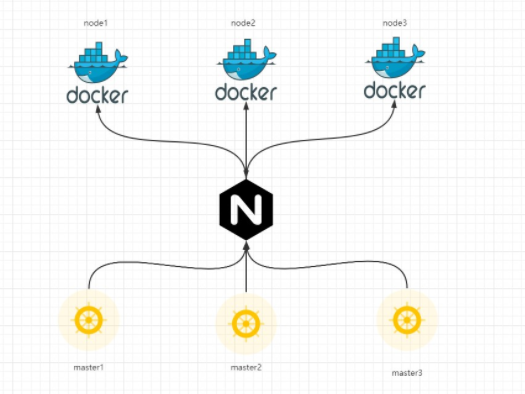

4.1 概述

kubeadm是官方社区推出的一个用于快速部署k8s集群的工具,这个工具能通过两个命令快速搭建master环境和加入master集群。

4.2 准备环境

4.3 系统初始化

4.3.0 先他妈yum update一下,别问为什么,问就是坑

4.3.1 关闭防火墙(所有节点)

systemctl disable firewalld

|

4.3.2 关闭selinux(所有节点)

sed -i 's/enforcing/disabled/' /etc/selinux/config

|

4.3.3 关闭swap分区(所有节点)

sed -ri 's/.*swap.*/#&/' /etc/fstab

|

4.3.4 配置主机名(所有节点)

hostnamectl set-hostname <hostname>

|

hostnamectl set-hostname k8s-master

|

hostnamectl set-hostname k8s-node1

|

hostnamectl set-hostname k8s-node2

|

4.3.5 配置hosts文件(所有节点)

cat >> /etc/hosts << EOF

172.20.80.254 k8s-master

172.20.161.245 k8s-node1

172.20.165.125 k8s-node2

EOF

|

4.3.6 将桥接的IPv4流量传递到iptables的链(所有节点)

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.ip_forward = 1

EOF

|

lsmod | grep br_netfilter

|

4.3.7 配置时间同步(所有节点)

4.3.8 开启ipvs(所有节点)

yum -y install ipset ipvsadm

|

cat > /etc/sysconfig/modules/ipvs.modules <<EOF

#!/bin/bash

modprobe -- ip_vs

modprobe -- ip_vs_rr

modprobe -- ip_vs_wrr

modprobe -- ip_vs_sh

modprobe -- nf_conntrack_ipv4

EOF

|

chmod 755 /etc/sysconfig/modules/ipvs.modules && bash /etc/sysconfig/modules/ipvs.modules && lsmod | grep -e ip_vs -e nf_conntrack_ipv4

|

lsmod | grep -e ipvs -e nf_conntrack_ipv4

|

4.4 所有节点安装Docker/kubeadm/kubelet/kubectl

4.4.1 概述

- k8s默认CRI(容器运行时)为Docker,因此需要先安装Docker。

4.4.2 安装Docker

wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O /etc/yum.repos.d/docker-ce.repo

|

yum -y install docker-ce-18.06.3.ce-3.el7

|

systemctl enable docker && systemctl start docker

|

- 设置Docker镜像加速器,同时指定docker的cgroupdriver为systemd,这个systemd很重要,docker和k8s的cgroup driver必须一致,否则无法安装

sudo mkdir -p /etc/docker

|

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"exec-opts": ["native.cgroupdriver=systemd"],

}

EOF

|

sudo systemctl daemon-reload

|

sudo systemctl restart docker

|

4.4.3 添加阿里云的YUM软件源 (如果k8s的源无法外网访问,请移步到:当服务器无法连接外网时如何处理 中的下载k8s源 步骤)

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

|

4.4.4 安装kubeadm、kubelet和kubectl

yum install -y kubelet-1.18.0 kubeadm-1.18.0 kubectl-1.18.0

|

- 为了实现Docker使用的cgroup driver和kubelet使用的cgroup drver一致,建议修改"/etc/sysconfig/kubelet"文件的内容:

vim /etc/sysconfig/kubelet

|

KUBELET_EXTRA_ARGS="--cgroup-driver=systemd"

|

- 设置为开机自启动即可,由于没有生成配置文件,集群初始化后自动启动:

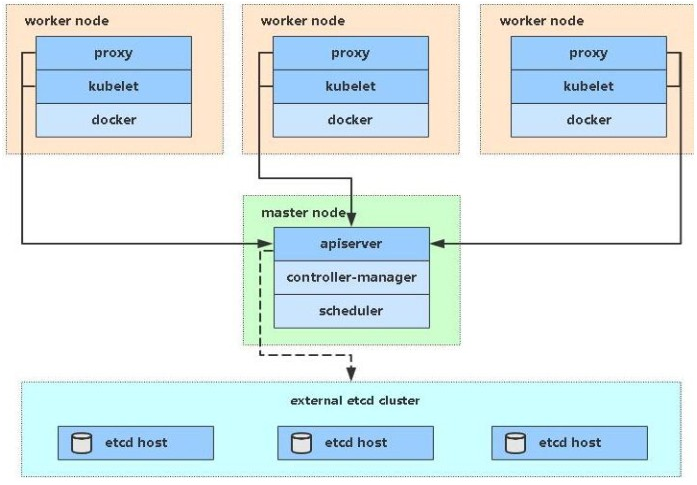

4.5 部署k8s的Master节点

- 部署k8s的Master节点(172.20.80.254):

kubeadm init \

--apiserver-advertise-address=172.20.80.254 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.18.0 \

--service-cidr=10.96.0.0/12 \

--pod-network-cidr=10.244.0.0/16

|

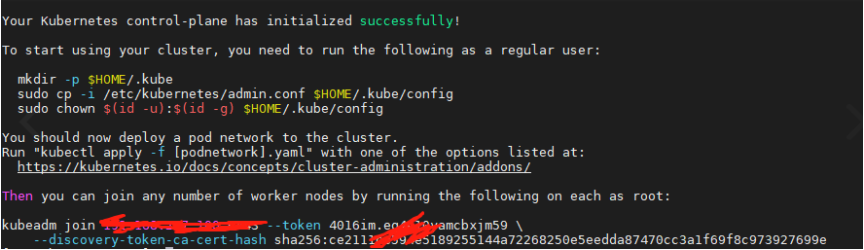

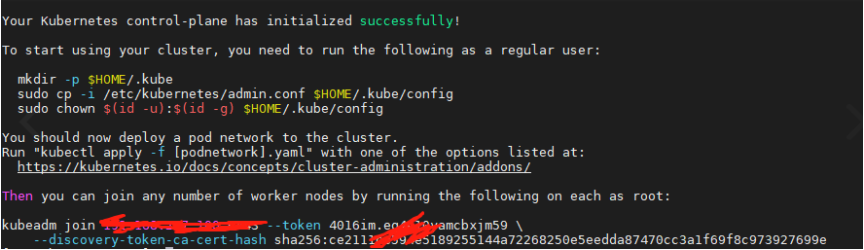

- 请将图中 kubeadm join.... 这两行话拷贝下来,后面node加入集群时要用

- 根据提示信息,在Master节点上使用kubectl工具:

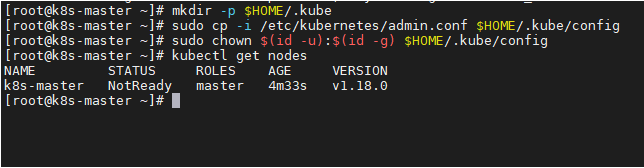

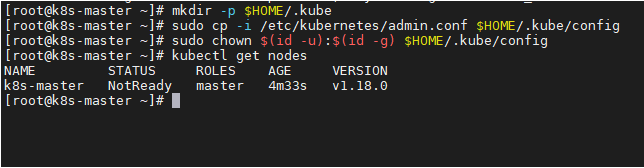

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

|

4.6 添加k8s的Node节点

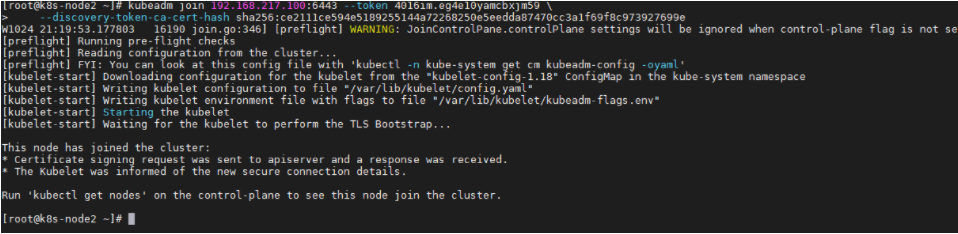

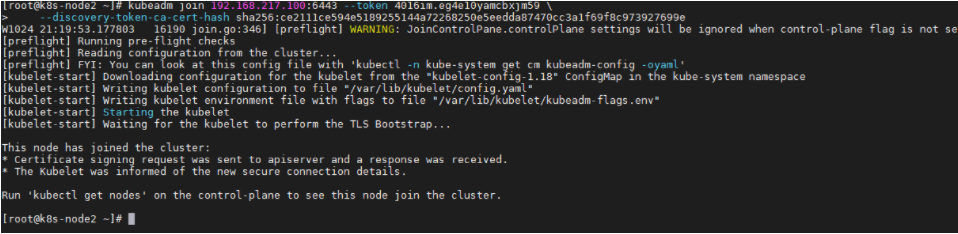

- 在172.20.161.245(k8s-node1)和172.20.165.125上添加如下的命令(该命令为上一步拷贝下来的命令)

kubeadm join 172.20.80.254:6443 --token 4016im.eg4e10yamcbxjm59 \

--discovery-token-ca-cert-hash sha256:ce2111ce594e5189255144a72268250e5eedda87470cc3a1f69f8c973927699e

|

- 默认的token有效期为24小时,当过期之后,该token就不能用了,这时可以使用如下命令创建token:

kubeadm token create --print-join-command

|

kubeadm token create --ttl 0

|

4.6.1 番外篇之删除节点(非必须勿用)

注意:以下操作都是在master下操作。

- 先将节点设置为维护模式(k8s-node1是节点名称)

kubectl drain k8s-node1 --delete-local-data --force --ignore-daemonsets node/k8s-node1

|

kubectl delete node k8s-node1

|

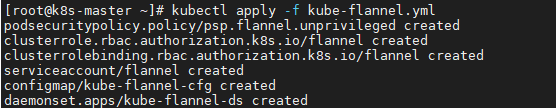

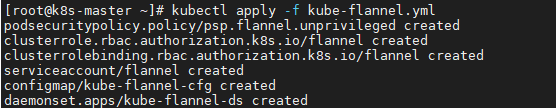

4.7 部署CNI网络插件

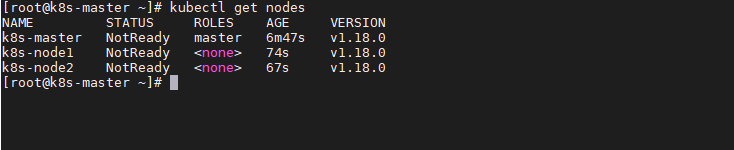

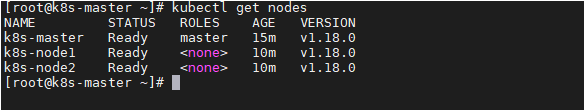

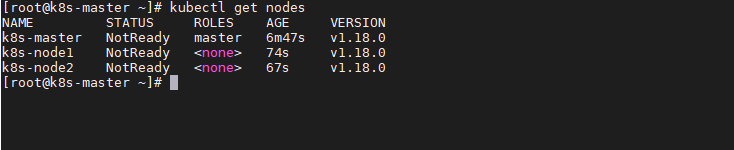

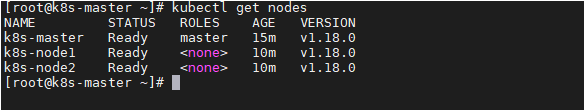

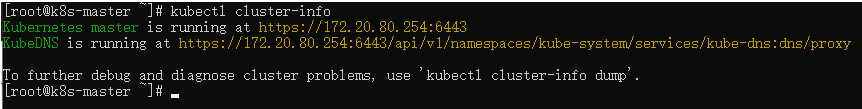

- 根据提示,在Master节点使用kubectl工具查看节点状态:

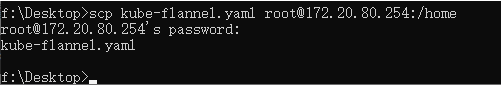

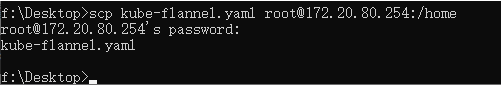

- 在Master节点部署CNI网络插件(可能会失败,如果失败,请下载到本地,然后安装,如果wget也不行,请将网址拷贝到你自己的电脑上下载,下载完毕后将yml文件再传到服务器上,可以使用scp命令(见下图中的scp命令使用)

wget https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

|

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

|

备注:此图只用于本地上传kube-flannel.yaml文件

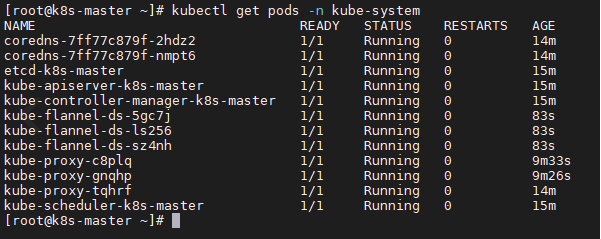

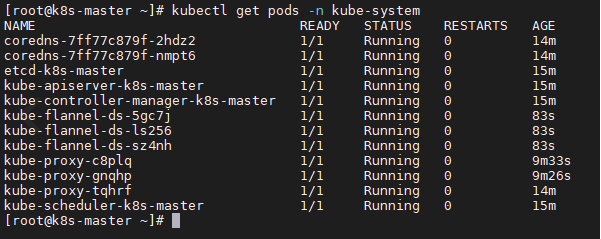

kubectl get pods -n kube-system

|

- 再次在Master节点使用kubectl工具查看节点状态:

参考资料:https://www.cnblogs.com/xuweiweiwoaini/p/13884112.html

浙公网安备 33010602011771号

浙公网安备 33010602011771号