数学是基础学科,学好了,还需要传承和与时俱进,去开发去解决未解之谜,数学为很多行业赋能;基础科学研究是人类科学探索和技术创新的源泉,虽然它的直接应用不一定立竿见影,但它为整个社会的进步和技术的突破提供了坚实的理论基础和源源不断的知识支持。因此,基础科学研究不仅对科学领域本身至关重要,也对经济发展、社会进步以及应对全球挑战具有深远的意义。

线程并发工作时的全局变量数据一致性问题,并不是纯粹的数学基础原理问题,而是计算机科学中的并发编程和操作系统领域的实际问题。它涉及到计算机操作系统中进程和线程的调度、内存模型、数据同步等复杂机制。

数学基础原理在这个问题中起到的作用是为解决一致性问题提供理论支持和算法模型。例如:

逻辑代数:在并发编程中,逻辑代数的原理可以用来分析和设计并发控制算法,确保数据的一致性。

组合数学:在分布式系统中,组合数学可以帮助我们理解系统中不同组件的组合方式,以及这些组合对全局变量可能产生的影响。

离散数学:离散数学中的概念,如集合论、图论等,可以用来建模和分析并发系统中的各种状态和状态转换。

算法理论:算法理论中的排序算法、搜索算法等,可以用来设计高效的数据一致性维护策略。

然而,解决线程并发工作下的全局变量数据一致性问题,通常还需要依赖于具体的编程语言和操作系统的特性,比如使用锁(Locks)、原子操作(Atomic Operations)、信号量(Semaphores)、消息队列(Message Queues)等同步机制。

在实际开发中,确保全局变量的一致性通常需要程序员具备扎实的计算机科学理论基础、操作系统知识以及并发编程能力。此外,还需要遵循良好的编程实践,比如使用线程安全的数据结构、避免竞态条件、合理设计同步机制等。

全局变量数据一致性问题在计算机科学中的并发编程和操作系统领域是一个非常重要的问题。这个问题涉及到以下几个方面:

进程和线程的调度:操作系统中的进程和线程调度器负责决定哪个任务应该在哪个处理器上执行。当多个线程尝试同时访问和修改全局变量时,调度器必须确保这些操作能够正确地同步,以维护数据的一致性。

内存模型:计算机内存模型定义了程序中不同线程之间的内存可见性和数据同步规则。不同的内存模型(如C++11的内存模型)提供了不同的保证,以帮助开发者确保数据的一致性。

数据同步:在并发编程中,数据同步机制如互斥锁(mutexes)、读写锁(read-write locks)、信号量(semaphores)和条件变量(condition variables)等,用于保护共享资源,防止多个线程同时修改全局变量,从而导致数据不一致。

原子操作:原子操作是一种不可分割的操作,它在执行过程中不会被其他线程中断。在处理全局变量时,原子操作可以用来保证某些关键操作的一致性。

竞态条件:竞态条件是指两个或多个线程因为执行顺序的不确定性而导致的结果不确定情况。避免竞态条件是确保全局变量一致性的关键。

死锁:死锁是指两个或多个线程永久地等待对方释放资源而无法继续执行的情况。在设计并发程序时,需要避免死锁,以确保系统能够继续运行。

活锁:活锁是指线程虽然没有被阻塞,但是也无法进行有效的进展,这与死锁不同,活锁中的线程是活跃的,但是在某种条件下无法继续执行。

为了解决这些问题,并发编程和操作系统领域的专家们提出了许多理论和实践的解决方案。在实际应用中,选择合适的同步机制和设计正确的程序结构是确保全局变量数据一致性的关键。此外,对并发程序进行彻底的测试,包括寻找和修复潜在的竞态条件,也是确保数据一致性的重要步骤。

同步机制和正确的程序结构是确保全局变量数据一致性的关键。下面详细解释这两个方面:

同步机制

同步机制是协调多个线程访问共享资源的一致性的技术手段。在并发编程中,同步机制可以防止多个线程同时修改同一数据,从而避免数据不一致的问题。常见的同步机制包括:

互斥锁(Mutexes):确保同一时间只有一个线程可以访问共享资源。

读写锁(Read-Write Locks):允许多个读操作同时进行,但在写操作时会阻塞其他所有读写操作。

条件变量(Condition Variables):允许线程在某些条件下挂起,直到满足特定条件才被唤醒。

信号量(Semaphores):一个整数变量的封装,可以用来控制对共享资源的访问数量。

原子操作(Atomic Operations):在操作过程中不会被其他线程中断的基本操作,如原子加法、原子比较交换等。

程序结构

程序结构是指并发程序的组织方式,包括线程的创建、执行顺序、以及它们如何交互。正确的程序结构可以帮助避免竞态条件和其他并发问题。以下是一些设计并发程序时考虑的因素:

最小化共享资源:尽量减少需要同步的共享资源,以降低复杂性。

限制共享资源的访问:通过设计良好的API和使用同步机制,限制对共享资源的访问。

使用线程局部存储(Thread-Local Storage, TLS):对于每个线程独立的数据,可以使用TLS避免共享。

合理的任务分解:将复杂的任务分解为可以并行执行的小任务,但要确保分解后的任务不会导致竞态条件。

顺序一致性模型:在某些编程语言中,如C++11,提供了顺序一致性模型,可以帮助开发者编写更容易维护的并发代码。

确保全局变量数据一致性还需要对并发程序进行彻底的测试,包括寻找和修复潜在的竞态条件。此外,开发者应该遵循一些最佳实践,如避免死锁、活锁和饥饿等问题,以确保程序的稳定性和性能。

graph LR;

计算机科学 -->|组成部分| 硬件与软件

硬件 -->|五大部件| 存储器、运算器、控制器、输入设备、输出设备

硬件 -->|体系结构| 单核、多核、分布式系统、集群

软件 -->|层次划分| 系统软件、应用软件

系统软件 -->|子类| 操作系统、编译器、驱动程序

应用软件 -->|领域| 办公软件、数据库管理系统、Web应用、移动应用

程序设计 -->|基础| 数据结构、算法、编程语言

数据结构 -->|实例| 数组、链表、树、图、堆栈、队列

算法 -->|分类| 排序算法、搜索算法、图算法、动态规划等

编程语言 -->|类型| 面向过程、面向对象、函数式、逻辑式、脚本语言

计算理论 -->|分支| 可计算性理论、自动机理论、形式语言与自动机

计算模型 -->|范例| 图灵机、冯·诺依曼架构、并行计算模型

网络技术 -->|协议栈| 物理层、数据链路层、网络层、传输层、应用层

安全与隐私 -->|主题| 加密算法、访问控制(如Windows ACL)、网络安全、数据隐私

人工智能 -->|领域| 机器学习、深度学习、自然语言处理、计算机视觉

数据科学 -->|环节| 数据采集、清洗、存储、分析、可视化

基础科学研究(Basic Scientific Research),也称为基础研究、纯科学研究,指的是旨在拓宽人类对自然界和宇宙本质理解的研究,它不以直接应用为目的,而是探索事物的基本原理和规律。其核心目标是解答“是什么”、“怎么样”和“为什么”等基础性问题。

1. 什么是基础科学研究?

基础科学研究是指那些主要关注理论和知识的探索、规律的发现,不直接关注短期的应用成果。它通常不以产生直接经济效益为目标,而是致力于发现和理解自然界、物理世界、生命现象等的基本规律。基础科学研究通常跨越多个学科领域,如物理学、化学、生物学、天文学、数学等。

2. 怎么样进行基础科学研究?

基础科学研究通常采取以下几种方式:

-

实验研究:通过实验室中可控的环境进行观察和实验,获取数据,验证假设。例如,粒子物理学中的加速器实验、化学反应研究等。

-

理论建模:通过建立数学模型和理论框架,描述和解释现象。例如,爱因斯坦的相对论、量子力学的理论模型等。

-

观察与分析:一些领域,如天文学或生物学,主要依赖对自然界的观察、数据采集和长期监测分析,得出规律。

-

跨学科合作:许多基础科学研究涉及多学科的交叉,理论物理与计算机科学、生物学与化学等领域的合作,往往能够提供新的视角和创新方法。

3. 为什么要进行基础科学研究?

基础科学研究的意义远远超越了眼前的应用,具体来说有以下几个方面:

-

推动人类知识的进步:基础研究使我们对自然界和宇宙的理解更为深入,为人类社会提供了知识的基础。例如,量子力学的发现不仅深刻改变了物理学,也催生了计算机技术、通信技术等多个领域的飞跃。

-

解决未来问题的关键:基础科学研究往往能够为未来的技术革新提供理论支持,许多现代科技的突破(如互联网、人工智能、医学进步等)都是建立在基础研究的成果之上的。

-

提升创新能力和竞争力:国家和社会的科技创新能力离不开基础研究的支持。许多国家(如美国、欧洲、日本)都意识到基础研究对国家竞争力的重要性,投入大量资源支持基础科学的探索。

-

应对全球性挑战:基础研究对解决全球性问题,如气候变化、能源危机、公共健康等,也具有长远的战略意义。例如,生物学的基础研究推动了基因工程、疫苗研发等领域的革命。

-

培养未来的科学家和技术人才:基础研究是科学家成长的重要土壤,它不仅推动了科学进步,还培养了大量的科研人才,这些人才是未来技术创新的核心力量。

基础科学研究是人类科学探索和技术创新的源泉,虽然它的直接应用不一定立竿见影,但它为整个社会的进步和技术的突破提供了坚实的理论基础和源源不断的知识支持。因此,基础科学研究不仅对科学领域本身至关重要,也对经济发展、社会进步以及应对全球挑战具有深远的意义。

基础科学研究(Basic Scientific Research),也称为基础研究、纯科学研究,指的是旨在拓宽人类对自然界、生命现象和宇宙本质的理解的研究。其主要目的是为了探索自然界的规律,而不是为了直接的应用或商业化成果。基础科学研究关注的是探索“是什么”“为什么”和“怎么做”这些问题,属于对自然界基本原理的系统探讨。

1. 基础科学研究的定义

基础科学研究是对事物的本质、构成、发展规律和相互关系的探索,往往不带有明确的商业或技术应用目的。它以揭示自然现象背后的规律为核心,而不是通过实验直接得到可用于产品或技术的成果。例如,物理学家研究万有引力定律和量子力学的原理,生物学家研究基因的遗传规律等,这些都属于基础科学研究。

2. 基础科学研究的特点

基础科学研究有一些独特的特点,使其不同于应用科学研究:

-

非直接应用性:基础研究不以解决具体的、眼前的技术难题为目标,它更多的是为人类理解自然现象提供理论支持。基础科学的研究成果可能需要经过很多年,甚至几十年才能转化为实际应用。

-

探索性和开放性:基础研究的探索性特征十分突出,许多研究方向开始时没有明确的目的,它更多的是对未知的探索。这意味着基础研究往往不确定性较高,研究成果可能会改变甚至推翻已有的理论。

-

学科交叉:基础科学研究往往需要跨学科的合作。很多科学领域之间存在着相互联系,通过跨学科的合作,能够加速科学突破的进程。例如,物理学与计算机科学、化学与生物学等领域的交叉合作,产生了量子计算、合成生物学等新兴领域。

-

长期性:基础科学研究的成果通常是长期积累的结果,其影响往往是渐进式的,而非即时性的。许多基础研究的成果在短期内看不到直接应用,但它们为未来的科学发现和技术创新提供了支撑。

3. 基础科学研究的主要领域

基础科学研究涵盖了许多领域,下面是一些典型的研究领域:

-

物理学:物理学作为基础科学的重要分支,研究物质的基本构成、宇宙的起源、能量与物质的相互作用等。经典的物理学如牛顿力学、热力学、光学等,以及现代物理学中的相对论、量子力学、粒子物理学等。

-

化学:化学研究物质的组成、结构、性质及其相互作用,涵盖有机化学、无机化学、物理化学、分析化学等子领域。化学家通过对分子结构的研究,探索了分子之间的化学反应与变化。

-

生物学:生物学研究生命的起源、结构、功能、演化等基本问题。它涉及从微观的分子生物学、细胞学到宏观的生态学、进化论等多个层次。分子生物学中的基因、DNA研究为生物医药领域提供了基础。

-

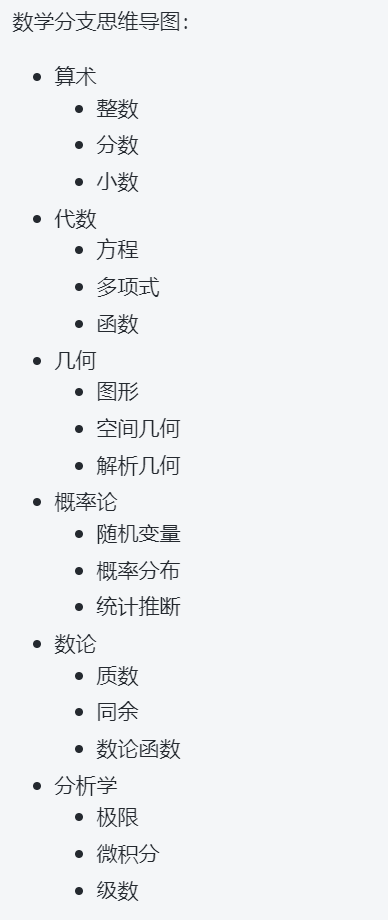

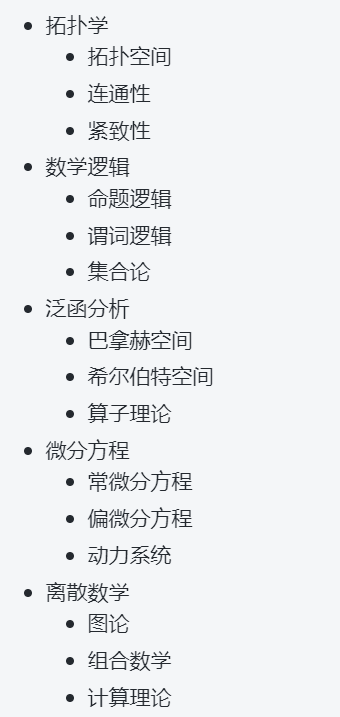

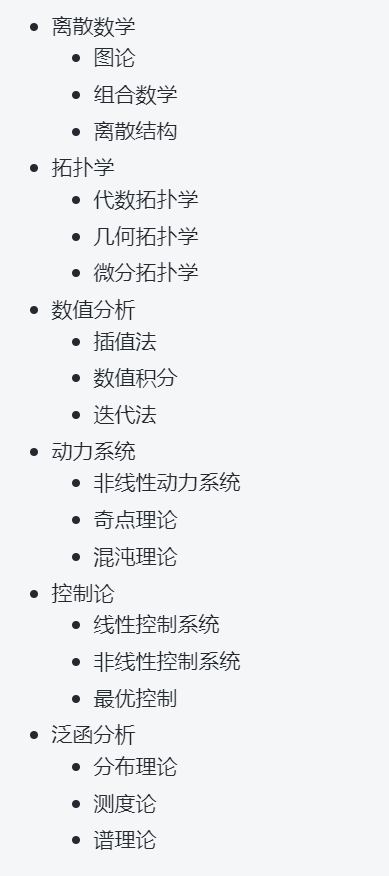

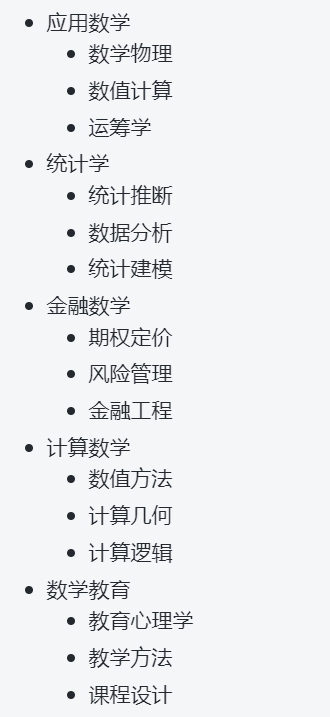

数学:数学是基础科学研究的基础,提供了其他学科研究的语言和工具。数学的基础研究包括纯数学(如数论、几何、拓扑等)以及应用数学领域(如统计学、数学物理等)。

-

天文学与宇宙学:天文学研究宇宙中的天体、星系及其演化,宇宙学则进一步研究宇宙的起源、结构和未来。基础天文学的研究对人类理解宇宙起源、星系结构及宇宙规律至关重要。

4. 基础科学研究的重要性

基础科学研究对社会、经济、技术、文化等方面都具有深远的影响。尽管它没有直接的商业应用,但其作用是推动科技进步和社会发展的核心动力。

-

推动技术创新:许多现代技术的突破都源于基础科学的进展。比如,量子力学的研究推动了半导体技术和计算机的发展;电磁学的发展推动了无线电、雷达等技术的创新;生物学的进展为基因工程、基因疗法等新技术奠定了基础。

-

深化对自然规律的理解:基础科学的研究不断加深人类对自然界的理解,帮助我们解释和预测自然现象。例如,爱因斯坦的相对论和量子力学的理论彻底改变了我们对物质世界和宇宙的认识。

-

应对全球性挑战:许多全球性问题,如气候变化、能源危机、疾病预防等,需要依赖基础科学研究的成果。基础科学研究为应对这些挑战提供了理论依据和技术解决方案。例如,基础生物学研究促进了疫苗的研发,而气候科学的基础研究则为全球气候变化问题的应对提供了数据和模型支持。

-

培养人才:基础科学研究不仅是技术创新的源泉,也为科学人才的培养提供了平台。许多科学家在基础研究领域的探索和发现,为未来的科技领域提供了源源不断的人才和智力支持。

5. 基础科学研究的挑战

尽管基础科学研究对社会发展具有重要意义,但它也面临着一些挑战:

-

高投入、低回报:基础科学研究往往需要大量资金和长期投入,而其应用成果的转化通常需要较长的时间。这使得很多基础科学领域可能面临资金不足和长期成果无法显现的困境。

-

跨学科的协作需求:基础科学的研究往往涉及多个学科之间的协作,这需要不同领域的专家进行知识的整合与沟通,可能面临学科壁垒、思维模式差异等挑战。

-

伦理与安全问题:随着基础科学研究向更深层次、更前沿的领域发展,某些研究可能会引发伦理或安全上的问题,例如基因编辑技术的伦理争议、人工智能带来的隐私问题等。

基础科学研究是人类文明进步的基石,它为应用科学和技术创新提供了理论基础和方法论支持。基础研究可能没有直接的短期经济效益,但它是科技创新的源泉、解决全球性问题的关键,并且对国家、社会和人类的未来具有深远的意义。

基础科学研究中的数学分支对多种领域的推动作用极为重要,它为解决实际问题提供了理论框架、模型和工具。以下是数学在基础科学研究中推动的主要方面:

1. 推动物理学的进展

数学为物理学提供了分析自然现象的语言和方法。许多物理定律和理论都是通过数学公式来表达和推导的。例如:

- 经典力学:牛顿的三大定律用数学公式精确描述了物体的运动规律。

- 电磁学:麦克斯韦方程组将电和磁现象与数学相结合,揭示了电磁波的传播规律。

- 量子力学:数学中的线性代数、复数分析等方法在量子力学中起着至关重要的作用,例如薛定谔方程是描述量子状态变化的核心方程。

- 广义相对论:爱因斯坦的广义相对论通过复杂的微分几何和张量分析,描述了引力和时空的关系。

2. 推动计算机科学的发展

数学,特别是离散数学和计算理论,为计算机科学的基础提供了理论支持。关键的领域包括:

- 算法与数据结构:离散数学为设计高效算法、数据结构提供了工具。比如,图论在计算机网络、搜索算法等中的应用。

- 计算复杂度理论:数学帮助确定哪些问题能高效解决,哪些问题则难以解决,推动了理论计算机科学的发展。

- 密码学:数学中的数论、代数等领域为现代加密技术提供了理论基础,广泛应用于信息安全。

3. 推动生物学与医学的进展

数学在生物学和医学中发挥着重要作用,尤其在疾病建模、基因研究和生物系统的分析中:

- 流行病学建模:数学模型帮助预测和控制疾病的传播,例如SIR模型用于流行病传播的分析。

- 基因组学:数学在基因数据分析、遗传算法和统计学中的应用,推动了基因组学的进展。

- 生物力学:通过数学建模,生物学家可以更好地理解人体运动、细胞力学等生物现象。

4. 推动天文学与宇宙学的研究

天文学和宇宙学通过数学模型理解天体运动和宇宙结构:

- 天体物理学:数学推导帮助理解星体的形成、演化以及相互作用。

- 引力波与黑洞研究:通过数学推导,科学家能够理解引力波的传播、黑洞的性质等,进而探索宇宙深处的未知领域。

5. 推动经济学和社会科学的发展

数学在经济学和社会学中用于构建模型,分析市场行为和社会现象:

- 经济模型:微观经济学和宏观经济学中的数学模型(如供需模型、博弈论)帮助分析经济行为。

- 运筹学与优化:运筹学中的线性规划、整数规划等方法广泛应用于资源优化、供应链管理等领域。

6. 推动工程学和技术的发展

数学在工程学中的应用极其广泛:

- 控制理论:数学为自动控制系统、飞行器控制、机器人等提供了理论支持。

- 信号处理:傅里叶变换、卷积等数学工具在信号处理、图像处理、通信系统中得到广泛应用。

- 结构工程:数学中的有限元分析等方法帮助工程师分析建筑、桥梁等结构的稳定性。

7. 推动气候科学和环境科学的进展

气候和环境研究中的数学模型帮助科学家预测气候变化、污染扩散等:

- 气候模型:数学方程用于模拟气候变化、温室气体排放对全球气候的影响。

- 生态模型:数学模型用于研究物种生长、生态系统的平衡等问题。

8. 推动金融学的研究

数学在金融学中的应用非常广泛,主要体现在风险管理、衍生品定价、投资策略等方面:

- 金融数学:如布朗运动、随机过程、期权定价模型(如Black-Scholes模型)等数学工具在金融市场中得到应用。

- 风险管理与投资优化:数学帮助量化风险、优化投资组合,推动了现代金融学的进展。

数学在基础科学研究中的推动作用不仅仅限于物理学、计算机科学等传统领域,它的应用已经渗透到生物学、社会科学、气候学等多学科。数学不仅提供了解决问题的工具,还帮助形成了许多学科的理论基础,是推动科技和社会发展的重要力量。

数学在推动计算机科学发展的过程中,尤其在人工智能(AI)领域扮演着至关重要的角色。AI技术的发展依赖于深厚的数学基础,以下是数学在AI领域的具体应用和推动作用:

1. 线性代数

线性代数是人工智能中的核心数学工具,广泛应用于机器学习、深度学习、计算机视觉等领域。以下是它的几个关键应用:

-

矩阵运算与数据表示:在机器学习和神经网络中,数据经常以矩阵或向量的形式表示。例如,图像可以表示为矩阵,文本可以通过词向量表示。线性代数的运算(如矩阵乘法、转置、求逆)是这些数据处理和模型计算的基础。

-

特征提取与降维:PCA(主成分分析)是通过线性代数方法实现数据降维的典型例子。通过减少数据的维度,可以更有效地进行分类、聚类和回归分析。

-

神经网络中的权重更新:神经网络中每一层的计算通常都涉及矩阵乘法。训练过程中,反向传播算法依赖线性代数的知识来更新权重和偏置,以最小化误差。

2. 概率与统计

AI模型,特别是机器学习模型,通常依赖概率和统计方法来处理不确定性、推断和数据分析。具体包括:

-

贝叶斯推断:贝叶斯方法为AI提供了一种处理不确定性的框架。贝叶斯网络和贝叶斯分类器是基于贝叶斯理论的模型,广泛应用于自然语言处理、图像识别和推荐系统中。

-

概率模型:隐马尔可夫模型(HMM)和高斯混合模型(GMM)等是常见的概率模型,广泛应用于语音识别、机器翻译和时间序列预测等领域。

-

统计学习:统计学为机器学习提供了分析和理解数据的工具。例如,回归分析、假设检验和假设验证方法可以帮助构建更健壮的AI模型,并评估其性能。

-

蒙特卡罗方法:蒙特卡罗模拟是一种统计方法,通过随机采样来估计复杂问题的解。在强化学习和优化问题中,蒙特卡罗方法常用于策略评估和决策。

3. 优化理论

优化是AI中非常重要的一部分,它帮助算法找到最优解。优化方法广泛应用于模型训练和参数调整,主要应用包括:

-

梯度下降:梯度下降算法是深度学习中最常用的优化方法。通过计算损失函数关于模型参数的梯度,并沿着梯度的反方向更新参数,以最小化损失函数。这个过程是通过微积分中的导数来实现的。

-

凸优化:许多机器学习和深度学习问题可以通过凸优化来解决。凸优化中的数学理论帮助我们找到全局最优解,而不是局部最优解。在支持向量机(SVM)等算法中,凸优化的理论被广泛应用。

-

线性规划与整数规划:这些优化方法被用于机器学习中的许多任务,如最大化某些目标函数,或者在给定约束条件下选择最优解。

4. 信息论

信息论是AI的一个基础学科,它为我们理解和处理信息的传播、存储和编码提供了数学框架。主要应用包括:

-

熵与信息增益:在决策树学习中,信息增益(基于熵的度量)是用来选择最佳特征的关键准则。熵越小,信息越集中,分类的效果越好。

-

编码理论:信息论中的编码方法(如霍夫曼编码)在数据压缩、数据传输和误差检测中扮演着重要角色。

-

自编码器:自编码器是一种神经网络架构,用于数据压缩和特征学习,它依赖信息论中的概念来设计网络结构。

5. 图论

图论在AI的多个领域中也有广泛应用,特别是在图像分析、社交网络、推荐系统等领域:

-

图神经网络(GNN):图神经网络是一类基于图论的深度学习方法,用于处理图数据。图中的节点和边的结构信息可以帮助模型在图结构中进行节点分类、链接预测等任务。

-

社交网络分析:图论帮助理解社交网络中节点(用户)之间的关系,例如通过计算图的中心性、连通性等指标来分析社交网络的结构和传播效应。

-

最短路径与网络流:图论中的最短路径算法、最大流最小割理论在优化问题、路径规划、物流调度等AI应用中有重要应用。

6. 计算复杂度理论

计算复杂度理论帮助理解AI算法的效率和可行性,特别是在处理大规模数据和复杂任务时:

-

NP问题与近似算法:很多AI问题(如旅行商问题)是NP难题,解决这些问题需要近似算法或启发式搜索方法。通过理解这些问题的复杂性,研究者能够设计出更高效的算法来处理现实问题。

-

大O表示法:大O符号用于分析算法的时间复杂度和空间复杂度,帮助开发人员优化AI模型的执行效率。例如,深度学习中的卷积操作、矩阵运算和反向传播都涉及复杂度分析。

7. 深度学习与神经网络

深度学习是AI的重要发展方向,而神经网络本身就是一个数学模型,主要依赖于以下数学原理:

-

反向传播算法:反向传播(Backpropagation)算法利用微积分中的链式法则来计算神经网络中各层的误差,从而更新权重。

-

激活函数:在神经网络中,激活函数如Sigmoid、ReLU、Tanh等通过非线性变换来增加网络的表达能力,这些函数的数学性质(如导数、单调性)决定了网络的训练效率。

-

卷积运算:卷积神经网络(CNN)通过卷积操作提取局部特征,这种操作来源于数学中的卷积运算,用于图像、视频、语音等数据的特征提取。

8. 数学模型与仿真

AI中有许多应用依赖于数学模型和仿真技术,例如:

-

强化学习:强化学习中的马尔可夫决策过程(MDP)模型是基于概率和优化理论的,数学模型帮助设计智能体的策略,使其能够在环境中学习并作出最优决策。

-

模拟与预测:AI系统经常使用数学模型进行模拟,以预测未来的事件或行为。例如,在自动驾驶汽车中,AI系统依赖数学模型来预测其他车辆的行为,从而做出决策。

数学是人工智能发展的基石,涵盖了线性代数、概率论、统计学、优化、信息论等多个学科领域。通过这些数学工具,AI能够处理大规模数据、设计高效算法、构建模型并进行优化,从而实现更精确的预测、分类和决策能力。数学不仅为AI提供了强大的理论支持,也促进了技术的进步,推动了许多实际应用的发展。

浙公网安备 33010602011771号

浙公网安备 33010602011771号