从0到1安装hadoop+hive环境记录(超详细超全)

java环境

下载java:http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

创建文件夹

mkdir /usr/local/java

cd /usr/local/java

解压jdk

tar -zxvf jdk-8u151-linux-x64.tar.gz

设置环境变量,注意/etc前面有斜杠否则会创建一个新的空文本

vi /etc/profile

在profile文件中添加以下内容并保存,别忘了把jdk的编号改一下,按照自己的下的版本改下第二行和第三行的内容。

set java environment JAVA_HOME=/usr/local/java/jdk1.8.0_151 JRE_HOME=/usr/local/java/jdk1.8.0_151/jre CLASS_PATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin export JAVA_HOME JRE_HOME CLASS_PATH PATH

完成。完成后使用 source /etc/profile 让设置生效。

如果在后面报错:/usr/local/java/jdk1.8.0_281/bin/java: 无法执行二进制文件: 可执行文件

查阅资料后认为是版本不对应,使用uname -m来查看版本,可以看到x86_64,这是linux系统的版本,java也要选择这个版本的。x86是32位的,对应下载32位的java。

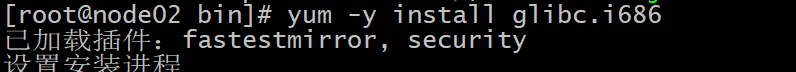

如果后面报错:bad ELF interpreter: 没有那个文件或目录。

因为系统内缺少glibc库导致,需要安装glibc。

防火墙设置

查询防火墙状态:

systemctl status firewalld.service

可以看到防火墙绿灯是亮的,关闭防火墙:

systemctl stop firewalld.service

设置开机时候不再启动防火墙:

systemctl disable firewalld.service

完毕。

SSH免密登录

ssh-keygen -t rsa

遇到选项回车就可以了,生成密钥。

使用以下命令把密钥给远程主机对应的账户下:

ssh-copy-id localhost

执行命令看是否验证成功:

ssh-copy-id localhost

Hadoop配置

我下载的是hadoop2.10.1

首先把压缩包解压在home下面

tar -zxvf hadoop-2.10.1.tar.gz -C /home

修改环境变量

vim /etc/profile

里面加入:(按照自己的版本添加进去)

export HADOOP_HOME=/home/hadoop-2.10.1 export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

使配置文件生效:

source /etc/profile

接下来是伪分布式的安装与配置,都是改hadoop文件夹下面的一些参数

第一个修改配置中jdk的路径。首先定位到hadoop文件夹下,配置文件在hadoop文件夹下面etc/hadoop里面。

首先配置hadoop-env.sh和yarn-env.sh,配置结束后保存。因为都是一样的所以我这里只写一行,两个文件都得写啊别他妈偷懒。

export JAVA_HOME=/home/jdk1.8.0_301

然后配置core-site.xml文件

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop-2.10.1/tmp</value>

</property>

</configuration>

然后配置hdfs-site.xml文件

<configuration> <property> <name>dfs.namenode.name.dir</name> <value>/home/hadoop-2.10.1/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>/home/hadoop-2.10.1/dfs/data</value> </property> <property> <name>dfs.replication</name> <value>1</value> </property> </configuration>

配置mapred-site.xml文件

这里注意如果没有mapred-site.xml文件可以将maperd-site.xml.template重命名

<configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration>

配置yarn-site.xml

<configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>localhost</value>

</property>

</configuration>

切换到hadoop的安装目录,执行

./bin/hdfs namenode -format

ok

浙公网安备 33010602011771号

浙公网安备 33010602011771号