Prometheus Operator自定义监控对象 -- Ingress-Nginx

一、自定义资源

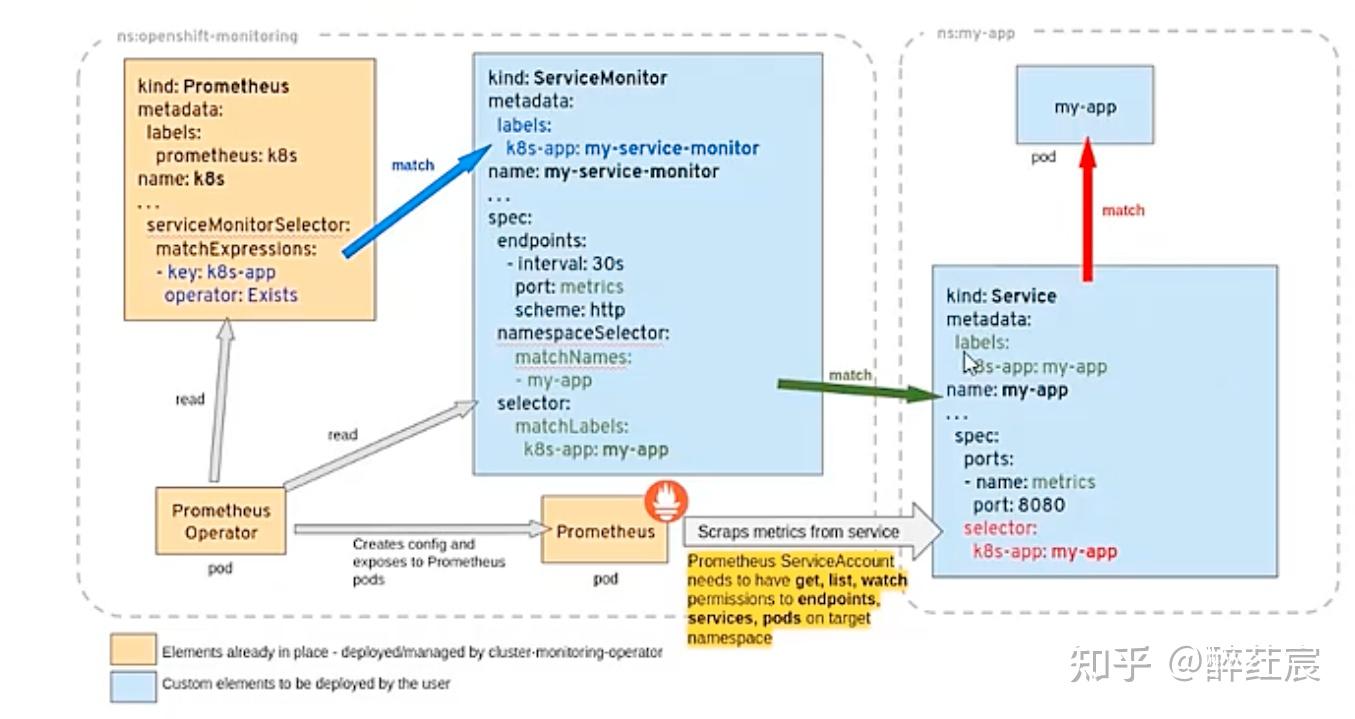

Prometheus-operator 通过定期循环watch apiserver,获取到CRD资源(比如servicemonitor)的创建或者更新,将配置更新及时应用到运行中的prometheus pod中转换成标准promethesu配置文件供prometheus server使用。

各个CRD以及operator之间的关系:

使用CRD做prometheus配置,“匹配” 是一个很重要的细节,详细匹配关系如图,任何地方匹配失败会导致转化成的标配prometheus文件无法识别到。

Prometheus Operater 定义了如下的四类自定义资源:

-

Prometheus

-

ServiceMonitor

-

Alertmanager

-

PrometheusRule

1.1、Prometheus

Prometheus 自定义资源(CRD)声明了在 集群中运行的 Prometheus 的期望设置。包含了副本数量,,以及 Prometheus 实例发送警告到的 Alertmanagers等配置选项。

每一个 Prometheus 资源,Operator 都会在相同 namespace 下部署成一个正确配置的 StatefulSet,Prometheus 的 都会挂载一个名为 的 Secret,里面包含了 Prometheus 的配置。Operator 根据包含的 ServiceMonitor 生成配置,并且更新含有配置的 Secret。无论是对 ServiceMonitors 或者 Prometheus 的修改,都会持续不断的被按照前面的步骤更新。

示例配置如下

kind: Prometheus

metadata: # 略

spec:

alerting:

alertmanagers:

- name: prometheus-prometheus-oper-alertmanager # 定义该 Prometheus 对接的 Alertmanager 集群的名字, 在 default 这个 namespace 中

namespace: default

pathPrefix: /

port: web

baseImage: quay.io/prometheus/prometheus

replicas: 2 # 定义该 Proemtheus “集群”有两个副本

ruleSelector: # 定义这个 Prometheus 需要使用带有 prometheus=k8s 且 role=alert-rules 标签的 PrometheusRule

matchLabels:

prometheus: k8s

role: alert-rules

serviceMonitorNamespaceSelector: {} # 定义这些 Prometheus 在哪些 namespace 里寻找 ServiceMonitor

serviceMonitorSelector: # 定义这个 Prometheus 需要使用带有 k8s-app=node-exporter 标签的 ServiceMonitor,不声明则会全部选中

matchLabels:

k8s-app: node-exporter

version: v2.10.01.2、ServiceMonitor

ServiceMonitor 自定义资源(CRD)能够声明如何监控一组动态服务的定义。它使用标签选择定义一组需要被监控的服务。这样就允许组织引入如何暴露 的规定,只要符合这些规定新服务就会被发现列入监控,而不需要重新配置系统。

要想使用 Prometheus Operator 监控 Kubernetes 集群中的应用,Endpoints 对象必须存在。Endpoints 对象本质是一个 IP 地址列表。通常,Endpoints 对象由 Service 构建。Service 对象通过对象选择器发现 Pod 并将它们添加到 Endpoints 对象中。

Prometheus Operator 引入 ServiceMonitor 对象,它发现 Endpoints 对象并配置 Prometheus 去监控这些 Pods。

ServiceMonitorSpec 的 endpoints 部分用于配置需要收集 metrics 的 Endpoints 的端口和其他参数。

ServiceMonitor 和发现的目标可能来自任何 namespace:

-

使用 PrometheusSpec 下 ServiceMonitorNamespaceSelector, 通过各自 Prometheus server 限制 ServiceMonitors 作用 namespece。

-

使用 ServiceMonitorSpec 下的 namespaceSelector 允许发现 Endpoints 对象的命名空间。要发现所有下的目标,namespaceSelector 必须为空。

spec:

namespaceSelector:

any: true示例配置如下

apiVersion: monitoring.coreos.com/v1

kind: ServiceMonitor

metadata:

labels:

k8s-app: node-exporter # 这个 ServiceMonitor 对象带有 k8s-app=node-exporter 标签,因此会被 Prometheus 选中

name: ingress-nginx

namespace: monitoring

spec:

endpoints:

- interval: 15s # 定义这些 Endpoints 需要每 15 秒抓取一次

port: prometheus # 这边一定要用svc中 port的name。

namespaceSelector:

matchNames:

- ingress-nginx # 选定抓取的指定namespace

selector:

matchLabels: # 匹配的抓取标签

app.kubernetes.io/component: controller

app.kubernetes.io/instance: ingress-nginx

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

app.kubernetes.io/version: 1.7.01.3、Alertmanager

Alertmanager 自定义资源(CRD)声明在 Kubernetes 集群中运行的 Alertmanager 的期望设置。它也提供了配置和持久化存储的选项。

每一个 Alertmanager 资源,Operator 都会在相同 namespace 下部署成一个正确配置的 StatefulSet。Alertmanager pods 配置挂载一个名为 的 Secret, 使用 alertmanager.yaml key 对作为配置文件。

当有两个或更多配置的副本时,Operator 可以模式运行Alertmanager实例。

示例配置如下:

kind: Alertmanager # 一个 Alertmanager 对象

metadata:

name: prometheus-prometheus-oper-alertmanager

spec:

baseImage: quay.io/prometheus/alertmanager

replicas: 3 # 定义该 Alertmanager 集群的节点数为 3

version: v0.17.01.4、PrometheusRule

PrometheusRule CRD 声明一个或多个 Prometheus 实例需要的 Prometheus rule。

Alerts 和 recording rules 可以保存并应用为 yaml 文件,可以被动态加载而不需要重启。

示例配置如下:

kind: PrometheusRule

metadata:

labels: # 定义该 PrometheusRule 的 label, 显然它会被 Prometheus 选中

prometheus: k8s

role: alert-rules

name: prometheus-k8s-rules

spec:

groups:

- name: k8s.rules

rules: # 定义了一组规则,其中只有一条报警规则,用来报警 kubelet 是不是挂了

- alert: KubeletDown

annotations:

message: Kubelet has disappeared from Prometheus target discovery.

expr: |

absent(up{job="kubelet"} == 1)

for: 15m

labels:

severity: critical1.5、配置间的匹配总结

ServiceMonitor 注意事项:

-

ServiceMonitor 的 label 需要跟prometheus中定义的serviceMonitorSelector一致。

-

ServiceMonitor 的 中 port 时对应k8s service资源中的 portname , 不是 port number。

-

ServiceMonitor 的 selector.matchLabels 需要匹配 k8s service 中的 label。

-

ServiceMonitor 资源创建在 prometheus 的 namespace 下,使用 namespaceSelector 匹配要监控的 的 ns。

-

servicemonitor 若匹配多个 svc ,会发生数据重复。

二、抓取自定义资源 -- Ingress-nginx(Helm)

2.1、暴露ingress的监控端口

通过 helm 部署维护的 ingress-nginx

vim values.yaml

metrics:

port: 10254

portName: metrics

# if this port is changed, change healthz-port: in extraArgs: accordingly

enabled: true

service:

annotations:

prometheus.io/scrape: "true"

prometheus.io/port: "10254"

···

prometheusRule:

enabled: true

additionalLabels: {}

namespace: "monitoring"

...

serviceMonitor:

enabled: true

additionalLabels: {}

annotations: {}

#添加报警规则

...

prometheusRule:

enabled: true

additionalLabels:

namespace: "monitoring"

rules:

# # These are just examples rules, please adapt them to your needs

- alert: NGINXConfigFailed

expr: count(nginx_ingress_controller_config_last_reload_successful == 0) > 0

for: 1s

labels:

severity: critical

annotations:

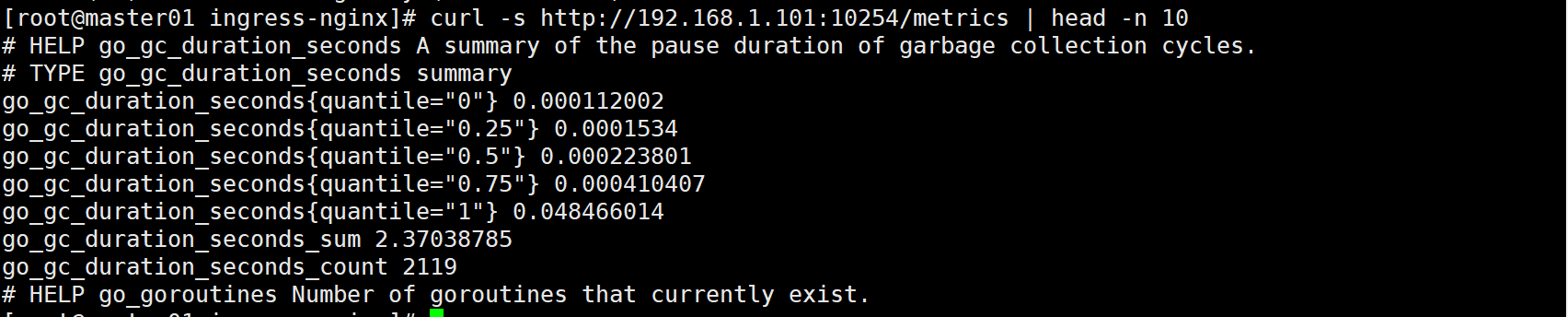

....默认情况下的监控指标端口为10254,监控路径为其下的/metrics。调整配置ingress-nginx的配置文件,打开service及pod的10254端口。

更新:

helm upgrade ingress-nginx ./ingress-nginx -f ./ingress-nginx/values.yaml -n ingress-nginx查看验证指标数据:

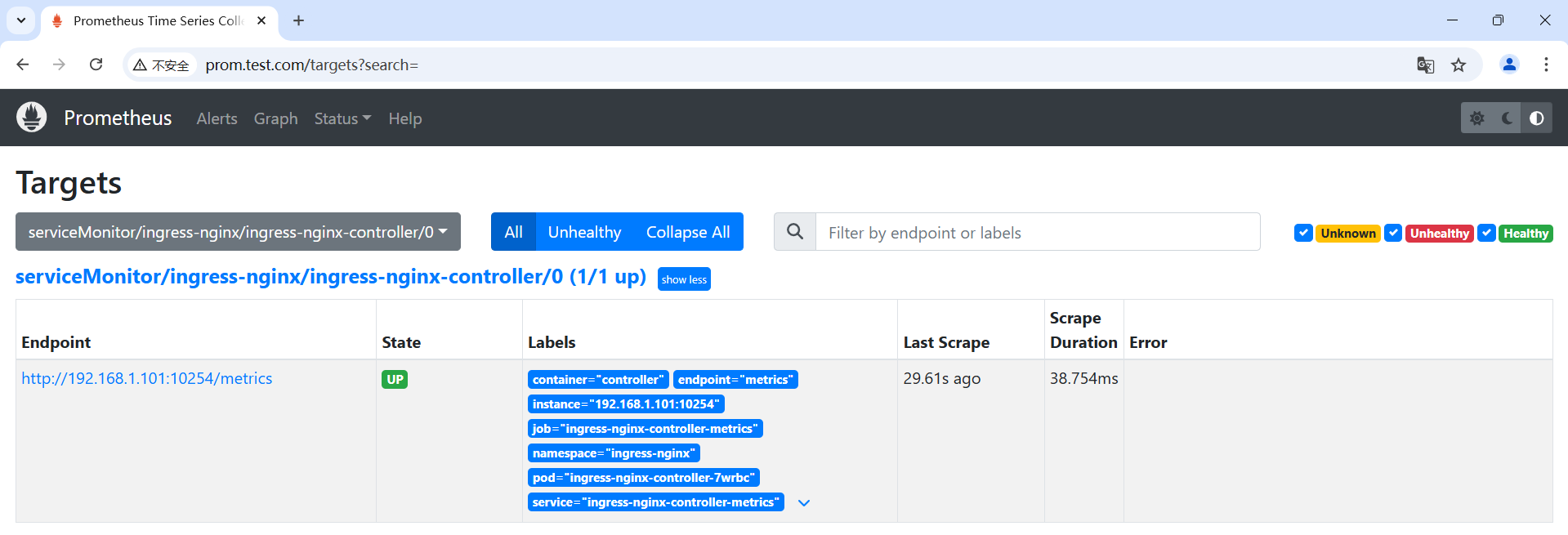

2.2、手动添加serviceMonitor

apiVersion: monitoring.coreos.com/v1

kind: ServiceMonitor

metadata:

name: ingress-nginx

namespace: monitoring

spec:

endpoints:

- interval: 15s

port: metrics

namespaceSelector:

matchNames:

- ingress-nginx

selector:

matchLabels:

app.kubernetes.io/component: controller

app.kubernetes.io/instance: ingress-nginx

app.kubernetes.io/managed-by: Helm

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

app.kubernetes.io/version: 1.11.1

helm.sh/chart: ingress-nginx-4.11.1

# 在对应的ns中创建角色

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: prometheus-k8s

rules:

- apiGroups: [""]

resources: ["*"]

verbs: ["get", "list", "watch"]

- apiGroups: ["apps"]

resources: ["*"]

verbs: ["get", "list", "watch"]

- apiGroups: ["batch"]

resources: ["*"]

verbs: ["get", "list", "watch"]

# 绑定角色 prometheus-k8s 角色到 Role

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: prometheus-k8s-ingress

subjects:

- kind: ServiceAccount

name: prometheus-k8s

namespace: monitoring

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: prometheus-k8s验证:

# kubectl get -n monitoring servicemonitors.monitoring.coreos.com

NAME AGE

ingress-nginx 5d1h

相关借鉴:

浙公网安备 33010602011771号

浙公网安备 33010602011771号