在本地部署deepseek离线模型

最近的大模型热度很高,本文用来记录在本地部署大模型

紧跟时代脚步,避免变成老油条

1.为什么需要在本地部署

- DeepSeek网页在线版,由于服务器被攻击,对接入设备严格限制,表现出来的情况就是,一天基本上只能提问一次

- 虽然说现在是免费的,但是未来不一定

- 使用别人的服务器可能会造成信息泄露

但是在本地部署缺点也很明显

- 受限于本地机器的性能,运行的模型参数量很小,这是效果不好的直接原因

- 我的机器是八年前的笔记本,配置已经比较老了

- CPU:i7-7700hq

- GPU:GTX1060 6G

- RAM:16GB

2.开始部署

- 下载安装:打开ollama官网,点击下载,下载windows版本,安装包基本上700MB+,一路下一步,会自动安装到C盘

- 安装验证:安装完成后,在powershell终端打开,运行

ollama -v,理论上就可以看到相关的版本号,代表我们的模型安装完成了,你的电脑右下角会有一个ollama logo,代表正在运行 - 安装模型:

- 在模型搜索界面,可以看到很多模型,包含了不同公司做的不同版本

- 在deepseek-r1模型界面,选择下拉框,可以看到不同参数量的模型,包含(1.5B、7B、8B、14B)等等,这里的

B指的是十亿,7B就代表这个模型有十亿参数,671B的模型,就是目前DeepSeek网页的正式版本 - 在终端中输入,

ollama run deepseek-r1:7b,就可以运行7b模型了,模型如果没有下载则会先下载

3.模型测试

- 如果模型已经下载完成,在终端中输入,

ollama run deepseek-r1:7b,稍等片刻,就可以和模型进行对话了- 模型会先从硬盘加载到显存中,如果显存不够,则会部分搬运到内存中

- 如果内存中包含模型,则会使用CPU推理,速度慢很多

- 实际测试中,7B可以完全加载到显存中,14B部分加载在内存中,所以7B的效果快的很多

PS C:\Users\13588> ollama run deepseek-r1:7b

>>> 你好,你是谁,你能做什么

<think>

您好!我是由中国的深度求索(DeepSeek)公司开发的智能助手DeepSeek-R1。有关模型和产品的详细内容请参考官方文档。

</think>

您好!我是由中国的深度求索(DeepSeek)公司开发的智能助手DeepSeek-R1。有关模型和产品的详细内容请参考官方文档。

>>> Send a message (/? for help)

4. 网页前端部署

使用命令行可以对话,但是太不优雅了,所以最好有一个像DeepSeek网页版那样的页面

Page Assist 是一款开源的浏览器扩展程序,主要为本地 AI 模型提供直观的交互界面,让用户可以在任何网页上与本地 AI 模型进行对话和交互,基本功能如下:

- 侧边栏交互:用户可以在任何网页上打开侧边栏,与本地 AI 模型进行对话,获取与网页内容相关的智能辅助。

- 网页 UI:提供类似 ChatGPT 的网页界面,用户可以在此界面中与 AI 模型进行更全面的对话。

- 网页内容对话:用户可以直接与网页内容进行对话,获取相关信息的解释或分析。

- 多浏览器支持:支持 Chrome、Brave、Edge 和 Firefox 等主流浏览器。

- 快捷键操作:通过快捷键可以快速打开侧边栏和网页 UI,方便用户使用。

- 支持多种本地 AI 提供商:目前支持 Ollama 和 Chrome AI (Gemini Nano) 等本地 AI 提供商。

- 文档解析:支持与 PDF、CSV 等多格式文档进行聊天交流。

- 离线模型适配:适用于离线环境,用户可以在本地运行 AI 模型。

- 隐私保护:所有交互都在本地完成,不会收集用户个人数据,数据存储在浏览器的本地存储中。 开发模式:支持开发者模式,便于进行扩展的开发和测试。

4.3 安装与使用

- 可以直接从 Chrome Web Store 或 Firefox Add-ons 商店下载安装,也可以通过手动安装的方式进行,访问 https://chromewebstore.google.com/search/

搜索 Page Assist - 离线下载插件后,打开浏览器插件的开发者模式,将插件拖进去就可以安装

- 点击插件按钮,就可以进入到主页面了

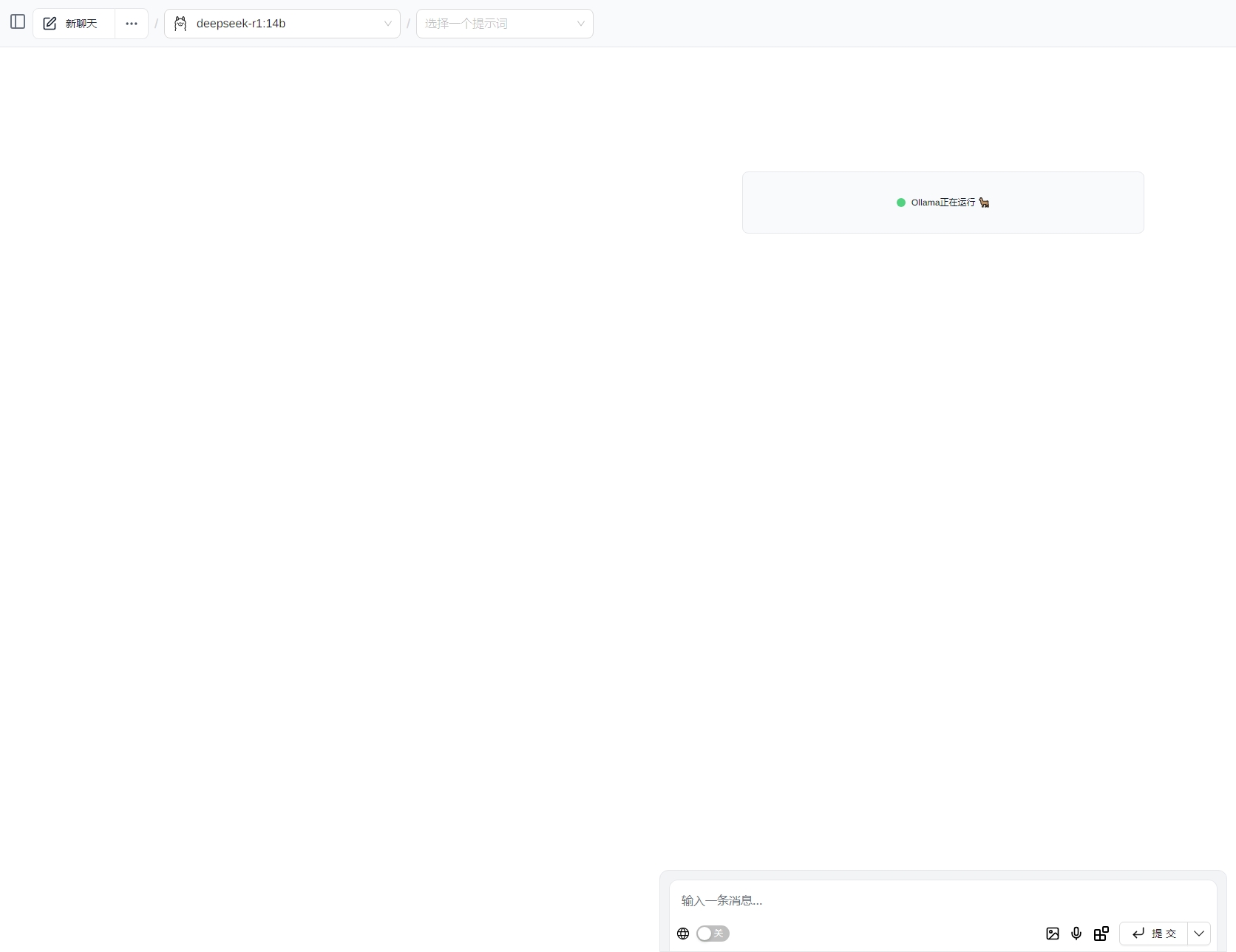

- 主界面如下

5. 其他

- 在下载模型中,会出现下载变慢甚至倒退的情况,这是由于模型是分块下载的,并且时间靠后的链接优先级更高,感觉到速度变慢后,可以强制退出终止,然后再重新下载

浙公网安备 33010602011771号

浙公网安备 33010602011771号