hadoop集群中namenode没有启动

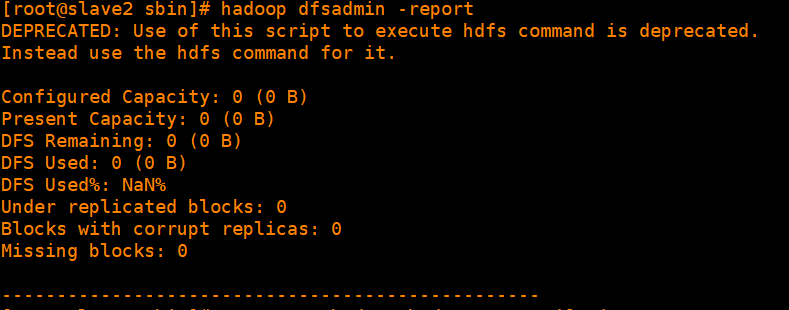

最近,我在学习搭建hadoop集群,可是搭建完成后当使用start-all.sh启动hadoop的时候,会发现用jps测试的时候一切均显示正常,但通过Hadoop指令向hdfs上传输文件的时候,会报错表示datanode没有正常启动,

在网上找了一些博客讲述是可能防火墙没关,还有就是删除hadoop目录下的tmp文件夹和logs文件夹,可是都不凑效,我经过反复查询发现是因为datanode的clusterID不匹配!

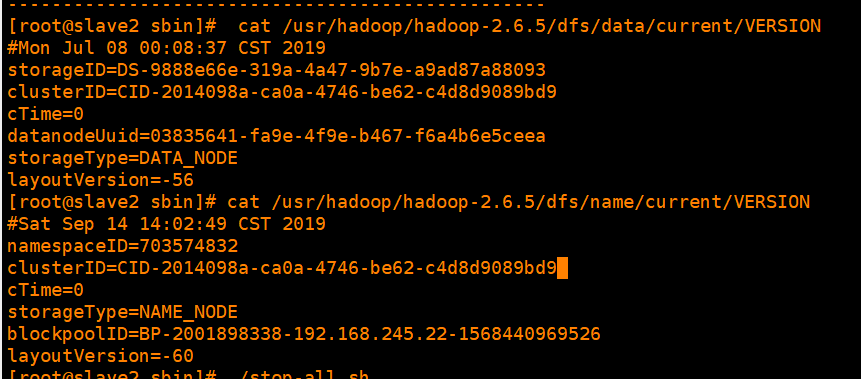

打开hdfs-site.xml里配置的datanode和namenode对应的目录,分别打开dfs目录下data和name文件下的current文件夹里的VERSION,可以看到clusterID正如日志里记录的一样,确实不一致。

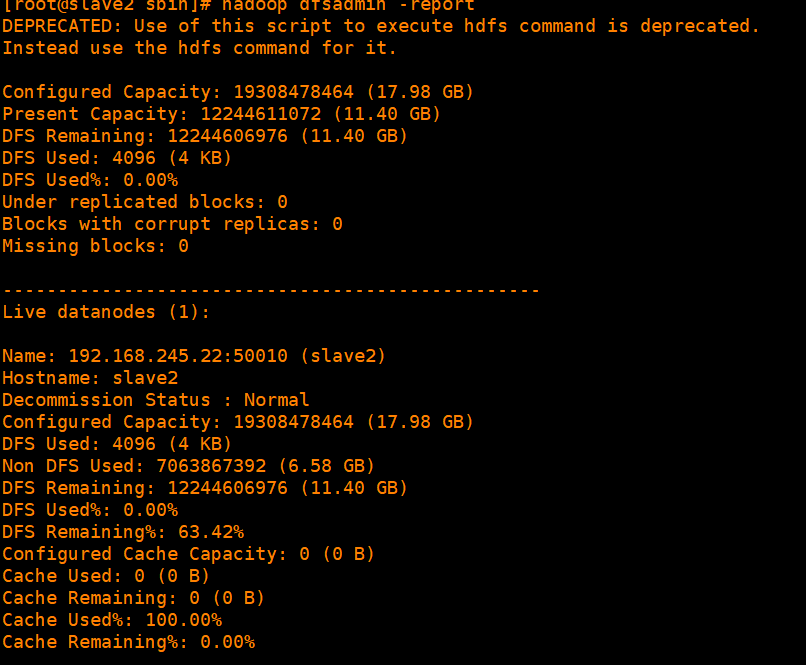

修改datanode里VERSION文件的clusterID与namenode里的一致,再重新启动dfs(执行start-all.sh)再执行jps命令可以看到datanode已正常启动。

浙公网安备 33010602011771号

浙公网安备 33010602011771号