hadoop安装笔记

最近在学习hadoop,hadoop的安装过程如下

我选用的是ubuntu 14桌面版+hadoop3.1.1。

1,ubuntu的安装

需要准备的有:ubuntu镜像文件,VMware虚拟机

首先我们需要linux系统,但是由于平时大家基本都是使用windows系统,而且hadoop集群又需要多个节点,所以我们需要使用虚拟机,这里选用的是VM ware ,当然你也可以使用virtual box,两者孰优孰劣,仁者见仁,全凭喜好。

安装好VMware之后(VMware是商业软件,作为一个学生,如何去使用它,相信难不住各位看官,在此便不作赘述),新建虚拟机-->自定义-->下一步-->稍后安装操作系统,下一步-->操作系统linux,版本:ubuntu64位,下一步-->编辑虚拟机名称,安装位置,下一步-->根据实际需要进行处理器配置,我直接next-->为虚拟机分配内存,我电脑8G,分给虚拟机2G-->选择网络类型:桥接网络-->控制器类型:选推荐-->磁盘类型:选推荐-->选择磁盘:创建虚拟磁盘-->分配磁盘空间:将虚拟磁盘存储为单个文件-->next-->完成。至此虚拟机新建完成。

接下来安装ubuntu系统,ubuntu系统可以在ubuntu官网http://ubuntu.com.cn/download/alternative-downloads下载,这里使用的是ubuntu14桌面版,首先编辑虚拟机设置-->CD/DVD,右侧连接,使用ISO映像文件,选择你下载的ubuntu镜像,确定,开机。

ubuntu安装过程如下:

1,选择语言,中文简体,然后选择安装ubuntu

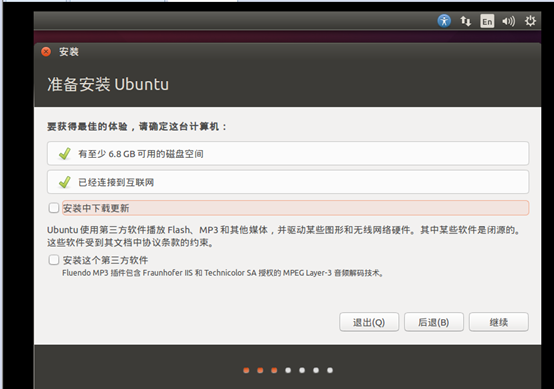

2,直接点Next

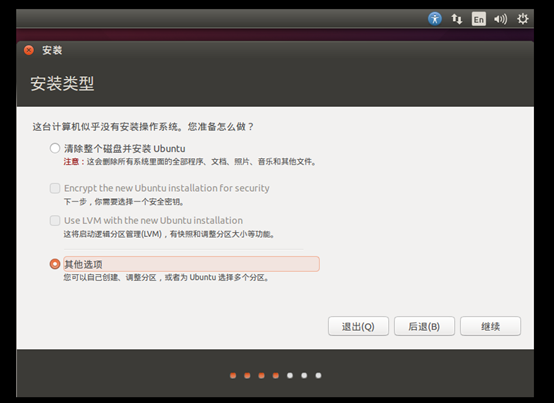

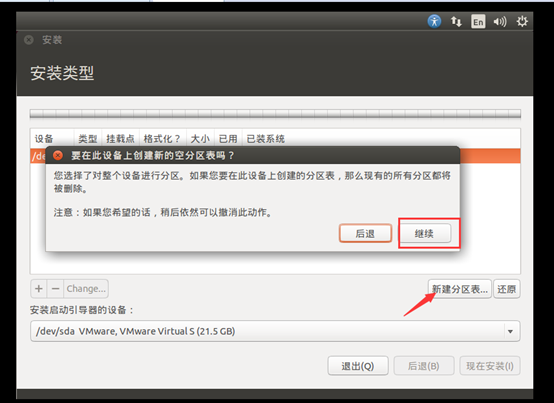

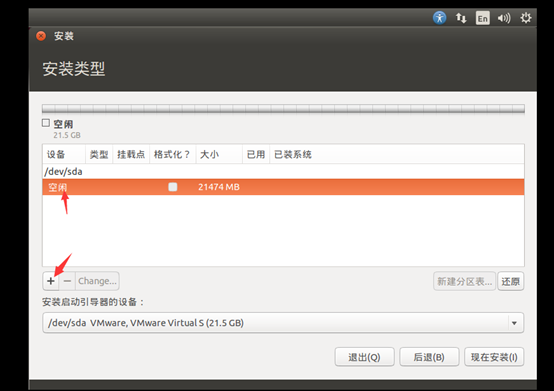

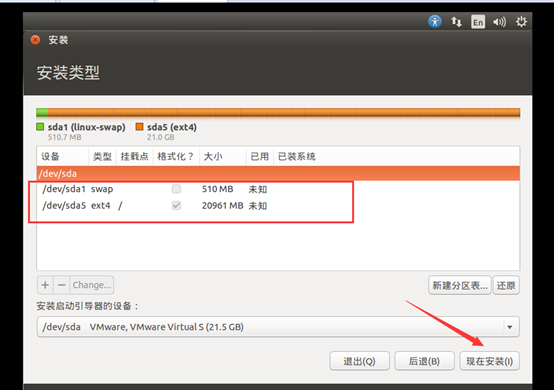

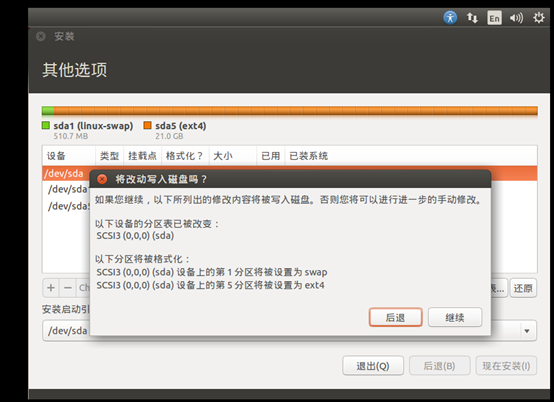

3,选择其他选项,新建分区表

4分配交换空间。一般来说,我们选择512MB到1G大小作为交换空间,剩下空间全部用来作为根目录

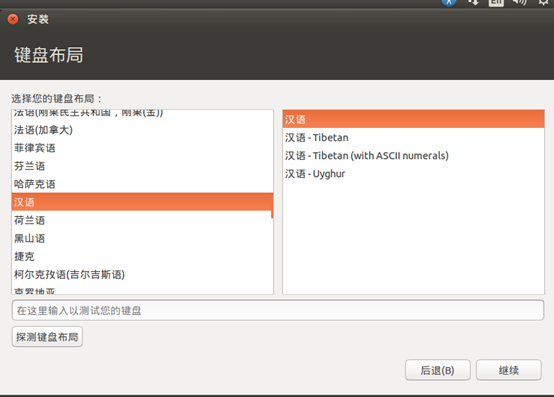

5键盘布局

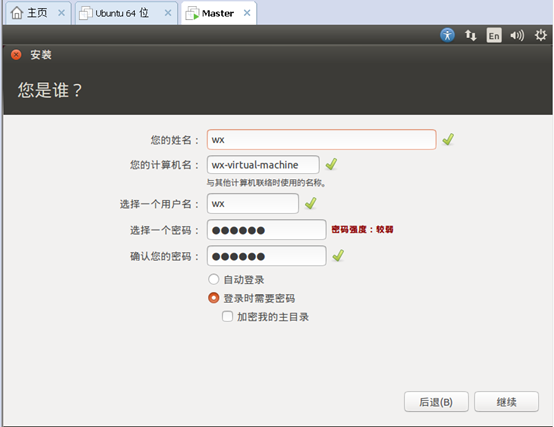

6,设置主机名和密码

7,等待安装完成,不要点skip

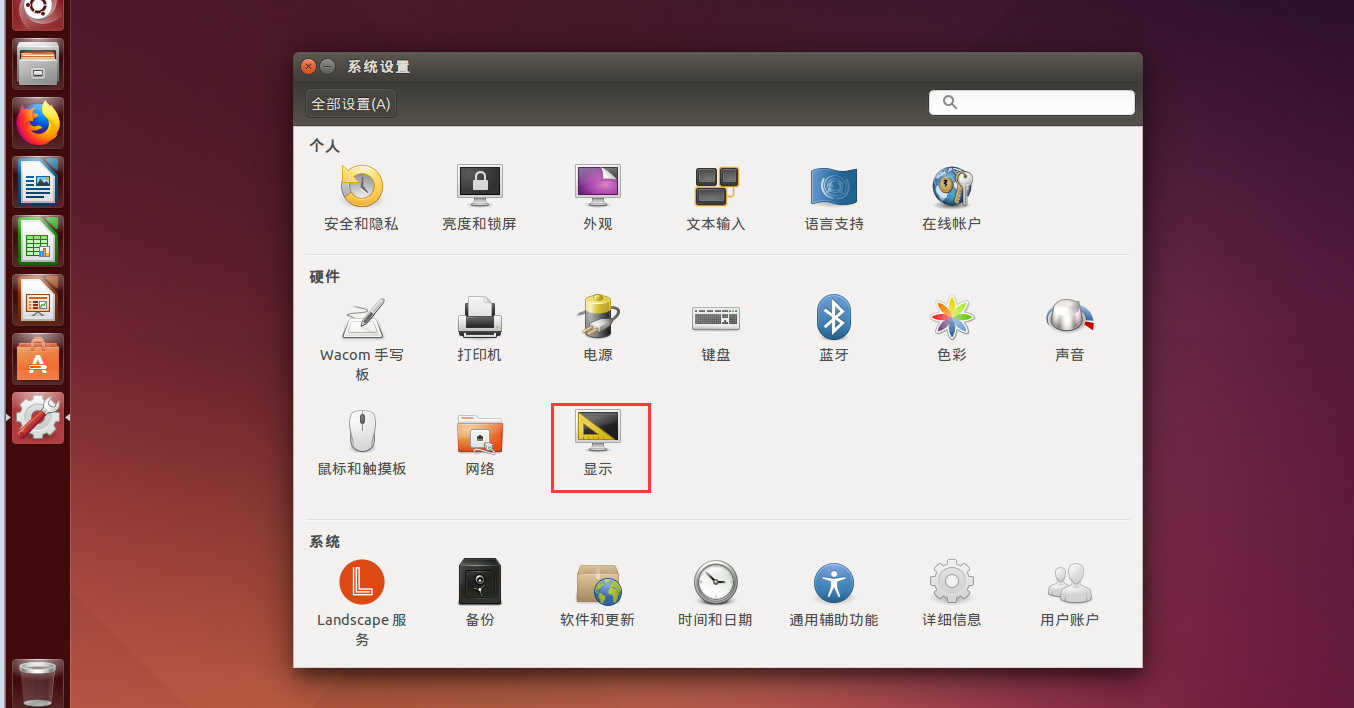

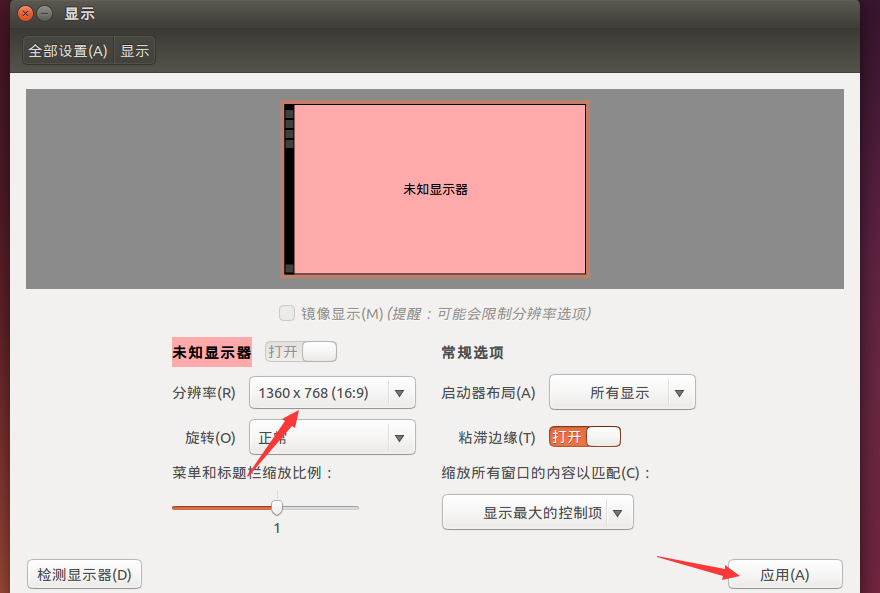

安装完毕后,重启即可,你可以在显示设置里修改屏幕分辨率

完成。

首先创建hadoop用户:

sudo useradd -m hadoop -s /bin/bash

接着使用如下命令设置密码,可简单设置为 hadoop,按提示输入两次密码:

sudo passwd hadoop

为 hadoop 用户增加管理员权限

sudo adduser hadoop sudo

然后更换为hadoop用户。

更新apt

sudo apt-get update

安装vim

sudo apt-get install vim

安装ssh,Ubuntu 默认已安装了 SSH client,我们需要安装 SSH server:

sudo apt-get install openssh-server

安装后,可以使用如下命令登陆本机

ssh localhost

此时会有如下提示(SSH首次登陆提示),输入 yes 。然后按提示输入密码 hadoop,这样就登陆到本机了。

但这样登陆是需要每次输入密码的,我们需要配置成SSH无密码登陆比较方便。

首先退出刚才的 ssh,就回到了我们原先的终端窗口,然后利用 ssh-keygen 生成密钥,并将密钥加入到授权中

exit # 退出刚才的 ssh localhost cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost ssh-keygen -t rsa # 会有提示,都按回车就可以 cat ./id_rsa.pub >> ./authorized_keys # 加入授权

接下来下载jdk和hadoop,都在官网下载,jdk:https://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

hadoop:http://mirror.bit.edu.cn/apache/hadoop/common/

网上已有的linux安装jdk的经验https://www.jianshu.com/p/c43b73e7edd8

安装好jdk后来安装hadoop

我们选择将 Hadoop 安装至 /usr/local/ 中:

sudo tar -zxf ~/下载/hadoop-2.6.0.tar.gz -C /usr/local # 解压到/usr/local中 cd /usr/local/ sudo mv ./hadoop-2.6.0/ ./hadoop # 将文件夹名改为hadoop sudo chown -R hadoop ./hadoop # 修改文件权限

Hadoop 解压后即可使用。输入如下命令来检查 Hadoop 是否可用,成功则会显示 Hadoop 版本信息:

cd /usr/local/hadoop

./bin/hadoop version

Hadoop伪分布式配置

Hadoop 的配置文件位于 /usr/local/hadoop/etc/hadoop/ 中,伪分布式需要修改2个配置文件 core-site.xml 和 hdfs-site.xml 。Hadoop的配置文件是 xml 格式,每个配置以声明 property 的 name 和 value 的方式来实现。修改配置文件 core-site.xml (通过 gedit 编辑会比较方便: gedit ./etc/hadoop/core-site.xml)

将以下内容插入到<configuration></configuration>里

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

同样地,对于hdfs-site.xml:

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

配置完成后,执行 NameNode 的格式化:

./bin/hdfs namenode -format

看到 “successfully formatted” 和 “Exitting with status 0” 的提示,表示成功

接着开启 NameNode 和 DataNode 守护进程。

./sbin/start-dfs.sh

启动完成后,可以通过命令 jps 来判断是否成功启动,若成功启动则会列出如下进程: “NameNode”、”DataNode” 和 “SecondaryNameNode”

成功启动后,可以访问 Web 界面 http://localhost:50070 查看 NameNode 和 Datanode 信息,还可以在线查看 HDFS 中的文件。

浙公网安备 33010602011771号

浙公网安备 33010602011771号