K8S ingress控制器

文章转载自:

K8S ingress控制器 (一)https://blog.51cto.com/u_13760351/2728917

K8S ingress控制器 (二)https://blog.51cto.com/u_13760351/2744342

K8S ingress控制器 (三)https://blog.51cto.com/u_13760351/2764008

K8S ingress控制器 (一)

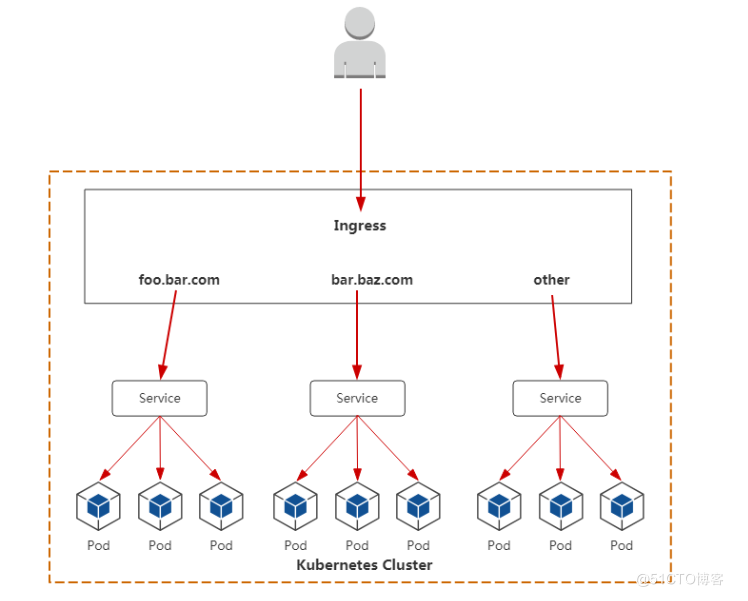

ingress controller可以为外网用户访问K8S集群内部pod提供代理服务。

提供全局访问代理

访问流程: 用户–>ingress controller–>service–>pod

ingress控制器种类:

Kubernetes Ingress Controller

参考 http://github.com/kubernetes/ingress-nginx

实现:Go/Lua(nginx 是用 C 写的)

许可证:Apache 2.0

Kubernetes 的“官方”控制器(之所以称为官方,是想把它区别于 NGINX 公司的控制器)。这是社区开发的控制器,它基于 nginx Web 服务器,并补充了一组用于实现额外功能的 Lua 插件。

由于 NGINX 十分流行,再加上把它用作控制器时所需的修改较少,它对于 K8s 普通工程师来说,可能是最简单和最直接的选择。

NGINX Ingress Controller

参考 http://github.com/nginxinc/kubernetes-ingress

实现:Go

许可证:Apache 2.0

这是 NGINX 公司开发的官方产品,它也有一个基于 NGINX Plus 的商业版。NGINX 的控制器具有很高的稳定性、持续的向后兼容性,且没有任何第三方模块。

由于消除了 Lua 代码,和官方控制器相比,它保证了较高的速度,但也因此受到较大限制。相较之下,它的付费版本有更广泛的附加功能,如实时指标、JWT 验证、主动健康检查等。

NGINX Ingress 重要的优势是对 TCP/UDP 流量的全面支持,最主要缺点是缺乏流量分配功能。

Traefik

参考 http://github.com/containous/traefik

实现:Go

许可证:MIT

最初,这个代理是为微服务请求及其动态环境的路由而创建的,因此具有许多有用的功能:连续更新配置(不重新启动)、支持多种负载均衡算法、Web UI、指标导出、对各种服务的支持协议、REST API、Canary 版本等。

支持开箱即用的 Let’s Encrypt 是它的另一个不错的功能,但它的主要缺点也很明显,就是为了控制器的高可用性,你必须安装并连接其 Key-value store。

在 2019 年 9 月发布的 Traefik v2.0 中,虽然它增加许多不错的新功能,如带有 SNI 的 TCP/SSL、金丝雀部署、流量镜像/shadowing 和经过改进的 Web UI,但一些功能(如 WAF 支持)还在策划讨论中。

与新版本同期推出的还有一个名叫 Maesh 的服务网格,它建在 Traefik 之上。

Istio Ingress

参考 http://istio.io/docs/tasks/traffic-management/ingress

实现:Go

许可证:Apache 2.0

Istio 是 IBM、Google 和 Lyft 的联合开发项目,它是一个全面的服务网格解决方案——不仅可以管理所有传入的外部流量(作为 Ingress 控制器),还可以控制集群内部的所有流量。

Istio 将 Envoy 用作每种服务的辅助代理。从本质上讲,它是一个可以执行几乎所有操作的大型处理器,其中心思想是最大程度的控制、可扩展性、安全性和透明性。

通过 Istio Ingress,你可以对流量路由、服务之间的访问授权、均衡、监控、金丝雀发布等进行优化。

Kong Ingress

参考 http://github.com/Kong/kubernetes-ingress-controller

实现:Go

许可证:Apache 2.0

Kong Ingress 由 Kong Inc 开发,有两个版本:商业版和免费版。它基于 NGINX 构建,并增加了扩展其功能的 Lua 模块。

最初,Kong Ingress 主要用作 API 网关,用于 API 请求的处理和路由。现在,它已经成为成熟的 Ingress 控制器,主要优点是拥有大量易于安装和配置的附加模块、插件(包括第三方插件)。它开启了控制器具备大量附加功能的先河,其内置函数也提供了许多可能性。Kong Ingress 配置是用 CRD 执行的。

Kong Ingress 的一个重要特性是它只能在一个环境中运行(而不支持跨命名空间)。这是一个颇有争议的话题:有些人认为这是一个缺点,因为必须为每个环境生成实例;而另一些人认为这是一个特殊特性,因为它是更高级别的隔离,控制器故障的影响仅限于其所在的环境。

HAProxy Ingress

参考 http://github.com/jcmoraisjr/haproxy-ingress

实现:Go(HAProxy 是用 C 写的)

许可证:Apache 2.0

HAProxy 是众所周知的代理服务器和负载均衡器。作为 Kubernetes 集群的一部分,它提供了“软”配置更新(无流量损失)、基于 DNS 的服务发现和通过 API 进行动态配置。 HAProxy 还支持完全自定义配置文件模板(通过替换 ConfigMap)以及在其中使用 Spring Boot 函数。

通常,工程师会把重点放在已消耗资源的高速、优化和效率上。而 HAProxy 的优点之一正是支持大量负载均衡算法。值得一提的是,在今年 6 月发布的 v2.0 中,HAProxy 增加了许多新功能,其即将推出的 v2.1 有望带来更多新功能(包括 OpenTracing 支持)。

Voyager

参考 http://github.com/appscode/voyager

实现:Go

许可证:Apache 2.0

Voyager 基于 HAProxy,并作为一个通用的解决方案提供给大量供应商。它最具代表性的功能包括 L7 和 L4 上的流量负载均衡,其中,TCP L4 流量负载均衡称得上是该解决方案最关键的功能之一。

在今年早些时候,尽管 Voyager 在 v9.0.0 中推出了对 HTTP/2 和 gRPC 协议的全面支持,但总的来看,对证书管理(Let’s Encrypt 证书)的支持仍是 Voyager 集成的最突出的新功能。

Contour

参考 http://github.com/heptio/contour

实现:Go

许可证:Apache 2.0

Contour 和 Envoy 由同一个作者开发,它基于 Envoy。它最特别的功能是可以通过 CRD(Ingreoute)管理 Ingress 资源,对于多团队需要同时使用一个集群的组织来说,这有助于保护相邻环境中的流量,使它们免受 Ingress 资源更改的影响。

它还提供了一组扩展的负载均衡算法(镜像、自动重复、限制请求率等),以及详细的流量和故障监控。对某些工程师而言,它不支持粘滞会话可能是一个严重缺陷。

Ambassador

参考 http://github.com/datawire/ambassador

实现:Python

许可证:Apache 2.0

Ambassador 也是一个基于 Envoy 的解决方案,它有免费版和商业版两个版本。

Ambassador 被称为“Kubernetes 原生 API 微服务网关”,它与 K8s 原语紧密集成,拥有你所期望的从 Ingress controller 获得的功能包,它还可以与各种服务网格解决方案,如 Linkerd、Istio 等一起使用。

顺便提一下,Ambassador 博客日前发布了一份基准测试结果,比较了 Envoy、HAProxy 和 NGINX 的基础性能。

Gloo

参考 http://github.com/solo-io/gloo

实现:Go

许可证:Apache 2.0

Gloo 是在 Envoy 之上构建的新软件(于 2018 年 3 月发布),由于它的作者坚持认为“网关应该从功能而不是服务中构建 API”,它也被称为“功能网关”。其“功能级路由”的意思是它可以为后端实现是微服务、无服务器功能和遗留应用的混合应用路由流量。

由于拥有可插拔的体系结构,Gloo 提供了工程师期望的大部分功能,但是其中一些功能仅在其商业版本(Gloo Enterprise)中可用。

Skipper

参考 http://github.com/zalando/skipper

实现:Go

许可证:Apache 2.0

Skipper 是 HTTP 路由器和反向代理,因此不支持各种协议。从技术上讲,它使用 Endpoints API(而不是 Kubernetes Services)将流量路由到 Pod。它的优点在于其丰富的过滤器集所提供的高级 HTTP 路由功能,工程师可以借此创建、更新和删除所有 HTTP 数据。

Skipper 的路由规则可以在不停机的情况下更新。正如它的作者所述,Skipper 可以很好地与其他解决方案一起使用,比如 AWS ELB。

K8S ingress控制器 (二)

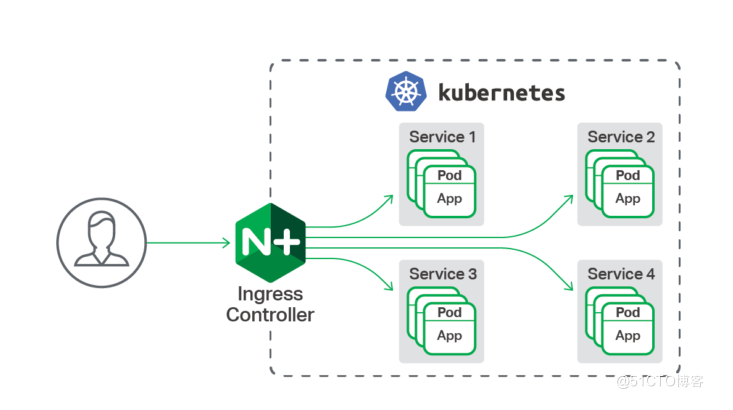

nginx ingress controller

参考链接:https://www.nginx.com/products/nginx/kubernetes-ingress-controller

一、nginx ingress controller部署

项目地址:https://github.com/kubernetes/ingress-nginx

安装文档地址: https://github.com/kubernetes/ingress-nginx/blob/nginx-0.30.0/docs/deploy/index.md

1.下载并修改配置文件

wget https://raw.githubusercontent.com/kubernetes/ingress-nginx/nginx-0.30.0/deploy/static/mandatory.yaml

apiVersion: v1

kind: Namespace

metadata:

name: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

---

kind: ConfigMap

apiVersion: v1

metadata:

name: nginx-configuration

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

---

kind: ConfigMap

apiVersion: v1

metadata:

name: tcp-services

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

---

kind: ConfigMap

apiVersion: v1

metadata:

name: udp-services

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

---

apiVersion: v1

kind: ServiceAccount

metadata:

name: nginx-ingress-serviceaccount

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

---

apiVersion: rbac.authorization.k8s.io/v1beta1

kind: ClusterRole

metadata:

name: nginx-ingress-clusterrole

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

rules:

- apiGroups:

- ""

resources:

- configmaps

- endpoints

- nodes

- pods

- secrets

verbs:

- list

- watch

- apiGroups:

- ""

resources:

- nodes

verbs:

- get

- apiGroups:

- ""

resources:

- services

verbs:

- get

- list

- watch

- apiGroups:

- ""

resources:

- events

verbs:

- create

- patch

- apiGroups:

- "extensions"

- "networking.k8s.io"

resources:

- ingresses

verbs:

- get

- list

- watch

- apiGroups:

- "extensions"

- "networking.k8s.io"

resources:

- ingresses/status

verbs:

- update

---

apiVersion: rbac.authorization.k8s.io/v1beta1

kind: Role

metadata:

name: nginx-ingress-role

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

rules:

- apiGroups:

- ""

resources:

- configmaps

- pods

- secrets

- namespaces

verbs:

- get

- apiGroups:

- ""

resources:

- configmaps

resourceNames:

- "ingress-controller-leader-nginx"

verbs:

- get

- update

- apiGroups:

- ""

resources:

- configmaps

verbs:

- create

- apiGroups:

- ""

resources:

- endpoints

verbs:

- get

---

apiVersion: rbac.authorization.k8s.io/v1beta1

kind: RoleBinding

metadata:

name: nginx-ingress-role-nisa-binding

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: Role

name: nginx-ingress-role

subjects:

- kind: ServiceAccount

name: nginx-ingress-serviceaccount

namespace: ingress-nginx

---

apiVersion: rbac.authorization.k8s.io/v1beta1

kind: ClusterRoleBinding

metadata:

name: nginx-ingress-clusterrole-nisa-binding

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: nginx-ingress-clusterrole

subjects:

- kind: ServiceAccount

name: nginx-ingress-serviceaccount

namespace: ingress-nginx

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-ingress-controller

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

spec:

replicas: 1

selector:

matchLabels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

template:

metadata:

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

annotations:

prometheus.io/port: "10254"

prometheus.io/scrape: "true"

spec:

terminationGracePeriodSeconds: 300

hostNetwork: true # 需要添加这句,使用主机网络

serviceAccountName: nginx-ingress-serviceaccount

nodeSelector:

kubernetes.io/os: linux

containers:

- name: nginx-ingress-controller

image: quay.io/kubernetes-ingress-controller/nginx-ingress-controller:0.30.0

args:

- /nginx-ingress-controller

- --configmap=$(POD_NAMESPACE)/nginx-configuration

- --tcp-services-configmap=$(POD_NAMESPACE)/tcp-services

- --udp-services-configmap=$(POD_NAMESPACE)/udp-services

- --publish-service=$(POD_NAMESPACE)/ingress-nginx

- --annotations-prefix=nginx.ingress.kubernetes.io

securityContext:

allowPrivilegeEscalation: true

capabilities:

drop:

- ALL

add:

- NET_BIND_SERVICE

runAsUser: 101

env:

- name: POD_NAME

valueFrom:

fieldRef:

fieldPath: metadata.name

- name: POD_NAMESPACE

valueFrom:

fieldRef:

fieldPath: metadata.namespace

ports:

- name: http

containerPort: 80

protocol: TCP

- name: https

containerPort: 443

protocol: TCP

livenessProbe:

failureThreshold: 3

httpGet:

path: /healthz

port: 10254

scheme: HTTP

initialDelaySeconds: 10

periodSeconds: 10

successThreshold: 1

timeoutSeconds: 10

readinessProbe:

failureThreshold: 3

httpGet:

path: /healthz

port: 10254

scheme: HTTP

periodSeconds: 10

successThreshold: 1

timeoutSeconds: 10

lifecycle:

preStop:

exec:

command:

- /wait-shutdown

---

apiVersion: v1

kind: LimitRange

metadata:

name: ingress-nginx

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

spec:

limits:

- min:

memory: 90Mi

cpu: 100m

type: Container

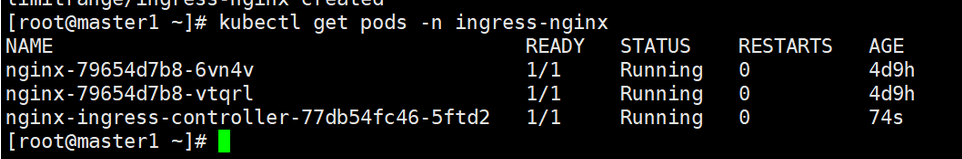

2.应用配置文件

kubectl apply -f mandatory.yaml

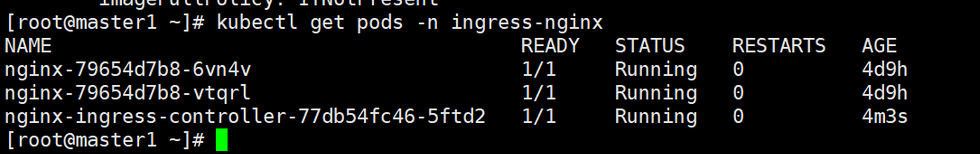

验证部署结果,注意镜像较大,可提前下载至集群node节点中。

kubectl get pods -n ingress-nginx

hostNetwork: true的补充说明:

此参数为true表示pod使用主机网络,也就是pod的IP就是node的IP

但同一个deployment里的pod副本数如果为2或越过2,在同一个node上只能启一个pod *

# vim deployment-nginx.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: deploy-nginx

spec:

replicas: 2 # 副本数为2

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

hostNetwork: true # 加上这一句

containers:

- name: c1

image: nginx:1.15-alpine

kubectl apply -f deployment-nginx.yaml

kubectl get pods -o wide

可以看到pod-IP就是node-IP,而且只能启动成功一个副本

二、ingress-http案例

1.创建deployment

# vim nginx.yml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx

namespace: ingress-nginx

spec:

replicas: 2

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: c1

image: nginx:1.15-alpine

imagePullPolicy: IfNotPresent

2.应用YAML

kubectl create namespace ingress-nginx

kubectl apply -f nginx.yml

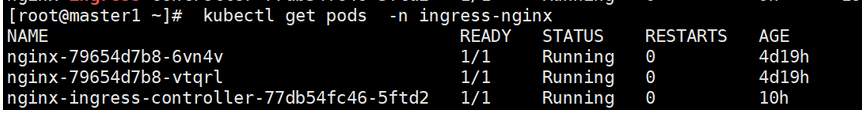

3.验证pod

kubectl get pods -n ingress-nginx

4.创建service

# vim nginx-service.yml

apiVersion: v1

kind: Service

metadata:

name: nginx-service

namespace: ingress-nginx

labels:

app: nginx

spec:

ports:

- port: 80

targetPort: 80

selector:

app: nginx

5.应用YAML

kubectl apply -f nginx-service.yml

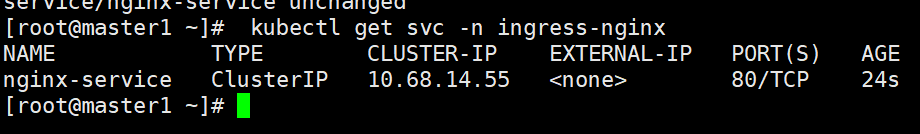

6.验证service

kubectl get svc -n ingress-nginx

7.创建ingress

# vim ingress-nginx.yaml

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: ingress-nginx #自定义ingress名称

namespace: ingress-nginx

spec:

rules:

- host: www.daniel.com # 自定义域名

http:

paths:

- backend:

serviceName: nginx-service # 对应上面创建的service名称

servicePort: 80

8.应用YAML

kubectl apply -f ingress-nginx.yaml

9.验证ingress

kubectl get ingress -n ingress-nginx

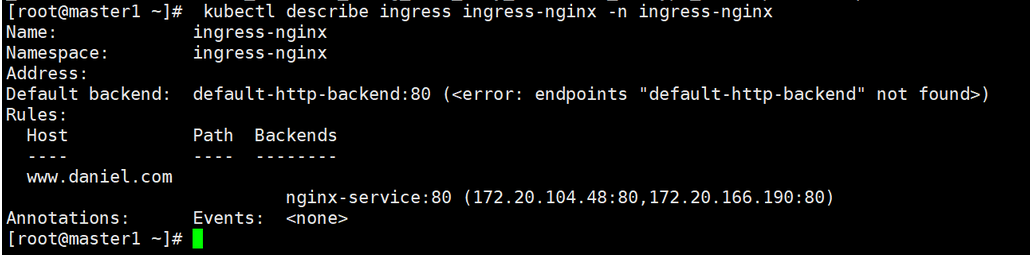

查看ingress信息

kubectl describe ingress ingress-nginx -n ingress-nginx

nginx-service:80 (172.20.104.48:80,172.20.166.190:80) 与下面查询的两个pod的IP对应

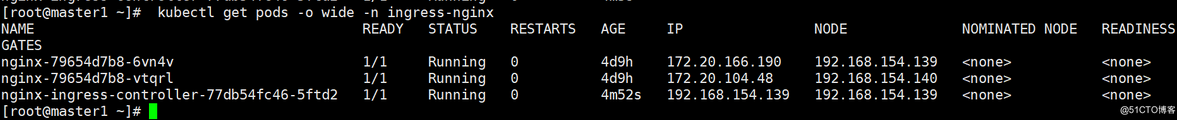

kubectl get pods -o wide -n ingress-nginx

可以看到两个pod的IP正好对应ingress域名对应的IP

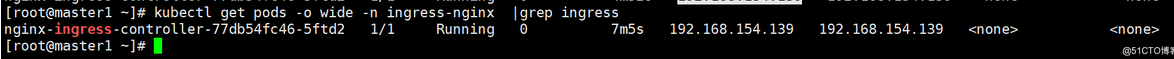

确认nginx-ingress-controller的podIP为192.168.154.139

模拟客户端访问

1, 确认nginx-ingress-controller的podIP,

下面命令查询的结果为192.168.154.139

kubectl get pods -o wide -n ingress-nginx |grep ingress

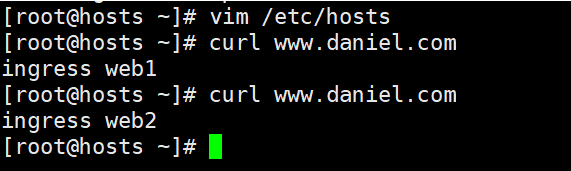

2, 在集群之外任一主机中(我这里为hostos)添加上述域名与IP地址解析(模拟公网DNS)

[root@hostos ~]# vim /etc/hosts

192.168.154.139 www.daniel.com

3, 准备pod内容器运行的web主页

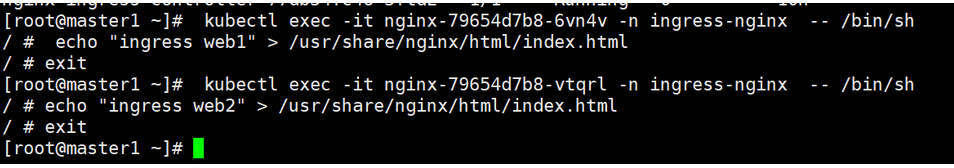

kubectl get pods -n ingress-nginx

kubectl exec -it nginx-79654d7b8-6vn4v -n ingress-nginx -- /bin/sh

/ # echo "ingress web1" > /usr/share/nginx/html/index.html

/ # exit

kubectl exec -it nginx-79654d7b8-vtqrl -n ingress-nginx -- /bin/sh

/ # echo "ingress web2" > /usr/share/nginx/html/index.html

/ # exit

4, 访问及结果展示

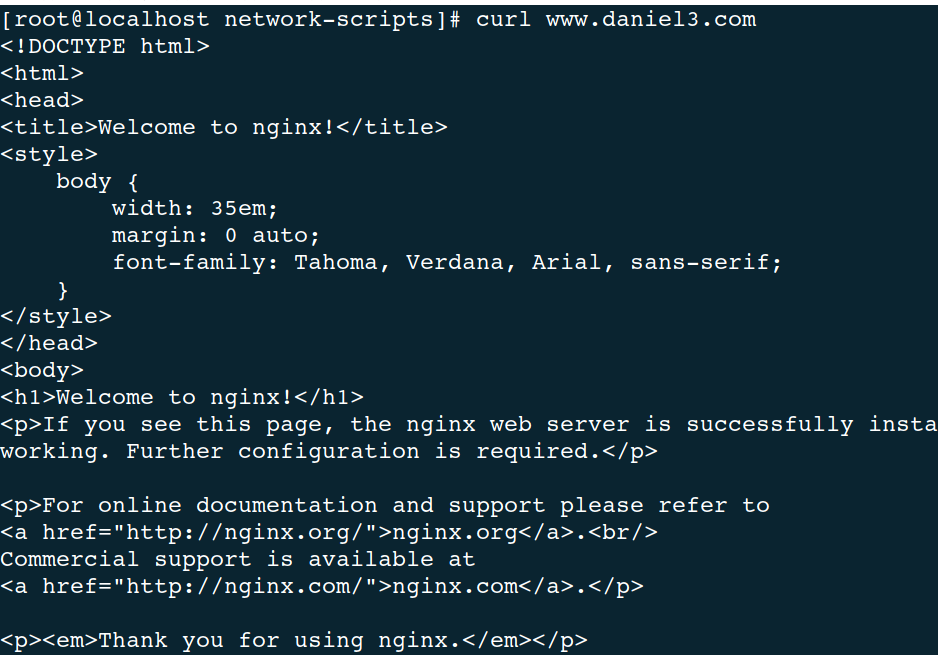

[root@hostos ~]# curl www.daniel.com

三、 ingress-https案例

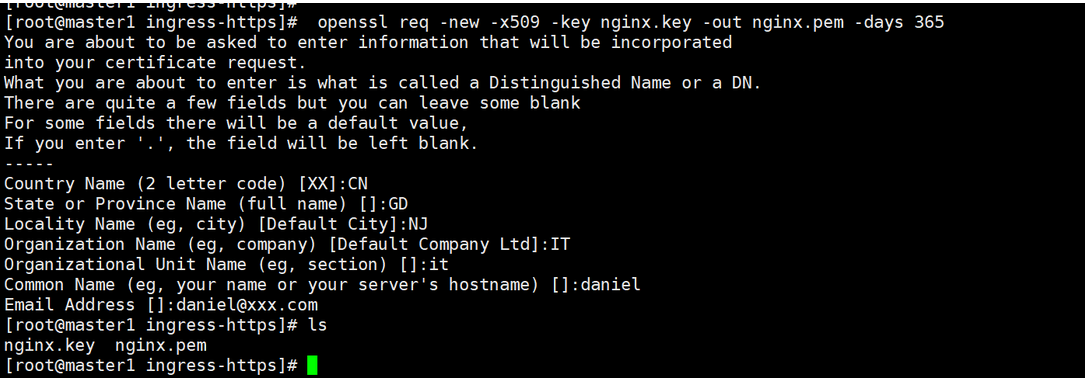

1.创建自签证书

mkdir ingress-https

cd ingress-https/

openssl genrsa -out nginx.key 2048

openssl req -new -x509 -key nginx.key -out nginx.pem -days 365

ls

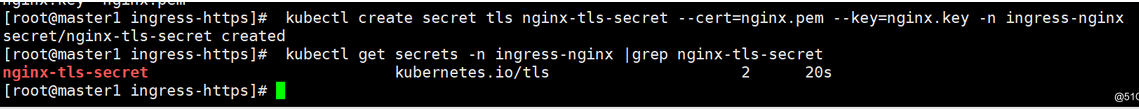

2.将证书创建成secret

kubectl create secret tls nginx-tls-secret --cert=nginx.pem --key=nginx.key -n ingress-nginx

kubectl get secrets -n ingress-nginx |grep nginx-tls-secret

3.编排YAML并创建

# vim ingress-https.yml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx2

namespace: ingress-nginx

spec:

replicas: 2

selector:

matchLabels:

app: nginx2

template:

metadata:

labels:

app: nginx2

spec:

containers:

- name: c1

image: nginx:1.15-alpine

imagePullPolicy: IfNotPresent

ports:

- name: http

containerPort: 80

- name: https

containerPort: 443

---

apiVersion: v1

kind: Service

metadata:

name: nginx-service2

namespace: ingress-nginx

labels:

app: nginx2

spec:

ports:

- name: http

port: 80

targetPort: 80

- name: https

port: 443

targetPort: 443

selector:

app: nginx2

---

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: ingress-nginx2

namespace: ingress-nginx

spec:

tls:

- hosts:

- www.daniel2.com # 域名

secretName: nginx-tls-secret # 调用前面创建的secret

rules:

- host: www.daniel2.com # 域名

http:

paths:

- backend:

serviceName: nginx-service2 # 对应服务名

servicePort: 80

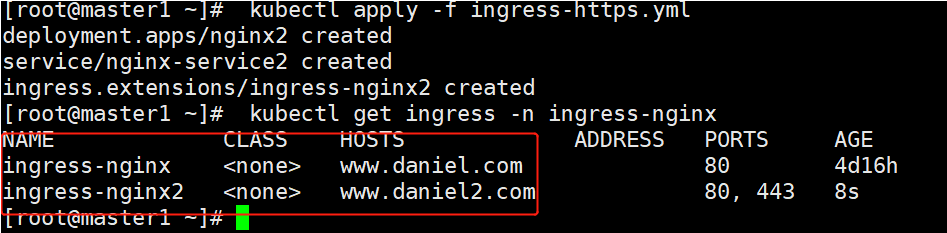

kubectl apply -f ingress-https.yml

4.验证

kubectl get ingress -n ingress-nginx

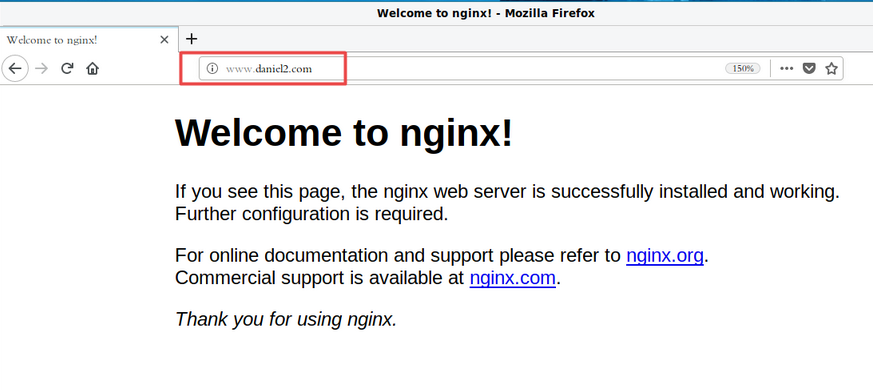

5.模拟客户端访问

[root@hostos ~]# vim /etc/hosts

192.168.154.139 www.daniel2.com 添加这行模拟DNS

[root@hostos ~]# firefox https://www.daniel2.com &

四、ingress+nodeport服务

# vim ingress-nodeport.yml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx3

namespace: ingress-nginx

spec:

replicas: 2

selector:

matchLabels:

app: nginx3

template:

metadata:

labels:

app: nginx3

spec:

containers:

- name: c1

image: nginx:1.15-alpine

imagePullPolicy: IfNotPresent

---

apiVersion: v1

kind: Service

metadata:

name: nginx-service3

namespace: ingress-nginx

labels:

app: nginx3

spec:

type: NodePort # NodePort类型服务

ports:

- port: 80

targetPort: 80

selector:

app: nginx3

---

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: ingress-nginx3

namespace: ingress-nginx

spec:

rules:

- host: www.daniel3.com

http:

paths:

- backend:

serviceName: nginx-service3

servicePort: 80

kubectl apply -f ingress-nodeport.yml

kubectl get svc -n ingress-nginx

nginx-service3是nodeport类型

[root@hostos ~]# vim /etc/hosts

192.168.154.139 www.daniel3.com 添加这行模拟DNS

[root@hostos ~]# curl www.daniel3.com

[root@hostos ~]# curl www.daniel3.com

K8S ingress控制器 (三)

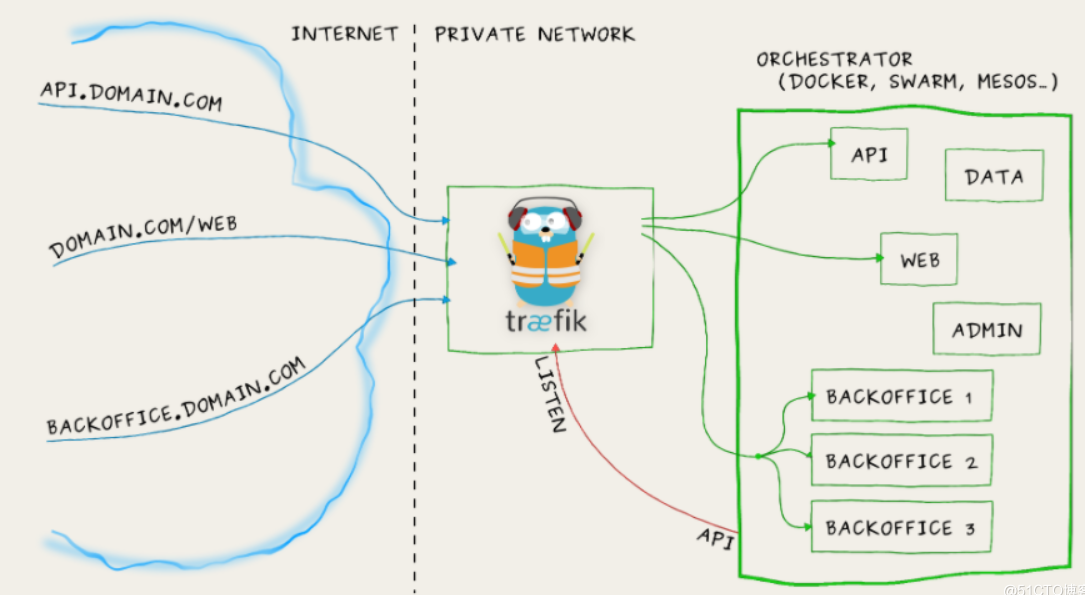

认识traefik

参考: https://traefik.cn/

是一个为了让部署微服务更加便捷而诞生的现代HTTP反向代理、负载均衡工具。 它支持多种后台 (Docker, Swarm, Kubernetes, Marathon, Mesos, Consul, Etcd, Zookeeper, BoltDB, Rest API, file…) 来自动化、动态的应用它的配置文件设置。

traefik部署

mkdir traefik/

cd traefik/

# 编排ConfigMap

# vim traefik-config.yaml

apiVersion: v1

kind: ConfigMap

metadata:

name: traefik-config

namespace: kube-system

data:

traefik.toml: |

defaultEntryPoints = ["http","https"]

debug = false

logLevel = "INFO"

InsecureSkipVerify = true

[entryPoints]

[entryPoints.http]

address = ":80"

compress = true

[entryPoints.https]

address = ":443"

[entryPoints.https.tls]

address = ":8080"

[kubernetes]

[metrics]

[metrics.prometheus]

buckets=[0.1,0.3,1.2,5.0]

entryPoint = "traefik"

[ping]

entryPoint = "http"

# 编排SA与DaemonSet

# vim traefik-ds.yaml

apiVersion: v1

kind: ServiceAccount

metadata:

name: traefik-ingress-controller

namespace: kube-system

---

kind: DaemonSet

apiVersion: apps/v1

metadata:

name: traefik-ingress-controller-v2

namespace: kube-system

labels:

k8s-app: traefik-ingress-lb

spec:

selector:

matchLabels:

name: traefik-ingress-lb-v2

template:

metadata:

labels:

k8s-app: traefik-ingress-lb

name: traefik-ingress-lb-v2

spec:

serviceAccountName: traefik-ingress-controller

terminationGracePeriodSeconds: 60

containers:

- image: traefik:2.1.6

name: traefik-ingress-lb-v2

ports:

- name: http

containerPort: 80

hostPort: 80

- name: admin

containerPort: 8080

hostPort: 8080

securityContext:

capabilities:

drop:

- ALL

add:

- NET_BIND_SERVICE

args:

- --api

- --api.insecure=true

- --providers.kubernetesingress=true

- --log.level=INFO

volumes:

- configMap:

name: traefik-config

name: config

---

kind: Service

apiVersion: v1

metadata:

name: traefik-ingress-service-v2

namespace: kube-system

labels:

k8s-app: traefik-ingress-lb-v2

spec:

selector:

k8s-app: traefik-ingress-lb-v2

ports:

- protocol: TCP

port: 80

name: web

- protocol: TCP

port: 8080

name: admin

# 编排rbac

# vim traefik-rbac.yaml

kind: ClusterRole

apiVersion: rbac.authorization.k8s.io/v1beta1

metadata:

name: traefik-ingress-controller

rules:

- apiGroups:

- ""

resources:

- services

- endpoints

- secrets

verbs:

- get

- list

- watch

- apiGroups:

- extensions

resources:

- ingresses

verbs:

- get

- list

- watch

- apiGroups:

- extensions

resources:

- ingresses/status

verbs:

- update

---

kind: ClusterRoleBinding

apiVersion: rbac.authorization.k8s.io/v1beta1

metadata:

name: traefik-ingress-controller

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: traefik-ingress-controller

subjects:

- kind: ServiceAccount

name: traefik-ingress-controller

namespace: kube-system

# 编排dashborad

# vim traefik-dashboard.yaml

apiVersion: v1

kind: Service

metadata:

name: traefik-web-ui

namespace: kube-system

spec:

selector:

k8s-app: traefik-ingress-lb

ports:

- name: web

port: 80

targetPort: 8080

---

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: traefik-web-ui

namespace: kube-system

spec:

rules:

- host: traefik-daniel.com # 这里换成自己的域名(实验环境模拟一个就OK)

http:

paths:

- path: /

backend:

serviceName: traefik-web-ui

servicePort: 80

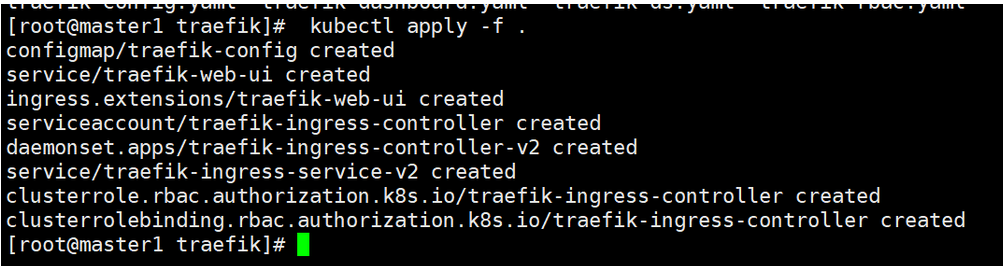

# 应用YAML

# kubectl apply -f .

# 验证

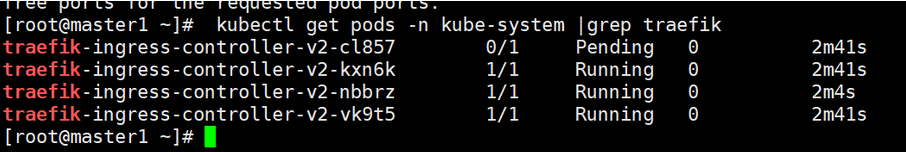

# kubectl get pods -n kube-system |grep traefik

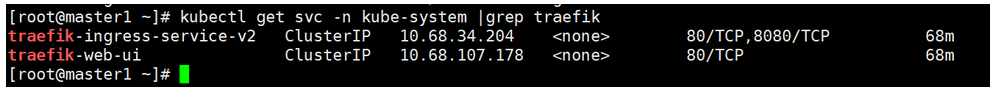

# kubectl get svc -n kube-system |grep traefik

# 访问

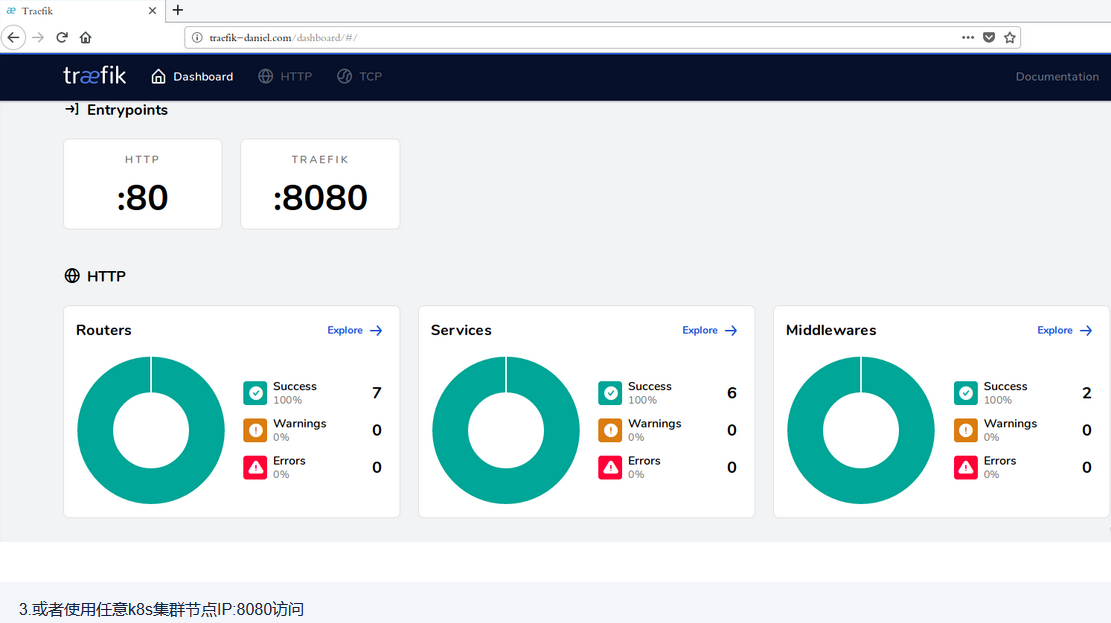

1.用宿主机模拟客户端

vim /etc/hosts

192.168.154.139 traefik-daniel.com # 添加域名与任意k8s集群节点的绑定

2.客户端firefox访问traefik-daniel.com

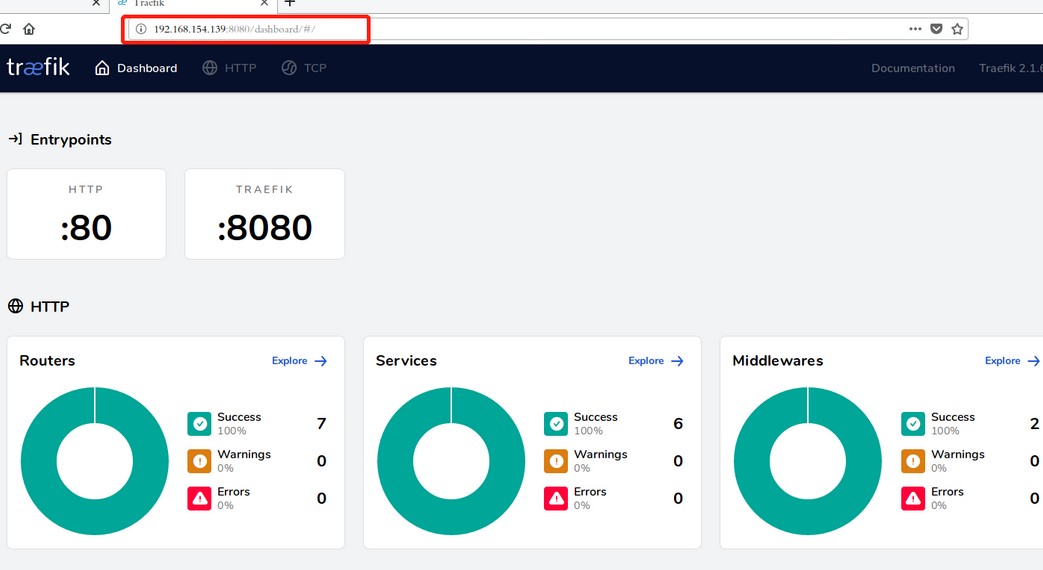

# 3.或者使用任意k8s集群节点IP:8080访问