ollama 安装 HuggingFace 上的模型

HuggingFace 是全球最大的模型托管平台厂商。上面有很多私人炼丹后的模型,当需要在 ollama 中使用这些模型时就需要安装到 ollama 中。

一、HuggingFace 网址

国外站点: https://huggingface.co/models

国内 huggingface 镜像:https://hf-mirror.com/models

二、ollama 安装 高效本地推理格式(GGUF)模型

ollama 可以直接安装 HuggingFace 上的 GGUF 格式的模型。

1、在 HuggingFace 上搜索需要安装的模型

例如: Llama-3.2-1B-Instruct-GGUF

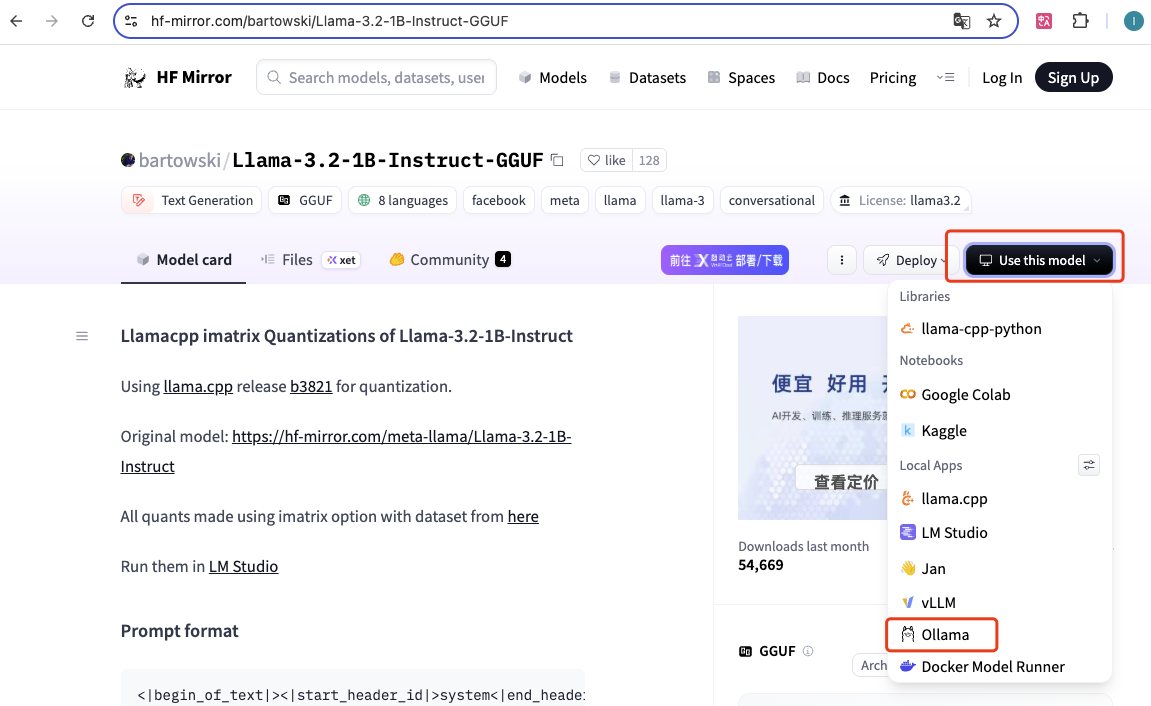

2、点击 Use this model 查看是否支持 ollama

3、点击 ollama,点击 copy,复制运行命令

4、在命令行中执行如下命令安装模型

ollama run hf.co/bartowski/Llama-3.2-1B-Instruct-GGUF:Q4_K_M

三、ollama 安装通用二进制格式(.bin)模型

huggingface 上的有些模型作者没有上传 GGUF 格式模型,不能直接在 ollama 中安装。

整体的方式是将 bin 格式模型转换为 GGUF 格式模型然后在安装到 ollama。

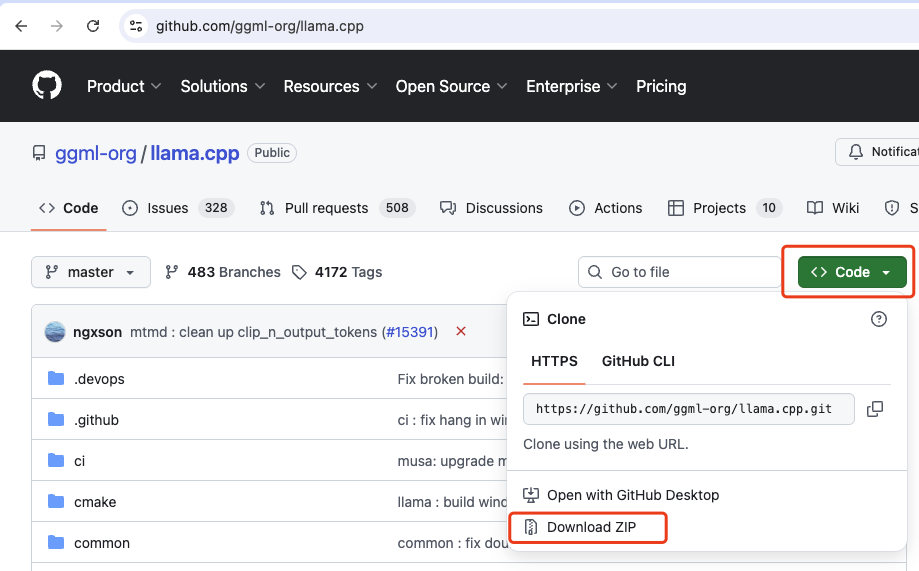

1、安装 llama.cpp

克隆官方仓库并进入项目目录:

git clone https://github.com/ggerganov/llama.cpp cd llama.cpp

也可以直接下载 zip 包。

2、安装 Python 依赖。

pip install -r requirements.txt

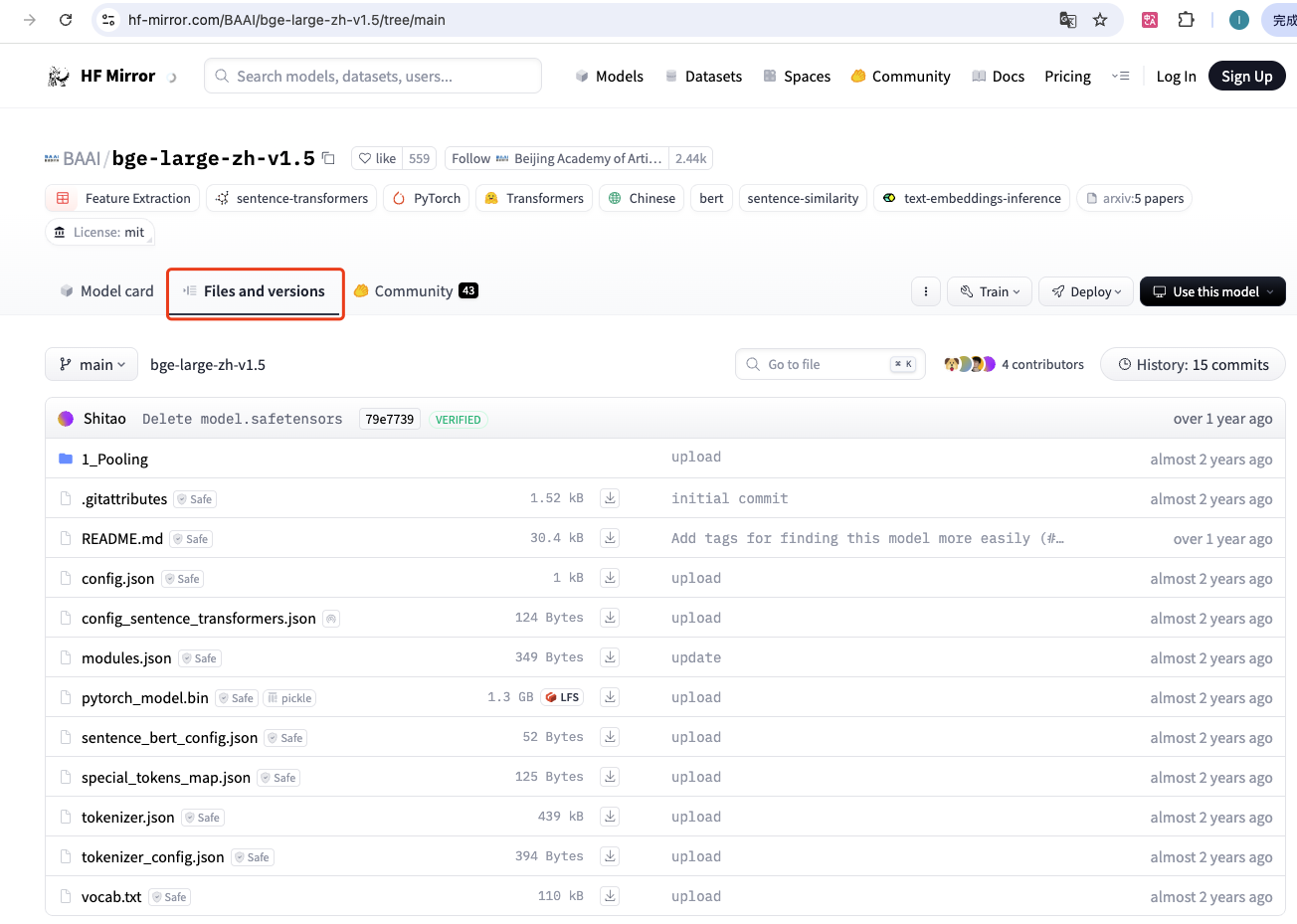

3、从 HuggingFace 网站下载对应模型文件

例如: bge-large-zh-v1.5

A)手动下载模型文件

下载如下6个文件:

pytorch_model.bin config.json tokenizer.json tokenizer_config.json vocab.txt special_tokens_map.json

下载后如下图:

B)脚本下载模型文件

由于手动下载可能会下载错误,所以可以使用如下 python 脚本下载模型,python 代码如下:

其中:

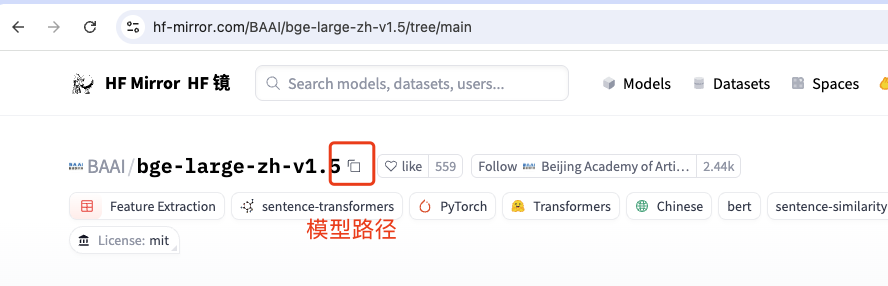

repo_id:替换成模型路径

local_dir:替换为模型下载后的保存目录

from huggingface_hub import hf_hub_download

# 下载必要的模型文件

files_to_download = [

'pytorch_model.bin',

'config.json',

'tokenizer.json',

'tokenizer_config.json',

'vocab.txt',

'special_tokens_map.json'

]

for filename in files_to_download:

try:

hf_hub_download(

repo_id = 'BAAI/bge-large-zh-v1.5',

filename = filename,

local_dir = '/Users/rslai/Desktop/bge-large-zh-v1'

)

print(f"Downloaded {filename}")

except Exception as e:

print(f"Failed to download {filename}: {e}")

运行 pythone 下载模型文件:

A)将如上代码保存为 download_model.py

B)进入 python3 虚拟环境,安装 python 虚拟环境参见:https://www.cnblogs.com/rslai/p/18741276

C)安装 python 依赖: pip install huggingface_hub

D)运行 python 文件下载模型 python download_model.py

4、将 bin 格式模型转换为 GGUF 格式

其中:

/Users/rslai/Desktop/bge-large-zh-v1:是上步下载模型保存的目录

/Users/rslai/Desktop/out:是转换成 GGUF 格式后的文件保存目录

python convert_hf_to_gguf.py /Users/rslai/Desktop/bge-large-zh-v1 --outfile /Users/rslai/Desktop/out

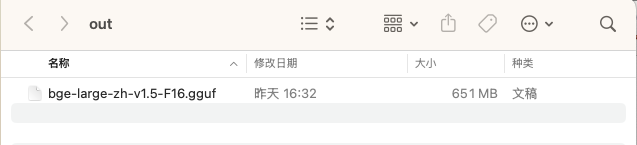

转换后如下图:

注意:虽然之前安装过 llama.cpp 的 python 依赖,但也有可能提示没有安装的依赖包,根据提示安装即可。

5、使用 Modelfile 加载模型

A)创建 Modelfile.mf 文件

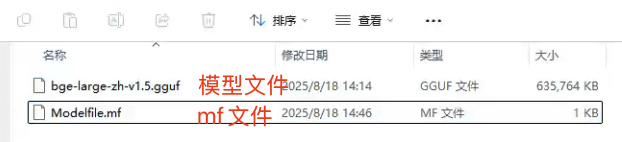

如下图:

B)文件中添加,其中 bge-large-zh-v1.5.gguf 是模型名称

FROM ./bge-large-zh-v1.5.gguf

如下图:

C)导入模型文件。进入对应目录后执行如下命令

ollama create bge-large-zh-v1.5 -f ./Modelfile.mf

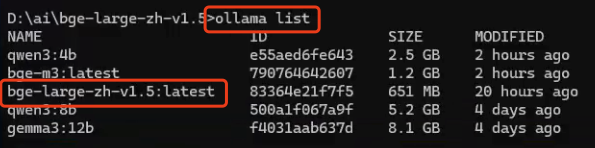

D)执行 ollama list 显示刚导入的模型

四、ollama 安装 新型安全模型存储格式(.safetensors)模型

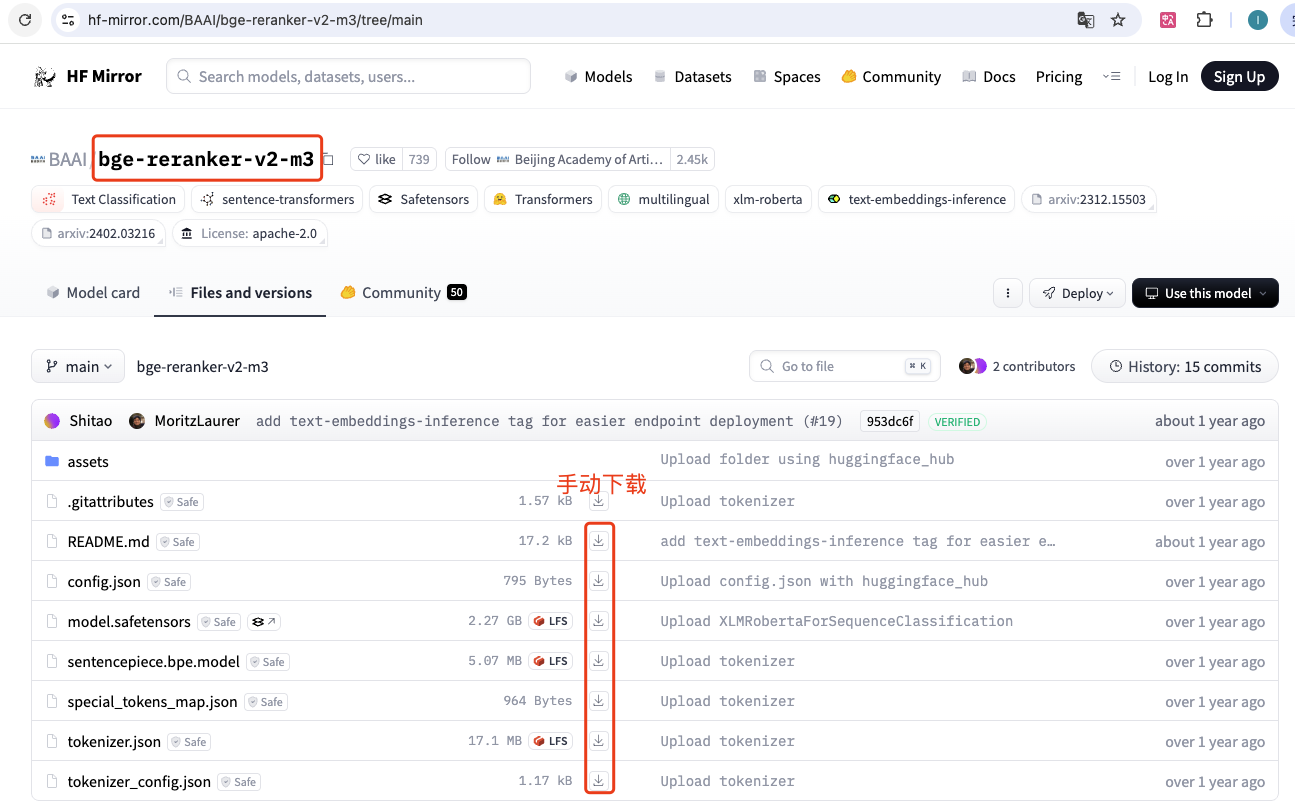

1、从 HuggingFace 网站下载对应模型文件

可以修改以上脚本自动下载模型,或者按上图点击下载按钮,手动下载模型文件,注意为避免错误尽量都下载。

2、将 safetensors 格式模型转换为 GGUF 格式

- /Users/rslai/Desktop/bge-reranker-v2-m3/: 是下载模型的存放路径

- /Users/rslai/Desktop/e/bge-reranker-v2-m3.gguf: 是转为 gguf 格式后模型的存放位置及文件名

python convert_hf_to_gguf.py /Users/rslai/Desktop/bge-reranker-v2-m3 --outfile /Users/rslai/Desktop/e/bge-reranker-v2-m3.gguf

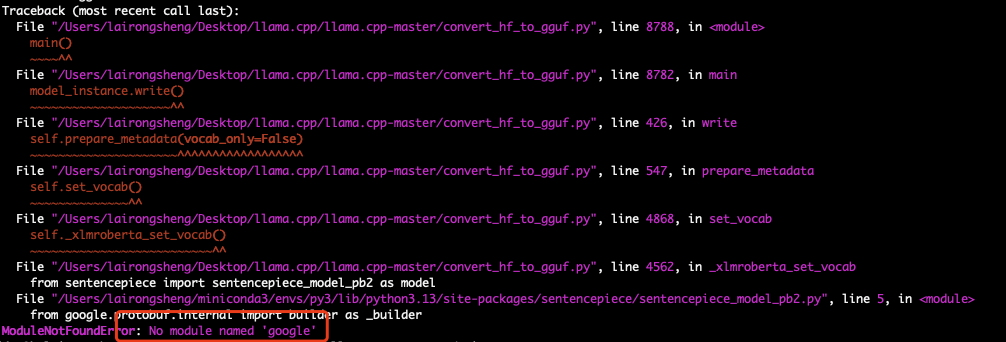

注意:我这里执行转换时报错如下图,原因是没有安装 google 模块

执行以下命令安装 google 模块。安装后重新执行转换命令即可。

pip install google-api-python-client

.ckpt : PyTorch Lightning 框架采用的模型存储格式

.pth PyTorch 的标准模型保存格式

参考文档:

浙公网安备 33010602011771号

浙公网安备 33010602011771号