用 n8n 和 LangBot 打造跨平台 AI 聊天机器人

把 n8n 的可视化工作流与 LangBot 的多平台机器人框架结合起来,可以快速部署覆盖 QQ、微信、Discord、Telegram、Slack 等多个平台的 AI 聊天机器人,无需编写代码。本文教你几分钟内完成集成。

准备工作

- Python 3.11+

- Node.js 22+

- npm 或 npx

- 15 分钟时间

三条命令部署 LangBot

LangBot 是一个生产级机器人框架,支持连接多个消息平台和 AI 服务,包括 Dify、FastGPT、Coze、OpenAI、Claude 和 Gemini。快速部署:

cd your-workspace

mkdir -p langbot-instance && cd langbot-instance

uvx langbot@latest

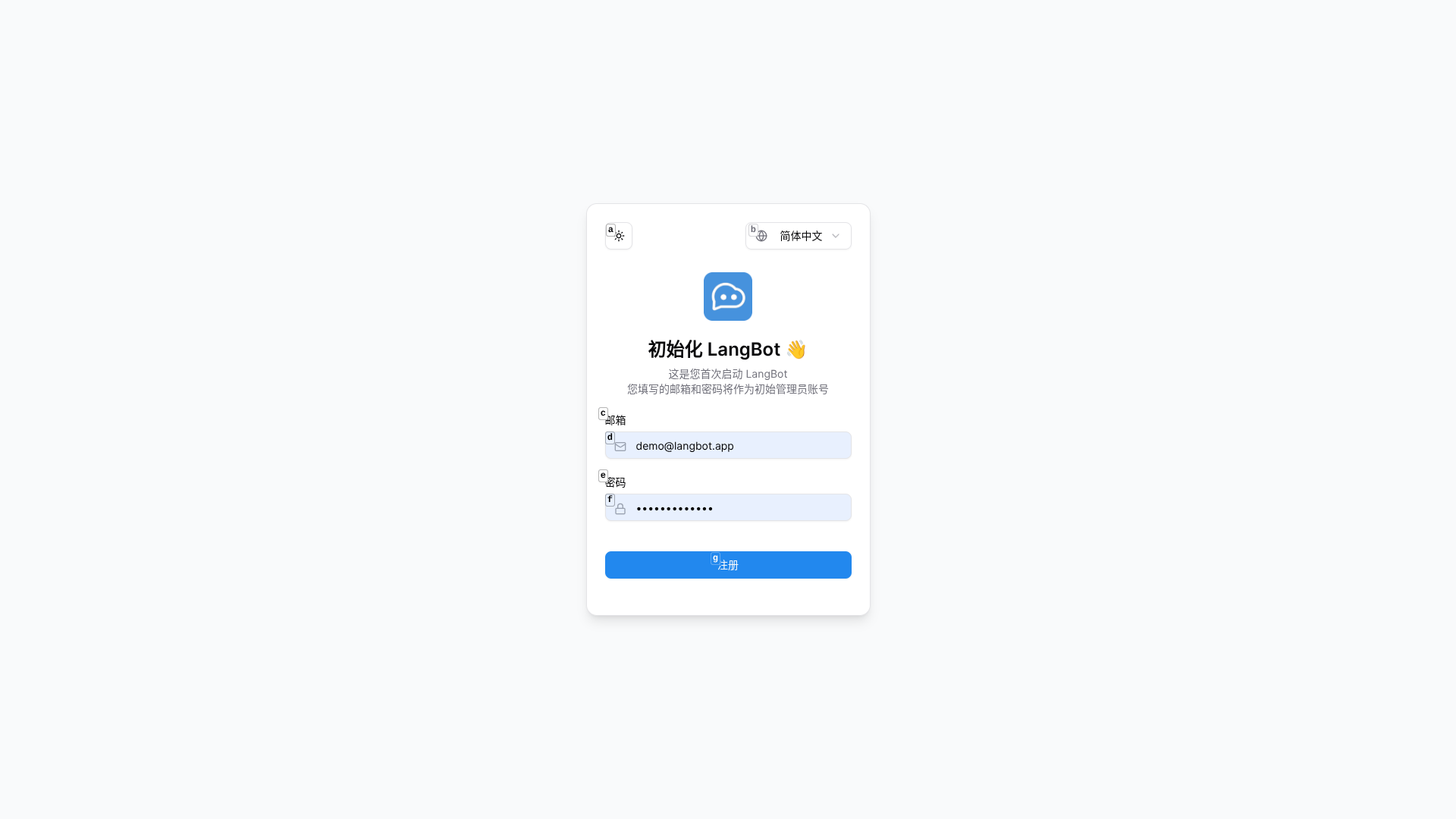

首次启动时,LangBot 会自动初始化。在浏览器打开 http://127.0.0.1:5300。

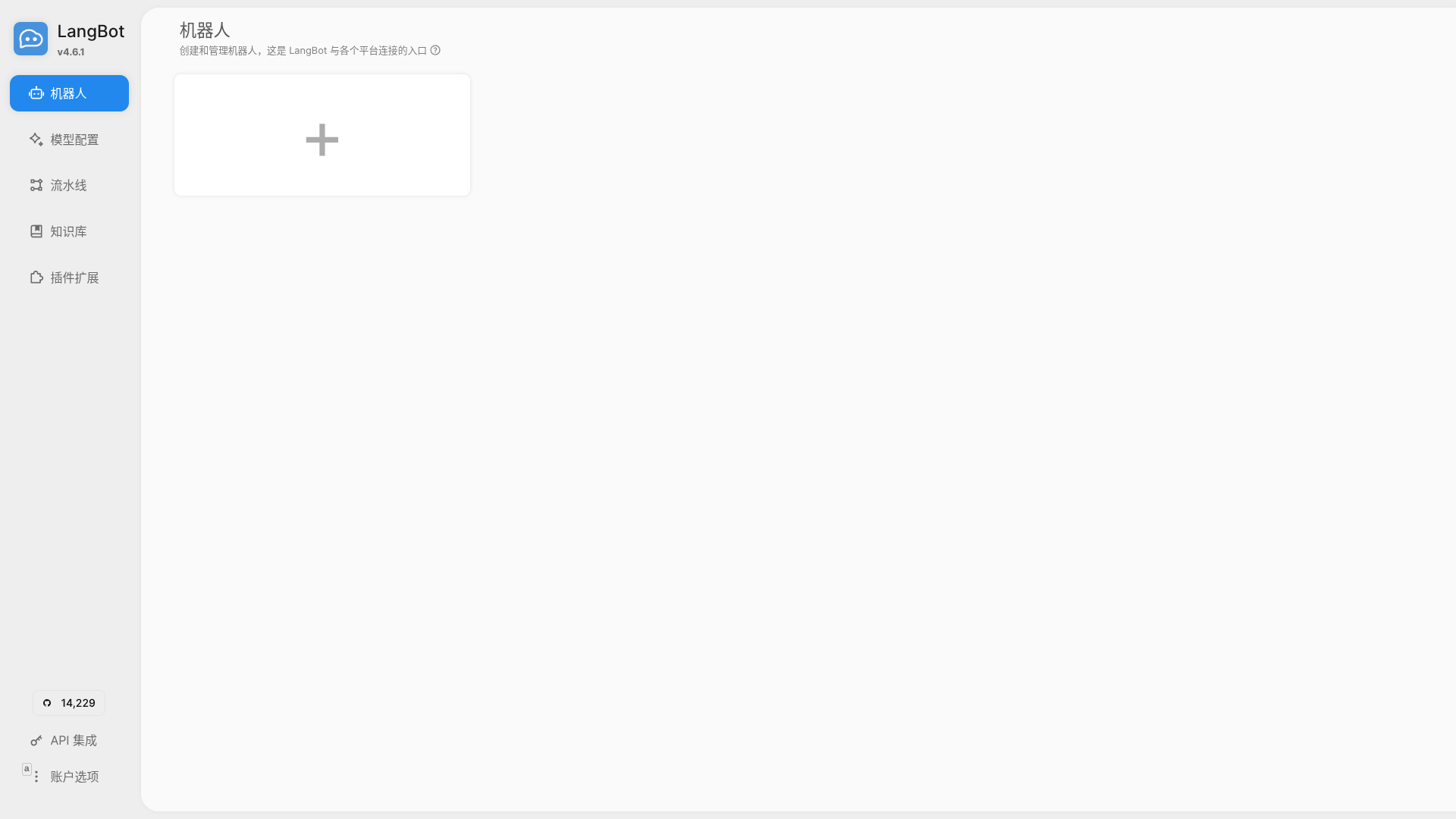

按提示注册管理员账号。进入控制面板后,你可以管理机器人、模型、流水线和集成。

部署 n8n 工作流自动化平台

n8n 是一个开源自动化平台,拥有 400+ 集成和强大的 AI 能力。本地启动:

cd your-workspace

mkdir -p n8n-data

export N8N_USER_FOLDER=$(pwd)/n8n-data

npx n8n

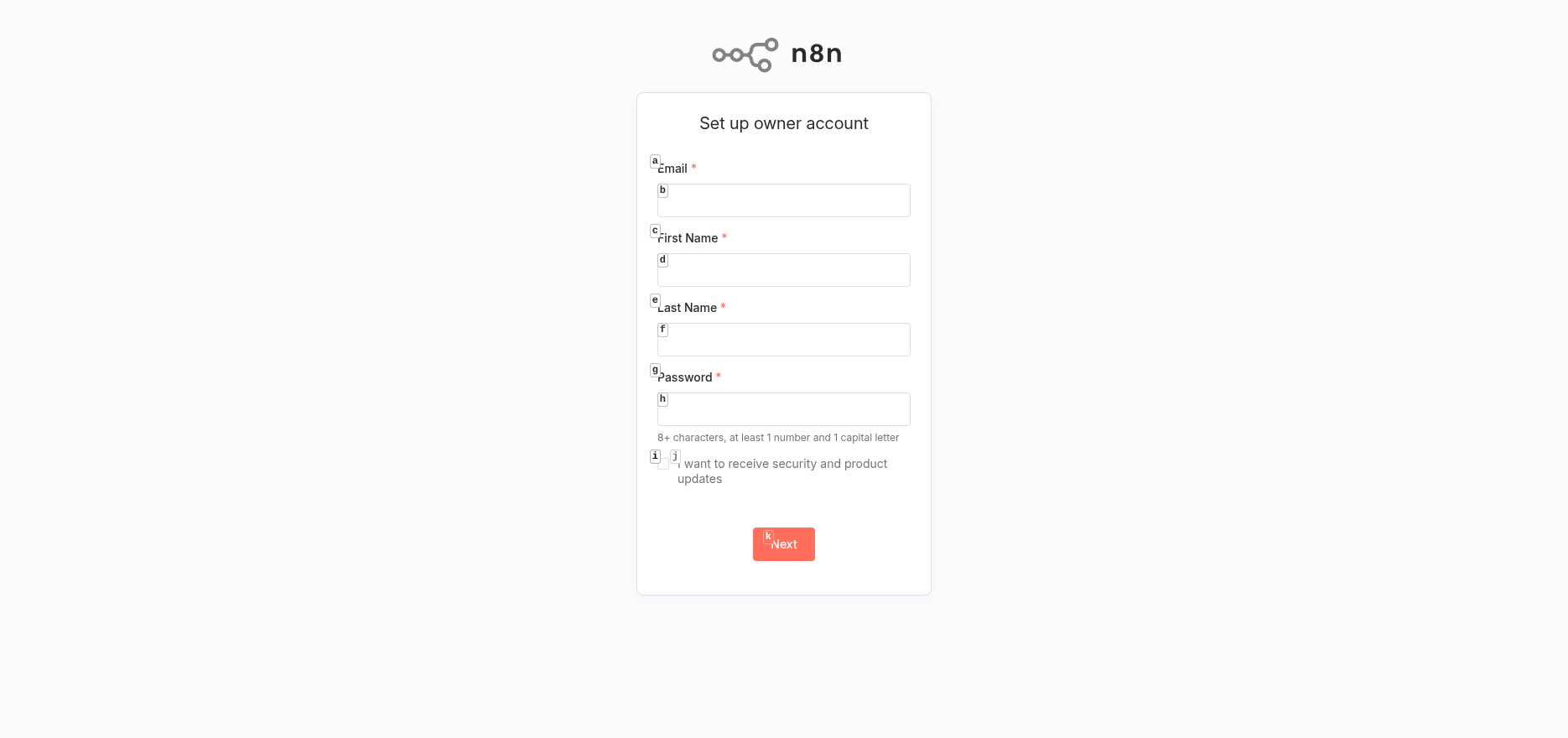

访问 http://127.0.0.1:5678,创建所有者账号。

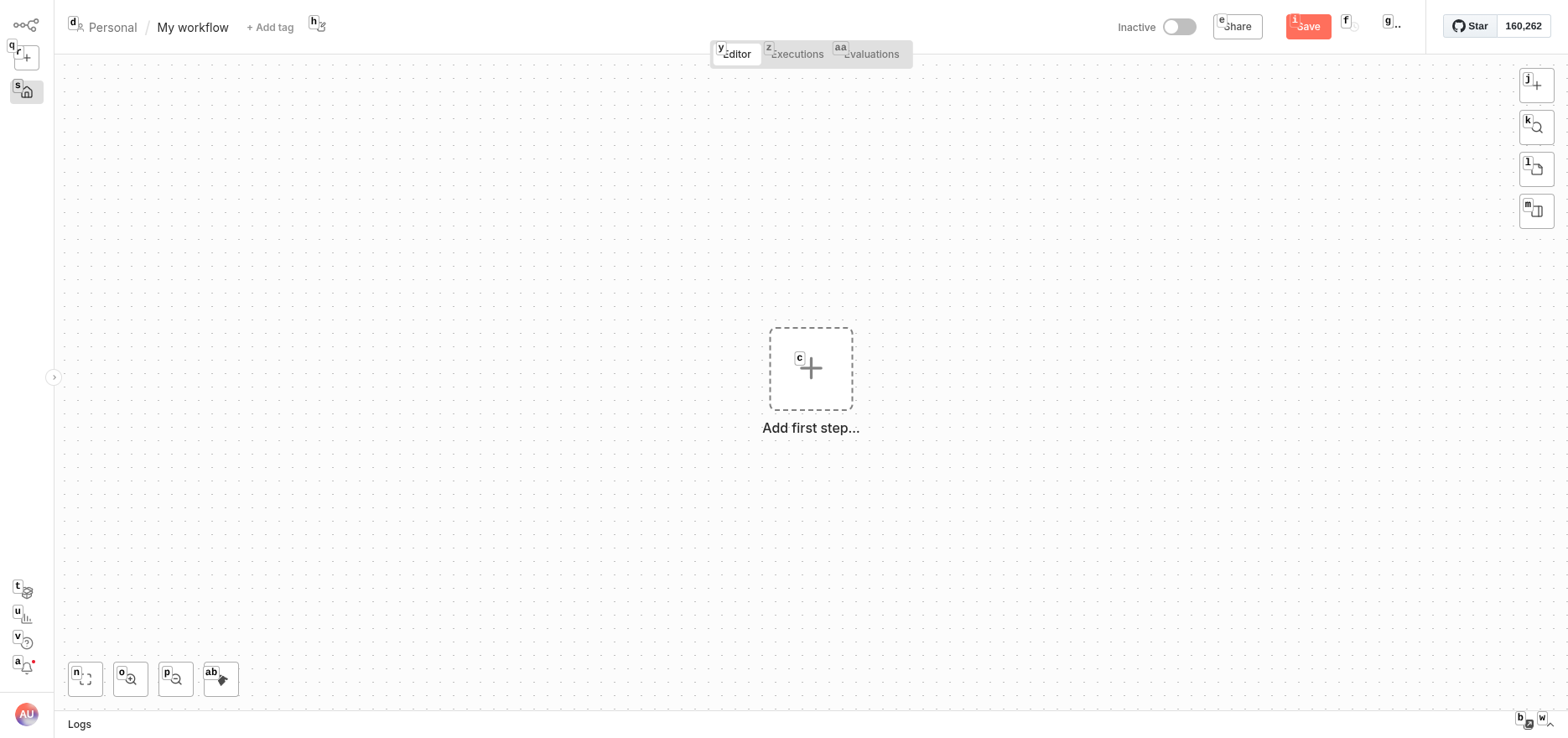

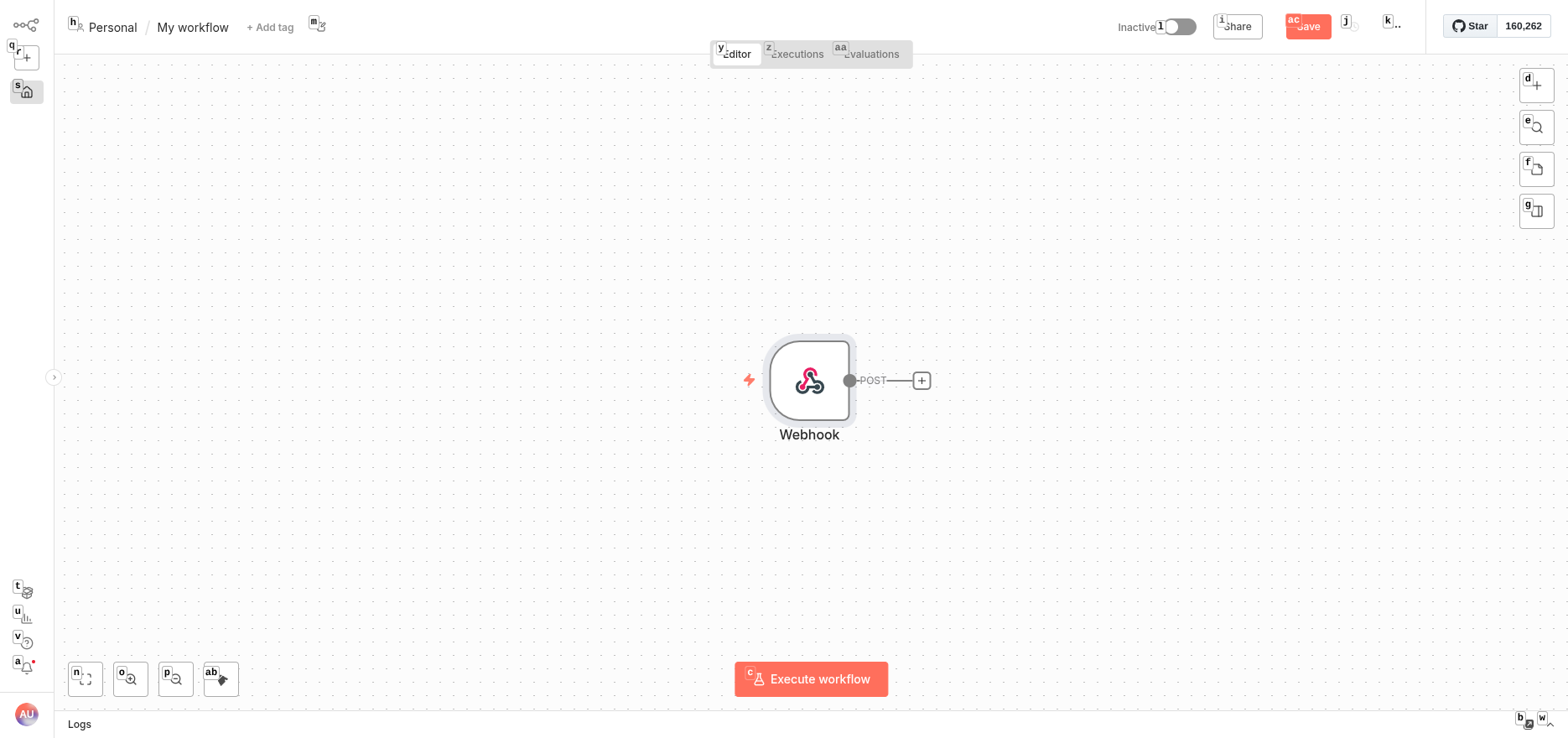

构建 AI 工作流

在 n8n 中创建新工作流。你需要两个核心节点:

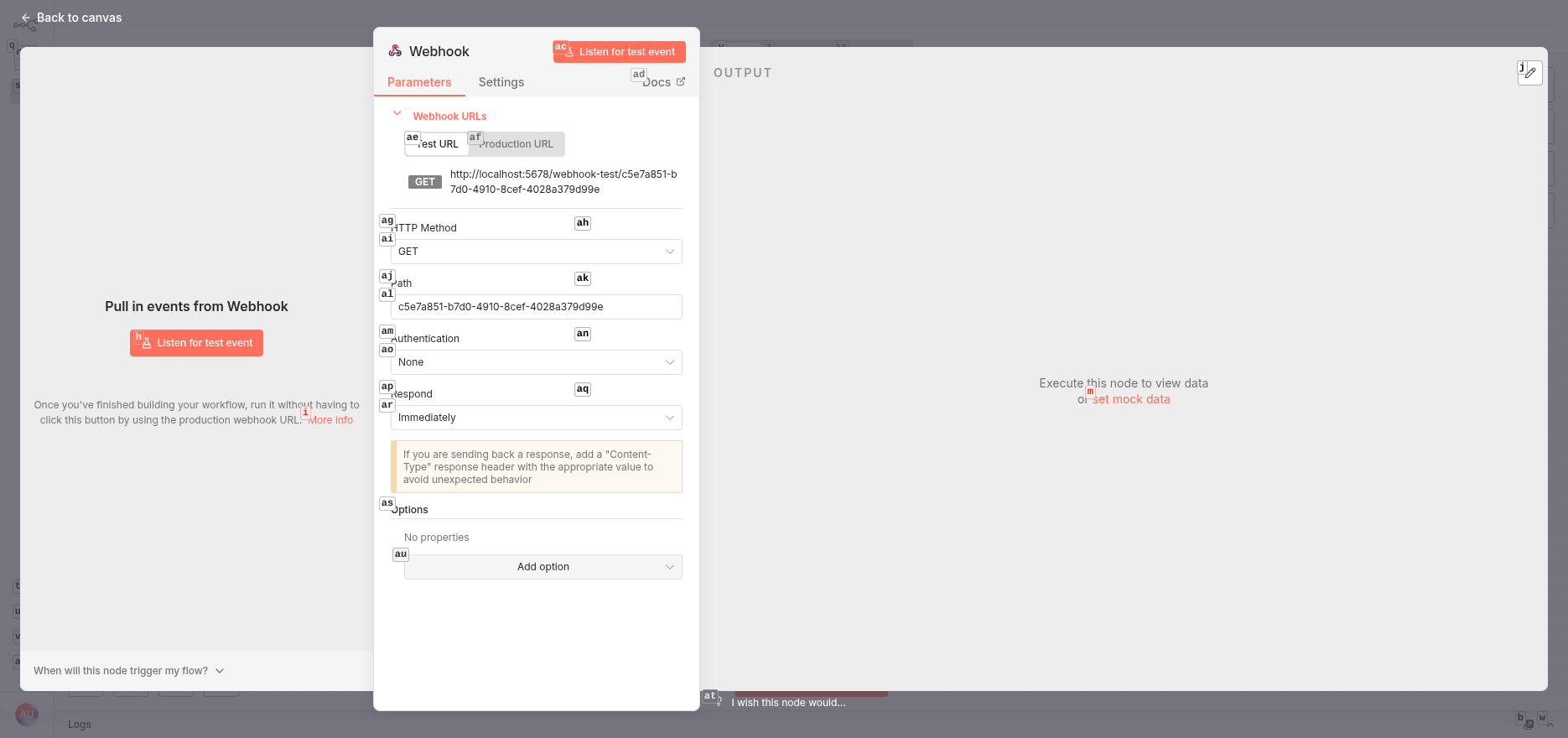

添加 Webhook 触发器

在画布上点击"+",添加 Webhook 节点。配置:

- HTTP Method: POST

- Response Mode: Streaming (启用实时聊天响应)

- Authentication: None (生产环境按需调整)

添加 AI Agent

按 Tab 键,选择 "AI" 类别,然后选择 AI Agent。

配置 Chat Model: 点击 "Chat Model",选择 "OpenAI Chat Model"。添加凭据:

- API Key: 你的 OpenAI API 密钥(或兼容服务的密钥)

- Base URL: 如果使用 Claude、Gemini 或本地模型等 OpenAI 替代方案,更新为你的提供商端点

关键步骤 - 修正 Prompt 来源: 默认情况下,AI Agent 期望从 Chat Trigger 节点接收输入,这与 Webhook 不兼容。修复方法:

- 在 AI Agent 设置中找到 "Source for Prompt (User Message)"

- 从 "Connected Chat Trigger Node" 改为 "Define below"

- 切换到 "Expression" 模式

- 输入:

{{ $json.body }}

这个表达式从 Webhook 请求体中提取用户消息。

激活并获取 Webhook URL

保存工作流,点击右上角的激活开关。切换到 "Production URL" 标签,复制 webhook URL:

http://localhost:5678/webhook/{your-webhook-id}

连接 LangBot 与 n8n

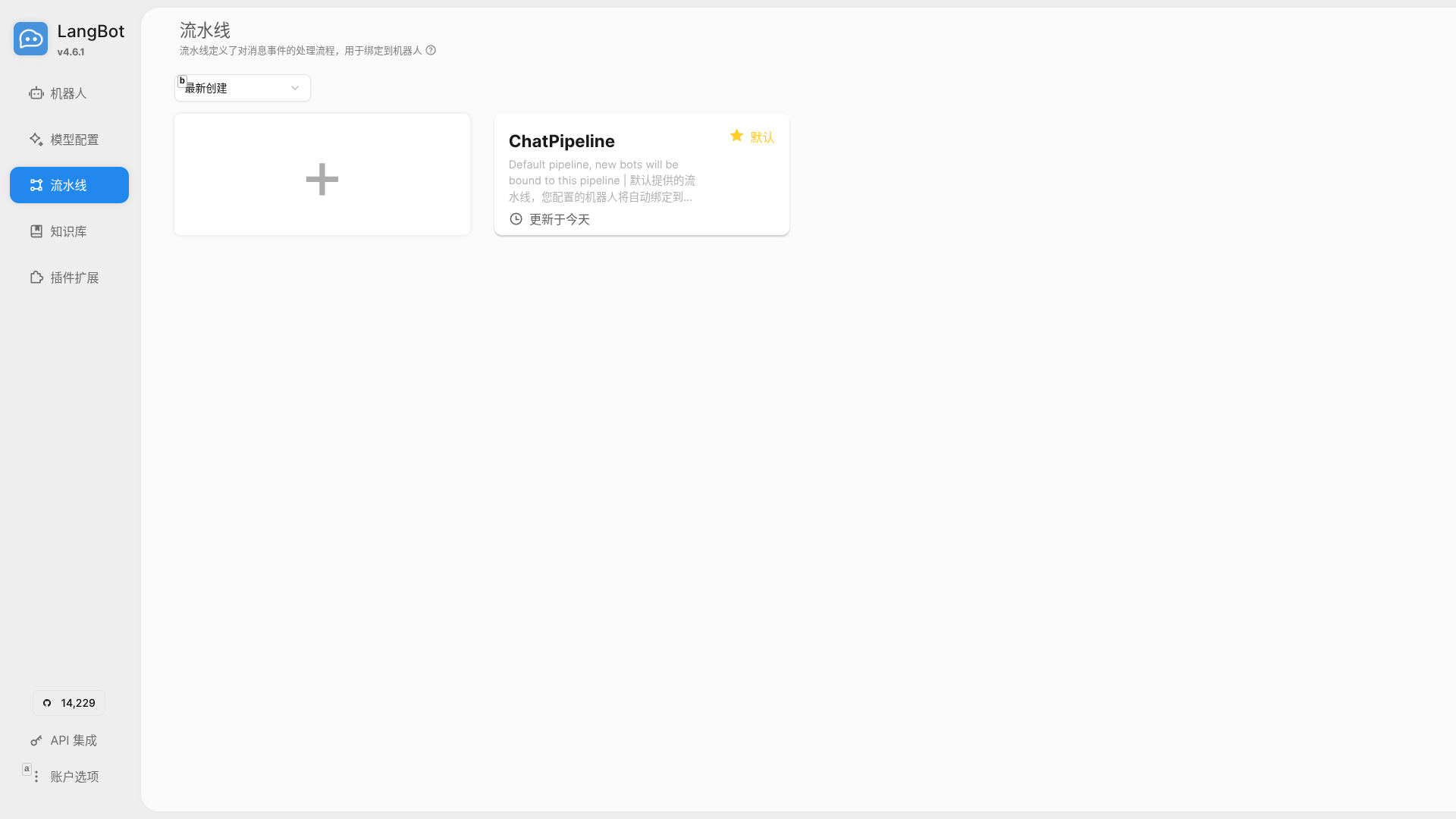

回到 LangBot 控制面板,进入 Pipelines 页面,点击默认的 "ChatPipeline"。

切换到 AI 标签页,在 Runner 下拉菜单中选择 "n8n Workflow API"。配置:

- Webhook URL: 粘贴你的 n8n 生产 webhook URL

- Authentication Type: None (与你的 n8n webhook 设置匹配)

- Timeout: 120 秒

- Output Key: response

点击 Save。

测试集成

在 Pipeline 编辑器中,点击左侧的 "Debug Chat"。发送测试消息,如 "什么是 LangBot?"。

如果一切正常,你会看到 LangBot 将消息发送到 n8n,AI Agent 处理后流式返回响应。

故障排除

错误: "Expected to find the prompt in an input field called 'chatInput'"

这意味着 AI Agent 仍配置为 Chat Trigger 节点。修复:

- 打开 AI Agent 配置

- 将 "Source for Prompt (User Message)" 设为 "Define below"

- 切换到 Expression 模式

- 输入:

{{ $json.body }}

直接测试 Webhook

用 curl 验证 webhook 是否工作:

curl -X POST http://localhost:5678/webhook/your-webhook-id \

-H "Content-Type: application/json" \

-d '{"body": "Hello, can you introduce yourself?"}'

成功的响应应该是流式 JSON,包含 AI 的回复。

集成工作原理

完整流程如下:

- 用户通过 QQ、微信、Discord、Telegram、Slack、LINE 或任何 LangBot 支持的平台发送消息

- LangBot 的 Pipeline 接收消息并调用 n8n Workflow API

- n8n 的 Webhook 节点捕获请求并传递给 AI Agent

- AI Agent 使用 OpenAI、Claude、Gemini 或你配置的 LLM 生成响应

- n8n 将响应流式返回给 LangBot

- LangBot 将响应发送回用户的原始平台

为什么这个组合好用

LangBot + n8n 解锁强大能力:

- 无代码 AI 逻辑: 在 n8n 中可视化设计对话流程,无需编写代码

- 多平台触达: 同时在 QQ、微信、Discord、Telegram、Slack、LINE、钉钉和飞书部署相同的 AI

- 灵活的 AI 模型: 在 OpenAI GPT、Anthropic Claude、Google Gemini、Coze、Dify、本地模型等之间自由切换

- 丰富的集成: 连接 n8n 的 400+ 集成 - 数据库、API、Notion、Airtable、Google Sheets、Slack 等

- 工具调用能力: AI Agent 可以触发 n8n 工具,如数据库查询、API 调用或自定义函数

- 工作流扩展: 添加预处理、内容审核、日志记录或自定义业务逻辑

适用场景:

- 企业客服机器人

- 知识库问答系统

- 多平台社群管理

- 任务自动化助手

- 团队统一聊天接口

扩展功能

进一步扩展你的机器人:

- 集成 Dify 或 FastGPT 实现高级 RAG(检索增强生成)

- 添加向量数据库节点(Pinecone、Qdrant、Weaviate)进行知识检索

- 连接业务 API 获取实时数据

- 实现对话记忆和上下文跟踪

- 添加内容过滤和审核工作流

- 使用 Langflow 或 Coze 进行额外的 AI 编排

这个集成让你既拥有 LangChain 等代码框架的灵活性,又享受可视化工作流构建器的简便性 - 同时触达所有主流消息平台的用户。

准备好部署你的多平台 AI 助手了吗?今天就开始使用 LangBot 和 n8n 吧。

浙公网安备 33010602011771号

浙公网安备 33010602011771号