本地部署DeepSeek-R1并使用自定义的知识库AnythingLLM

一、基础信息

1、概述

以下是私有化部署方案的优势:

性能卓越:提供媲美商业模型的对话交互体验

环境隔离:完全离线运行,杜绝数据外泄风险

数据可控:完全掌控数据资产,符合合规要求

2、硬件环境

CPU >= 2 Core

显存/RAM ≥ 16 GiB(推荐)

3、软件

(1)Ollama

Ollama 是一款跨平台的大模型管理客户端(MacOS、Windows、Linux),旨在无缝部署大型语言模型 (LLM),例如 DeepSeek、Llama、Mistral 等。Ollama 提供大模型一键部署,所有使用数据均会保存在本地机器内,提供全方面的数据隐私和安全性。

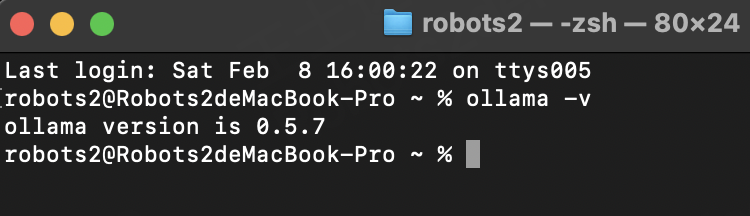

访问 Ollama 官网,根据提示下载并安装 Ollama 客户端。安装完成后,在终端内运行 ollama -v 命令将输出版本号。

(2)DeepSeek

DeepSeek 是一款开创性的开源大语言模型,凭借其先进的算法架构和反思链能力,为 AI 对话交互带来了革新性的体验。通过私有化部署,你可以充分掌控数据安全和使用安全。你还可以灵活调整部署方案,并实现便捷的自定义系统。

(3)Dify

Dify 作为同样开源的 AI 应用开发平台,提供完整的私有化部署方案。通过将本地部署的 DeepSeek 服务无缝集成到 Dify 平台,企业可以在确保数据隐私的前提下,在本地服务器环境内构建功能强大的 AI 应用。

二、部署DeepSeek-R1

1、部署Ollama

(1)打开官网

https://ollama.com/

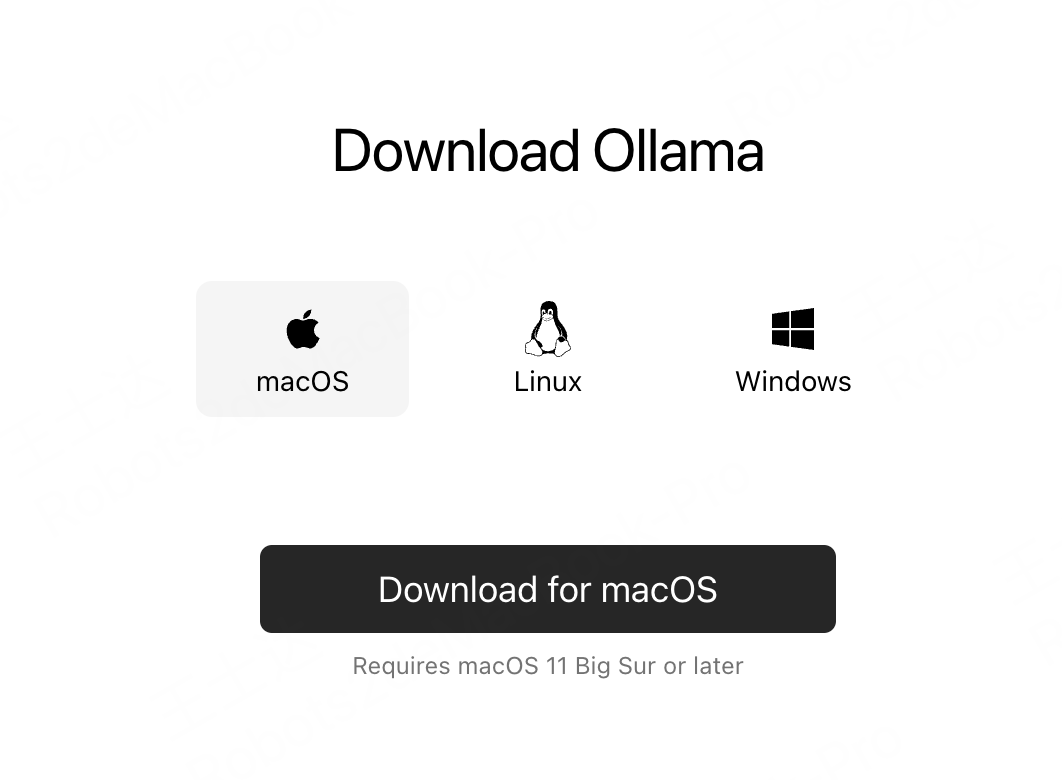

(2)下载对应系统的Ollama

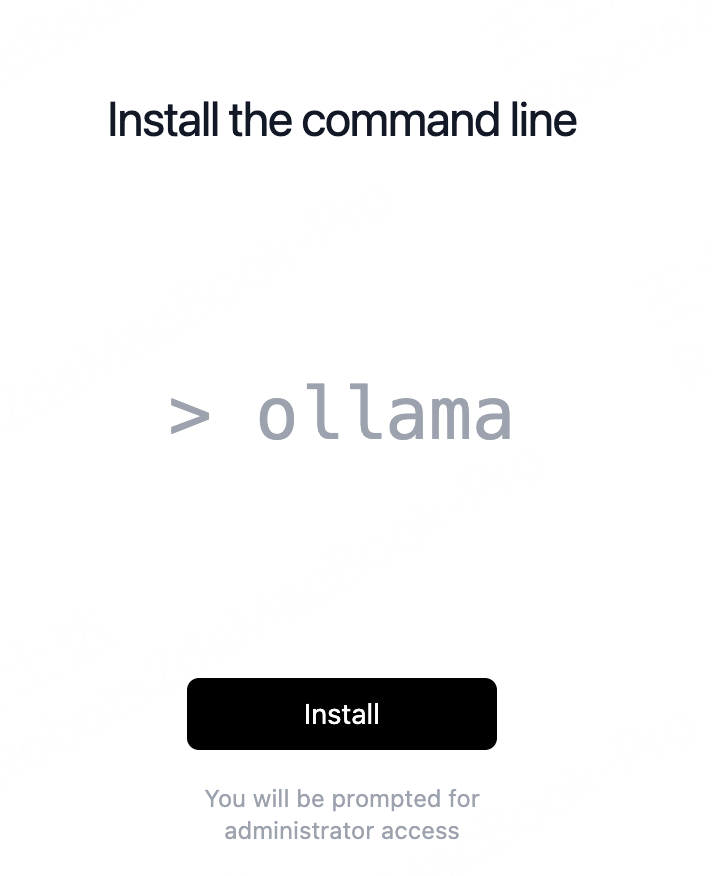

(3)安装

(4)验证--终端执行

ollama -v

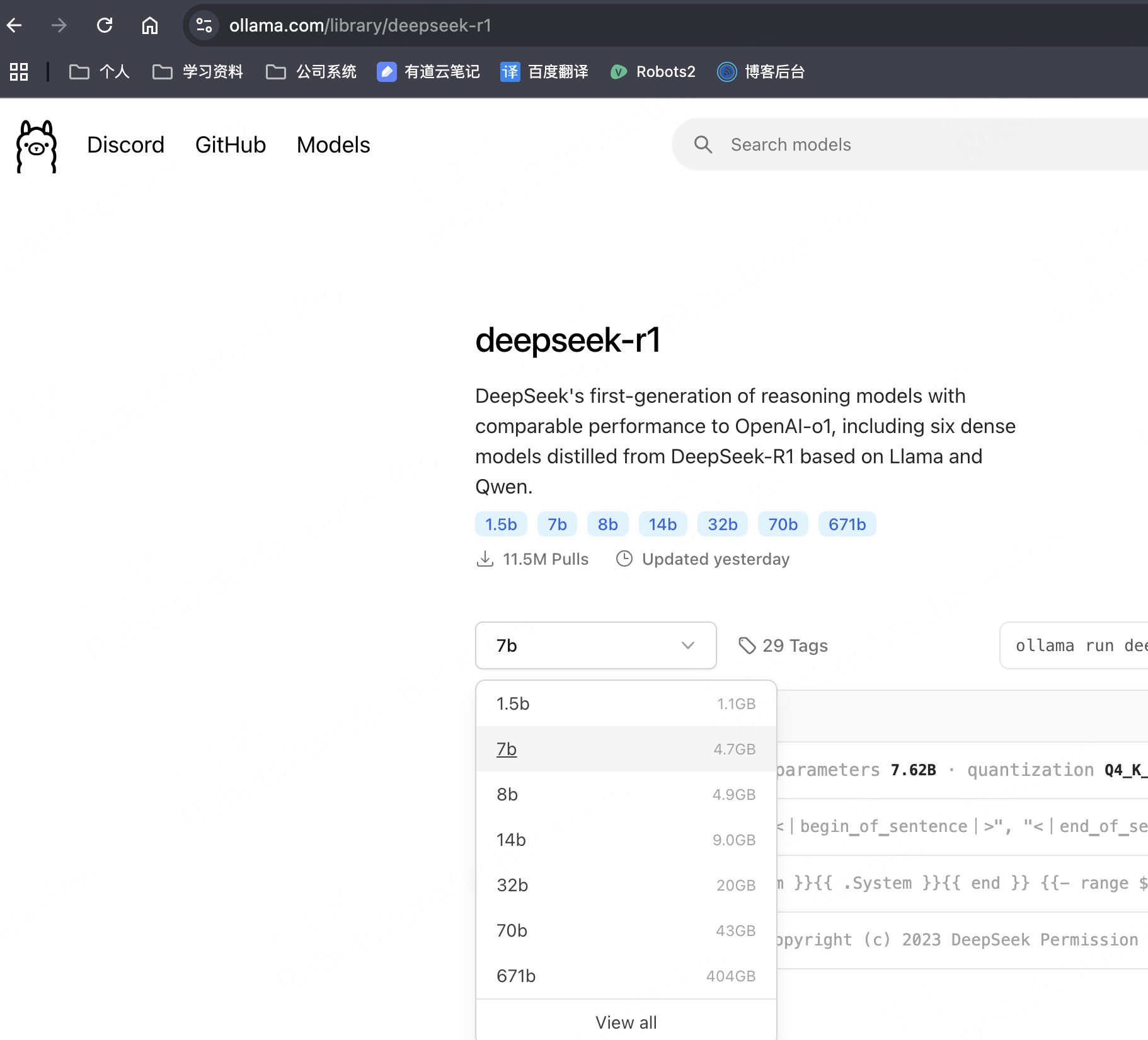

2、使用ollama安装DeepSeek-r1模型

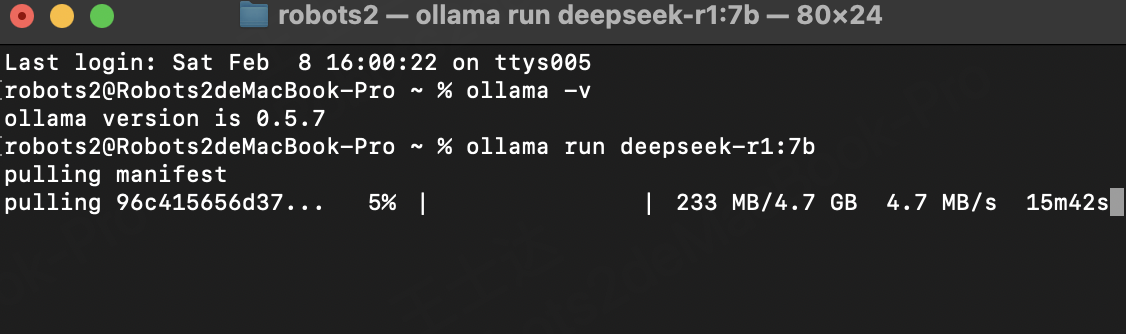

(1)ollama安装DeepSeek模型

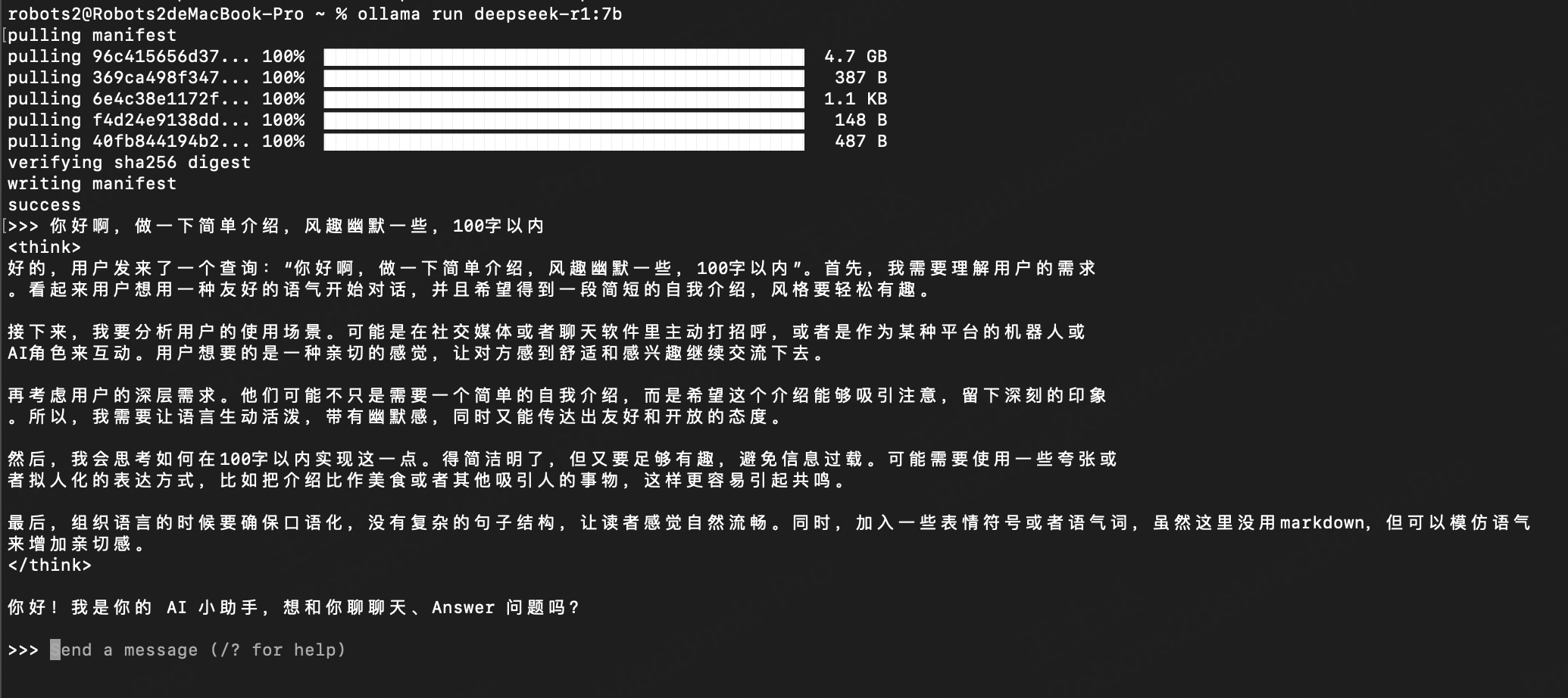

ollama run deepseek-r1:7b

注:根据本机配置,选择合适的DeepSeek模型进行部署。本机推荐安装 7B 尺寸模型,大约需要拉取4.7GB数据,可以在ollama官网搜索模型,查看模型大小

(2)安装后验证

安装完成,直接输入问题即可,可以看到回复信息

三、部署本地可视化工具AnythingLLM,支持本地知识库

1、下载

官网:https://anythingllm.com/

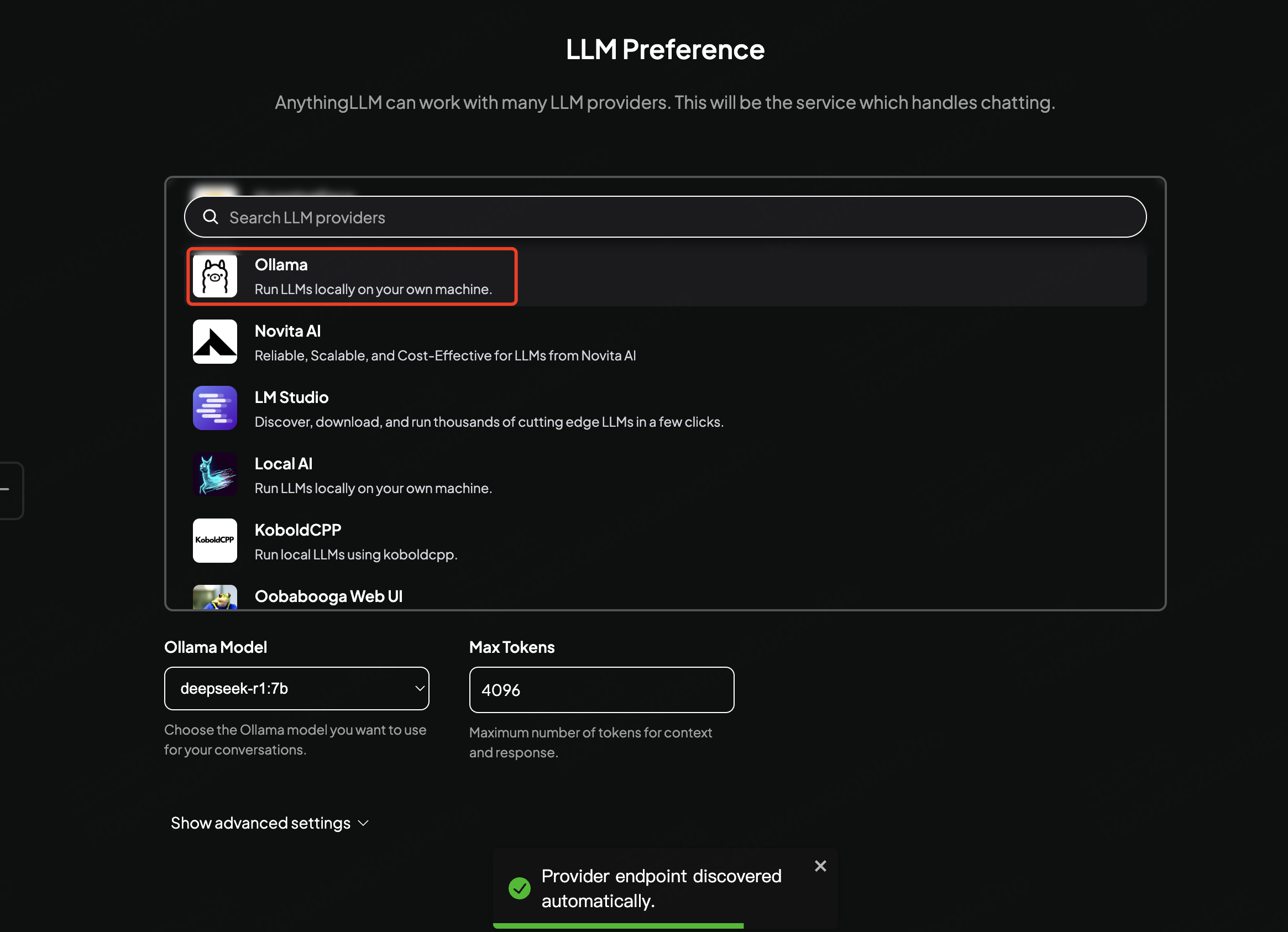

2、打开anythingllm

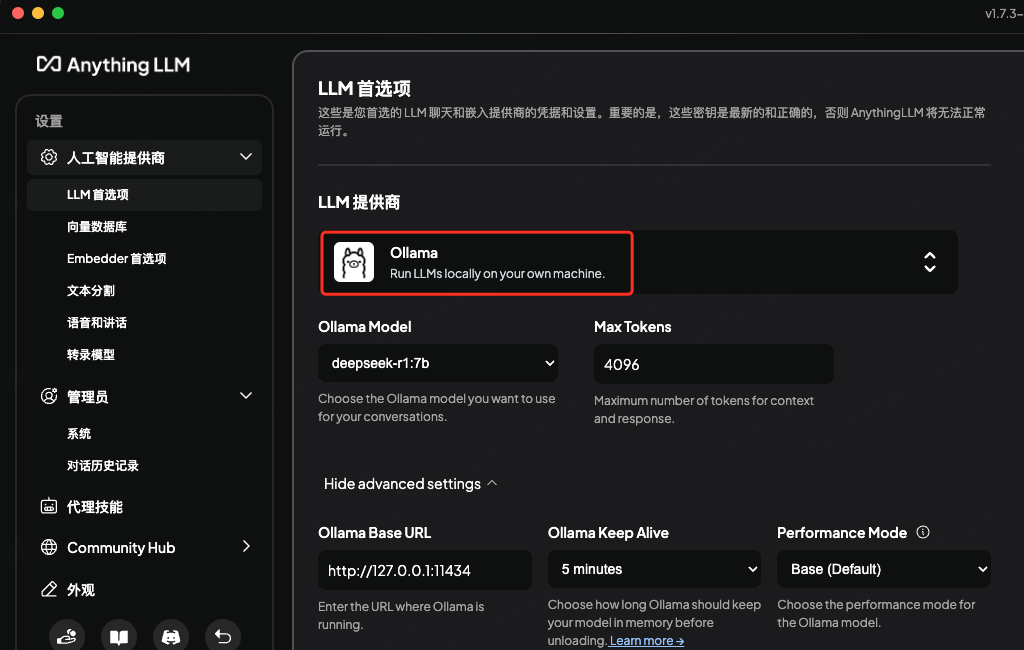

第一次打开,选择Ollama,会自动查询本地Ollama的模型和版本

第二次打开,在左下角设置中指定模型

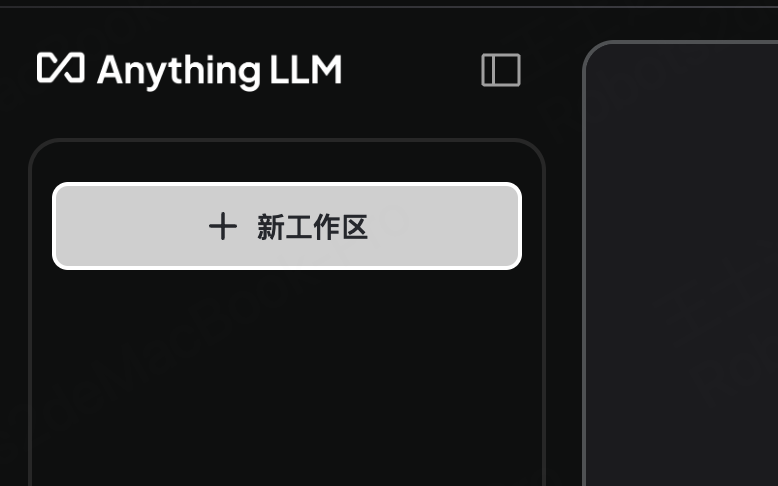

2、创建一个workspace

4、选择 Ollama应用,AnythingLLM会自动识别本地正在运行的 Ollama

终端验证是否运行Ollama:curl http:127.0.0.1:11434

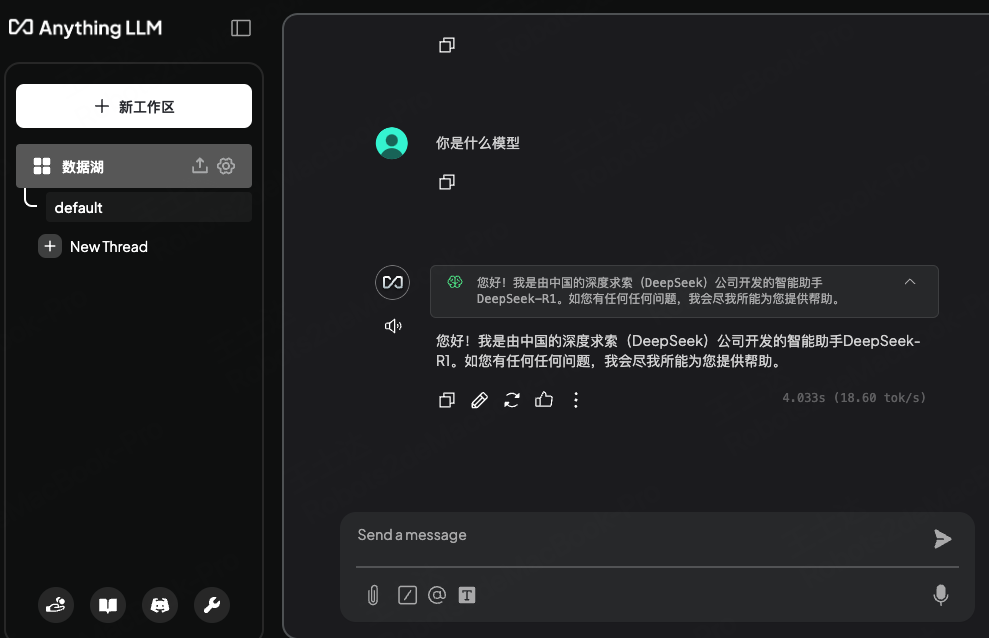

聊天验证:输入消息,查看回复内容

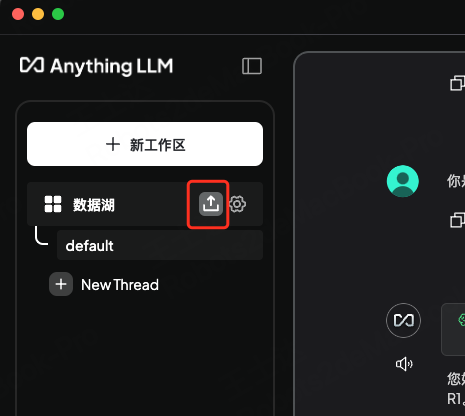

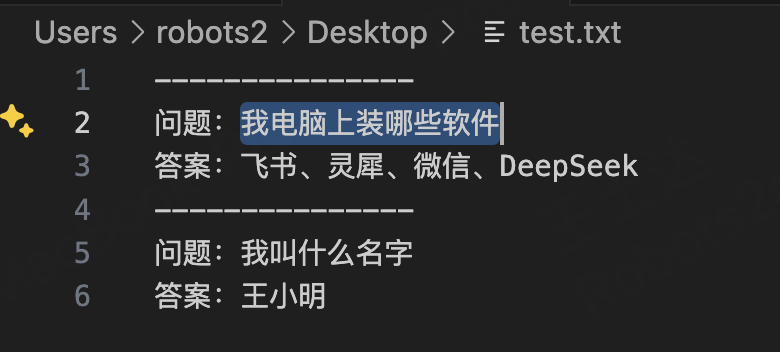

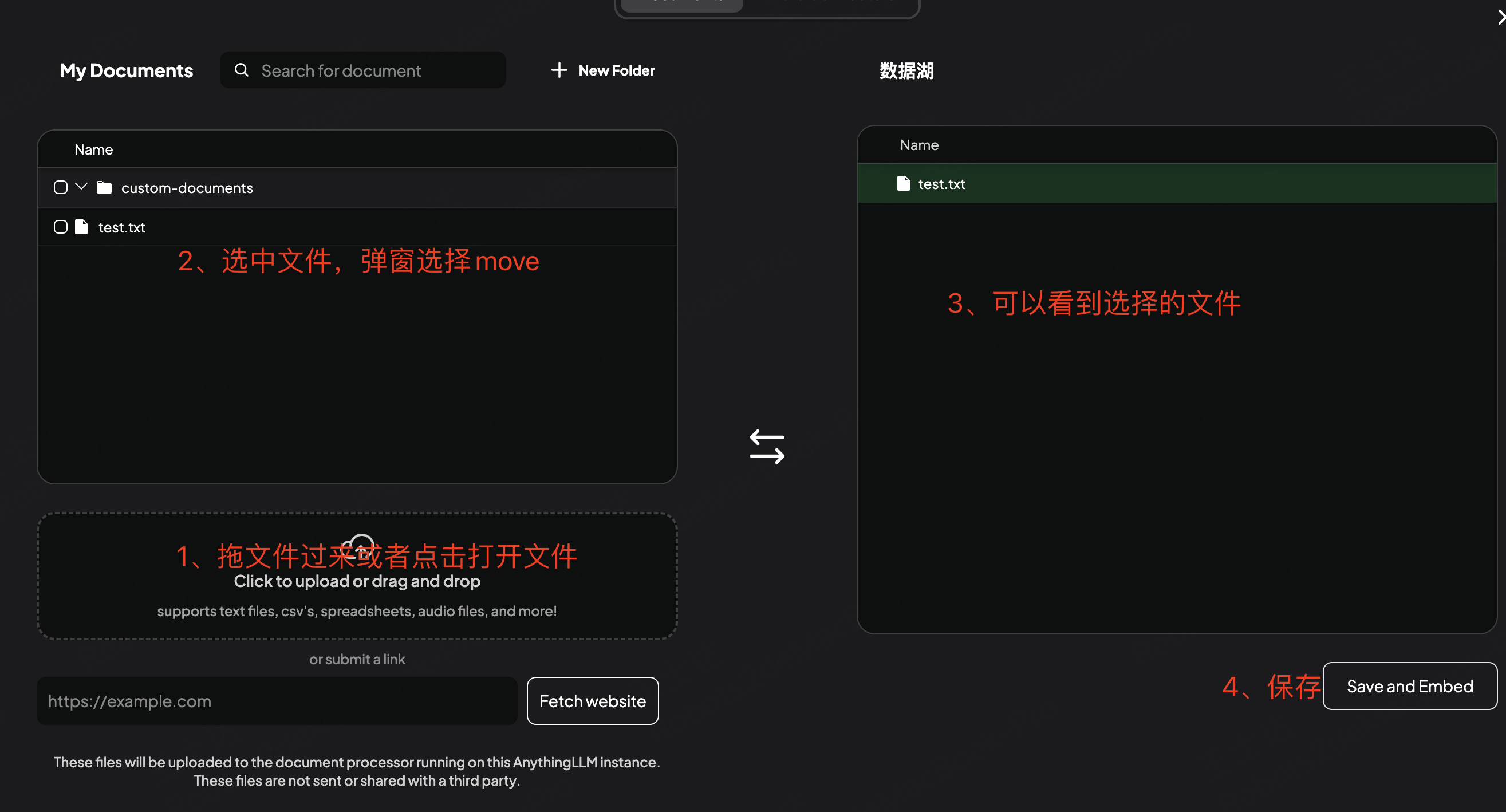

5、本地知识库上传内容

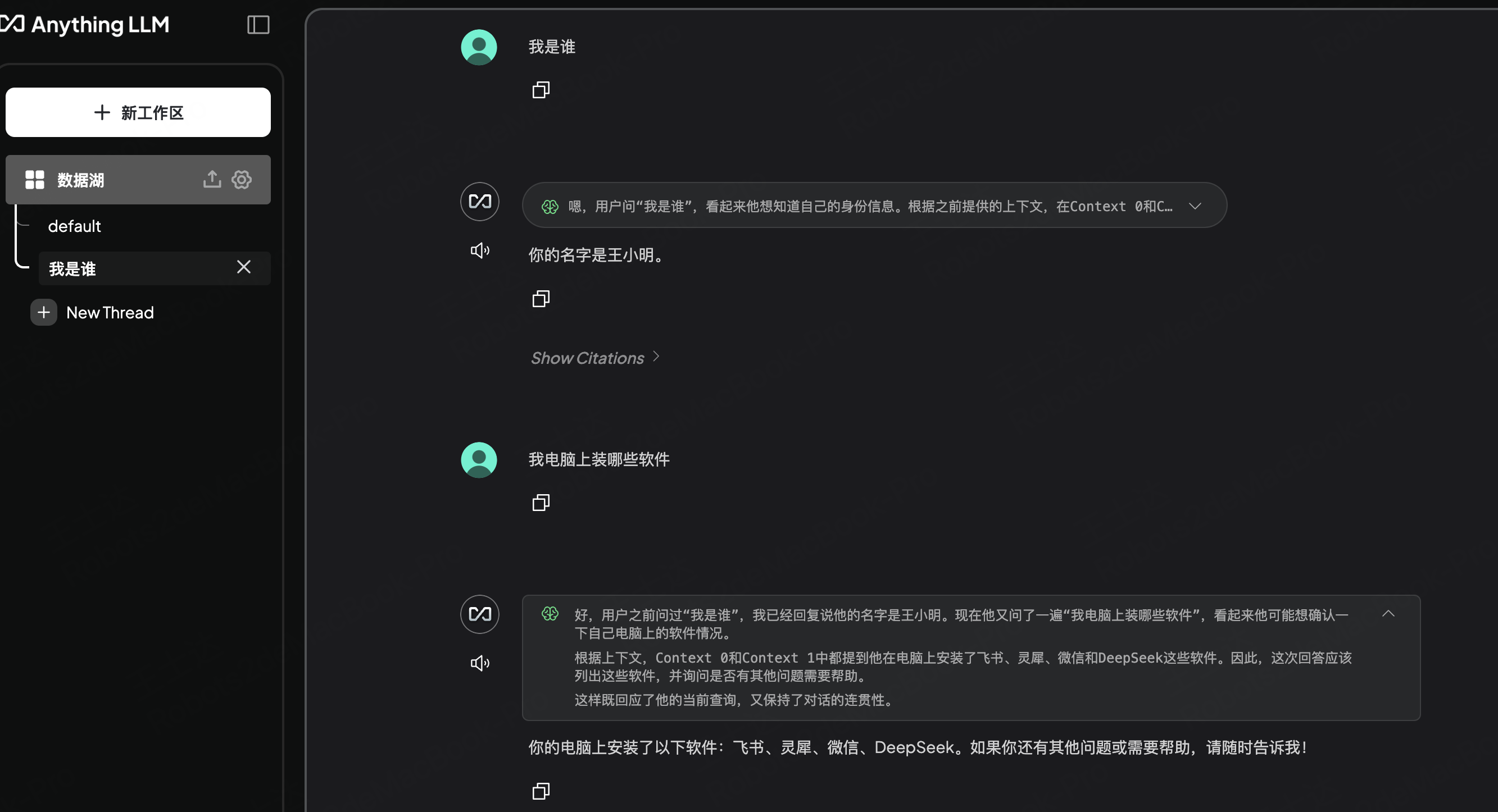

6、验证

输入本地上传文件中的问题,查看回复内容是否是本地知识,这里看到使用了本地知识库回复

浙公网安备 33010602011771号

浙公网安备 33010602011771号