第五章 Monte Carlo Methods 读书笔记

蒙特卡洛方法不需要对环境模型有完全的认识。总结来说,蒙特卡罗方法是从经验中学习值函数和策略的方法。

- 可以从与真实环境的交互中学习,并不需要模型;

- 能从模拟中学习,不需要概率分布。(不像DP,需要全部的分布,现在只需要给出reward和 next_state)

- 可以从任意的state和action开始。

相同点

- 使用GPI思想

但是,估计Q值所采用的方法不同。

蒙特卡洛方法是基于平均样本奖赏的方法。本书中蒙特卡洛方法被用于情节式的任务。以情节为单位修改值函数和策略的。

蒙特卡洛方法为每一个状态-行为对进行平均取样方法和第二章介绍的多臂赌博机有些相似。主要的不同是该蒙特卡洛方法有许多不同的状态,其中每个状态又像是不同的赌博机问题,而且这些问题是相互关联的,是动态问题。

为了解决这种动态问题,使用DP中用到的GPI,只不过没有完全的环境模型,只有与环境的采样样本。

5.1 蒙特卡洛预测

我们从用蒙特卡洛方法求在给定策略下估计状态值函数开始讲。一个显而易见的方法是用该状态下回报的平均值来近似值函数。当样例非常多时,值函数就非常准确了。这个方法是所有蒙特卡洛方法的基础。

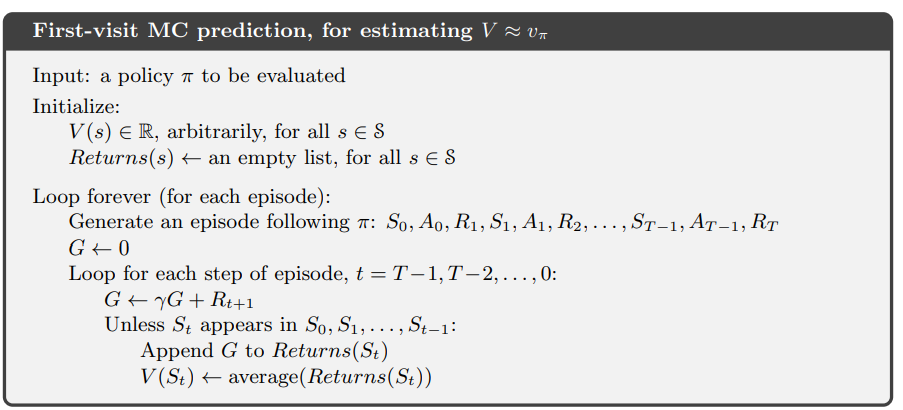

,初次访问蒙特卡洛方法和每次访问蒙特卡洛方法。初次访问蒙特卡洛方法是初次访问s的回报的平均值,而每次访问是所有访问到的回报的平均值。初次访问蒙特卡洛方法用的最广,每次访问蒙特卡洛方法可以自动地扩展应用到模糊函数和合理轨迹,这在后面章节还会介绍。下面是初次访问蒙特卡洛方法的程序图。

当样例数非常多时,初次访问和每次访问都能收敛到给定策略的值函数。

右图为蒙特卡罗方法的方向传播图,蒙特卡洛方法和动态规划方法的两个不同:

- MC的反向传播图只有一个完整的到结束状态的轨迹,而DP有所有可能的转换。(宽度)

- DP反向传播图中只有一步的转换,而MC方法有一个完整样本的转换。(长度)

- MC方法估计值函数是不依赖于其他状态估计值的,这和DP是不一样的,换句话说MC不自举。

5.2 动作值函数的蒙特卡洛估计

对于有环境转移概率分布的问题来说,有了状态值函数就可以根据概率分布来选择最佳行为。而对于用蒙特卡洛方法解决的无模型的问题来说,计算行为值函数就十分有必要。因为这样才能制定最优策略。

有环境转移概率,意味着在给定状态采取动作后,结果是可计算的,事实的。所以说,DP可以通过state值函数来选择动作。

估计Qπ(s,a)就是,估计在给定策略π下,在状态s下采取动作a时期望的返回值。

问题:许多状态-行为对可能不会被访问到。这样就会不能根据经验来改进策略。

解决方法: exploring starts使每一个状态-行为对都有一个非零的可能性被选择,这就是初始探索的假定。

5.3 蒙特卡洛控制

蒙特卡洛控制利用了GPI的思想。利用给定策略形成行为值函数的估计,再利用它贪婪地改进策略。

其中策略改进是可以用策略改进定理证明的。

5.4 没有初始探索的蒙特卡洛方法

如何避免不太可能的初始探索呢?唯一的方法就是要确保所有的行为都能被选择。

- 同策略:要评定和改进的策略和产生数据的策略(行为策略)是同一个.

- 离策略:要评定和改进的策略和产生数据的策略(行为策略)不一样。

在线方法是利用e-soft方法:π(a|s)> 0 对所有a。随着时间的积累,越来越向最佳策略逼近。在这里我们使用 e-greedy方法。

使用e-greedy方法可以不用探索初始的方法,因为所有的action都可能被选择。而且改进的策略π’可以证明比原来的策略好(或者一样好)。

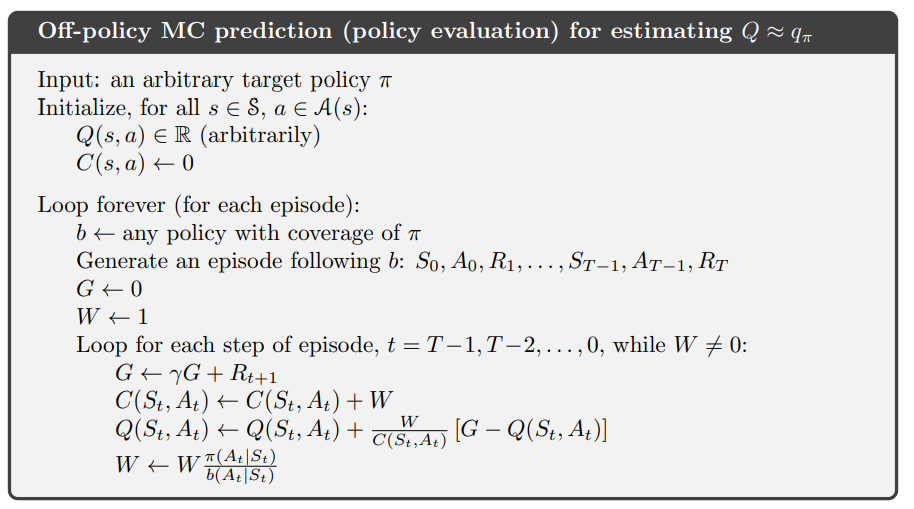

5.5 基于重要性采样的离策略估计

5.6 递增表示

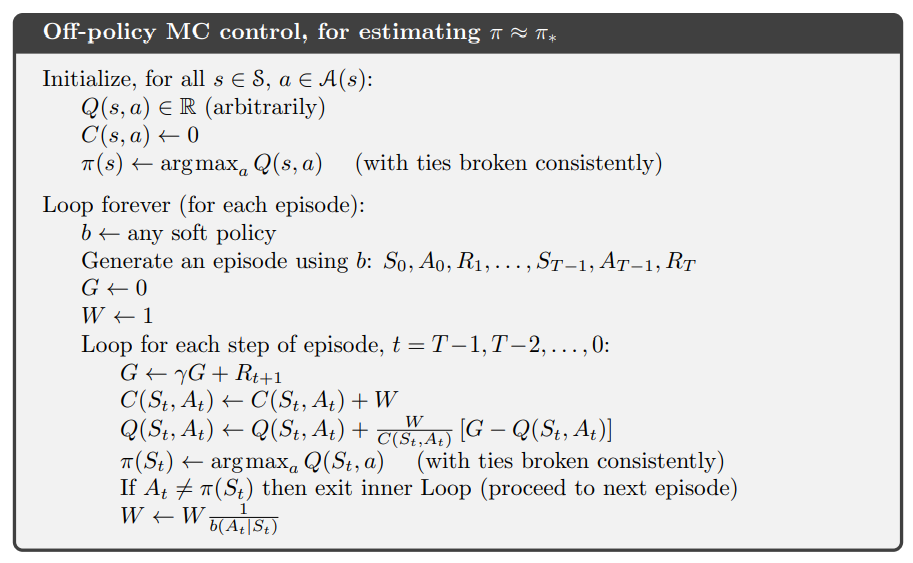

5.7 离策略蒙特卡洛控制

5.8 有折扣感知的重要性采样*

5.9 基于每步决策的重要性采样*

5.10 总结

相对于DP方法,蒙特卡罗方法带来的四大优势是:

- 一、能够从与真实环境交互中学习,没有环境模型的要求。

- 二、可以从模拟实验中学习,不需要给出概率分布。

- 三、蒙特卡罗方法可以只关心全部集合的一个子集合。

- 四、不自举。

蒙特卡洛方法同样利用GPI思想。它通过策略估计的替代(利用样本经验)来估计每个状态的值,没有使用环境的概率分布。因为没有环境的模型,蒙特卡洛方法比较倾向于对动作值的估计来形成最优策略。

初始探索的离策略方法能用于模拟的情节中,而不适合与环境实际交互。同策略方法中,智能体总是一边探索一边形成最优策略。而离策略方法从behavior policy产生的数据中学习形成最优策略。而重要性采样又分为一般重要性采样和加权重要性采样。

一般重要性采样和加权重要性采样的区别:一般重要性采样产生无偏估计,但是可能无限大的方差,而加权重要性采样有有限的方差,而且在实际上一般倾向于它。尽管概念的简单,用离策略进行估计和控制的问题既然没有解决并且是正在研究的课题。

浙公网安备 33010602011771号

浙公网安备 33010602011771号